LCEL(LangChain Expression Language)でLangChain再入門する

LCEL、いろいろな課題をクリアできそうで俄然興味がでてきたので、久々にLangChain触ってみる。再入門。

まずは公式のチュートリアルなど写経していく。

まずはシンプルな、プロンプト+モデル+出力パーサの例。

パッケージインストール

!pip install --upgrade --quiet langchain-core langchain-community langchain-openai

!pip freeze | grep -i langchain

langchain-community==0.0.32

langchain-core==0.1.41

langchain-openai==0.1.2

APIキー読み込み。

import os

from google.colab import userdata

os.environ['OPENAI_API_KEY'] = userdata.get('OPENAI_API_KEY')

モデルを定義

from langchain_openai import ChatOpenAI

model = ChatOpenAI(model="gpt-3.5-turbo-0125")

プロンプトテンプレートを定義

from langchain_core.prompts import ChatPromptTemplate

prompt = ChatPromptTemplate.from_template("{topic}についてのジョークを1つ言ってみて。")

出力パーサを定義

from langchain_core.output_parsers import StrOutputParser

output_parser = StrOutputParser()

これをLCELでチェーン定義する。UNIX/Linuxのパイプ的に出力を次の入力につなげていく。

chain = prompt | model | output_parser

では、プロンプトテンプレートの変数を渡してチェーン実行。

response = chain.invoke({"topic": "アイスクリーム"})

response

アイスクリームを食べるとき、必ずしもカロリーを気にしなくていいという理論があるんだけど、それって冷たいジョークじゃない?

なるほどわかりやすい。

各コンポーネントごとに呼び出して結果を見ることもできる。

prompt_value = prompt.invoke({"topic": "アイスクリーム"})

prompt_value

ChatPromptValue(messages=[HumanMessage(content='アイスクリームについてのジョークを1つ言ってみて。')])

プロンプトをHumanMessageオブジェクトで取り出し。

prompt_value.to_messages()

[HumanMessage(content='アイスクリームについてのジョークを1つ言ってみて。')]

プロンプトを文字列で取り出し。

prompt_value.to_string()

Human: アイスクリームについてのジョークを1つ言ってみて。

モデルにプロンプトを渡すところまで。

message = model.invoke(prompt_value)

message

AIMessage(content='なぜアイスクリームはいつも元気がいいか?\nなぜなら、いつもクールなからだから!', response_metadata={'token_usage': {'completion_tokens': 37, 'prompt_tokens': 31, 'total_tokens': 68}, 'model_name': 'gpt-3.5-turbo-0125', 'system_fingerprint': 'fp_b28b39ffa8', 'finish_reason': 'stop', 'logprobs': None}, id='run-58416fac-045f-4ee8-aad0-7806fac4e723-0')

completionモデルであれば文字列になるように出力は変わる。

from langchain_openai import OpenAI

llm = OpenAI(model="gpt-3.5-turbo-instruct")

message2 = llm.invoke(prompt_value)

message2

'\n\n「なぜアイスクリームはいつも冷たいの?\u3000なぜなら、冷たくなければ「アイスクリーム」じゃなくて「ミルクスープ」だからさ!」'

modelの出力をoutput_parserに渡す。output_parserはBaseOutputParserのサブクラスを指定(今回は``であり、りこれにより出力が文字列になる。

modelからのレスポンスを出力パーサで文字列に変換する。

output_parser.invoke(message)

なぜアイスクリームはいつも元気がいいか?\nなぜなら、いつもクールなからだから!

モデルの出力が違っても同じように処理される(以下の例は元々文字列なのであまり意味はないけども)

output_parser.invoke(message2)

'\n\n「なぜアイスクリームはいつも冷たいの?\u3000なぜなら、冷たくなければ「アイスクリーム」じゃなくて「ミルクスープ」だからさ!」'

見にくいので上から下にしているけど、こういう流れ。

チェーンは途中の状態で出力することもできる

input = {"topic": "アイスクリーム"}

display(prompt.invoke(input))

display((prompt | model).invoke(input))

ChatPromptValue(messages=[HumanMessage(content='アイスクリームについてのジョークを1つ言ってみて。')])

AIMessage(content='アイスクリームが怒っている理由は何でしょう?\u3000なぜなら、いつもコーンビーフがジェラートになっているから!', response_metadata={'token_usage': {'completion_tokens': 51, 'prompt_tokens': 31, 'total_tokens': 82}, 'model_name': 'gpt-3.5-turbo-0125', 'system_fingerprint': 'fp_b28b39ffa8', 'finish_reason': 'stop', 'logprobs': None}, id='run-810ba337-179e-43c8-9dbc-28c74efe9c8d-0')

次にRAGの例。

少しパッケージを追加

!pip install docarray tiktoken

texts = []

texts.append("""\

イクイノックス(欧字名:Equinox、2019年3月23日 - )は、日本の競走馬・種牡馬。

主な勝ち鞍は、2022年・2023年の天皇賞(秋)連覇、2022年の有馬記念、2023年のドバイシーマクラシック、宝塚記念、ジャパンカップ。\

""")

texts.append("""\

オグリキャップ(欧字名:Oguri Cap、1985年3月27日 - 2010年7月3日)は、日本の競走馬、種牡馬。

主な勝ち鞍は、1988年・1990年の有馬記念、1989年のマイルチャンピオンシップ、1990年の安田記念。\

""")

texts.append("""\

ドウデュース(欧字名:Do Deuce、2019年5月7日 - )は、日本の競走馬。

主な勝ち鞍は、2021年の朝日杯フューチュリティステークス、2022年の東京優駿、2023年の有馬記念。\

""")

from langchain_community.vectorstores import DocArrayInMemorySearch

from langchain_core.output_parsers import StrOutputParser

from langchain_core.prompts import ChatPromptTemplate

from langchain_core.runnables import RunnableParallel, RunnablePassthrough

from langchain_openai import OpenAIEmbeddings

from langchain_openai import ChatOpenAI

llm = ChatOpenAI(model="gpt-3.5-turbo-0125")

embedding = OpenAIEmbeddings(model="text-embedding-3-small")

vectorstore = DocArrayInMemorySearch.from_texts(

texts,

embedding=embedding,

)

retriever = vectorstore.as_retriever()

template = """\

以下のコンテキストにもとづいて、質問に答えてください:

{context}

質問: {question}

回答: \

"""

prompt = ChatPromptTemplate.from_template(template)

output_parser = StrOutputParser()

setup_and_retrieval = RunnableParallel(

{"context": retriever, "question": RunnablePassthrough()}

)

chain = setup_and_retrieval | prompt | model | output_parser

chain.invoke("ドウデュースの勝利したレースは何?")

主な勝ち鞍は、2021年の朝日杯フューチュリティステークス、2022年の東京優駿、2023年の有馬記念。

上記のチェーンのsetup_and_retrievalはそのためのベクトル検索を行うコンポーネントとして定義してある。まずは単体でretrieverを実行してみる。

retriever.invoke("ドウデュースの勝利したレースは何?")

[Document(page_content='ドウデュース(欧字名:Do Deuce、2019年5月7日 - )は、日本の競走馬。\n主な勝ち鞍は、2021年の朝日杯フューチュリティステークス、2022年の東京優駿、2023年の有馬記念。'),

Document(page_content='イクイノックス(欧字名:Equinox、2019年3月23日 - )は、日本の競走馬・種牡馬。\n主な勝ち鞍は、2022年・2023年の天皇賞(秋)連覇、2022年の有馬記念、2023年のドバイシーマクラシック、宝塚記念、ジャパンカップ。'),

Document(page_content='オグリキャップ(欧字名:Oguri Cap、1985年3月27日 - 2010年7月3日)は、日本の競走馬、種牡馬。\n主な勝ち鞍は、1988年・1990年の有馬記念、1989年のマイルチャンピオンシップ、1990年の安田記念。')]

検索結果(といっても全件だけども)が配列でわたっている。で、これをpromptに渡すのだけど、promptは2つの引数を受け取る。

- query: 元の入力クエリ

- contexts: ベクトル検索結果

普通にチェーンでつなぐと、出力はそのまま次の入力になってしまうので、これを分けるためにRunnableParallelがある。

setup_and_retrieval = RunnableParallel(

{"context": retriever, "question": RunnablePassthrough()}

)

これでretrieverの結果はcontextsに入る。クエリはそのまま渡したい。RunnablePassthroughを使うと入力がそのままパススルーされて、questionに入る。

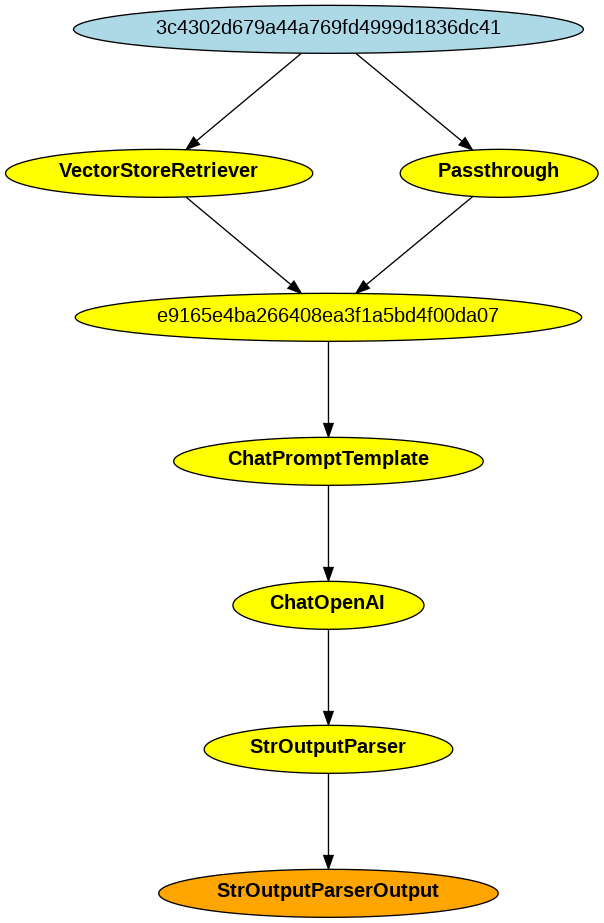

多分こんな感じ。

あとは同じ。

LCELのメリットについて書かれている。

LCELは、LLMを使って便利なアプリを構築し、関連するコンポーネントを組み合わせるプロセスを合理化するように設計されています。LCELは次のような機能を提供します:

- 統一インターフェース

- すべてのLCELオブジェクトはRunnableインターフェイスを実装し、共通の呼び出しメソッド(invoke, batch, stream, ainvoke, ...)を定義しています。これにより、LCELオブジェクトのチェーンは、それ自体がLCELオブジェクトであるため、中間ステップのバッチやストリーミングのような便利な操作を自動的にサポートすることができます。

- 合成プリミティブ

- LCELは、チェーンの構成、コンポーネントの並列化、フォールバックの追加、チェーン内部の動的構成などを容易にする、多くのプリミティブを提供します。

LCELの価値をよりよく理解するためには、LCELの動作を見て、LCELなしで同じような機能を再現する方法を考えることが役立ちます。このウォークスルーでは、スタートセクションにある基本的な例を使って、まさにそれを行います。すでに多くの機能を定義しているシンプルなプロンプト+モデルチェーンを取り上げ、そのすべてを再現するために何が必要かを見ていきます。

ということでLCELあり・なしのコードが用意されているが、LCELのコードを試していく。

パッケージインストール

!pip install --upgrade --quiet langchain-core langchain-openai langchain-anthropic

!pip freeze | grep -i langchain

langchain-anthropic==0.1.7

langchain-core==0.1.41

langchain-openai==0.1.2

APIキーを読み込み

import os

from google.colab import userdata

os.environ['OPENAI_API_KEY'] = userdata.get('OPENAI_API_KEY')

os.environ['ANTHROPIC_API_KEY'] = userdata.get('ANTHROPIC_API_KEY')

Invoke

from langchain_openai import ChatOpenAI

from langchain_core.prompts import ChatPromptTemplate

from langchain_core.output_parsers import StrOutputParser

from langchain_core.runnables import RunnablePassthrough

prompt = ChatPromptTemplate.from_template(

"{topic}についてのジョークを1つおしえて。"

)

output_parser = StrOutputParser()

model = ChatOpenAI(model="gpt-3.5-turbo")

chain = (

{"topic": RunnablePassthrough()}

| prompt

| model

| output_parser

)

response = chain.invoke("アイスクリーム")

print(response)

なぜアイスクリームはいつも元気がいいのか? なぜなら、いつもクールなからだを持っているから!

streamでストリーミング。わかりやすいように改行を入れてみた。

for chunk in chain.stream("アイスクリーム"):

print(chunk, end="\n", flush=True)

ア

イ

ス

ク

リ

ーム

は

ど

う

して

優

秀

な

従

業

員

な

ん

で

し

ょ

う

か

?

な

ぜ

な

ら

、

い

つ

も

ク

ール

で

フ

レ

ーバ

ー

が

豊

富

だ

から

!

batch。バッチ。

chain.batch(["アイスクリーム", "スパゲッティ", "餃子"])

['アイスクリームが学校に行くとき、何を着ていく?\n\nソフトクリーム!',

'スパゲッティがお皿の上で踊っていたら、なぜかみんなが手拍子をしていました。なぜなら、それはアルデンテだったから!',

'餃子が好きな人は、餃子が好きな人が好きだって!']

async。非同期。

await chain.ainvoke("アイスクリーム")

アイスクリームのためなら、どんなに寒い日でも私は"冷静"でいられるよ!

asyncのbatch。

await chain.abatch(["アイスクリーム", "スパゲッティ", "餃子"])

['なぜアイスクリームはいつも冷たいの?\u3000なぜなら、それがクールだから!',

'スパゲッティがテニスをするとき、どんなスタイルを使うか知っていますか? \n\n「スパゲッティ・スイング」です!',

'餃子ってなぜ飛べない?\nだって翼がないから!']

チャットモデルじゃないモデル

from langchain_openai import OpenAI

llm = OpenAI(model="gpt-3.5-turbo-instruct")

llm_chain = (

{"topic": RunnablePassthrough()}

| prompt

| llm

| output_parser

)

llm_chain.invoke("アイスクリーム")

\n\nQ: アイスクリームはなぜ笑っているの? \nA: なぜならば、彼はコーンに入るためにドレッシングしているから!

違うモデルプロバイダー

from langchain_anthropic import ChatAnthropic

anthropic = ChatAnthropic(model="claude-3-haiku-20240307")

anthropic_chain = (

{"topic": RunnablePassthrough()}

| prompt

| anthropic

| output_parser

)

anthropic_chain.invoke("アイスクリーム")

はい、アイスクリームのジョークを1つご紹介します。\n\nアイスクリームが冷蔵庫の中で待っていると、冷蔵庫のなかの他の食べ物たちが言いました。\n「もう少しで夏が来るから、アイス君、頑張ってね!」\nそしてアイスクリームが答えました。\n「いいえ、私はもう冷凍庫の中にいます。」\n\n冷蔵庫の中のアイスクリームが、夏が近づいているのを待っているというジョークですね。でも実際はすでに冷凍されているので、夏を待っていません。アイスクリームのユーモアを楽しんでいただけましたでしょうか。

実行時に設定を渡すのところだけど、ちょっとここの書き方が書いてあるとおりに動かない。一番下のフルコードから単体でやってみた。

from langchain_openai import OpenAI, ChatOpenAI

from langchain_anthropic import ChatAnthropic

from langchain_core.prompts import ChatPromptTemplate

from langchain_core.runnables import RunnablePassthrough, ConfigurableField

from langchain_core.output_parsers import StrOutputParser

prompt = ChatPromptTemplate.from_template(

"{topic}についてのジョークを1つおしえて。"

)

chat_openai = ChatOpenAI(model="gpt-3.5-turbo")

openai = OpenAI(model="gpt-3.5-turbo-instruct")

anthropic = ChatAnthropic(model="claude-3-haiku-20240307")

model = (

chat_openai

.configurable_alternatives(

ConfigurableField(id="model"),

default_key="chat_openai",

openai=openai,

anthropic=anthropic,

)

)

chain = (

{"topic": RunnablePassthrough()}

| prompt

| model

#| StrOutputParser() # modelの出力をそのまま出す

)

chain.invoke("アイスクリーム")

AIMessage(content='なぜアイスクリームがいつも冷たいのか?\nなぜなら、冷たい方がクールだから!', response_metadata={'token_usage': {'completion_tokens': 38, 'prompt_tokens': 31, 'total_tokens': 69}, 'model_name': 'gpt-3.5-turbo', 'system_fingerprint': 'fp_b28b39ffa8', 'finish_reason': 'stop', 'logprobs': None}, id='run-7cab2735-4d0e-4c0c-ab5c-9fcbf8da6ea9-0')

chain.invoke("アイスクリーム", config={"model": "openai"})

AIMessage(content='なぜアイスクリームはいつも冷たいのか?\n\nなぜなら、アイスクリームはクールなやつだから!', response_metadata={'token_usage': {'completion_tokens': 43, 'prompt_tokens': 31, 'total_tokens': 74}, 'model_name': 'gpt-3.5-turbo', 'system_fingerprint': 'fp_b28b39ffa8', 'finish_reason': 'stop', 'logprobs': None}, id='run-0352125e-3a90-4372-911f-5a9ec4554028-0')

chain.invoke("アイスクリーム",config={"model": "anthropic"})

AIMessage(content='なぜアイスクリームはいつも笑っているのか?\nなぜなら、いつもクールなからだだから!', response_metadata={'token_usage': {'completion_tokens': 38, 'prompt_tokens': 31, 'total_tokens': 69}, 'model_name': 'gpt-3.5-turbo', 'system_fingerprint': 'fp_b28b39ffa8', 'finish_reason': 'stop', 'logprobs': None}, id='run-810a3784-6066-447e-b6ea-f14e6fd1f03b-0')

なんだったらこういうのも

chain.invoke("アイスクリーム", config=({"model": "hogehoge"}))

AIMessage(content='なぜアイスクリームはいつも冷たいのか?\n\nなぜなら、冷たくないと「アイス」クリームじゃなくなるから!', response_metadata={'token_usage': {'completion_tokens': 52, 'prompt_tokens': 31, 'total_tokens': 83}, 'model_name': 'gpt-3.5-turbo', 'system_fingerprint': 'fp_b28b39ffa8', 'finish_reason': 'stop', 'logprobs': None}, id='run-1ef57003-7e7d-431f-b05d-5cb14655f499-0')

全く機能していない・・・

で、調べてみた。

なんか書き方が違う。。。

chain.with_config(configurable={"model": "openai"}).invoke("アイスクリーム")

\n\nQ: アイスクリームが好きな人は何者でしょうか?\nA: ジェラートマニアック!

chain.with_config(configurable={"model": "anthropic"}).invoke("アイスクリーム")

AIMessage(content='はい、これはアイスクリームに関するジョークです:\n\nなぜアイスクリーマーは仕事を続けるのか分かりますか? \n\nそれは、彼らは暑い季節を通してしっかり溶けないからです。\n\nこのジョークは、アイスクリームを扱う人々がなぜ仕事を続けられるかという皮肉的なコメントです。暑い季節でもアイスクリームは溶けないため、彼らは仕事を続けられるのだと言っています。少し冗談っぽくて、アイスクリームビジネスに関する遊び心のあるジョークですね。', response_metadata={'id': 'msg_016fHk3bqzkEUfPJHMhRZd6d', 'model': 'claude-3-haiku-20240307', 'stop_reason': 'end_turn', 'stop_sequence': None, 'usage': {'input_tokens': 27, 'output_tokens': 199}}, id='run-f27074ff-4249-4d6e-9c4c-daf778315170-0')

chain.with_config(configurable={"model": "hogehoge"}).invoke("アイスクリーム")

ValueError: Unknown alternative: hogehoge

ちゃんとできたっぽい。

ソースを見る限りはconfigはRunnableConfigで指定しないといけないっぽい。

from langchain_core.runnables import RunnableConfig

chain.invoke("アイスクリーム",config=RunnableConfig(configurable={"model": "anthropic"}))

AIMessage(content='アイスクリームにまつわる面白いジョークがこちらです:\n\n"アイスクリームを食べすぎたら、ぜったいにアイス・クリーミングが始まるから気をつけなきゃね。"\n\nこの冗談は、アイスクリームを食べ過ぎると胃痛になるというネタに基づいています。「アイス・クリーミング」というのは、おなかの調子が悪くなることを表現した言葉遊びです。少しグローリーかもしれませんが、アイスクリームに関するユーモアのある一例としてお楽しみください。', response_metadata={'id': 'msg_012QggXGbV6rQmKhNDGgWz81', 'model': 'claude-3-haiku-20240307', 'stop_reason': 'end_turn', 'stop_sequence': None, 'usage': {'input_tokens': 27, 'output_tokens': 190}}, id='run-97111645-d93a-4759-ab8e-4206ff4f0667-0')

ドキュメントが更新されていないってことなのかしら。。。。

参考)

で最後にFallback。ここはちょっと再現ができなかったのでコードだけ。

(snip)

model = (

chat_openai

.with_fallbacks([anthropic]) # ここ

.configurable_alternatives(

ConfigurableField(id="model"),

default_key="chat_openai",

openai=openai,

anthropic=anthropic,

)

)

(snip)

すべて実装したフルのコードが公式ページの一番下にあるけど、上で少し触れたので割愛。ただ、LCELを使わない場合と比べて圧倒的にコード量も少ないし、見通しもものすごく良いのがよくわかる。

というか自分が以前触れていたのもLCELを使わない場合のコードだし、もう別物としてイチからやり直している気分だなー

LCELの各コンポーネントは、Runnableプロトコルにもとづいて統一されたインタフェースを持っている。

標準インタフェースは以下。

-

stream: レスポンスのストリームをチャンクで返す -

invoke: 入力に対してチェーンを呼び出す -

batch: 入力リストに対してチェーンを呼びだす

これらにそれぞれ非同期メソッドも用意されていて、asyncioのawaitと組み合わせて使用する

-

astream:streamの非同期 -

ainvoke:invokeの非同期 -

abatch:batchの非同期 -

astream_log: 最終的なレスポンスに加えて、中間ステップもストリームで返す。 -

astream_events: チェーンで発生したイベントをストリームで返す(ベータ。langchain-core0.1.14から)

また各コンポーネントは入力と出力のそれぞれに型を持っている。

| コンポーネント | 入力の型 | 出力の型 |

|---|---|---|

| Prompt | 辞書 | PromptValue |

| ChatModel | 単一の文字列/チャットメッセージのリスト/PromptValue | ChatMessage |

| LLM | 単一の文字列/チャットメッセージのリスト/PromptValue | 文字列 |

| OutputParser | LLM/ChatModelの出力 | パーサによって異なる |

| Retriever | 単一の文字列 | ドキュメントのリスト |

| Tool | 単一の文字列や辞書など、ツールによって異なる | ツールによって異なる |

すべてのRunnableコンポーネントは入出力をチェックするためのスキーマ、input_schema/output_schemaが用意されており、これらはコンポーネントの構造からPydanticで自動的に生成される。

シンプルなプロンプト・LLMのチェーンを作成する。

!pip install --upgrade --quiet langchain-core langchain-openai langchain-community

!pip freeze | grep -i langchain

langchain-community==0.0.32

langchain-core==0.1.41

langchain-openai==0.1.2

import os

from google.colab import userdata

os.environ['OPENAI_API_KEY'] = userdata.get('OPENAI_API_KEY')

from langchain_core.prompts import ChatPromptTemplate

from langchain_openai import ChatOpenAI

model = ChatOpenAI()

prompt = ChatPromptTemplate.from_template("{topic}についてのジョークを1つ考えて。")

chain = prompt

チェーンの入出力スキーマを確認。出力は少しインデントを整形した。

chain.input_schema.schema()

{

'title': 'PromptInput',

'type': 'object',

'properties': {

'topic': {

'title': 'Topic',

'type': 'string'

}

}

}

chain.output_schema.schema()

{

'title': 'ChatOpenAIOutput',

'anyOf': [

{

'$ref': '#/definitions/AIMessage'

},

{

'$ref': '#/definitions/HumanMessage'

},

{

'$ref': '#/definitions/ChatMessage'

},

{

'$ref': '#/definitions/SystemMessage'

},

{

'$ref': '#/definitions/FunctionMessage'

},

{

'$ref': '#/definitions/ToolMessage'

}

],

'definitions': {

'AIMessage': {

'title': 'AIMessage',

'description': 'Message from an AI.',

'type': 'object',

'properties': {

'content': {

'title': 'Content',

'anyOf': [

{

'type': 'string'

},

{

'type': 'array',

'items': {

'anyOf': [

{

'type': 'string'

},

{

'type': 'object'

}

]

}

}

]

},

'additional_kwargs': {

'title': 'Additional Kwargs',

'type': 'object'

},

'response_metadata': {

'title': 'Response Metadata',

'type': 'object'

},

'type': {

'title': 'Type',

'default': 'ai',

'enum': [

'ai'

],

'type': 'string'

},

'name': {

'title': 'Name',

'type': 'string'

},

'id': {

'title': 'Id',

'type': 'string'

},

'example': {

'title': 'Example',

'default': False,

'type': 'boolean'

}

},

'required': [

'content'

]

},

'HumanMessage': {

'title': 'HumanMessage',

'description': 'Message from a human.',

'type': 'object',

'properties': {

'content': {

'title': 'Content',

'anyOf': [

{

'type': 'string'

},

{

'type': 'array',

'items': {

'anyOf': [

{

'type': 'string'

},

{

'type': 'object'

}

]

}

}

]

},

'additional_kwargs': {

'title': 'Additional Kwargs',

'type': 'object'

},

'response_metadata': {

'title': 'Response Metadata',

'type': 'object'

},

'type': {

'title': 'Type',

'default': 'human',

'enum': [

'human'

],

'type': 'string'

},

'name': {

'title': 'Name',

'type': 'string'

},

'id': {

'title': 'Id',

'type': 'string'

},

'example': {

'title': 'Example',

'default': False,

'type': 'boolean'

}

},

'required': [

'content'

]

},

'ChatMessage': {

'title': 'ChatMessage',

'description': 'Message that can be assigned an arbitrary speaker (i.e. role).',

'type': 'object',

'properties': {

'content': {

'title': 'Content',

'anyOf': [

{

'type': 'string'

},

{

'type': 'array',

'items': {

'anyOf': [

{

'type': 'string'

},

{

'type': 'object'

}

]

}

}

]

},

'additional_kwargs': {

'title': 'Additional Kwargs',

'type': 'object'

},

'response_metadata': {

'title': 'Response Metadata',

'type': 'object'

},

'type': {

'title': 'Type',

'default': 'chat',

'enum': [

'chat'

],

'type': 'string'

},

'name': {

'title': 'Name',

'type': 'string'

},

'id': {

'title': 'Id',

'type': 'string'

},

'role': {

'title': 'Role',

'type': 'string'

}

},

'required': [

'content',

'role'

]

},

'SystemMessage': {

'title': 'SystemMessage',

'description': 'Message for priming AI behavior, usually passed in as the first of a sequence\nof input messages.',

'type': 'object',

'properties': {

'content': {

'title': 'Content',

'anyOf': [

{

'type': 'string'

},

{

'type': 'array',

'items': {

'anyOf': [

{

'type': 'string'

},

{

'type': 'object'

}

]

}

}

]

},

'additional_kwargs': {

'title': 'Additional Kwargs',

'type': 'object'

},

'response_metadata': {

'title': 'Response Metadata',

'type': 'object'

},

'type': {

'title': 'Type',

'default': 'system',

'enum': [

'system'

],

'type': 'string'

},

'name': {

'title': 'Name',

'type': 'string'

},

'id': {

'title': 'Id',

'type': 'string'

}

},

'required': [

'content'

]

},

'FunctionMessage': {

'title': 'FunctionMessage',

'description': 'Message for passing the result of executing a function back to a model.',

'type': 'object',

'properties': {

'content': {

'title': 'Content',

'anyOf': [

{

'type': 'string'

},

{

'type': 'array',

'items': {

'anyOf': [

{

'type': 'string'

},

{

'type': 'object'

}

]

}

}

]

},

'additional_kwargs': {

'title': 'Additional Kwargs',

'type': 'object'

},

'response_metadata': {

'title': 'Response Metadata',

'type': 'object'

},

'type': {

'title': 'Type',

'default': 'function',

'enum': [

'function'

],

'type': 'string'

},

'name': {

'title': 'Name',

'type': 'string'

},

'id': {

'title': 'Id',

'type': 'string'

}

},

'required': [

'content',

'name'

]

},

'ToolMessage': {

'title': 'ToolMessage',

'description': 'Message for passing the result of executing a tool back to a model.',

'type': 'object',

'properties': {

'content': {

'title': 'Content',

'anyOf': [

{

'type': 'string'

},

{

'type': 'array',

'items': {

'anyOf': [

{

'type': 'string'

},

{

'type': 'object'

}

]

}

}

]

},

'additional_kwargs': {

'title': 'Additional Kwargs',

'type': 'object'

},

'response_metadata': {

'title': 'Response Metadata',

'type': 'object'

},

'type': {

'title': 'Type',

'default': 'tool',

'enum': [

'tool'

],

'type': 'string'

},

'name': {

'title': 'Name',

'type': 'string'

},

'id': {

'title': 'Id',

'type': 'string'

},

'tool_call_id': {

'title': 'Tool Call Id',

'type': 'string'

}

},

'required': [

'content',

'tool_call_id'

]

}

}

}

各コンポーネント単位でも確認できる。以下はプロンプトの入力スキーマ。

prompt.input_schema.schema()

プロンプト→LLMのチェーンなので、当然チェーンの入力スキーマとプロンプトの入力スキーマは同じになる。

{

'title': 'PromptInput',

'type': 'object',

'properties': {

'topic': {

'title': 'Topic',

'type': 'string'

}

}

}

当然ながらチェーンの出力スキーマとLLMの出力スキーマも同じになる。

各メソッドについては前回もやっているものについては割愛。触れていないものだけ少し見ておく。

Async Stream Events (ベータ)

※ベータなので変更される可能性あり。

多分トレーシングやログで使えるものだと思う。ベータだしサラッと動かす程度で。

!pip install -q faiss-cpu

from langchain_community.vectorstores import FAISS

from langchain_core.output_parsers import StrOutputParser

from langchain_core.runnables import RunnablePassthrough

from langchain_core.prompts import ChatPromptTemplate

from langchain_openai import ChatOpenAI

from langchain_openai import OpenAIEmbeddings

template = """\

以下の文脈のみに基づいて質問に回答して下さい:

{context}

質問: {question}

回答: \

"""

prompt = ChatPromptTemplate.from_template(template)

doc = """\

オグリキャップ(欧字名:Oguri Cap、1985年3月27日 - 2010年7月3日)は、日本の競走馬、種牡馬。

主な勝ち鞍は、1988年・1990年の有馬記念、1989年のマイルチャンピオンシップ、1990年の安田記念。\

"""

vectorstore = FAISS.from_texts(

[doc], embedding=OpenAIEmbeddings()

)

retriever = vectorstore.as_retriever()

model = ChatOpenAI()

retrieval_chain = (

{

"context": retriever.with_config(run_name="Docs"),

"question": RunnablePassthrough(),

}

| prompt

| model.with_config(run_name="my_llm")

| StrOutputParser()

)

async for event in retrieval_chain.astream_events(

"オグリキャップの主な勝ち鞍は?", version="v1", include_names=["Docs", "my_llm"]

):

kind = event["event"]

print(f"----- {kind} ----")

if kind == "on_chat_model_stream":

print(event["data"]["chunk"].content, end="\n")

elif kind in {"on_chat_model_start"}:

print("Start Streaming LLM:")

elif kind in {"on_chat_model_end"}:

print("Done streaming LLM.")

elif kind == "on_retriever_end":

print("--")

print("Retrieved the following documents:")

print(event["data"]["output"]["documents"])

elif kind == "on_tool_end":

print(f"Ended tool: {event['name']}")

else:

pass

----- on_retriever_start ----

----- on_retriever_end ----

--

Retrieved the following documents:

[Document(page_content='オグリキャップ(欧字名:Oguri Cap、1985年3月27日 - 2010年7月3日)は、日本の競走馬、種牡馬。\n主な勝ち鞍は、1988年・1990年の有馬記念、1989年のマイルチャンピオンシップ、1990年の安田記念。')]

----- on_chat_model_start ----

Start Streaming LLM:

----- on_chat_model_stream ----

----- on_chat_model_stream ----

198

----- on_chat_model_stream ----

8

----- on_chat_model_stream ----

年

----- on_chat_model_stream ----

・

----- on_chat_model_stream ----

199

----- on_chat_model_stream ----

0

----- on_chat_model_stream ----

年

----- on_chat_model_stream ----

の

----- on_chat_model_stream ----

有

----- on_chat_model_stream ----

馬

----- on_chat_model_stream ----

記

----- on_chat_model_stream ----

念

----- on_chat_model_stream ----

、

----- on_chat_model_stream ----

198

----- on_chat_model_stream ----

9

----- on_chat_model_stream ----

年

----- on_chat_model_stream ----

の

----- on_chat_model_stream ----

マ

----- on_chat_model_stream ----

イ

----- on_chat_model_stream ----

ル

----- on_chat_model_stream ----

チ

----- on_chat_model_stream ----

ャ

----- on_chat_model_stream ----

ン

----- on_chat_model_stream ----

ピ

----- on_chat_model_stream ----

オ

----- on_chat_model_stream ----

ン

----- on_chat_model_stream ----

シ

----- on_chat_model_stream ----

ッ

----- on_chat_model_stream ----

プ

----- on_chat_model_stream ----

、

----- on_chat_model_stream ----

199

----- on_chat_model_stream ----

0

----- on_chat_model_stream ----

年

----- on_chat_model_stream ----

の

----- on_chat_model_stream ----

安

----- on_chat_model_stream ----

田

----- on_chat_model_stream ----

記

----- on_chat_model_stream ----

念

----- on_chat_model_stream ----

----- on_chat_model_end ----

Done streaming LLM.

Async Stream Intermediate Steps

すべてのRunnableあh中間ステップを生成するための.astream_log()を実装している。ユーザに進行状態を示す・中間結果を表示・デバッグなどで使える。すべてのステップをストリームすることもできるし、タグ・名前・メタデータなどで含む・含まないも制御できる。

JSONPatchがストリームで流れてくるらしい。

async for chunk in retrieval_chain.astream_log(

"オグリキャップの主な勝ち鞍は?", include_names=["Docs"]

):

print("-" * 40)

print(chunk)

----------------------------------------

RunLogPatch({'op': 'replace',

'path': '',

'value': {'final_output': None,

'id': '298f2298-70ea-4993-a5a1-f059c4f8eca8',

'logs': {},

'name': 'RunnableSequence',

'streamed_output': [],

'type': 'chain'}})

----------------------------------------

RunLogPatch({'op': 'add',

'path': '/logs/Docs',

'value': {'end_time': None,

'final_output': None,

'id': '3184e2a9-2381-471e-a2e3-b12cb8b9ab1d',

'metadata': {},

'name': 'Docs',

'start_time': '2024-04-11T18:55:03.668+00:00',

'streamed_output': [],

'streamed_output_str': [],

'tags': ['map:key:context', 'FAISS', 'OpenAIEmbeddings'],

'type': 'retriever'}})

----------------------------------------

RunLogPatch({'op': 'add',

'path': '/logs/Docs/final_output',

'value': {'documents': [Document(page_content='オグリキャップ(欧字名:Oguri Cap、1985年3月27日 - 2010年7月3日)は、日本の競走馬、種牡馬。\n主な勝ち鞍は、1988年・1990年の有馬記念、1989年のマイルチャンピオンシップ、1990年の安田記念。')]}},

{'op': 'add',

'path': '/logs/Docs/end_time',

'value': '2024-04-11T18:55:03.991+00:00'})

----------------------------------------

RunLogPatch({'op': 'add', 'path': '/streamed_output/-', 'value': ''},

{'op': 'replace', 'path': '/final_output', 'value': ''})

----------------------------------------

RunLogPatch({'op': 'add', 'path': '/streamed_output/-', 'value': '198'},

{'op': 'replace', 'path': '/final_output', 'value': '198'})

----------------------------------------

RunLogPatch({'op': 'add', 'path': '/streamed_output/-', 'value': '8'},

{'op': 'replace', 'path': '/final_output', 'value': '1988'})

----------------------------------------

RunLogPatch({'op': 'add', 'path': '/streamed_output/-', 'value': '年'},

{'op': 'replace', 'path': '/final_output', 'value': '1988年'})

----------------------------------------

RunLogPatch({'op': 'add', 'path': '/streamed_output/-', 'value': '・'},

{'op': 'replace', 'path': '/final_output', 'value': '1988年・'})

----------------------------------------

RunLogPatch({'op': 'add', 'path': '/streamed_output/-', 'value': '199'},

{'op': 'replace', 'path': '/final_output', 'value': '1988年・199'})

----------------------------------------

RunLogPatch({'op': 'add', 'path': '/streamed_output/-', 'value': '0'},

{'op': 'replace', 'path': '/final_output', 'value': '1988年・1990'})

----------------------------------------

RunLogPatch({'op': 'add', 'path': '/streamed_output/-', 'value': '年'},

{'op': 'replace', 'path': '/final_output', 'value': '1988年・1990年'})

----------------------------------------

RunLogPatch({'op': 'add', 'path': '/streamed_output/-', 'value': 'の'},

{'op': 'replace', 'path': '/final_output', 'value': '1988年・1990年の'})

----------------------------------------

RunLogPatch({'op': 'add', 'path': '/streamed_output/-', 'value': '有'},

{'op': 'replace', 'path': '/final_output', 'value': '1988年・1990年の有'})

----------------------------------------

RunLogPatch({'op': 'add', 'path': '/streamed_output/-', 'value': '馬'},

{'op': 'replace', 'path': '/final_output', 'value': '1988年・1990年の有馬'})

----------------------------------------

RunLogPatch({'op': 'add', 'path': '/streamed_output/-', 'value': '記'},

{'op': 'replace', 'path': '/final_output', 'value': '1988年・1990年の有馬記'})

----------------------------------------

RunLogPatch({'op': 'add', 'path': '/streamed_output/-', 'value': '念'},

{'op': 'replace', 'path': '/final_output', 'value': '1988年・1990年の有馬記念'})

(snip)

diff=Falseをつけるとインクリメンタルにストリームされる。

async for chunk in retrieval_chain.astream_log(

"オグリキャップの主な勝ち鞍は?", include_names=["Docs"], diff=False

):

print("-" * 70)

print(chunk)

----------------------------------------------------------------------

RunLog({'final_output': None,

'id': '0f08bd20-8065-4038-81dc-75d42fb2f039',

'logs': {},

'name': 'RunnableSequence',

'streamed_output': [],

'type': 'chain'})

----------------------------------------------------------------------

RunLog({'final_output': None,

'id': '0f08bd20-8065-4038-81dc-75d42fb2f039',

'logs': {'Docs': {'end_time': None,

'final_output': None,

'id': '7f66132d-e3da-43c5-a8c6-e4dbb29d0305',

'metadata': {},

'name': 'Docs',

'start_time': '2024-04-11T18:58:33.186+00:00',

'streamed_output': [],

'streamed_output_str': [],

'tags': ['map:key:context', 'FAISS', 'OpenAIEmbeddings'],

'type': 'retriever'}},

'name': 'RunnableSequence',

'streamed_output': [],

'type': 'chain'})

----------------------------------------------------------------------

RunLog({'final_output': None,

'id': '0f08bd20-8065-4038-81dc-75d42fb2f039',

'logs': {'Docs': {'end_time': '2024-04-11T18:58:33.401+00:00',

'final_output': {'documents': [Document(page_content='オグリキャップ(欧字名:Oguri Cap、1985年3月27日 - 2010年7月3日)は、日本の競走馬、種牡馬。\n主な勝ち鞍は、1988年・1990年の有馬記念、1989年のマイルチャンピオンシップ、1990年の安田記念。')]},

'id': '7f66132d-e3da-43c5-a8c6-e4dbb29d0305',

'metadata': {},

'name': 'Docs',

'start_time': '2024-04-11T18:58:33.186+00:00',

'streamed_output': [],

'streamed_output_str': [],

'tags': ['map:key:context', 'FAISS', 'OpenAIEmbeddings'],

'type': 'retriever'}},

'name': 'RunnableSequence',

'streamed_output': [],

'type': 'chain'})

----------------------------------------------------------------------

RunLog({'final_output': '',

'id': '0f08bd20-8065-4038-81dc-75d42fb2f039',

'logs': {'Docs': {'end_time': '2024-04-11T18:58:33.401+00:00',

'final_output': {'documents': [Document(page_content='オグリキャップ(欧字名:Oguri Cap、1985年3月27日 - 2010年7月3日)は、日本の競走馬、種牡馬。\n主な勝ち鞍は、1988年・1990年の有馬記念、1989年のマイルチャンピオンシップ、1990年の安田記念。')]},

'id': '7f66132d-e3da-43c5-a8c6-e4dbb29d0305',

'metadata': {},

'name': 'Docs',

'start_time': '2024-04-11T18:58:33.186+00:00',

'streamed_output': [],

'streamed_output_str': [],

'tags': ['map:key:context', 'FAISS', 'OpenAIEmbeddings'],

'type': 'retriever'}},

'name': 'RunnableSequence',

'streamed_output': [''],

'type': 'chain'})

----------------------------------------------------------------------

RunLog({'final_output': '198',

'id': '0f08bd20-8065-4038-81dc-75d42fb2f039',

'logs': {'Docs': {'end_time': '2024-04-11T18:58:33.401+00:00',

'final_output': {'documents': [Document(page_content='オグリキャップ(欧字名:Oguri Cap、1985年3月27日 - 2010年7月3日)は、日本の競走馬、種牡馬。\n主な勝ち鞍は、1988年・1990年の有馬記念、1989年のマイルチャンピオンシップ、1990年の安田記念。')]},

'id': '7f66132d-e3da-43c5-a8c6-e4dbb29d0305',

'metadata': {},

'name': 'Docs',

'start_time': '2024-04-11T18:58:33.186+00:00',

'streamed_output': [],

'streamed_output_str': [],

'tags': ['map:key:context', 'FAISS', 'OpenAIEmbeddings'],

'type': 'retriever'}},

'name': 'RunnableSequence',

'streamed_output': ['', '198'],

'type': 'chain'})

----------------------------------------------------------------------

RunLog({'final_output': '1988',

'id': '0f08bd20-8065-4038-81dc-75d42fb2f039',

'logs': {'Docs': {'end_time': '2024-04-11T18:58:33.401+00:00',

'final_output': {'documents': [Document(page_content='オグリキャップ(欧字名:Oguri Cap、1985年3月27日 - 2010年7月3日)は、日本の競走馬、種牡馬。\n主な勝ち鞍は、1988年・1990年の有馬記念、1989年のマイルチャンピオンシップ、1990年の安田記念。')]},

'id': '7f66132d-e3da-43c5-a8c6-e4dbb29d0305',

'metadata': {},

'name': 'Docs',

'start_time': '2024-04-11T18:58:33.186+00:00',

'streamed_output': [],

'streamed_output_str': [],

'tags': ['map:key:context', 'FAISS', 'OpenAIEmbeddings'],

'type': 'retriever'}},

'name': 'RunnableSequence',

'streamed_output': ['', '198', '8'],

'type': 'chain'})

----------------------------------------------------------------------

RunLog({'final_output': '1988年',

'id': '0f08bd20-8065-4038-81dc-75d42fb2f039',

'logs': {'Docs': {'end_time': '2024-04-11T18:58:33.401+00:00',

'final_output': {'documents': [Document(page_content='オグリキャップ(欧字名:Oguri Cap、1985年3月27日 - 2010年7月3日)は、日本の競走馬、種牡馬。\n主な勝ち鞍は、1988年・1990年の有馬記念、1989年のマイルチャンピオンシップ、1990年の安田記念。')]},

'id': '7f66132d-e3da-43c5-a8c6-e4dbb29d0305',

'metadata': {},

'name': 'Docs',

'start_time': '2024-04-11T18:58:33.186+00:00',

'streamed_output': [],

'streamed_output_str': [],

'tags': ['map:key:context', 'FAISS', 'OpenAIEmbeddings'],

'type': 'retriever'}},

'name': 'RunnableSequence',

'streamed_output': ['', '198', '8', '年'],

'type': 'chain'})

----------------------------------------------------------------------

RunLog({'final_output': '1988年・',

'id': '0f08bd20-8065-4038-81dc-75d42fb2f039',

'logs': {'Docs': {'end_time': '2024-04-11T18:58:33.401+00:00',

'final_output': {'documents': [Document(page_content='オグリキャップ(欧字名:Oguri Cap、1985年3月27日 - 2010年7月3日)は、日本の競走馬、種牡馬。\n主な勝ち鞍は、1988年・1990年の有馬記念、1989年のマイルチャンピオンシップ、1990年の安田記念。')]},

'id': '7f66132d-e3da-43c5-a8c6-e4dbb29d0305',

'metadata': {},

'name': 'Docs',

'start_time': '2024-04-11T18:58:33.186+00:00',

'streamed_output': [],

'streamed_output_str': [],

'tags': ['map:key:context', 'FAISS', 'OpenAIEmbeddings'],

'type': 'retriever'}},

'name': 'RunnableSequence',

'streamed_output': ['', '198', '8', '年', '・'],

'type': 'chain'})

----------------------------------------------------------------------

RunLog({'final_output': '1988年・199',

'id': '0f08bd20-8065-4038-81dc-75d42fb2f039',

'logs': {'Docs': {'end_time': '2024-04-11T18:58:33.401+00:00',

'final_output': {'documents': [Document(page_content='オグリキャップ(欧字名:Oguri Cap、1985年3月27日 - 2010年7月3日)は、日本の競走馬、種牡馬。\n主な勝ち鞍は、1988年・1990年の有馬記念、1989年のマイルチャンピオンシップ、1990年の安田記念。')]},

'id': '7f66132d-e3da-43c5-a8c6-e4dbb29d0305',

'metadata': {},

'name': 'Docs',

'start_time': '2024-04-11T18:58:33.186+00:00',

'streamed_output': [],

'streamed_output_str': [],

'tags': ['map:key:context', 'FAISS', 'OpenAIEmbeddings'],

'type': 'retriever'}},

'name': 'RunnableSequence',

'streamed_output': ['', '198', '8', '年', '・', '199'],

'type': 'chain'})

(snip)

Parallelism

並列リクエストはRunnableParallelを使う

from langchain_core.runnables import RunnableParallel

from langchain_core.prompts import ChatPromptTemplate

from langchain_openai import ChatOpenAI

model = ChatOpenAI()

chain1 = ChatPromptTemplate.from_template("{topic}に付いてのジョークを1つ考えて") | model

chain2 = (

ChatPromptTemplate.from_template("{topic}についての短い(2行)の詩を書いて") | model

)

combined = RunnableParallel(joke=chain1, poem=chain2)

単体で実行してみる。

%%time

chain1.invoke({"topic": "アイスクリーム"})

CPU times: user 41.4 ms, sys: 813 µs, total: 42.3 ms

Wall time: 852 ms

AIMessage(content='アイスクリームは、冷たくても心は温かい!', response_metadata={'token_usage': {'completion_tokens': 22, 'prompt_tokens': 29, 'total_tokens': 51}, 'model_name': 'gpt-3.5-turbo', 'system_fingerprint': 'fp_b28b39ffa8', 'finish_reason': 'stop', 'logprobs': None}, id='run-f5f4f8e1-ce7a-4f01-9848-12a028050613-0')

%%time

chain2.invoke({"topic": "アイスクリーム"})

CPU times: user 23.7 ms, sys: 1.21 ms, total: 24.9 ms

Wall time: 789 ms

AIMessage(content='夏の日に\n冷たい甘味\u3000幸せ溶ける', response_metadata={'token_usage': {'completion_tokens': 22, 'prompt_tokens': 35, 'total_tokens': 57}, 'model_name': 'gpt-3.5-turbo', 'system_fingerprint': 'fp_b28b39ffa8', 'finish_reason': 'stop', 'logprobs': None}, id='run-663fac17-393d-4c5d-afec-7eb952cba783-0')

並列実行

%%time

combined.invoke({"topic": "アイスクリーム"})

CPU times: user 42.1 ms, sys: 7.17 ms, total: 49.3 ms

Wall time: 886 ms

{'joke': AIMessage(content='アイスクリームが嫌いな人は、クールな人とは言えないよ!', response_metadata={'token_usage': {'completion_tokens': 28, 'prompt_tokens': 29, 'total_tokens': 57}, 'model_name': 'gpt-3.5-turbo', 'system_fingerprint': 'fp_b28b39ffa8', 'finish_reason': 'stop', 'logprobs': None}, id='run-3b73e12b-0abb-4698-86d0-df1737eb5711-0'),

'poem': AIMessage(content='冷たい舌で溶ける\n甘い夢を追いかける', response_metadata={'token_usage': {'completion_tokens': 24, 'prompt_tokens': 35, 'total_tokens': 59}, 'model_name': 'gpt-3.5-turbo', 'system_fingerprint': 'fp_b28b39ffa8', 'finish_reason': 'stop', 'logprobs': None}, id='run-49d5c600-d60b-4322-8426-f67ea7cda82b-0')}

バッチで実行してみる。

%%time

chain1.batch([{"topic": "アイスクリーム"}, {"topic": "チョコレート"}])

CPU times: user 62.5 ms, sys: 11.7 ms, total: 74.2 ms

Wall time: 1.32 s

[AIMessage(content='なぜアイスクリームはいつも冷たいままなのか?なぜなら、溶けるとクリームのようになってしまうからだ!', response_metadata={'token_usage': {'completion_tokens': 51, 'prompt_tokens': 29, 'total_tokens': 80}, 'model_name': 'gpt-3.5-turbo', 'system_fingerprint': 'fp_b28b39ffa8', 'finish_reason': 'stop', 'logprobs': None}, id='run-088aec9b-c2a0-4071-ae1c-6e63a327894d-0'),

AIMessage(content='Why did the chocolate go to the doctor?\n\nBecause it was feeling fudged up!', response_metadata={'token_usage': {'completion_tokens': 18, 'prompt_tokens': 27, 'total_tokens': 45}, 'model_name': 'gpt-3.5-turbo', 'system_fingerprint': 'fp_b28b39ffa8', 'finish_reason': 'stop', 'logprobs': None}, id='run-e00fd48a-a6e7-459c-9382-aedc4def7e1b-0')]

%%time

chain2.batch([{"topic": "アイスクリーム"}, {"topic": "チョコレート"}])

CPU times: user 42 ms, sys: 5.1 ms, total: 47.1 ms

Wall time: 945 ms

[AIMessage(content='甘い氷、口の中で溶ける\n夏の日を彩る至福のひととき', response_metadata={'token_usage': {'completion_tokens': 32, 'prompt_tokens': 35, 'total_tokens': 67}, 'model_name': 'gpt-3.5-turbo', 'system_fingerprint': 'fp_b28b39ffa8', 'finish_reason': 'stop', 'logprobs': None}, id='run-b36a1746-4a19-4fe6-9b40-b04fb2a844f9-0'),

AIMessage(content='甘く溶ける\n口の中で幸せ満ちる', response_metadata={'token_usage': {'completion_tokens': 19, 'prompt_tokens': 33, 'total_tokens': 52}, 'model_name': 'gpt-3.5-turbo', 'system_fingerprint': 'fp_b28b39ffa8', 'finish_reason': 'stop', 'logprobs': None}, id='run-24975d44-0bc9-437f-8968-08e74fc28d54-0')]

%%time

combined.batch([{"topic": "アイスクリーム"}, {"topic": "チョコレート"}])

CPU times: user 79.6 ms, sys: 5.77 ms, total: 85.3 ms

Wall time: 1.13 s

[{'joke': AIMessage(content='アイスクリームがビジネスマンになったら、毎日が忙しくてバニランドに行く時間もないかもしれない!', response_metadata={'token_usage': {'completion_tokens': 49, 'prompt_tokens': 29, 'total_tokens': 78}, 'model_name': 'gpt-3.5-turbo', 'system_fingerprint': 'fp_b28b39ffa8', 'finish_reason': 'stop', 'logprobs': None}, id='run-7502d217-583d-49d7-ac60-968e54b5edc0-0'),

'poem': AIMessage(content='甘い冷たさ\n夏の日を涼む', response_metadata={'token_usage': {'completion_tokens': 17, 'prompt_tokens': 35, 'total_tokens': 52}, 'model_name': 'gpt-3.5-turbo', 'system_fingerprint': 'fp_b28b39ffa8', 'finish_reason': 'stop', 'logprobs': None}, id='run-426e420c-4d29-438f-9365-36304d85c016-0')},

{'joke': AIMessage(content="Why did the chocolate go to the therapist?\n\nBecause it just couldn't seem to break out of its shell!", response_metadata={'token_usage': {'completion_tokens': 22, 'prompt_tokens': 27, 'total_tokens': 49}, 'model_name': 'gpt-3.5-turbo', 'system_fingerprint': 'fp_b28b39ffa8', 'finish_reason': 'stop', 'logprobs': None}, id='run-36569f97-42e2-47fb-9c40-37fae271b29c-0'),

'poem': AIMessage(content='甘い誘惑\n口溶けの魔法', response_metadata={'token_usage': {'completion_tokens': 17, 'prompt_tokens': 33, 'total_tokens': 50}, 'model_name': 'gpt-3.5-turbo', 'system_fingerprint': 'fp_b28b39ffa8', 'finish_reason': 'stop', 'logprobs': None}, id='run-44b12f98-72c2-4202-8d91-c98789deb238-0')}]

短い時間で処理できていることから並列実行が効いているのがわかる

Primitives

LCELで使えるコンポーネントは以下

これ以外にもユーティリティ的なコンポーネントが用意されている。これをプリミティブという。

プリミティブを使うと以下のようなことができる。

- データの受け渡しやフォーマット

- 引数のバインド

- カスタムロジックの呼び出し

プリミティブとしてあげられているのは以下。

- Sequences: Runnableをチェーンにする

- Binding: 実行時の引数をアタッチする

- Passthrough: 入力をパススルーする

- 実行時にチェーン内の設定を変更する

- Parallel: データをフォーマットする

- Lambda: カスタム関数を実行する

- Assign: 値を状態に追加する

順に見ていく

Sequences: Runnableをチェーンにする

!pip install --upgrade --quiet langchain-core langchain-openai

!pip freeze | grep -i langchain

langchain-core==0.1.42

langchain-openai==0.1.3

import os

from google.colab import userdata

os.environ['OPENAI_API_KEY'] = userdata.get('OPENAI_API_KEY')

from langchain_core.prompts import ChatPromptTemplate

from langchain_openai import ChatOpenAI

from langchain_core.output_parsers import StrOutputParser

model = ChatOpenAI()

prompt = ChatPromptTemplate.from_template("{topic}についてのジョークを1つ考えて。")

chain = prompt | model | StrOutputParser()

chain.invoke({"topic": "アイスクリーム"})

なぜアイスクリームはいつも冷たいのか?\n- なぜなら、"アイス"だから!

RunnableのチェーンはRunnableSequenceとなり、Runnableと同じくinvokeができる。

print(type(chain))

<class 'langchain_core.runnables.base.RunnableSequence'>

さらにチェーンを繋いでチェーンを作ることもできる。ただしRunnable同士の入出力をあわせる必要はある。

from langchain_core.prompts import ChatPromptTemplate

from langchain_openai import ChatOpenAI

from langchain_core.output_parsers import StrOutputParser

model = ChatOpenAI()

prompt = ChatPromptTemplate.from_template("{topic}についてのジョークを1つ考えて。")

chain = (

prompt

| model

| StrOutputParser()

)

analysis_prompt = ChatPromptTemplate.from_template("このジョークは笑えるどうかを説明して: {joke}")

composed_chain = (

{"joke": chain}

| analysis_prompt

| model

| StrOutputParser()

)

このジョークは、アイスクリームが冷たいという普通の理由ではなく、ジョーク自体が冷たいというユーモアが含まれています。言葉遊びを楽しむ人には笑えるかもしれません。

途中の状態も含めて見てみる。

async for event in composed_chain.astream_events(

{"topic": "アイスクリーム"}, version="v1"

):

kind = event["event"]

if kind == "on_chat_model_stream":

print(event["data"]["chunk"].content, end="")

elif kind in {"on_chat_model_start"}:

print()

print("Start LLM:")

elif kind in {"on_chat_model_end"}:

print()

print("End LLM")

print()

elif kind in {"on_prompt_start"}:

print("Start Prompt:")

print(event["data"])

print()

elif kind in {"on_prompt_end"}:

print("End prompt")

print(event["data"]["output"].to_messages())

else:

pass

Start Prompt:

{'input': {'topic': 'アイスクリーム'}}

End prompt

[HumanMessage(content='アイスクリームについてのジョークを1つ考えて。')]

Start LLM:

なぜアイスクリームはいつも冷たいのか? なぜなら、熱いと「アイス、アイス、走れ!」から始まるからだ!

End LLM

Start Prompt:

{'input': {'joke': 'なぜアイスクリームはいつも冷たいのか?\u3000なぜなら、熱いと「アイス、アイス、走れ!」から始まるからだ!'}}

End prompt

[HumanMessage(content='このジョークは笑えるどうかを説明して: なぜアイスクリームはいつも冷たいのか?\u3000なぜなら、熱いと「アイス、アイス、走れ!」から始まるからだ!')]

Start LLM:

このジョークは、アイスクリームがいつも冷たい理由を、アイスクリーム自体に対して人間の感情や行動を重ねて面白おかしく表現している点が笑いを誘う要素です。通常、アイスクリームが冷たいのはその性質によるものですが、ここではそれを熱いという感情や行動に例えて、意外性とユーモアを持って表現しています。そのため、聞いた人が予想外の展開に笑いがこみ上げるでしょう。

End LLM

関数を実行させる事もできる。ただしストリーミングとかの場合は使い方を注意しないといけない。

composed_chain_with_lambda = (

chain

| (lambda input: {"joke": input})

| analysis_prompt

| model

| StrOutputParser()

)

composed_chain_with_lambda.invoke({"topic": "アイスクリーム"})

このジョークは、アイスクリームが冷たいから元気がいいというユーモアを含んでいます。アイスクリームはクールで元気がある食べ物であるという意外な視点からのジョークであり、その意外性から笑いが生まれる要素があります。また、アイスクリームがいつも元気がいいという言い方も、人間の感情や様子を食べ物に例えているところも面白さを引き立てています。

パイプでつないでいるものは.pipe()メソッドでもつなげる。

composed_chain_with_pipe = (

chain

.pipe((lambda input: {"joke": input}))

.pipe(analysis_prompt)

.pipe(model)

.pipe(StrOutputParser())

)

composed_chain_with_pipe.invoke({"topic": "アイスクリーム"})

このジョークは、アイスクリームが自分で歩いていくことが不可能なことを前提にして、そのようなことが可能になった場合のユーモアを描写しています。また、"クリーム・パフェレーション"という造語が面白おかしいという点も笑いを生んでいます。全体的に、非現実的でありながらも想像力を掻き立てる要素があり、笑いを誘う要素が含まれています。

Parallel: データをフォーマットする

Parallelなんだけど、なんでデータのフォーマットの話なのかなと思って見てみた。

RunnableParallelプリミティブは基本的にdictで、その値はrunnable(または関数のようにrunnableに強制できるもの)です。このプリミティブはすべての値を並列に実行し、各値はRunnableParallelの全体的な入力で呼び出されます。最終的な戻り値は、各値の結果を適切なキーの下に持つdictです。

これは、操作を並列化するのに便利だが、あるRunnableの出力を操作して、シーケンスの次のRunnableの入力フォーマットと一致させるのにも役立ちます

なるほど、入出力データをフォーマットできる。

!pip install --upgrade --quiet langchain-core langchain-openai langchain_community faiss-cpu

!pip freeze | grep -i langchain

langchain-community==0.0.32

langchain-core==0.1.42

langchain-openai==0.1.3

import os

from google.colab import userdata

os.environ['OPENAI_API_KEY'] = userdata.get('OPENAI_API_KEY')

texts = []

texts.append("""\

イクイノックス(欧字名:Equinox、2019年3月23日 - )は、日本の競走馬・種牡馬。

主な勝ち鞍は、2022年・2023年の天皇賞(秋)連覇、2022年の有馬記念、2023年のドバイシーマクラシック、宝塚記念、ジャパンカップ。\

""")

texts.append("""\

オグリキャップ(欧字名:Oguri Cap、1985年3月27日 - 2010年7月3日)は、日本の競走馬、種牡馬。

主な勝ち鞍は、1988年・1990年の有馬記念、1989年のマイルチャンピオンシップ、1990年の安田記念。\

""")

texts.append("""\

ドウデュース(欧字名:Do Deuce、2019年5月7日 - )は、日本の競走馬。

主な勝ち鞍は、2021年の朝日杯フューチュリティステークス、2022年の東京優駿、2023年の有馬記念。\

""")

from langchain_community.vectorstores import FAISS

from langchain_core.output_parsers import StrOutputParser

from langchain_core.prompts import ChatPromptTemplate

from langchain_core.runnables import RunnablePassthrough

from langchain_openai import ChatOpenAI, OpenAIEmbeddings

vectorstore = FAISS.from_texts(

texts, embedding=OpenAIEmbeddings()

)

retriever = vectorstore.as_retriever()

template = """\

以下のコンテキストにもとづいて、質問に答えてください:

{context}

質問: {question}

回答: \

"""

prompt = ChatPromptTemplate.from_template(template)

model = ChatOpenAI()

retrieval_chain = (

{"context": retriever, "question": RunnablePassthrough()}

| prompt

| model

| StrOutputParser()

)

retrieval_chain.invoke("イクイノックスの生年月日は?")

2019年3月23日

なるほど、たしかに辞書で渡していたわ。

retrieval_chain = (

{"context": retriever, "question": RunnablePassthrough()}

| prompt

| model

| StrOutputParser()

)

こういう書き方もできる。

retrieval_chain = (

RunnableParallel({"context": retriever, "question": RunnablePassthrough()})

| prompt

| model

| StrOutputParser()

)

retrieval_chain = (

RunnableParallel(context=retriever, question=RunnablePassthrough())

| prompt

| model

| StrOutputParser()

)

itemgetterを使ってこういう書き方もできる、というかitemgetter使ったことないわ。

なるほど。

from operator import itemgetter

from langchain_community.vectorstores import FAISS

from langchain_core.output_parsers import StrOutputParser

from langchain_core.prompts import ChatPromptTemplate

from langchain_core.runnables import RunnablePassthrough

from langchain_openai import ChatOpenAI, OpenAIEmbeddings

vectorstore = FAISS.from_texts(

texts, embedding=OpenAIEmbeddings()

)

retriever = vectorstore.as_retriever()

template = """\

以下のコンテキストにもとづいて、質問に答えてください:

{context}

質問: {question}

回答に使用する言語: {language}

回答: \

"""

prompt = ChatPromptTemplate.from_template(template)

chain = (

{

"context": itemgetter("question") | retriever,

"question": itemgetter("question"),

"language": itemgetter("language"),

}

| prompt

| model

| StrOutputParser()

)

chain.invoke({"question": "イクイノックスの主な勝ち鞍は?", "language":"スペイン語"})

Las principales victorias de Equinox son la doble victoria en el Tenno Sho (Otoño) en 2022 y 2023, la victoria en la Copa Arima Kinen en 2022, la Dubai Sheema Classic en 2023, el Takarazuka Kinen y la Japan Cup en 2023.

questionとlanguageはパススルーされるのね

これ以降の箇所は以下と重複するのでスキップ

Binding: 実行時に引数をアタッチする

Runnableシーケンス内のRunnableを、シーケンス内の先行するRunnableの出力の一部でもなく、ユーザー入力の一部でもない定数引数で呼び出したいことがある。Runnable.bind()を使って、これらの引数を渡すことができる。

!pip install --upgrade --quiet langchain-core langchain-openai

!pip freeze | grep -i langchain

langchain-core==0.1.42

langchain-openai==0.1.3

import os

from google.colab import userdata

os.environ['OPENAI_API_KEY'] = userdata.get('OPENAI_API_KEY')

from langchain_core.output_parsers import StrOutputParser

from langchain_core.prompts import ChatPromptTemplate

from langchain_core.runnables import RunnablePassthrough

from langchain_openai import ChatOpenAI

prompt = ChatPromptTemplate.from_messages(

[

(

"system",

"代数記号を使って次の方程式を書き出しそれを解きなさい。書式は以下を使用しなさい。\n\nEQUATION:...\n\nSOLUTION:...\n\n"

),

(

"human",

"{equation_statement}"

),

]

)

model = ChatOpenAI(temperature=0)

runnable = (

{"equation_statement": RunnablePassthrough()}

| prompt

| model

| StrOutputParser()

)

print(runnable.invoke("xの3乗+7=12"))

EQUATION: ( x^3 + 7 = 12 )

SOLUTION:

( x^3 = 12 - 7 = 5 )( x = \sqrt[3]{5} )

モデル実行時にstopワードを追加する

runnable = (

{"equation_statement": RunnablePassthrough()}

| prompt

| model.bind(stop="SOLUTION")

| StrOutputParser()

)

print(runnable.invoke("xの3乗+7=12"))

EQUATION: ( x^3 + 7 = 12 )

stopワードで指定したSOLUTIONのところで出力が終了する。

Function Callingの関数をアタッチする。

function = {

"name": "solver",

"description": "方程式を立てて解く",

"parameters": {

"type": "object",

"properties": {

"equation": {

"type": "string",

"description": "方程式の代数的表現",

},

"solution": {

"type": "string",

"description": "方程式の解",

},

},

"required": ["equation", "solution"],

},

}

prompt = ChatPromptTemplate.from_messages(

[

(

"system",

"代数記号を使って次の方程式を書き出し、それを解きなさい。",

),

("human", "{equation_statement}"),

]

)

model = ChatOpenAI(model="gpt-4-turbo-2024-04-09", temperature=0).bind(

function_call={"name": "solver"}, functions=[function]

)

runnable = (

{"equation_statement": RunnablePassthrough()}

| prompt

| model

)

print(runnable.invoke("xの3乗+7=12"))

content='' additional_kwargs={'function_call': {'arguments': '{"equation":"x^3 + 7 = 12","solution":"x^3 = 5"}', 'name': 'solver'}} response_metadata={'token_usage': {'completion_tokens': 23, 'prompt_tokens': 118, 'total_tokens': 141}, 'model_name': 'gpt-4-turbo-2024-04-09', 'system_fingerprint': 'fp_6fcb0929db', 'finish_reason': 'stop', 'logprobs': None} id='run-83ccf762-c34b-4a5a-bad1-0a9ee6b9a975-0'

ということは、こういう書き方もできるはず。

model = ChatOpenAI(model="gpt-4-turbo-2024-04-09", temperature=0)

runnable = (

{"equation_statement": RunnablePassthrough()}

| prompt

| model.bind(function_call={"name": "solver"}, functions=[function])

)

print(runnable.invoke("xの3乗+7=12"))

Tool Call、つまりParallel Function Callingでもできる。

tools = [

{

"type": "function",

"function": {

"name": "get_current_temperature",

"description": "指定された都市の現在の気温を取得する",

"parameters": {

"type": "object",

"properties": {

"location": {

"type": "string",

"description": "都市名を英語で指定。例) San Francisco, Tokyo.",

},

"unit": {

"type": "string",

"enum": ["fahrenheit", "celsius"],

"description": "気温の単位。ユーザの言語や位置情報から判断する。",

},

},

"required": ["location", "unit"],

}

}

},

{

"type": "function",

"function": {

"name": "get_current_weather",

"description": "指定された都市の現在の天気を取得する",

"input_schema": {

"type": "object",

"properties": {

"location": {

"type": "string",

"description": "都市名を英語で指定。例) San Francisco, Tokyo.",

},

},

"required": ["location"]

}

}

}

]

model = ChatOpenAI(model="gpt-3.5-turbo-0125").bind(tools=tools)

response = model.invoke("サンフランシスコの天気と気温を教えて")

response.additional_kwargs["tool_calls"]

[{'id': 'call_aOjTvxAyFQgDthpqmZwkKumy',

'function': {'arguments': '{}', 'name': 'get_current_weather'},

'type': 'function'},

{'id': 'call_3jNSjN9WWeAKgtJcHRBbNRKW',

'function': {'arguments': '{"location": "San Francisco", "unit": "celsius"}',

'name': 'get_current_temperature'},

'type': 'function'}]

Lambda: カスタム関数を実行する

パイプラインでは任意の関数を使用することができる。

これらの関数への入力は、すべて単一の引数である必要があることに注意してください。複数の引数を受け取る関数がある場合は、単一の入力を受け取り、それを複数の引数に展開するラッパーを書く必要があります。

RunnableLambdaを使う。

!pip install --upgrade --quiet langchain-core langchain-openai langchain-community

!pip freeze | grep -i langchain

langchain-community==0.0.32

langchain-core==0.1.42

langchain-openai==0.1.3

import os

from google.colab import userdata

os.environ['OPENAI_API_KEY'] = userdata.get('OPENAI_API_KEY')

from operator import itemgetter

from langchain_core.prompts import ChatPromptTemplate

from langchain_core.runnables import RunnableLambda

from langchain_openai import ChatOpenAI

def length_function(text):

""" 単一の文字列の長さを返す """

return len(text)

def _multiple_length_function(text1, text2):

""" 2つの文字列の長さの乗を返す """

return len(text1) * len(text2)

def multiple_length_function(_dict):

""" _multiple_length_functionに渡すためのラッパー """

return _multiple_length_function(_dict["text1"], _dict["text2"])

prompt = ChatPromptTemplate.from_template("{a} + {b} は?")

model = ChatOpenAI()

chain1 = prompt | model

chain = (

{

"a": itemgetter("foo") | RunnableLambda(length_function),

"b": {"text1": itemgetter("foo"), "text2": itemgetter("bar")}

| RunnableLambda(multiple_length_function),

}

| prompt

| model

)

chain.invoke({"foo": "りんご", "bar": "パイナップル"})

AIMessage(content='3 + 18 = 21', response_metadata={'token_usage': {'completion_tokens': 7, 'prompt_tokens': 14, 'total_tokens': 21}, 'model_name': 'gpt-3.5-turbo', 'system_fingerprint': 'fp_b28b39ffa8', 'finish_reason': 'stop', 'logprobs': None}, id='run-fac2f053-a913-4e11-9fed-9f244a36e206-0')

んー、例がわかりにくい。。。噛み砕くとこう。

- "foo"の文字列を

RunnableLambdaで指定した関数(length_function)に渡して結果を"a"にアサイン3

- "foo"と"bar"のそれぞれの文字列を

RunnableLambdaで指定した関数(multiple_length_function)に渡して結果を"b"にアサイン-

3 * 6=18

-

- aとbをプロンプトに埋め込んでLLMに渡す(

3 + 18 は?)

なるほど、パイプの中で別のパイプを並列実行してそれぞれマッピングする的な感じか。

RunnableLambdaはオプションでRunnableConfigを受けとって、コールバック、タグ、設定などをネストされたRunnableに渡すことができる。

import json

from langchain_core.prompts import ChatPromptTemplate

from langchain_core.runnables import RunnableLambda, RunnableConfig

from langchain_openai import ChatOpenAI

from langchain_core.output_parsers import StrOutputParser

from langchain_community.callbacks import get_openai_callback

def parse_or_fix(text: str, config: RunnableConfig):

fixing_chain = (

ChatPromptTemplate.from_template(

"以下の文章を修正して下さい:\n\n```text\n{input}\n```\nError: {error}"

"説明を入れずに、修正したデータだけを応答して下さい。"

)

| ChatOpenAI()

| StrOutputParser()

)

for _ in range(3):

try:

return json.loads(text)

except Exception as e:

text = fixing_chain.invoke({"input": text, "error": e}, config)

return "Failed to parse"

with get_openai_callback() as cb:

output = RunnableLambda(parse_or_fix).invoke(

"{foo: bar}", {"tags": ["my-tag"], "callbacks": [cb]}

)

print(output)

print(cb)

{'foo': 'bar'}

Tokens Used: 85

Prompt Tokens: 76

Completion Tokens: 9

Successful Requests: 1

Total Cost (USD): $0.000132

んー、ちょっとピンとこない。というか

with get_openai_callback() as cb:

output = RunnableLambda(parse_or_fix).invoke(

"{foo: bar}"

)

print(output)

print(cb)

指定がない場合でも同じ出力になる。

{'foo': 'bar'}

Tokens Used: 85

Prompt Tokens: 76

Completion Tokens: 9

Successful Requests: 1

Total Cost (USD): $0.000132

一応まあこうやると

def parse_or_fix(text: str, config: RunnableConfig):

fixing_chain = (

ChatPromptTemplate.from_template(

"以下の文章を修正して下さい:\n\n```text\n{input}\n```\nError: {error}"

"説明を入れずに、修正したデータだけを応答して下さい。"

)

| ChatOpenAI()

| StrOutputParser()

)

for _ in range(3):

try:

return json.loads(text)

except Exception as e:

print("DEBUG: ", config) # ここ

text = fixing_chain.invoke({"input": text, "error": e}, config)

return "Failed to parse"

普通にわたっているので何かしらコールバックとか使えそうではあるんだけども。

DEBUG: {'tags': ['my-tag'], 'metadata': {}, 'callbacks': <langchain_core.callbacks.manager.CallbackManager object at 0x7e353636a650>, 'recursion_limit': 25}

なんか上の方でもあったけどRunnableConfigがドキュメントのとおりに書いても動いてない気がするなぁ。。。とりあえずスルーする。

ジェネレーターを使った関数をパイプラインで使うこともできる。

まず普通に動物名をリストアップするチェーンを作る

from typing import Iterator, List

from langchain_core.prompts import ChatPromptTemplate

from langchain_openai import ChatOpenAI

from langchain_core.output_parsers import StrOutputParser

prompt = ChatPromptTemplate.from_template(

"Write a comma-separated list of 5 animals similar to: {animal}. Do not include numbers"

"{animal} に似た動物を5つ、カンマ区切りで書いてください。数字は含めないでください。"

)

model = ChatOpenAI(temperature=0.0)

str_chain = prompt | model | StrOutputParser()

stream。わかりやすいように"|"を含めている。

for chunk in str_chain.stream({"animal": "クマ"}):

print(chunk, end="|", flush=True)

|ク|マ|,| パ|ン|ダ|,| シ|ロ|ク|マ|,| ヒ|グ|マ|,| コ|ア|ラ||

invoke

str_chain.invoke({"animal": "クマ"})

クマ, パンダ, シロクマ, コアラ, クマネズミ

これにカンマでsplitするような関数を出力パーサとして追加する。このときの入出力はIterator[Input] -> Iterator[Output]でなけれなばらない。

# LLMトークンのイテレータをカンマで区切られた文字列のリストに

# 分割するカスタムパーサ

def split_into_list(input: Iterator[str]) -> Iterator[List[str]]:

# コンマが入るまで保持

buffer = ""

for chunk in input:

# 現在のチャンクをバッファに追加

buffer += chunk

# バッファにカンマがある間

while "," in buffer:

# コンマでバッファを分割

comma_index = buffer.index(",")

# コンマより前はすべてyieldで返す

yield [buffer[:comma_index].strip()]

# 次回のイテレーションのための残りを保持

buffer = buffer[comma_index + 1 :]

# 最後のチャンクをyieldで返す

yield [buffer.strip()]

list_chain = str_chain | split_into_list

for chunk in list_chain.stream({"animal": "クマ"}):

print(chunk, end="|", flush=True)

['クマ']|['パンダ']|['シロクマ']|['ヒグマ']|['コアラ']|

list_chain.invoke({"animal": "クマ"})

['クマ', 'パンダ', 'シロクマ', 'ヒグマ', 'コアラ']

これの非同期バージョン。非同期の場合はAsyncIterator[Input] -> AsyncIterator[Output]でなければならない。

stream。

async for chunk in list_chain.astream({"animal": "クマ"}):

print(chunk, end="|", flush=True)

['クマ']|['パンダ']|['シロクマ']|['コアラ']|['クマネズミ']|

invoke

await list_chain.ainvoke({"animal": "クマ"})

['クマ', 'パンダ', 'シロクマ', 'ヒグマ', 'コアラ']

Passthrough: 入力をパススルーする

RunnablePassthroughは入力をそのままパススルーする。RunnableParallelで後続のRunnableに新しい変数としてマップする場合に使われることが多い。

!pip install --upgrade --quiet langchain-core langchain-openai langchain-community

!pip freeze | grep -i langchain

langchain-community==0.0.32

langchain-core==0.1.42

langchain-openai==0.1.3

import os

from google.colab import userdata

os.environ['OPENAI_API_KEY'] = userdata.get('OPENAI_API_KEY')

from langchain_core.runnables import RunnableParallel, RunnablePassthrough

runnable = RunnableParallel(

passed=RunnablePassthrough(),

modified=lambda x: x["num"] + 1,

)

runnable.invoke({"num": 1})

{'passed': {'num': 1}, 'modified': 2}

retrievalの例は重複するので割愛。

Assign: 値を状態に追加する

RunnablePassthrough.assign(...)静的メソッドは、入力値を受け取り、assign関数に渡された追加引数を追加します。

これは、LCELの一般的なパターンである、後のステップの入力として使用する辞書を追加的に作成する場合に便利です。

!pip install --upgrade --quiet langchain-core langchain-openai langchain-community faiss-cpu

!pip freeze | grep -i langchain

langchain-community==0.0.32

langchain-core==0.1.42

langchain-openai==0.1.3

import os

from google.colab import userdata

os.environ['OPENAI_API_KEY'] = userdata.get('OPENAI_API_KEY')

一つ上のコードのRunnablePassthroughに.assign()メソッドで関数を追加している。

from langchain_core.runnables import RunnableParallel, RunnablePassthrough

runnable = RunnableParallel(

extra=RunnablePassthrough().assign(multi=lambda x: x["num"] * 3),

modified=lambda x: x["num"] + 1,

)

runnable.invoke({"num": 1})

{'extra': {'num': 1, 'multi': 3}, 'modified': 2}

RunnablePassthrough.assign()を使うと、値が利用可能になったらすぐに使えること、らしい。

from langchain_community.vectorstores import FAISS

from langchain_core.output_parsers import StrOutputParser

from langchain_core.prompts import ChatPromptTemplate

from langchain_core.runnables import RunnablePassthrough

from langchain_openai import ChatOpenAI, OpenAIEmbeddings

texts = []

texts.append("""\

イクイノックス(欧字名:Equinox、2019年3月23日 - )は、日本の競走馬・種牡馬。

主な勝ち鞍は、2022年・2023年の天皇賞(秋)連覇、2022年の有馬記念、2023年のドバイシーマクラシック、宝塚記念、ジャパンカップ。\

""")

texts.append("""\

オグリキャップ(欧字名:Oguri Cap、1985年3月27日 - 2010年7月3日)は、日本の競走馬、種牡馬。

主な勝ち鞍は、1988年・1990年の有馬記念、1989年のマイルチャンピオンシップ、1990年の安田記念。\

""")

texts.append("""\

ドウデュース(欧字名:Do Deuce、2019年5月7日 - )は、日本の競走馬。

主な勝ち鞍は、2021年の朝日杯フューチュリティステークス、2022年の東京優駿、2023年の有馬記念。\

""")

vectorstore = FAISS.from_texts(

texts, embedding=OpenAIEmbeddings()

)

retriever = vectorstore.as_retriever()

template = """\

以下のコンテキストにもとづいて、質問に答えてください:

{context}

質問: {question}

回答: \

"""

prompt = ChatPromptTemplate.from_template(template)

model = ChatOpenAI()

generation_chain = prompt | model | StrOutputParser()

retrieval_chain = {

"context": retriever,

"question": RunnablePassthrough(),

} | RunnablePassthrough.assign(output=generation_chain)

stream = retrieval_chain.stream("オグリキャップの主な勝ち鞍は?")

for chunk in stream:

print(chunk)

retrievalのドキュメントが一番最初に出力されている。

{'question': 'オグリキャップの主な勝ち鞍は?'}

{'context': [Document(page_content='オグリキャップ(欧字名:Oguri Cap、1985年3月27日 - 2010年7月3日)は、日本の競走馬、種牡馬。\n主な勝ち鞍は、1988年・1990年の有馬記念、1989年のマイルチャンピオンシップ、1990年の安田記念。'), Document(page_content='イクイノックス(欧字名:Equinox、2019年3月23日 - )は、日本の競走馬・種牡馬。\n主な勝ち鞍は、2022年・2023年の天皇賞(秋)連覇、2022年の有馬記念、2023年のドバイシーマクラシック、宝塚記念、ジャパンカップ。'), Document(page_content='ドウデュース(欧字名:Do Deuce、2019年5月7日 - )は、日本の競走馬。\n主な勝ち鞍は、2021年の朝日杯フューチュリティステークス、2022年の東京優駿、2023年の有馬記念。')]}

{'output': ''}

{'output': '198'}

{'output': '8'}

{'output': '年'}

{'output': '・'}

{'output': '199'}

{'output': '0'}

{'output': '年'}

{'output': 'の'}

{'output': '有'}

{'output': '馬'}

{'output': '記'}

{'output': '念'}

{'output': '、'}

{'output': '198'}

{'output': '9'}

{'output': '年'}

{'output': 'の'}

{'output': 'マ'}

{'output': 'イ'}

{'output': 'ル'}

{'output': 'チ'}

{'output': 'ャ'}

{'output': 'ン'}

{'output': 'ピ'}

{'output': 'オ'}

{'output': 'ン'}

{'output': 'シ'}

{'output': 'ッ'}

{'output': 'プ'}

{'output': '、'}

{'output': '199'}

{'output': '0'}

{'output': '年'}

{'output': 'の'}

{'output': '安'}

{'output': '田'}

{'output': '記'}

{'output': '念'}

{'output': ''}

なんかユースケースありそうだけど思いつかないな。

追記:以下をやってみてわかった。RunnablePassthroughと組み合わせると出力パラメータを追加するのに使える。

実行時にチェーン内の設定を変更する

-

configurable_fieldsはRunnableの特定のフィールドを設定変更できる。 -

configurable_alternativesは実行時に設定ができるRunnableランナブルのオプションを用意する。

configurable_fields

!pip install --upgrade --quiet langchain-core langchain-openai langchain-anthropic

!pip freeze | grep -i langchain

langchain-anthropic==0.1.8

langchain-core==0.1.42

langchain-openai==0.1.3

import os

from google.colab import userdata

os.environ['OPENAI_API_KEY'] = userdata.get('OPENAI_API_KEY')

os.environ['ANTHROPIC_API_KEY'] = userdata.get('ANTHROPIC_API_KEY')

ConfigurableFieldでモデルのtemperatureを設定可能にする。

from langchain_core.prompts import ChatPromptTemplate

from langchain_core.runnables import ConfigurableField

from langchain_openai import ChatOpenAI

model = ChatOpenAI(temperature=0).configurable_fields(

temperature=ConfigurableField(

id="llm_temperature",

name="LLM Temperature",

description="The temperature of the LLM",

)

)

普通に実行

model.invoke("ランダムな数字を1つ選んで。")

AIMessage(content='9', response_metadata={'token_usage': {'completion_tokens': 1, 'prompt_tokens': 20, 'total_tokens': 21}, 'model_name': 'gpt-3.5-turbo', 'system_fingerprint': 'fp_b28b39ffa8', 'finish_reason': 'stop', 'logprobs': None}, id='run-8c9402c8-498a-44f8-bca2-20c4076c9c04-0')

実行時に変更する

model.with_config(configurable={"llm_temperature": 0.9}).invoke("ランダムな数字を1つ選んで。")

AIMessage(content='8', response_metadata={'token_usage': {'completion_tokens': 1, 'prompt_tokens': 20, 'total_tokens': 21}, 'model_name': 'gpt-3.5-turbo', 'system_fingerprint': 'fp_c2295e73ad', 'finish_reason': 'stop', 'logprobs': None}, id='run-599e1b9f-05fc-4a3b-8037-2d149a8295af-0')

チェインに対して設定することでも反映される。

prompt = ChatPromptTemplate.from_template("{x}以上のランダムな数字を1つ選んで。")

chain = prompt | model

chain.with_config(configurable={"llm_temperature": 0.9}).invoke({"x": 10})

AIMessage(content='27', response_metadata={'token_usage': {'completion_tokens': 1, 'prompt_tokens': 23, 'total_tokens': 24}, 'model_name': 'gpt-3.5-turbo', 'system_fingerprint': 'fp_b28b39ffa8', 'finish_reason': 'stop', 'logprobs': None}, id='run-9f555d73-61a1-4c0e-8e61-6747ef9743cf-0')

LangChain Hubのプロンプト切り替えとかにはHubRunnablesが使える。

ちょっとパッケージがよくわからないけど、以下が追加で必要。

!pip install --upgrade --quiet langchain langchainhub

from langchain.runnables.hub import HubRunnable

from langchain_core.runnables import ConfigurableField

prompt = HubRunnable("rlm/rag-prompt").configurable_fields(

owner_repo_commit=ConfigurableField(

id="hub_commit",

name="Hub Commit",

description="The Hub commit to pull from",

)

)

prompt.invoke({"question": "foo", "context": "bar"})

ChatPromptValue(messages=[HumanMessage(content="You are an assistant for question-answering tasks. Use the following pieces of retrieved context to answer the question. If you don't know the answer, just say that you don't know. Use three sentences maximum and keep the answer concise.\nQuestion: foo \nContext: bar \nAnswer:")])

prompt.with_config(configurable={"hub_commit": "rlm/rag-prompt-llama"}).invoke(

{"question": "foo", "context": "bar"}

)

ChatPromptValue(messages=[HumanMessage(content="[INST]<<SYS>> You are an assistant for question-answering tasks. Use the following pieces of retrieved context to answer the question. If you don't know the answer, just say that you don't know. Use three sentences maximum and keep the answer concise.<</SYS>> \nQuestion: foo \nContext: bar \nAnswer: [/INST]")])

configurable_alternatives

ちょっとインポートのところは変更している。

from langchain_core.prompts import ChatPromptTemplate

from langchain_anthropic import ChatAnthropic

from langchain_core.runnables import ConfigurableField

from langchain_openai import ChatOpenAI

llm = ChatAnthropic(model="claude-3-haiku-20240307", temperature=0).configurable_alternatives(

# これはこのフィールドにidを与える。

# 一番最後のRunnableを設定するとき、このidを使ってこのフィールドを設定することができる

ConfigurableField(id="llm"),

# これはデフォルトキーをセットする

# このキーを指定すると、デフォルトのLLM(上で初期化されたChatAnthropic)が使われる

default_key="anthropic",

# これは新しいオプションを追加する。`openai`という名前で`ChatOpenAI()`になる

openai=ChatOpenAI(),

# これは新しいオプションを追加する。`gpt`という名前で`ChatOpenAI(model="gpt-4")`になる

gpt4=ChatOpenAI(model="gpt-4"),

# 更にオプションを追加できる

)

prompt = ChatPromptTemplate.from_template("{topic}についてのジョークを1つ考えて。")

chain = prompt | llm

何も指定しなければデフォルト(claude-3-haiku)

chain.invoke({"topic": "クマ"})

AIMessage(content='はい、クマについてのジョークを考えてみました。\n\nクマが森の中を歩いていると、ウサギに出会いました。\nクマは尋ねました。「ウサギさん、この森の中で一番面白いジョークを教えてください。」\nウサギは答えました。「クマさん、あなたがちょうど今立っているところが一番面白いジョークです!」\n\nクマは少し困惑しながらも、ウサギのジョークを面白いと感じたそうです。クマはウサギの機知に富んだユーモアに感心したのでした。', response_metadata={'id': 'msg_018i1czJUTmny3qgZjX3tysr', 'model': 'claude-3-haiku-20240307', 'stop_reason': 'end_turn', 'stop_sequence': None, 'usage': {'input_tokens': 23, 'output_tokens': 183}}, id='run-2d7ddb9c-9629-4e91-b966-3c096352d161-0')

"openai" = ChatOpenAI()

chain.with_config(configurable={"llm": "openai"}).invoke({"topic": "クマ"})

AIMessage(content='クマがお風呂に入るとどうなるか知ってる?\u3000クマだらけのお湯風呂になるんだよ!', response_metadata={'token_usage': {'completion_tokens': 42, 'prompt_tokens': 25, 'total_tokens': 67}, 'model_name': 'gpt-3.5-turbo', 'system_fingerprint': 'fp_b28b39ffa8', 'finish_reason': 'stop', 'logprobs': None}, id='run-e5918663-3f0c-4079-bba6-94fb5fdbec88-0')

"gpt4" = ChatOpenAI(model="gpt-4")

chain.with_config(configurable={"llm": "gpt4"}).invoke({"topic": "クマ"})

AIMessage(content='どうしてクマはコンピューターが苦手なの?\n\nキーボードを押すと、いつも"ベア"が出てしまうからだよ!(Bearは英語でクマの意味)', response_metadata={'token_usage': {'completion_tokens': 62, 'prompt_tokens': 25, 'total_tokens': 87}, 'model_name': 'gpt-4', 'system_fingerprint': None, 'finish_reason': 'stop', 'logprobs': None}, id='run-8a60c2ac-7c9b-46d8-ba0a-72ad4400acb5-0')

同じようにプロンプトでもやってみる。

llm = ChatAnthropic(model="claude-3-haiku-20240307", temperature=0)

prompt = ChatPromptTemplate.from_template(

"{topic}についてのジョークを1つ考えて。"

).configurable_alternatives(

ConfigurableField(id="prompt"),

default_key="joke",

poem=ChatPromptTemplate.from_template("{topic}についての短い詩を1つ考えて。"),

)

chain = prompt | llm

chain.invoke({"topic": "クマ"})

AIMessage(content='はい、クマについてのジョークを考えてみました。\n\nクマが森の中を歩いていると、ウサギに出会いました。\nクマは尋ねました。「ウサギさん、この森の中で一番面白いジョークを教えてください。」\nウサギは答えました。「はい、分かりました。クマさん、クマさんはなぜ木の上に登るのですか?」\nクマは考えて言いました。「それは、木の上から落ちるのが怖いからですよ。」\nウサギは笑いながら言いました。「違います。クマさんは木の上に登るのが怖いからですよ!」\n\nクマは少し恥ずかしそうでしたが、ウサギのジョークを面白いと思いました。\nクマとウサギは森の中で楽しく過ごしたのでした。', response_metadata={'id': 'msg_01MW8cgK1kHv9CKwaw9E9D4E', 'model': 'claude-3-haiku-20240307', 'stop_reason': 'end_turn', 'stop_sequence': None, 'usage': {'input_tokens': 23, 'output_tokens': 263}}, id='run-d7e5d86b-687f-415d-a9ad-72b2bd3855f3-0')

chain.with_config(configurable={"prompt": "poem"}).invoke({"topic": "クマ"})

AIMessage(content='クマの詩\n\n大きな体に優しい瞳\n森の中で静かに歩む\n木の実を探し食べては\n冬眠の準備をする\n\n力強く、でも穏やかな\n自然の一部であるクマ\n人間に脅かされながらも\n大切な生き物なのだ', response_metadata={'id': 'msg_01Y3iLQSzzqpQZWXxKVpxpet', 'model': 'claude-3-haiku-20240307', 'stop_reason': 'end_turn', 'stop_sequence': None, 'usage': {'input_tokens': 23, 'output_tokens': 96}}, id='run-84c97b70-b22f-4add-b43b-5109e7e79e2f-0')

両方組み合わせる

from langchain_core.prompts import ChatPromptTemplate

from langchain_anthropic import ChatAnthropic

from langchain_core.runnables import ConfigurableField

from langchain_openai import ChatOpenAI

llm = ChatAnthropic(model="claude-3-haiku-20240307", temperature=0).configurable_alternatives(

ConfigurableField(id="llm"),

default_key="anthropic",

openai=ChatOpenAI(),

gpt4=ChatOpenAI(model="gpt-4"),

)

prompt = ChatPromptTemplate.from_template(

"{topic}についてのジョークを1つ考えて。"

).configurable_alternatives(

ConfigurableField(id="prompt"),

default_key="joke",

poem=ChatPromptTemplate.from_template("{topic}についての短い詩を1つ考えて。"),

)

chain = prompt | llm

chain.invoke({"topic": "クマ"})

AIMessage(content='はい、クマについてのジョークを考えてみました。\n\nクマが森の中を歩いていると、ウサギに出会いました。\nクマは尋ねました。「ウサギさん、この森の中で一番速いのは誰ですか?」\nウサギは答えました。「もちろんわたしですよ!」\nすると、クマは言いました。「じゃあ、一緒に走ってみましょう!」\nウサギは喜んで走り出しましたが、すぐにクマに追いつかれてしまいました。\nクマは満足そうに言いました。「やっぱり、クマが一番速いんだね。」\n\nいかがでしょうか。クマの特徴を活かしたジョークになっていると思います。クマの力強さと、ウサギの速さのギャップが面白いポイントになっています。', response_metadata={'id': 'msg_011rUxXsGRxXc5MoTPNogKgY', 'model': 'claude-3-haiku-20240307', 'stop_reason': 'end_turn', 'stop_sequence': None, 'usage': {'input_tokens': 23, 'output_tokens': 264}}, id='run-34b57172-a4d8-40a9-af4e-4c764d8c86a9-0')

chain.with_config(configurable={"llm": "openai", "prompt": "poem"}).invoke({"topic": "クマ"})

AIMessage(content='森の中に\nふわふわと歩く\nやさしいクマ', response_metadata={'token_usage': {'completion_tokens': 23, 'prompt_tokens': 27, 'total_tokens': 50}, 'model_name': 'gpt-3.5-turbo', 'system_fingerprint': 'fp_b28b39ffa8', 'finish_reason': 'stop', 'logprobs': None}, id='run-251d0ea2-c684-449d-8488-07cb8a69fc32-0')

オブジェクトとして設定付きで保持できる。

openai_poem = chain.with_config(configurable={"llm": "openai", "prompt": "poem"})

openai_poem.invoke({"topic": "クマ"})

AIMessage(content=' 森の中に\u3000クマが住む\u3000大きな力\u3000心温かく', response_metadata={'token_usage': {'completion_tokens': 25, 'prompt_tokens': 27, 'total_tokens': 52}, 'model_name': 'gpt-3.5-turbo', 'system_fingerprint': 'fp_b28b39ffa8', 'finish_reason': 'stop', 'logprobs': None}, id='run-a9d25e18-3d9d-4777-a7e2-be29cc673efd-0')

Streaming

ここはこれまで繰り返してきた内容がカバーされてそうなので、とりまスキップ。

Adding message history(memory)

ここざっと見てみたのだけど、ちょっとむずい。というか、まずLangChainの旧来のメモリの扱い方を先にやったほうがいい気がしてきた。

ということで、一旦LCELから離れて、これまでのやり方を少し確認してから戻ることにする

メモリについては以下の前提がまず重要と感じる。

LangChainは、システムにメモリを追加するための多くのユーティリティを提供しています。 これらのユーティリティは、単独で使用することも、チェーンにシームレスに組み込むこともできます。

LangChainのメモリ関連機能のほとんどはベータ版としてマークされています。これには2つの理由があります:

- ほとんどの機能(例外あり、詳細は以下)は、本番環境での利用には準備が整っていない。

- ほとんどの機能(例外あり、詳細は以下)は、新しいLCEL構文ではなく、"レガシー"なチェーンで動作する。

主な例外は

ChatMessageHistory機能です。この機能は、本番環境での利用が可能で、LCELと統合されています。

- LCEL Runnables:LCEL runnables で

ChatMessageHistoryを使用する方法の概要についてはこのドキュメントを参照してください。- インテグレーション:ChatMessageHistoryの様々なインテグレーションについてはこのドキュメントを参照してください。

ということで、LCELで使うならば、基本的にはChatMessageHistoryだけを見ておけば良さそうではあるものの、一応レガシーなメモリ関連モジュールにあってLCEL対応のChatMessageHistoryにはないもの、を抑えておく意味で、非LCELでサラッと流してみる。

基本的な仕組み

- ユーザの入力を受けて、メモリから過去の会話履歴を読み込んで、セットでプロンプトに渡してから、LLMに渡す

- LLMの出力結果を受けて、メモリに今回の会話ターン(ユーザクエリ+LLMの回答)を記録する

よって、メモリに最低限必要な機能は以下の2つだけとなる。

- メモリの読み出し

- メモリへの書き込み