GPT-4o miniでファインチューニングが可能に

はじめに

日本時間2024年7月24日にGPT-4o miniのファインチューニング (Finetuning) が可能となりました。

ファインチューニングとは?

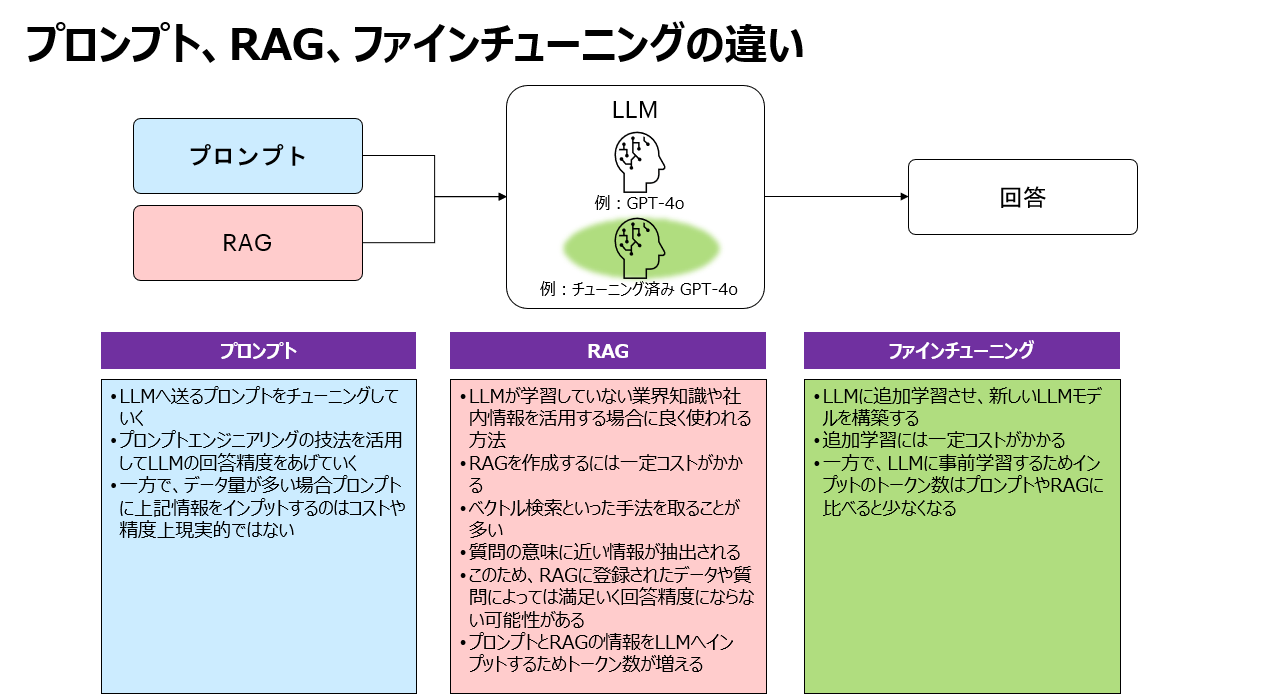

ファインチューニングはLLMに追加学習させて回答の精度をあげていくアプローチとなります。

プロンプトやRAGの場合は、LLMに質問するときに追加情報を毎回付与しなければならないのに対してファインチューニングの場合は追加情報が学習済みなので、インプット、アウトプットのトークン数が減りコストメリットの可能性があります。

私が以前執筆した下記記事が参考になると思います。

プロンプト、RAG、ファインチューニングの違いを学ぶ No.1

https://zenn.dev/acntechjp/articles/75040fe187f425

プロンプト、RAG、ファインチューニングの違いを学ぶ No.2

https://zenn.dev/acntechjp/articles/316d969547b3f1

コストのメリット

GPT3.5 TurboのFinetuning Modelに比べて、トレーニングが約37.5%、インプットが約10%、アウトプットが約20%となっておりコストメリットが高いと言えます。

精度のメリット

LLMはプロンプトの最初と最後を重要視すると言われています。なので情報量が多い追加情報が必要な場合はファインチューニングが選択肢になりえます。RAGについても、ベクトル検索の性質上、質問に関連する文字を含むチャンクがプロンプトになってくるので、大量パターンの学習といった場合はファインチューニングの方が精度が高くなると考えられます。

スピードのメリット

GPT-4o miniが登場した時はスピードがGemini 1.5 Flashレベルと言われていましたが、現在ランクがさがっていますね🤔

とはいえ、一定のスピードはでそうです。

GPT-4o miniのファインチューニングの方法

- OpenAIのAPIダッシュボードへアクセスします

https://platform.openai.com/

2.「Fine-tuning」をクリックします

3.「Create」をクリックします

4.「Base Model」の「GPT-4o mini」をクリックします

5.追加情報や各種パラメータの設定をします

6.「Create」をクリックして、ファインチューニングさせます

さいごに

いかがでしたか。

GPT-4o miniでファインチューニングができるようになり、特にコスト面で検討の対象になりえると考えています!

Discussion