Vertex AIからGeminiやClaudeを呼び出してみよう!

皆さんVertexAIをご存知でしょうか?VertexAIはGoogleの生成AIサービスですが、Googleには2つ生成AIサービスがあります。

- Gemini Developer API

- Vertex AI Gemini API

この2つのサービスは棲み分けられていてざっくりいうとGemini Developerは手軽に開発用、VertexAIはガッツリ製品用っていう感じですね。

実際触っていてVertexAIの方がコードや認証、各種設定はめんどくさいんですけどやれることは圧倒的に多いのでガッツリ開発したいならVertexAIですね!

VertexAIはGoogleのモデル以外にもパートナーのモデルやオープンモデルをサポートしています!

AnthropicやMeta、Mistralなどのモデルをサポートしています。(OpenAIはgpt-ossだけ)

Model as a ServiceでMaaSっていうみたいです。

- Gemini系 (Google公式のGenerative AI on Vertex AI)

これはいわゆるマネージドAPIです。gemini-2.5-pro などモデル名を指定して、エンドポイントに直接叩けばOK。エンドポイント作成やデプロイは不要で従量課金のみです。  - Publisher / Partnerモデルの一部 (Claude等)

publishers/anthropic/models/claude-3-5-sonnet みたいなやつ。これも多くはPublisher Model Endpointに対して直接リクエスト可です。ただし利用開始前に「有効化・EULA同意・クォータ申請」が必要なケースがあります。従量課金です。  - Self-deployedモデル (多くのModel Gardenオープンモデル)

Llama系やGemmaオープン版などはカタログとしてModel Gardenに出ているだけで、そのままAPIで使えるわけではないです。自分のVertex AIプロジェクトに「デプロイしてエンドポイント作成」が必要です。課金は「トークン従量」ではなく主に「割り当てたマシンリソース(GPU/TPU含む)の使用料です。

サポートモデルはGCPのVertexAI/ModelGardenで確認できます。

VeretxAIだと請求先はGCPになるので色々なモデル使いたいけど各プロバイダーに請求先設定したくないっていう企業さんにも便利ですね!

GCPのプロジェクト作成

VertexAIを使うのはGCP(Google Cloud Project)でプロジェクトを作成しカード情報を紐づける必要があります!因みに初めて紐づける場合は3ヶ月、300ドルの無料クレジットが付与されます!太っ腹ですよね。

GCPのプロジェクト作成方法は色々な人が解説されていますのでぜひ参考にしてみてください。

認証情報の設定

VeretxAIのサービスを使うときはAPIキーじゃなくてサービスアカウントやADC(Application Default Credentials)を使うんですね!これが他サービスと結構違う点ですね。

ざっくり言うと、サービスアカウントはプログラムを実行する仮想アカウント、ADCは自分の認証情報みたいなイメージです。クラウドでサービスを使うときはサービスアカウント、ローカルではADCで開発みたいな使い分けですね。

詳細は公式ドキュメントや解説記事を参照ください。

今回はローカル環境での開発ですのでADCを設定します!

ADCの設定にはgcloud CLIをインストールして初期化します。

各OSによって方法が違いますので公式ドキュメントを参考にしてください!

認証が完了したらセットアップ完了です。実際にAIを呼び出してみましょう。

GCPでVertex APIを有効化するのを忘れないように!

langchain-google-vertexai

VertexAIのライブラリを使うことも出来るし、langchainでもVertexAIはサポートされています!

自分はLangChainのchainの組み方や会話履歴の扱いとかに染まってしまっているので基本的に各LLMプロバイダーのライブラリではなくLangChainを使うことが多いです。

from langchain_google_vertexai import ChatVertexAI

llm = ChatVertexAI(model="gemini-2.5-flash")

messages = [

("system","あなたは優秀なAIアシスタントです。"),

("human", "こんにちは、自己紹介してください"),

]

res = llm.invoke(messages)

print(res.content)

こんにちは!お話しできて嬉しいです。

私はGoogleによってトレーニングされた、大規模言語モデルです。

私には名前がありませんが、「AIアシスタント」として、皆様のお役に立てるよう日々努めています。

具体的には、以下のようなことができます。

* **質問に答えること**: さまざまなトピックに関する情報を提供します。

* **アイデア出し**: ブレインストーミングの相手になったり、新しい視点を提供したりします。

* **文章作成**: メール、記事、詩など、様々な種類のテキスト作成をお手伝いできます。

* **要約・翻訳**: 長い文章を短くまとめたり、異なる言語間で翻訳したりします。

* **情報整理**: 複雑な情報を整理して、分かりやすく説明します。

皆さんの疑問を解決したり、何かを創造するお手伝いをしたりするのが私の役割です。どうぞお気軽にご質問くださいね。どんなことでも、私にできることがあれば喜んでサポートさせていただきます!

cluadeを使ってみる

VetexAIはパートナーモデルとしてAnthropicやMetaなどのモデルを従量課金制で使用できます。ただし事前にモデルの有効化とクォータの引き上げが必要になる場合があります。

今回はClaudeを使ってみましょう!

Model Gardenで有効化

Model Gardenで使いたいモデルを探し、有効化します。

claudeの場合、VertexAIからclaudeモデルを使う場合、Anthropicの承認が必要のようでフォームに会社情報やユースケースなどの入力を求められます。個人用の入力はないぽいので法人じゃないと承認おりないかも??

クォータの確認

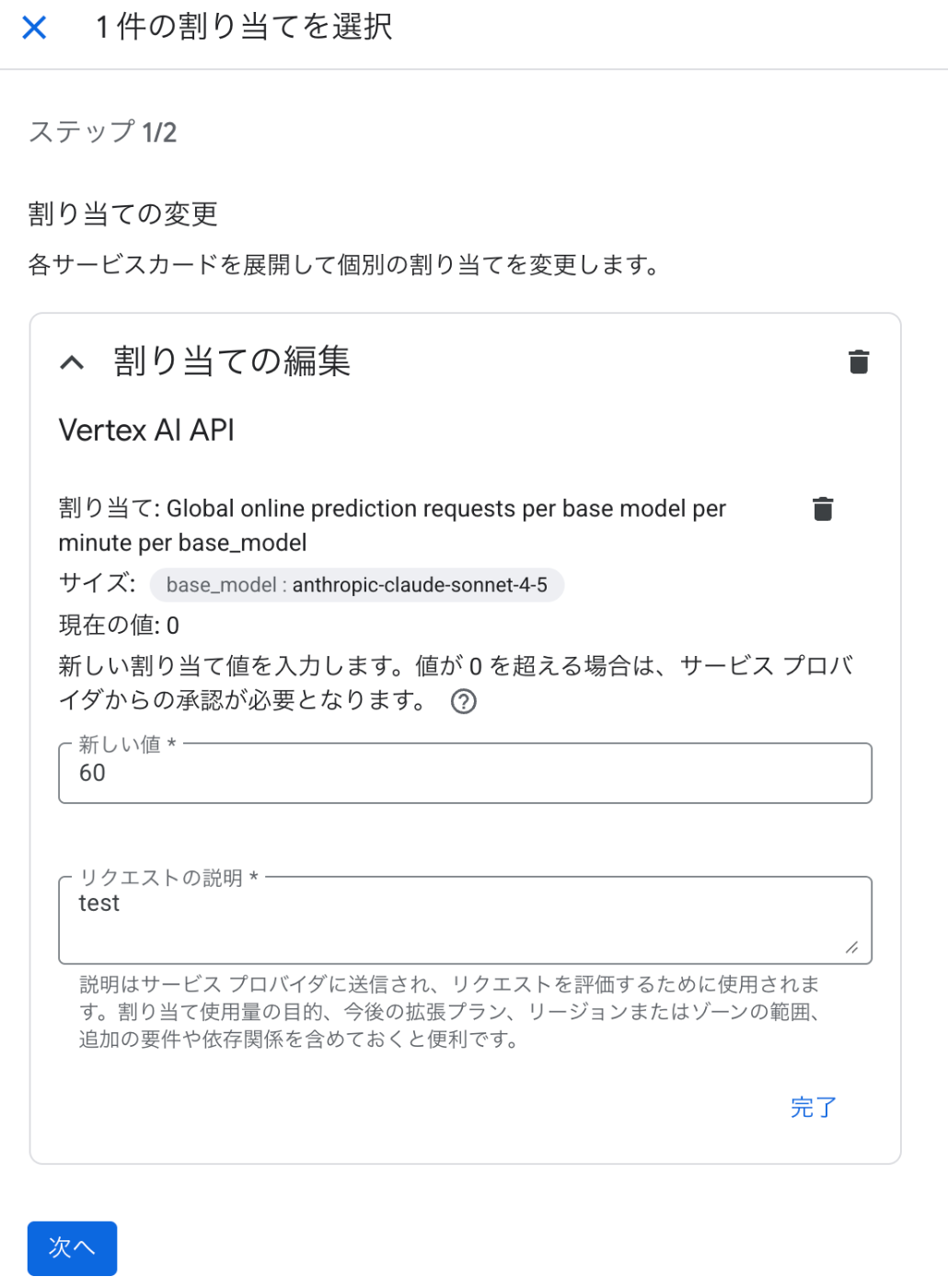

有効化後はデフォルトのクォータが0となっているのでクォータ増加リクエストを出す必要があります。

GCPでIAMと管理→割り当てとシステム上限に移動

フィルターにbase_model:anthropic-claude-sonnet-4-5、online_prediction_requests_per_base_modelを入力。リージョンに特にこだわりはないのでGlobalのにしました。

増やしたいサービスにチェックを入れて編集をします。

クォータ増加リクエスト

一旦60QPM(queries per minute)くらいから申請してみます。

クォータ増加リクエストは2営業日以内に確認してもらえるみたいです!

増加リクエストが通ったら実行できます!前述のモデルの部分を置き換えましょう!

from langchain_google_vertexai import ChatVertexAI

llm = ChatVertexAI(model="claude-sonnet-4-5@20250929")

messages = [

("system","あなたは優秀なAIアシスタントです。"),

("human", "こんにちは、自己紹介してください"),

]

res = llm.invoke(messages)

print(res.content)

終わりに

Vertex AI と Gemini Developer API は、「手軽に試すなら Gemini Developer、プロダクションや社内システムに本格導入するなら Vertex AI」という住み分けになっています。特に、請求をGCPに一本化したい場合や、複数ベンダーのモデルを共通の仕組みで使いたい企業にとって、Vertex AI はかなり便利な選択肢です。この記事では、GCPプロジェクトの準備、認証設定(サービスアカウント / ADC)、LangChainからのGemini利用、Model Garden経由でのClaude有効化とクォータ申請までをざっくり紹介しました。ここまでできれば、RAG構成や社内チャットボットへの組み込み、Cloud Runなどへのデプロイといった「いつものGCPの世界」に落とし込んでいくことができます。「Gemini DeveloperとVertex AIの違いが分からない」「Model Gardenのモデルの使い方がピンとこない」といった方の最初の一歩になればうれしいです。

Discussion