Closed7

Difyをローカルで動かす

クラウド版とDockerローカル版の2つがあるが、クラウド版だと制限があるがローカルだと.envで設定をカスタムできるので自由度高くおすすめみたい。

わかりやすい解説:

参考いろいろ:

Meetupなるものもある:

Difyテンプレ集:

ローカル環境構築

初っ端、バッファサイズが大きくてクローンできない問題に直面したが、結論以下でいけた。ネットワーク環境にも依存するので、何回か試してみたらうまくいくかも(自分は3回目で上手くいった)。

git config --global http.postBuffer 524288000

git clone https://github.com/langgenius/dify.git --depth 1

# 後から全部の履歴を取得できる(大体この対応をしている場合はこれもコケる)

git fetch --unshallow

docker compose upでno space left on deviceとなる場合は手っ取り早くDocker DesktopのResourceを弄る。自分はVirtual disk limitが8GBしかなかったので512GBに変更したらうまくいった。

write /var/lib/docker/tmp/GetImageBlob1700855425: no space left on device

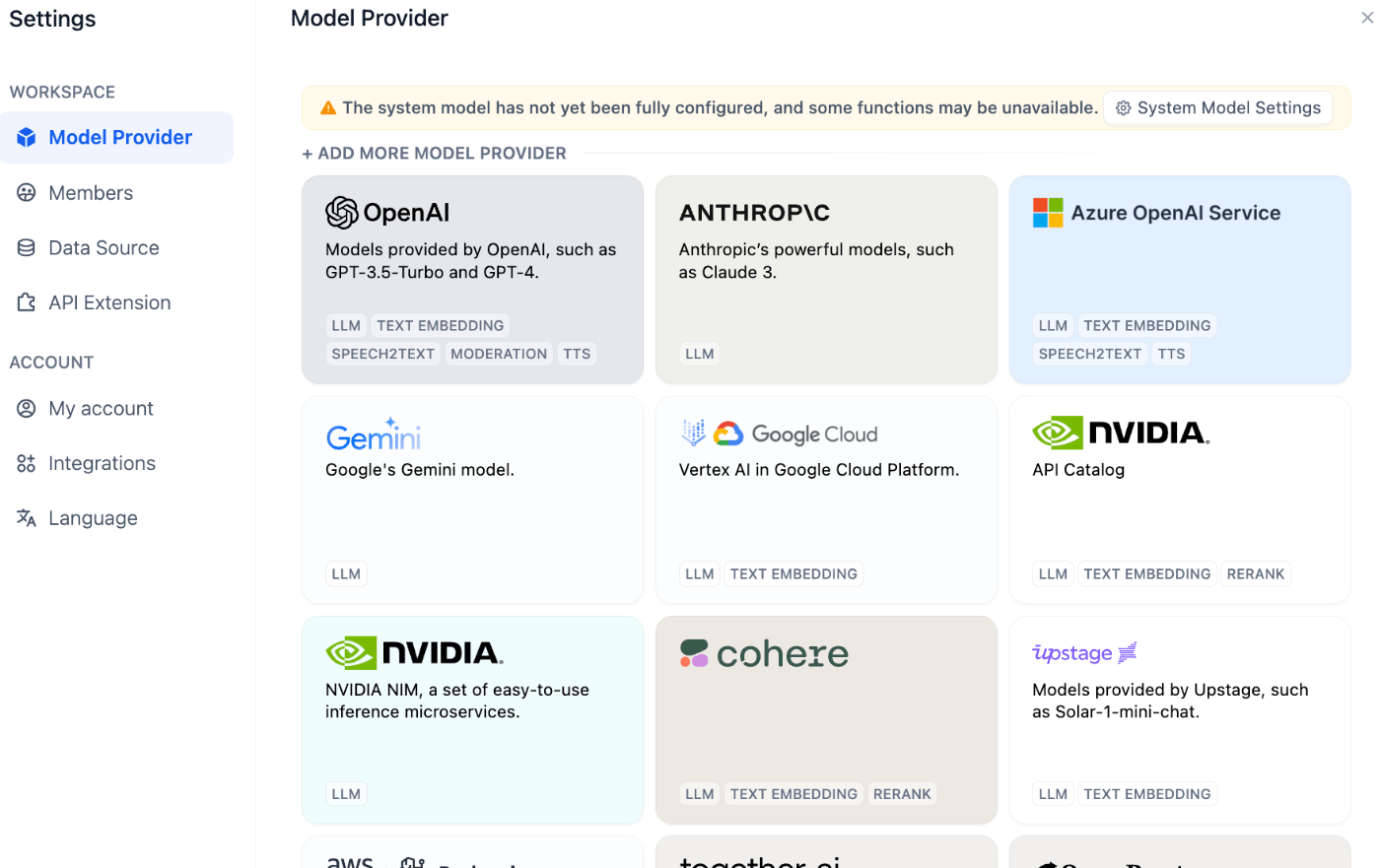

Difyの特徴の一つでいろいろなModel Providerを用途に応じて試すことができる:

今はマルチLLMは主流ぽく、アプリケーションの機能ごとにLLMを使い分けることもあるみたい。

- tool calling用のLLM

- 回答作成用のLLM

- 文章校正用のLLM

Ollamaとの連携

Ollamaでオープンモデルをローカル実行すればセキュアな情報の検証も楽に実施できる。

Debug and Previewが優秀すぎて、InstructionsやContextに応じて結果を確認しながらチューニングできる。モデル比較(応答速度も含めて)もできるのでその判断にも使える。

例:

このスクラップは2024/08/29にクローズされました