NotebookLMの最新動向と活用事例

CHANGELOG

- 2025.10.03

- NotebookLM Enterprise 版で可能になった API 経由での操作について API 対応による外部統合の自動化 に追記しました

- Video Overviews の正式提供にあわせて注意書きを削除しました

- 2025.06.04

- 2025年6月3日にリリースされた 一般公開機能 について追記しました

はじめに

2024年後半から現在にかけて話題沸騰中の NotebookLM ですが、私も 2025年4月30日に発表された Audio Overview の日本語対応 をきっかけに常時利用しています。やはりテキストベースより音声ベースのインタフェースは直感的で楽しく、理解が捗る印象です。私は最近第二子が生まれたのですが、育児で手が離せない時間も多いので空き時間でインプットできる手段が増えたことは嬉しいです。

NotebookLM の基本機能や使い方はすでにたくさんのわかりやすい情報が出回っているため、本記事では扱いません。Google Japan 公式の note や以下のエンジニア調査タスクの使い方が参考になると思います。

今回は SNS やブログなどで見つけた個人的に良さそうだと思った活用方法を改めてまとめてみた内容です。また Google I/O を経て、2025年5月現在でも様々な機能アップデートが提供・予定されていますので、その辺りの最新動向など見つつ紹介します。

前提

私は会社で Google Workspace Enterprise の利用ができることもあり、上位プランの NotebookLM in Pro を使っています(以前は Notebook Plus という名称でしたが、いつの間にか名称が変わりましたね)。ちなみに Google Workspace エディションによってコアサービスに含まれるか否かは こちら から確認できます。

通常プランとの制限比較も以下に記載します。プラン表記載の通り、通常版の5倍の機能が利用できます。

| 機能 | NotebookLM の制限 | NotebookLM in Pro の制限 |

|---|---|---|

| ノートブック数 | 最大 100 個 | 最大 500 個 |

| ソース数 | 各ノートブックにつき最大 50 個(各ソースは 50 万語まで) | 各ノートブックにつき最大 300 個 |

| チャットクエリ回数 | 1日あたり最大 50 回 | 1日あたり最大 500 回 |

| 音声生成回数 | 1日あたり最大 3 回 | 1日あたり最大 20 回 |

世の中の活用事例

カンファレンス系のキャッチアップ

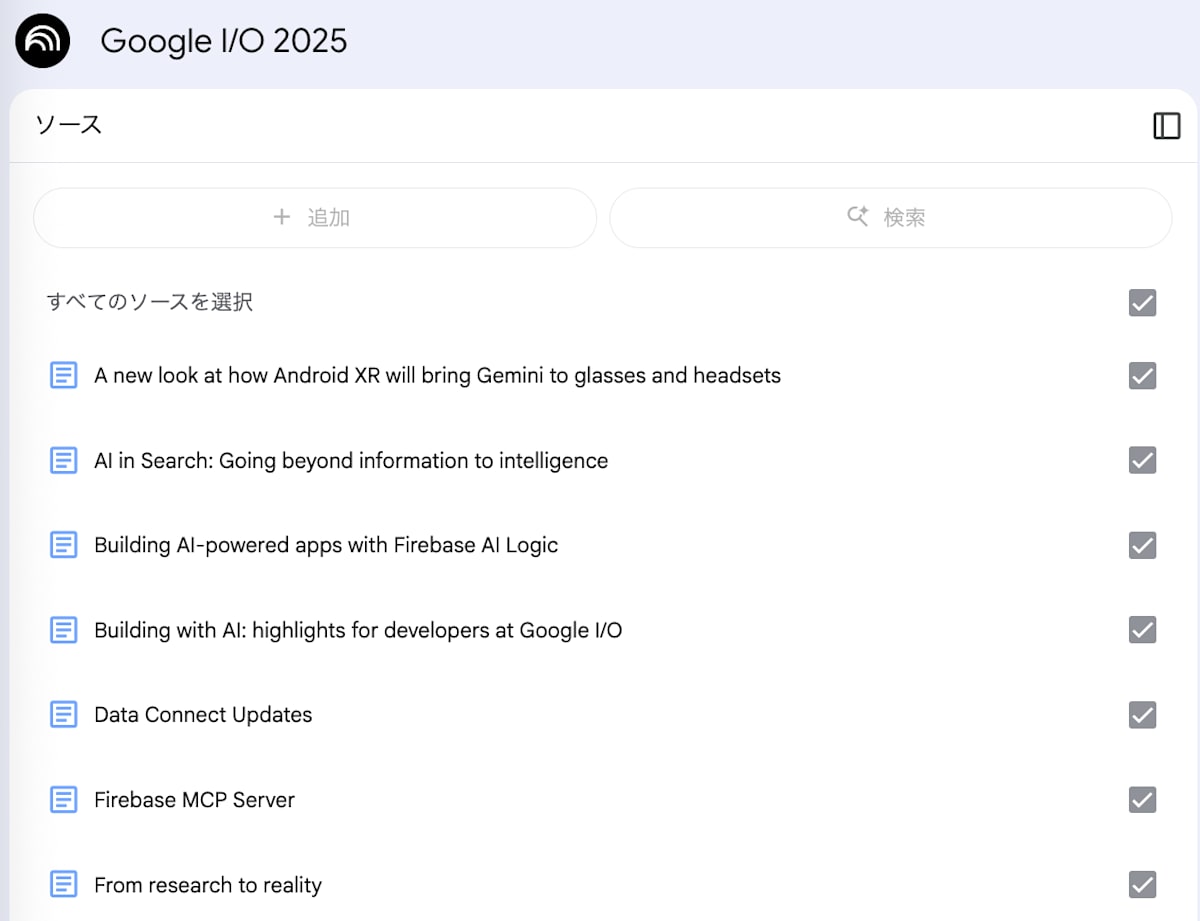

2025年5月に Google I/O'25があり今回も様々なアップデートが発表されましたが、公式が Google I/O'25のリソースをまとめたノートブック を公開してくれています。本編の Keynote セッションは YouTube にあがっています が、大体2時間くらいあります。最初は YouTube リンクなどをソースに追加してインプットしていたのですが、公式対応してくれているならその必要もないですね。このノートブックは一般公開機能を使って Google から公式提供されており誰でも閲覧できます。

Understand all the I/O news with NotebookLM.より引用

単純にチャットや要約で利用するのはもちろん、リソースが束ねられている点も嬉しいポイントです。Google I/O に限らずテックカンファレンスはアップデート項目が多く情報源を探すのに苦労することも多いですが、すでにリストアップされているので気になる内容はソースから辿ることができます。例えば私の例ですが、Firebase MCP Server を利用できることを見落としていましたが、ソースを見ていて気づきました。firebase-tools で開発されており、CLI で firebase コマンドを覚えておく必要もなく自然言語でやりとりできるようになるのでしょう。

Google I/O'25 Notebookより引用

Google はもちろん、今後のテックカンファレンス系も NotebookLM にソースをまとめて一般公開するといった流れになるのかなと思います(自分が主催者または運営だったらそうするかなと思います)。

DeNA 南場智子流の商談準備

これは 2025年2月に開催された DeNA × AI Day 2025の Keynote で発言されていた内容で、経営者の使い方として参考になります。商談相手のパーソナリティや思考の事前インプットするために、インタビュー記事や SNS 発信をソースに情報収集するそうです。この Keynote は2月時点なので「タクシーの中でチャットする」と発言されていますが、今は Audio Overview があるので音声でインプットしているのかもしれません。いずれにしても、分刻みの時間がない中での経営者でもインプットできる点は強みですし、「交渉は会う前から始まっている」を体現する形で、事前準備を徹底するすべての業務に生かせそうです。

“まず初めて会う人の情報は「Perplexity」で「その方についての必読記事はなんですか」と聞いて、そのURLをすべて「NotebookLM」にアップします。その人がYouTubeでも発信している場合は、最近のものは全部URLをコピーして「NotebookLM」に入れます。Xで発信している場合はテキストで入れることもあります。”

“すぐにその方の最近の考え方とか、どんな活躍をしているかがまとめられ、効率的に分かります。打ち合わせに行くタクシーの中で「NotebookLM」とチャットをしながら「この方はトランプ政権については何か言っていますか」とか、「スタートアップエコシステムについてはどうでしょうか」と聞くと、「この人はこれについてこんな考えを持っているよ」と答えてくれるので、ピンポイントでもいい情報が集まります。”

ちなみに DeNA × AI Day 2025の本編は YouTube にもあがっていますし、雑多ですがスクラップしていますので興味があればご参照ください。

経営戦略の透明性@ログラス社

ログラス社 CEO が X で投稿していた内容ですが、5時間のキックオフスピーチをソースとしてノートブックにまとめて全社員に公開したそうです。長時間のスピーチは後で振り返るのも大変なので、ある種の"会社方針 Wiki" として全社員がいつでもアクセスできるのは社員目線で嬉しいと思います。

私の所属する会社でもキックオフは毎シーズンありますし、そこで言及される戦略を元に日頃の業務の意思決定をしたりしています(会社員ではそういう方が多いと思います)。シーズン初めに述べられた戦略はどうしても時間の経過とともに忘れられてしまいますが、いつでもアクセスできる状態で公開されていればその心配もなくなりそうです。もちろん、これまでも資料や録画は共有されていますが、それを毎回見直すのは大変ですし、チャットで FAQ できたりするのは NotebookLM の強みですよね。

資格試験の壁打ち学習

こちらは2025年5月に GA となった Google Cloud 認定資格の「Generative AI Leader」での最速合格レポートより引用した事例です。GA になったばかりで過去問もなく情報が出回っていない中、試験概要や出題範囲をソースとして投入し壁打ちして学習した事例です。

Google Cloud 認定資格を受験したことがある方であればわかると思いますが、大半は過去問が Udemy や海外サイトなどに転がっており参考に勉強している人も多いと思います。Generative AI Leader は GA したばかりでそれらの情報がない中ですが、壁打ちして最速合格できたとのことでした。

また、NotebookLM は「学習ガイド」機能でクイズ化もしてくれるので、知識定着の確認用途でも優秀です。試しに Generative AI Leaderの試験ガイド をソースに学習ガイドを使うと以下のような設問を作ってくれます。

クイズ (ショートアンサー)

- ジェネレーティブ AI は、どのようなタイプの新しいコンテンツを生成できますか?

- 教師あり学習と教師なし学習の主な違いは何ですか?

- 機械学習ライフサイクルの主な段階を挙げてください。

- 基盤モデルを選択する際に考慮すべき要因は何ですか?

- 構造化データと非構造化データの違いを説明し、それぞれの例を挙げてください。

- ジェネレーティブ AI ランドスケープのコアレイヤーを列挙してください。

- Google Cloud が企業向け AI プラットフォームであると言えるのは、どのような特徴があるからですか?

- ジェネレーティブ AI モデルにおける「ハルシネーション」とは何ですか?

- プロンプトエンジニアリングの目的は何ですか?

- グラウンディングはジェネレーティブ AI モデルの出力にどのように影響しますか?

クイズ解答キー

- テキスト、画像、コード、動画など、様々なタイプの新しいコンテンツを生成できます。

- 教師あり学習はラベル付きデータで訓練されるのに対し、教師なし学習はラベルなしデータからパターンを抽出します。

- データ取り込み、データ準備、モデル訓練、モデル展開、モデル管理です。

- モダリティ、コンテキストウィンドウ、セキュリティ、可用性、コスト、パフォーマンス、ファインチューニング、カスタマイズなどです。

- 構造化データは表形式で整理されており(例:スプレッドシート)、非構造化データはフォーマットが自由です(例:画像)。

- インフラストラクチャ、モデル、プラットフォーム、エージェント、アプリケーションです。

- 責任性、セキュリティ、プライバシー、信頼性、スケーラビリティなどの特徴を備えているためです。

- モデルが事実に基づかない、または意味をなさない出力を生成する現象です。

- 基盤モデルとの対話を最適化し、より良い、より関連性の高い出力を得ることを目的としています。

- グラウンディングは、モデルが特定のデータソースや知識に基づいて出力を生成するようにガイドし、より正確で信頼性の高い応答を可能にします。

エッセイ形式問題案

- Google Cloud Certified Generative AI Leader が組織内で担う役割と、その成功に不可欠なスキルセットについて詳細に論じなさい。技術的な実装ではなく、戦略的リーダーシップと影響力に焦点を当ててください。

- ジェネレーティブ AI におけるデータ品質とデータアクセシビリティの重要性について、ビジネスへの影響を含めて深く掘り下げて説明しなさい。構造化データ、非構造化データ、ラベル付きデータ、ラベルなしデータの違いに言及し、それぞれのビジネスへの関連性について論じなさい。

- Google Cloud のジェネレーティブ AI オファリングが、どのように顧客体験を向上させ、開発者が AI を活用したアプリケーションを構築することを可能にしているかについて、具体的なサービス(Vertex AI Search、Customer Engagement Suite、Vertex AI Platform など)に触れて説明しなさい。

- ジェネレーティブ AI モデルが抱える一般的な限界(ハルシネーション、バイアスなど)について説明し、それらを軽減するために Google Cloud が推奨するプラクティス(グラウンディング、RAG、プロンプトエンジニアリング、ファインチューニングなど)について詳細に論じなさい。

- 成功するジェネレーティブ AI ソリューションを組織に導入するための Google Cloud 推奨ステップについて説明しなさい。特に、Secure AI と Responsible AI の重要性、およびそれらがビジネス戦略にどのように組み込まれるべきかについて重点的に論じなさい。

用語集

- 人工知能 (Artificial Intelligence, AI): コンピュータシステムが人間のような知的能力(学習、問題解決、知覚など)を模倣する技術。

- 自然言語処理 (Natural Language Processing, NLP): コンピュータが人間の言語を理解、解釈、生成できるようにする AI の分野。

- 機械学習 (Machine Learning): 明示的にプログラムされることなく、データから学習して予測や決定するアルゴリズムやモデルの開発に焦点を当てた AI のサブフィールド。

- ジェネレーティブ AI (Generative AI, gen AI): 新しい、オリジナルのコンテンツ(テキスト、画像、コードなど)を生成できる AI の一種。

- 基盤モデル (Foundation Models): 大規模データセットで訓練され、様々なダウンストリームタスクに適用できる、汎用性の高い巨大なモデル。

- マルチモーダル基盤モデル (Multimodal Foundation Models): 複数のタイプのデータ(テキスト、画像、音声など)を理解し、処理できる基盤モデル。

- 拡散モデル (Diffusion Models): ノイズからデータを生成することで、高解像度の画像を生成するのに特に効果的な生成モデルの一種。

- プロンプトチューニング (Prompt Tuning): 大規模な基盤モデルのごく一部のパラメータだけをチューニングすることで、特定のタスクにモデルを適用させる手法。

- プロンプトエンジニアリング (Prompt Engineering): 生成モデルから目的の出力を得るために、入力として与えるテキスト(プロンプト)を設計するプロセス。

- 大規模言語モデル (Large Language Models, LLMs): 膨大な量のテキストデータで訓練された、非常に大きな言語モデル。

- 構造化データ (Structured Data): 事前に定義されたフォーマットに従い、整理されているデータ(データベースのテーブル、スプレッドシートなど)。

- 非構造化データ (Unstructured Data): 定まった構造を持たず、自由形式で存在するデータ(テキスト文書、画像、音声ファイルなど)。

- ラベル付きデータ (Labeled Data): 各データポイントに、学習タスクに関連する意味のあるラベルやタグが付けられているデータ。

- ラベルなしデータ (Unlabeled Data): 各データポイントにラベルやタグが付けられていないデータ。

- ハルシネーション (Hallucinations): 生成モデルが事実に基づかない、または意味をなさない、しかしもっともらしく聞こえる出力を生成する現象。

- グラウンディング (Grounding): 生成モデルの出力を特定の情報源(企業データ、Web データなど)に固定し、より正確で関連性の高い応答を生成させるプロセス。

- 検索拡張生成 (Retrieval-Augmented Generation, RAG): 外部の情報源(ドキュメント、データベースなど)から関連情報を検索し、その情報を使って生成モデルの応答を生成する手法。

- プロンプトチェイン (Prompt Chaining): 複数のプロンプトを連鎖させて、複雑なタスクを実行したり、より詳細な応答を生成したりする手法。

- 思考の連鎖プロンプト (Chain-of-Thought Prompting): モデルに推論の途中段階を生成させることで、複雑な問題解決能力を向上させるプロンプト技術。

- ReAct プロンプト (ReAct Prompting): Reason (推論) と Act (行動) を交互に行うことで、より効果的な問題解決と情報収集を可能にするプロンプト技術。

- 温度 (Temperature): 生成モデルの出力のランダム性を制御するパラメータ。高い温度はより多様で創造的な出力を、低い温度はより予測可能で焦点を絞った出力を生成する傾向がある。

- Top-p (Nucleus Sampling): 生成される可能性のあるトークンを、その累積確率が指定された閾値(p)に達する最小限のセットに絞り込むサンプリング手法。

- Secure AI Framework (SAIF): AI システムのセキュリティを確保するための Google のフレームワーク。

- 責任ある AI (Responsible AI): 公平性、透明性、プライバシー、セキュリティ、説明責任などを考慮して AI を開発および使用する取り組み。

- 説明可能性 (Explainability): AI システムがどのように特定の決定や出力を生成したかを人間が理解できる能力。

勉強会での活用事例

クラスメソッド社のブログで公開されていた事例です。登壇資料をソースに読み込み、ノートブックごとメンバーに共有します。

この記事を拝見して私のチームでもノートブックの共有を試運転しています。時間的制約で登壇者に質問しきれない部分とかはチャットで質問できますし、勉強会に参加できなかったメンバーも Audio Overviews などでさらっとキャッチアップできる点が優秀です。

作成したノートブックの共有は一般公開してもよいですし、毎回勉強会に参加するメンバーが固定化してその範囲のみの共有で十分な場合は、 Google グループを作成 して共有するのが楽だと思います。

勉強会での NotebookLM 活用のフローイメージ

最近の動向

以下は、初期リリースから最近のモバイルアプリリリースまでを調査した主要マイルストーンです。Experimental フェーズを外れた2024年10月頃からの進化のスピードがすごいですね。本セクションでは最近のモバイルアプリリリースと今後の機能の周辺調査についてまとめています。

| 日付 | マイルストーン・機能追加 | 概要 |

|---|---|---|

| 2023年初期 | 初期リリース (Project Tailwind) | Google Labs が開発した AI 駆動型研究・メモ作成ツールの最初の発表 |

| 2024年9月 | Audio Overviews リリース | 文書を会話形式のポッドキャストのように要約する機能が追加 |

| 2024年10月中旬 | 「実験的」ステータス解除 | 製品の安定性と成熟度が認められ、本格商用化へ移行 |

| 2024年12月 | NotebookLM Plus 企業向けリリース | 有料版が企業および有料 Gemini サブスクライバー向けに提供開始 |

| 2025年2月5日 | Google Workspace コアサービス化 | エンタープライズグレードのデータ保護と共に Google Workspace に統合 |

| 2025年2月10日 | NotebookLM Plus 個人向け拡大 | Google One AI Premium を通じて個人ユーザーにも提供開始 |

| 2025年4月2日 | Discover sources 機能追加 | ウェブから関連ソースを検索・取り込む機能が追加され、リサーチ能力が向上 |

| 2025年5月 | モバイルアプリのリリース | Android および iOS 向けアプリが提供され、利用環境が拡大 |

| 2025年6月 | 一般公開機能の追加 | リンクを知っているる人全員が閲覧できる形で公開可能に |

Discover sources 機能の追加

2025年4月に登場した機能で、知りたいことを自然言語で入力すると自動的に Web から関連ソースを検索し NotebookLM のソースに追加できます。

NotebookLM のソースには Google Workspace 関連のファイル(Google Docs, Google Slides 等)はもちろん、YouTube や Web サイトの URL、テキストファイルなど多様な形式を追加できますが、手動での追加が必要となります。Discover sources はその手動追加部分も省略し自動で行います。

New in NotebookLM: Discover sources from around the web より引用

私はよく DeepResearch の簡易版のような感覚で使っています。ソース上限が10件までなので、 より高度な調査用途でしたら DeepResearch を使ったほうが良いと思います。最近はマクロな技術トレンドを把握するためには過去や技術の変遷を知る必要があると思い、歴史をまとめてもらうことが多いです。例として、以下はプログラミング言語 Dart の登場から今に至るまでの調査結果です。NotebookLM の Breefing(要約)機能を組み合わせることで、簡単に情報インプットができます(検索スピードも早くこの要約に至るまで2~3分で完了します)。もちろん要約に限らず、マインドマップや音声でのインプットもできます。

Discover sourcesでDartの歴史について言及し要約した様子

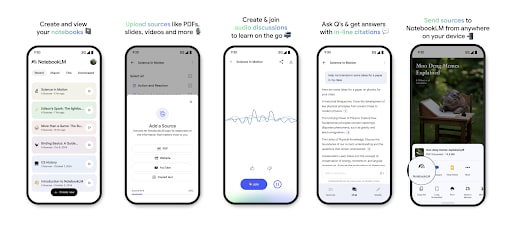

モバイルアプリのリリース

2025年5月19日に NotebookLM の iOS・Android アプリがリリースされました。現在はまだソース・チャット・Audio Overviews の基本機能しか搭載されておらず Web 版と比較すると最低限の実装になっていますが、今後追従することでしょう。ただ Audio Overviews の機能がついている点が大きく、バックグラウンド再生もサポートされているため通勤・通学、家事・育児などあらゆる場面でのインプットが捗ります。

Google Play ストアスクリーンショットより引用

共有機能(Share)でそのままソース追加のUX

外出中や業務外にスマートフォンで調べ物をする方も多いと思います。気になった記事や SNS などの発言をブックマークしたり、Notion や Obsidian、メモアプリ機能を使ってあとで見返すといった使い方もしているかもしれません。共有ボタンからそのままソースに取り込めるため、これまで以上に調べ物が捗ることでしょう。SNS でいくつか方法があがっていますが、抜粋して引用させていただきます。

参考: 共有機能でアプリにソースを取り込む手順(ぬこぬこ氏のX投稿より引用)

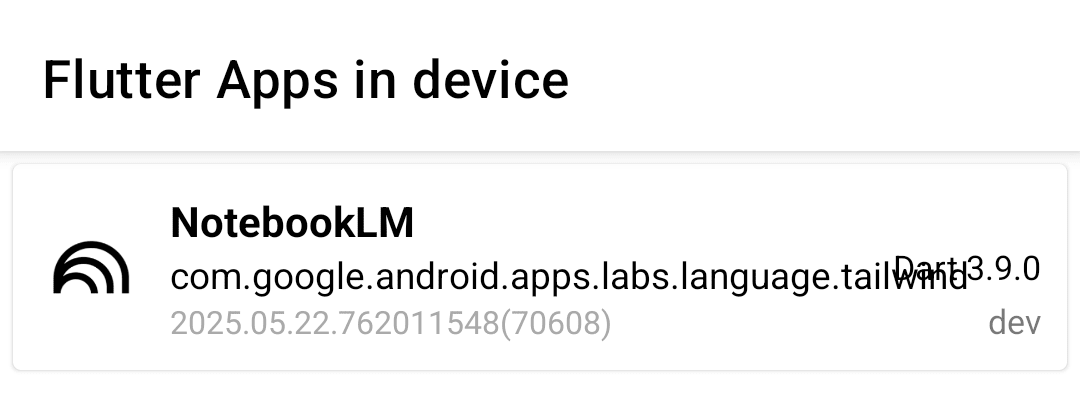

Flutter製

本記事では余談中の余談なので読み飛ばして問題ないですが、NotebookLM アプリは Flutter で開発されているようです。"👀"アイコンで引用されているだけで言及は見つからなかったですが、触った雰囲気だけでもそれとわかります。

ライセンスページが見つからなかったので、一応 Android で Flutter 製かチェックできる FlutterShark を使ってみたら、しっかりでてきました。しかも、執筆時 Dart 3.9.0の dev チャンネルを使っているみたいで、かなり先進的に開発されている点が伺えます。Google プロダクトの Flutter 採用事例は個人的に こちら にまとめていますが、ロングタームで使われていて良いニュースだと思います。

FlutterSharkスクリーンショットより引用

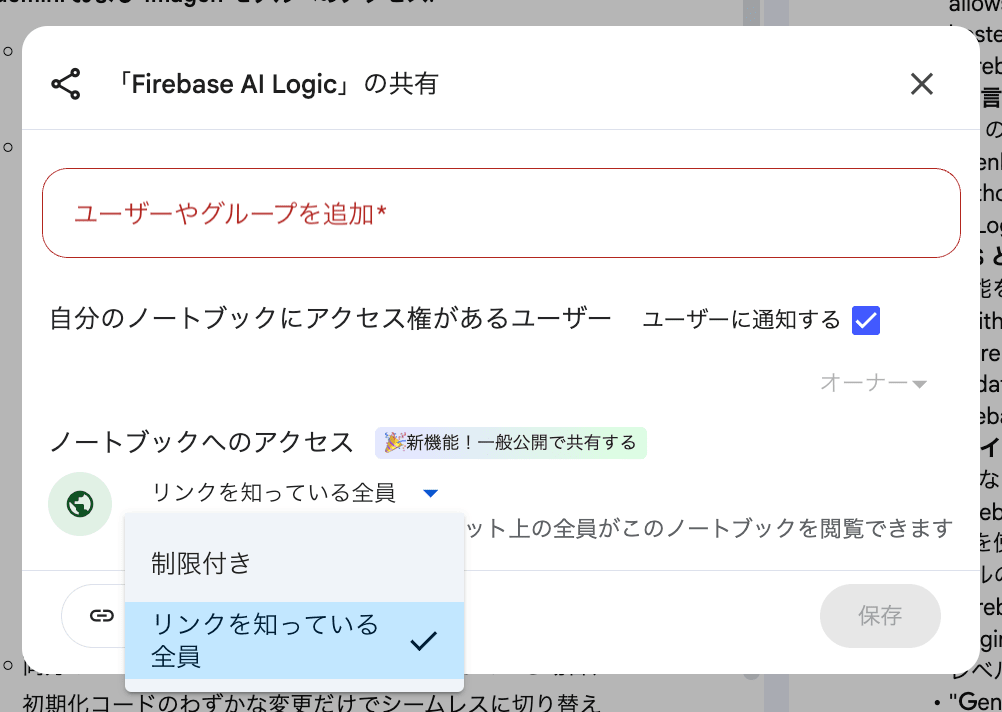

一般公開機能の追加

2025年6月3日にノートブックのリンクを知っている人全員アクセスできる一般公開機能が追加されました。これまでの共有は同じ Google Workspace 内のユーザーのみでしたが、全世界へ公開できるようになりました。これにより、カンファレンス系のキャッチアップ のような公開情報を束ねて参加者に配布できるような使い方ができます。

Audio Overviewsの追加機能

Interactive mode

Audio Overviews をホストに第三者として会話に割り込んでインタラクティブに対話ができるモードです。すでにベータ版利用できる Interactive mode ですが、まだ日本語対応はされていません。これまでは聴くだけ学習でしたが、動的に質問を挟むことにより対話学習ができるようになります。

中央の"Join"ボタンから割り込んで会話ができる

どうやら英語版では「Audio Overviews」機能が2024年の9月頃に利用可能になり、その約3ヶ月後である2024年の12月頃に、この「interactive mode」が搭載されたそうです。

「Audio Overviews」の日本語対応が2025年の5月だったことを考えると、もし英語版と同じようなペースで開発が進むのであれば、2025年の夏、例えば8月頃には、私たちも日本語で AI と対話しながら資料を読み解ける日が来るかもしれません!

https://note.com/it_lawyer/n/n2dc4dcd1a225

日本語版対応の時期は不明ですが、Audio Overviews 機能が日本語対応されるまでの期間から推測すると、夏頃には使えるようになるかもしれません。

音声時間の設定

地味ですが結構嬉しい設定です。現在は10分弱の音声しか出力できないですが、short・long が選択できるようになるみたいです。ソース量の大小にかかわらず一律で10分弱にまとめられてしまうので、「もうすこし丁寧に解説してほしいな」と思うこともしばしばありました。このあたりのニーズに合わせて柔軟に設定変更できるのは嬉しい機能です。先行して英語版では利用できるみたいなので近々日本語版にも対応されることでしょう。

With short (~5+ min), long (~20+ min), and default (~10+ min) settings,

English only, but more soon!

Video Overviewsの登場

こちらは、音声に加えて良い感じの説明動画も作ってくれる機能です。すでに Google I/O'24 の SNS 投稿 で使われていました。利用シーンですが、学習はもちろん、自社アプリの使い方動画、広告マーケティング動画など SNS に投稿する短尺動画を簡単に作れるようになりそうですね。アップデートも coming “SO” soon!と書いてありますが、英語版が先行して日本語版は2,3ヶ月遅れて利用できると言った感じでしょうか。

今後に期待

現時点でも情報インプット・学習効率が劇的に変わってありがたい限りですが、欲を言えば以下あたり対応されるようになると個人的には嬉しいです。

API 対応による外部統合の自動化

- 現在 API は非対応のため基本的にアップロードはマニュアルになるので全自動化はできない

- Google Meet の AI 議事録化と繋いだり、あるいはめちゃ早く RAG 化できたりするはず

追記: NotebookLM Enterprise 版のみ API 経由での操作が可能になりました。通常版と Pro 版については2025年10月時点においても未対応です。

ソースの自動更新

- Google Docs などを読み込ませたあとに、元ファイルを修正しても変更は反映されず手動で再同期作業が必要

- NotebookLM にアップロードされたソース(ファイル)はコピーなので、元のファイル自体を編集しても反映されないのは納得しつつ、できたら嬉しい

まとめ

本記事では、2025年5月現在の NotebookLM の世の中の活用事例と最近の動向についてご紹介しました。2024年に登場して以降、凄まじい進化を遂げていますが、2025年もまだまだその勢いは止まらないみたいです。いろいろな生成 AI ツールが出てきていますが、NotebookLM は人間の作業を完全に自動化するものではなく人間の能力を拡張するツールであるという点が、個人的に気に入っているポイントです。AI が反復的で時間のかかるタスク(要約、情報抽出)を効率化し、人間がより複雑な認知タスク(分析、判断、創造性)に集中するという、AI 時代における理想的な協調作業モデルだと思います。NotebookLM は今後もみなさんの業務や学習などあらゆる場面で重宝することでしょう。

Discussion