😃

【Transformer】Residual connection(残差コネクション)の話

当たり前のようにある残差コネクション

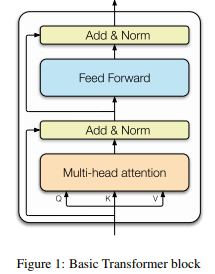

(引用:https://arxiv.org/pdf/2303.15647.pdf)

Transformerには、残差コネクション[1]が設けてある(Add & Normに向かう矢印部分)

☛attentionの部分とfully-connected network(FFN:全結合層)の両方に搭載されている。

attentionの部分側の残差コネクションにフォーカスしてみると,

・Multi-Head Attentionの出力は入力と加算(Add)される。

・加算後はLayer Normalizationが行われる。

この残差コネクションはモデルが大きくなるほど、大きな役割をもつ。

初期の残差ブロック

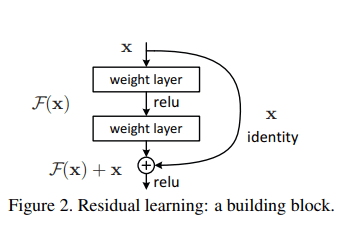

論文(Deep Residual Learning for Image Recognition)にて登場

(引用:https://arxiv.org/pdf/1512.03385.pdf)

生まれた背景

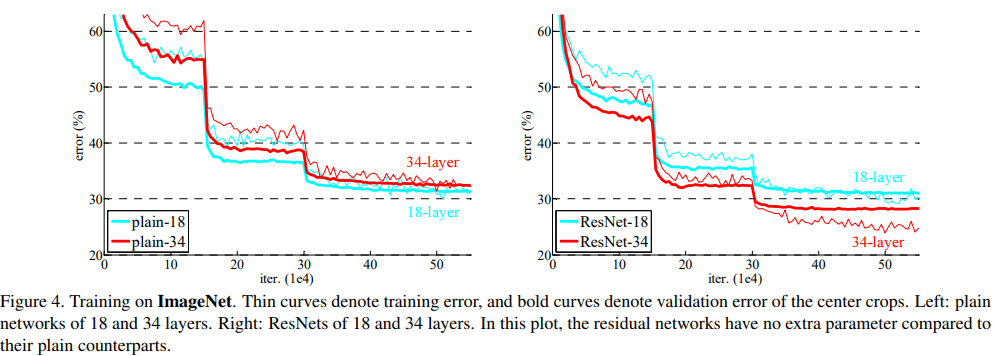

(引用:https://arxiv.org/pdf/1512.03385.pdf)

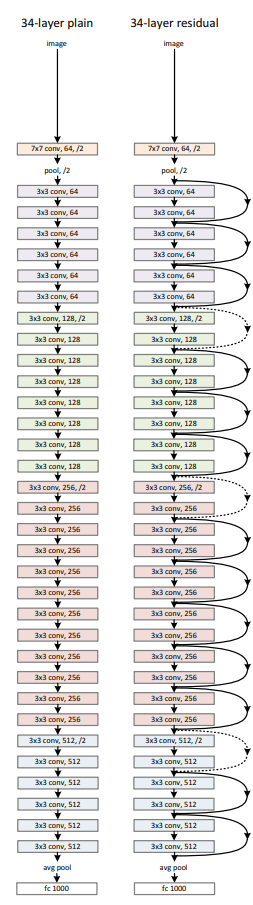

上記に34層のplainなNNと残差があるNN(ResNet)を載せておく。

(引用:https://arxiv.org/pdf/1512.03385.pdf)

plainなNNでは、層が増えれば増えるほど、精度が悪化していることが分かる。

もちろんplainなNNには、BN(バッチノーマライゼーション)はある。

☛勾配の消失はないと考えた。

それにもかかわらず、劣化する現象が見られた。

-

skip connectionとも呼ばれたりする ↩︎

Discussion