時系列データ分析 論文解説④「 S-Mamba 」

論文

時系列データ分析のための論文紹介になります。Mamba の解説はこちらになります。

タイトル

Is Mamba Effective for Time Series Forecasting?

論文: https://arxiv.org/pdf/2403.11144

GitHub: https://github.com/wzhwzhwzh0921/S-D-Mamba

概要

- Mamba (v1) を時系列予測に適用した

- Simple-Mamba(S-Mamba)は低い計算負荷を維持しつつ、最先端の性能を達成した

- シンプルに言えば、iTransformer の Mamba バージョンである

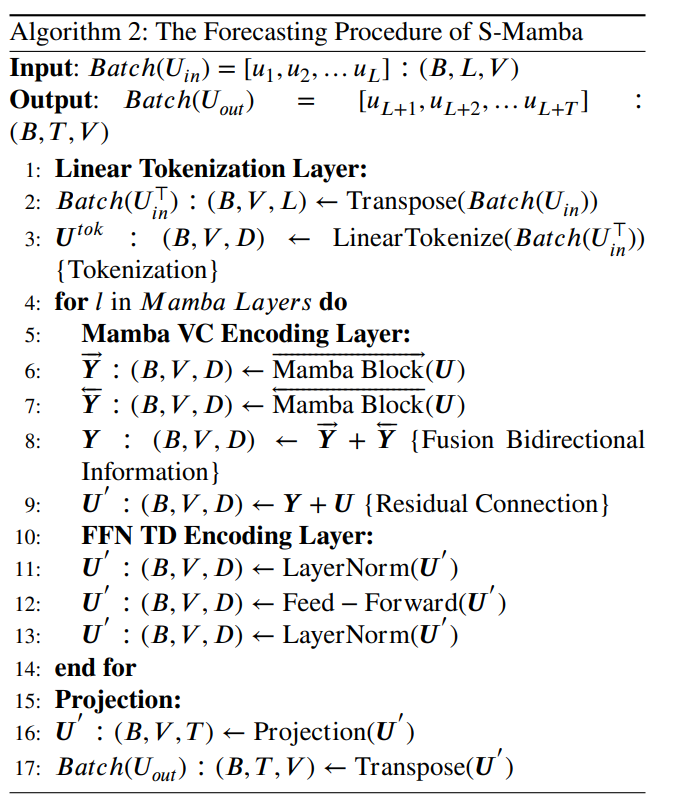

モデル構造

Mamba レイヤーを理解できていれば、後は iTransformer と同じような構造です。

特徴量と時系列の反転

iTransfomer 同様、反転した後、時系列

双方向の相関

iTransfomer では特徴量次元に対して Transfomer Encoder に入力する事で、特徴量同士の相関のような計算が行われていました(参照)。

S-Mamba でも同様の狙いと思われます。

そして、ご存じの通り Mamba は状態空間モデルであるため、単方向の時間軸

結果

結果はこのような感じです。やる気が無いような感じで申し訳ありませんが、詳細な考察などは論文をご参照ください。

考察と感想

紹介しておいて何ですが、単に色々組み合わせてやってみました、といった感じであり、アイデアの新規性などは無かったです(無駄にしたくない想いで記事にしました...)。

ひとつ気になる事は、結局 Mamba をはじめとするSSM というのは、情報を内部状態に圧縮する分、Attention に比べて不利です。原理的には Transformer の方が良いはずなんです。

なのに、ほぼ同じ構造である iTransfomer より平均的に若干良いのは不思議です。相変わらず RLinear が優れているデータセットもありますし...。

やはり、ひとえに「時系列予測」と言っても、データセットが違えばドメインが異なるわけで、それぞれに適した構造を考えてやる必要があるんじゃないかと、個人的には思うところです。

Discussion