【gpt-oss】20bモデルをollamaで触ってみた!

はじめに

2025年8月6日にOpenAIが「gpt-oss」を発表しました。

ローカルLLMについて詳しく知らなったのですが、Xやブログを拝見するとすごい発表なんだと思い、さっそく触ってみました。

GPT‑OSS とは

- OpenAI初のオープンウェイト(重みが公開された)言語モデル

-

gpt‑oss‑120b(約1200億パラメータ)とgpt‑oss‑20b(約200億パラメータ)の2種類がある

- 120bモデルはo4‑mini 相当の性能を持ち、単一GPU(約80GB)での実行が可能

- 20bモデルは一般的なノートPCや16GBメモリ端末で動作可能

- Apache 2.0ライセンスにより、商用利用・再配布・カスタマイズが可能

1200億という膨大な数のパラメータをローカルで使用できる技術として、MoEという技術があるようです。

使うことのメリット

-

モデル利用料無料

生成AIを活用する際は、モデルの利用料に縛られることが多いため、

それが無料になることでコスト面での不安が拭えます。 -

セキュリティ的に安全

一度ダウンロードすれば、インターネットに接続しなくても動作が可能です。

また、ローカルなのでプロンプトの内容や生成した回答はすべてローカルPCの中です。

そのため、ネットワークやデータ的にとても安全に生成AIが使用できます。 -

OSSなので商標・カスタマイズ可能

Apache 2.0ライセンスなので、商標はもちろん、カスタマイズも可能です。

自社独自の用途に合わせた微調整や展開ができるようになります。

ollamaで使ってみた

ollamaとは

「Ollama」はLLMをWindows/Mac/Linuxで簡単に実行できるアプリケーションです。

ダウンロード

Ollamaのサイトからインストーラをダウンロードしてインストール。

モデル選択・ダウンロード

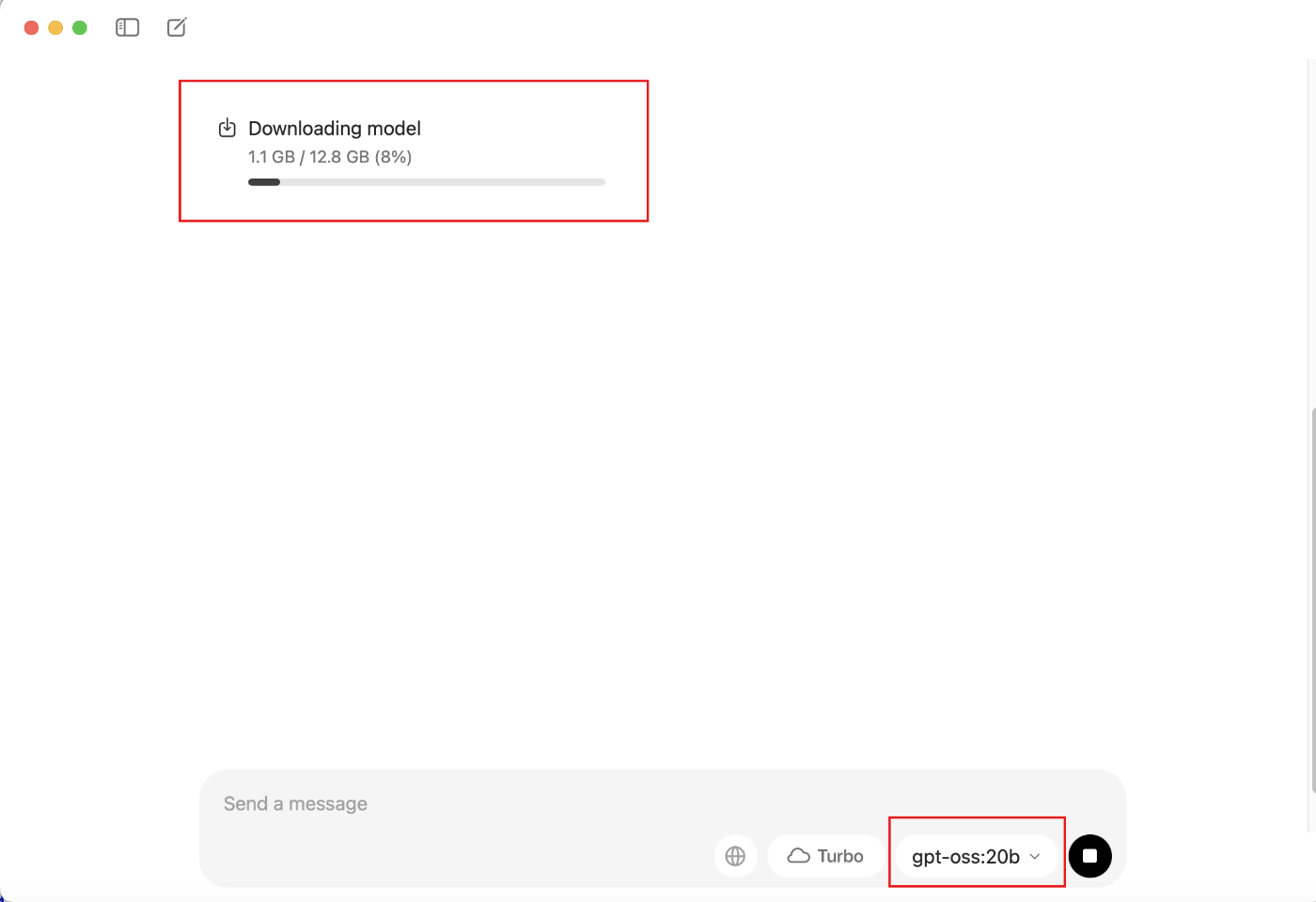

「Ollama」の実行し、モデルで「gpt-oss:20b」を選択。

メッセージを入力して送信すると自動的にダウンロード (20分ほど) が始まります。

※M1 Macbook pro メモリ32GBの場合

完了したら好きなように質問してみましょう!

回答の動き的に一度英語で回答した後に日本語で回答しているようなので、少し時間がかかる印象です。

おわりに

実際に調査し、触ってみてこれからのローカルLLM活用がとても楽しみになりました。

コストパフォーマンスが優れているという点では、Bedrockで使用できるようになれば他のモデルよりも優位に立つ可能性もありそうです。

参考

Discussion