ChatbotArena的なシステムでTanuki-8x8Bを始めとする大規模言語モデルの日本語性能を評価する(2024年8月)

関連URL

- Tanuki-8x8B

- Tanuki-8B

-

大規模言語モデルTanuki-8B, 8x8Bの位置づけや開発指針など

- 全体像

-

フルスクラッチで開発した大規模言語モデルTanuki-8B, 8x8Bの性能についての技術的な詳細

- Japanese MT-Benchにおける性能の詳細とJasterに関する一部言及

-

ChatbotArena的なシステムでTanuki-8x8Bを始めとする大規模言語モデルの日本語性能を評価する(2024年8月)

- ブラインドテスト形式で種々のモデル出力の優劣を人手で評価した結果と、各種ベンチマークとの関係性

-

大規模言語モデルを開発するにあたっての事前・事後学習の戦略メモー特に合成データについてー

- 開発の鍵となった合成データ戦略に至るまでの試行錯誤など

-

Tanuki-8B,8x8Bの開発完了までに考えていたことと、「科学の基盤モデル」の構築に向けた考え

- 開発時に考えていたこと、科学研究が可能な基盤モデルの構築に向けた現状整理など

概要

2024年8月にTanuki-8x8B, Tanuki-8Bという大規模言語モデル(LLM)を開発しました。このモデルの開発にあたっては、Japanese MT-Benchという対話・作文系の能力を問うベンチマークの結果を参考にしました。そのおかげか、国産モデルとしては高い性能が出ています。

このベンチマークは当該能力を計測する上で定番的に用いられていますが、必ずしも、実戦での対話能力の高さを保証するものではありません。

そこで、ユーザーの質問に対するモデルの回答をブラインドテスト形式で比較する、いわゆるChatBot Arenaのようなシステムで性能を検証することにしました。

本記事では、対話試験の結果や、他のベンチマークとの比較、他のモデルに対する位置づけなどを記載します。

ChatBot Arenaとは

既存システムとの比較

本家はこちらのサイトです。24年8月23日時点で、131種のモデルと170万件のフィードバックが集まっているようです。

日本語版も存在します。43種のモデルが登録されているようです。ただし最近はモデルの更新が止まっているようで、最新のClaude 3.5ではなくClaude2.1がエントリーされています。また、このサイトでは本家と異なり、ユーザーは自身で生成した質問を入力することはできず、あらかじめ準備された質問をランダムに選ぶ仕様になっています。

仕組み

ChatBot ArenaはLLMの出力を相対評価するシステムです。以下のようなスキームでLLM同士を戦わせながら、モデル同士の性能を比較していきます。

- ユーザーが好きな質問をする

- ランダムに選ばれた2つの匿名のLLMが回答する

- ユーザーが好みの回答を選ぶ*

- 回答が選ばれたモデルが加点される

- 1に戻る

*両方とも良かった、悪かった回答も記録

特徴

ChatBotArenaはLLMの性能を計測するための完璧なシステムではありませんが、ChatBotとしての手触り感を調べる上は、現状ではベストの枠組みであるように思われます。

メリット

- ChatBotとして最も重要な、人間によるフィードバックがなされる

- 通常のベンチマークと異なり、実戦形式の評価である

- 評価の都合を優先した不自然な制約条件をつける必要がない (e.g., 出力形式の固定)

- ベンチマーク問題のリークや、ベンチマークへの過学習といった課題に悩む必要がない

- 様々なユーザーが評価に参加することで、多角的にモデル性能を比較できる

課題

- アルゴリズムや言語モデルによる評価と異なり、コスト、再現性などに課題がある

- それなりのマンパワーと計算資源を要する

- 質問項目や採点基準に評価者のバイアスがかかる

- 難解な問題は出題されにくい(評価が面倒なので、そういう質問は投稿されにくい)

- 今回の枠組みでは、シングルターンの評価のみ

- 悪意のある/低品質なフィードバックを行う評価者への対策が必要になる場合がある

- 評価者は出力の見かけを重視する傾向もある(e.g., マークダウン形式の整った見た目の回答を高評価. ただし今回は生の文字列を評価に利用)

今回の枠組み

システム

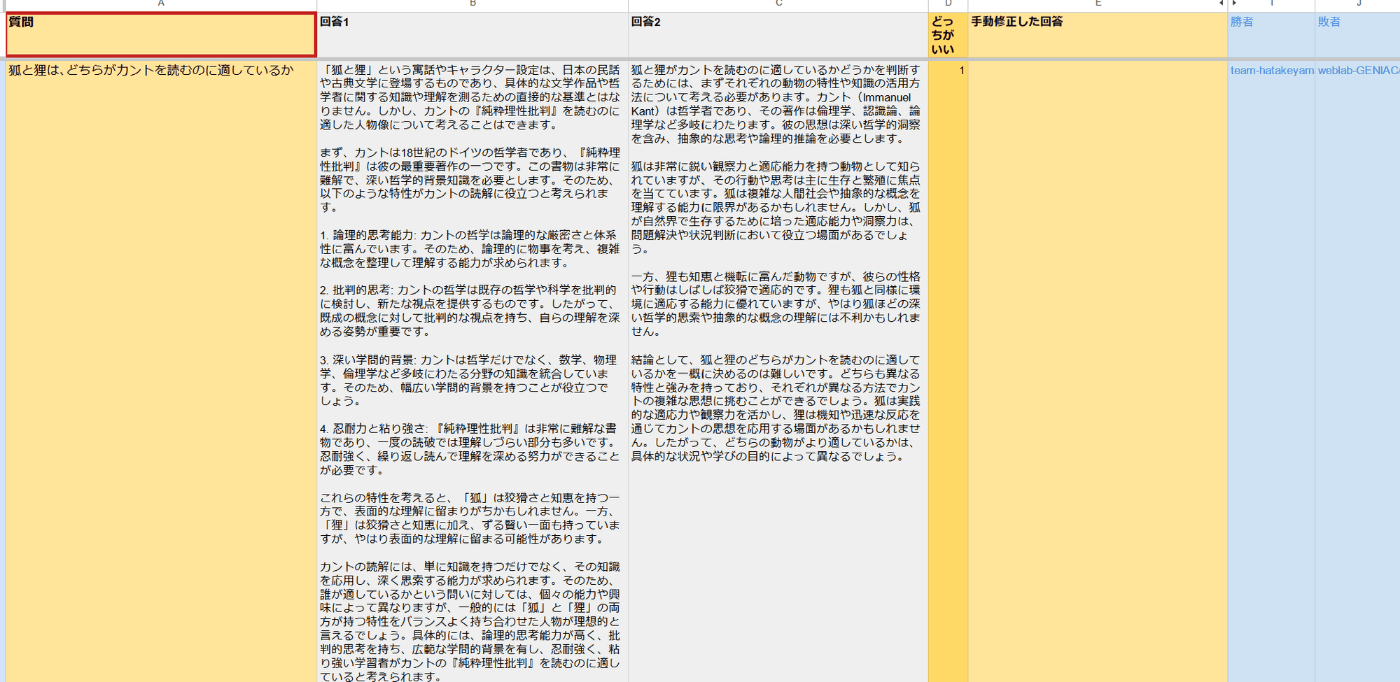

ChatBotArenaを模したシステムをGoogle SpreadSheet上に構築しました。

「質問」の列に質問を入力すると、しばらくして「回答1,2」の列に、ランダムに選ばれたLLMが回答が生成されるインターフェースです。その後、「どっちがいい」の列に回答番号を入力すると、勝者と敗者が確定するシステムです。ユーザーが回答を修正したい場合は、「手動修正した回答」の列に入力することもできるようになっています*。

*このシステムで得られたデータを、指示データセットとして使う際に役立つ機能です。

実施期間

2024年8月19日ー2024年8月25日

参加者

以下のメンバーが評価に参加しました*

- Tanukiモデルの開発者

- 松尾・岩澤研 LLM CommunityのSlackメンバー(登録上は5000名程度)

システムを一般公開すれば、より多用な評価者・視点からモデルを評価することが可能です。一方、今回のプロジェクトでは、モデルの一般公開の前に、ある程度の評価作業を済ませておく必要があったことに加え、一般公開時に求められる堅牢なサーバーシステムの構築コスト(悪意のある評価者の対策コストなど)を鑑み、内部での評価に留めることとしました。

エントリーモデル

以下の12種のモデルをエントリーしました。選択基準は、以下の2点です。

- 日本語能力が高そう

- モデル重みがオープンである(またはAPIが公開されている)

| モデル名 | 備考 |

|---|---|

| cyberagent/calm3-22b-chat | サイバーエージェントのモデル |

| elyza/Llama-3-ELYZA-JP-8B | Llama3をElyzaがチューニングしたモデル(70Bは重み、APIが非公開のため使用不可) |

| gemini-1.5-flash | Googleの高速モデル |

| gemini-1.5-pro | Googleのフラグシップモデル |

| gpt-3.5-turbo | OpenAIの高速モデル |

| gpt-4o-2024-05-13 | OpenAIのフラグシップモデル |

| gpt-4o-mini-2024-07-18 | OpenAIの高速モデル |

| karakuri-ai/karakuri-lm-8x7b-chat-v0.1 | Mixtralをkarakuriがチューニングしたモデル |

| plamo-beta | PFEの100Bモデル |

| Tanuki-8x8B-dpo-v1.0 | チームの開発モデル |

| tokyotech-llm/Llama-3-Swallow-70B-Instruct-v0.1 | Llama3-をSwallowグループがチューニングしたモデル |

| Tanuki-8B-dpo-v1.0 | チームの開発モデル(8B ver) |

8/19時点までで、ビッグテックから発表された実用性能のモデル、あるいは◯◯な条件で日本語性能1位と謳われることの多い、高性能とされるモデルのみをエントリーしました。

先述の日本語版ChatBotArenaにおいて、おそらく10位以内にランクインするようなモデルのみが選ばれる、かなりハイレベルな戦いであることを付記しておきます。例えばGPT-3.5は日本語版ChatBotArenaで13-15位 / 43位 とハイランクに位置づけられていますが、今回のベンチマークでは、最低レベルとなりました。「なんとなく日本語が喋れる」レベルの性能では不十分で、商用モデルと戦える品質の出力が求められる試合となりました。

(日本語版ChatBot Areaの上位モデル)

GPUリソースや評価コスト*の問題で、gemma系、Phi-3、Claudeなどは入れられませんでした。10 Bクラス枠としてはTanuki-8B, Elyza-8B、海外モデルの継続学習枠として、karakuri, swallow, elyzaがありますので、gemmaはその中間的な挙動を取るだろうという都合の良い解釈をしました。Phi-3は日本語がややぎこちないため、今回の試験では最低クラス帯に位置すると推定し、使わないことにしました。

例えば10 Bクラスの性能を見る目的でTanuki-8B, Elyza-8Bをエントリーしました。また、海外モデルの継続学習枠として、karakuri, swallow, elyzaをエントリーしました。最近話題のGoogleのgemmaはそれらの中間的な挙動を取るだろうと推定し、今回の評価対象からは除きました。

海外の高性能モデルとしてはPhi-3が挙げられますが、日本語がややぎこちないため、今回の試験では評価が低くなると推定し、エントリーしませんでした。

*信頼性の確保のため、1モデルを一つ追加するごとに、ざっくり100問程度の質問と評価を行う必要があります。モデル評価はそれなりに手間のかかる作業なので、途中から、あまり気軽にモデルをエントリーできなくなってきた、という経緯もあります。

推論条件

重みが公開されているモデルについては、以下の条件で推論しました(運用初期は、少し試行錯誤しました)。

- temperature = 0.3

- プロンプト: 標準のchat templateを使用

- それ以外のパラメータはデフォルト

APIで呼び出すモデルについては、全てデフォルトのパラメータを使用しました。

単なる勝率ではなく、より正確に対戦成績の集計評価が可能とされるGlicko-2レーティングや、ChatBotArenaの本家でも使われるBradley-Terryモデルに基づくレーティングも用いながらモデルの相対性能を評価しました*。

レーティングシステムは、プレイヤーの実力を評価するためのシステムで、対戦成績を基にしたレーティングの変動に信頼性や変動性を加味して、より正確に実力を反映するようにしています。このシステムでは、プレイヤーの強さが安定しているかどうかや、どれだけ変動するかを考慮して、対戦後にレーティングが適切に調整されます。これにより、従来のシステムよりも現実に近いプレイヤーの評価が可能になります。

詳細はこちらのサイトなどを参照。

*Glicko-2レーティングでは、以下の標準的なパラメータでレーティングを行いました。

レーティング r: 1500

レーティング偏差 RD: 350

レーティング変動率 vol: 0.06

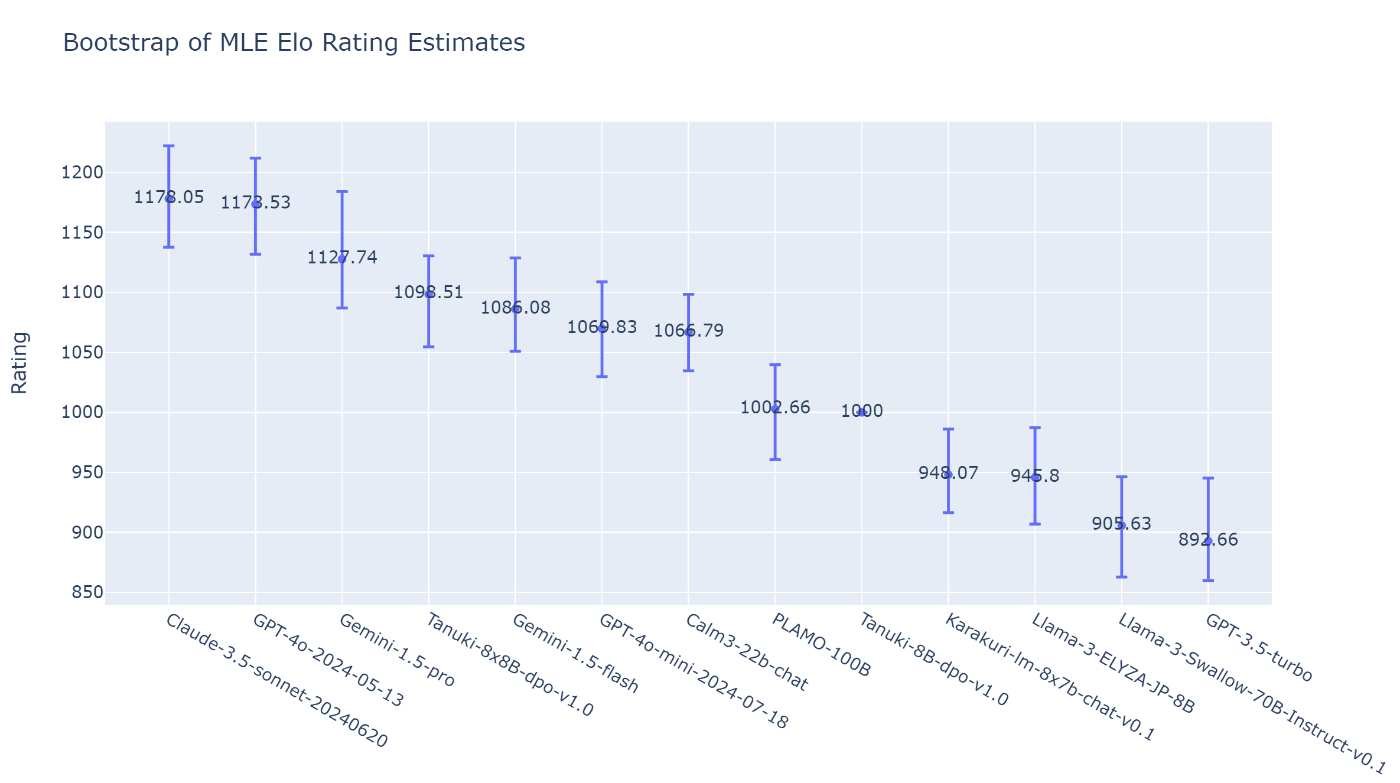

Bradley-Terryモデルでは、Tanuki-8Bの性能を1000としたときの相対レーティング値を推定しました。実装例はこちらなどを参考にしました。

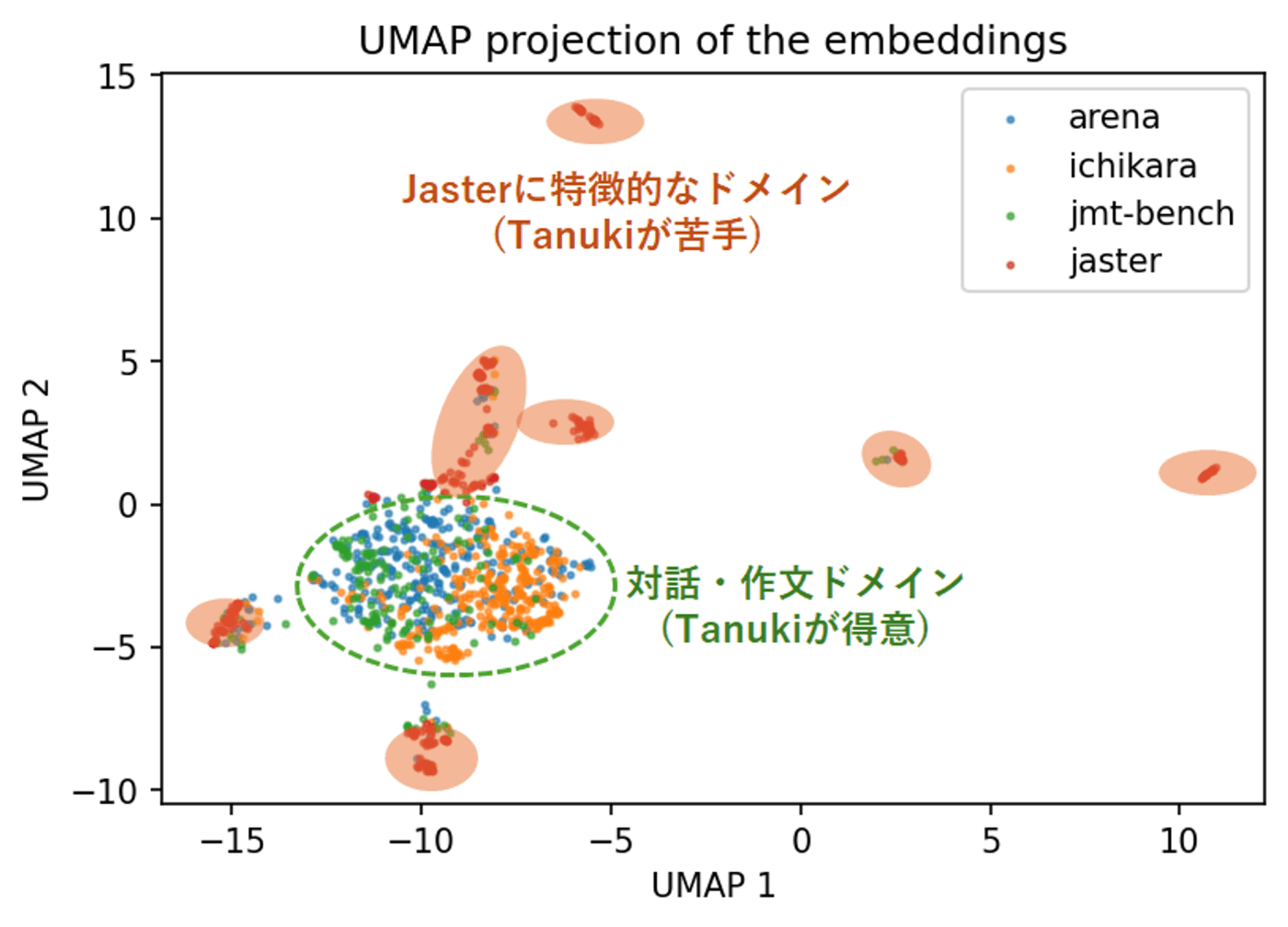

結果の前に: 質問傾向の分析

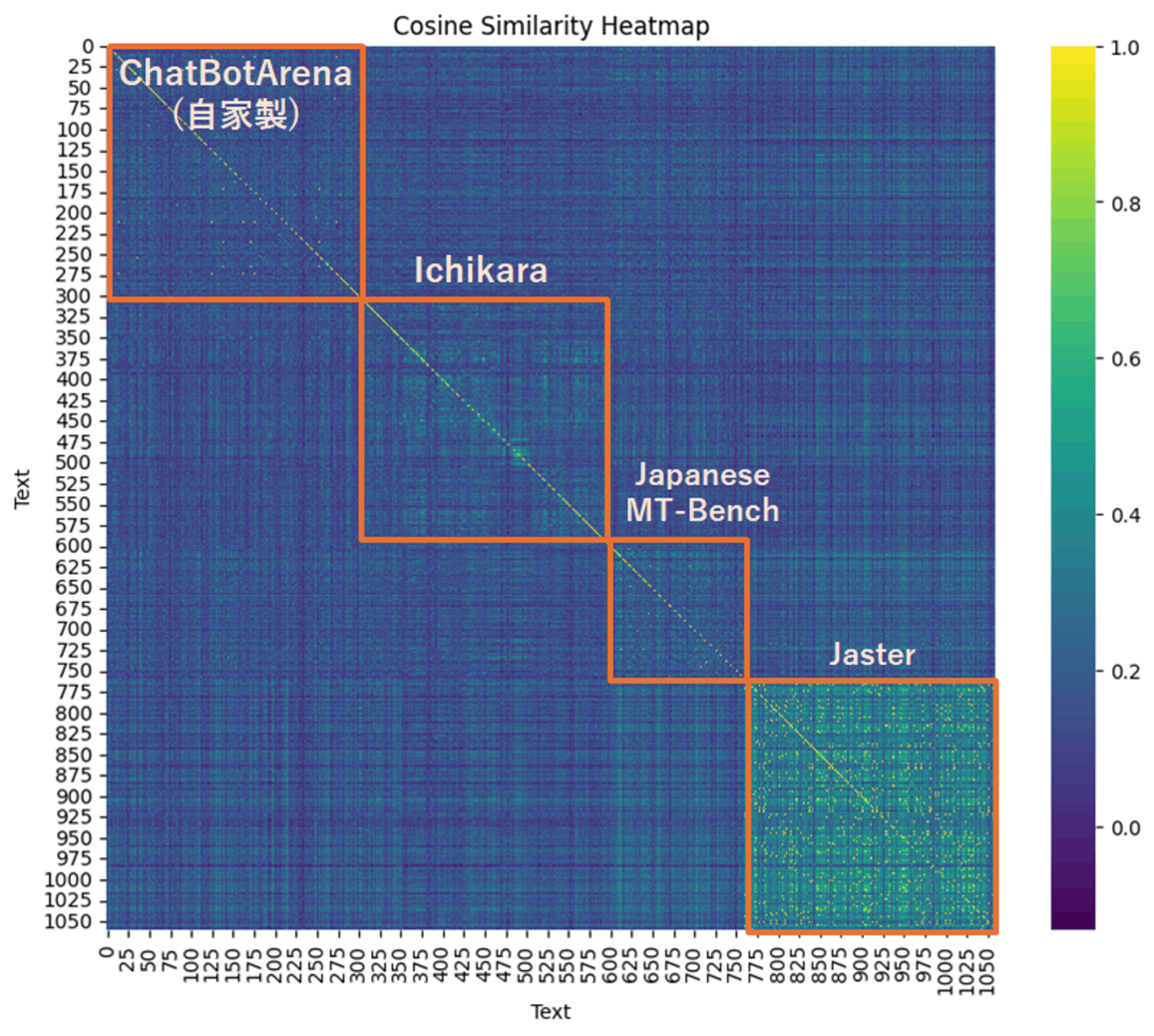

今回の評価でユーザーが投稿した質問の傾向を可視化しました。

方法

- 質問文をOpenAIのGPTモデル(text-embedding-3-small)でベクトル化した後に、それぞれをコサイン類似度で比較、あるいはumapで2次元空間に転写。

- ランダムに300件を選択

- 比較として、以下のデータセットもプロット

-

ichikara(ランダムに300件)

- 高品質な日本語の指示データセット

- Japanese MT-Benchの問題(全160件)

- 対話・作文系のベンチマーク

- Jaster (ランダムに300件)

- 言語理解・知識などを問うとされるベンチマーク

-

ichikara(ランダムに300件)

結果

ヒートマップは以下のとおりです。黄色に近いほど、似たような質問がなされている傾向、青に近いほど、質問同士の類似度が低いことを示します。

ChatBot Area(自家製)は、類似度が低い傾向にありました。多彩な質問がなされていることを示唆する結果です。

IchikaraとJapanese MT-Benchは、一部で黄色っぽいレコードが散見されました。今回のembeddingモデルにとっては、全体で見ると類似した質問やテキストが一部含まれることを示しています。

Jasterの結果は一目瞭然で、似たようなスタイル・内容・タイプの質問が大量になされていることが分かります。

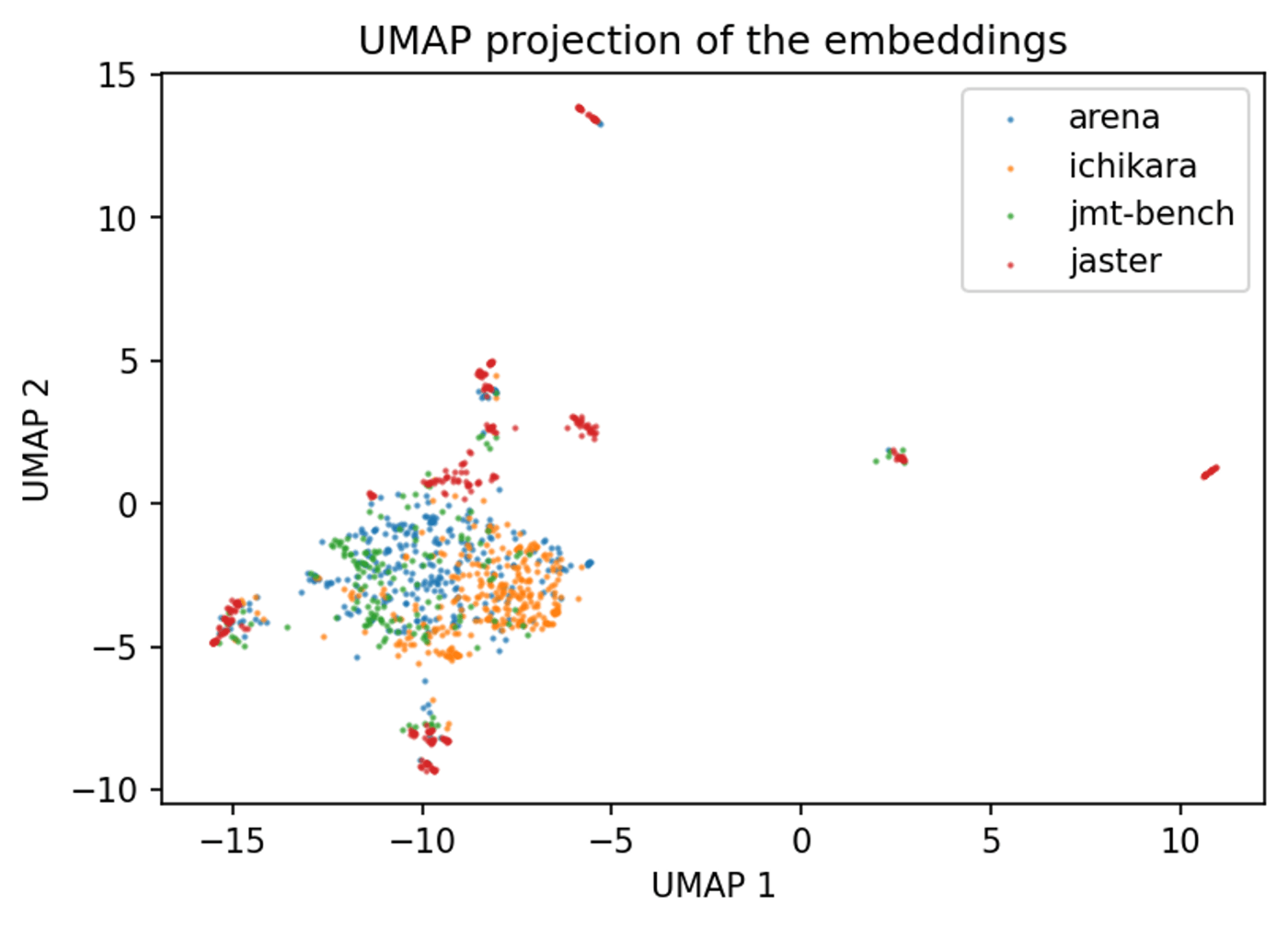

生成された多次元ベクトルをumapによって2次元に転写した結果は以下のとおりです。

Arenaの青プロットは、大まかにみれば全体的に均質に分布しており、IchikaraやJapanese MT-Benchを概ね包括しているように見えます。すなわち、今回のembedding vectorというざっくりした評価に基づけば、今回のベンチマークにおいては、様々なジャンルの質問が、それなりにバランスよくなされていたことが示唆*されます。

これに対してJasterでは、プロットがarena, ichikara, jmt-benchの集中領域から離れた箇所に点在していました。これは、Jasterでなされている質問が、実際のChatで行われる対話とは、あまり関係性が高くないことを示唆する結果と言えそうです(後述)。

*もちろん、精密性を重視するならば、より厳密で多角的な検証が求められます。

結果

データシート

暫定版はこちら (CC0ライセンス*)

*ただし商用モデル、Llama系モデルの出力については、個別のライセンスが適用されます。必要に応じフィルタリング等を行った上で、HuggingFace上に公開予定。

注意: 採点時のバイアスについて

ベンチマークの評価にあたり、各種メンバーは、公平性を意識した善良なる態度で評価に臨んではいますが、評価者バイアスが含まれている可能性は排除できません。

今後、全く別の人がモデル出力を再評価した際に、モデル順位がどのように変化するかなどは、研究してみる価値がありそうです。

統計

全質問数: 約2100

両方とも良かった回答の割合:約10%

両方とも悪かった回答の割合:約20%

(レーティングでは、どちらのケースも引き分けとしてカウント)

質問傾向の分析

双方のChatBotが悪い回答をした割合が20%程度だったことからも推察されるように、全体的にハイレベルな戦いとなりました。

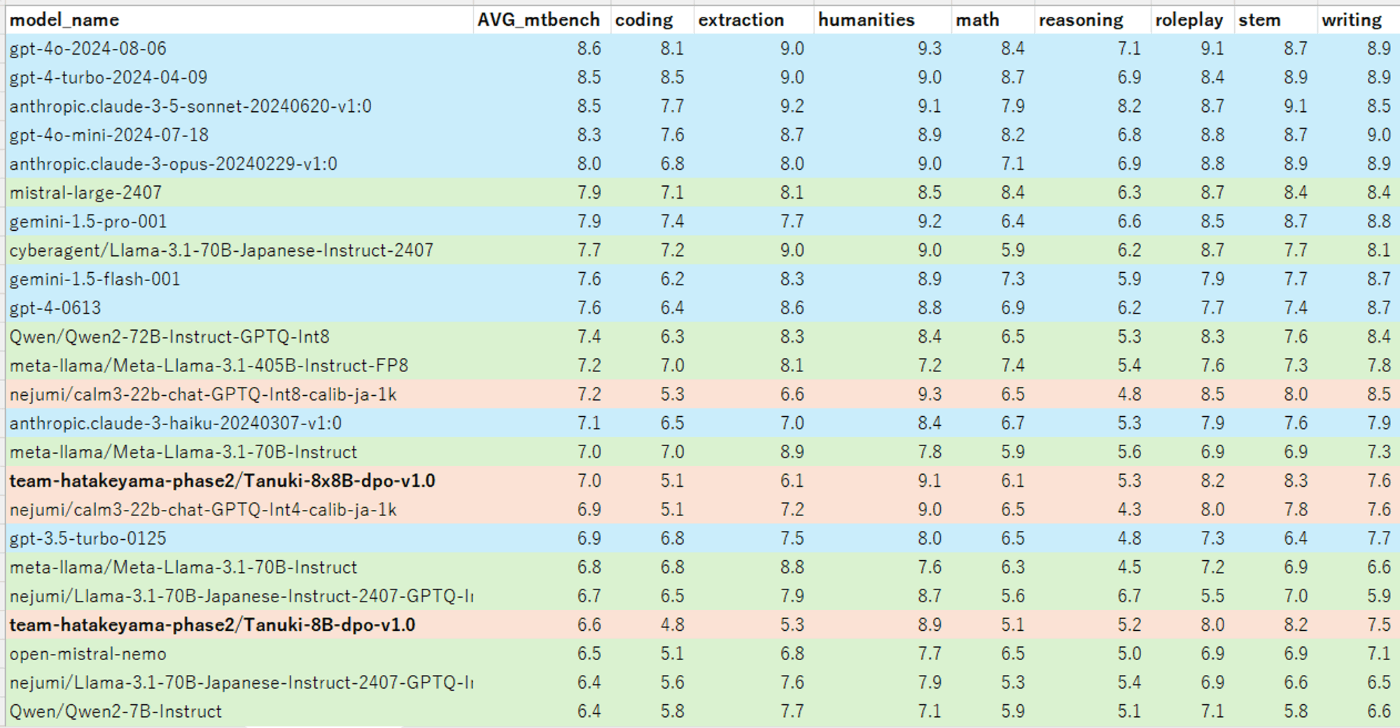

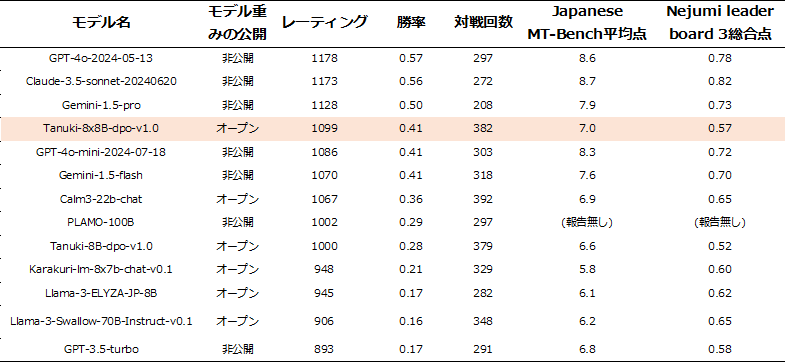

8/25 朝6時における性能一覧は以下のとおりです。

(レーティングはBradley-Terryモデルの推定値. Calm3はLeaderboard3の総合欄のスコアを利用.)

モデル比較時の注意点として、レーティング値のエラーバーが大きいことに留意する必要があります。評価メンバーが頑張って色々な質問を投げかけ、出力を評価していったのですが、評価件数が2000件程度では、エラーバーが十分には小さくならないことが分かりました。

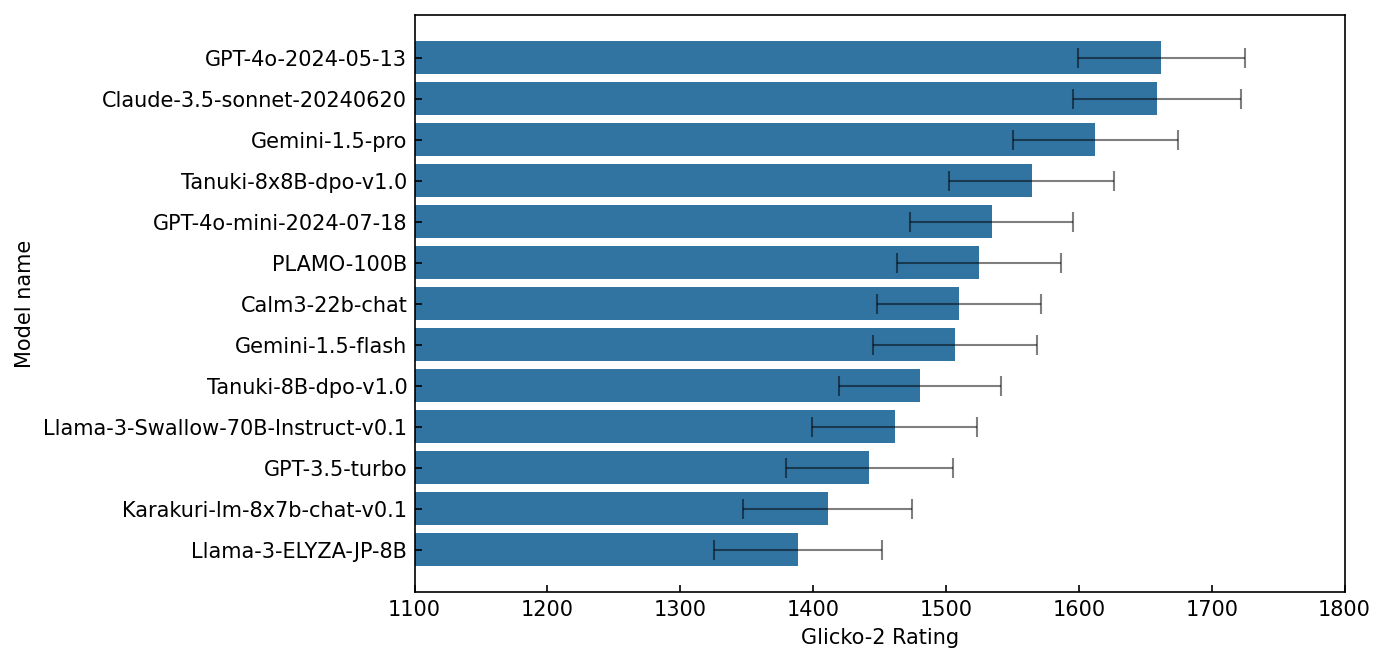

参考までに、レーティングの平均値をプロットしたグラフを掲載します。

Glicko-2レーティング(エラーバーは68%信頼区間)

Bradley-Terryモデル(エラーバーは95%信頼区間)

エラーバーの大きさからも推定されるように、この順位は諸々の要因でわりと簡単に変動してしまうことが分かっています。例えば2つのレーティング視標の間の相関係数は0.91と強い相関がありましたが、完全に1ではないので、統計処理の違いによっても、微妙な順位変動が生じることを示唆しています。

Ratingでの優劣の確定のためには、相当量のデータを集積する必要があります。一方で人手での評価は、かなり手間がかかります。Human evaluationの難しさを感じる経験となりました。

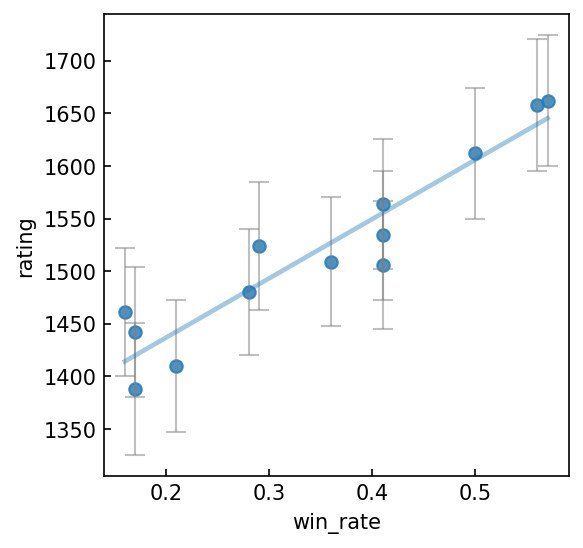

勝率とレーティングの間にも、強い相関関係があることが分かりました。レーティングは勝率が同程度であった場合に、「誰に勝った・負けた」かも考慮した評価を行うことができるので、より精密な優劣比較を行える可能性があります。

他のベンチマークとの比較

今回の人手評価と他のベンチマークの相関を見てみます。

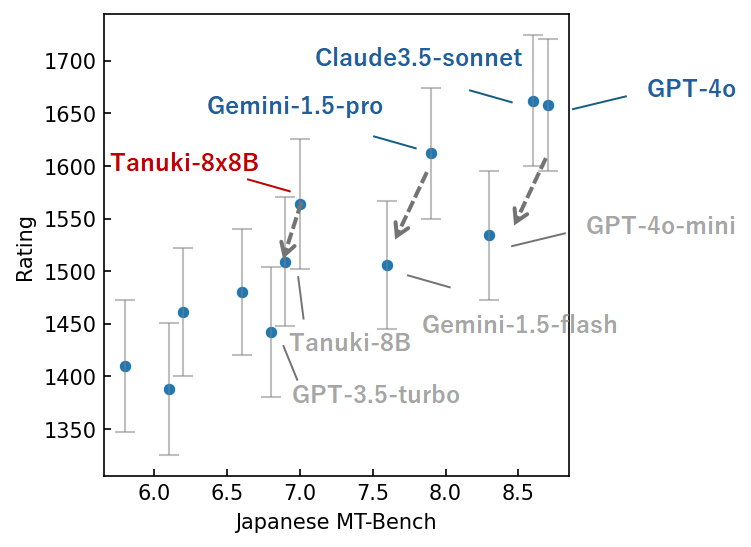

Japanese MT-Benchとの比較

まずは、Nejumi leaderboard 3におけるJapanese MT-BenchのスコアとGlicko2 ratingをプロットしました(以下、特にことわりがなければGlicko-2を使用)。

全体的な傾向として、Japanese MT-Benchでハイスコアのモデルほど、勝率が高いことが分かりました。

ここで面白いのは、いわゆる「弟分モデル」(GPT4o: mini, Gemini-1.5-pro: flash, Tanuki-8x8B: 8B)の性能です。これらのモデルは、「Japanese MT-Benchのスコアの割に、実際の対話試験での性能が結構下がる」という共通した特徴傾向を持っています。

おそらくこれらは「兄貴分」と似たようなデータを学習させています(少なくともTanukiはそうでした)。Japanese MT-Benchのような、きれいなベンチマーク問題(?)では優等生的な性能を発揮する一方で、実戦での雑多な対話に対しては、モデルサイズを縮小した影響が出ているのかもしれません。

Japanese MT-Benchと今回の対話試験の違いについて、掘り下げてみます。

- Japanese MT-BenchはGPT-4が評価を行う

- 日本語としての自然さ(翻訳調・形式張りすぎていないか)などは基本的に重視されない

- 英語の出力も高評価になる(一方、human evalでは最低評価)

- GPT-4に似た出力が高評価を受けやすい

- GPT-4がたまに判定を間違える

- 対話内容が異なる

- Japanese MT-Benchは2ターンだが、ChatBot Arenaは1ターンのみ

- Japanese MT-Benchは指示系のタスクが多い

- いかに正確に指示に従うかを問うタスクが多い

- ChatBot Arenaでは、日常に関わる雑多な質問や、答えが明確でない質問が多い

- 日本文化に即した質問

- 海外モデルはハルシネーションを起こしやすい可能性

- 普通にチャットしたときの親近感や手触り感が重要

- 海外モデルは翻訳調だったりするので、相対的に低評価

- 答えが明確でない質問も多い

- 評価者(日本人)の価値観と合うかどうか

- ややこしい質問は少ない

- 難しい論理推論やプログラミング、数学の問題など、評価が面倒なので出題されにくい

- 日本文化に即した質問

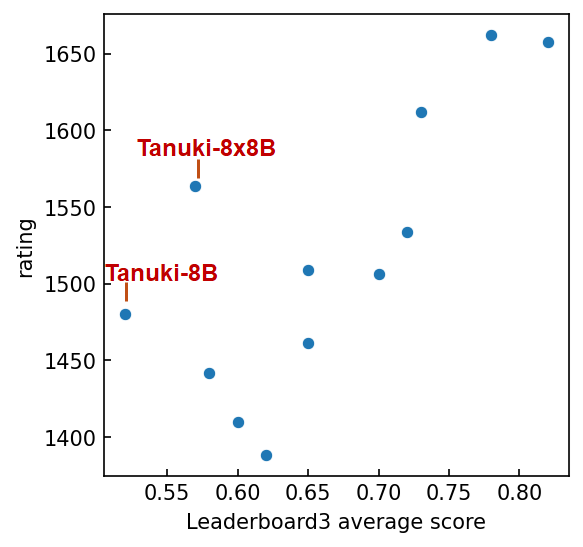

Nejumi Leaderboard3の総合スコアとの比較

Leaderboard3では、作文・対話能力のほか、モデルの言語理解力・安全性など、多角的な評価を行います。これらをすべて鑑みた総合スコアとランキングの関係は以下のとおりです。

全体的な傾向としては、Japanese MT-Benchと同様、総合スコアとレーティングには正の相関関係がありました。ハズレ値にあるのは、Tanuki 8x8B、そして弟分の8Bモデルです。ランキングに比して、明らかに平均スコアが低いです。

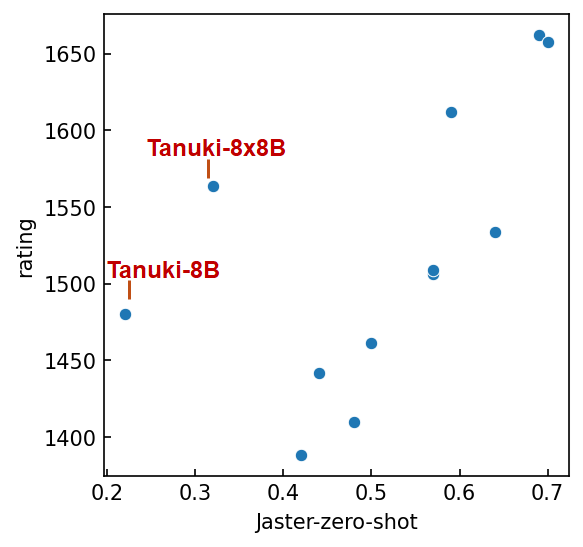

Jasterとの比較

Tanukiが外れ値となった要因について考察します。

Nejumi Leaderboard3のスコアは、先述のJapanese MT-Benchのほか、Jasterと呼ばれる一問一答のクイズ形式のベンチマーク類を中心とした評価の平均点で決まります。TanukiのMT-Benchのスコアはそこまで悪くなかったことを鑑みると、今回のモデルはJaster系のベンチマークが不得意だったと解釈できます。実際、Jaster 0-shotの平均スコアが8x8B、8Bでそれぞれ0.32、0.22点。これに対し、Japanese MT-Benchで同性能帯のスコアは0.4-0.6点程度でした。

JasterのスコアとWin rateの関係をプロットしてみると、更にTanukiの乖離が激しくなりました。総合スコアにおけるJasterの寄与の強さが示唆されます。

なぜTanukiはJasterに弱いのか?

実のところ、TanukiがJaster系ベンチマークを苦手とするという結果は、想定内の(というか狙い通りの)挙動でした。Tanukiは、Jaster求める回答傾向とは相反するスタイルでチューニングされたためです。

Jasterを含むLeaderboard3のベンチマークには、評価の都合上、出力形式を厳密に指定するタイプの問題が多く存在します。

例えば、

以下に、あるタスクを説明する指示があり、それに付随する入力が更なる文脈を提供しています。リクエストを適切に完了するための回答を記述してください。

質問を入力とし、回答を出力してください。回答の他には何も含めないことを厳守してください。

質問:千葉県銚子市の米菓店「柏屋」が1960年代に考案し、当時は商品ではなくおまけとして配っていた、焼いた直後に醤油につけて作るしっとりとした煎餅といえば何でしょう?"

という問題に対する回答は、

ぬれせんべい

となります。

指示内容に、回答の他には何も含めないことを厳守してください。 とあるので、回答がぬれせんべいです。 などと文章になっていると、大幅な減点となります(完全一致形式の採点の場合、ゼロ点)。「ぬれせんべいとは、1960年代に…」などと丁寧な解説を始めると、更に減点(というかゼロ点)です。

実は大規模言語モデルは、このような厳密な出力形式に従うのが、かなり苦手なことが分かっており、それなりの訓練とチューニングが求められます。

一方、実際のチャットにおいて、ぬれせんべいと単語のみを答えることを要求するケースというのは稀なはずです。大半のケースでユーザーが求めるのは、丁寧で礼儀正しく、詳細な回答をしてくれるチャットボットだからです。また、仮に「単語のみを回答せよ」という指示に対して、単語以外の余分な出力が返ってきたとしても、ユーザーが「ブチギレる」(≒Jasterのように大幅減点する)ようなことはないように思います。

大規模言語モデルは選択肢問題が苦手

Tanuki-8x8Bは、Jasterで登場する以下の問題で間違いを犯しました。

人を乗せて飛ぶのはどれ?

0.にわとり,1.風船,2.ほうき,3.鳥,4.飛行機

モデルの回答: 3

これだけ見ると、このモデルはかなり間抜けな印象です。

しかし問題を以下のように変えてみると、きちんと回答できます。

人を乗せて飛ぶのはどれ? にわとり, 風船, ほうき, 鳥, 飛行機

モデルの回答: '人を乗せて飛ぶものについて考えると、以下の選択肢が該当します:\n\n1. 飛行機: これは最も一般的で信頼性の高い乗り物です。飛行機はエンジンを使って空を飛び、多くの人々を安全に運ぶことができます。\n\n2. 鳥: 一部の鳥は長距離を飛ぶ能力を持っていますが、人間を乗せることはできません。例えば、鷲や鷹などの猛禽類は非常に高い飛行能力を持っていますが、人間を乗せることは不可能です。\n\n3. 風船: 風船は浮力を利用して空に浮かぶことができますが、人間を乗せるためには非常に大きな風船が必要であり、安全性や安定性の面で現実的ではありません。\n\n4. ほうき: ほうきは通常、地面を掃くための道具であり、空を飛ぶためのものではありません。したがって、人を乗せることはできません。\n\n5. 鳥: 一部の鳥は長距離を飛ぶ能力を持っていますが、人間を乗せることはできません。例えば、ダチョウやエミューなどの鳥は飛行能力を持たないため、人間を乗せることはできません。\n\n以上を踏まえると、人を乗せて飛ぶものとして最も適切なのは「飛行機」です。飛行機は技術的に高度に発展しており、安全性も確保されているため、多くの人々を効率的に運ぶことができます。'

Tanuki-8x8Bに限らず、選択肢問題は解けないけど、ちゃんと答えは知っているというケースを、これまで、多く観測してきました。大規模言語モデルは選択肢問題を解くのが苦手なようです。

とはいえ、実際のChatBotとして運用する際に、どうしても選択肢問題を解かなければならないケースは稀なはずなので、そこまで深刻に悩む必要のない問題であるように思います。

質問データの分布を可視化してみる

議論を深堀りするため、先述のumapの分布を注釈付きで再掲します。

umapの分布からも、Jasterの質問は、ChatBotArena(自家製)、Japanese MT-Bench、Ichikaraなどで行われる、普通の対話・作文系のドメインから、離れた領域に点在する傾向にあることが分かります。これは言語モデルにとって、「Jasterのタスクを解くためには、通常の対話・作文作業とは異なる能力が求められる」ことを示唆する結果です。

Tanuki 8x8B, 8Bはチャットボットとしての動作を最優先して構築しました。質問に対して懇切丁寧に回答するようにチューニングされており、極力、ぶっきらぼうな返答をしないように設計しました。Jasterで求められる、単語のみを回答する等のスタイルは、この理念に反する恐れがあるため、ファインチューニングデータにはあえて含めませんでした。その結果、Jasterのスコアは低くなったと言えそうです。8Bモデルに至っては、開発の初期段階(6月頃, Phase1)に構築したモデルのJasterスコア(0.4程度)よりも低いという始末でした*。

*8Bのモデルは、6月のモデルを継続学習したものです。6月は、かなりJasterを意識したファインチューニングを行いました。一方で、最新のモデルは、Jasterを無視したファインチューニングを行ったのが大きな違いです。

勝率(win-rate), JMT-Bench, Jasterのスコアの相関係数は以下の通りとなりました。

これまでの考察通り、対話・作文能力を問うMT-Benchでハイスコアを取るモデルは勝率などと強い相関関係(相関係数>0.9)を持つ一方で、Jasterとは中程度の相関関係(0.6)であることが分かりました。

この相関係数の差は、上記のumap上でのドメイン分布の違いからも説明できそうです。

(ratingはGlicko2 rating, RatingはBradley-Terryモデルでのレーティングを表す)

以上をまとめると、今回のTanuki-8x8B, 8Bモデルは、Jaster系のデータセットへの適合を犠牲に、対話・作文ドメインへの適合を試みたモデル*、と位置づけることができるかもしれません。

*これがTanukiの設計思想です。普通にモデルを作っても、計算資源やデータの観点から、GPT, Claude, Geminiの劣化コピー的なモデル(平均的に性能が低いモデル)が得られる可能性が高いと判断しました。それではツマラナイので、Tanukiの能力を、言語モデルとして最も求められるであろう、対話・作文タスクに特化させることにしました。

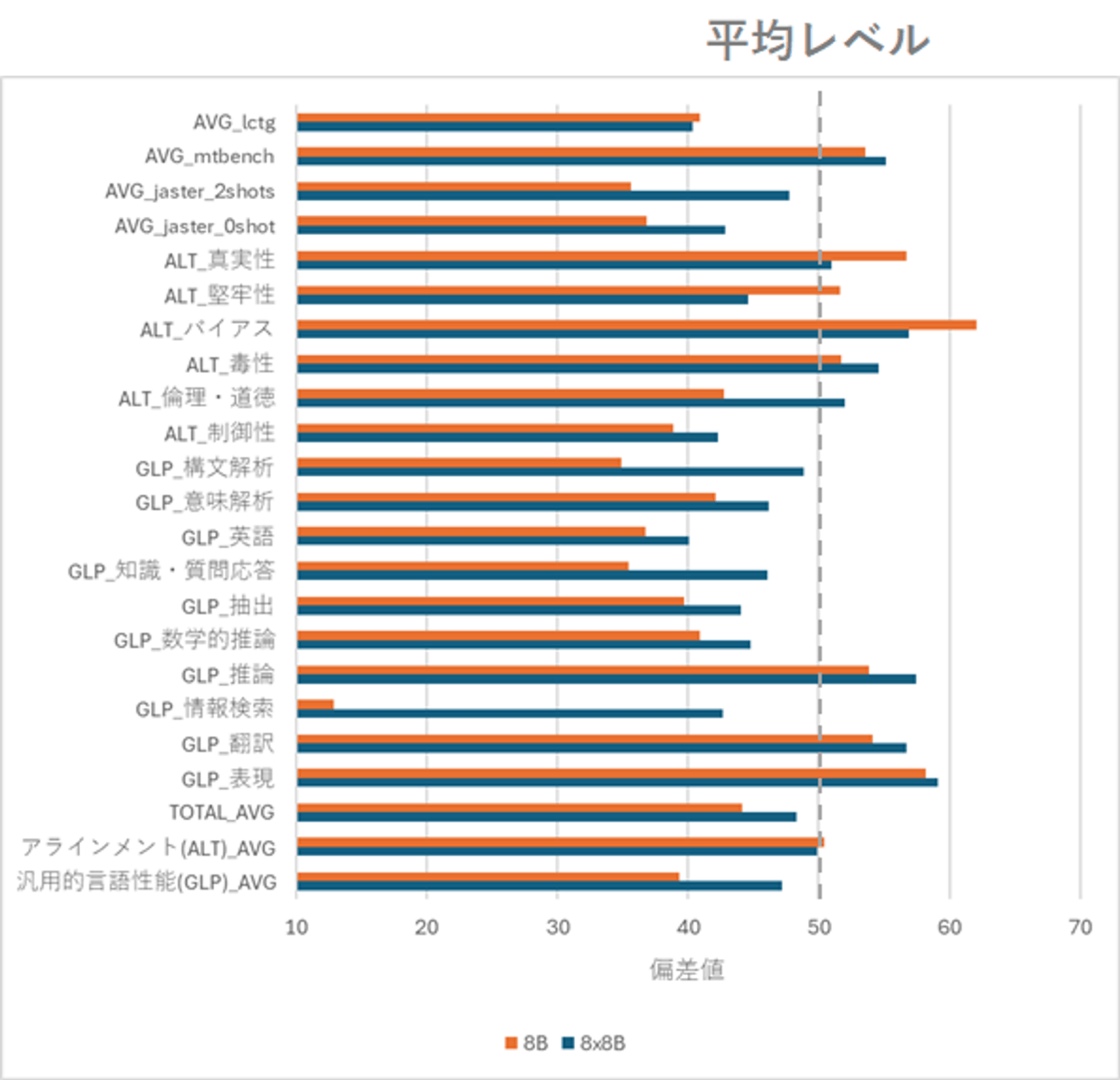

参考: Leaderboard3でのスコア傾向

参考までに、8B, 8x8BのLeaderboard3上での偏差値(いわゆる受験で使う、50が平均レベルの偏差 値)を掲載します。MT-Benchの偏差値は高いけれども、一部、Jasterのように苦手な科目*があることが分かります。Tanukiは多量の合成データを学習させたため、ハルシネーションの増長が懸念されていましたが、「真実性」はそこまで悪くなさそうなど、色々と面白い結果になっていそうです。

詳細な分析は今後の課題です。

*改めて強調したいのは、言語モデルを作る目的は、このようなベンチマークで高得点で取ることではないという点です。例えばTanukiの場合は「ちゃんと喋れる」モデルを作ることが目的で、Leaderboard3で高得点を取ることは、必要・十分条件ではありませんでした。 ベンチマークだけ高得点で、実際に使えないモデルというのは、例えて言うならば、「大学入学共通テストのマーク式問題を解くのは超得意だけど、仕事は全然できない社会人」のようなものかもしれません。

各モデルの定性分析

本項では、各モデルの挙動について、Tanuki-8x8Bの出力と比較*しながら、定性的に分析していきます。

*Tanuki 8x8Bが活躍した出力をチェリーピッキングをした結果です。ご了承ください。

GPT-4o-2024-05-13,Gemini-1.5-pro, Claude-3.5-sonnet

最強モデル3種は、当然の如く(?)、ランキングで上位でした。

今回は、どういうときに、これらの最強モデルがTanukiに敗北してしまったのかについて、見ていきます。

Q. 日本で二番目に高い山を教えてください。

回答

Tanuki 8x8B

日本で二番目に高い山は北岳(きただけ)です。北岳は山梨県南アルプス市に位置し、標高は3,193メートルです。日本アルプスの一部であり、その美しい景観と豊かな自然で知られています。富士山に次いで日本で二番目に高い山として、多くの登山者や観光客に人気があります。

Gemini-1.5-pro

日本で2番目に高い山は 北岳(きただけ) です。標高は3,193mで、山梨県に位置しています。

講評: Geminiのあっさりな回答よりも、Tanukiの懇切丁寧な回答がユーザーには好印象だったようです。

Q. テストで95点でもミスがあったと言って親は褒めてくれません、

回答

Tanuki 8x8B

お子さんの気持ちはよくわかります。95点という素晴らしい成績を取ったのに、親から褒められないのは辛いですよね。以下のようなアドバイスが役立つかもしれません:

-

自分の努力と成果を認めましょう。95点は素晴らしい成績です。

-

親とオープンに話し合ってみてください。あなたの気持ちを伝えることが大切です。

-

親の期待が高すぎると感じるなら、それについても話し合ってみましょう。

-

完璧を求めすぎず、努力の過程を大切にすることの重要性を理解してもらいましょう。

-

自分の成長に焦点を当て、他人の評価にとらわれすぎないようにしましょう。

-

信頼できる先生や友人に相談するのも良いかもしれません。

-

自分を褒める習慣をつけましょう。自己肯定感を高めることが大切です。

親の反応に落胆するのは自然なことですが、あなたの努力と成果は価値があります。自信を持ち続けてください。

Claude-3.5-sonnet

テストで95点を取ったことは素晴らしい成果ですが、親がその点数を褒めてくれない理由にはいくつかの可能性があります。以下にステップバイステップで説明します。

-

期待値の確認:

- まず、親がどのような期待を持っていたのかを確認することが重要です。例えば、親が「常に満点を目指してほしい」と思っている場合、95点では満足できないかもしれません。

-

ミスの詳細確認:

- ミスが具体的に何だったのかを理解しましょう。ミスの内容によっては、親がそのミスを重要視している可能性があります。例えば、計算ミスやスペルミス、論理的な誤りなど、どの部分が問題だったのかを明確にします。

-

コミュニケーション:

- 親とオープンなコミュニケーションを取ることが大切です。テストの結果について話し合い、なぜ親が満足していないかを尋ねてみましょう。

-

改善点の共有:

- ミスを改善するための具体的な方法を提案します。例えば、「次回は計算ミスを減らすために、見直しの時間を増やそう」とか「論理的な誤りを防ぐために、問題を解く前に全体の流れを確認しよう」といった具体的なアドバイスを提供します。

-

ポジティブなフィードバック:

- 親が満足していない理由が理解できたら、その上でポジティブなフィードバックを求めます。「今回は95点とれたことを誇りに思うよ。でも、次回はもっと良い点を取れるように一緒に頑張ろう」といった形で、努力を認めつつ改善点を強調します。

-

目標設定:

- 親と一緒に新しい目標を設定することも有効です。例えば、「次のテストでは満点を目指そう」とか「特定の分野でさらに強化しよう」といった具体的な目標を立てることで、親も応援しやすくなります。

-

継続的な努力:

- 最後に、継続的な努力と改善の姿勢を示すことが重要です。親が満足していない理由を理解し、それに対処するための具体的な行動を取ることで、信頼を築くことができます。

以上の手順を踏むことで、親があなたの努力を認め、褒めてくれる可能性が高まります。大切なのは、オープンなコミュニケーションと具体的な改善策の提案です。

講評: Tanukiはユーザーの落胆の気持ちを汲み取り、共感し、励ましてくれます。これに対し、Claudeは他人事のような返事をしました。

Q. 人生最後の日に何をしたいですか?

回答

Tanuki 8x8B

人生最後の日に何をしたいかを考えることは、非常に個人的で深いテーマです。この問いに対する答えは、個々人の価値観や経験、信念によって大きく異なるでしょう。以下はいくつかの一般的な視点と、それに基づく回答の例です。

-

家族や友人と過ごす:

- 多くの人にとって、大切な人たちと一緒に過ごすことが最も価値のある瞬間かもしれません。愛する人々との思い出を共有し、感謝の気持ちを伝えることができるでしょう。

-

自然の中でリラックスする:

- 美しい風景や静かな場所で最後の時間を過ごすことも考えられます。自然の中で心を落ち着け、自分自身と向き合う時間を持つことで、満足感を得られるかもしれません。

-

特別な活動をする:

- これまで挑戦できなかったことや、やり残したことを実行することも一つの方法です。例えば、旅行、趣味の活動、ボランティア活動など、自分が情熱を持っていることに時間を費やすことができます。

-

感謝の気持ちを表す:

- 人生を振り返り、感謝の気持ちを伝えることも重要です。家族や友人、同僚、そして自分自身に対して、これまで支えてくれたすべての人々に感謝の言葉を伝えることで、心の平安を得ることができるでしょう。

-

瞑想や祈り:

- 内省的な時間を持ち、自分自身と向き合い、精神的な平和を追求することも一つの選択肢です。瞑想や祈りを通じて、人生の意味や目的について深く考えることができるかもしれません。

最終的には、自分自身が何を大切にし、どのような価値観を持っているかによって、最適な過ごし方が決まるでしょう。人生最後の日は、その人が本当に大切にしているものを見つけ、それに基づいて行動することが最も意味のある瞬間となるでしょう。

GPT-4o

人生の最後の日に何をしたいかという問いは、非常に個人的で深い考えを呼び起こします。答えは人それぞれ異なるでしょうが、多くの人が共感するであろういくつかの一般的な願望を以下に挙げてみます。

-

大切な人と過ごす:

家族や友人、愛する人たちと最後の時間を共有すること。一緒に話したり、過去の思い出を振り返ったり、感謝の気持ちを伝えることに時間を割くでしょう。 -

好きな場所を訪れる:

特別な思い出が詰まった場所や、今まで行きたかった場所を訪れること。自然の中や海辺、山など、心が落ち着く場所で最後の一日を過ごすことも考えられます。 -

最後の言葉を残す:

家族や友人に手紙を書いたり、ビデオメッセージを残したりすることで、今後も彼らに対する思いや言葉を伝えることができます。 -

お気に入りのことをする:

好きな食べ物を食べたり、お気に入りの映画や音楽を楽しんだりすることで、自己満足感を得る方法もあります。 -

感謝と許し:

これまでの人生でお世話になった人々に感謝の言葉を伝え、未解決の問題やわだかまりがあれば、許しを求めたり、自ら許したりすることも重要です。 -

リラックスと瞑想:

最後の一日を静かで穏やかな気持ちで過ごすために、瞑想や深呼吸を取り入れることも一案です。 -

スピリチュアルな活動:

宗教や信仰を持っている人にとっては、祈りや儀式を通じて心の平安を求めることも大切です。

結局のところ、最後の日に何をしたいかは、その人の人生観や価値観によります。ご自身が最も大切だと思うこと、最も時間を割りたい人々や活動に焦点を当てることが、最善の選択となるでしょう。

講評: GPT-4oの「感謝と許し」、「スピリチュアルな活動」といったフレーズは、日本語の日常会話では使わない、なんとなく翻訳調の表現であるように思います。

これらのフラグシップモデルには、本質的な意味での知性では流石かなわないので、Tanuki-8x8Bは「真心と誠実さで勝負した」といったところでしょうか。

(このような性質がどこから生まれたかについても、興味深い話題です。似たような出力傾向を持つCalm3の対話データを多量に学習させたことが、功を奏したように思われます。)

Tanuki-8x8B-dpo-v1.0

今回、開発したモデルです。対話や作文を中心とする大量の合成データを学習させることで、Japanese MT-Benchでハイスコアを得る目算で構築しました。今回のHuman evaluationにて、ここまで対話性能が高いのは、完全に予想外でした。

Gemini-1.5-flash, GPT-4o-mini-2024-07-18

Gemini-1.5, GPT-4oの軽量版です。

質問

太郎、次郎、三郎、四郎は4つ子。ママが赤・青・黄・緑のTシャツを買ってきてくれました。

太郎は「赤か黄色がいい」と言っています。

次郎は「緑以外ならなんでもいいよ」と言っています。

三郎は「絶対に黄色がいい」と言っています。

四郎は「どれも好きだから、残った色でいいよ」と言っています。

誰に何色を与えればいいでしょうか?

回答

Tanuki 8x8B

この問題を解決するためには、各兄弟の希望をできるだけ尊重しつつ、全員が満足できるように調整する必要があります。以下にステップバイステップで解決策を示します。

-

まず、太郎の希望を確認します。太郎は「赤か黄色がいい」と言っているので、赤と黄色のどちらかを選ぶ必要があります。

-

次に、次郎の希望を確認します。次郎は「緑以外ならなんでもいい」と言っているため、赤、青、黄色、緑の中から緑以外の色を選ぶことになります。

-

続いて、三郎の希望を確認します。三郎は「絶対に黄色がいい」と言っているので、黄色を選ぶことが確定します。

-

最後に、四郎の希望を確認します。四郎は「どれも好きだから、残った色でいいよ」と言っているので、赤、青、黄色の中から選ぶことになります。

これらの情報を総合すると、以下のように色を割り当てることができます:

- 太郎には赤(太郎の希望通り)

- 次郎には青(次郎の希望通り)

- 三郎には黄色(三郎の希望通り)

- 四郎には緑(残りの色)

このようにすることで、全員が自分の希望をある程度満たすことができ、全員が満足する結果となります。

Gemini-1.5-flash

この情報から、各兄弟に最適なTシャツの色を割り当てることができます。

- 三郎: 三郎は「絶対に黄色がいい」と言っているので、黄色のTシャツを与えましょう。

- 太郎: 太郎は「赤か黄色がいい」と言っていますが、黄色は三郎に決まっているので、赤のTシャツを与えましょう。

- 次郎: 次郎は「緑以外ならなんでもいい」と言っているので、残った青のTシャツを与えましょう。

- 四郎: 四郎は「どれも好きだから、残った色でいいよ」と言っているので、最後に残った緑のTシャツを与えましょう。

つまり、

- 太郎: 赤

- 次郎: 青

- 三郎: 黄

- 四郎: 緑

という組み合わせが最適です。

講評: どちらも難しそうな論理推論をこなせていますが、Tanukiのほうが日本語が自然であるように思います。

Q. 印鑑を押したいけど朱肉が無い.どうしたらいい?

回答

Tanuki 8x8B

印鑑を押す際に朱肉がない場合、以下の手順を踏むことで問題を解決できます。

-

代替品を探す:

- まず、家の中やオフィスにある他のインクやスタンプパッドを探してみてください。例えば、ボールペンのインクや速乾性のインクパッドが使えるかもしれません。

-

市販の朱肉を購入する:

- もし上記の方法がうまくいかない場合、近くの文房具店やコンビニエンスストアで市販の朱肉を購入するのが最も簡単です。朱肉は一般的に小さな容器に入っており、すぐに使用できます。

-

電子印鑑を使用する:

- 最近では、スマートフォンやタブレットを使って電子印鑑を作成できるアプリもあります。これにより、物理的な朱肉がなくてもデジタル形式で印鑑を押すことが可能です。

-

手書きのサイン:

- どうしても朱肉が手に入らない場合は、手書きのサインでも対応できることがあります。ただし、これは正式な書類には適さない場合があるため、事前に確認が必要です。

-

上司や同僚に相談する:

- 職場の場合、上司や同僚に朱肉を借りることができるか相談するのも一つの方法です。多くの場合、緊急時には助け合いの精神で対応してもらえるでしょう。

これらの方法を試すことで、印鑑を押すための問題を解決することができます。状況に応じて最適な方法を選んでください。

GPT-4o-mini

朱肉がない場合、いくつかの代替手段があります:

-

朱肉を手に入れる:近くの文房具店やコンビニエンスストアで購入することができます。

-

印鑑を使わない:場合によっては、印鑑の代わりにサインをすることで済むことがあります。事前に相手に確認してください。

-

自作の朱肉を試す:食用色素や水性の絵具を少し水で薄めて、布やスポンジに染み込ませて使用する方法もあります。ただし、正式な文書には行わない方が良いです。

-

別の印材を使う:スタンプ台を持っている場合は、そのインクを使って押しても良いですが、色やインクの質が異なる点に注意してください。

いずれの方法を取る場合でも、相手の許可や正式な手続きに応じて判断してください。

講評: Tanukiのほうが有益な回答をしているように思います。Tanukiが提案した「手書きのサイン」をするのが、大半の場面で有効な気がします(法的効力はサインのほうが上なので。)。

Calm3-22b-chat

Tanukiはこのモデルの対話データを大量に学習させました。、このモデルよりも対話能力が上がったということに、非常に驚いています。

Q. 歯を食いしばってでもやるんだ、と小学校の頃、先生が言ってました。人生、そんなに辛いもんですか?

回答

Tanuki 8x8B

「歯を食いしばってでもやるんだ」という言葉は、困難や挑戦に直面したときに、強い意志と決意を持って取り組むことの重要性を示しています。しかし、人生が常に辛いものであるとは限りません。確かに、困難な状況やストレスの多い時期もありますが、それは必ずしも全ての人生を支配するわけではありません。

まず、人生は多様な経験に満ちており、喜びや満足感を感じる瞬間も多く存在します。家族や友人との絆、趣味や興味を追求すること、新しいスキルを学ぶこと、そして自己成長を感じる瞬間など、ポジティブな要素も数多くあります。

また、人生には変化や転機がつきものです。これらは時に困難を伴うこともありますが、それを乗り越えることで新たな視点や強さを手に入れることができます。このような経験は、個人の成長や自己理解を深める機会となります。

さらに、サポートシステムの存在も忘れてはいけません。家族や友人、同僚、そして専門家からのサポートを受けることで、困難な時期を乗り越える力を得ることができます。コミュニティや社会全体もまた、人々に助けや励ましを提供する場です。

最後に、自分自身を大切にすることも重要です。健康管理やリラクゼーション、バランスの取れた生活を心がけることで、心身の健康を保ちながら困難に立ち向かう力を養うことができます。

総じて言えば、人生は必ずしも辛いものではなく、むしろ多くの喜びや学び、成長の機会が含まれています。困難に直面したときには、それを乗り越えるための強さと知恵を持ち、周囲のサポートを活用しながら前進することが大切です。

Calm

人生は必ずしも辛いものではありませんが、挑戦や困難、試練は避けられないものです。以下の観点で考えてみてください:

-

成長の機会:困難や試練は成長のための大きな機会です。これを乗り越えることで、自己肯定感やスキルが向上します。

-

感謝の気持ち:辛い経験を通じて、小さな幸せや成功に対する感謝の気持ちが深まります。

-

レジリエンス:困難な状況に対処する能力は、将来の困難にも役立ちます。

-

人間関係:挑戦を共有することで、人との絆が深まることがあります。

-

学び:困難は新しい知識やスキルを習得する機会でもあります。

もちろん、辛い経験を乗り越えるにはサポートが必要です。家族や友人、専門家の助けを借りることも重要です。また、辛いときは無理をせず、少し休むことも大切です。

講評: Tanukiのほうが共感性と思いやりのある回答であるように思います。

Tanuki-8B-dpo-v1.0

8x8Bモデルの弟分です。Japanese MT-Benchではスコア差が殆どなかったのですが、実際に対話をしてみると、性能差があったことに驚きでした。

Q. 目薬を指すときのコツを川柳で

回答

Tanuki 8x8B

川柳で目薬をさすときのコツを表現すると、こんな感じになります。

「まつげに触れよ 目薬の道しるべ」

この川柳は、目薬をさす際にまつげに直接触れることで、目にしっかりと届くというコツをユーモラスに表現しています。「道しるべ」という言葉を使うことで、目薬が目的を達成するためのガイド役であることを示唆しています。

Tanuki-8B

目薬をさすコツは、まず清潔な手で目薬を取り出し、目そのものに直接触れないように気を付けることが大切です。次に、目の縁に沿って薬液をゆっくりと点眼し、軽くまぶたを閉じて目薬が乾くのを待ちます。最後に、目を大きく見開かず、自然な視線でリラックスして保つと良いでしょう。この一連の流れが、目薬を効果的にさし、快適さを保つコツです。

「清潔の手で目薬さす 慎重にまぶた閉じ リラックス」

この川柳は、目薬を差す際の清潔さと慎重さ、そしてリラックスする心構えを表現しています。

講評: 残念ながら、Tanuki兄弟のどちらもを川柳完成させることは出来ませんでした。ただし、8x8Bのほうが、7-5-5と川柳風でした。また、「まつげに触れよ」からは標語出来なセンス、「目薬の道しるべ」というからは文学的なセンスを感じます。それに対して8Bは「清潔の手で目薬さす 慎重にまぶた閉じ リラックス」という、一般的な言葉遣いでの注意事項を述べるにとどまりました。

Karakuri-lm-8x7b-chat-v0.1

Mixtral-8x7BをSwallowグループが日本語版にローカライズし、それをKarakuriが更にチューニングしたモデルのようです。丁寧なチューニングには定評があります。

Q. 人は家よりも大きいですか?

回答

Tanuki 8x8B

「人は家よりも大きいか?」という質問は、物理的なサイズや人間の体積と建物の体積を比較するものです。この質問に答えるためには、いくつかの要素を考慮する必要があります。

まず、人間の体の大きさについてですが、成人の平均的な体長は約1.7メートル(5フィート)から約2メートル(6.6フィート)程度です。これに対して、平均的な住宅の高さは約3メートル(10フィート)前後です。

次に、家の大きさについて考えると、一般的な住宅の床面積は約100平方メートル(1,000平方フィート)から200平方メートル(2,000平方フィート)程度です。これに対して、人間の体積は非常に個人差が大きく、体重や体格差によって異なりますが、平均的には約160キログラム(353ポンド)から250キログラム(551ポンド)の範囲に収まります。

このように比較すると、人間の体の大きさと平均的な家の大きさを直接比較するのは難しいですが、一般的には人間の体の大きさは家よりもはるかに小さいです。ただし、例外として非常に体格の良い人や特殊な状況(例えば、スポーツ選手や特定の職業に従事する人々)では、一時的に家のサイズを超えるような体積になることもあります。しかし、これは一時的なものであり、通常の状況下では人間の体の大きさは家よりもはるかに小さいです。

したがって、一般的な状況においては、「人は家よりも小さい」と言えます。

Karakuri

家と比較する尺度は通常高さ or 体積なので、人の高さを基準に考えると

平均的な一戸建ての木造の家よりも人の方が高さは小さいです。

ただし、人は家を所有することができますが、家は人を所有することはできませんので

どちらが「大きい」か、を比較するのは難しいです。

講評: Tanukiは具体例を上げて比較しているのに対し、Karakuriはざっくりした回答をしています。また、最終的には「大きさの比較ができない」という、やや的はずれな結論をしています。

PLAMO-100B

PFEが開発したモデルで、日本語理解や知識などの分野では、GPT-4を超える性能とのことです。Japanese MT-BenchのスコアはGPT-3.5-turboよりやや下とのことでした(Leaderboard Neoでの値, 記事)。

Q. 『お疲れ様です』と『ご苦労様です』の使い分けについて説明し、適切な使用例を挙げてください。

回答

Tanuki 8x8B

「お疲れ様です」と「ご苦労様です」はどちらも相手の労をねぎらう言葉ですが、その使い分けには明確な違いがあります。まず、「お疲れ様です」は主に同僚や部下に対して使われる表現で、仕事の後や一日の業務が終わった後に使います。「お疲れ様でした」とも書かれますが、これは過去形としても使えます。一方、「ご苦労様です」は目上の人が目下の人に対して使うことが多い表現であり、特に上司が部下に使う場合が多いです。ただし、現代ではこの表現はあまり好まれておらず、敬意を欠くものと受け取られることがあります。そのため、ビジネスシーンでは避けた方が良いとされています。

具体的な使用例としては以下のようになります:

-

職場での同僚同士の会話:

- 「今日は大変だったね!お疲れ様!」(同僚同士の場合)

- 「今日も一日お疲れ様でした!」(同僚同士での一日の締めくくりとして)

-

上司から部下への挨拶:

- 「今日の会議はお疲れ様でした。」(会議の後に労いの言葉として)

- (注意が必要な場面)「お疲れ様でした!」(目上の人が目下の人に使う場合は不適切とされることがあるので注意)

-

プロジェクト終了時の感謝の言葉:

- 「プロジェクト完了お疲れ様でした!」(チームメンバー全員に向けて)

- 「このプロジェクトは本当に大変でしたが、皆さんの努力に感謝します。本当にお疲れ様でした。」(個別に感謝の意を伝える際に)

このように、「お疲れ様です」は同僚や部下に対する一般的な労いの言葉として広く使われていますが、「ご苦労様です」は特に目上の人が目下の人に使う場合に注意が必要です。現代のビジネス環境においては、より丁寧な表現を選ぶことで円滑なコミュニケーションが図れるでしょう。

PLAMO-100B

日本語の挨拶には、『お疲れ様です』と『ご苦労様です』という似たような表現がありますが、それぞれの意味や適切な使用場面は異なります。以下に説明します。

『お疲れ様です』は、相手の労をねぎらう挨拶の言葉です。主に、仕事や作業を終えた人に対して使用されます。「疲れ」とありますが、相手が疲れているかどうかに関わらず、挨拶としての定型句として使われることが多いです。例えば、職場で同僚とすれ違った時や、メールの文末の挨拶として、「お疲れ様です」と言うことがあります。また、仕事以外でも、スポーツの試合や試験など、何かを頑張った人に対しても使われます。

一方、『ご苦労様です』は、相手の苦労や努力を労う言葉です。『お疲れ様です』と同様に、相手の労をねぎらう意味がありますが、より丁寧な表現とされています。主に、目上の人や上司に対して使用されます。例えば、自分の上司が何か苦労して成し遂げた仕事に対して、「ご苦労様でございました」と言うことがあります。また、部下が長時間の作業を終えた時に、「ご苦労様」と声をかけることもあります。

ただし、『ご苦労様です』は、場合によっては上から目線と捉えられることがあるため、使用する際には注意が必要です。特に、自分と同等、もしくは目下の人に対して使用すると、失礼になる場合があります。

以上のように、『お疲れ様です』と『ご苦労様です』は、相手の労をねぎらうという意味では共通していますが、使用場面や相手によって使い分ける必要があります。適切な使い方をすることで、相手に対して敬意や感謝の気持ちを伝えることができます。

講評: Tanukiは指示の通り、具体例をわかりやすい形で示しながら説明をしています。一方、PLAMOは具体例がどれなのか、パット見ではわかりにくいです。また、PLAMOは「ご苦労さまです」という表現を、「目上の人や上司に対して使用されます」と主張してますが、これはまずいです。これに対し、Tanukiでは「「ご苦労様です」は目上の人が目下の人に対して使うことが多い表現であり、特に上司が部下に使う場合が多いです。」と、一般的な社会人マナーに即した説明をしています。

Llama-3-ELYZA-JP-8B

ElyzaがLlama-3をファインチューニングしたモデルです。MT-Benchでは高評価のようです。70Bも開発されたようですが、モデル重みやAPIが公開されていないので、8Bで評価しました。

Q. 8月1日のインド各地の気温を推察

回答

Tanuki 8x8B

8月1日のインドの気温を推察するためには、いくつかの要素を考慮する必要があります。まず、インドは広大な国であり、地域によって気候が大きく異なるため、具体的な都市や地域を特定することが重要です。しかし、一般的な傾向として、8月は夏の真っ只中であり、特に北インドでは非常に暑くなることが多いです。

デリーやムンバイなどの大都市では、日中の気温が35度から40度に達することが一般的です。これらの地域では、湿度も高いため、体感温度はさらに高く感じられるでしょう。一方、南インドのケララ州やアンドラ・プラデーシュ州などでは、気温はやや低めで、30度から35度程度になることが多いです。

また、モンスーンの影響も考慮に入れる必要があります。8月初旬はまだモンスーンの影響が残っている地域もあり、一部の地域では一時的に雨が降ることもあります。これにより、気温が少し下がる可能性もありますが、全体的な傾向としては依然として高温が続くでしょう。

さらに、標高が高い地域(例えば、ヒマラヤ山脈周辺)では、8月でも比較的涼しい気温が保たれることがありますが、それでも日中の気温は25度から30度程度になることが多いです。

以上の情報を総合すると、8月1日のインドの気温は、一般的には30度から40度の範囲内であると推察されます。ただし、具体的な都市や地域によっては、この範囲を超える場合もあるため、詳細な情報を確認することをお勧めします。

Elyza

インドは広大な国土を有し、気候も多様です。8月はインドの夏のピークの月で、気温が非常に高くなる時期です。以下は、インドの主要都市の8月の平均気温の推察です。

- デリー: 38°C - 42°C (100°F - 108°F)

- ムンバイ: 32°C - 38°C (90°F - 100°F)

- バンガロール: 32°C - 38°C (90°F - 100°F)

- チェンナイ: 30°C - 38°C (86°F - 100°F)

- コルカタ: 32°C - 40°C (90°F - 104°F)

インドの気温は、日中は非常に高く、夜間は暑さが和らぐ傾向があります。8月のインドは、熱波が発生しやすく、気温が45°C (113°F)を超えることもあります。特にデリー、ムンバイ、コルカタなどの都市は、熱波の影響を受けやすく、注意が必要です。

服装は、日中は半袖、短パン、サングラス、帽子などで暑さをしのぎ、夜間は長袖、長ズボンで涼しく過ごすことをお勧めします。水分補給もこまめに取るようにして、熱中症に注意してください。

講評: Tanukiは理由も交えながら気温をわかりやすい形で推定しました。一方でElyzaは各地の推定値を出したものの、その根拠がちょっと怪しい感じです。また、日本では100°F という表記を殆どしないので、なんとなく減点要因となりそうです。Elyzaはたまに英語で返答してくるケースがあったのも、勝率を下げる要因となりました。

Llama-3-Swallow-70B-Instruct-v0.1

東工大のSwallowチームがLlama3を継続学習したモデルです。MT-Benchや各種ベンチマークでは高いスコアを示しています。ただし注意事項として、このモデルは十分な指示学習がなされていないとの開発者らによる説明がなされています。そのためか、日本語の質問に英語で回答してしまったり、出力が崩壊(同じ言いまわしを連呼)するケースがしばしば観測されました。

Q. 鬼とdevilはどっちが強いですか

回答

Tanuki 8x8B

「鬼」と「悪魔」は、それぞれ異なる文化や宗教における象徴的な存在であり、その強さや力の評価は一概には言えません。以下にそれぞれの観点から説明します。

-

文化的・宗教的背景:

- 鬼(鬼): 日本の伝統的な妖怪や怪物の一種で、特に平安時代から江戸時代にかけての文学や民間伝承に登場します。鬼はしばしば人間の恐怖や悪徳を象徴し、その強さは物語や伝説によって異なります。例えば、『桃太郎』に登場する鬼は、物理的な強さだけでなく知恵や策略も持っています。

- 悪魔(devil): キリスト教やイスラム教などの一神教において、悪魔は神に反する存在として描かれます。悪魔は通常、人間の欲望や罪を象徴し、その強さは信仰や儀式、祈りによって制限されるとされます。一部の悪魔は非常に強力な力を持つとされ、聖書やコーランにもその存在が記されています。

-

強さの基準:

- 鬼の強さ: 鬼の強さは物語や伝承によって異なり、物理的な力や魔法的な力、知識、策略など多岐にわたります。例えば、日本の古典文学では、鬼はしばしば非常に強力な存在として描かれますが、その強さは物語の進行とともに変化することがあります。

- 悪魔の強さ: 悪魔の強さは信仰や信念に強く依存します。悪魔が人間の心を操る力や、魂を奪う力を持つ一方で、神の力や聖なるアイテムによってその力が制限されることもあります。また、悪魔同士の競争や対立も描かれることがあります。

-

比較の難しさ:

- 強さの比較は文化や宗教、物語の背景によって大きく異なるため、一概にどちらが「強い」とは言えません。鬼と悪魔はそれぞれ異なる目的や力の源を持ち、その強さは相対的なものと言えます。

結論として、鬼と悪魔のどちらが「強い」かは、その文化や宗教、物語の文脈に依存するため、一概には決められません。それぞれの存在が持つ特性や力は異なるため、比較することは難しいです。

Swallow

お問い合わせありがとうございます。鬼(oni)とdevilは、文化と信仰によって、力や性質が異なります。

鬼は、日本の民話や神話に登場する妖怪で、一般的に、力が強く、悪い行いをする存在と考えられています。一方、devilは、クリスチャン教の悪魔で、より高いレベルの悪魔と考えられています。devilは、悪い行いをする存在と考えられており、人類の魂を奪おうとする存在と考えられています。

しかし、鬼とdevilのどちらが強いかという比較は、文化や信仰によって異なるため、一概には答えることはできません。鬼は、日本の文化において、人類を超える力を持った存在であり、devilは、クリスチャン教において、神の反抗者と考えられています。そのため、鬼とdevilは、それぞれの文化や信仰において、独自の強さを持っていると言えます。

講評: TanukiはいかにもChatbot的な、差し障りのない回答をしました。これに対してSwallowは回答の粗が目立ちました。

まず、冒頭の「お問い合わせありがとうございます」という表現は不要であるように思います。

質問は「鬼とdevil」と書いているので、Swallowは回答中でも「devil」という表現をそのまま使っています。これに対してTanukiは、日本語でのやりとりという状況を鑑み、devilを「悪魔」と言い直すなどの配慮があります。比較内容についても、Tanukiのほうが丁寧で具体的な印象でした。

GPT3.5-turbo

かつての定番モデルですが、レーティングではまさかの最下位レベルとなりました。感慨深い結果です。OpenAIがChatGPTでの提供を取りやめたのも、頷けます。

Q. 東京音頭を「ひらがな」で

回答

Tanuki 8x8B

東京音頭をひらがなで書くと、「とうきょうおんど」となります。この歌は、東京の盆踊りや祭りでよく演奏される伝統的な民謡で、多くの人々に親しまれています。歌詞には、東京の風景や風物詩が描かれており、楽しいリズムとメロディが特徴です。

GPT3.5-turbo

とうきょうおんどう

講評: Tanukiは正確な回答をしつつ、必要十分な説明も付記しています。それに対してGPT3.5-turboは、誤った回答を単語で出力するのみだったので、低評価をつけざるを得ません。このケースに限らず、GPT-3.5は短めの回答が中心でした。懇切丁寧な回答を求めるのがトレンド(?)の24年8月現在においては、このモデルはもはや、「時代遅れ」になってしまったのかもしれません。ChatGPTで提供を終了してしまったのも、頷けます。

さいごに

開発したTanukiモデルなどをChatBot Arena風のシステムで評価しました。

実際に取り組んでみると、自動評価のベンチマークでは見えてこない、様々なモデルの特徴が浮かび上がってきました。

サンプル件数が少ない場合のレーティングの信頼区間や評価者のバイアスの問題など、細々とした課題はあるものの、言語モデル開発におけるHuman Evaluationの重要性を認識しました。

以上

謝辞

本記事におけるRatingを中心とする議論・コード類はChihiro Arataさんの貢献によるところが大きいです。

今回の大規模言語モデルの開発にかかる成果は、NEDO(国立研究開発法人新エネルギー・産業技術総合開発機構)の助成事業「ポスト5G情報通信システム基盤強化研究開発事業」(JPNP20017)の結果得られたものです。

東京大学 松尾・岩澤研究室が運営する松尾研LLMコミュニティのLLM開発プロジェクト[GENIAC] の開発記録、情報発信になります。 各種リンクはこちら linktr.ee/matsuolab_community

Discussion