大規模言語モデルの性能の自動評価に関する問題点のメモ書き:Tanuki-8x8Bの事例から

Tanuki-8x8B:日本語大規模言語モデルの性能評価と分析

はじめに

2024年に開発されたTanuki-8x8Bは、日本語に特化した大規模言語モデル(LLM)です。このモデルは、対話能力や長文生成において優れた性能を示しました。具体的には、Japanese MT-Bench(日本語の対話・作文能力を測るベンチマーク)や対人タスクで高いスコアを記録しています。

2024年8月の関連記事では、ChatbotArena的なシステムを用いてTanuki-8x8Bを含む大規模言語モデルの日本語性能評価について詳しく解説しています。

しかし、Nejumi Leaderboard3という総合的な評価システムでは、予想外に低いスコアとなりました。この結果の背景には、MT-Bench以外の多くの評価タスク、特にJaster系のベンチマークが、Tanuki-8x8Bが重点を置いた対話・作文の能力とは異なる側面を測定している可能性があります。

本記事では、特にJCommonSenseQAという知識を問う選択式問題タスクに焦点を当て、Tanuki-8x8Bの性能をより深く分析します。

Nejumi Leaderboard3の結果

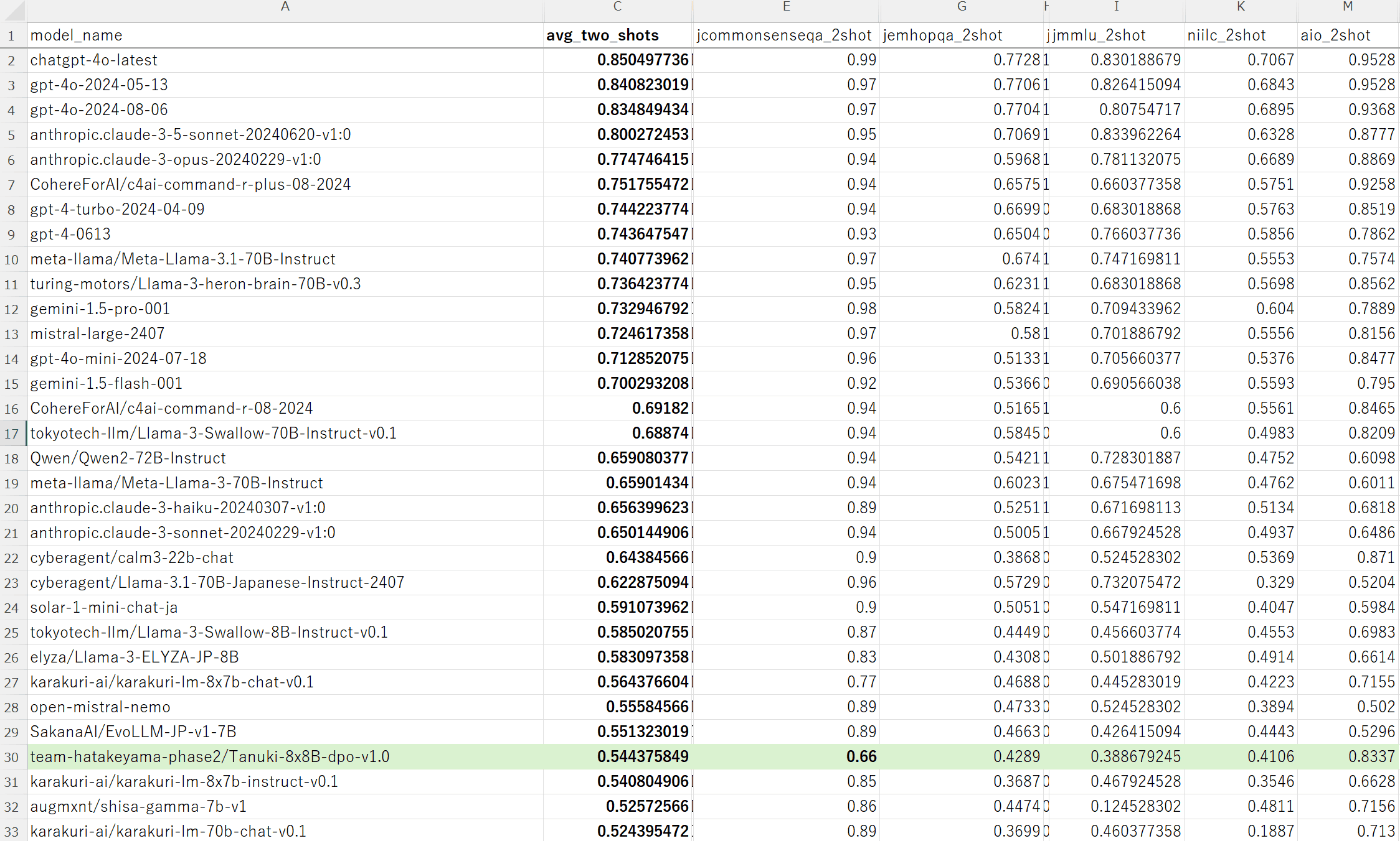

Nejumi Leaderboard3は、様々な種類のタスクを通じて言語モデルの総合的な性能を評価するシステムです。以下の図は、このリーダーボードにおける知識系ベンチマークの結果を示しています:

この図から、Tanuki-8x8BがJapanese MT-Benchでは他のローカルモデル(例:Llama-3-Swallow-70B-Instruct-v0.1)を上回る性能を示す一方で、JCommonSenseQAを含む知識系タスクでは予想外に低いスコアとなったことがわかります。

JCommonSenseQAのスコアが低い理由

JCommonSenseQAでのスコアが低かった理由として、主に以下の2点が考えられます:

-

ファインチューニングの特性: Tanuki-8x8Bのファインチューニング(モデルの調整)過程で、選択式問題を解くための特別な訓練が十分に行われていなかった可能性があります。

-

推論方法の違い: モデルが選択肢番号をそのまま答えるのではなく、Chain of Thought (CoT)と呼ばれる方法を用いて推論しながら答える訓練を受けていたため、それ以外の出力形式では十分な能力を発揮できなかった可能性があります。CoTは答えに至る過程を段階的に考える方法で、最近のOpenAIのモデル「o1」でもその有効性が報告されています。

ベンチマークの特性と評価方法

JCommonSenseQAやMMLU(多言語理解力テスト)などの多くのベンチマークは、基本的にCoTを含まない直接的な回答を求めています。特に、Jasterを含むLeaderboard3のベンチマークには、評価の都合上、出力形式を厳密に指定するタイプの問題が多く存在します。

例えば、JCommonSenseQAには、以下のような問題があります:

以下に、あるタスクを説明する指示があり、それに付随する入力が更なる文脈を提供しています。リクエストを適切に完了するための回答を記述してください。

質問と回答の選択肢を入力として受け取り、選択肢から回答を選択してください。なお、回答は選択肢の番号(例:0)でするものとします。 回答となる数値をint型で返し、他には何も含めないことを厳守してください。

質問:スキー場などにある、輸送機器の一つで、高所低所に張られたケーブルにアームが付き、そこにむき出しの椅子を据えたものをなんというか?

選択肢:0.北海道大学,1.ポプラ並木,2.ベンチ,3.パイプ椅子,4.リフト

この問題の正解は単に「4」です。指示には「回答の他には何も含めないことを厳守してください」とあるため、「答えは4です」のように、単語以外の情報があれば、減点(完全一致形式の採点の場合はゼロ点)となります。

問題の聞き方によって回答が変化する

Tanuki-8B, 8x8Bは、上記の問題に対して、Leaderboardのベンチマークプログラム上では、「3」と誤答する傾向があることがわかっています。

一方、期間限定で公開されている8Bモデルに、「回答の他には何も含めないことを厳守してください」といった制約はつけず、普通に質問をしてみると、正しい答えが返ってきます。

以下、質問の仕方によって、どのように回答が変化するかをベンチマーク問題全体で調査しました。

CoTを用いた推論の結果

本記事では、CoTを許容して推論させた際のJCommonSenseQAのスコアを簡単に評価しました。

推論方法

以下のようなプロンプト(指示)を用意し、モデルが自由形式で回答できるようにしました:

system="以下は、タスクを説明する指示です。要求を適切に満たす応答を書きなさい。次の選択肢問題について、選択肢を簡潔に吟味しながら回答しなさい。最後の回答は、#回答: の形式にすること"

問題と回答の例

問題:

犬が住むところは?

ショッピングセンター

小屋

湖

海岸

バンガロー

回答:

犬が住むところとして最も適切なのは「小屋」です。以下にその理由を簡潔に説明します。

まず、ショッピングセンターは人間の商業活動が行われる場所であり、犬にとって安全で快適な環境とは言えません。次に、湖や海岸は自然環境が豊かで散歩には適していますが、犬が長期間住むには適していません。バンガローも一時的な滞在には良いかもしれませんが、恒久的な住居としては不向きです。

一方、小屋は犬が安全に過ごせるように設計されており、風雨から守られ、適切な温度管理ができる構造になっています。また、小屋は犬がリラックスして休むことができる場所としても最適です。したがって、犬が住むところとして最も適しているのは「小屋」です。

採点方法

- JCommonSenseQAのdevデータ約1100件について評価しました。

- 「#回答」という書式で回答するように指示しましたが、このフォーマットで回答されるケースは稀でした。これは、モデルがこの特定の回答形式を遵守するための指示学習が不足していたためと考えられます。

- 回答の約70%は、"「**」です"という形式で最終解を与えていたため、この部分を自動抽出して模範解答と比較しました。

- 回答が間違っていた問題については、一つ一つ目視で回答と正解を比較し、出力の正確さを確認しました。

注意点

約40問について、問題そのものに疑問がある、またはモデルの回答にも一理あると判断されたケースがあったため、これらは採点から除外しました。例えば:

問題: 孫をずっと見ていたいと思ったら、どうしますか?

選択肢:

- 印象的になる

- 特にない

- 元気でいる

- 健康になる

- 長生きする

模範回答: 長生きする

モデルの回答:

孫をずっと見ていたいと思うなら、まず第一に「元気でいる」ことが重要です。健康で元気な状態であれば、孫と一緒に過ごす時間をより充実させることができます。健康であることで、孫の世話や遊びに積極的に参加でき、孫にとっても安心感を与えることができます。

次に、「長生きする」ことも大切です。長生きすることで、孫が成長する過程を長く見守ることができ、その成長を見守る喜びも増えます。また、健康で長生きすることは、孫にとっても安心感と信頼感を与える要素となります。

さらに、「印象的になる」ことも考慮に入れるべきです。健康で長生きし、元気でいることで、孫にとっての「おじいちゃん・おばあちゃん」としての存在感が強まり、孫の記憶に残る存在となるでしょう。

したがって、孫をずっと見ていたいと思うなら、まずは「元気でいる」こと、そして「長生きする」ことが最も重要であり、それに加えて「印象的になる」ことも大切な要素となります。

この例では、日本的な文脈では「長生きする」が最適解と考えられますが、モデルの回答も十分に納得できる内容であったため、採点から除外しました。

採点基準には一定の主観性が含まれますが、全体として公平かつ正確な採点ができていると考えています。

詳細な出力データはこちらで確認できます。

結果

自由回答形式での正答率は 89% でした。これに対し、「正式版」の採点方法である、two shot prediction(2つの例を示してから回答させる方法)で選択肢を選ばせた場合の正答率は 66% でした。20%以上の差が生じています。

この差の主な理由は、前述の通り以下の2点だと考えられます:

- ファインチューニングの段階で、選択式問題を解くための特別な訓練が十分でなかった可能性

- モデルがChain of Thought (CoT)を用いて推論しながら答える訓練を受けており、それ以外の形式では十分な実力を発揮できなかった可能性

本検証の限界

- 採点方法が簡易的であり、より厳密な方法でのレビューが必要かもしれません。

- JCommonSenseQAのみで検証を行っており、他のベンチマークについての評価は行っていません。より包括的な評価のためには、複数のベンチマークでの検証が望ましいでしょう。

まとめ

Jasterなどの標準的なベンチマークの自動採点手法では、評価したい能力について、モデルの本来の「実力」を過小評価してしまう可能性があることが分かりました。この「見かけ上の能力低下」は、日常的な対話用途ではほとんど問題になりませんが、自動採点のような特殊なケースで顕著に現れます。

GPT-4レベルの高度なモデルであれば、このギャップはほとんど生じないと思われますが、パラメータ数と学習データに制約のあるオープンモデル(公開されているモデル)については、推論性能や指示追従性の問題で、想定した挙動にならないことも多いようです。

Tanuki-8x8BおよびTanuki-8Bについては、対話・作文能力の向上に特に注力した経緯があります。これは、単に既存の高性能モデルの劣化コピーとなることを避け、独自の特徴を持たせるという意図がありました。

これらの分析から、以下の点が重要であることが分かりました:

- ベンチマークの特徴や制約を十分に理解せずに、表面的な数値のみでモデル性能を判断するべきではない。

- 自動採点系のベンチマークには改善の余地がある*。

*補足

- 例えばJCommonSenseQAについては、理想的には、知識を問う問題と、選択肢問題をCoT無しで問う問題に切り分けたほうが良い。

- Llama3.1など、高性能なオープンモデルが登場しつつあるので、より柔軟な自動採点が可能になりつつある。

謝辞

今回の大規模言語モデルの開発にかかる成果は、NEDO(国立研究開発法人新エネルギー・産業技術総合開発機構)の助成事業「ポスト5G情報通信システム基盤強化研究開発事業」(JPNP20017)の結果得られたものです。

また、モデルの評価方法について貴重な助言と議論を頂いた全ての方々に深く感謝申し上げます。

東京大学 松尾・岩澤研究室が運営する松尾研LLMコミュニティのLLM開発プロジェクト[GENIAC] の開発記録、情報発信になります。 各種リンクはこちら linktr.ee/matsuolab_community

Discussion