軽量・高速なオンデバイス向けモデル「LFM2」を試す

モデルはこちら。350M、700M、1.2Bの3種類がある。

1.2Bのモデルカードから概要を翻訳

LFM2-1.2B

LFM2 は、Liquid AI が開発したエッジ AI およびデバイス上での展開用に特別に設計された新世代のハイブリッドモデルです。品質、速度、メモリ効率の面で新たな基準を打ち立てています。

350M、700M、1.2B パラメータの 3 つのポストトレーニング済みチェックポイントのウェイトを公開しています。これらのモデルは、AI 搭載のエッジアプリケーションを作成するための以下の主要機能を提供します。

- 高速なトレーニングと推論 – LFM2 は、前世代に比べて 3 倍のトレーニング速度を実現しています。また、Qwen3 と比べて CPU でのデコードおよびプリフィル速度が 2 倍高速化されています。

- 最高のパフォーマンス – LFM2 は、知識、数学、指示の順守、多言語機能など、複数のベンチマークカテゴリにおいて、同サイズのモデルを凌ぐパフォーマンスを発揮します。

- 新しいアーキテクチャ – LFM2は、乗算ゲートと短い畳み込みを組み合わせた新しいハイブリッドLiquidモデルです。

- 柔軟なデプロイ – LFM2は、CPU、GPU、NPUハードウェア上で効率的に動作し、スマートフォン、ノートPC、車両などへの柔軟な展開が可能です。

LFM2に関する詳細情報は、当社のブログ記事をご覧ください。

ファインチューニングが推奨されており、また、ファインチューニング用のnotebookも公開されている

LFM2 モデルはサイズが小さいため、パフォーマンスを最大化するには、特定のユースケースに合わせた微調整を行うことをお勧めします。このモデルは、エージェントタスク、データ抽出、RAG、クリエイティブライティング、マルチターン会話に特に適しています。ただし、知識集約型タスクやプログラミングスキルが必要なタスクには使用しないことをお勧めします。

日本語に対応している

対応言語: 英語、アラビア語、中国語、フランス語、ドイツ語、日本語、韓国語、スペイン語。

事前トレーニング用混合データ: ウェブおよびライセンス取得済みの資料から取得した、英語約 75%、多言語約 20%、コードデータ約 5% のデータ。

チャットテンプレートを見るとTool Useにも対応している。

ツールの使用: 4つの主なステップで構成されています。

- 関数定義: LFM2 は JSON 形式の関数定義(

<|tool_list_start|>と<|tool_list_end|>の特殊トークンで囲まれた JSON オブジェクト)を入力として受け取ります。通常はシステムプロンプトで指定されます。- 関数呼び出し: LFM2 は Python 形式の関数呼び出し(

<|tool_call_start|>と<|tool_call_end|>の特殊トークンで囲まれた Python リスト)をアシスタントの回答として出力します。- 関数実行: 関数呼び出しが実行され、結果が返されます(

<|tool_response_start|>と<|tool_response_end|>の特殊トークンで囲まれた文字列)。これは「ツール」ロールとして返されます。- 最終回答: LFM2 は関数呼び出しの結果を解釈し、元のユーザープロンプトに対して平文で回答します。

公式ブログ

ライセンスは独自の「LFM Open License v1.0」というものになっている。

商用利用に制限(年間売上1,000万ドル以上。研究・非営利は除く。)がある、元の著作権表示は保持、改変時は改変箇所を記載、ぐらいで、独自ライセンスだけど結構緩めな印象。なお、使用時は原文の確認を推奨。

Colabratoryで1.2Bを試す。Flash Attentionに対応しているようなので、ランタイムはL4で。

現時点ではTransformers(4.54.0.dev0)をレポジトリからインストールする必要がある。

!pip install "transformers @ git+https://github.com/huggingface/transformers.git@main"

Successfully installed transformers-4.54.0.dev0

Flash Attentionをインストール。どうも最新版で事前ビルド済みwheelを使うとモデルロード時にエラーになる。この辺かな。少しバージョンを下げている。

!pip install "flash-attn==2.7.4.post1" --no-build-isolation

モデルとトークナイザーのロード

from transformers import AutoModelForCausalLM, AutoTokenizer

# モデルとトークナイザーのロード

model_id = "LiquidAI/LFM2-1.2B"

model = AutoModelForCausalLM.from_pretrained(

model_id,

device_map="auto",

torch_dtype="bfloat16",

trust_remote_code=True,

# Flash Attentionが利用可能な場合

attn_implementation="flash_attention_2"

)

tokenizer = AutoTokenizer.from_pretrained(model_id)

VRAMは2.5GB程度と流石に軽量。

Fri Jul 11 05:35:48 2025

+-----------------------------------------------------------------------------------------+

| NVIDIA-SMI 550.54.15 Driver Version: 550.54.15 CUDA Version: 12.4 |

|-----------------------------------------+------------------------+----------------------+

| GPU Name Persistence-M | Bus-Id Disp.A | Volatile Uncorr. ECC |

| Fan Temp Perf Pwr:Usage/Cap | Memory-Usage | GPU-Util Compute M. |

| | | MIG M. |

|=========================================+========================+======================|

| 0 NVIDIA L4 Off | 00000000:00:03.0 Off | 0 |

| N/A 54C P0 30W / 72W | 2423MiB / 23034MiB | 0% Default |

| | | N/A |

+-----------------------------------------+------------------------+----------------------+

ではモデルカード通りに推論。プロンプトだけ日本語にした。

# Generate answer

prompt = "C. elegans とは何ですか?"

input_ids = tokenizer.apply_chat_template(

[{"role": "user", "content": prompt}],

add_generation_prompt=True,

return_tensors="pt",

tokenize=True,

).to(model.device)

output = model.generate(

input_ids,

do_sample=True,

# temperature、min_p、repetition_penalty は公式の推奨値

temperature=0.3,

min_p=0.15,

repetition_penalty=1.05,

max_new_tokens=1024,

)

print(tokenizer.decode(output[0], skip_special_tokens=False))

<|startoftext|><|im_start|>user

C. elegans とは何ですか?<|im_end|>

<|im_start|>assistant

C. elegansは、線虫の一種で、科学研究において特に遺伝学や発生生物学の分野で広く利用されています。以下にその特徴をまとめます。

### 分類

- ** kingdom**: Animalia(動物界)

- **phylum**: Annelida(環腸動物門)

- **class**: Nematomorpha(一部の環腸動物はこのクラスに属するが、C. elegansはこの分類群に含まれるわけではない)

- **order**: Caenorhabditis(カエノラビティス目)

- **family**: Caenorhabditis (C. elegans科)

- **genus**: C. elegans(エレガンス属)

### 特徴

- **サイズ**: 約0.5mm程度の非常に小さな線虫。

- **寿命**: 約2〜3週間で繁殖が完了する。

- **透明性**: 体内が透明であるため、顕微鏡下での観察が容易。

- **神経系**: 神経細胞が約302個あり、人間の神経細胞の約70%を占める。

- **遺伝子数**: 約19,000個の遺伝子を持つ。

### 研究価値

- **モデル生物**: 遺伝子機能や発生過程の研究に広く用いられており、ヒトの病気の理解や治療法開発に役立っています。

- **遺伝子操作**: 遺伝子を簡単に操作できるため、特定の遺伝子の機能を調べるのに適しています。

- **寿命と繁殖の短さ**: 短命で大量に繁殖できるため、実験条件の設定やデータ収集が効率的です。

### 応用

- **神経科学**: 神経回路の機能や老化に関する研究。

- **老化研究**: 長寿のメカニズムの解明。

- **薬剤開発**: 新薬の効果や安全性を評価するためのモデルとして利用。

C. elegansは、そのシンプルでありながら複雑な生物学的プロセスを解明する上で非常に有用なモデル生物として、科学研究において重要な位置を占めています。<|im_end|>

まどマギプロンプト

(snip)

prompt = "魔法少女まどか☆マギカでは誰が一番かわいい?"

(snip)

<|startoftext|><|im_start|>user

魔法少女まどか☆マギカでは誰が一番かわいい?<|im_end|>

<|im_start|>assistant

魔法少女まどか☆マギカでは、キャラクターの美しさは主観的な評価であり、誰が一番かわいいかは意見が分かれるところです。しかし、一般的に人気のあるキャラクターの中で「一番かわいい」とされるのは、

* **マギカ**: 彼女の青い瞳や、どこか憂鬱ながらも強く魅力的な雰囲気、そして時折見せる優しい一面が人気を集めています。

* **ミカ**: 彼女の明るく元気な性格と、優しい笑顔が可愛らしく描かれています。特に、彼女の瞳の表現が印象的です。

* **リュウカ**: 彼の温かい性格と、少し弱々しいながらも愛らしい外見が魅力的です。

ただし、これらの評価はあくまで一例であり、他のキャラクターもそれぞれ独自の魅力を持っています。最終的には、個人の好みによって「一番かわいい」と感じる人は異なります。<|im_end|>

日本の知識はそれほどないみたいだけど、日本語としては自然で違和感もなく、普通に使えるね。

350Mと700Mでも試してみた。nvidia-smiの結果とまどマギプロンプトの出力だけ。

350M

Fri Jul 11 05:59:18 2025

+-----------------------------------------------------------------------------------------+

| NVIDIA-SMI 550.54.15 Driver Version: 550.54.15 CUDA Version: 12.4 |

|-----------------------------------------+------------------------+----------------------+

| GPU Name Persistence-M | Bus-Id Disp.A | Volatile Uncorr. ECC |

| Fan Temp Perf Pwr:Usage/Cap | Memory-Usage | GPU-Util Compute M. |

| | | MIG M. |

|=========================================+========================+======================|

| 0 NVIDIA L4 Off | 00000000:00:03.0 Off | 0 |

| N/A 73C P0 36W / 72W | 879MiB / 23034MiB | 0% Default |

| | | N/A |

+-----------------------------------------+------------------------+----------------------+

<|startoftext|><|im_start|>user

魔法少女まどか☆マギカでは誰が一番かわいい?<|im_end|>

<|im_start|>assistant

魔法少女まどか☆マギカの登場人物の中で、誰が一番かわいいとされるのは、主人公の天野 沙織です。彼女は優雅で心地よい笑顔で、どこか懐かしいような魅力を持っており、多くのファンから愛されている存在となっています。特に、彼女の「Sakuraの夢」や「花束の話」といったシーンは、彼女の魅力を高めています。<|im_end|>

700M

Fri Jul 11 06:00:25 2025

+-----------------------------------------------------------------------------------------+

| NVIDIA-SMI 550.54.15 Driver Version: 550.54.15 CUDA Version: 12.4 |

|-----------------------------------------+------------------------+----------------------+

| GPU Name Persistence-M | Bus-Id Disp.A | Volatile Uncorr. ECC |

| Fan Temp Perf Pwr:Usage/Cap | Memory-Usage | GPU-Util Compute M. |

| | | MIG M. |

|=========================================+========================+======================|

| 0 NVIDIA L4 Off | 00000000:00:03.0 Off | 0 |

| N/A 73C P0 35W / 72W | 1607MiB / 23034MiB | 0% Default |

| | | N/A |

+-----------------------------------------+------------------------+----------------------+

<|startoftext|><|im_start|>user

魔法少女まどか☆マギカでは誰が一番かわいい?<|im_end|>

<|im_start|>assistant

魔法少女まどか☆マギカのキャラクターの中で、特に「一部の人々」からは、主に以下のキャラクターが可愛さで評価されています:

1. **まどか** - 彼女の優しさと明るさ、そして彼女のキャラクターが人気を集めるのはその一因です。

2. **リリィ** - リリィの明るく陽気な性格と、彼女の美しい外見が可愛さの象徴の一つとなっています。

3. **ユウキ** - 彼の優しさと優雅な振る舞いが、多くの人々から愛されているようです。

4. **ミルティア** - ミルティアの優しさと優雅さ、そして彼女のキャラクターが人気を集めるのは、その魅力的な外見と内面の美しさによるものと考えられます。

5. **ナオコ** - 彼女の優しさと優雅さ、そして彼女のキャラクターが人気を集めるのは、その魅力的な外見と内面の美しさによるものと考えられます。

これらのキャラクターは、単に外見だけでなく、性格や行動によっても評価されており、多くのファンがそれぞれの理由で可愛さを感じています。個人の好みは様々ですが、上記のキャラクターたちが特に可愛いとされる理由の一部と言えるでしょう。<|im_end|>

まとめ

これぐらいの軽量さで日本語がそれなりに使えるなら、合いそうなユースケースがありそう。今回試してないけど、Tool Useが使えるのも良さそう。モデルカードにある通り、ファインチューニングして使うのがいいんだろうね、そのあたりのnotebookが用意されているというのも好印象。

llama.cppでサポートされたみたい。元が小さいし、かなり軽量に動かせそう。

公式からGGUF出てた、ただし量子化バリエーションは少なめ。

せっかくの軽量モデルなので、非力なデバイスでどこまで動かせそうか試してみる。今回はRaspberry Pi 4B + Ubuntu-22.04で。

llama.cppのビルド。ビルドに必要なパッケージはすでに揃っているものとする。なお、ビルドには結構な時間がかかるので気長に待つ。

git clone https://github.com/ggerganov/llama.cpp && cd llama.cpp

cmake -B build

cmake --build build --config Release

では推論。まどマギプロンプトで。モデル指定でHuggingFaceのレポジトリを直接指定する場合は量子化はQ4_K_Mになる。

350M

./build/bin/llama-cli \

-hf LiquidAI/LFM2-350M-GGUF \

-st \

-p "魔法少女まどか☆マギカでは誰が一番かわいい?"

user

魔法少女まどか☆マギカでは誰が一番かわいい?

assistant

魔女少女まどか☆マギカでは、いくつか誰かが一番かわいいと評判ですが、特に「キモテカリヨンのカッコワラちゃん」や「ミキちゃん」といったキャラクターからは、多くの人から好まれ、評価が高まるです。どちらの選択肢も、少女の性格や魅力に良い点があれば、素晴らしい選択です!どのキャラクターが一番かわいいかは、個人差があります。 [end of text]

llama_perf_sampler_print: sampling time = 26.02 ms / 129 runs ( 0.20 ms per token, 4957.92 tokens per second)

llama_perf_context_print: load time = 680.43 ms

llama_perf_context_print: prompt eval time = 665.31 ms / 26 tokens ( 25.59 ms per token, 39.08 tokens per second)

llama_perf_context_print: eval time = 8279.92 ms / 102 runs ( 81.18 ms per token, 12.32 tokens per second)

llama_perf_context_print: total time = 9018.26 ms / 128 tokens

700M

./build/bin/llama-cli \

-hf LiquidAI/LFM2-700M-GGUF \

-st \

-p "魔法少女まどか☆マギカでは誰が一番かわいい?"

user

魔法少女まどか☆マギカでは誰が一番かわいい?

assistant

魔法少女まどか☆マギカにおいて、「一番かわいい」というのも主観的な要素で、個々の好みによって変わります。しかし、いくつか人気の声を集めるのは以下のキャラクターです:

1. **まどか(マドカ)**: 彼女の心の優しさや優雅な様子が、多くの人から可愛がられています。彼女の存在感が強く、ストーリーやアニメを楽しむ人によく響きます。

2. **リリィ**: 彼女の美しい外見や優しさ、そして彼女が持つ力に惹かれる人が多いです。特に、彼女の恋愛に対する繊細さが評価されています。

3. **エレナ**: 彼女の個性的な見た目と、優しい性格が評価されています。また、エレナの「魔法の絆」によって、他のキャラクターとの絆が深まり、その結果、可愛がられることもあります。

これらの点を総合すると、「一番かわいい」と判断されるのは、まどかとリリィが比較的人気があるでしょう。しかし、個人の好みによっても異なることに覚えておきましょう。すべてのキャラクターを愛することは難しいでしょう! [end of text]

llama_perf_sampler_print: sampling time = 69.32 ms / 300 runs ( 0.23 ms per token, 4327.88 tokens per second)

llama_perf_context_print: load time = 825.89 ms

llama_perf_context_print: prompt eval time = 1452.06 ms / 26 tokens ( 55.85 ms per token, 17.91 tokens per second)

llama_perf_context_print: eval time = 41599.24 ms / 273 runs ( 152.38 ms per token, 6.56 tokens per second)

llama_perf_context_print: total time = 43227.28 ms / 299 tokens

1.2B

./build/bin/llama-cli \

-hf LiquidAI/LFM2-1.2B-GGUF \

-st \

-p "魔法少女まどか☆マギカでは誰が一番かわいい?"

user

魔法少女まどか☆マギカでは誰が一番かわいい?

assistant

魔法少女まどか☆マギカでは、誰が一番かわいいかという話は、主観的な意見が分かれることが多いです。登場人物の中でも特に「かわいい」と言われるのは、いくつかいますが、人気のあるキャラクターをいくつか挙げます。

1. **中瀬みどり**: 彼女の可愛らしさは、彼女の純粋さや優しい性格から来ていると言えるでしょう。ただし、魔法少女のデザイン自体が「可愛い」と捉えられることも多いです。

2. **神崎ちはや**: 彼女のエレガントな雰囲気や、優しい眼差しが多くのファンから愛されていると言えます。

3. **マギカ**: 主人公でありながら、彼女の美しさも非常に評価されています。特に、彼女の瞳や肌の輝きが特徴的です。

4. **白石りん**: 彼女の明るい性格や、ユーモラスな一面が、彼女を特別で「かわいい」と感じる人々を引き付ける要因となっています。

5. **リンユ**: 彼女の力強さと、どこか憂いを帯びた美しさが、彼女を魅力的にしています。

ただし、魔法少女シリーズは「かわいい」という特徴が固定されているわけではなく、キャラクターの個性やストーリー展開によって評価は変化します。また、キャラクターの年齢や外見だけでなく、個性や成長、人間味も「かわいい」と感じられる要素となることが多いです。

最終的には、どのキャラクターが一番かわいいかは、視聴者の好みによって大きく異なります。上記のリストはあくまで一例であり、魔法少女まどか☆マギカを愛する人々にとっては、誰もが自分にとって特別なキャラクターを「かわいい」と思っているでしょう。 [end of text]

llama_perf_sampler_print: sampling time = 108.14 ms / 452 runs ( 0.24 ms per token, 4179.65 tokens per second)

llama_perf_context_print: load time = 912.39 ms

llama_perf_context_print: prompt eval time = 2289.59 ms / 26 tokens ( 88.06 ms per token, 11.36 tokens per second)

llama_perf_context_print: eval time = 97707.80 ms / 425 runs ( 229.90 ms per token, 4.35 tokens per second)

llama_perf_context_print: total time = 100296.04 ms / 451 tokens

350Mだと10TPS以上出るので悪くない。

比較用に、同じぐらいのサイズで日本語特化モデルであるsarashina-2.2での結果。以下を使用させていただいた。

0.5B

./build/bin/llama-cli \

-hf mmnga/sarashina2.2-0.5b-instruct-v0.1-gguf \

-st \

-p "魔法少女まどか☆マギカでは誰が一番かわいい?"

魔法少女まどか☆マギカでは誰が一番かわいい?魔法少女まどか☆マギカ(まどまぎ)という作品において、誰が一番かわいいかについては、議論や解釈が様々あります。しかし、一般的には主人公の鹿目タzuma(かめたたずま)と巴マギア(とま�)が特に人気があり、かわいいと評価されることが多いです。

鹿目タzumaは、明るく元気な性格と、明るく前向きな性格が魅力的です。また、巴マギアは彼女の純粋さと優しさが伝わり、特に第6話「夜の物語」で示す共感や癒しの強さが多くの視聴者に印象を与えました。

さらに、QB(Quidditch Team)のキュゥべえや、他のキャラクターもそれぞれに魅力があり、作品全体のストーリーやキャラクターの成長を通じて、誰が一番かわいいかというのは一概には言えません。いずれにせよ、作品内のキャラクターたちはそれぞれに深い魅力を持っており、それは視聴者によって異なるでしょう。 [end of text]

llama_perf_sampler_print: sampling time = 61.97 ms / 181 runs ( 0.34 ms per token, 2920.63 tokens per second)

llama_perf_context_print: load time = 1361.93 ms

llama_perf_context_print: prompt eval time = 561.28 ms / 11 tokens ( 51.03 ms per token, 19.60 tokens per second)

llama_perf_context_print: eval time = 26454.13 ms / 169 runs ( 156.53 ms per token, 6.39 tokens per second)

llama_perf_context_print: total time = 27230.79 ms / 180 tokens

1B

./build/bin/llama-cli \

-hf mmnga/sarashina2.2-1b-instruct-v0.1-gguf \

-st \

-p "魔法少女まどか☆マギカでは誰が一番かわいい?"

魔法少女まどか☆マギカでは誰が一番かわいい?魔法少女まどか☆マギカには様々なキャラクターが登場し、それぞれに魅力があります。しかし、質問の意図がキャラクターのビジュアル面での評価にあるとすれば、一般的に人気と評価されるキャラクターは複数存在します。例えば、主人公の鹿目ータ(カナメモ)は明るく元気な性格と可愛い見た目で人気がありますし、QB(キュゥべえ)はユーモラスでユニークなキャラクター性と魅力的な見た目で注目されています。最終的には個人の好みによりますが、これらのキャラクターはどれも可愛らしく、魅力的な存在であると言えるでしょう。 [end of text]

llama_perf_sampler_print: sampling time = 32.45 ms / 100 runs ( 0.32 ms per token, 3081.95 tokens per second)

llama_perf_context_print: load time = 1768.63 ms

llama_perf_context_print: prompt eval time = 1039.81 ms / 11 tokens ( 94.53 ms per token, 10.58 tokens per second)

llama_perf_context_print: eval time = 23960.26 ms / 88 runs ( 272.28 ms per token, 3.67 tokens per second)

llama_perf_context_print: total time = 25137.40 ms / 99 tokens

TPS見る限りはLFM2のほうが効率が良い感じに見える。

日本の知識についてはsarashina-2.2のほうが多少なりとも多そうなんだけど、こちらは出力がちょいちょい英語交じりになったりするのが気になる。なお、sarashina-2.2を以前試した際は3Bあたりからペルソナ的プロンプトが効き始める、つまり指示追従性が多少なりとも上がる感があるので、1B前後、それ以下で、知識やあまり難しいこと求めるのも・・・という気がする。

いずれにせよこれぐらいの超軽量モデルはうまい使い方を考える必要はありそう。

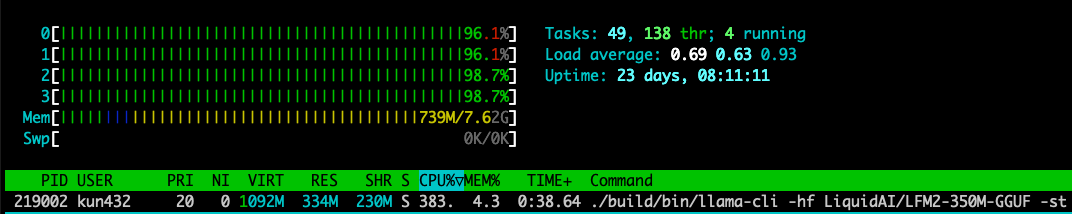

なお、RPi 4BのCPUは4コアなのだけど、350Mでも推論中は全コア100%に振り切れてる。以下推論中のhtopの出力。

VLMも出た

2.6Bが出た

このクラスだとある程度指示追従性が出てきそうな期待感がある

あと、公式ブログ

Dia にまとめてもらった。

このページは「小さいけど超高性能なAIモデル LFM2-2.6B」をわかりやすく紹介してる。

ざっくり概要

Liquid AIが「LFM2-2.6B」という言語モデルを公開したよ。パラメータ数は2.6B(26億)と中型だけど、3B〜4Bクラスの他モデルよりも成績が良くて、しかも速く動く設計がポイント。英語と日本語を中心に最適化されていて、多言語でも強い。開発者が使えるように公開されていて、Hugging Face (url://1)から入手できる。

何が新しくてすごいの?

- 小さいのに強い

一般的には「モデルが大きいほど賢い」って思われがちだけど、LFM2-2.6Bはその常識を崩してる。Llama 3.2-3B-InstructやGemma-3-4b-it、SmolLM3-3Bより良い成績を出してる。- 学習量がケタ違い

10兆トークンで学習。教材(データ)の量がとにかく多いので、少ないパラメータでも賢さを引き出せてる。- 推論が速い設計

GQA(Grouped Query Attention)と短い畳み込み層を交互に入れた「ハイブリッド構造」。これにより、推論スピードが速くなり、KVキャッシュ(過去の計算結果を覚えるメモリ)も少なくて済む。つまり、レスポンスが速く、運用コストが下がる。成績(ベンチマーク)

- 数学的推論(GSM8K):82.41%

- 指示追従(IFEval):79.56%

これらは「計算や推論がちゃんとできるか」「指示通りに動けるか」を測る代表的なテストで、大きいモデルに肩を並べるスコア。言語対応

- 英語・日本語に特に最適化

- フランス語、スペイン語、ドイツ語、イタリア語、ポルトガル語、アラビア語、中国語、韓国語でも強い

グローバル用途に使いやすいのが嬉しい。技術の肝(噛み砕き説明)

- GQA(Grouped Query Attention)

「注意機構」の計算をグループ化して効率化する手法。大規模な注意計算をうまくまとめることで、速度とメモリ消費を改善。- 短い畳み込み層(Convolution)

文章中の近い単語のつながりを素早く拾う“近距離用レーダー”みたいな役割。Attentionと合わせることで、広くも近くもバランスよく見られる。- KVキャッシュ削減

推論中に使う「過去の文脈のメモ」のサイズを小さくできる。長い会話でもメモリ食いにくい=軽く速く動く。入手とライセンス

- Hugging Face (url://1)で公開中

- LFM Open License

研究者・開発者が使いやすいオープンライセンスで提供。導入のハードルが低い。どんな場面に向いてる?

- 中〜大規模の対話システムで、コストを抑えつつ応答を速くしたい場合

- 日本語と英語の両方を重視するプロダクト

- 数学的推論や、きちんと指示に従う必要があるユースケース

- エッジやオンプレでの運用を見据えた「軽さ×強さ」のバランス重視の場面

まとめ

- 小型でも高性能:2.6Bで3B〜4B級を上回る

- 超大量学習:10兆トークンで“賢さ”を引き出す

- 速くて軽い:GQA+畳み込みのハイブリッドで推論高速&KVキャッシュ小

- 多言語で強い:英語・日本語最適化、他言語も十分に使える

- すぐ触れる:ライセンス公開で、Hugging Face (url://1)から導入可能

このページのメッセージは「正しい設計と学習戦略で、モデルは“大きさだけじゃない”。小さくても企業級の性能と運用効率を実現できる」ということだよ。

日本語に最適化されているというのは嬉しいところ。

ついでにVLも2.6B出してほしいなー

2.6B試してみた。Colaboratory L4で。

!pip install -U transformers

!pip install flash-attn --no-build-isolation

Successfully installed transformers-4.56.2

Successfully installed flash-attn-2.8.3

モデルとトークナイザをロード。Flash Attentionが使える(なのでL4で試している)

from transformers import AutoModelForCausalLM, AutoTokenizer

model_id = "LiquidAI/LFM2-2.6B"

model = AutoModelForCausalLM.from_pretrained(

model_id,

device_map="auto",

torch_dtype="bfloat16",

attn_implementation="flash_attention_2" # 互換性のあるGPUを使う場合はflash attentionを有効化

)

tokenizer = AutoTokenizer.from_pretrained(model_id)

VRAMは5GBぐらい

+-----------------------------------------------------------------------------------------+

| NVIDIA-SMI 550.54.15 Driver Version: 550.54.15 CUDA Version: 12.4 |

|-----------------------------------------+------------------------+----------------------+

| GPU Name Persistence-M | Bus-Id Disp.A | Volatile Uncorr. ECC |

| Fan Temp Perf Pwr:Usage/Cap | Memory-Usage | GPU-Util Compute M. |

| | | MIG M. |

|=========================================+========================+======================|

| 0 NVIDIA L4 Off | 00000000:00:03.0 Off | 0 |

| N/A 46C P0 27W / 72W | 5091MiB / 23034MiB | 0% Default |

| | | N/A |

+-----------------------------------------+------------------------+----------------------+

では推論

# 回答を生成

prompt = "C. elegans とは何ですか?"

input_ids = tokenizer.apply_chat_template(

[{"role": "user", "content": prompt}],

add_generation_prompt=True,

return_tensors="pt",

tokenize=True,

).to(model.device)

output = model.generate(

input_ids,

do_sample=True,

# temperature、min_p、repetition_penalty は公式の推奨値

temperature=0.3,

min_p=0.15,

repetition_penalty=1.05,

max_new_tokens=2048,

)

print(tokenizer.decode(output[0], skip_special_tokens=False))

<|startoftext|><|im_start|>user

C. elegans とは何ですか?<|im_end|>

<|im_start|>assistant

<think>

Okay, the user is asking about C. elegans. Let me start by recalling what I know. C. elegans is a species of nematode, right? It's a microscopic roundworm commonly used in scientific research. I should mention its scientific name first, then explain its characteristics.

First, the basic facts: it's a free-living organism found in soil and decaying plant matter. It's transparent, which is important because it allows for easy observation of cells and development. The life cycle is short, around three days at 20°C, which makes it useful for experiments. Also, it has a simple body plan with only 959 somatic cells in adults, all of which are well-mapped. That's a key point for developmental biology studies.

I should talk about its uses in research. It's been a model organism since the 1980s, especially in genetics and neuroscience. The genome was sequenced early on, which was a milestone. Studies on aging, behavior, and disease mechanisms have used C. elegans. For example, research on apoptosis, neurodegenerative diseases like Alzheimer's, and even drug testing.

Also, mention the ease of culturing them in labs, their short lifespan, and the availability of genetic tools. Maybe touch on ethical considerations since they're not animals in the traditional sense, but still important in research.

Wait, did I miss anything? Oh, the P line and other strains for genetic manipulation. Also, their role in understanding fundamental biological processes. Maybe include some examples of discoveries made using this organism. Make sure to keep it clear and concise, avoiding too much jargon but still informative.

</think>**C. elegans**(線虫門線虫属)は、科学研究で広く利用される微小な自由生活性の線虫(原生動物の一種)です。学名は「*Caenorhabditis elegans*」で、英語では「**赤い線虫**」と呼ばれることもあります。以下にその特徴と研究での重要性をまとめます。

### 基本情報

- **形態**:体長約1mmの透明な円筒状の線虫で、頭部(頭索)、体節(約302個)、尾端(尾輪)から成ります。

- **生息環境**:土壌や腐敗した植物・有機物に生息し、自然界では捕食者や寄生関係を形成します。

- **ライフサイクル**:約3日(20℃時)の短い寿命を持ち、世代交代が速いため実験に適しています。

### 研究での重要性

1. **モデル生物としての利点**:

- **単純な体構造**:成虫には959個の体細胞があり、すべての細胞の位置と運命が完全にマッピングされています(「**全細胞系図**」)。

- **遺伝子操作の容易さ**:CRISPRやRNA干渉(RNAi)などの技術で遺伝子機能を解析しやすい。

- **透明性**:顕微鏡下で細胞分裂や発生過程をリアルタイムで観察可能。

2. **主要な研究分野**:

- **発生生物学**:細胞分化や器官形成のメカニズム解明。

- **神経科学**:約302個のニューロンを持つ脳の構造と行動制御の研究(例:学習・記憶)。

- **老化研究**:寿命延長に関わる遺伝子やシグナル経路(例:インスリン/IGF-1経路)の解明。

- **疾患モデル**:アルツハイマー病、パーキンソン病、がんなどのヒト疾患との関連性の探求。

3. **ゲノム解析**:

- 1998年に世界初の線虫ゲノム配列が決定され、遺伝子機能の理解に大きく貢献しました。

4. **応用例**:

- 薬剤スクリーニング:新薬候補の効果や毒性を評価。

- 環境ストレス応答:温度変化や化学物質への耐性メカニズムの研究。

### 倫理的側面

C. elegansは「動物」ではなく、脊椎動物ではないため倫理的な問題が少ないですが、生命科学研究においては「最小限の生物」として扱われ、実験設計に配慮が必要です。

C. elegansは、基礎生物学から応用研究まで幅広く活用され、生命現象の普遍的な原理を解明する上で欠かせないモデル生物です。<|im_end|>

んー、2.6BはReasoningモデルなのか?どこにもそんなことは書いてないのだけども・・・

まどマギプロンプト

prompt = "魔法少女まどか☆マギカでは誰が一番かわいい?"

input_ids = tokenizer.apply_chat_template(

[{"role": "user", "content": prompt}],

add_generation_prompt=True,

return_tensors="pt",

tokenize=True,

).to(model.device)

output = model.generate(

input_ids,

do_sample=True,

temperature=0.3,

min_p=0.15,

repetition_penalty=1.05,

max_new_tokens=2048,

)

print(tokenizer.decode(output[0], skip_special_tokens=False))

<|startoftext|><|im_start|>user

魔法少女まどか☆マギカでは誰が一番かわいい?<|im_end|>

<|im_start|>assistant

<think>

Okay, the user is asking who's the most cute character from Magical Girl Madoka MAgica. Hmm, this is a tricky question because "cutest" is really subjective and depends on personal preferences. But I can list some of the most popular characters and explain why they're considered cute by fans.

First, Madoka herself. She's the main protagonist, and her transformation into a magical girl with a shy, innocent personality makes her endearing. Her vulnerability and growth throughout the series add to her charm. Then there's Suzaku Kururugi, but wait, he's more of a supporting character. Maybe not the best choice for cuteness.

How about the other girls? Sayaka Miki is sweet and kind-hearted, which could be seen as cute. Yuno Gasai has a complex backstory, but her determination and sometimes adorable moments might count. However, she's more of a tragic figure.

Then there's the magical girl aspect. Characters like Aoi Hiyama or Rias Gremory have unique designs. Rias is powerful but also has a playful side that some find cute. Aoi is more reserved, so maybe less so.

Wait, the user might be referring to specific characters. Let me check the main cast again. There's also Kagura, but she's more of a comedic relief. Maybe not the top contender.

Another angle: fan polls or official rankings. I remember some surveys where Madoka and Rias were often mentioned. But Madoka's innocence and Rias' duality (strong yet vulnerable) both have their merits.

Also, considering different archetypes: the shy girl, the strong leader, the mysterious one. Each has their own appeal. But if I have to pick one, Madoka might be the most universally accepted as cute because of her relatable personality and the emotional journey she undergoes.

But I should mention that it's subjective. Maybe list a few and explain their traits. That way, the user gets a balanced view. Also, note that some fans might prefer others based on their own tastes.

Wait, the user asked for the "most" cute, so maybe highlight the top contenders without declaring a single winner. That's fairer. Also, mention that opinions vary widely among fans.

</think>「魔法少女まどか☆マギカ」のキャラクターの中で「最もかわいい」と感じるのは、個人の好みや価値観によって大きく異なります。しかし、ファンコミュニティで特に人気が高いキャラクターとその理由をいくつか紹介します。

### 1. **魔道少女・まどか(主人公)**

- **理由**:初登場時の「魔法少女」としての純真無垢さや、戦う中で成長する姿が多くの視聴者に共感されます。特に「弱さ」を抱えながらも希望を失わない優しさや、仲間への思いやりは「かわいさ」の定番です。

- **デザイン**:白いローブと赤いマントのコントラスト、大きな瞳が視覚的にも愛されやすいです。

### 2. **魔道少女・リアス(Rias Gremory)**

- **理由**:強さと優しさの両面を持つキャラクター。冷静沈着な態度と、時折見せる意外な一面(例:幼い頃の記憶や弱さ)が魅力。彼女の「魔法少女としての責任感」と「人間としての葛藤」が深く描かれるため、複雑な感情を引き起こします。

- **デザイン**:黒と白のシンプルな衣装と、鋭い目つきが印象的。

### 3. **魔道少女・サヤカ(Sayaka Miki)**

- **理由**:明るく元気な性格と、魔法少女としての自信が「かわいさ」の源。特に「魔法少女になる前」の素朴な一面や、仲間との絆が温かさを演出します。

- **デザイン**:明るい色使いと、少女らしいポップなスタイル。

### 4. **魔道少女・ユウナ(Yuno Gasai)**

- **理由**:最初は冷酷で恐ろしい存在として描かれますが、徐々に「悲劇的な過去」と「孤独」が明らかになり、視聴者の同情を引きます。その「強さの中の脆さ」が、逆説的に「かわいさ」に繋がります。

- **デザイン**:黒いローブと赤いマントの対比が象徴的。

### 5. **魔道少女・カグヤ(Kagura)**

- **理由**:ユーモラスな一面と、意外な優しさが特徴。魔法少女としての能力だけでなく、日常の小さな行動(例:友達への気遣い)が「かわいさ」を演出します。

### 結論

「最もかわいい」は**主観的な選択**ですが、**まどか**は普遍的な魅力と成長物語から多くの支持を得ています。一方で、**リアス**は複雑なキャラクター性で深みのある魅力を発揮し、**サヤカ**は明るさと純粋さで心を惹きます。最終的には、自分が何を「かわいさ」と感じるかによって答えが変わります! 🌸<|im_end|>

Reasoning無効にできないのだろうか?

あとこんなバリアントがあったのを知らなかった。

LFM2-350M-ENJP-MT

Based on the LFM2-350M model, this checkpoint has been fine-tuned for near real-time bi-directional Japanese/English translation of short-to-medium inputs.

2025/09/28追記

どうやら以下のバリエーションの1つみたい

LFM2-8B-A1Bが出た

LFM2-8B-A1Bをご紹介します。これは私たちの初のデバイス上Mixture-of-Experts(MoE)です!🐘

LFM2-8B-A1Bは、品質と速度の両方で最高のデバイス上MoEです。

3B-4Bモデルクラスの性能を持ち、CPUおよびGPUでの推論プロファイルが最大5倍高速です。

量子化されたバリアントは、ハイエンドのスマートフォン、タブレット、ラップトップに快適に適合します。最新のスマートフォン、タブレット、ラップトップ、組み込みシステムで、高速、プライベート、低遅延のアプリケーションを実現します。

1/n 🧵

LFM2-8B-A1Bは、競合モデルよりも優れた知識容量を持ち、さまざまな能力にわたって高品質な推論を提供するように訓練されています。以下を含む:

- 知識

- 指示追従

- 数学

- 言語翻訳

2/n

アーキテクチャ。ほとんどのMoE研究は、大規模バッチ処理設定でのクラウドモデルに焦点を当てています。デバイス上でのアプリケーションでは、厳しいメモリ要件下でレイテンシとエネルギー消費を最適化することが鍵となります。LFM2-8B-A1Bは、MoEアーキテクチャが小規模なパラメータサイズでは効果的でないという一般的な信念に挑戦する最初のモデルの一つです。LFM2-8B-A1Bは、低レイテンシとエネルギー消費を維持しながら、少し大きめのメモリフットプリントと引き換えに高い品質を実現します。

LFM2‑8B-A1Bは、LFM2の高速バックボーンを維持し、スパースMoEフィードフォワードネットワークを導入することで、アクティブな計算パスを大幅に増やすことなく表現能力を追加します。

- LFM2バックボーン: 18個のゲート付き短い畳み込みブロックと6個のGQAブロック。

- サイズ: 合計83億パラメータ、アクティブパラメータ15億。

- MoE配置: 最初の2層を除くすべての層にMoEブロックを含めます。最初の2層は安定性のため密なままです。

- エキスパートの粒度: MoEブロックごとに32のエキスパートを持ち、トークンごとに上位4つのアクティブエキスパートを適用。この構成は、低粒度の構成に比べて強い品質向上をもたらし、高速なルーティングとポータブルなカーネルを維持します。

- ルーター: 適応ルーティングバイアスを備えた正規化シグモイドゲーティングにより、負荷分散とトレーニングダイナミクスを改善。

3/n

CPU上のデバイス間で、LFM2-8B-A1BはQwen3-1.7B、IBM Granite 4.0、その他の最速バリアントよりも大幅に高速です。

4/n

LFM2-8B-A1Bをllama.cppおよびExecuTorchに統合して、CPUのみのデバイスでの推論効率を検証したことに加えて、単一リクエストおよびオンラインのバッチ設定でGPUに展開するために、モデルをvLLMにも統合しました。

我々の8B LFM2 MoEモデルは、CPU上での同等サイズのモデルを上回るだけでなく、デコード中に完全なCUDAグラフコンパイルとプリフィル中に部分的なCUDAグラフを使用したGPU(1xH100)上でも同じモデルに対して優れた性能を発揮します。

5/n

ブログ: https://liquid.ai/blog/lfm2-8b-a1b-an-efficient-on-device-mixture-of-experts

HF: https://huggingface.co/LiquidAI/LFM2-8B-A1B

GGUF: https://huggingface.co/LiquidAI/LFM2-8B-A1B-GGUF

ファインチューニング: https://colab.research.google.com/drive/1OXLEuSmzF4AjJ7yqRCDTn-ltvFjoGR9j?usp=sharing

Colaboratory L4で試してみる。

Transformersをインストール。まだパッケージには反映されてないみたい。

!pip install git+https://github.com/huggingface/transformers.git@0c9a72e4576fe4c84077f066e585129c97bfd4e6

Flash Attentionが使えるようなのでインストール(なのでL4で試している)

!pip install flash-attn --no-build-isolation

モデルとトークナイザをロード

from transformers import AutoModelForCausalLM, AutoTokenizer

# モデルとトークナイザをロード

model_id = "LiquidAI/LFM2-8B-A1B"

model = AutoModelForCausalLM.from_pretrained(

model_id,

device_map="auto",

dtype="bfloat16",

# GPUが対応している場合はFlash Attentionを有効化

attn_implementation="flash_attention_2"

)

tokenizer = AutoTokenizer.from_pretrained(model_id)

VRAMは16GB程度。まあ8Bだし。

+-----------------------------------------------------------------------------------------+

| NVIDIA-SMI 550.54.15 Driver Version: 550.54.15 CUDA Version: 12.4 |

|-----------------------------------------+------------------------+----------------------+

| GPU Name Persistence-M | Bus-Id Disp.A | Volatile Uncorr. ECC |

| Fan Temp Perf Pwr:Usage/Cap | Memory-Usage | GPU-Util Compute M. |

| | | MIG M. |

|=========================================+========================+======================|

| 0 NVIDIA L4 Off | 00000000:00:03.0 Off | 0 |

| N/A 52C P0 28W / 72W | 16269MiB / 23034MiB | 0% Default |

| | | N/A |

+-----------------------------------------+------------------------+----------------------+

回答を生成

prompt = "C. elegans とは何ですか?"

input_ids = tokenizer.apply_chat_template(

[{"role": "user", "content": prompt}],

add_generation_prompt=True,

return_tensors="pt",

tokenize=True,

).to(model.device)

output = model.generate(

input_ids,

do_sample=True,

temperature=0.3,

min_p=0.15,

repetition_penalty=1.05,

max_new_tokens=2048,

)

print(tokenizer.decode(output[0], skip_special_tokens=False))

<|startoftext|><|im_start|>user

C. elegans とは何ですか?<|im_end|>

<|im_start|>assistant

**C. elegans(カエノルブス線虫)**は、線虫の一種で、科学研究、特に発生生物学、神経科学、老化研究などで広く使われるモデル生物です。学名は *Caenorhabditis elegans*。

### 主な特徴と特徴:

- **小さな体長**:約1mm程度の微小な線虫。

- **透明な体**:発生過程や細胞の動きが顕微鏡で直接観察可能。

- **単純な構造**:約1,000個の体細胞からなり、すべての細胞の発生と運命(細胞分化)が完全に解明されている。

- **短いライフサイクル**:約3日で成熟し、約3週間で一世代を完結。

- **遺伝子の解析が容易**:ゲノム配列が完全に解読されており、遺伝子操作が簡単。

- **定住性**:土壌中で細菌を餌として生活する。

### 研究での利用:

- **発生生物学**:受精卵から成体までの発生過程が詳細に解明されており、細胞分裂や分化のメカニズムのモデルとして重要。

- **神経科学**:神経系が302個のニューロンしか持たないにもかかわらず、行動や学習の研究に最適。

- **老化研究**:寿命や老化の分子メカニズムの研究で広く用いられる。

- **遺伝学・分子生物学**:RNA干渉(RNAi)やCRISPRなどの技術が効率的に適用可能。

### 意義:

C. elegansは、複雑な生命現象をシンプルな生物で研究できるため、基礎生命科学の発展に大きく貢献しています。2006年には、線虫を含むモデル生物のゲノム情報がヒトを含む他の生物と比較される「モデル生物ゲノムプロジェクト」の代表例となりました。

---

要約すると、**C. elegansは tiny yet powerfulな線虫で、生命の基本的な仕組みを解明するための強力な研究ツール**です。<|im_end|>

まどマギプロンプトも。

prompt = "魔法少女まどか☆マギカでは誰が一番かわいい?"

input_ids = tokenizer.apply_chat_template(

[{"role": "user", "content": prompt}],

add_generation_prompt=True,

return_tensors="pt",

tokenize=True,

).to(model.device)

output = model.generate(

input_ids,

do_sample=True,

temperature=0.3,

min_p=0.15,

repetition_penalty=1.05,

max_new_tokens=2048,

)

print(tokenizer.decode(output[0], skip_special_tokens=False))

<|startoftext|><|im_start|>user

魔法少女まどか☆マギカでは誰が一番かわいい?<|im_end|>

<|im_start|>assistant

「魔法少女まどか☆マギカ」では、キャラクターそれぞれに魅力があり、「かわいい」と感じるポイントは人それぞれですが、多くのファンから特に愛されるのは以下のようなキャラクターたちです:

- **まどか**:純粋で優しい性格、明るい笑顔、そして成長する姿に多くの人が共感し、かわいさを感じます。

- **うるまき まゆ**:明るく元気な性格と、時折見せる繊細な表情が愛されています。

- **花乃 まゆ**:おとなしくて内気な雰囲気が「癒やし」を感じさせ、親しみやすいかわいい一面があります。

- **百合子**:複雑な心の持ち主でありながら、どこか憧れの「魔法少女」としての側面も持ち、深みのあるかわいいキャラクターです。

結局のところ「一番かわいい」は主観によるものですが、多くの人が**まどか**や**まゆ**系のキャラクターを特にかわいく感じるのではないでしょうか。物語を通じて成長していく姿が、多くの人の心に響くからです。<|im_end|>