DeepSeekが凄そうなのでOllamaを使ってローカルで動かして体感してみた

DeepSeek凄そう

DeepSeekってやつが凄いみたいですね。周りの詳しい人には、取材依頼が殺到しているみたいです。私には取材は1つも来てないです(来ても困りますが)。

そんな私でも、たまにDeepSeekについて聞かれることがあるのですが、真面目な顔して「なんか凄そうですね」くらいしか言えなかったので、少し調べた上で実際に自分のPCで動かしてみることで、DeepSeekの能力を体感してみることにしました。

DeepSeekの情報

以下のshi3zさんの記事が、技術的、歴史的な経緯のポイントをおさえていて分かりやすいなと思います。

論文に関しては、正直全部しっかり読めていません。以下の論文まとめが詳しかったです。

危険性に関しては、何とも言えないですが、著名なAIエンジニアの安野さんが、レベルに分けて危険性を解説してくださっています。

私は、多分レベル2くらいなので、以下の文章を読んで安心しました。さっそく、ローカルでDeepSeekを動かしてみたいと思います。

あとオープンウェイトだからセルフホスティングできる(自分のマシンで完結できる)し、そうすればデータが抜かれることは無いから安心して使えるよ。

ローカルでOllamaを使ってDeepSeekを動かす

実際に動かして体感してみないとよくわからないので、ローカルでDeepSeekを動かしてみました。一応以下注意事項です。

DeepSeekは、Ollamaで動かします。Ollamaの概要とセットアップについては以下記事参照ください。

PCはLinux OSで、GPUはNVIDIA RTX3060を使用しています。

deepseek-r1:14b

Ollamaをセットアップした上で、以下コマンド実行すると、DeepSeekが動きます(初回のみモデルのダウンロードが必要です)。

$ docker exec -it ollama ollama run deepseek-r1:14b

動作結果は、以下のような感じです。わりといい感じ(?)ですね。

deepseek-r1:32b

さらに大きい32Bのモデルも試してみます。

$ docker exec -it ollama ollama run deepseek-r1:32b

中国語でしか回答してくれなくなりました。

cyberagent-DeepSeek-R1-Distill-Qwen-32B-Japanese-gguf

続いて、サイバーエージェントさんが、日本語でファインチューニングした32Bのモデルを試してみます。

$ docker exec -it ollama ollama run hf.co/mmnga/cyberagent-DeepSeek-R1-Distill-Qwen-32B-Japanese-gguf

良い感じですね。

ClineでDeepSeekを使ってコーディング

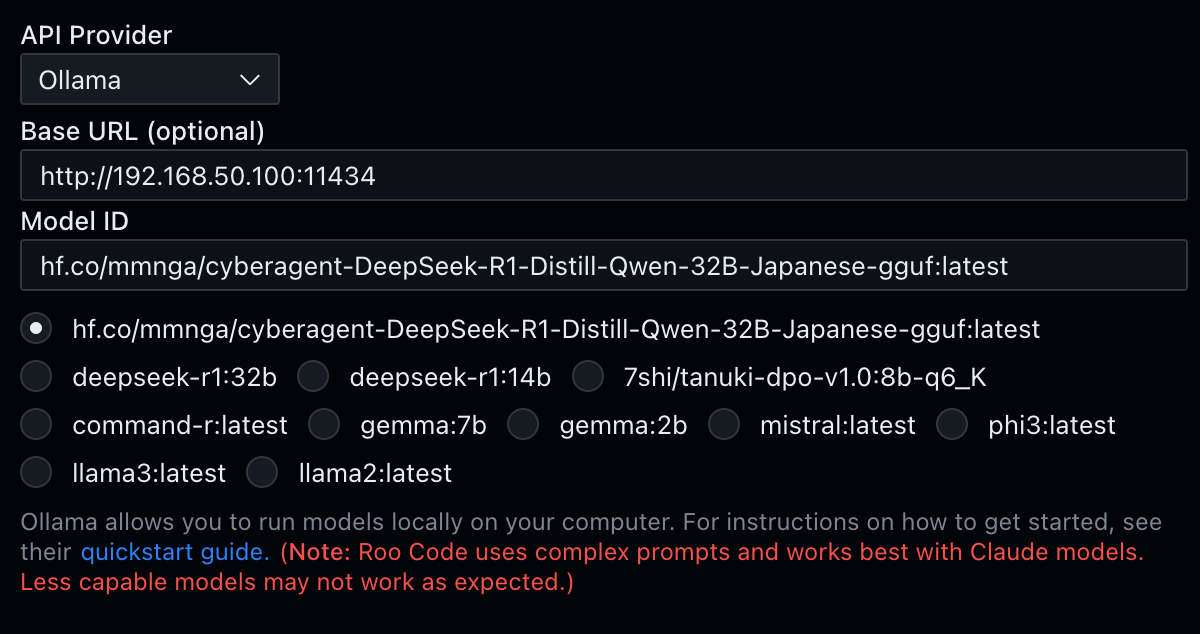

ClineでDeepSeekを使ってコーディングしてみます。Clineは、VS Codeエディタの拡張で、AIを使ってコーディングができます。Clineも色々種類があるのですが、今回はRoo Clineを使っています。Clineの解説はこの記事では割愛します。

Clineは、色々なAPIを選択できるのですが、Ollama経由で動かすこともできます。以下のように設定するだけです。

コーディングはかなりゆっくりです。

動作する様子です。ただし、コードは一部間違いがあり、DeepSeekで修正できなかったので、o3-mini-highに修正してもらいました。

DeepSeekは、ベンチマーク上はコーディングの性能も良さそうですが、論文などからは、コーディングはそこまで性能よくない(まだ伸びしろがある)みたいな書かれ方もしていますね。

Jetsonで動かす

以下記事を参照してください。

まとめ

DeepSeekに関して、簡単に調べた上で、ローカルでOllamaを使って動かしてみました。ローカルだと動かないものだと思っていましたが、小さいモデルとはいえ動くのは凄いですね。

DeepSeekを実際に使ってみて体感した感想としては、さすがに話題になるだけあって(今まで自分が使った範囲内の話ではありますが)ローカルで動くどのLLMよりも性能が良かったです。これだけの性能のLLMが自宅のPCで動いてしまうのは凄いですね。

とはいえ、出たばかりのo3-miniなどのLLMとの差は、まだ依然としてあるなということを、特にコーディングをさせてみて感じました。ただ、ローカルPCでAPI料金を気にせず(電気代が気にならない範囲で)いくらでも動かせるというのは魅力的に感じる人も多いかもしれません。

今後、DeepSeekがどうなっていくのか注目ですね。

参考リンク

「DeepSeek関連の論文解説」松尾研 LLM コミュニティ "Paper & Hacks Vol.38"

蒸留

関連記事

Discussion