スマホでローカルLLMを動かしたい

PocketPal AI というのがあるらしい

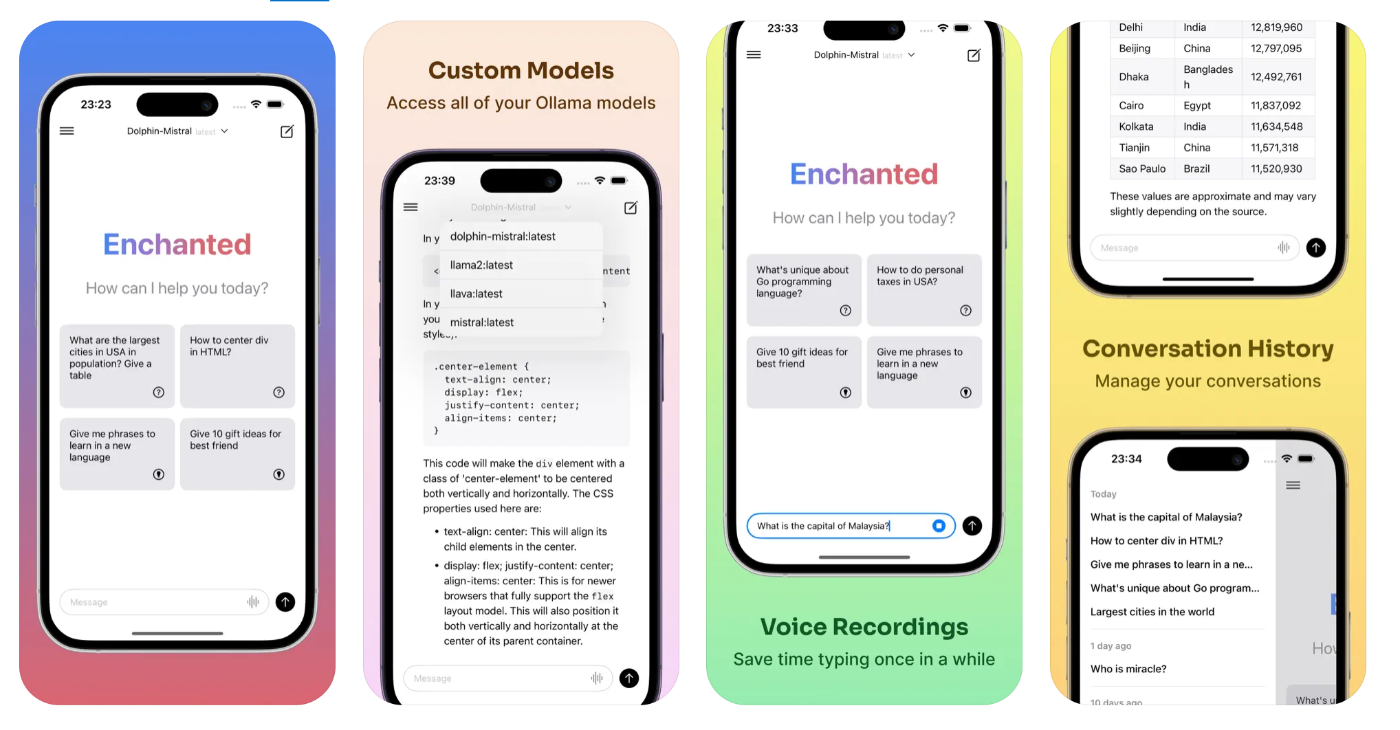

Enchanted LLM こういうのものあるらしい

日本語でiPhoneでローカルLLMを使うのにおすすめのモデル

iPhoneでローカルLLMを日本語で使用する場合、以下のモデルがおすすめです:

-

Llama-3-ELYZA-JP-8B-AWQ: Meta社のLlama-3をベースにELYZA社が日本語対応させたモデルです。量子化により一般的なノートPCでも動作可能な小さいサイズになっており、iPhoneでも使用できる可能性が高いです[3]。

-

Mistral 7B v0.1: 比較的小さなサイズで優秀なパフォーマンスを発揮します。Q3_K_S (3.16GB) やQ4_K_S (4.14GB) の量子化バージョンがiPhoneで動作することが確認されています[1]。

-

Calm 2 7B Chat: 日本語LLMとして知られており、Q3_K_S (3.47GB) やQ4_K_S (3.12GB) の量子化バージョンがiPhoneで使用可能です[1]。

-

Gemma-2-2b-jpn-it: Googleが開発したGemma2の日本語チューニング2Bモデルです。エントリークラスのGPUやモバイルGPUでも実用的な速度で動作します[5]。

これらのモデルを使用する際は、LLMFarmやOllamaなどのアプリケーションを通じてiPhoneにインストールできます[2][7]。ただし、モデルのサイズやiPhoneの性能によっては動作が制限される場合があるため、使用する端末のスペックを確認することをおすすめします。

Citations:

[1] https://zenn.dev/shu223/articles/localllm-ios

[2] https://note.com/izai/n/ncd3315f87534

[3] https://chatgpt-enterprise.jp/blog/local-llm-japanese/

[4] https://www.docswell.com/s/shu223/ZDE8XL-llm-ios

[5] https://note.com/catap_art3d/n/na046217a6246

[6] https://weel.co.jp/media/tech/openelm/

[7] https://qiita.com/kazu_ppp/items/beef492ef1df10eaef2d

[8] https://pc.watch.impress.co.jp/docs/column/nishikawa/1629215.html

[9] https://gigazine.net/news/20250131-sakana-ai-tinyswallow-taid/

[10] https://note.com/rrrrrrrrrr_666/n/n703f2cc721ee

Perplexity の Eliot より: pplx.ai/share

fullmoonをインストールしてみた。

モデルはdeepseek-r1 -distill-qwen-1.5b-8bit

あれ...モデル4個しかない?

Hugging Faceモデルは使えなさそうなので引退

次にPocketPal AIをダウンロード。

サインアップもアンケートもクレカ登録もない。いきなりモデルダウンロードw

標準で出てくるモデルは少ないが、Hugging Faceから好きなモデルをダウンロードできる。(これ重要

先日出た日本語に定評のあるsarashina2.2を使いたかったので、一番ダウンロード数が多かったsarashina2.2-3b-instruct-v0.1-Q8-0.gguf

を採用

ちょうはやい

ChathubからLM StudioとかのローカルLLM使いたい...という気持ち