Closed31

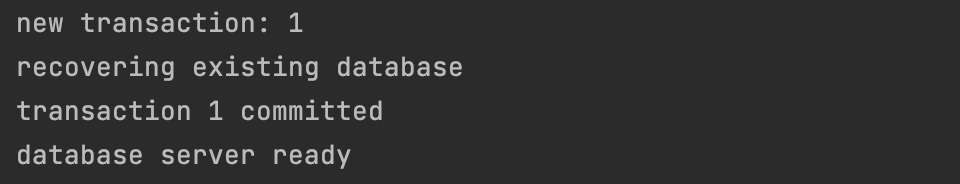

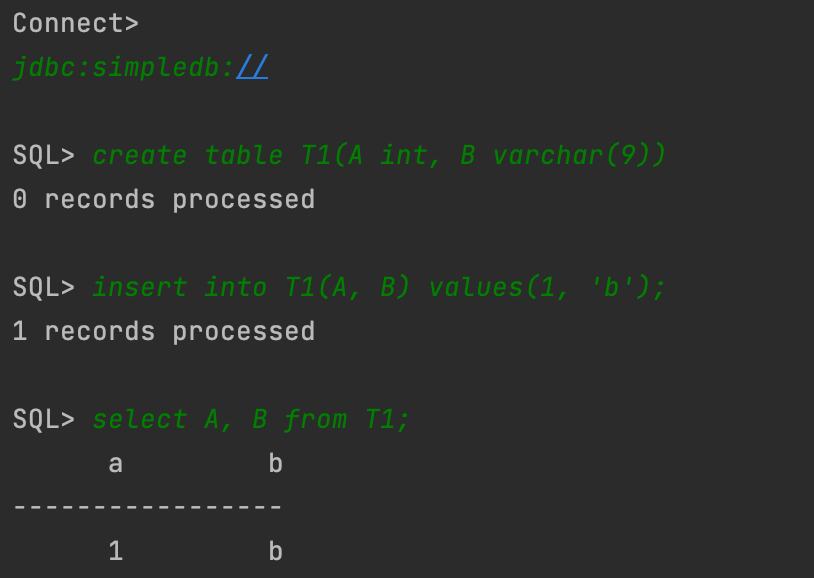

読書メモ: Database Design and Implementation

書籍

配布ソース

取り組み方

- 章ごとの要点をまとめる

- インターフェースとテストコードから実装をイメージする

- 実装を読み解いてコメントを書きながら写経する

-

Suggested Readingは気になる資料のリストアップまで

Exercises はどこまでやるか悩ましい。

割とボリューミーなので、1周目は読むだけに留めて、2周目で取り組むくらいの気持ちで。

全体に対するメモ

- 実装パートは事前に解説した内容まで踏み込まない

- Exerciseパートで、追加で取り組む課題として設定されてたりする

- 扱える値

- string, integer

- buffer replacement

- clock まで解説 & 実装はナイーブなもの

- recovery

- 記録する log の種類は、ファイル末尾への block の追加まで解説 & 実装するのは以下

- CHECKPOINT

- (transactionの) START, COMMIT, ROLLBACK

- SETINT, SETSTRING

- undo-redo まで解説 & 実装は undo-only

- nonquiescent chckpointing まで解説 & 実装は quiescent

- 記録する log の種類は、ファイル末尾への block の追加まで解説 & 実装するのは以下

- transaction

- 4 つの分離レベルやレベルごとの slock の利用方法について解説 & 実装は serializable

- deadlock 検出は解説のみ

- multiversion lock は解説のみ

- lock の粒度の解説 & 実装は block 単位のみ

- record 表現

- spanned/unspanned record を解説 & 実装は unspanned

- homogeneous/nonhomogeneous file を解説 & 実装は homogeneous

- fixed-length/variable-length field を解説 & 実装は fixed-length

- metadata

- 4種類の metadata を解説 & 実装

- table metadata

- view metadata

- index metadata

- statistical metadata

- query processing

- 関係代数はかなりライトに解説

- 演算子は select, project, product のみ

- 実装するのも上記の演算子のみ

- select のための predicate も実装

- 構造

- predicate

- terms

- expression

- constant

- フィールド、定数の等価比較まで

- 構造

- 関係代数はかなりライトに解説

- planning

- 基本的な計画作成プロセスのみ(最適な計画作成は最終章でカバー)

- 単純な SQL のサブセットをサポートするだけなので select, project, product のみを使用したクエリツリーで実装

- 計算、ソート、グループ化、入れ子、名前の変更は含まず

- indexing

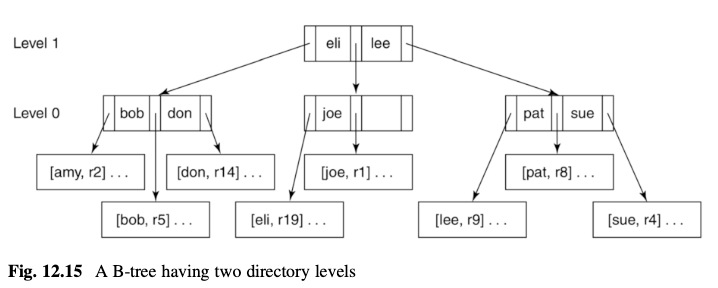

- static hashing, extendable hashing, B-trees を解説

- static hashing, B-trees を実装

- B-trees の実装は簡易的なもの

- merge は実装しない

- latch, lock は実装しない

- 実装済の block 単位の lock にて一貫性を担保?

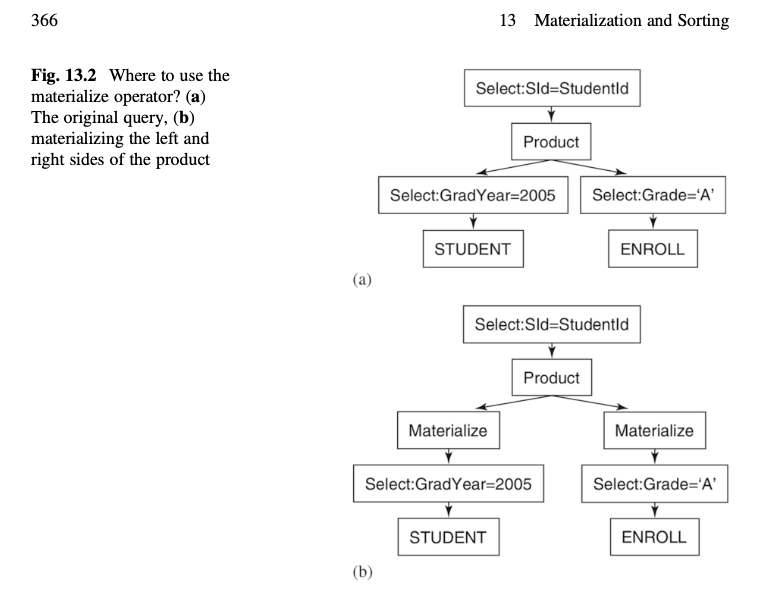

- materialization & sorting

- 一時テーブルを利用して sort, groupby, mergejoin を実装

- 一時テーブルの破棄タイミングは DB 起動時のみ

- sort は素朴な mergesort + α

- 解説では一度に merge する run の数を増やしたり、初期の run の数を減らすような改善を紹介しているが、実装はしない

- groupby の集計式は count, max のみ実装

- mergejoin は sort を利用して効率化 & 駆動表に join 値が重複する際の内部表の読み直しも想定

- 効果的なバッファ使用手法

- 関係演算子によって使用可能なバッファの割り当て方法を変えると、効率化できることを解説

- 例: merge sort は一度に複数の run を merge 出来ると良い(multibuffer sorting)

- SimpleDB では Multibuffer Product のみを実装

- バッファ数の割り当て方法としては、ルート計算、因子計算を実装

- multibuffer sort ではルートを利用(解説のみ)

- multibuffer product では因子を利用(実装まで)

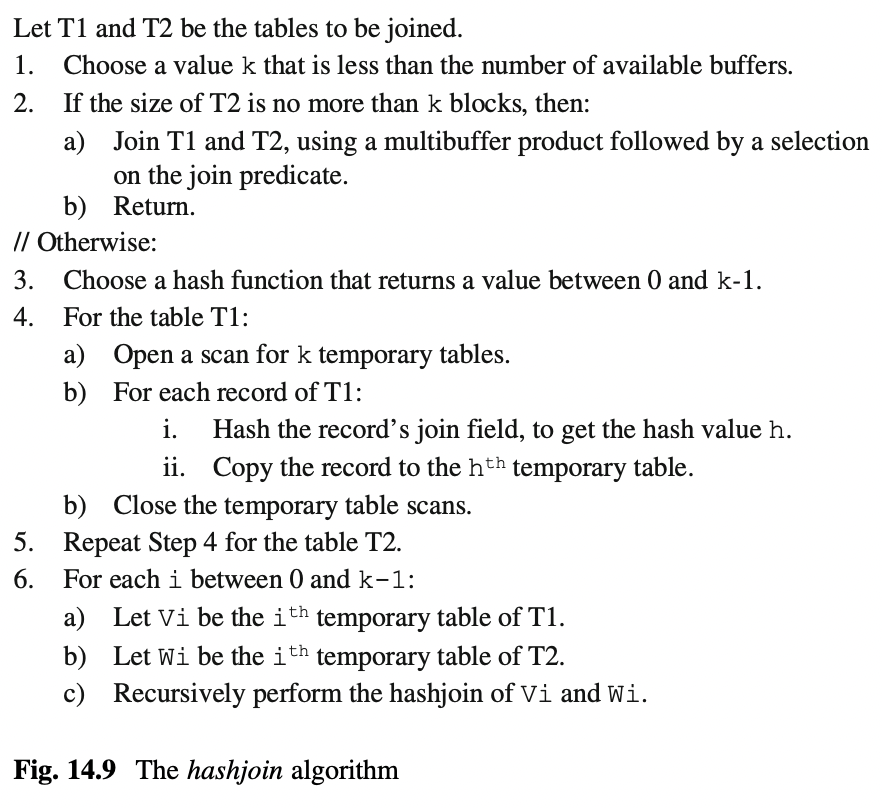

- join アルゴリズムの比較が面白かった

- mergejoin, hashjoin, indexjoin がユースケースによって、効率が変わることが説明されていた

- 関係演算子によって使用可能なバッファの割り当て方法を変えると、効率化できることを解説

- クエリ最適化

- 最適化のための個々の操作を解説

- products の並び替え

- select の分割

- select の移動

- select-product の join への変換

- projection の追加

- クエリ最適化のステップをヒューリスティクなものを中心に解説

- そのうち一部を使ったものを実装

- 最適化のための個々の操作を解説

Chapter 1: Database Systems

Database Systems の概要説明の章。

- Database に求められるもの

- Record Storage

- update / read を効率良くおこなえるような構造で記録

- Multi-user Access

- 複数ユーザーが同時に操作でき、かつ不整合な状態にならないようにする

- Dealing with Catastrophe

- クラッシュからリカバリー可能にする

- Memory Management

- disk/flash の操作は遅いのでメモリーへのキャッシュする

- Usability

- query language をサポートすることで usability を提供

- Record Storage

- Java-based な database system として Derby が参考になる

- 洗練されている代わりに複雑

- この本では Java でシンプルな実装の database system を実装していく

- ソースはここからダウンロード可能

- embedded, server-based のどちらもサポート

- query はかなり制限

- select: フィールド名称のリストのみ

- from: テーブル名称のリストのみ

- where: boolean オペレータと and のみ

- その他には、

*なし、null なし、join なし、union なし、insert は明示的な値のみ、update での set 対象は 1 つのみ

Chapter 2: JDBC

JDBC の説明が主なので省略。

Chapter 3: Disk and File Management - 要点

- Disk ドライブの説明

- 物理的な構造: Platters, Tracks, Spindle, Actuator などなど

- 回転スピード: 5,400 rpm - 15,000 rpm

- 転送速度: 100MB/s など(回転スピードと Track あたりのバイト数による)

- seek time: Actuator が Disk ヘッド を動かす時間(平均 5ms ほど)

- RAID の話

- Flash ドライブの説明

- Disk のブロックレベルのインターフェース

- 割り当て可能なブロックの記録方法のベーシックなストラテジー

- disk map

- ブロックに対応する bit の値で free/allocated を管理

- free list

- チャンクのチェーンの方式で管理

- チャンク: 連続した未割り当てのブロックかたまり

- チャンクの先頭ブロックに自身のチャンクの長さと、次のチャンクの位置が記録

- チャンクのチェーンの方式で管理

- disk map

- Disk のファイルレベルのインターフェース

- OS はファイルシステムと呼ばれる Disk への高レベルなインターフェースも提供

- Database エンジンを実装する際に上記のどちらを選ぶべきか?

- ブロックレベルを使うと

- Disk ブロックを完全にコントロールできる

- 例えば、よく使うブロックをシーク時間が短い位置に配置するなど

- OS の制限を超えるサイズや複数ディスクドライブにまたがるデータをサポートできる

- disadvantage もある

- 実装が複雑になる

- database 管理者もブロックアクセスパターンについての幅広い知識が要求される

- Disk ブロックを完全にコントロールできる

- ファイルシステムをフルに利用すると

- 実装が簡単だが、2 つの理由から受け入れがたい

- database システムはブロックの境界を把握できないとデータを効率良く扱えない

- OS の I/O バッファの管理方法はデータベースクエリに適してない

- 実装が簡単だが、2 つの理由から受け入れがたい

- 妥協案: データを OS ファイルに格納し、そのファイルを raw disk と同じように扱う

- 多くの database システムで採用されている

- Microsoft Access, Oracle, Derby, SimpleDB

- 多くの database システムで採用されている

- ブロックレベルを使うと

- 割り当て可能なブロックの記録方法のベーシックなストラテジー

Chapter 3: Disk and File Management - 実装

実装対象: BlockId, Page, FileMgr

BlockId

- ファイル名と論理的なブロックナンバーから特定のブロックを識別

BlockId blk = new BlockId("student.tbl", 23)

Page

- Disk ブロックの内容を保持

- Buffer Manager, Log Manager から使われるコンストラクタをそれぞれ用意

- ページ内の特定の位置に値を格納したりアクセスするための get/set メソッドを実装

- 例

getString,setString

- 例

- 3 つの値のタイプを保持可能とする

- int, string, blob

- クライアントは任意の場所に値を格納できるが、どこに何の値を格納したか把握しておく必要がある

-

setStringした場所に対してはgetStringで値を取得する必要あり

-

-

setString,getStringはそれぞれ内部でsetBytes,getBytesを呼び出し - setBytes は先頭にバイト配列の長さをセットしつつ、バイト配列自体もセット

private ByteBuffer bb; // Page のコンストラクタで生成

public void setBytes(int offset, byte[] b) {

bb.position(offset);

bb.putInt(b.length);

bb.put(b);

}

FileMgr

- OS ファイルシステムとのインタラクションをハンドリング

- database システムが扱うファイルを格納するディレクトリ名と、ブロックのサイズを保持

- database システム起動時に 1 つの FileMgr オブジェクトを生成して保持

- read, write は synchronized 指定

public synchronized void read(BlockId blk, Page p) {

try {

RandomAccessFile f = getFile(blk.fileName()); // ここで Map<String,RandomAccessFile> openFiles から該当の File を取得

f.seek(blk.number() * blocksize);

f.getChannel().read(p.contents());

} catch (IOException e) {

throw new RuntimeException("cannot read block " + blk); // e を握りつぶしている感

}

}

- synchronized 指定は内部的にオープン済の RandomAccessFile オブジェクトを Map にキャッシュしているため?

Chapter 4: Memory Management

- Two Principles of Database Memory Management

- Principle 1: Minimize Disk Accesses

- RAM は速い

- flash に比べて 1000 倍

- disk に比べて 100,000 倍

- Principle 2: Dont't Rely on Virtual Memory

- OS に Memory Management を委ねると 2 つの問題が発生する

- database engine のクラッシュリカバリー能力が損なわれる(可能性がある)

- ページ更新前にログレコードに書き込むべきだが、その前にページが swap out される可能性がある

- OS が間違った推測をして不必要なディスクアクセスが発生する可能性がある

- database engine がどのページを使っていて、どのページは気にしていないかを知るすべがないため

- database engine のクラッシュリカバリー能力が損なわれる(可能性がある)

- OS に Memory Management を委ねると 2 つの問題が発生する

- Principle 1: Minimize Disk Accesses

Managing Log Information

- database を変更するたびに、その変更を取り消す必要がある場合に備えてログレコードを記録

- Log Manager はログの中身は把握せず、ただログをファイルに書き出す役割

- 素朴に実装するとログを追加するたびに disk read/write が発生して非効率

- disk read は単に current のログのページを保持しておくだけで減らせる

- disk write は、ログのページがいっぱいになるまで遅延させることで減らせる

- が、それでは問題がある

- ログが書き込まれないと、database への変更も disk に書き込むことができないため、「ログのページがいっぱいになるまで」待つ必要があるのは問題

- ログに適したバッファ管理はもうひと工夫必要

- Chap.5 でも取り上げる話

- ログが書き込まれないと、database への変更も disk に書き込むことができないため、「ログのページがいっぱいになるまで」待つ必要があるのは問題

- が、それでは問題がある

Managing User Data

- ログレコードの使われ方は

well-understoodなので、Log Manager は細かくチューニングできる - 一方 JDBC アプリケーションからのアクセスは完全には予期できない

- The Buffer Manager

- バッファープールと呼ばれる固定的なページを保持

- バッファプールはコンピューターの物理メモリーに収める必要あり

- バッファープール内のページは

pinned、もしくはunpinned状態となる- pinned 状態である限りバッファプール内に保持

- クライアントがあるブロックに対応するページに pin する時

- すでにバッファプールに該当ページが存在したら pinned をインクリメント

- バッファプールに存在しない場合

- プールに空きがある、もしくは unpinned 状態のページがあればブロックからページに読み込みを行う

- reuse する対象のページを選択するための主要な Strategies は後述

- プールに空きがなく、unpinned 状態のページもない場合はクライアントを wait list に追加して unpinned 状態のページが出てくるまで待ってもらう

- プールに空きがある、もしくは unpinned 状態のページがあればブロックからページに読み込みを行う

- バッファープールと呼ばれる固定的なページを保持

- Buffer Replacement Strategies

- Buffer Manager はどのページが次にアクセスされるか予期できないが、できるだけ長い時間再度読み込む必要がないものを選択したい

- database のライフタイムを通じて常に使用されるページ(e.g. カタログファイル) などもある

- 主要な 4 つの戦略

- ナイーブ: シンプルにシーケンシャルに unpinned 状態のページを探す

- SimpleDB はこれを実装

- FIFO

- LRU: least recently used

- Clock: バッファプールをリング状にスキャン & スキャン開始場所は前回の置換した場所の後ろから

- ナイーブ: シンプルにシーケンシャルに unpinned 状態のページを探す

- Buffer Manager はどのページが次にアクセスされるか予期できないが、できるだけ長い時間再度読み込む必要がないものを選択したい

メモ

- ここで言うログは WAL と同一なのか?

- おそらく同一

- ↑にも記載があるように、Chap.5 で取り上げられていそうではある

- 参考資料

Chapter 4: Memory Management(Log) - 実装

実装対象: LogMgr, LogIterator

LogMgr

- append: ログレコードをページの先頭に向かって書き込み、そのログシーケンスナンバー(LSN)を返す

- 唯一の制限: ログレコードの配列がページに収まる必要あり

- synchronized 指定

- 追加するログがページに収まりきらない場合は、flush して次のブロックに移動

- ページの先頭に、最後に書き込んだログレコードの pos を記録

public synchronized int append(byte[] logrec) {

int boundary = logpage.getInt(0);

int recsize = logrec.length;

int bytesneeded = recsize + Integer.BYTES;

if (boundary - bytesneeded < Integer.BYTES){// It doesn't fit

flush(); // so move to the next block.

currentblk = appendNewBlock();

boundary = logpage.getInt(0);

}

int recpos = boundary - bytesneeded;

logpage.setBytes(recpos, logrec);

logpage.setInt(0, recpos); // the new boundary latestLSN += 1;

return latestLSN;

}

- flush: ログレコードを確実に disk に書き込む

- iterator: ログレコードを逆順に返す iterator を取得

- constructor

- ログファイルが存在しない場合は1つめのブロックを発行

- ログファイルが存在する場合は、一番最後のブロックを読み込み

LogIterator

- ブロック内のログレコードをブロックの先頭から読み込み

- ログレコードは後ろから先頭に向けて書き込まれるため、先頭から読み込むと書き込みと逆順となる

- ページに読み込んだブロックの先頭まで達したら、次のブロックに移動

Chapter 4: Memory Management(Buffer) - 実装

実装対象: Buffer, BufferMgr

Buffer

- ページを読み込み

- pin 数を保持

- 変更に関わる情報も保持

- トランザクション識別番号と、ページ変更時に生成されたログレコードの LSN を記録

- flush

- disk write を行って、バッファが割り当てられた disk ブロックと、バッファが保持するページの値を一致させる

- 先にページ変更時に生成されたログレコードを flush して disk に記録した上で実施

BufferMgr

- pin: 内部的に tryToPin を呼び出し

- tryToPin

- 2 つのパートがある

- findExistingBuffer: すでに該当のブロックにに割り当てられた buffer を探す

- chooseUnpinnedBuffer: ナイーブな方法で unpinned buffer を探す

- tryToPin が null を返した場合、pin メソッドは wait する

- unpin されたら notifyAll が呼び出される

- タイムアウトも設定

- 2 つのパートがある

- tryToPin

public synchronized Buffer pin(BlockId blk) {

try {

long timestamp = System.currentTimeMillis();

Buffer buff = tryToPin(blk);

while (buff == null && !waitingTooLong(timestamp)) {

wait(MAX_TIME);

buff = tryToPin(blk);

}

if (buff == null)

throw new BufferAbortException();

return buff;

} catch(InterruptedException e) {

throw new BufferAbortException();

}

}

public synchronized void unpin(Buffer buff) {

buff.unpin();

if (!buff.isPinned()) {

numAvailable++;

notifyAll();

}

}

Chapter 5: Transaction Management

- buffer manager は複数のクライアントが同じ buffer に並行アクセスすることを許容

- 結果はカオスになり得る

- concurrency manager

- トランザクションが一貫して動くように実行を制御

- recovery manager

- ログレコードを読み取り/書き込み

- コミットされていないトランザクションを必要に応じて取り消し可能にする

- ログレコードを読み取り/書き込み

Transactions

- 単一の操作として動作する操作のグループ

- ACID 特定によって特徴づけられる

- atomicity and durability

- commited, rollback 操作の適切な動作を記述

- recovery manager の責務

- consistency and isolation

- 並行アクセス時の適切な動作を記述

- conflict する操作を防ぐ

- 典型的な戦略は、conflict を検知したら一方のクライアントを wait させる

- concurrency manager の責務

Chapter 5: Transaction Management - Recovery Manager

- log record の書き込み

- transaction の rollback

- システムクラッシュ後の復旧

Log Records

- loggable activity が発生した際に log record を書き込み

- 基本的な 4 タイプのレコード

- start

- commit

- rollback

- update

- SimpleDB では integer, string の 2 種類に対応

- 潜在的な loggable activity はファイル末尾への block の追加

- transaction が rollback した際、追加された block の割り当て解除

- 簡単のため SimpleDB では対応しない

- record に含む情報

- record のタイプ

- START, SETINT, SETSTRING, COMMIT, ROLLBACK

- transaction の ID

- update の record のみ追加の 5 つの値

- 変更対象のファイルの名称

- ブロックナンバー

- 変更箇所の offset

- 変更箇所の old value

- 変更箇所の new value

- record のタイプ

- 複数の transaction が同時に log に書き込まれるため、log record は散在

Rolback

- 変更を元に戻すことで transaction を rollback

- update の record を追加した逆順で値を古い値に更新していく

Recovery

- リカバリは database engine 起動時に実行

- 目的は database を「合理的な状態」に復元すること

- 「合理的な状態」とは

- すべての未完了のトランザクションは rollback

- すべての commit 済みのトランザクションは変更が disk に書かれている

- 正常なシャットダウン後の起動時にはすでに合理的な状態になっている

- トランザクションの完了とバッファの flush が完了するまで wait するため

- 予期せずクラッシュした場合は処理が必要

- recovery manager はログファイルに記録された情報をもとにリカバリを実行

- コミット操作を完了する前に確実にログレコードをフラッシュする必要がある

- undo-redo algorithm

- undo

- すべてのログを逆順に読む

- committed, rollback のログであればそれぞれのリストに追加

- committed, rollback のリストに含まれないトランザクションの update ログであれば、指定の箇所に古い値を格納

- redo

- 全てのログを先頭から読む

- committed のリスト上のトランザクションの update ログであれば、指定の箇所に新しい値を格納

- undo

Undo-Only and Redo-Only Recovery

- undo もしくは redo のみを実行することでアルゴリズムをシンプルにできる

- undo のみのアルゴリズム

- commit record 書き込み前に disk に書き込むことを保証すれば redo は不要になる

- 良い点: リカバリはログファイルを 1 回読めば終わるので高速 & 更新レコードの new value は不要

- 悪い点: commit 操作は buffer flush を伴うので非常に遅くなる

- クラッシュ頻度が低い場合は、redo した方が効率良くなる

- redo のみのアルゴリズム

- commit されていない buffer が disk に書き込まれないのであれば undo は不要になる

- transaction が完了するまで buffer を pin 留め

- 良い点: リカバリは undo 処理がない分高速

- 悪い点: transaction が変更するブロックをすべて buffer に pin 留めするので buffer の競合を増加させる

Write-Ahead Logging

- リカバリ時に未完了の transaction の undo が必要 -> 未完了の transaction のすべての更新は log ファイル内に対応する log record を持つ必要がある

- 上記を満たす方法

- 更新 log record が書き込まれたらすぐに disk に flush

- が、非常に非効率的

- 未完了 transaction が page を更新した際にシステムクラッシュした場合の 4 パターン

- (a) page と log record が両方 disk に書き込まれた

- (b) page だけが disk に書き込まれた

- (c) log record だけが disk に書き込まれた

- (d) どちらも disk に書き込まれなかった

- ↑のうち (b) が問題となる

- database エンジンは buffer page を flush する際に更新 log record を flush することで回避

- Write Ahead Log と呼ばれる

- database エンジンは buffer page を flush する際に更新 log record を flush することで回避

Quiescent Checkpointing

- log ファイルには database に対する全ての変更の履歴が含まれる

- database ファイルよりも大きくなることもある

- リカバリ作業は労力が必要になるので、 log の一部だけを読み出す手法が考案された

- ある log について、それより前に commit されていない transaction が存在しなければ undo を停止できる

- 完了した transaction の buffer が disk に flush されていれば redo は停止できる

- quiescent checkpoint は log 内の目印として機能

- undo 時に checkpoint log に遭遇 -> redo はその log 以降のみ処理可能

- アルゴリズム

- Stop accepting new transactions.

- Wait for existing transaction to finish.

- Flush all modified buffers.

- Append a quiescent checkpoint record to the log and flush it to disk.

- Start accepting new transactions.

- quiescent checkpoint log record の書き込みに適したタイミングはシステム起動時のリカバリが終わり、新しい transaction が開始される前

Nonquiescent Checkpoiting

- quiescent checkpointing はシンプルで理解しやすい

- が、recovery manager が transaction の完了を待っている間 database が利用できないようにする必要がある

- 許容できないケースも多い

- quiescent(静的)な状態を必要としないアルゴリズムが開発された

- 許容できないケースも多い

- が、recovery manager が transaction の完了を待っている間 database が利用できないようにする必要がある

- アルゴリズム

- Let T1,...,Tk be the currently running transactions.

- Stop accepting new transactions.

- Flush all modified buffers

- Write the record <NQCKPT T1,...,Tk> into the log.

- Start accepting new transactions.

- 実行中のトランザクションを NQCKPT レコードに記録しておき、リカバリ時の undo をその場所で止めることができる

- NQCKPT ログに到達したら、そこに記録されているトランザクションの状況を確認

- 残っていたトランザクションの開始レコードの開始レコードより前のログは無視できる

Data item Granularity

- granularity(粒度)

- log record に含むデータ項目の大きさ

- ここまでの説明における granularity は変更された値だったが、他にも block またはファイル単位の選択肢もある

- block

- block が変更されるたびに更新 log record 作成

- block の以前の値、新しい値が log record に含まれる

- log record の数は少なくなるが、更新 log record が非常に大きくなってしまう

- ファイル

- 変更したファイルに対して 1 つの更新 log record を生成

- log record にはファイルの元の内容全体が含まれる

- 値がいくつ変更されても、ファイル全体のコピーを作成するため実用的ではない

- ワープロソフトなどは採用している

Chapter 5: Transaction Management - Recovery Manager 実装

実装対象: 各種 LogRecord, RecoveryMgr

LogRecords

- 各 log record は共通のインターフェースを実装

public interface LogRecord {

static final int CHECKPOINT = 0, START = 1, COMMIT = 2,

ROLLBACK = 3, SETINT = 4, SETSTRING = 5;

int op();

int txNumber();

void undo(int txnum);

// ...省略

}

- LogRecord を実装した SetStringRecord

- コンストラクタ: バイト配列から↑の6つの値を抽出

- writeToLog: SETSTRINGログレコードの6つの値をバイト配列にエンコードする静的メソッド

- undo: undo を実行する transaction を受け取り、対象の block を pin し、old value を書き込み、unpin する

- 呼び出し側が disk に flush する責務を持つ

public class SetStringRecord implements LogRecord {

private int txnum, offset;

private String val;

private BlockId blk;

public SetStringRecord(Page p) {

int tpos = Integer.BYTES;

txnum = p.getInt(tpos);

int fpos = tpos + Integer.BYTES;

String filename = p.getString(fpos);

int bpos = fpos + Page.maxLength(filename.length());

int blknum = p.getInt(bpos);

blk = new BlockId(filename, blknum);

int opos = bpos + Integer.BYTES;

offset = p.getInt(opos);

int vpos = opos + Integer.BYTES;

val = p.getString(vpos);

}

// ...省略

@Override

public void undo(Transaction tx) {

tx.pin(blk);

tx.setString(blk, offset, val, false); // don't log the undo!

tx.unpin(blk);

}

public static int writeToLog(LogMgr lm, int txnum, BlockId blk, int offset, String val) {

int tpos = Integer.BYTES;

int fpos = tpos + Integer.BYTES;

int bpos = fpos + Page.maxLength(blk.fileName().length());

int opos = bpos + Integer.BYTES;

int vpos = opos + Integer.BYTES;

int reclen = vpos + Page.maxLength(val.length());

byte[] rec = new byte[reclen];

Page p = new Page(rec);

p.setInt(0, SETSTRING);

p.setInt(tpos, txnum);

p.setString(fpos, blk.fileName());

p.setInt(bpos, blk.number());

p.setInt(opos, offset);

p.setString(vpos, val);

return lm.append(rec);

}

}

RecoveryMgr

- undo-only リカバリーを実装

- commit, rollback は log record 書き込み前に transaction の buffer を flush

- ここでいう log record は commit, rollback のタイプのもの

- 更新 log record はすでに記録されている

- ここでいう log record は commit, rollback のタイプのもの

- (private method) doRecover, doRollback

- ログレコードを後方からたどる

- 該当の transaction の log record を見つけるたびに、undo を呼び出し

- 停止条件

- doRecover: checkpoint log を読む or 終端に達する

- doRollback: 該当 transaction の start log を読んだ時

public class RecoveryMgr {

// ...省略

public void commit() {

bm.flushAll(txnum);

int lsn = CommitRecord.writeToLog(lm, txnum);

lm.flush(lsn);

}

public void rollback() {

doRollback();

bm.flushAll(txnum);

int lsn = RollbackRecord.writeToLog(lm, txnum);

lm.flush(lsn);

}

public void recover() {

doRecover();

bm.flushAll(txnum);

int lsn = CheckpointRecord.writeToLog(lm);

lm.flush(lsn);

}

// ...省略

private void doRollback() {

Iterator<byte[]> iter = lm.iterator();

while (iter.hasNext()) {

byte[] bytes = iter.next();

LogRecord rec = LogRecord.createLogRecord(bytes);

if (rec.txNumber() == txnum) {

if (rec.op() == LogRecord.START)

return;

rec.undo(tx);;

}

}

}

private void doRecover() {

Collection<Integer> finishedTxs = new ArrayList<Integer>();

Iterator<byte[]> iter = lm.iterator();

while (iter.hasNext()) {

byte[] bytes = iter.next();

LogRecord rec = LogRecord.createLogRecord(bytes);

if (rec.op() == LogRecord.CHECKPOINT)

return;

if (rec.op() == LogRecord.COMMIT || rec.op() == LogRecord.ROLLBACK)

finishedTxs.add(rec.txNumber());

else if (!finishedTxs.contains(rec.txNumber()))

rec.undo(tx);

}

}

}

Chapter 5: Transaction Management - Concurrency Manager

- Concurrency Manager は同時実行 transaction の正しい実行に責任を持つ

- このセクションでは

- 「実行が正しい」とはどういうことかを検討

- 正しさを保証するいくつかのアルゴリズムをとりあげる

Serializable Schedules

- transaction の履歴は database ファイルにアクセスするメソッド(get/set など)の呼び出しのシーケンス

- database 操作の粒度はさまざま

- 値単位

- block 単位

- その他もある(後述)

- 複数の transaction が同時実行されている場合

- database エンジンはそれらのスレッドの実行をインターリーブ

- SimpleDB では Java ランタイムが自動的におこなう

- transaction の履歴は予測不可能なインターリブになる

- -> スケジュールと呼ばれる

- database エンジンはそれらのスレッドの実行をインターリーブ

- concurrency control の目的は、正しいスケジュールだけが実行されることを保証

- 正しいとは?を以下で見ていく

- すべての transaction が直列に実行されるスケジュールを考えると

- インターリーブされない

- スケジュールは back-to-back 履歴となる

- このようなスケジュールは

serial scheduleと呼ばれる

- 同一の transaction であっても serial schedule が異なれば異なる結果になり得る

- 以下のような transaction を考える

- T1: W(b1); W(b2)

- T2: W(b1); W(b2)

- どちらも b1 block を書いた後に b2 block を書くため、block 単位の操作については同一の履歴を持つ

- ただ、transaction としては必ずしも同一ではない

- T1 はブロックの先頭に X を書き込み、T2 は Y と書き込む場合など

- T1, T2 の順番が変わると、結果が変わる

- どちらの serial schedule についても database エンジンは正しいものとして扱う

- ただ、transaction としては必ずしも同一ではない

- 以下のような transaction を考える

- non-serial schedule であっても、ある serial schedule と同じ結果を出す場合、

serializableという - non-serial schedule である以下のような transaction を考える

- W1(b1); W2(b1); W1(b2); W2(b2)

- T1 の前半、T2 の前半、T1 の後半、T2 の後半を実行した結果

- このスケジュールは T1 を実行し、T2 を実行することと等価なので

serializable

- W1(b1); W2(b1); W1(b2); W2(b2)

- 以下のようなnon-serial schedule の場合は

non-serializable- W1(b1); W2(b1); W2(b2); W1(b2)

- T1 の前半、T2 の前半、T2 の後半、T1 の後半

- b1 block には T2 の値が書き込まれるが、b2 block には T1 の値が書き込まれる

- W1(b1); W2(b1); W2(b2); W1(b2)

- ACID の isolation の性質

- 各トランザクションがあたかもシステムにおける唯一のトランザクションであるかのように実行されるべき

- non-serializable では↑の性質をもたないので、non-serializable なスケジュールは正しくない

- schedule は serializable である場合のみ「正しい」

The Lock Table

- database エンジンは全てのスケジュールが serializable を保証する責任がある

- 一般的なテクニック: locking を利用して transaction の実行を延期

- このセクションでは lock がどう機能するかを説明

- 各 block に対する lock

- 共有 lock(slock)

- 他の transaction は共有 lock を持つことはできる

- 排他 lock(xlock)

- 他の transaction はいかなる lock も持てない

- 共有 lock(slock)

- 1 つの transaction で 1 つの block に対して共有 lock と排他 lock を持つことはできる

The Lock Protocol

- すべてのスケジュールが serializable であることを保証する

- 以下の transaction を考える

- T1: R(b1); W(b2)

- T2: W(b1); W(b2)

- serial schedule が異なる結果になる原因

- 両方とも同じ b2 block に書き込むため、順序によって値が変わる

- 一般的に、実行順序によって異なる結果を生む可能性がある場合、「競合」する

- 読み書きの衝突もある

- T1 の R(b1) の実行が、T2 の W(b1) の先か後かで結果が変わる

- 両方とも同じ b2 block に書き込むため、順序によって値が変わる

- non-serial schedule で競合する操作が実行される順序は、同等の serial schedule がどうあるべきかを決定

- ↑の例では W2(b1) が R1(b1) より先に実行される場合、同等の serial schedule は T1 より先に T2 が実行されなければならない

- 衝突するすべての操作を考えると、T1 完了後に T2 実行、もしくは T2 完了後に T1 実行のどちらかとなる

- 衝突しない操作は任意の順序で発生させることができる

- lock プロトコル

- ある block を読む前に共有 lock を取得する

- ある block を変更する前に排他 lock を取得する

- commit or rollback 後に全ての lock を開放する

- ↑のプロトコルから 2 つの推論ができる

- ある transaction が block の共有 lock を取得した場合、他の transaction はその block に書き込んでいない

- ある transaction が block の排他 lock を取得した場合、他の transaction はその block にアクセスしていない

- つまり、ある transaction が実行した操作は、他のアクティブな transaction による以前の操作と衝突しないことを意味する

- 結果として、得られるスケジュールは常に serializable となる

- 等価な serial schedule は transaction のコミット順序によって決定される

- lock protocol システムの並行性を大幅に制限する

- transaction が完了するまで lock を保持するため

- 不要になった時点で lock を解放できれば、他の transaction の待ち時間は短くなる

- が、transaction 完了前に lock を解放すると 2 つの深刻な問題が起きる(後述)

Chapter 5: Transaction Management - Concurrency Manager Part2

(Chapter 5 が長いので分割)

Serializability Problems

- transaction が block の lock を解放すると、serializability への影響無しに別の block を lock できなくなる

- 以下の transaction T1 を考える

- T1: ...R(x); UL(x); SL(y); R(y);...

- R: read, UL: unlock, SL: shared lock

- T1: ...R(x); UL(x); SL(y); R(y);...

- x の unlock と y の共有 lock の間において T1 は非常に脆弱となる

- その間に T2 が割り込んで x, y に排他 lock をかけて書き込み、commit & unlock したとする

- T1 は T2 書き込み前の x を読んだので serial order は T2 より前に来る必要がある

- が、T1 はその後 T2 が書き込んだ y を読むので T1 は T2 より後に来なければならない

- 結果、スケジュールは non-serializable となる

- 逆に transaction が unlock する前に全ての lock を取得する場合のスケジュールは serializable となる

- 2 phase lock と呼ばれる

- lock を蓄積するフェーズと、lock を解放するフェーズがあるため

- 2 phase lock は database エンジンで簡単には利用できない

- 通常、最終 block にアクセスし終わる頃には transaction は commit する準備ができている

- (意味が取れてない)

- 通常、最終 block にアクセスし終わる頃には transaction は commit する準備ができている

Reading Uncommitted Data

- lock を早期に解放することのもう一つの問題は、transaction が commit されてないデータを読み取れてしまうこと

- 以下の部分的なスケジュールを考える

- ...W1(b); UL1(b); SL2(b); R2(b);

- T1 が b block に書き込み & unlock、T2 が b block を共有 lock して読み込み、をしたとする

- T1 が rollback すると、 T2 は存在しない変更に基づいた読み込みをしているため rollback が必要になる

- -> rollback の連鎖が起きる(カスケードロールバック)

- transaction に commit されていないデータの読み取りを許可すると

- より多くの同時実行を可能にする

- が、データを書き込んだ transaction が commit されないリスクを負う

- ほとんどの商用 DB は transaction 完了するまで常に排他 lock 解放を待つ

Deadlock

- lock protocol は全ての transaction が commit されることを保証しているわけではない

- 保証するのは、スケジュールが serializable となること

- 特に、deadlock になる可能性がある

- 以下の transaction の履歴を考える

- T1: W(b1); W(b2)

- T2: W(b2); W(b1)

- T1 が先行している状態で、T1 が b2 の lock 取得前に T2 が b2 の lock を取得すると deadlock となる

- concurrency manager は waits-for グラフを保持することで deadlock を検出

- 各 transaction に 1 つのノードを持つ

- T1 が T2 の持つ lock を待っている場合、T1 から T2 へのエッジを持つ

- 各エッジには transaction が待っている block のラベルが貼られる

- lock が要求、または解放されるたびにグラフは更新

- waits-for グラフがサイクルを持つする場合 deadlock が発生

- transaction manager は deadlock を検出するとサイクル内の transaction を 1 つ選択して rollback

- サイクル発生の原因となった lock を要求した transaction を選択

- 選択する戦略は他にもある

- サイクル発生の原因となった lock を要求した transaction を選択

- lock 待ちのスレッドだけでなく buffer 待ちのスレッドも考慮すると、deadlock は複雑になる

- 以下のシナリオを考える

- T1: xlock(b1); pin(b4)

- T2: pin(b2); pin(b3); xlock(b1)

- T1 が b1 の lock を取得したのちに中断し、その間に T2 が b2, b3 を pin し b1 の lock 取得待ちに入る場合

- T1 が b4 の buffer 取得待ちに入り、他に unpin されることがなければ deadlock

- lock manager は waits-for グラフを保持するだけでなく、transaction の buffer 待ちも考慮するのはかなり困難

- waits-for グラフ使用の問題点

- グラフの維持がやや困難

- サイクル検出に時間がかかる

- deadlock 検出を近似的におこなう、より単純な戦略もある

- 常に deadlock を検出 & deadlock ではない状況も deadlock 判定されることがあるもの

- wait-die

- T1 の lock 要求が T2 が保持する lock と競合した時を考える

- T1 が T2 よりも古い transaction であれば wait する

- そうでなければ rollback する

- use time limit

- T1 の lock 要求が T2 が保持する lock と競合した時を考える

- T1 は lock 取得待ちをする

- wait list 上に一定時間以上いたら rollback される

File-Level Conflicts and Phantoms

- これまで block の読み書きに起因する競合を見てみた

- ファイルの終端マーカーの読み書きをする size, append メソッドの衝突もある

- 以下の transaction を考える

- T1: ...; append; ...

- T2: ...; size; ...

- T1 が T2 の size 呼び出し前に append を呼び出すとすると、serial order 上 T1 は T2 より前に来る必要がある

- phantom 問題: ↑の衝突の結果の 1 つ

- T2 がファイルの全内容を繰り返し読み、その度に size を呼び出す場合

- T2 が size を呼び出した後、T1 が append した場合、T2 が次にファイルを読み込むとき、T2 は追加された値を見ることになる

- ACID の分離の性質に違反

- 解決策

- end-of-file マーカーを lock 可能にする

- append するためには xlock、size を呼び出すためには slock を実施

- end-of-file マーカーを lock 可能にする

Multiversion Locking

- 待ち時間を減らすための戦略

- 読み取りと更新 transaction は先にロックを取得した transaction が完了するまで、もう一方は待たされる

The Principle of Multiversion Locking

- 各 block に複数のバージョンを保存

- 基本的なアイデアは以下

- block の各バージョンにはそれを書き込んだ transaction の commit 時刻のタイムスタンプが付けられる

- 読み取り専用の transaction が block から値を要求すると concurrency manager は transaction の開始時に最も最近 commit された block のバージョンを使用する

- 読み取り専用 transaction は transaction の開始時に見えたであろう commit された block のバージョンを使用

- 読み取り専用 transaction は commit されたデータのスナップショットを見ることになる

- それ以降の transaction によって書き込まれたデータを見ることはない

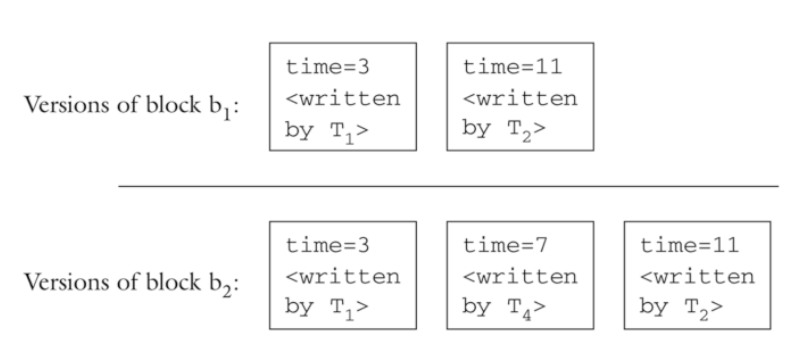

- 次の multiversion lock の例を考える

- T1: W(b1); W(b2)

- T2: W(b1); W(b2)

- T3: R(b1); R(b2)

- T4: W(b2)

- スケジュール

- W1(b1); W1(b2); C1; W2(b1); R3(b1); W4(b2); C4; R3(b2); C3; W2(b1); C2

- Ci: commit タイミングで、i は transaction の番号に対応

- 更新 transaction である T1, T2, T4 は lock protocol に従う

- それぞれの transaction ごとに block のバージョンが保存される

- time は transaction が commit した時間

- 読み取り専用 transaction である T3 は lock protocol に従わない

- R3(b1) で読み取られるのは直前に commit されている T1 が書き込んだ値

- R3(b2) は T4 の transaction が commit された後にスケジュールされているが time=7 のバージョンは表示されない

- multiversion lock の優れた点

- 読み取り専用の transaction が lock を取得する必要がなく、待つ必要がない

- 更新する transaction が比較的少ないと仮定すると、待機の頻度はかなり低くなる

5.4.6.2 Implementing Multiversion Locking

- 各 block のバージョンをどのように管理するか

- バージョンファイルを明示的に保存する方法

- シンプルだけどやや難しい方法

- ログを使用して block の任意の望ましいバージョンを再構築する方法

- バージョンファイルを明示的に保存する方法

- ログを使用して再構築する方法の実装

- 読み取り専用 transaction 開始時にタイムスタンプを付与

- 更新トランザクションは commit する時にタイムスタンプを付与

- commit 方法は以下

- recovery manager は commit log record の一部として transaction のタイムスタンプを書き込む

- transaction が保持する各 xlock について、concurrency manager が block をピン留めし、タイムスタンプを block の先頭に書き込み、buffer を unpin する

- 適切なバージョン再構築のステップ

- block の現在のバージョンを新しいページをコピーする

- 次のように log を3回逆向きに読む

- 読み取り transaction が持つタイムスタンプ t の後に commit された transaction のリストを構築

- t よりも小さいタイムスタンプの commit record まで達したら log 読み込みをストップ

- 未完了の transaction リストを構築

- commit or rollback record がないものは未完了の transaction

- quiescent checkpoint の場合: checkpoint record に達した時点で log 読み込みをストップ

- nonquiescent checkpoint の場合: checkpoint record に含まれる transaction の最も古い開始 record に達した時点で log 読み込みをストップ

- 上記のリストのいずれかにある transaction による更新を巻き戻す

- 更新を巻き戻した block の情報を返す

- 読み取り transaction が持つタイムスタンプ t の後に commit された transaction のリストを構築

- 読み取り専用 transaction は JDBC においては

setReadOnlyというメソッドで指定

Transaction Isolation Levels

- serializabitily を強制することはかなりの待ち時間を発生させる

- multiversion lock は読み取り専用 transaction においては待ち時間が無く魅力的

- 実装はやや複雑

- version を作成するために追加のディスクアクセスが必要

- 更新 transaction には適用できない

- 待ち時間を短縮する方法: 完全な serializability を目指さない

- transaction 分離レベルと共有 lock の使用方法のまとめ

- serializable

- problems: none

- lock usage

- transaction 完了まで共有 lock を保持

- EOF マーカーに対しても共有 lock 取得

- repeatable read

- problems: phantoms

- lock usage

- transaction 完了まで共有 lock を保持

- EOF マーカーに対しては共有 lock はとらない

- read committed

- problems: phantoms, 値が変わりうる

- lock usage

- 共有 lock を早めに解放

- EOF マーカーに対しては共有 lock はとらない

- read uncommitted

- problems: phantoms, 値が変わりうる, ダーティリード

- lock usage

- 共有 lock をとらない

- serializable

- ↑のどの分離レベルでもデータの書き込みに関しては正しく振る舞うべき

- 適切な排他 lock(EOF マーカー含む)を取得し、完了するまで保持

- read uncomitted isolation と multiversion locking の比較

- どちらも読み取り専用の transaction に適用 & lock 無しで動作

- read uncommitted は各 block の現在の値を見れてしまう

- serializable とは程遠い

- multiversion locking は transaction 開始時点で commit されていた値を見るので serializable

Data Item Granularity

- ここまで block 単位で lock することを想定してきたが、他の粒度も可能

- 粒度(=concurrency data item と呼ばれる)

- 値

- ファイル

- database 全体

- concurrency control の原則は粒度に影響されない

- 定義、プロトコル、アルゴリズムはどの粒度にも適用される

- 粒度の選択は実用性をもとに判断

- 粒度選択におけるトレードオフ

- 粒度のサイズを小さい場合

- より多くの同時実行が可能になる

- より多くの lock が必要となる

- 粒度のサイズを大きい場合

- 同時実行性が悪化する

- より少ない lock で扱える

- -> 結果、block 粒度は妥当な選択といえる

- 粒度のサイズを小さい場合

- データレコードの粒度を扱える database もある

- 魅力的だが phantom に関する新たな問題が発生する

- 新しいデータレコードは既存の block に挿入される場合 phantom リードが起こる

- 解決策は block やファイルレベルの粒度もサポート

- 魅力的だが phantom に関する新たな問題が発生する

Chapter 5: Transaction Management - Concurrency Manager 実装

実装対象: LockTable, ConcurrencyMgr

ConcurrencyMgr

- 各 transaction が CocurrencyMgr を持つ

- 各 ConcurrencyMgr は同じ LockTable を使用する必要がある

- CocurrencyMgr はその transaction が保持する lock を追跡

- sLock メソッド

- transaction がすでにblock を lock していたら何もしない

- ロックしていない場合 LockTable の sLock メソッドを呼び出し

- 許可されるのを待つ

public void sLock(BlockId blk) {

if (locks.get(blk) == null) {

locktbl.sLock(blk);

locks.put(blk, "S");

}

}

- xLock メソッド

- すでに block に対する xLock を保持している場合は何もしない

- まず sLock を呼び出して、ロックが許可されるのを待つ

- LockTable の xLock メソッドは transaction が block に対する slock を持っていることを仮定

public void xLock(BlockId blk) {

if (!hasXLock(blk)) {

sLock(blk);

locktbl.xLock(blk);

locks.put(blk, "X");

}

}

LockTable

- locks

- 現在 lock が割り当てられている各 block のエントリーを含む

- エントリ: 排他 lock では -1, 正の値は共有 lock 数

- 現在 lock が割り当てられている各 block のエントリーを含む

- sLock メソッド

- BufferMgr の pin メソッドと似た動作

- xlock がある場合は待ち続ける

- xlock がない場合は locks の該当 block の値をインクリメント

private final Map<BlockId, Integer> locks = new HashMap<>();

public synchronized void sLock(BlockId blk) {

try {

long timestamp = System.currentTimeMillis();

while (hasXlock(blk) && !waitingTooLong(timestamp))

wait(MAX_TIME);

if (hasXlock(blk))

throw new LockAbortException();

int val = getLockVal(blk); // will not be negative

locks.put(blk, val + 1);

} catch (InterruptedException e) {

throw new LockAbortException();

}

}

- xLock メソッド

- BufferMgr の pin メソッドと似た動作

- 該当 block に 2 つ以上の slock がかかっている場合 while ループで待つ

-

hasOtherSLocksはlocks の値 > 1を返す - ConcurrencyMgr は xlock 要求前に slock を取得するため該当 block に対する slock 数は少なくとも 1 ある

-

- 他の transaction の slock がなければ

locksの該当 block の値を-1に上書き - なぜこのような実装になっているか?

- -> ある block に対して複数の transaction が xlock を取ろうとした場合の制御のため。

- slock は xlock がない場合のみ取得できるので xlock を取る際も事前に slock を取っている

- -> ある block に対して複数の transaction が xlock を取ろうとした場合の制御のため。

public synchronized void xLock(BlockId blk) {

try {

long timestamp = System.currentTimeMillis();

while (hasOtherSLocks(blk) && !waitingTooLong(timestamp))

wait(MAX_TIME);

if (hasOtherSLocks(blk))

throw new LockAbortException();

locks.put(blk, -1);

} catch (InterruptedException e) {

throw new LockAbortException();

}

}

- unlock メソッド

- 指定された lock をコレクションから削除 or decrement

- コレクションから削除された場合、待機中のスレッドに通知

Chapter 5: Transaction Management - Transaction 実装

実装対象: Transaction, BufferList

Transaction

- BufferList を使用して pin 留めした buffer を管理

- 各 Transaction オブジェクトはそれぞれ recovery manager と concurrency manager を生成

- commit, rollback メソッド

- 残りの buffer を unpin

- recovery manager を呼び出して commit/rollback

- concurrency manager を呼び出して lock を解放

public void commit() {

recoveryMgr.commit();

concurMgr.release();

mybuffers.unpinAll();

System.out.println("transaction " + txnum + " committed");

}

public void rollback() {

recoveryMgr.rollback();

concurMgr.release();

mybuffers.unpinAll();

System.out.println("transaction " + txnum + " roll back");

}

- getInt, getString メソッド

- 指定された block の slock を取得

- buffer から値を返す

public int getInt(BlockId blk, int offset) {

concurMgr.sLock(blk);

Buffer buff = mybuffers.getBuffer(blk);

return buff.contents().getInt(offset);

}

public String getString(BlockId blk, int offset) {

concurMgr.sLock(blk);

Buffer buff = mybuffers.getBuffer(blk);

return buff.contents().getString(offset);

}

- setInt, setString メソッド

- concurrencyMgr から xlock 取得

- log record 作成 & lsn 取得

- buffer の setModified に lsn を記録

public void setInt(BlockId blk, int offset, int val, boolean okToLog) {

concurMgr.xLock(blk);

Buffer buff = mybuffers.getBuffer(blk);

int lsn = -1;

if (okToLog)

lsn = recoveryMgr.setInt(buff, offset, val);

Page p = buff.contents();

p.setInt(offset, val);

buff.setModified(txnum, lsn);

}

public void setString(BlockId blk, int offset, String val, boolean okToLog) {

concurMgr.xLock(blk);

Buffer buff = mybuffers.getBuffer(blk);

int lsn = -1;

if (okToLog)

lsn = recoveryMgr.setString(buff, offset, val);

Page p = buff.contents();

p.setString(offset, val);

buff.setModified(txnum, lsn);

}

- size, append メソッド

- EOF マーカーを block number -1 として扱う

- size は↑の block の slock を取得し block 数を返す

- append は ↑の block の xlock を取得し block を追加する

public int size(String filename) {

BlockId dummyblk = new BlockId(filename, END_OF_FILE);

concurMgr.sLock(dummyblk);

return fm.length(filename);

}

public BlockId append(String filename) {

BlockId dummyblk = new BlockId(filename, END_OF_FILE);

concurMgr.xLock(dummyblk);

return fm.append(filename);

}

BufferList

- ある transaction に対して pin 留めされている buffer のリストを管理

- block の buffer 割り当てや pin 留め数を管理

Chapter 6: Record Management

- record manager は block 内の値の配置に責務を持つ

Record Manager の設計

- 以下のような問題に対処する必要がある

- 各レコードは 1 つの block 内に配置する必要があるか

- block 内のレコードはすべて同じテーブルのものか

- 各フィールドはあらかじめ決められたバイト数で表現できるか

- 各フィールドの値はそのレコードのどこに配置すべきか

- 問題点の詳細とトレードオフは後述

Spanned or Unspanned Records

- spanned record: 値が 2 つ以上の block にまたがる record

- unspanned だと

- disk スペースを浪費

- 例: block の 51 % の容量の record を連続して配置すると 49 % 分 が使われない状態になる

- block より大きなサイズの record は記録できない

- spanned だと

- record へのアクセスが複雑になる

- メモリ上での record の再構築も必要

Homogeneous or Nonhomogeneous Files

- homogeneous file: ファイル内の全ての record が同じテーブルのもの

- homogeneous だと

- 単一テーブルに対するクエリは簡単に返せる

- 複数テーブルに対するクエリは効率が悪くなる

- nonhomogeneous file: 同じファイル内にクラスタリングしたレコードを一緒に格納

- nonhomogeneous だと

- クラスタリングされたテーブルを結合するクエリの効率が向上

- 単一テーブルのクエリの効率は低下

- 各テーブルのレコードがより多くのブロックに分散するため

- 単一テーブルのクエリの効率は低下

Fixed-Length Versus Variable-Length Fields

- ほとんどの型は固定長

- 整数、浮動小数点、日付/時刻型、...

- 可変長の表現は複雑

- フィールドの変更時にレコードの大きさが変わると再配置が必要となることもある

- 文字列の3つの表現

- a: 可変長表現

- 文字列が必要とする正確な量のスペースをレコードに割り当て

- b: 固定長表現1

- 文字列をレコードの外部の場所に格納し、レコード内には固定長の参照を保持

- c: 固定長表現2

- 各文字列に対して、長さに関係なく同じ量のスペースを割り当て

- スペースが無駄になりがち

- 上記の表現は SQL 標準の char, varchar, clob に対応

- char: c

- varchar: a

- clob: b

Placing Fields in Records

- 固定長のレコードの場合、最も簡単な位置決め方法: 隣り合わせに格納

- レコードのサイズは各フィールドのサイズの合計

- オフセットは前のフィールドの終端

- 大抵のコンピューターでは整数はメモリ上の4の倍数の位置にある必要がある

- record manager は全ての整数が 4 バイト境界にアラインされていることを確認

- 前のフィールドが 4 の倍数でない場所で終わっている場合パディングする

- 型が異なると必要とするパディングも変わることもある

- 倍精度浮動小数点数は 8 バイト境界にアライン

- 例:

create table T (A smallint, B double precision, C smallint, D int, E int)- B は倍精度浮動小数点数なので A は 6 バイトパディングをして B の開始位置を 8 の倍数に合わせる必要がある

- D は整数なので C は 2 バイトパディングして D の開始位置を 4 の倍数に合わせる必要がある

- -> 合計 28 バイト必要

- パディングが最小になるようにフィールドを並び替える方法もある

- ↑の例だと [B, D, A, C, E] の順で格納すればパディングは不要となる

- -> 合計 20 バイト必要

- フィールドだけでなくレコードのパディングもおこなう

- [A, B, C, D, E] の順で格納する場合、2 レコード目の開始位置は 28 バイト目となるが、2 レコード目の B の開始位置が 36 (=28 + 8) バイト目となり、倍精度浮動小数点の 8 バイト境界に違反

- 1 レコードが 28 バイトの場合、レコードとしては 4 バイトのパディングが必要となる

- Java ではバイト配列内の数値に直接アクセスできないので考慮不要

-

ByteBuffer.getIntは整数取得の機械語は使わないので(非効率だが)アライメント問題を回避できる

レコードファイルの実装についての考察

- 設計上の決定が実装にどのような影響を及ぼすかを考える

A Straightforward Implementation

- homogeneous, unspanned, fixed-length なファイルを作る

- unspanned

- ファイルを block のシーケンスとして扱うことができる

- 各 block はそれ自身のレコードを含んでいる

- homogeneous & fixed-length

- block 内の各レコードに同じ量のスペースを割り当てることができる

- 各 block はレコードの配列として扱うことができる

- -> SimpleDB ではこのような block を record page と呼ぶ

- block 内の各レコードに同じ量のスペースを割り当てることができる

- unspanned

- record page の実装

- block を slot に分割

- slot はレコード + 1 バイトを保持

- 上記の 1 バイトは slot が空か使用中かを示すフラグ

- 0: 空, 1: 使用中

- 例: block サイズが 400, レコードサイズが 26 の場合

- 各 slock は 27 バイトで、block には 14 個の slock があり、22 バイトの無駄なスペースがある

- 上記の 1 バイトは slot が空か使用中かを示すフラグ

- record page 内のレコードを insert, delete, modify するにはレコードに関する以下の情報が必要

- slock のサイズ

- レコードの各フィールドの name, type, length, offset

- -> これらを「レイアウト」と呼ぶ

- レイアウトが与えられれば page 内の各値の位置を決定できる

- 新しいレコードを挿入

- slock の空フラグを探して、使用中に変更

- すべてのフラグが使用中であれば挿入は不可能

- slock の空フラグを探して、使用中に変更

- レコードの削除

- フラグを空に変更

- レコードの値の変更

- 対象のフィールドの場所を特定し、その場所に値を書き込む

- レコードの取り出し

- 使用中フラグを探す

- レコードの識別

-

record pageの場合は slot 番号で識別可能

-

- 新しいレコードを挿入

Implementing Variable-Length Fields

- variable-length フィールドを導入

- 問題1: レコード内のフィールドの offset が固定ではなくなる

- 特に variable-length フィールドに続くすべてのフィールドの offset はレコードごとに異なる

- offset を決定するには、前のフィールドを読み、どこで終わるかを確認する必要がある

- 各レコードの先頭に fixed-length フィールド、末尾に variable-length フィールドを配置すると効率よくアクセスできる

- 問題2: フィールドの値を変更するとレコードの長さが変わる

- 新しい値が大きい場合、変更された値の後ろの block の内容をシフトする必要がある

- 極端なケースではシフトされたレコードが block から溢れる

- overflow block を確保することで対処する

- overflow block は複数になることもある

- 問題3: レコードの識別子に slot 番号を使用できない

- そもそも slot 番号が分かっていても variable-length なので

slot サイズ * slot 番号をしても slot の offset は計算できない- 先頭からレコードを読み込む必要あり

- variable-length なのでレコード削除後に slot のスペースが再利用できない状態(断片化)になる可能性があり、デフラグすると slot 番号が変わってしまう

- 解決方法は ID テーブルを使って ID と slot の位置を管理

- block 内の配置

- block の一方の端に ID テーブル、もう一方の端にレコードを置く

- 互いに向かいあって成長

- block の一方の端に ID テーブル、もう一方の端にレコードを置く

- そもそも slot 番号が分かっていても variable-length なので

Implementing Spanned Records

- unspanned なレコードであれば各 block の最初のレコードは同じ位置から始まる

- spanned なレコードでは状況が違う

- 各 block の先頭に整数を格納して、最初のレコードの offset を保持

- spanned レコードの分割方法 2 パターン

- block を可能な限り埋めて block 境界で分割し、残りのバイトをファイルの次の block に配置

- こちらはスペースを無駄にしないが、block 間で値が分割されるので 2 つの block を連携して値を再構築する必要あり

- レコードを値ごとに書き込み、ページが一杯になったら新しいページに書き込む

- block を可能な限り埋めて block 境界で分割し、残りのバイトをファイルの次の block に配置

Implementing Nonhomogeneous Records

- nonhomogeneous レコードをサポートする場合、variable-length レコードもサポートする必要がある

- 異なるテーブルのレコードはサイズも異なる可能性があるため

- 2 つの問題がある

- block 内の各レコードのレイアウトを知る必要がある

- 各レコードがどのテーブル由来のものであるかを知る必要がある

- 上記の 1 つ目の問題はレイアウトの配列を保持することで対処

- 2 つ目の問題は各レコードの先頭に

タグ値と呼ばれる値を追加することで対処- タグ値: レイアウト配列のインデックス

Chapter 6 Record Management: Record Pages 実装

実装対象: Schema, Layout, RecordPage

Schema

-

[fieldname, type, length]の triple のリストを保持 - フィールド追加や取得のメソッドを実装

Layout

- レコードに関する物理的な情報も含む

- フィールド, slot サイズ, フィールド offset を計算

- コンストラクタは 2 つ

- テーブル作成時に利用し、レイアウト情報を計算

- テーブル作成後に呼び出され、以前計算された値を提供

- slot の先頭には

空/使用フラグのための 4 バイトを確保

RecordPage

- ページ内のレコードを管理

- getInt, getString: 指定された slot 番号のレコードのフィールドの値を返す

public int getInt(int slot, String fldname) { int fldpos = offset(slot) + layout.offset(fldname); return tx.getInt(blk, fldpos); } public String getString(int slot, String fldname) { int fldpos = offset(slot) + layout.offset(fldname); return tx.getString(blk, fldpos); }- slot 自体の offset とレコード内でのフィールドの offset を足して block 内での pos を算出して取得

- nextAfter, insertAfter: ページ内の対象のレコードを検索

- nextAfter: 指定された slot に続く最初の空でない slot を探す

- insertAfter: 指定された slot に続く最初の空である slot を探す

- 空の slot が見つかったらフラグを

使用中に変更して slot 番号を返す - 内部で

searchAfterというメソッドを利用

private int searchAfter(int slot, int used) { slot++; while(isValidSlot(slot)) { if (tx.getInt(blk, offset(slot)) == used) { return slot; } slot++; } return -1; }-

isValidSlotは指定された slot が block サイズ内に収まっている場合 true を返す - used: EMPTY=0, USED=1

Chapter 6 Record Management: Table Scans 実装

実装対象: TableScan

TableScan

- テーブルのレコードを管理するクラス

- beforeFirst: 操作対象のレコードをファイルの最初の block の最初のレコードの 1 つ前へ

- (分かりにくい...)

public void beforeFirst() { moveToBlock(0); } private void moveToBlock(int blknum) { close(); BlockId blk = new BlockId(filename, blknum); rp = new RecordPage(tx, blk, layout); currentslot = -1; } - next: 操作対象のレコードを 1 つ後ろにずらす

public boolean next() { currentslot = rp.nextAfter(currentslot); while (currentslot < 0) { if (atLastBlock()) { return false; } moveToBlock(rp.block().number() + 1); currentslot = rp.nextAfter(currentslot); } return true; }- 現在の block にそれ以上レコードがない場合、後続の block を読み込む

- get/set/delete: 操作対象のレコードに対して実施

- TableScan クラスは block 構造をクライアントから隠す

- insert: 現在の slot より後ろの空 slot の位置に移動

public void insert() { currentslot = rp.insertAfter(currentslot); while (currentslot < 0) { if (atLastBlock()) { moveToNewBlock(); } else { moveToBlock(rp.block().number() + 1); } currentslot = rp.insertAfter(currentslot); } }- 同一 block 内に空きがない場合は後続の block の空きを探す

Chapter 7 Metadata Management

レコードのレイアウトなどメタデータも管理する必要がある

The Metadata Manager

- メタデータの種類

- テーブルのレコードの構造

- View のプロパティ

- その定義や作成者など

- Index の記述

- 統計的な情報

- 各テーブルのサイズとそのフィールド値の分布

- クエリオプティマイザがクエリのコストを推定するのに利用

- database が更新される度に生成

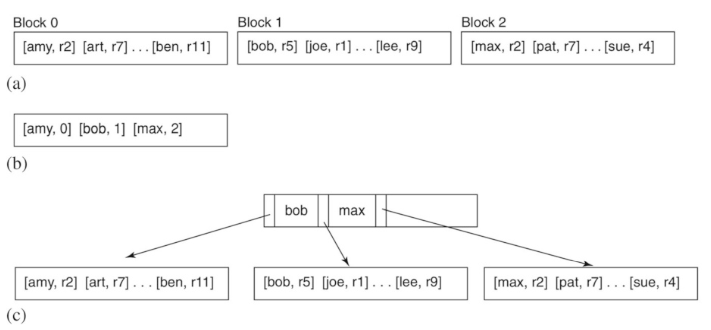

Table Metadata

※SimpleDB の TableMgr クラスを説明しているので、一般的な内容ではない

- テーブル生成時にテーブル名とスキーマの情報と、レコードの offset を計算してカタログに保存

- 一般的なカタログの管理方法は database テーブルに格納

- tableCatalog(tablename varchar, slotsize int)

- テーブルごとに 1 レコード

- filedCatalog(tablename varchar, fieldname varchar, type int, length int, offset int)

- 各テーブルのフィールドごとに 1 レコード

- tableCatalog(tablename varchar, slotsize int)

- TableScan を利用してテーブル情報登録 & 読み込み

View Metadata

- View: クエリから動的に計算されるレコードを持つテーブル

- このクエリ = View の定義

- 定義を保存しておき、リクエスト時に定義を取得して処理

- SimpleDB では ViewMgr が定義の管理をおこなう(情報は database テーブルに格納)

- viewCatalog(viewName, viewDef)

- SimpleDB の制約上、viewDef は 100 文字以内

- viewCatalog(viewName, viewDef)

- TableScan を利用してテーブル情報登録 & 読み込み

Statistical Metadata

- 統計情報: database 内の各テーブルのレコード数やフィールド値の分布など

- クエリプランナーがコストを見積もるために使用

- 優れた統計情報を使うとクエリの実行時間を大幅に改善できる

- SimpleDB では 3 種類をピックアップ

- 各テーブルが使用する block 数

- 各テーブルのレコード数

- テーブルの各フィールドについてのカーディナリティ

- 統計情報の管理方法

- database カタログに情報を格納し、database が変更されるたびに情報を更新

- 統計情報を最新に保つためのコストが問題

- insert, delete, setInt, setString の度にテーブルを更新

- 同時実行性が低下

- 統計情報を更新する際に xlock が取られる

- 同一のテーブルに対する更新だけでなく、読み取り(slock取得)も lock 待ち

- 厳密性は求められないので読み取り時に slock を取らない方法もとれる

- 統計情報を最新に保つためのコストが問題

- 情報をメモリに保持し、エンジンの初期化時に計算する

- 統計情報は比較的小さいのでメモリに収まるはず

- 起動時に統計情報をゼロから計算する必要があるのが問題

- 2 つのオプションがある

- database を更新する度に統計情報を更新

- 定期的にゼロから統計情報を再計算

- SimpleDB ではこちらを採用

- database カタログに情報を格納し、database が変更されるたびに情報を更新

StatMgr 実装

- getStatInfo

- 呼び出される度にカウンターをインクリメント

- カウンターが特定の値に達すると統計情報をリフレッシュ

public synchronized StatInfo getStatInfo(String tableName, Layout layout, Transaction tx) { numCalls++; if (numCalls > 100) refreshStatistics(tx); StatInfo si = tableStats.get(tableName); if (si == null) { si = calcTableStats(tableName, layout, tx); tableStats.put(tableName, si); } return si; } - refreshStatistics

- テーブル情報が記録された tableCatalog テーブルをループ

- テーブルごとにテーブルの統計情報を計算

- 簡略化のためフィールド値はカウントしない

private synchronized void refreshStatistics(Transaction tx) { tableStats = new HashMap<>(); numCalls = 0; Layout tableCatalogLayout = tblMgr.getLayout("tableCatalog", tx); TableScan ts = new TableScan(tx, "tableCatalog", tableCatalogLayout); while (ts.next()) { String tableName = ts.getString("tableName"); Layout layout = tblMgr.getLayout(tableName, tx); StatInfo si = calcTableStats(tableName, layout, tx); tableStats.put(tableName, si); } ts.close(); } private synchronized StatInfo calcTableStats(String tableName, Layout layout, Transaction tx) { int numRecs = 0; int numBlocks = 0; TableScan ts = new TableScan(tx, tableName, layout); while (ts.next()) { numRecs++; numBlocks = ts.getRid().blockNumber() + 1; } ts.close(); return new StatInfo(numBlocks, numRecs); }

Index Metadata

- Index metadata の構成

- Index の名前

- Index 対象のテーブル名

- Index 対象のフィールドのリスト

- Index Manager は上記の metadata を保存したり取得したりするコンポーネント

- metadata をカタログテーブルに格納 & 取得

IndexMgr 実装

- コンストラクタ

- システム起動時に呼び出される

- createIndex

- TableScan を用いて Index metadata をカタログテーブルに格納

- getIndexInfo

- TableScan を用いて指定されたテーブルの Index metadata を取得

- Index の対象フィールドに対する IndexInfo クラス(詳細は後述)の Map を返す

IndexInfo 実装

- コンストラクタ

- Index の名前、Index されたフィールド、関連するテーブルのレイアウト、統計 metadata を受け取る

- 統計 metadata によって Index レコードのスキーマを構築 & Index ファイルのサイズを推定

- open

- HashIndex コンストラクタに Index の名前とスキーマを渡して Index を open

- HashIndex については後の章で説明

- blocksAccessed

- Index を検索するために必要なブロックアクセス数の見積もりを返す

- Index のサイズではない、とのこと

public int blocksAccessed() { int rpb = tx.blockSize() / idxLayout.slotSize(); int numBlocks = si.recordsOutput() / rpb; return HashIndex.searchCost(numBlocks, rpb); }-

rpb: おそらく record per block,si: 前節で実装した StatInfo - Index ファイルのブロック数を算出した上で、HashIndex クラスの searchCost メソッドに渡してコストを返す

- コスト: Indexを探索するためのブロックアクセス数

- Index を検索するために必要なブロックアクセス数の見積もりを返す

- recordsOutput

- 検索キーを持つレコードの推定件数を返す

- テーブル内のレコード数を Index 付きフィールドの異なる値の数で割った値

public int recordsOutput() { return si.recordsOutput() / si.distinctValues(fieldName); } - distinctValues

- 指定されたフィールドの個別値を返す

- また、Index 付きフィールドの場合は 1 を返す

Metadata Manager

- これまで見てきた 4 つのマネージャクラスをラップ

- metadata の種類毎に metadata を生成・保存、取得

- 統計 metadata は例外

Chapter 8 Query Processing

- Database エンジンは SQL を関係代数(relational algebra)クエリに変換し、実行

- この章では関係代数のクエリとその実装を紹介

- 次の 2 つの章では SQL から関係代数への変換を扱う

Relational Algebra

- 関係代数は演算子の集合で構成

- 各演算子は 1 つ以上のテーブルを入力 & 1 つ以上の出力テーブルを生成するという特殊なタスクを実行

- これらの演算子を組み合わせることで複雑なクエリを構築

- SimpleDB 版の SQL は 3 つの演算子を用いて実装

- select

- 出力テーブルが入力テーブルと同じカラムを持ち、いくつかの行が削除されたもの

- project

- 出力テーブルが入力テーブルと同じ行を持ち、いくつかの列が削除されたもの

- product

- 出力テーブルが、2 つの入力テーブルのレコードのすべての可能な組み合わせから構成されるもの

- select

Select

- select 演算子

- 入力テーブルと述語の 2 つの引数を取る

- 例:

select(STUDENT, GradYear=2019)

- 出力テーブル

- 述語を満たす入力レコードで構成される

- 常に入力テーブルと同じスキーマを持つ

- select クエリ

- レコードのサブセットを持つテーブルを返す

- 例

- クエリ Q1:

select(STUDENT, GradYear=2019)- 2019 年に卒業した生徒を見つける

- クエリ Q2:

select(STUDENT, GradYear=2019 and (MajorId=10 or MajorId = 20))- 述語は、任意の真偽値の組み合わせが可能( SQL の where 句に相当)

- 2019 年に卒業し、専攻が学科10または20のどちらかの生徒を見つける

- クエリ Q3:

select(select(STUDENT, GradYear=2019), MajorId=10 or MajorId=20)- あるクエリの出力テーブルを別のクエリの入力にすることができる

- Query2 と同等の結果となる

- クエリ Q4:

select(Q1, MajorId=10 or MajorId=20)- Q3 の一部を Q1 を使用して表現したパターン

- クエリ Q1:

- 関係代数のクエリはクエリツリーとして絵として表現できる

- テーブルはリーフノード、演算子は内部ノード

Project

- project 演算子

- 入力テーブルとフィールド名のセットという 2 つの引数を取る

- 例:

project(STUDENT, {SName, GradYear})

- 出力テーブル

- 入力テーブルと同じレコードを持つが、スキーマには指定されたフィールドのみが含まれる

- 重複したレコードが含まれることがある

- project クエリ

- project 演算子と select 演算子の両方で構成できる

- 例

- クエリ Q5:

project(STUDENT, {SName, GradYear})- すべての学生の名前と卒業年を返す

- クエリ Q6:

project(select(STUDENT, MajorId=10), {SName})- select 演算子も利用したパターン

- 学科10 を先行しているすべての学生の名前をリストしたテーブルを返す

- クエリ Q5:

Product

- product 演算子

- 複数のテーブルから情報を組み合わせて比較できる

- 例:

product(STUDENT, DEPT)

- 出力テーブル

- 入力テーブルのレコードのすべての組み合わせ

- スキーマは入力スキーマのフィールドの和集合

- 同じ名前の2つのフィールドを持たないよう、入力テーブルのフィールド名はバラバラである必要あり

- 例

- クエリ Q8:

product(STUDENT, DEPT)- STUDENTに N レコード、DEPT に M レコードある場合、出力テーブルには NM レコードが含まれる

- クエリ Q9:

select(product(STUDENT, DEPT), MajorId=Did)- DEPT テーブルの id で絞り込み

- クエリ Q8:

Scans

- Scan: 関係代数クエリの出力を表す

- 以下は、SimpleDB における話

- Scan は TableScan のサブセット

- クエリ、テーブルどちらも表せる

- Scan オブジェクトはクエリツリーのノードに対応

- リレーショナル演算子ごとに Scan クラスがある

- SelectScan, ProjectScan, ProductScan

- ツリーのリーフは TableScan となる

- リレーショナル演算子ごとに Scan クラスがある

Update Scans

- クエリは仮想テーブルを定義

- Scan は仮想テーブルからの読み取りはできるるが、更新はできないメソッドを持つ

- すべての Scan が意味のある更新を行えるわけではない

- Scan が更新可能な場合は?

- 出力レコードのすべてが、基礎となる database テーブルに対応するレコードをもつ場合

- 更新可能 Scan の場合、UpdateScan インターフェースをサポート

- 5 つの変更操作のメソッド

- SimpleDB では TableScan と SelectScan が UpdateScan インターフェースを実装

Scan の実装

Scan (インターフェース)

- 各 Scan クラスが実装するインターフェース

- レコードを読み取るメソッドを定義

- beforeFirst, next, getInt, getString, hasField, close

UpdateScan (インターフェース)

- SelectScan など更新可能な Scan が実装するインターフェース

- Scan インターフェースを拡張して、レコードを更新するメソッドを定義

- setInt, setString, insert, delete, getRid, moveToRid

- レコードを読み取るメソッドを定義

- beforeFirst, next, getInt, getString, hasField, close

SelectScan

- UpdateScan インターフェースを実装

- constructor

- 基礎となる Scan と Predicate (述語) を受け取る

public SelectScan(Scan s, Predicate pred) { this.s = s; this.pred = pred; } - beforeFirst, getInt, getString, hasField

- 基礎となる Scan の対応するメソッドを呼び出すのみ

- next

- Predicate が満足するレコードを探す

public boolean next() { while (s.next()) if (pred.isSatisfied(s)) return true; return false;} - setInt (setString, insert, delete, getRid, moveToRid も同様)

- 基礎となる Scan を UpdateScan にキャストした上で、対応するメソッドを呼び出す

public void setInt(String fieldName, int val) { UpdateScan us = (UpdateScan) s; us.setInt(fieldName, val); }- ClassCastException は起きないようにプランナーが Scan のツリーを作成することを前提とする

ProjectScan

- Scan インターフェースを実装

- projection は更新可能であるにも関わらず、実装する ProjectScan は UpdateScan を実装しない

- Exercise で実装を完成させる

- constructor

- 基礎となる Scan と出力フィールドのリストを受け取る

public ProjectScan(Scan s, List<String> fieldList) { this.s = s; this.fieldList = fieldList; } - beforeFirst, next, getInt, getString,

- 基礎となる Scan の対応するメソッドを呼び出すのみ

- hasField

- 出力フィールドのリストに含まれるフィールドかどうかを判定

public boolean hasField(String fieldName) { return fieldList.contains(fieldName); }

ProductScan

- Scan インターフェースを実装

- コンストラクタで受け取る 2 つの Scan について多重にループしつつ結果を返す

- constructor

- 基礎となる Scan s1, s2 を受け取り、beforeFirst を呼び出し

public ProductScan(Scan s1, Scan s2) { this.s1 = s1; this.s2 = s2; beforeFirst(); } - beforeFirst

- s1 の 1 件目、s2 の 0 件目のレコードに index をセット

public void beforeFirst() { s1.beforeFirst(); s1.next(); s2.beforeFirst(); } - next

- s2 のレコードが尽きたら s1 のレコードを進めて s2 を先頭レコードに戻す

if (s2.next()) return true; s2.beforeFirst(); return s2.next() && s1.next(); - getInt, getString

- 対象のフィールドを持っている Scan を確認して返す

public int getInt(String fieldName) { if (s1.hasField(fieldName)) return s1.getInt(fieldName); return s2.getInt(fieldName); } - hasField

- s1, s2 の hasField を用いて結果を返す

public boolean hasField(String fieldName) { return s1.hasField(fieldName) || s2.hasField(fieldName); } - close

- s1, s2 両方の close を呼び出す

Pipelined Query Processing

- 前項の 3 つの関係代数演算子の実装には 2 つの共通点がある

- 出力レコードは必要に応じて一度に 1 つずつ生成される

- 出力レコードを保存せず、また中間の計算も保存しない

- これらの実装はパイプライン型と呼ばれる

- パイプライン化された実装は効率的

- Project, Select の場合

- 対象のテーブルのスキャンは 1 回だけ

- Product の場合

- 対象のテーブルのスキャンが複数回実行されうるため、出力レコードを一時テーブルに格納する実装などもある(後述されるとのこと)

- Project, Select の場合

Predicates(述語)

- 与えられた Scan の各行に対して、真か偽かを返す条件

- Predicate の構造

- Predicate は Term(項)や Term の boolean 結合

- Term は 2 つの Expression(式)の間の比較

- Expression は Constans(定数)とフィールド名に対する操作で構成

- Constans は整数や文字列などあらかじめ決められた型の値

- SimpleDB では許容する表現を単純化

Constant の実装

public class Constant implements Comparable<Constant> {

private Integer iVal = null;

private String sVal = null;

public Constant(Integer iVal) {

this.iVal = iVal;

}

public Constant(String sVal) {

this.sVal = sVal;

}

// equals, hashCode, compareTo, toString などを実装

}

- Interger か String を持つ

Expression の実装

public class Expression {

private Constant val = null;

private String fieldName = null;

public Expression(Constant val) {

this.val = val;

}

public Expression(String fieldName ) {

this.fieldName = fieldName;

}

}

- 定数かフィールド名を持つ

- evalute

- スキャンの現在の出力レコードに関する式の値を返す

public Constant evaluate(Scan s) { return (val != null) ? val : s.getVal(fieldName); }- 式が定数の場合は Scan は無視

- 式がフィールドである場合 Scan からフィールドの値を返す

- appliesTo

- 式のスコープを決定するために利用

public boolean appliesTo(Schema sch) { return val != null || sch.hasField(fieldName); }

Term の実装

- constructor

- 左辺の式と右辺の式を受け取る

public Term(Expression lhs, Expression rhs) { this.lhs = lhs; this.rhs = rhs; } - isSatisfied

- 与えられた Scan で左辺の式と右辺の式が同じ値に評価された場合に true を返す

public boolean isSatisfied(Scan s) { Constant lhsVal = lhs.evaluate(s); Constant rhsVal = rhs.evaluate(s); return rhsVal.equals(lhsVal); } - 残りのメソッドは query planner 向けのもの

- reductionFactor

- 述語を満たすレコードの予想数を決定

- 後述

- 述語を満たすレコードの予想数を決定

- equatesWithConstant, equatesWithField

- query planner がいつ index を使用するかを決定するのを助ける

- 後述

- query planner がいつ index を使用するかを決定するのを助ける

- reductionFactor

Predicate の実装

- Term のリストを保持

- 各 Term の対応するメソッドを呼び出す

public boolean isSatisfied(Scan s) { for (Term t : terms) if (!t.isSatisfied(s)) return false; return true; } public int reductionFactor(Plan p) { int factor = 1; for (Term t : terms) { factor *= t.reductionFactor(p); } return factor; } // ...

Chapter 9 Parsing

- パーザは言語の構文解析器

- metadata については何も知らないので SQL の意味を評価することはできない

- metadata を調べる責任は planner

- 後述

- metadata を調べる責任は planner

Lexical Analysis

- 入力文字列をトークンに分割

- トークンには型と値がある

- SimpleDB の lexical analyzer は 5 つのトークンタイプをサポート

- カンマなどの1文字の区切り文字

- 整数定数

- 文字列定数

- キーワード(select, from, where, ...)

- 識別子(テーブル名, フィールド名, ...)

Lexer 実装

-

java.io.StreamTokenizerを利用 - delimiter, int, String, keyword, id などを判定したり eat(consume)して返すメソッドを実装

- 一部抜粋

public boolean matchDelim(char d) { return d == (char)tok.ttype; } public void eatDelim(char d) { if (!matchDelim(d)) throw new BadSyntaxException(); nextToken(); } public boolean matchKeyword(String w) { return tok.ttype == StreamTokenizer.TT_WORD && tok.sval.equals(w); } public void eatKeyword(String w) { if (!matchKeyword(w)) throw new BadSyntaxException(); nextToken(); } public boolean matchId() { return tok.ttype == StreamTokenizer.TT_WORD && !keywords.contains(tok.sval); } public String eatId() { if (!matchId()) throw new BadSyntaxException(); String s = tok.sval; nextToken(); return s; } // ... private void initKeywords() { keywords = Arrays.asList( "select", "from", "where", "and", "insert", "into", "values", "delete", "update", "set", "create", "table", "int", "varchar", "view", "as", "index", "on" ); }-

keywordsリストはidに指定された文字が keyword ではないことを確認することにしか使ってないが、matchKeywordでも使った方が良い気がする

Grammer

- トークンをどのように組み合わせることができるかを記述したルールセット

- 文法規則の例

<Field> := IdTok- 左辺は構文カテゴリ:

<Field>はフィールド名という概念を表す - 右辺は構文カテゴリに属する文字列の集合を指定するパターン

- SimpleDB がサポートする文法規則

<Field> := IdTok<Constant> := StrTok | IntTok<Expression> := <Field> | <Constant><Term> := <Expression> = <Expression><Predicate> := <Term> [ AND <Predicate> ]<Query> := SELECT <SelectList> FROM <TableList> [ WHERE <Predicate> ]<SelectList> := <Field> [ , <SelectList> ]<TableList> := IdTok [ , <TableList> ]<UpdateCmd> := <Insert> | <Delete> | <Modify> | <Create><Create> := <CreateTable> | <CreateView> | <CreateIndex><Insert> := INSERT INTO IdTok ( <FieldList> ) VALUES ( <ConstList> )<FieldList> := <Field> [ , <FieldList> ]<ConstList> := <Constant> [ , <ConstList> ]<Delete> := DELETE FROM IdTok [ WHERE <Predicate> ]<Modify> := UPDATE IdTok SET <Field> = <Expression> [ WHERE <Predicate> ]<CreateTable> := CREATE TABLE IdTok ( <FieldDefs> )<FieldDefs> := <FieldDef> [ , <FieldDefs> ]<FieldDef>:= IdTok <TypeDef><TypeDef> := INT | VARCHAR ( IntTok )<CreateView> := CREATE VIEW IdTok AS <Query><CreateIndex> := CREATE INDEX IdTok ON IdTok ( <Field> )

Recursive-Descent Parsers

- SimpleDB の SQL の文法は単純で再帰下降構文解析で解析できる

- 基本的なパーザは解析のみ

- query planner が必要とする情報を返すように変更する必要がある

-

adding actions to the parser

-

- query planner が必要とする情報を返すように変更する必要がある

- SQL パーザは SQL 文から情報を抽出する

- テーブル名、フィールド名、述語、定数など

Parsing Predicate

- SimpleDB がサポートするPredicate の文法に従ってパーズ

- expression までの処理の抜粋

public Expression expression() { if (lex.matchId()) return new Expression(field()); else return new Expression(constant()); } public Term term() { Expression lhs = expression(); lex.eatDelim('='); Expression rhs = expression(); return new Term(lhs, rhs); } public Predicate predicate() { Predicate pred = new Predicate(term()); if (lex.matchKeyword("and")) { lex.eatKeyword("and"); pred.conjoinWith(predicate()); } return pred; }

Parsing Queries

- SimpleDB がサポートする Query の文法に従ってパーズ

public QueryData query() {

lex.eatKeyword("select");

List<String> fields = selectList();

lex.eatKeyword("from");

Collection<String> tables = tableList();

Predicate pred = new Predicate();

if (lex.matchKeyword("where")) {

lex.eatKeyword("where");

pred = predicate();

}

return new QueryData(fields, tables, pred);

}

Parsing Updates

- SimpleDB がサポートする UpdateCmd の文法に従ってパーズ

- 文字列の最初のトークンをもとに各パーズ処理にディスパッチ

public Object updateCmd() {

if (lex.matchKeyword("insert"))

return insert();

else if (lex.matchKeyword("delete"))

return delete();

else if (lex.matchKeyword("update"))

return modify();

else

return create();

}

private InsertData insert() {

lex.eatKeyword("insert");

lex.eatKeyword("into");

String tblName = lex.eatId();

lex.eatDelim('(');

List<String> fields = fieldList();

lex.eatDelim(')');

lex.eatKeyword("values");

lex.eatDelim('(');

List<Constant> vals = constList();

lex.eatDelim(')');

return new InsertData(tblName, fields, vals);

}

// ... delete, update

private Object create() {

lex.eatKeyword("create");

if (lex.matchKeyword("table"))

return createTable();

else if (lex.matchKeyword("view"))

return createView();

else

return createIndex();

}

private CreateTableData createTable() {

lex.eatKeyword("table");

String tblName = lex.eatId();

lex.eatDelim('(');

Schema sch = fieldDefs();

lex.eatDelim(')');

return new CreateTableData(tblName, sch);

}

// .. createView, createIndex

Chapter 10 Planning

- パーズの次のステップは、抽出したデータを関係代数クエリツリーに変換すること

- このステップを計画と呼ぶ

- 等価なクエリツリーは複数あるがコストが異なる

- この章では基本的な計画作成プロセスについて検討

- 15 章で最適な計画を作成するトピックを扱う

Verification

- planner の最初の責務は、SQL 文が意味があるかの判断

- 以下を確認

- 言及されたテーブルとフィールドがカタログに存在

- 言及されたフィールドは曖昧ではない

- フィールドに対するアクションは正しい型である

- すべての定数は、そのフィールドに対して正しいサイズと型である

- SmpleDB の planner は上記の検証はしていない

- Exercise 対象

The Cost of Evaluating a Query Tree

- planner の第2の責務は、関係代数クエリツリーを構築すること

- クエリの実行時間に対する重要な寄与はブロックアクセス数

- 各関係演算子はそれぞれの独自のコスト算出式を持っている

| s | B(s) | R(s) | V(s, F) |

|---|---|---|---|

| TableScan(T) | B(T) | R(T) | V(T, F) |

| SelectScan(s1, A=c) | B(s1) | R(s1)/V(s1, A) | 1 if F = A V(s1, F) if F ≠ A |

| SelectScan(s1, A=B) | B(s1) | R(s1)/max{V(s1, A), V(s1, B)} | min{V(s1, A), V(s1, B)} if F = A,B V(s1, F) if F ≠ A,B |

| ProjectScan(s1, L) | B(s1) | R(s1) | V(s1, F) |

| ProductScan(s1, s2) | B(s1) + R(s1)*B(s2) | R(s1)*R(s2) | V(s1, F) if F is in s1 V(s2, F) if F in s2 |

- B(s): Scan の出力を構成するのに必要なブロックアクセス数

- R(s): Scan の出力に含まれるレコード数

- V(s, F): Scan に出力に含まれる異なる F の値(F-values)の個数

- F の値とは?

- F値 (曖昧さ回避): wikipediaの中の「F検定」...?後で調べる

- 単に

Fというフィールドの値という意味っぽい

- F の値とは?

- planner はそれぞれの値をどのように計算するか?

- product の場合、

B(s)の値は 2 つのテーブルのブロック数とその左側の Scan のレコード数に依存 - select の場合、

R(s)は Predicate で言及されたフィールドの異なる値の数に依存

- product の場合、

Table Scan のコスト

- B(s), R(s), V(s, F) の値は基礎となるテーブルのブロック数、レコード数、個別の値となる

Select Scan のコスト

- B(s) は 基礎となる Scan(s1) と全く同じ数のブロックアクセスが必要なので B(s1) と同様

- R(s), V(s, F) の計算は Predicate に依存

- 定数に対する選択: SelectScan(s1, A=c)

- A の値が等しく分布していると仮定するとマッチするのは R(s1)/V(s1, A) のレコード

- 均等に分布する仮定は、出力において他のフィールドの値も均等に分布していることを意味する

- V(s, A) = 1

- A は定数マッチしているもののみ

- V(s, F) = V(s1, F)

- A のフィールドでマッチさせても分布は変わらない

- V(s, A) = 1

- フィールドに対する選択: SelectScan(s1, A=B)

- このケースでは A と B は何らかの関係があると考えられる

- R(s) = R(s1) / max{V(s1, A), V(s1, B)} となる理由

- もし B の値が A の値よりも多い場合、すべての A の値は B 内にあると仮定する

- もし A の値が B の値よりも多い場合、すべての B の値は A 内にあると仮定する

- (上記の仮定は A と B がキーと外部キーの関係の場合は確実に成り立つ)

- s1 のレコードを考える

- B の値が A の値より多いと仮定すると

- A の値が B の値と一致する確率は 1/V(s1, B)

- A の値が B の値より多いと仮定すると

- B の値が A の値と一致する確率は 1/V(s1, A)

- B の値が A の値より多いと仮定すると

- 上記の確率の大きな方で R(s1) を割ると R(s) となる

- V(s, F) の値は等分布を仮定すると

- min(V(s1, A), V(s1, B)} for F = A or B

- それはそう

- V(s1, F) for all fields F other than A or B

- こちらも等分布なので絞り込んで変わらない

- min(V(s1, A), V(s1, B)} for F = A or B

- 定数に対する選択: SelectScan(s1, A=c)

Project Scan のコスト

- B(s) = B(s1), R(s) = R(s1), V(s, F) = V(s1, F) for all fields F

- 基礎となる Scan(s1) で必要とされる以上の追加のブロックアクセスは必要ではない

- project 操作はレコードの数、値を変更しない

Product Scan のコスト

- 基礎となる Scan は s1, s2 の2つで出力はそれらのすべての組み合わせ

- B(s) = B(s1) + (R(s1) * B(s2))

- ProductScan(s1, s2) と ProductScan(s2, s1) のブロックアクセス数は異なることがある

- 論理的にはどちらも一緒なので、上記の式で算出したブロックアクセス数が少ない方を利用した方がコストが低い

- R(s) = R(s1) * R(s2), V(s, F) = V(s1, F) or V(s2, F), depending on which schema F belongs to

- これらは自明

Plan の実装

Plan インターフェース

public interface Plan {

// Plant に対応する Scan を開く

public Scan open();

// ブロックアクセス数

public int blockAccessed();

// レコード数

public int recordsOutput();

// 値の数

public int distinctValues(String fieldName);

public Schema schema();

}

TablePlan

- 基礎となるテーブルスキャンのプラン

- constructor

public TablePlan(Transaction tx, String tblName, MetadataMgr md) { this.tblName = tblName; this.tx = tx; layout = md.getLayout(tblName, tx); si = md.getStatInfo(tblName, layout, tx); }- metadata マネージャーを受け取って、レイアウトや統計情報を取得して保持

- blockAccessed, recordOutput, distinctValues

- 統計情報

siの対応するメソッドを呼び出して返す

- 統計情報

SelectPlan

- constructor

public SelectPlan(Plan p, Predicate pred) { this.p = p; this.pred = pred; }- 基礎となる Plan と Predicate を受け取る

- blockAccessed

public int blockAccessed() { return p.blockAccessed(); }- 基礎となる Plan と同じ値

- recordsOutput

public int recordsOutput() { return p.recordsOutput() / pred.reductionFactor(p); }- 基礎となる Plan を Predicate で絞り込む

- distinctValues

public int distinctValues(String fieldName) { if (pred.equatesWithConstant(fieldName) != null) return 1; else { String fieldName2 = pred.equatesWithField(fieldName); if (fieldName2 != null) return Math.min( p.distinctValues(fieldName), p.distinctValues(fieldName2) ); else return p.distinctValues(fieldName); } }- 定数によって選択される場合: 1

- 他のフィールドによって選択される場合: 2 つのフィールドのうち値が少ない方の数

- それ以外の場合は基礎となる Plan と同じ値

ProjectPlan

- blockAccessed, recordOutput, distinctValues

- 基礎となる Plan の対応するメソッドを呼び出して返す

ProductPlan

- constructor

public ProductPlan(Plan p1, Plan p2) { this.p1 = p1; this.p2 = p2; schema.addAll(p1.schema()); schema.addAll(p2.schema()); }- 基礎となる 2 つの Plan を受け取る

- blockAccessed

public int blockAccessed() { return p1.blockAccessed() + p1.recordsOutput() * p2.blockAccessed(); }- 前節で検討した通り、基礎となる Plan のブロックアクセス数、レコード数を用いて算出

- recordsOutput

public int recordsOutput() { return p1.recordsOutput() * p2.recordsOutput(); }- 前節で検討した通り、基礎となる Plan のレコード数を用いて算出

- distinctValues

public int distinctValues(String fieldName) { if (p1.schema().hasField(fieldName)) return p1.distinctValues(fieldName); else return p2.distinctValues(fieldName); }- 対象のフィールドを保持する Plan に基づいて返す

Query Planning

- SimpleDB は単純化された SQL のサブセットのみをサポート

- 計算、ソート、グループ化、入れ子、名前の変更を含まない

- select, project, product の 3 つの演算子のみを使用したクエリツリーで実装

- アルゴリズム

- from 句にある各テーブルに対する Plan を構築

- T がテーブルである場合、T に対する Plan

- T が View である場合、Plan は T の定義に対してこのアルゴリズムを再帰的に呼び出した結果

- これらの Plan の product を与えられた順で取る

- where 句にある述語で select する

- select 句のフィールドに project する

- from 句にある各テーブルに対する Plan を構築

BasicQueryPlanner 実装

public Plan createPlan(QueryData data, Transaction tx) {

// Step 1: Create a plan for each mentioned table or view.

List<Plan> plans = new ArrayList<>();

for (String tblName : data.tables()) {

String viewDef = mdm.getViewDef(tblName, tx);

if (viewDef != null) { // Recursively plan the view.

Parser parser = new Parser(viewDef);

QueryData viewData = parser.query();

plans.add(createPlan(viewData, tx));

} else {

plans.add(new TablePlan(tx, tblName, mdm));

}

}

// Step 2: Create the product of all table plans

Plan p = plans.remove(0);

for (Plan nextPlan : plans)

p = new ProductPlan(p, nextPlan);

// Step 3: Add a selection plan for the predicate

p = new SelectPlan(p, data.pred());

// Step 4: Project on the field names

p = new ProjectPlan(p, data.fields());

return p;

}

- 基本的なクエリプランの作成

- QueryData.tables によって返される順序で ProductPlan を作成

- metadata は利用しないので、性能は不安定

- ProductPlan 作成の小さな改良版

// Step 2: Create the product of all table plans Plan p = plans.remove(0); for (Plan nextPlan : plans) { // Try both orderings and choose the one having the lowest cost Plan choice1 = new ProductPlan(nextPlan, p); Plan choice2 = new ProductPlan(p, nextPlan); if (choice1.blockAccessed() < choice2.blockAccessed()) p = choice1; elsep = choice2; }- まだクエリ内のテーブルの順番に依存

- 商用 DB はより洗練したアルゴリズムを使用

- 最適な Plan の選択は後述

BasicUpdatePlanner 実装

- executeDelete, executeModify

- SelectPlan を用いて対象のレコードを特定した上で操作を行う

public int executeDelete(DeleteData data, Transaction tx) { Plan p = new TablePlan(tx, data.tableName(), mdm); p = new SelectPlan(p, data.pred()); UpdateScan us = (UpdateScan) p.open(); int count = 0; while (us.next()) { us.delete(); count++; } us.close(); return count; } - executeInsert

- TablePlan を用いて insert 操作を行う

public int executeInsert(InsertData data, Transaction tx) { Plan p = new TablePlan(tx, data.tableName(), mdm); UpdateScan us = (UpdateScan) p.open(); us.insert(); Iterator<Constant> iter = data.vals().iterator(); for (String fieldName : data.fields()) { Constant val = iter.next(); us.setVal(fieldName, val); } us.close(); return 1; } - executeCreateTable, executeCreateView, executeCreateIndex

- metadata manager の対応するメソッドを呼ぶのみ

public int executeCreateTable(CreateTableData data, Transaction tx) { mdm.createTable(data.tableName(), data.newSchema(), tx); return 0; }

Planner

- SQL 文を Plan に変換するコンポーネント

- Parser を用いて SQL 文を QueryData や ModifyData(, DeleteData, ...) に変換

- QueryPlanner , UpdatePlanner に処理を委譲

- createQueryPlan

- Plan を作成して返す

- executeUpdate

- Plan を作成して実行して影響を受けたレコード数を返す

- 使用感

public static void main(String[] args) { SimpleDB db = new SimpleDB("dbdir/plannertest1"); Transaction tx = db.newTx(); Planner planner = db.planner(); String cmd = "create table T1(A int, B varchar(9))"; planner.executeUpdate(cmd, tx); int n = 200; System.out.println("Inserting " + n + " random records into T1."); for (int i = 0; i < n; i++) { int a = (int) Math.round(Math.random() * 50); String b = "bbb" + a + "(idx=" + i + ")"; cmd = "insert into T1(A, B) values(" + a + ", '" + b + "')"; planner.executeUpdate(cmd, tx); } cmd = "create table T2(C int, D varchar(9))"; planner.executeUpdate(cmd, tx); System.out.println("Inserting " + n + " records into T2."); for (int i = 0; i < n; i++) { int c = n - i -1; String d = "ddd" + c + "(idx=" + i + ")"; cmd = "insert into T2(C,D) values(" + c + ", '" + d + "')"; planner.executeUpdate(cmd, tx); } String query = "select B,D from T1,T2 where A=C"; Plan p = planner.createQueryPlan(query, tx); Scan s = p.open(); while (s.next()) System.out.println(s.getString("b") + " " + s.getString("d")); s.close(); tx.commit(); }- create table, insert, select などの SQL 文を実行できるようになっている

- 2 テーブルのフィールド値の一致条件も使えている

- create table, insert, select などの SQL 文を実行できるようになっている

Chapter 11 JDBC Interfaces

後回し

Chapter 12 Indexing

- static hashing, extendable hashing, B-trees について取り上げる

- index を利用した関係代数演算も開発

Index の価値

- 絞り込み対象のフィールドの値でソートされていれば、バイナリサーチでレコードを特定できる

- テーブルは複数の index を持てる

- index は役に立たないこともある

- フィールド A に対する index の有用性は、テーブル内の異なる A の値の数に比例

- index されたフィールドがテーブルの PrimaryKey である場合、最も有用

- 異なる A の値の数がブロックごとのレコード数より少ない場合、役に立たない

SimpleDB の index

- Index インターフェースにおける宣言メソッドは TableScan のメソッドと似ている

- well-known な特定の方法で使用されるため、より明確

- index を検索する際は常に値(検索キー)を指定

- すべての index レコードは同じ 2 つのフィールドを持つので、汎用の値の Getter が不要になる

- well-known な特定の方法で使用されるため、より明確

Static Hash Indexes

- 最もシンプルな index の実装

- 最も効率的とは言えないが理解しやすく、原理も明確

- 0 から N-1 までの固定数 N のバケットを使用

- 各 index レコードは dataVal を hash 化した結果のバケットに割り当てられる

- index レコードの格納するには

- hash 関数によって割り当てられたバケットに入れる

- index レコードを見つけるには

- 検索キーを hash 化して対応するバケットを調べる

- index レコードを削除するには

- index レコードを見つけてからバケットから削除する

- index レコードの格納するには

- hash index の検索コスト

- バケットの数に反比例

- index が B ブロックを含む & バケットが N 個ある場合

- バケットを検索するには B/N ブロックアクセスが必要

- 例: ブロックサイズが 4k バイト, バケット数が 1024, dataVal が varchar(10) の場合

- index レコードは 23 バイト(dataVal + dataRid + 空/使用フラグ )

- ブロックには 178 の index レコードが収まる

- -> 2 回のブロックアクセスを想定すると 364,544 レコード(=178 * 1024 * 2)を検索できる

Static Hash Indexes 実装

- 各バケットを別々のテーブルに格納

- 名称: index 名 + バケット番号

- beforeFirst

- 検索キーを hash 化し、バケットに対する TableScan を開く

public void beforeFirst(Constant searchKey) { close(); this.searchKey = searchKey; int bucket = searchKey.hashCode() % NUM_BUCKETS; String tblName = idxName + bucket; this.ts = new TableScan(tx, tblName, layout); } - next

- TableScan の現在の位置から開始し、検索キーを持つレコードが見つかるまで読み進める

public boolean next() { while (ts.next()) if (ts.getVal("dataVal").equals(searchKey)) return true; return false; } - searchCost

- IndexInfo.blocksAccessed によって呼び出される

public static int searchCost(int numBlocks, int rpb) { return numBlocks / HashIndex.NUM_BUCKETS; }- 第二引数はブロックごとに index レコード数だが、HashIndex では使われない

Extendable Hash Indexes

- Static Hash Index の検索コストはバケットの数に反比例

- バケットを多く使えば使うほど各バケットのブロック数は少なくなる

- 最も望ましいのは各バケットがちょうど 1 ブロックの長さになること

- 将来の必要性に基づいてバケットを多く用意すると、初期は無駄なスペースとなる

- Extendable hashing(拡張可能ハッシュ)は上記の問題を解決

- 各バケットが 1 ブロックより長くならないことを保証

- 複数のバケットが同じブロックを共有できるようにすることで、無駄なスペースを無くす

- 2 つのファイルによって実現

- バケットファイル

- index ブロックが格納されている

- バケットディレクトリ

- バケットとブロックの対応付けを行う

- 整数の配列と考えることができる

- 検索キーの hash 値とバケットファイル(の番号)のマッピング情報を保持

- index レコードが少ないうちは、異なる hash 値(hash 化 & mod 計算結果) を同一のブロックに割り当てることができる

- (レコードが溢れた場合は再配置が必要になりそう)

- バケットファイル

- バケットファイルの特定方法

- 検索キーを hash 化

- 例: hash 値=12

- 上記の値をバケットディレクトリ(整数配列)の長さで mod 計算

- 例: バケットディレクトリの長さが 8 の場合は 4

- 上記の値を バケットディレクトリの index として値を取得

- 例: バケットディレクトリの index=4 の値が 1

- 上記の値が対応するバケット

- 例: バケットファイルの番号は 1

- 検索キーを hash 化

- 複数のバケットでブロックを共有するためのパケットディレクトリの設定方法はたくさんあるので後述

Sharing Index Blocks

-

2^M - M: 整数 & index の最大深度と呼ばれる

- 整数値は 32 ビットなので M=32 が妥当

-

初期状態はすべてのディレクトリエントリは 1 つのブロックを指す

- 新しい index レコードはすべてのこのブロックに挿入

-

バケットファイル内のすべてのブロックはローカル深度を持つ

- ローカル深度L とは

- ブロック内のすべてのレコードの hash 値が同じ右端の L ビットを持つことを意味する

- ファイルの最初のブロックは任意の hash 値を持つことができるので L = 0 となる

- ローカル深度L とは

-

ある index レコードが割り当てられたブロックに収まらない場合

- ブロックは分割されレコードは分配される

- 再分配のアルゴリズムはブロックのローカル深度に基づく

- ブロック内のすべてのレコードは右端の L ビットが同じ

- L+1 ビットが 0 ならばもとのブロック、1 ならば新しいブロックに移動

- -> ブロックのローカル深度は 1 増加

- 再分配のアルゴリズムはブロックのローカル深度に基づく

- 分配後、バケットディレクトリを調整する

- もとのブロックを指すディレクトリエントリを特定

- 右端から L+1 ビットが1であるものは追加されたブロックを指すように変更

- ブロックは分割されレコードは分配される

-

分割の例:

-

どのような hash 法でもレコードが均等に分散される保証はない

- ブロックが分割される時、該当のブロックが含むレコードは同じブロックに割り当たるかもしれない

- ローカル深度が最大深度に達するとそれ以上の分割は不可能

- オーバーフローブロックを作成する必要がある