動画生成AI:比較×4、低VRAM:11GB、ローカル:T2V編

この記事でわかること

- なにか動いているものがあることを、お判りいただけたでしょうか?

- 動画生成AIは、ComfyUI、Geforce RTX 2080Ti_11GB でどこまで遊べるか?

昨今の動画生成界隈

2024年10月の Pyramid-flow を皮切りに、この 3か月間に LTX-Video, Hunyuan-Video と動画生成AIの怒涛の発表がありました。 そして今回 1月、満を持して NVIDIA Cosmos です。

年金生活のジジイにとって何がうれしいかというと、これらすべて ComfyUI が公式サポートしていることです。有料課金の生成動画系サイトではなく、ローカルPC で無料で遊べるのは本当に有難い。

各動画生成AI と ComfyUI

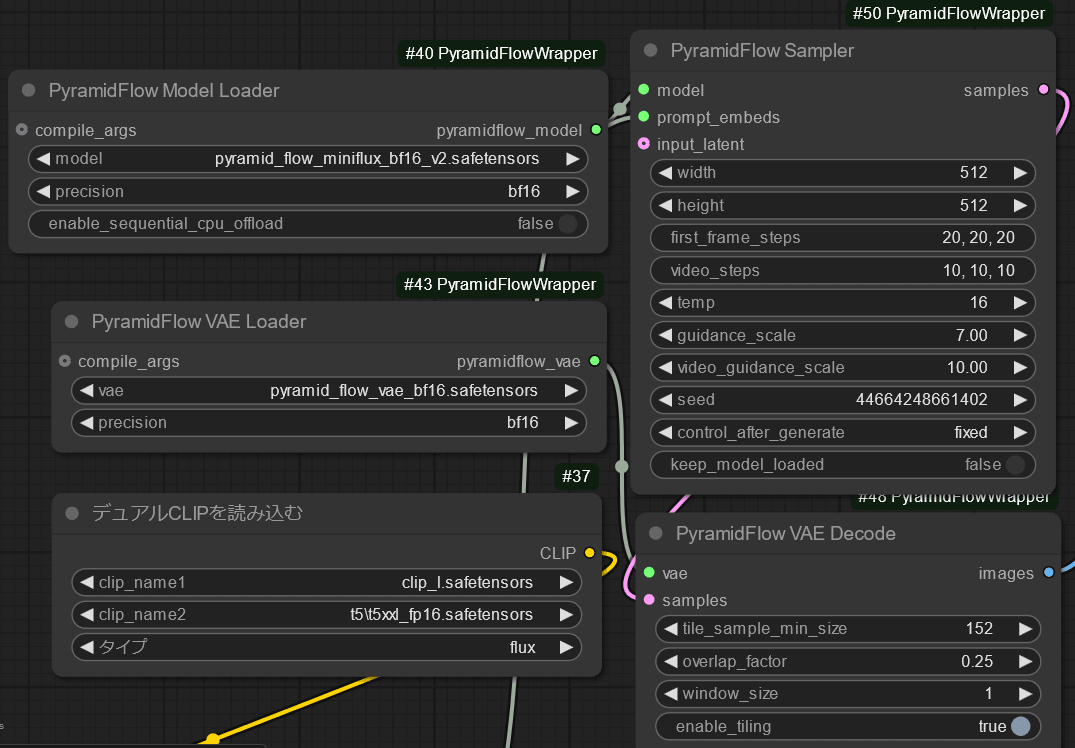

1. Pyramid-Flow:

2025.01.20 現在、旧workflowで使用されていた DownloadAndLoadPyramidFlowModel node は廃止され動かなくなっています。上記、Wrapper の workflow が動きます。T2V、I2V のおよそ 3 - 5秒間の動画を作成できます。

2. LTX-Video:

Workflow は上記公式より、ComfyUI_examples の方が使いやすいかも。T2V、I2V のおよそ 5秒間の動画を作成できます。

3. Hunyuan-Video:

2025.01.20 現在、Hunyuan で作成できるのは 一応 T2V です。一応というのは LTX と連動して I2V を実現する方法があります。最新 Cosmos を動かすのを優先したので、Hunyuan の I2V は確認できていません。

Hunyuan-Video の構築は、以下の ComfyUI_examples が最も導入しやすいと思います。

導入について、金のニワトリさんの記事が参考になります。

Hunyuan-Video の二次開発はすさまじいものがあり、混合精度 FP8 モデルや、量子化 gguf モデルがあります。ただし、FP8 Tensor Core に対応するのは RTX 40系からなので、ジジイの RTX 2080Ti では恩恵が受けられません(´・ω・`)。

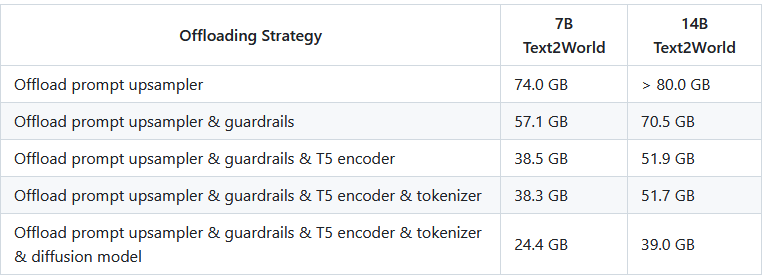

4. NVIDIA-Cosmos:

NVIDIA が提示する Cosmos の GPU 要求量です。様々な削減戦略で GPU を節約しても、7B系軽量モデルで T2V を行う場合、最低 24.4GB 必要です。もうすぐ発売される Geforce RTX 5090 32GB でもようやく動くレベルです。それを RTX 2080Ti 11GB でどうせよと、、

ComfyUI_examples に workflow がありますが、ジジイのスペックでは絵にかいた餅です。

今回は、shiba*2 さんの記事を参考に、低スペックで当たって砕けてみました。

Cosmos の workflow はこちらの workflow を使いました。

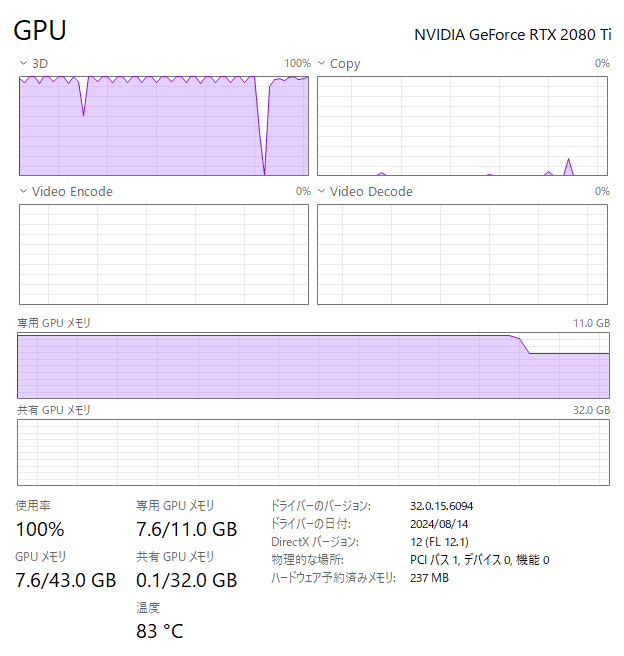

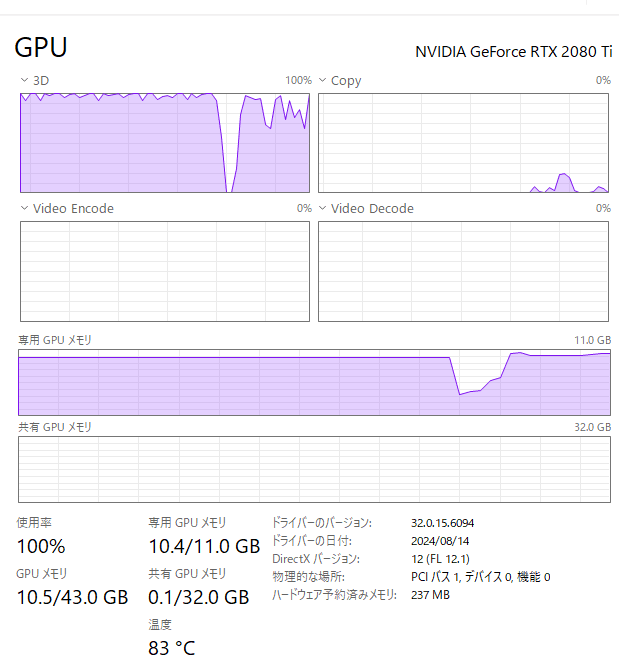

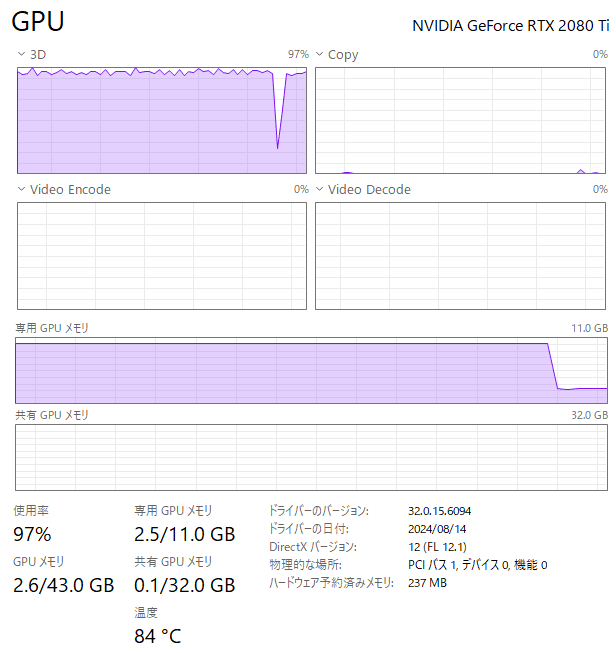

PCスペックとプロンプト

PCスペック

OS: Windows 11 Pro

CPU: Intel i9-9900K 3.6GHz

RAM: 64GB

VRAM: Geforce RTX 2080Ti 12GB

CUDA: 12.1

python: 3.11.8

pytorch: torch==2.5.0 torchvision==0.20.0 torchaudio==2.5.0

プロンプト

プロンプトのトークン数で、VRAMの消費はかなり変化します。以下のように Cosmos 256トークンのプロンプトを、内容や描写を変えないように、Claude 3.5 で半分の 128トークンに圧縮したものを使用しました。

Cosmos のプロンプト: 256トークン。

VRAM節約のため、128トークンに圧縮。

Deepl翻訳

Output

解像度: 512×512

frame_rate: 24fps

長さ: 各動画生成AIでOOMが発生する直前の最大秒数

T2V 結果

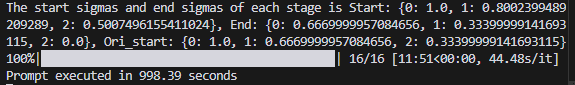

1. Pyramid-Flow:

| Settings |

|---|

|

| temp = 16 で約 5sec、31 で約10sec の動画が作成されます。 5sec 以上でOOMになりました。 |

| GPU消費 |

|---|

|

| Sampler でほぼ10GB、VAE Decode で 7.6GBほど。以下、GPU の使用量は Sampler と Decode が切り替わるときに記録を取っています。 |

| Generation time |

|---|

|

| 生成時間: 16分28秒ほど |

| Movie |

|---|

|

5秒間の動画、画質は悪くないと思います。キャラクターの細部が徐々に変化し、一貫性は破綻します。

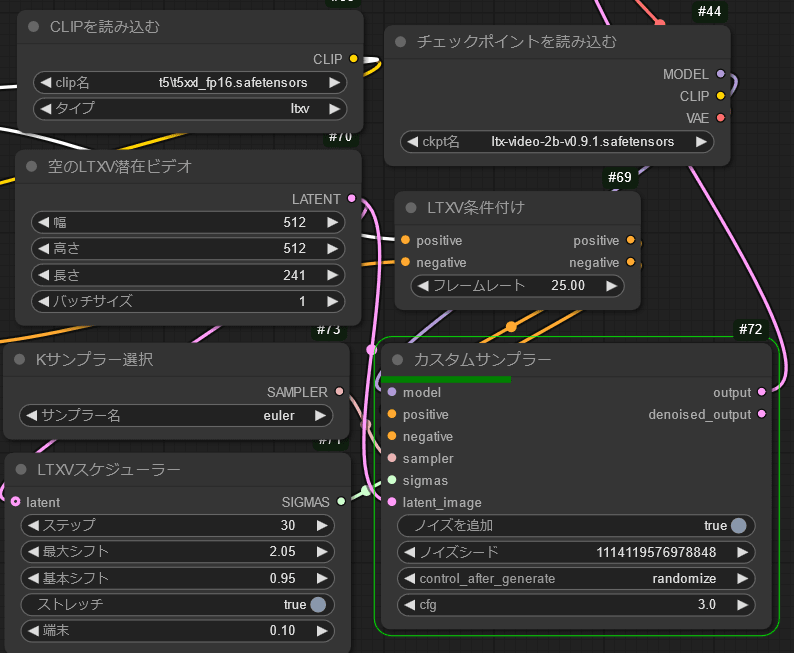

2. LTX-Video:

| Settings |

|---|

|

| 長さはframe数です。241は24fpsでほぼ10秒、241を超えるとOOMになりました。 |

| GPU消費 |

|---|

|

| Sampler でほぼ 9.7GB、VAE Decode で 9.4GBほど |

| Generation time |

|---|

|

| 生成時間: 5分40秒ほど |

| Movie |

|---|

|

最も早く、最も長い動画が作れます。キャラクター細部の一貫性や、動きの連続性に破綻があります。

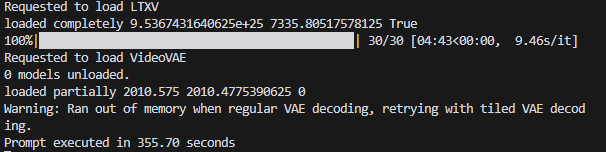

3. Hunyuan-Video:

| Settings |

|---|

|

| 109frames 4.5secの動画にするとOOM。 97frames 4secはOKでした。 |

| GPU消費 |

|---|

|

| Sampler でほぼ10.2GB、VAE Decode で 2.5GBほど |

| Generation time |

|---|

|

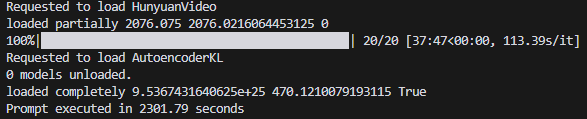

| 生成時間: 38分22秒ほど |

| Movie |

|---|

|

4秒間の動画。画質も良く動きもなめらかで、キャラクターの一貫性も良く保たれています。動画生成AI の中で唯一、"青い胸のライトが点滅する"というプロンプトを理解し、再現できました。しかしながら、4秒の動画に40分の作成時間は気が滅入ります。40系以降のVRAMをお持ちの方は、FP8 モデルで高速化は必須だと思います。

● Comfy-WaveSpeed

FP8 モデルとは別に、Comfy-WaveSpeed を用いる方法もあります。ComfyUI Manager から install する方法がありますが、ジジイの環境ではうまくいきませんでした。ComfyUI フォルダ配下の custom_nodes でgit clone https://github.com/chengzeyi/Comfy-WaveSpeed.gitする方法でビルドしました。Requirements.txt はなく pip install -r requirements.txt は不要です。Flux や LTX, Hunyuan 用の workflow は、Comfy-WaveSpeed フォルダ内にあります。

サファはユーチューバーさんの動画が導入の参考になります。

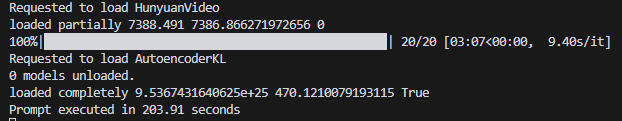

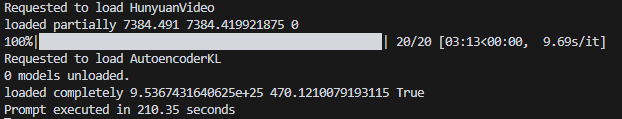

Comfy-WaveSpeed を使用する場合、推奨拡散モデルはhunyuan_video_720_cfgdistill_fp8_e4m3fn.safetensors です。また、residual_diff_threashold 値を Flux や LTX, Hunyuan の最適値にする必要があります。拡散モデルが同じであれば、2回目から高速化できるはずです。動画はプロンプトを変えるか、シード値を変えて作成します。今回は、1回目 Sleek humanoid robot で、2回目 Sleek humanoid female robot と変更し、両者 1sec の動画を作成しました。

a. 推奨拡散モデル: hunyuan_video_720_cfgdistill_fp8_e4m3fn

| WaveSpeed 1回目 | WaveSpeed 2回目 |

|---|---|

|

|

|

|

| 203.91 sec | 210.35 sec |

モデルが FP8 系なので、2080Ti で動くか心配でしたが、大丈夫でした。ただし、高速化はできませんでした。背景の荷物が躍るなど、WaveSpeed でやや品質低下を疑う結果でした。

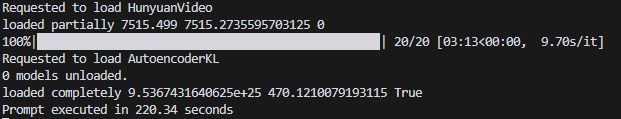

b. 拡散モデル: hunyuan_video_t2v_720p_bf16

| WaveSpeed 1回目 | WaveSpeed 2回目 |

|---|---|

|

|

|

|

| 220.34 sec | 236.02 sec |

モデルが FP16 系でも、WaveSpeed で動きました。やはり、高速化はできませんでしたが、画質はこちらのモデルの方が安定しています。

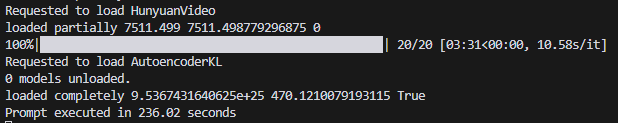

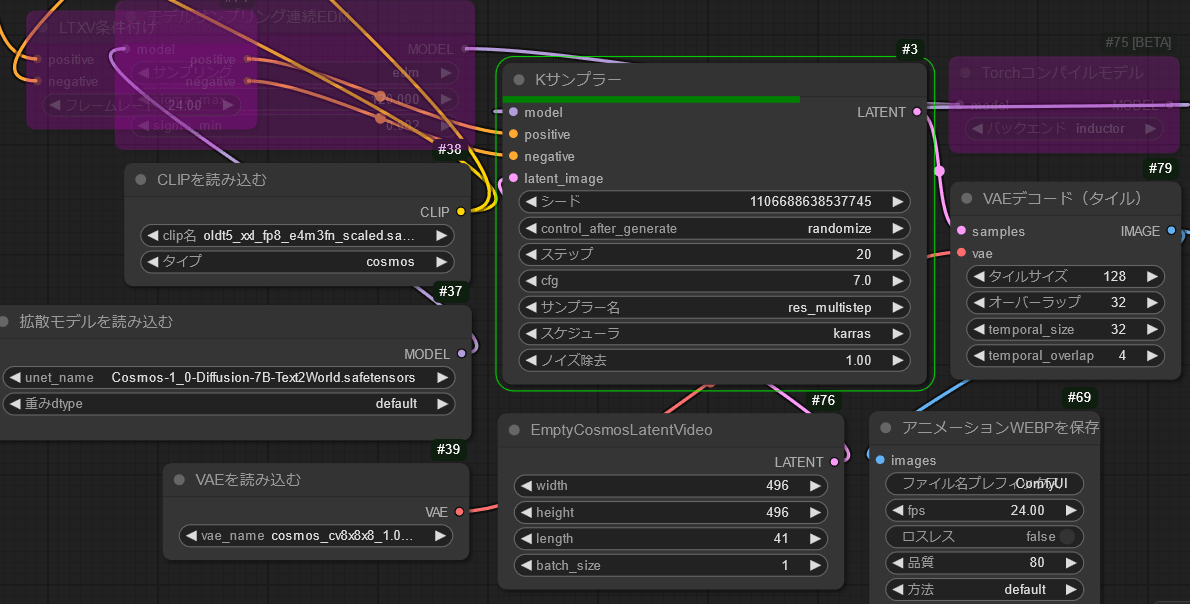

4. NVIDIA-Cosmos:

VRAM 11GB では、どう足掻いても Cosmos 動画を生成するのは厳しいです。"なにか動いているものがあることを、お判りいただけたでしょうか?"というレベルです。Workflow で提供されたVAE デコード node では、デコード時に OOM になります。VAE デコード(タイル)node で小分けにデコードします。また、プロンプトも negative prompts は空欄にして VRAM を節約します。解像度も 512×512 ではすべて OOM です。Length も 41 frames を超えると OOM になります。496×496 1.5sec 程度の動画が精一杯でした。shiba*2 さんが、A4000 16GB で解像度と生成枚数を調整する方法を紹介されていたので、11GB でもなんとか動くかもと思いましたが、甘かったです。

| Settings |

|---|

|

| GPU消費 |

|---|

|

| Sampler でほぼ11GB、VAE Decode で 8.2GBほど |

| Generation time |

|---|

|

| 生成時間: 2分43秒ほど。低画質 1.5sec なので参考値 |

| Movie |

|---|

|

なにか動いているものがあることを、お判りいただけたでしょうか?"青い胸のライト"はご愛敬です。

他の Cosmos robot 達もご紹介します。

| Movie 1 | Movie 2 | Movie 3 |

|---|---|---|

|

|

|

ComfyOnline NVIDIA 4090 で作成した本来の Cosmos robot は、以下で紹介しています。

まとめ

ローカル環境で動かせる4つの動画生成AI Pyramid-Flow, LTX-Video, HUnyuan-Video, NVIDIA-Cosmos を比較しました。低スペック VRAM でも楽しめる動画生成AI として、Hunyuan-Video は頭 2つ分くらい抜けてると思います。Hunyuan-Video が高速化されて I2V、V2V もできるようになれば、さらに人気が出ると思います。低スペック VRAM でも、動画生成AI の実力の片鱗を垣間見ることができました。技術の進歩は、有難いことです。ただし、NVIDIA-Cosmos についてはご覧の通りの結果で、未知数です。

同じ設定でも、ComfyUI が走る場合と、OOM になる場合があります。Youtube など、VRAM を消費する他のアプリが立ち上がっていないか、ComfyUI 作業台に無用の workflow がないか確認してください。生成時間待ちが長いとつい youtube も見たくなるし、作業が増えると消し忘れのworkflow が VRAM 喰ってます。

また機会があれば、ローカル環境で動かせる動画生成AI の I2V も試してみたいです。

Discussion