AGIに繋がる状況的帰納推論性能を測定する環境Marsについて【論文要約】

こんにちは、AIエンジニアを目指しているmitaです。

今回は、Mars: Situated Inductive Reasoning in an Open-World Environment

という論文で提案されているMarsとそこで結果を出したIfRについての要約と個人的な感想を書き留めていきます。

論文要約

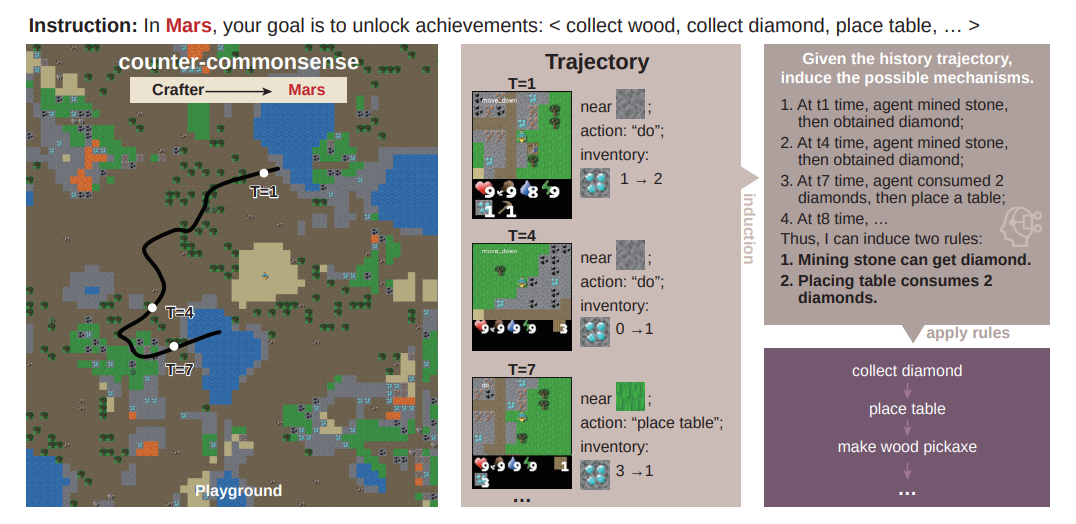

- Marsとは状況的帰納推論を評価するために本研究で開発されたオープンワールド環境で、地球とは異なる-ルールを持つ仮想世界でエージェントが自律的に新しい知識を発見・適応できるかを試すベンチマーク。

- IfR(Induction from Reflection)とは自己修正機構の一種で、エージェントが自分の行動履歴を反省し、そこからルールを帰納、次回以降の行動に活かすという特徴を持つ。

- Marsは状況的帰納推論を評価・学習するのに適した環境であることが示された。また、既存AIよりもIfRが好成績を残した。

論文の詳細

本論文は2024年10月に、北京大学とBIGAI(汎用人工知能の国家重点実験室)を中心とした研究チームによって執筆されたものです。

研究背景

近年目覚ましい進歩を遂げているLLMは大量のテキストデータを学習することで性能を発揮しています。

これは過去のデータに依存していて、特定環境から一般知識を誘導し応用することが難しいという課題がありました。

この問題を解決するには過去の観察から未観測の経験に対する一般的なルールやメカニズムを導き出す能力、すなわち帰納推論能力が不可欠です。

帰納推論を実行するためには、哲学者デイヴィッド・ヒュームが立てた問から下記2つの要素が必要と考えられます。

- 状況性(Situatedness): 動的に状況を理解し、現在の知識をもとに推論する能力。認知科学では、学習は社会的・文化的・物理的文脈に結びついた「状況的活動」の中で起こるとされています。

- 抽象性(Abstractiveness): 観察を抽象化し、過去の経験を超える結論(シンボル・論理・ルール・因果関係)を導き出す能力。

そのため、本研究では帰納推論に必要な2つの要素を測るための環境であるMarsを提案し、今後求められる能力を定量的に測定する手法を提案しています。

Marsとは

Marsは「火星」を意味する英単語ですが、本研究では地球の常識と異なる知識体系を持つ仮想世界を象徴するものとして扱われています。

Crafterという汎用エージェントの性能評価に用いられているオープンワールドゲームを使用して、①地球のルールに則った環境と②地球とは異なるルールが働く環境の2つを作成します。①と②の違いは下記3つです。まんまMinecraftですね。

- 地形(Terrain): 植生や地形効果を設定しています。Marsでは砂漠の中に植物が多く生えていたり、マグマ上を歩いてもダメージがない設定に変更します。

- サバイバル設定(Survival Settings): 牛、ゾンビ、植物などの特性(食べられるか、攻撃的か、近づいたときの効果など)や、それを摂取した時の体力・食料・水分の変化を変更します。

- タスク依存関係(Task Dependency): 資源を集め、ツールを作り、オブジェクトを配置するというタスク構造を持ちます。Marsでは、採掘やクラフトの依存関係を変更し、予想外のルールを作ります。

この環境下で事前に設定された実績を解除することを目的にエージェントが行動し、解除できた割合などでエージェントを評価します。

使用エージェントは強化学習系モデル2種類、LLM系モデル4種類、IfR1種類の計7種類です。

IfRとは

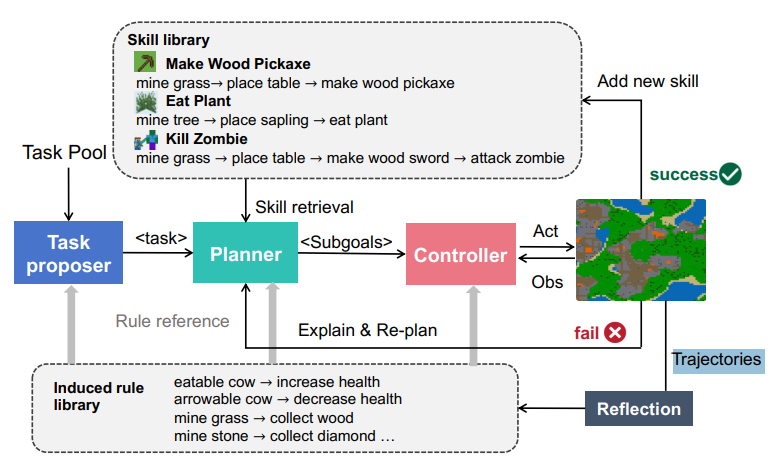

IfR(Induction from Reflection)は下記の特徴を有した自己修正機構の一つです。

- Skill Libraryをベースに、コントローラに「反省からの帰納」モジュールを追加。

- サブゴールを達成/失敗/タイムアウトするたびに、LLMに履歴をもとに反省させ、可能性のあるゲームルールを導出。

- 導出したルールを「Rule Library」に保存し、プランナー・コントローラが利用。

通常自己修正を行うAIは、行動履歴を抽象化してメモリに反映し、それを次回以降の計画に活かすものです。メモリを更新して計画で参照する流れで、失敗体験も成功体験も文脈として抽象化されメモリに保存されます。

IfRの面白い点は環境における成功体験をスキルライブラリとして保存したうえで、成功体験・失敗体験両方から得た一般知識をルールライブラリという領域に保存し、タスク参照・計画・行動の全工程でそれを参照できるようにしていることです。

スキルライブラリは通常の自己修正を行うAIと同じく、「成功した行動シーケンス」をそのまま保存するので似た状況でのみ有効です。

しかしルールライブラリは「成功・失敗から導いた抽象的な環境ルール」を保存するので、異なるタスクや新しい文脈でも適応できるようになります。

これによって帰納的推論能力が向上し、未知の環境から自律的に知識を獲得、次回以降に応用することが高度に可能となります。

実験結果

Mars(改変環境)では既存のRL・LLMベースの手法が軒並み性能低下しました。

デフォルトCrafterでは動くモデルも、ルールを改変したMarsでは成功率が大幅に落ちています。

特に「地形・サバイバル・タスク依存関係を全て改変した環境(All Three)」では、DreamerV3ですらスコアがほぼゼロに近い状態です。

ただしIfRもPrecision(正確さ)が60〜70%程度、Recall(網羅性)が約28%と、それほど高くない結果です。

この論文の主題は、IfRの性能云々ではなく、Marsという環境が帰納推論を測るうえで有用であり、既存モデルでは低スコアしかでない難しいベンチマークであることを示すということなのだと思います。

個人的感想

この研究はAGI開発に直結しそうでわくわくしますね!

既存モデルが太刀打ちできないMarsを利用し研究を進めれば状況的帰納推論に強いAIが生まれるはずです。

そうなれば現実世界を模した環境で学習させることで、現実世界に即したルールに自律的に適応できるAIが誕生し、多ドメイン多タスクをこなせる汎用型AIが誕生するのでは...!

問題は現実世界をどう仮想世界に落とし込むかですかね~

仮説として、現実世界の特定状況を模した仮想空間を様々なシチュエーションで作成し、それらで学習したAIをつなげることで多ドメイン多タスクをこなせるAGIを作成するなどを考えたり...

現実世界の仮想化、AI同士の連携、それ以外のアプローチなどなど、まだまだ情報収集が必要な領域が多いですね。VRとかとの連携などあったら面白そうですね。

今後も論文や書籍でキャッチアップを続ける予定なので、また情報共有します!

ぜひ見てください!!

Discussion