モデルマージ研究の最先端について【論文要約】

初めに

こんにちは、AIエンジニアを目指しているmitaです!

今回は

Model Merging in LLMs, MLLMs, and Beyond: Methods, Theories, Applications and Opportunities

という、複数モデルの知識をパラメータ空間で融合する「モデルマージ」の手法や応用を総合的に整理したサーベイ研究を要約&考察していきます。

キャッチアップした内容を共有していくので、何かしらの形でお役に立てれば光栄です!

論文要約

この論文は、モデルマージ(ModelMerging)の研究を体系的に整理したサーベイであり、

- マージ手法の体系的分類

- 基盤モデル(LLMs, MLLMs, 画像生成)での応用

- 継続学習、FLなど他ML分野での応用

-

今後の課題と展望

をまとめたもの。

特に、モデルマージを 「マージ前の手法(準備)」 と

「マージ中の手法(融合)」 の2つに大別して分類した点が特徴的。

論文詳細

論文背景

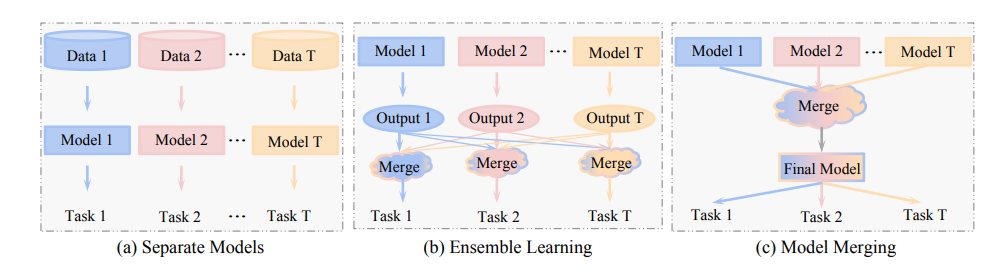

- モデルマージは「複数の専門モデルを、推論時に統合せず、パラメータ空間で一つにまとめる」技術。

- アンサンブルより効率的で、学習データや再学習を必要とせずに汎用モデルを作れる利点がある。

- 近年、LLMや画像生成モデルの公開が増え、多数の専門モデルをどう活かすかが課題となっており、モデルマージが注目されている。

マージ手法の分類と内容

1. マージ前の手法(Pre-Merging Methods)

-

線形化ファインチューニング (Linearization Fine-tuning)

- モデルの非線形性を抑え、接空間で線形近似したうえでファインチューニング。

- 干渉を減らし、マージ後の性能低下を防ぐ。

-

アーキテクチャ変換 (Architecture Transformation)

- 異なる構造を持つモデルを共通のアーキテクチャに変換してからマージ。

- 例: GAN

Cocktail(異なるGANを統一形式へ変換)、FuseChat(異種LLMをOpenChat形式に統一)。

-

重みアライメント (Weight Alignment)

- ニューロンのPermutationを合わせて同じ「最適化の谷」に整列。

- Git Re-basin、OTFusion など。

2. マージ中の手法(During-Merging Methods)

-

基本マージ (Basic Merging)

- 単純平均やタスク算術(タスクベクトルの加減算)によるマージ。

- 例: 特定タスクの忘却(ベクトル減算)。

-

重み付きマージ (Weighted Merging)

- モデルや層ごとに重み係数を学習してマージ。

- AdaMerging, Fisher-Merging, RegMean など。

-

部分空間マージ (Subspace-based Merging)

- モデルを疎な部分空間に射影し、重要なパラメータのみをマージ。

- TIES-Merging, DARE, Model Breadcrumbs など。

-

ルーティングベース (Routing-based Merging)

- 入力に応じて動的にどのモデルを反映するか決定。

- SMEAR, Twin-Merging, MoE形式でのマージ。

-

ポストキャリブレーション (Post-calibration)

- マージ後の表現ずれを補正し、知識損失を低減。

- Representation Surgery など。

3. 理論的分析

-

線形モード連結性

(LMC):局所解が損失一定の経路でつながるため、マージが可能。\ -

重み分離性 (Weight

Disentanglement):入力空間と重み空間の対応が独立していれば、干渉が少なくなる。\ - タスク算術とNTK理論:タスクベクトルの操作が理論的に妥当であることを示す。

応用

LLMへの応用

-

人間の嗜好整合 (Human Preference Alignment)

- RLHFやDPOで得た嗜好モデルをマージし、効率的に価値観整合。

- ExPO, Reward Soups など。

-

毒性低減 (Detoxification)

- 有害データで学習したベクトルを「反転」させてマージ。

- PEM, Ext-Sub など。

-

知識削除 (Knowledge Unlearning)

- 特定知識を持つタスクベクトルを減算して削除。

- SSU, FuseToForget, SKU など。

-

学習高速化 (Faster Training)

- チェックポイントマージで収束を加速。

- LAWA, ColD Fusion など。

-

専門能力の統合 (Expert LLM Integration)

- ドメイン特化LLMをマージして複合的な能力を付与。

- Robust Weight Signatures など。

MLLMへの応用

-

モダリティ統合 (Modality Fusion)

- 異なるモダリティ専用モデルをマージして、単一モデルで画像・音声・テキストを処理可能に。\

- JAM, DAMC, UnIVAL など。

-

クロスモーダル知識移転 (Cross-modal Knowledge Transfer)

- 一方のモダリティで学んだ表現を他モダリティへ移転。

- MAM で、画像/テキスト知識を音声分類へ応用。

画像生成モデルへの応用

-

スタイル融合 (Style Fusion)

- 異なるGANや拡散モデルをマージして複合スタイル生成。

- GAN Cocktail, Diffusion Soup, ZipLoRA。

-

学習コスト削減 (Training Efficiency)

- 中間チェックポイントを統合して訓練を短縮。

- LCSC。

-

忠実性向上 (Fidelity Enhancement)

- LoRAをスキルごとに学習してマージ、テキスト指示への忠実性を改善。

- SELMA。

まとめ

- モデルマージは 基盤モデル(LLM, MLLM, 画像生成) から CL, MTL,

FSL, FL, 敵対的学習, RL, GNN まで幅広い分野に有効。 - 特に、データ不要で「既存モデルの知識を効率的に統合できる」点が強み。

- 一方で、スケーラビリティ、理論的保証、安全性などが今後の課題として残されている。

個人的感想

論文解釈

本論文は近年注目を浴びているモデルマージ研究について、体系的分類がなく理論的有用性を示すものが少ないため、それらをまとめることで明確な研究指針を立てようと書かれたもの。

モデルマージの前にあった技術としてはアンサンブル学習があったが、こちらは2つのモデルの出力を統合するもので、必要なモデルは複数にわたっていた。

モデルマージはマージ後の1つのモデルのみで推論が可能であり、推論コストが減る。

また、アンサンブル学習はモデルたちの出力の平均であり、モデルの知識そのものが混ざるわけではないが、モデルマージではモデルたちの専門知識が組み合わさり新しい能力を獲得することが期待される。

今あるモデルマージはマージ前に調整を加えてマージしやすくする手法とマージ中に手を加えて性能を向上させる手法の2つに大きく分かれる。

理論的にマージの優位性を確立するための理論研究も進められていて、方向性としては損失ランドスケープの観点、重み分離性の観点、タスク算術の観点がある。

モデルマージの応用としてLLM、MLLM、画像処理それぞれに対する可能性を上げている。

考察(感想)

最近は提出されたばかりの論文を中心に読んできましたが、モデルマージに関する論文が非常に多い印象を受けています。私はこれまで主に「マージ中」に分類される手法の論文を読んでいたため、「マージ前」に分類される研究にも興味が湧いてきました。

特に、「AGIを実現するには既存モデルの統合が不可欠である」という考えから出発して探していた中で、異なるアーキテクチャを統合する手法が紹介されていたのは、とても嬉しく感じました。

また、モデルマージの応用例として「人間の嗜好整合」や「毒性低減」が挙げられていたのも印象的でした。以前読んだ論文では、AGIには人間が持つ常識や規範が必要であると述べられており、暗黙知のモデル化は難易度が高そうだと感じていた部分だったので、こちらも大変興味を持ちました。

最新技術を追うことはもちろん重要ですが、その基盤となる基礎研究を理解することで、さらに深い理解につながり、学ぶこと自体もより楽しめそうだと感じています。時間はかかると思いますが、本論文で紹介されている各分類から少なくとも1本は論文を読んでいきたいと思っているので、その際はまた見ていただけると嬉しいです。

Discussion