Human-AI Collaboration: パフォーマンスと人間の嗜好性のトレードオフ

こんにちは。ZENKIGENデータサイエンスチームの川﨑です。所属チームでXアカウントを運用しており、AIに関する情報を発信していますのでご興味あれば覗いてみてください。

論文は以下になります。

背景

AIの発展に伴い、人間とAIの協働の機会が増えています。しかし、AIが人間とうまく協働するためには、単にタスクのパフォーマンスを最大化するだけでなく、人間が心地よく感じる協働方法を設計することが重要です。

従来の研究では、AIの設計において「パフォーマンス」に重点が置かれることが多く、人間がどんなエージェントと協働したいと感じるかという「嗜好性」の側面はあまり注目されていませんでした。

本研究では、異なる複数の協働戦略を持つエージェントを作成し、人間の嗜好性とパフォーマンスの関係を調査しています。

研究内容

実験タスクについて

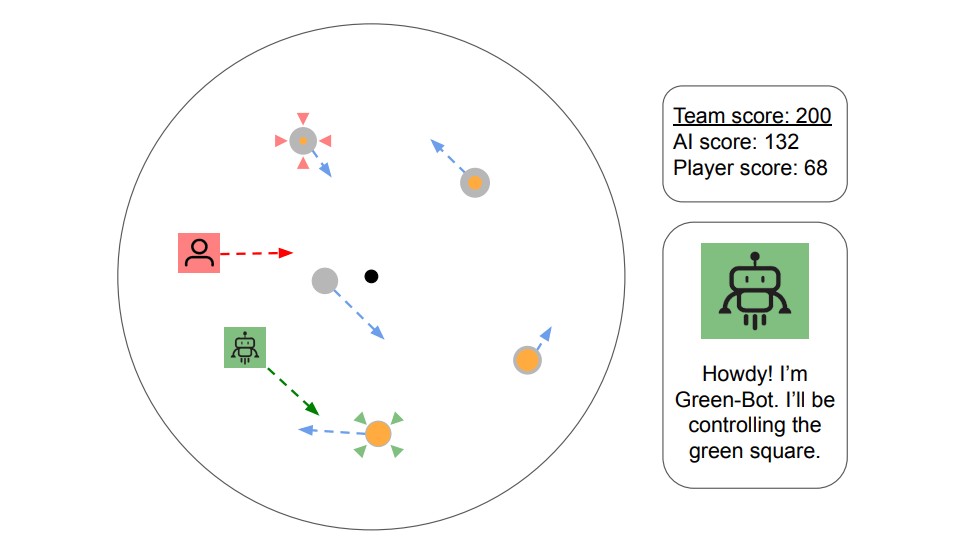

図1. 本研究で行われる実験タスクのイメージ図。HUMAN-AI COLLABORATION: TRADE-OFFS BETWEEN PERFORMANCE AND PREFERENCESより引用。

タスクは、簡潔に言うと「アバターで動くターゲットの邪魔をする」というものです。

ゲームエリアの中にランダムにターゲットが出現し、直線で移動します。ターゲットはゲームエリアの外周に到達したら消滅します。各プレイヤーはターゲットが消滅する前に進路を邪魔することで得点が入ります。

プレイヤーはターゲットをクリックすることで、邪魔をするのに最適なポイントにアバターを移動させることができます。そのため、プレイヤーは「どのターゲットを狙うか」の意思決定を行うイメージです。

また、各ターゲットは1-15点の得点が設定されており、優先度が異なります。

ゲームでは、同時にエージェントもプレイヤーとして参加します。エージェントは後述の5種類の協働戦略のいずれかを持っており、それぞれの戦略によってターゲットを狙う方法が異なります。

そのため、エージェントによって、最終的な得点が変わりますし、ゲーム中の体験も変わります。

なお、図ではプレイヤーやエージェント、AIの進む向きが矢印で示されていますが、実際のゲームでは矢印は表示されません。

エージェントの設計

各エージェントの設計は以下の通りです。

無知型エージェント(Ignorant)

人が狙っているターゲットや動きを考慮せず、得点の最大化を目的としたエージェント。

省略エージェント(Omit)

人が狙っているターゲットの情報を把握し、そのターゲットと、そのターゲットに向かう途中で特典する可能性があるターゲットを狙いから外すようにしたエージェント。

分割エージェント(Divide)

分割統治戦略を採用したエージェントで、人の位置に応じてゲームエリアを2分割し、人がいない側で得点可能なターゲットのみを対象としたエージェント。

遅延エージェント(Delay)

省略エージェントと同様のアルゴリズムだが、得点後に次のターゲットを選択するまでの間に意図的に遅延を加えたエージェント。人よりも速く行動することで、人よりも優れたパフォーマンスを防ぐ意図で設計されている。

低得点重視エージェント(Bottom-Feeder)

省略エージェントと同様のアルゴリズムだが、 内部的に各ターゲットの得点価値を反転させることで、低い得点を狙うようにしたエージェント。 非合理な戦略に見えるが、価値が高いターゲットに人が集中できるようにし、行動を補完することを意図している。

実験方法

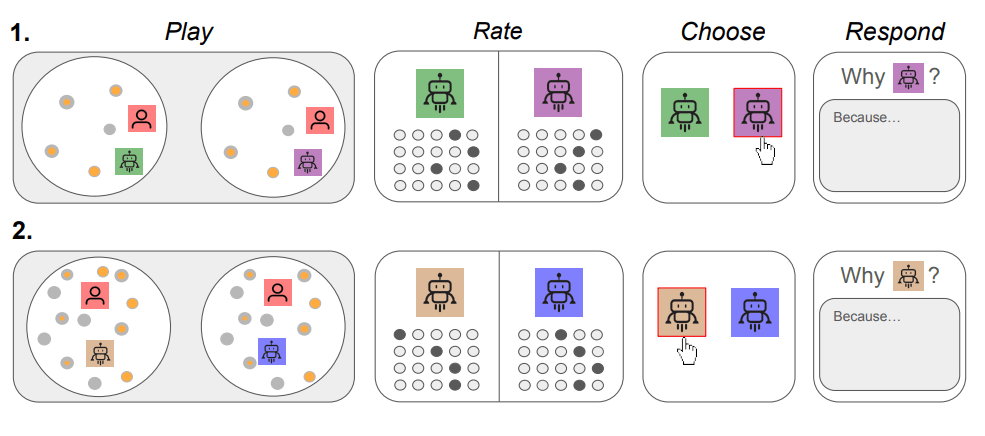

図2. 本研究の実験の流れ。HUMAN-AI COLLABORATION: TRADE-OFFS BETWEEN PERFORMANCE AND PREFERENCESより引用。

実験参加者は5つのエージェントのうち2つを割り当てられ、それぞれのエージェントと1度タスクを行い、その後アンケートに回答します。

実験は低密度(ターゲットが同時に5つ出現)と高密度(ターゲットが同時に15つ出現)の2つの条件で実施したため、上記のプロセスをラウンド1, 2と2回行っています。

また、実験参加者はエージェントがラウンド1, 2で同じものであることを知らされておらず、さらにエージェントの色はラウンド1, 2で変更されているため、参加者はラウンド1, 2で同じエージェントが割り当てられていることを意識しないように工夫されています。

評価方法

研究では以下の3つの側面から評価を行われました。

- パフォーマンス:人間-AIチームがタスクでどれだけ良いスコアを残したか

- 人間の主観的評価:参加者がエージェントに対して協調性や能力などをどう評価したか

- 人間の嗜好性:参加者がどのエージェントを好んだか

図3. リッカート尺度によるアンケートの文言。HUMAN-AI COLLABORATION: TRADE-OFFS BETWEEN PERFORMANCE AND PREFERENCESより引用。

主観的評価は7段階のリッカート尺度で、チームワーク、能力、貢献度、使いやすさなど、協調性や主観的な体験に関する8項目を取得しています。

結果

パフォーマンス

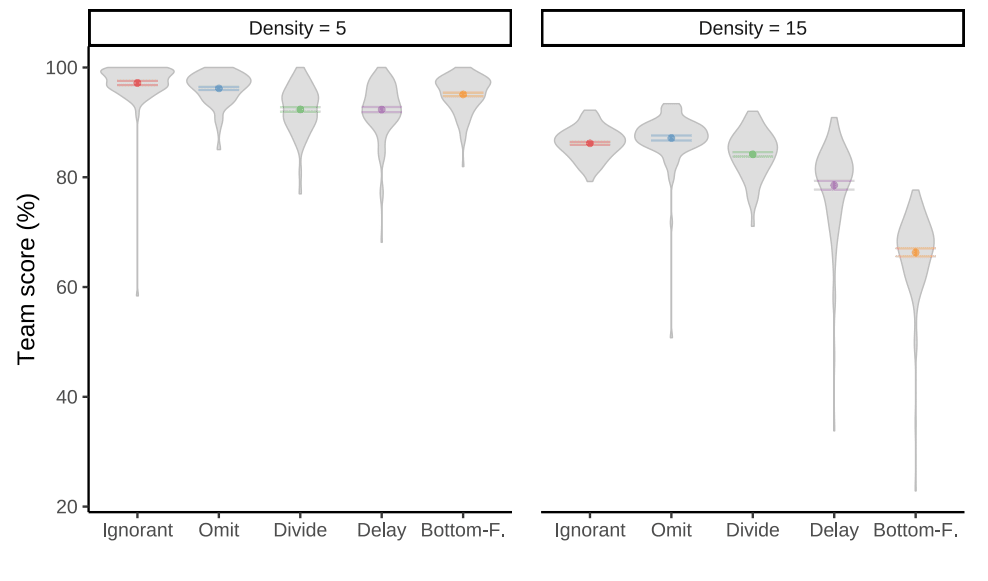

図4. 人とエージェントのスコアの結果。HUMAN-AI COLLABORATION: TRADE-OFFS BETWEEN PERFORMANCE AND PREFERENCESより引用。

こちらの図は、ゲーム中で可能だった得点に対して、プレイヤーとエージェントがどれだけ得点できたかの割合を示しています。そのため、両方を足しても100%にならないことに注意してください。

表より、最も高いパフォーマンスを示したのは無知型エージェントでした。しかし、人のパフォーマンスは最も低くなっています。

それ以外のエージェントでは、低密度環境ではDelay, Divideエージェントと協力した際に、人のパフォーマンスが最も高くなっています。高密度環境では低得点重視エージェントの際に、人のパフォーマンスが最も高くなっています。

図5. 総合スコアの結果。HUMAN-AI COLLABORATION: TRADE-OFFS BETWEEN PERFORMANCE AND PREFERENCESより引用。

全体スコアでは、無知型と省略型がどちらの環境でも高い点数を示しており、低得点重視型は低密度環境ではパフォーマンスが高いですが、高密度環境では顕著にパフォーマンスが低くなっています。

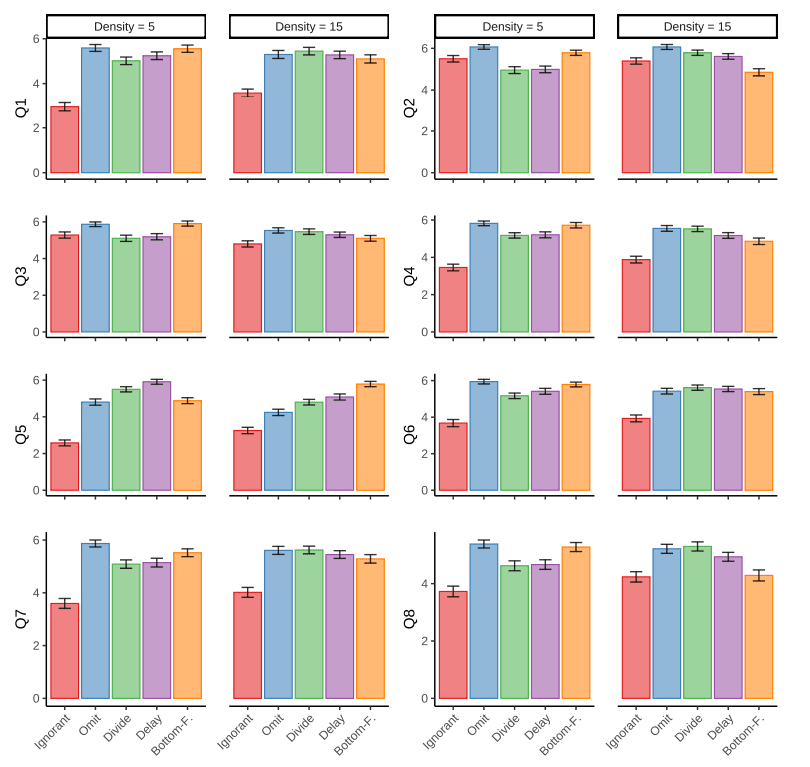

人間の主観的評価

図6. 人間の主観的評価の結果。HUMAN-AI COLLABORATION: TRADE-OFFS BETWEEN PERFORMANCE AND PREFERENCESより引用。

表より、無知型エージェントは、人間からの評価が全般的に低いことがわかります。

また、Q5の「チームのパフォーマンスに貢献した」が、低密度環境では低得点重視エージェントが低い一方で、高密度環境では最も高くなっている点は興味深いと感じます。

パフォーマンス観点では、高密度環境で低得点重視エージェントと組んだ場合に総合点が顕著に低かったため、パフォーマンスと人の主観的な評価は必ずしも一致しないことがわかります。

人間の嗜好性

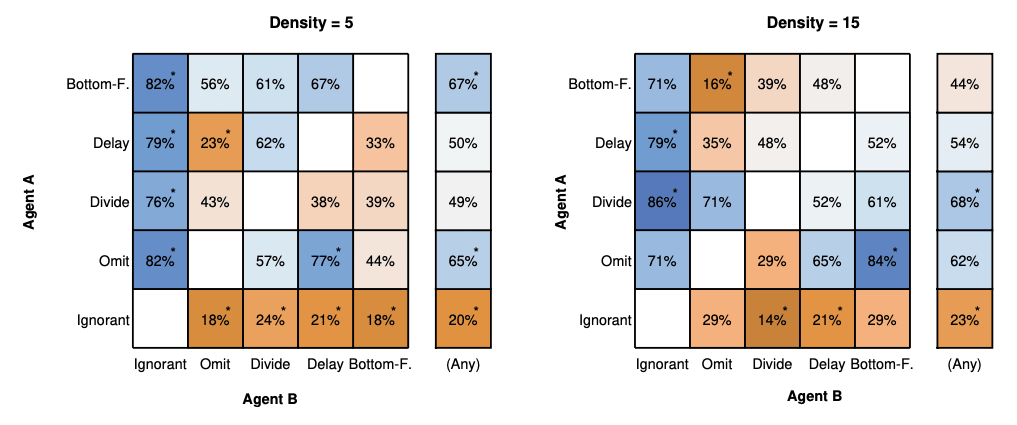

図7. 人間の嗜好性を推定した結果。HUMAN-AI COLLABORATION: TRADE-OFFS BETWEEN PERFORMANCE AND PREFERENCESより引用。

こちらの表は、割り当てられたボットのうちどちらをより好むかの回答結果から、Bradley-Terryモデルを用いて各エージェントの嗜好性の強さを推定した結果です。

表より、環境が同じであればエージェントはエージェントペアの相性にかかわらず嗜好性の傾向が出ると考えられます。

また、低密度環境では省略形エージェントと低密度型エージェントが、高密度環境では分割型エージェントが好まれる傾向を示しています。これは、リソースが成約された環境では単純なエージェントを、リソースが豊富な環境では複雑なエージェントを好む傾向があることを示しているのではないか、と考察されていました。

まとめ

以上、人間-AI協働において「パフォーマンス」と「人間の嗜好性」の両面から検証した研究でした。

結果として、純粋にパフォーマンスを最大化するだけでなく、人間の行動を考慮し、適切なバランスで協力するAIが好まれることが明らかになりました。

今後の研究では、異なるタスクや文化的背景における人間の嗜好性の違いや、長期的な協働における信頼構築プロセスなど、さらなる側面を調査することが期待されます。

また、論文内では各アンケート項目と低/高密度環境の関係性や自由記述での傾向、人とAIのスコア差が大きくなるほど好まれなくなるなど、興味深い内容が多く記載されています。

ご興味ある方は、ぜひ原著もご覧ください。

お知らせ

少しでも弊社にご興味を持っていただけた方は、お気軽にご連絡頂けますと幸いです。まずはカジュアルにお話を、という形でも、副業を検討したいという形でも歓迎しています。

Discussion