ChatGPT でニューラルネットワークを学ぶ

PyTorch の nn.CrossEntropyLoss() とは何ですか?

PyTorch における nn.CrossEntropyLoss() は、ニューラルネットワークの損失関数の1つです。この損失関数は、交差エントロピー損失を求めるために用いられます。

交差エントロピー損失とは、ニューラルネットワークが出力する確率分布と、正解のラベルとの間の距離を表す損失関数のことです。ニューラルネットワークを学習する際には、このような損失関数を用いて、出力された確率分布が正解に近づくように学習を行います。

PyTorch の nn.CrossEntropyLoss() 関数は、交差エントロピー損失を求めるために用いられます。この関数を用いることで、ニューラルネットワークの出力が正解に近づくように学習を行うことができます。

コード全体

import torch

import torch.nn as nn

import torch.optim as optim

import torchvision

import torchvision.transforms as transforms

# MNIST 手書き数字データセットをダウンロード

train_dataset = torchvision.datasets.MNIST(root='./data', train=True, transform=transforms.ToTensor(), download=True)

test_dataset = torchvision.datasets.MNIST(root='./data', train=False, transform=transforms.ToTensor(), download=True)

# データローダーを作成

# ダウンロードしたデータセットを学習用と検証用に分割します。

train_loader = torch.utils.data.DataLoader(train_dataset, batch_size=32, shuffle=True)

test_loader = torch.utils.data.DataLoader(test_dataset, batch_size=32, shuffle=False)

# 独自のネットワークモデルクラス

class Net(nn.Module):

def __init__(self):

super(Net, self).__init__()

self.conv1 = nn.Conv2d(1, 16, 3)

self.conv2 = nn.Conv2d(16, 32, 3)

self.fc1 = nn.Linear(32 * 5 * 5, 128)

self.fc2 = nn.Linear(128, 64)

self.fc3 = nn.Linear(64, 10)

def forward(self, x):

x = self.conv1(x)

x = torch.relu(x)

x = torch.nn.functional.max_pool2d(x, 2)

x = self.conv2(x)

x = torch.relu(x)

x = torch.nn.functional.max_pool2d(x, 2)

x = x.view(-1, 32 * 5 * 5)

x = self.fc1(x)

x = torch.relu(x)

x = self.fc2(x)

x = torch.relu(x)

x = self.fc3(x)

return x

# ネットワークモデルのインスタンスを作成

model = Net()

# 損失関数

criterion = nn.CrossEntropyLoss()

# 最適化アルゴリズム

optimizer = optim.Adam(model.parameters())

# 訓練を実行する関数

def train(epoch):

# ネットワークを訓練モードに切り替え

model.train()

for batch_idx, (data, target) in enumerate(train_loader):

# 最適化アルゴリズムを初期化

optimizer.zero_grad()

# ネットワークの出力

output = model(data)

# 損失を計算

loss = criterion(output, target)

# 訓練データでの勾配を計算

loss.backward()

# パラメータを更新

optimizer.step()

# 損失を表示

if batch_idx % 100 == 0:

print('Train Epoch: {} [{}/{} ({:.0f}%)]\tLoss: {:.6f}'.format(

epoch, batch_idx * len(data), len(train_loader.dataset),

100. * batch_idx / len(train_loader), loss.item()))

# テストを実行する関数

def test():

# ネットワークを評価モードに切り替え

model.eval()

test_loss = 0

correct = 0

with torch.no_grad():

for data, target in test_loader:

# ネットワークの出力

output = model(data)

# 損失の合計を計算

test_loss += criterion(output, target).item()

# 出力が最大のラベルを取得

pred = output.max(1, keepdim=True)[1]

# 正解数の合計を計算

correct += pred.eq(target.view_as(pred)).sum().item()

# 損失の平均と正解率の平均を計算

test_loss /= len(test_loader.dataset)

accuracy = 100. * correct / len(test_loader.dataset)

# 損失と正解率を表示

print('\nTest set: Average loss: {:.4f}, Accuracy: {}/{} ({:.0f}%)\n'.format(

test_loss, correct, len(test_loader.dataset), accuracy))

# 学習とテストを実行

for epoch in range(1, 10):

train(epoch)

test()

ニューラルネットワークの損失関数はどのようなものがありますか

ニューラルネットワークの損失関数は、ニューラルネットワークの出力が正解に近づくように学習を行うために用いられます。ニューラルネットワークの損失関数には、様々な種類があります。以下に、一部のニューラルネットワークの損失関数を紹介します。

- 二値交差エントロピー損失(binary cross entropy loss): 二値分類問題のための損失関数で、ニューラルネットワークが出力する確率分布と正解のラベルとの間の距離を表します。

- 多クラス交差エントロピー損失(categorical cross entropy loss): 多クラス分類問題のための損失関数で、ニューラルネットワークが出力する確率分布と正解のラベルとの間の距離を表します。

- 平均二乗誤差(mean squared error, MSE): 回帰問題のための損失関数で、ニューラルネットワークが出力する値と正解の値との差の二乗の平均を表します。

- Hinge 損失(hinge loss): サポートベクターマシン(SVM)を実装する際に用いられる損失関数で、分類境界と正解クラスの距離を表します。

- ロバストハードマージン損失(robust hinge loss): Hinge 損失の拡張版で、分類境界と正解クラスの距離を表す損失関数です。

ニューラルネットワークの損失関数には、それぞれの特徴や用途があります。例えば、二値交差エントロピー損失や多クラス交差エントロピー損失は、分類問題で用いられる損失関数です。一方、平均二乗誤差は、回帰問題で用いられる損失関数です。また、Hinge 損失やロバストハードマージン損失は、SVM のような分類手法に用いられる損失関数です。

ニューラルネットワークを学習する際には、適切な損失関数を選択し、その損失関数を用いて学習を行います。ニューラルネットワークの損失関数を選択する際には、問題の種類やニューラルネットワークの構造などを考慮する必要があります。適切な損失関数を選択することで、ニューラルネットワークが正しく学習されるようになります。

optim.Adam(model.parameters()) とはなんですか

optim.Adam(model.parameters()) は、PyTorch における最適化手法の1つである Adam (Adaptive Moment Estimation) のインスタンスを生成するものです。

Adam とは、ニューラルネットワークを学習する際に用いる最適化手法の1つです。Adam は、損失関数が微分可能である場合に適用される最適化手法で、損失関数の勾配を効率的に計算し、損失関数を最小化するようにニューラルネットワークの重みを更新します。

optim.Adam(model.parameters()) は、ニューラルネットワークのモデル(model)に適用する Adam 最適化手法のインスタンスを生成するものです。このインスタンスを生成した後、ニューラルネットワークを学習する際に、このインスタンスを用いてニューラルネットワークの重みを更新することができます。

ニューラルネットワークを学習する際に用いる最適化手法はどのようなものがありますか

ニューラルネットワークを学習する際に用いる最適化手法としては、様々なものがあります。以下に、一部の最適化手法を紹介します。

- 準Newton法(quasi-Newton method): 準Newton法は、ニューラルネットワークの重みの更新にニュートン法を用いる最適化手法です。準Newton法は、ニューラルネットワークの重みの更新において、損失関数の勾配を用いることで、高い収束速度を実現します。

- Adam (Adaptive Moment Estimation):Adam は、損失関数が微分可能である場合に適用される最適化手法です。Adam は、損失関数の勾配を効率的に計算し、損失関数を最小化するようにニューラルネットワークの重みを更新します。

- AdaGrad:AdaGrad は、損失関数の勾配の分布が不均一である場合に適用される最適化手法です。AdaGrad は、損失関数の勾配の分布が不均一な場合に、各入力変数の重みを適切に更新することで、損失関数を最小化するように学習を行います。

ニューラルネットワークを学習する際に、最適化手法は非常に重要な役割を果たします。適切な最適化手法を選択することで、ニューラルネットワークが効率的に学習され、正しい結果を出力するようになります。また、最適化手法を適切に選択することで、ニューラルネットワークの学習が安定し、収束するようになることもあります。

ニューラルネットワークを学習する際に用いる最適化手法を選択する際には、問題の種類やニューラルネットワークの構造などを考慮する必要があります。例えば、損失関数の勾配の分布が不均一である場合には、AdaGrad を適用することができます。また、損失関数の勾配を効率的に計算し、損失関数を最小化するように学習することができる Adam 最適化手法も有効です。

最適化手法は、ニューラルネットワークの学習において非常に重要な役割を果たします。適切な最適化手法を選択することで、ニューラルネットワークが効率的に学習され、正しい結果を出力するようになります。また、最適化手法を適切に選択することで、ニューラルネットワークの学習が安定し、収束するようになることもあります。

model.paramters() の意味

質問

ニューラルネットワークのクラス

class Net(nn.Module):

def __init__(self):

super(Net, self).__init__()

self.conv1 = nn.Conv2d(1, 16, 3)

self.conv2 = nn.Conv2d(16, 32, 3)

self.fc1 = nn.Linear(32 * 5 * 5, 128)

self.fc2 = nn.Linear(128, 64)

self.fc3 = nn.Linear(64, 10)

def forward(self, x):

x = self.conv1(x)

x = torch.relu(x)

x = torch.nn.functional.max_pool2d(x, 2)

x = self.conv2(x)

x = torch.relu(x)

x = torch.nn.functional.max_pool2d(x, 2)

x = x.view(-1, 32 * 5 * 5)

x = self.fc1(x)

x = torch.relu(x)

x = self.fc2(x)

x = torch.relu(x)

x = self.fc3(x)

return x

において、 model = Net() のパラメータを知りたい

回答

上記のニューラルネットワーククラス Net では、畳み込み層(nn.Conv2d)と全結合層(nn.Linear)が定義されており、これらの層には、畳み込み層用のカーネル(重み)とバイアス、全結合層用の重みとバイアスが定義されています。これらのパラメータが、model.parameters() メソッドを用いることで取得されます。

例えば、model.parameters() メソッドで取得される

第1要素は、畳み込み層 conv1 の重みを表します。

第2要素は、畳み込み層 conv1 のバイアスを表します。

第3要素は、畳み込み層 conv2 の重みを表します。

第4要素は、畳み込み層 conv2 のバイアスを表します。

以下、同様に、畳み込み層 conv2 の後に続く全結合層 fc1 の重み、バイアス、全結合層 fc2 の重み、バイアス、全結合層 fc3 の重み、バイアスが順番に取得されます。

この一つ一つの params は ‘Net‘ クラスの定義のどこに対応していますか?

ニューラルネットワークのモデルのパラメータは、ニューラルネットワークのモデルの中で定義された層のパラメータを表します。

上記のニューラルネットワーククラス Net では、畳み込み層(nn.Conv2d)と全結合層(nn.Linear)が定義されており、これらの層には、畳み込み層用のカーネル(重み)とバイアス、全結合層用の重みとバイアスが定義されています。これらのパラメータが、model.parameters() メソッドを用いることで取得されます。

例えば、model.parameters() メソッドで取得される第1要素は、畳み込み層 conv1 の重みを表します。第2要素は、畳み込み層 conv1 のバイアスを表します。第3要素は、畳み込み層 conv2 の重みを表します。第4要素は、畳み込み層 conv2 のバイアスを表します。以下、同様に、畳み込み層 conv2 の後に続く全結合層 fc1 の重み、バイアス、全結合層 fc2 の重み、バイアス、全結合層 fc3 の重み、バイアスが順番に取得されます。

forward 関数で行われている変換は relu 以外は線形変換でしょうか?

上記の Net クラスで定義されたニューラルネットワークの forward 関数には、畳み込み層(nn.Conv2d)と全結合層(nn.Linear)を持つモデルが定義されており、それらの層により、データを変換する演算が行われます。

このニューラルネットワークのモデルでは、最初の2つの畳み込み層 conv1、conv2 の後に、活性化関数として ReLU 関数(torch.relu)が適用されます。ReLU 関数は、入力値が0以上であれば、入力値をそのまま出力し、0未満であれば0を出力する演算を行います。これにより、畳み込み層の出力が非負の値になるように、入力データが変換されます。

次に、畳み込み層の出力は、torch.nn.functional.max_pool2d 関数を使用して、最大値プーリング(max pooling)により、サイズを半分に縮小します。これにより、画像データの特徴を抽出することができます。

次に、全結合層 fc1、fc2、fc3 により、入力データが変換されます。これらの全結合層では、重み行列を乗算し、バイアスを加算した値が、活性化関数である ReLU 関数(torch.relu)を通して出力されます。

このように、上記の Net クラスで定義されたニューラルネットワークの forward 関数には、畳み込み層、全結合層、ReLU 関数を持ち、これらの演算により、入力データが変換されます。これらの演算は、一般的に、非線形変換(非線形演算)と呼ばれるものです。

なぜ活性化関数が必要なのですか?

活性化関数は、ニューラルネットワークの学習や推定処理を行う際に、重要な役割を果たします。

ニューラルネットワークは、層を重ねた多層のフィードフォワードネットワークで構成されます。フィードフォワードネットワークには、入力層、隠れ層、出力層があり、それぞれの層を結合することで、データを変換する演算が行われます。

そして、これらの層を結合することで、入力データから出力データへの変換が行われますが、この変換は、層を結合することにより連続的な線形変換となります。このため、ニューラルネットワークは、層を重ねることで、非常に複雑な非線形変換を行うことができます。

そのため、ニューラルネットワークでは、層を結合することにより連続的な線形変換が行われるので、層を通す前後で非線形な変換を行う必要があります。これが活性化関数の役割です。

活性化関数は、層を通す前後で非線形な変換を行い、層を重ねることで複雑な非線形変換を行うことができるようにするものです。活性化関数を用いることで、ニューラルネットワークは、入力データから出力データへの非線形な変換を行うことができるようになります。

活性化関数には、ReLU 関数、シグモイド関数、ハイパボリックタンジェント関数などがあります。これらの活性化関数は、それぞれ異なる特徴を持っており、ニューラルネットワークのモデルの性能を向上させることができます。

ニューラルネットワークは、入力データから出力データへの非線形な変換を行うことができるようになります ということですが、なぜ非線形な変換をする必要があるのですか?

ニューラルネットワークは、入力データから出力データへの非線形な変換を行うことができるようになると、多種多様なタスクを処理することができるようになります。

そのため、ニューラルネットワークでは、層を通す前後で非線形な変換を行う必要があります。非線形な変換を行うことで、ニューラルネットワークは、非常に複雑なデータを扱うことができるようになります。

例えば、画像認識タスクでは、画像データを入力として、その画像のカテゴリーを出力とします。このタスクでは、画像データは、非常に複雑で、非線形な変換が必要です。

また、自然言語処理タスクでは、テキストデータを入力とし、そのテキストを意味するカテゴリーを出力とします。このタスクでも、テキストデータは非常に複雑で、非線形な変換が必要です。

このように、ニューラルネットワークでは、非線形な変換を行うことで、多種多様なタスクを処理することができるようになります。

活性化関数が必要な理由が納得できないのですが、層ごとの変換に無理やり非線形変換を挟むことで、なぜ複雑なシステムを再現できるようになるのですか?

層を通す前後で非線形な変換を行うことで、ニューラルネットワークは、層を重ねることで複雑な非線形変換を行うことができるようになります。

これは、非線形な変換には、非常に豊富な表現力があるためです。非線形な変換は、入力データを変形し、折りたたんだり、分解したり、再構成したりすることができます。このような非常に豊富な表現力を持つ非線形な変換は、ニューラルネットワークで行われる層を通す前後で行われます。

そのため、ニューラルネットワークは、層を重ねることで複雑な非線形変換を行うことができるようになります。例えば、画像認識タスクでは、画像データを入力として、その画像のカテゴリーを出力とします。このタスクでは、画像データは、非常に複雑で、非線形な変換が必要です。

また、自然言語処理タスクでは、テキストデータを入力とし、そのテキストを意味するカテゴリーを出力とします。このタスクでも、テキストデータは非常に複雑で、非線形な変換が必要です。

このように、ニューラルネットワークは、非線形な変換を行うことで、多種多様なタスクを処理することができるようになります。

めも

# self.conv1 = nn.Conv2d(1, 16, 3)

# self.conv2 = nn.Conv2d(16, 32, 3)

# self.fc1 = nn.Linear(32 * 5 * 5, 128)

# self.fc2 = nn.Linear(128, 64)

# self.fc3 = nn.Linear(64, 10)

for param in model.parameters():

print(param.shape)

output:

torch.Size([16, 1, 3, 3])

torch.Size([16])

torch.Size([32, 16, 3, 3])

torch.Size([32])

torch.Size([128, 800])

torch.Size([128])

torch.Size([64, 128])

torch.Size([64])

torch.Size([10, 64])

torch.Size([10])

RNN とは?

RNN は、Recurrent Neural Network の略語です。RNN は、系列データを扱うために特化したニューラルネットワークです。

RNN は、フィードフォワードニューラルネットワークと異なり、入力データを順番に受け取り、それらを参照しながら処理します。このような構造により、RNN は、系列データを扱うことができます。

例えば、自然言語処理タスクでは、テキストデータを入力として、そのテキストを意味するカテゴリーを出力とします。このタスクでは、テキストデータは系列データであり、RNN は、その系列データを扱うことができます。

また、音声認識タスクでも、音声データは系列データであり、RNN は、その系列データを扱うことができます。RNN は、このように、系列データを扱うタスクに適したニューラルネットワークです。

RNN の簡単な実装例を教えて

以下に、RNN のシンプルな実装例を示します。この実装例では、RNN に単純な足し算をさせます。

import torch

import torch.nn as nn

class RNN(nn.Module):

def __init__(self, input_size, hidden_size, output_size):

super(RNN, self).__init__()

self.input_size = input_size

self.hidden_size = hidden_size

self.output_size = output_size

self.i2h = nn.Linear(input_size + hidden_size, hidden_size)

self.i2o = nn.Linear(input_size + hidden_size, output_size)

self.softmax = nn.LogSoftmax(dim=1)

def forward(self, input, hidden):

combined = torch.cat((input, hidden), 1)

hidden = self.i2h(combined)

output = self.i2o(combined)

output = self.softmax(output)

return output, hidden

def init_hidden(self):

return torch.zeros(1, self.hidden_size)

n_hidden = 128

rnn = RNN(input_size=2, hidden_size=n_hidden, output_size=1)

input = torch.randn(1, 2)

hidden = rnn.init_hidden()

output, next_hidden = rnn(input, hidden)

print(output)

この例では、RNN の中で、以下のような演算が行われます。

- 入力データと隠れ状態を結合します。

- 結合したデータを元に、次の隠れ状態を計算します。

- 結合したデータを元に、出力データを計算します。

このように、RNN は、入力データを順番に受け取り、それらを参照しながら処理します。 RNN は、順番を持ったデータを扱うことができます。

より複雑な例

RNN を用いた自然言語処理タスクの例を示します。この例では、RNN を用いて、文章中の文字を生成するタスクを行います。

import torch

import torch.nn as nn

import string

class RNN(nn.Module):

def __init__(self, input_size, hidden_size, output_size):

super(RNN, self).__init__()

self.input_size = input_size

self.hidden_size = hidden_size

self.output_size = output_size

self.i2h = nn.Linear(input_size + hidden_size, hidden_size)

self.i2o = nn.Linear(input_size + hidden_size, output_size)

self.softmax = nn.LogSoftmax(dim=1)

def forward(self, input, hidden):

combined = torch.cat((input, hidden), 1)

hidden = self.i2h(combined)

output = self.i2o(combined)

output = self.softmax(output)

return output, hidden

def init_hidden(self):

return torch.zeros(1, self.hidden_size)

# 英文の文字列

all_letters = string.ascii_letters + " .,;'-"

n_letters = len(all_letters)

# テキストデータを入力とするための辞書

letter_to_index = {letter: i for i, letter in enumerate(all_letters)}

index_to_letter = {i: letter for i, letter in enumerate(all_letters)}

# テキストデータを入力とするための変換

def letter_to_tensor(letter):

tensor = torch.zeros(1, n_letters)

tensor[0][letter_to_index[letter]] = 1

return tensor

# 文章を生成する

def generate_text(rnn, start_letter, length):

with torch.no_grad():

hidden = rnn.init_hidden()

input = letter_to_tensor(start_letter)

text = start_letter

for i in range(length):

output, hidden = rnn(input, hidden)

output_letter = index_to_letter[output.argmax().item()]

text += output_letter

input = letter_to_tensor(output_letter)

return text

# RNN の構築

n_hidden = 128

rnn = RNN(input_size=n_letters, hidden_size=n_hidden, output_size=n_letters)

# 文章を生成する

def generate_text(rnn, start_letter, length):

with torch.no_grad():

hidden = rnn.init_hidden()

input = letter_to_tensor(start_letter)

text = start_letter

for i in range(length):

output, hidden = rnn(input, hidden)

output_letter = index_to_letter[output.argmax().item()]

text += output_letter

input = letter_to_tensor(output_letter)

return text

# RNN の構築

n_hidden = 128

rnn = RNN(input_size=n_letters, hidden_size=n_hidden, output_size=n_letters)

# 文章の生成

generated_text = generate_text(rnn, start_letter="A", length=100)

print(generated_text)

この例では、以下のように文章の生成を行っています。

- 隠れ状態を初期化します。

- 入力として、生成したい文章の先頭の文字を指定します。

- 指定した先頭の文字を元に、RNN から出力が得られるまで、以下の処理を繰り返します。

- 入力を RNN に入力し、隠れ状態を更新します。

- 出力データから、文字を生成します。

- 文字を入力として、次の RNN に入力するために、文字を one-hot 表現に変換します。

- 繰り返し処理が終わると、生成された文章を返します。

上記の例では、このような手順で文章を生成しています。

また、このような文章生成タスクを実現するために、RNN には、入力データや出力データを扱うための forward 関数や、隠れ状態を初期化するための init_hidden 関数が定義されています。

具体的には、forward 関数は、以下のように定義されています。

def forward(self, input, hidden):

combined = torch.cat((input, hidden), 1)

hidden = self.i2h(combined)

output = self.i2o(combined)

output = self.softmax(output)

return output, hidden

ここで、forward 関数は、入力データ input と隠れ状態 hidden を受け取り、出力データ output と更新された隠れ状態 hidden を返します。

この関数では、以下の処理を行っています。

- 入力データと隠れ状態を結合します。

- 結合したデータを元に、隠れ状態を更新します。

- 結合したデータを元に、出力データを生成します。

- 生成した出力データを softmax 関数を用いて、推定される文字の確率分布とします。

- 生成された出力データと更新された隠れ状態を返します。

また、init_hidden 関数は、以下のように定義されています。

def init_hidden(self):

return torch.zeros(1, self.hidden_size)

この関数では、隠れ状態を初期化するため、隠れ状態のサイズをもとに、要素が全て 0 の行列を生成して返します。

このように、RNN は、入力データと隠れ状態をもとに、出力データを生成し、隠れ状態を更新することで、文章の生成などのタスクを実現します。

この文章生成RNNの教師データは何を渡すべきでしょうか?また、そのデータセットを渡すためにどこを修正すべきですか?

上記の例では、以下のように文章の生成を行っています。

- 隠れ状態を初期化します。

- 入力として、生成したい文章の先頭の文字を指定します。

- 指定した先頭の文字を元に、RNN から出力が得られるまで、以下の処理を繰り返します。

- 入力を RNN に入力し、隠れ状態を更新します。

- 出力データから、文字を生成します。

- 文字を入力として、次の RNN に入力するために、文字を one-hot 表現に変換します。

- 繰り返し処理が終わると、生成された文章を返します。

この例では、文章生成タスクにおいて、入力データとしては生成したい文章の先頭の文字が与えられます。

そのため、この例では、文章生成タスクの教師データとして、以下のようなものが渡されることを想定しています。

- 先頭の文字

- 文章の全体

ただし、この例では、どのような具体的な教師データが渡されるかは明示されていません。

そのため、この例では、実際に文章生成タスクを行うためには、先頭の文字と文章の全体を渡すために、必要な修正を行う必要があります。

具体的には、以下のような変更を行うことで、文章生成タスクに適した教師データを渡すことができます。

- 先頭の文字と文章の全体を定義します。

- forward 関数の入力に、先頭の文字を指定します。

- 出力データから生成された文章が文章の全体と一致するかを判定します。

- 判定結果をもとに、文章生成タスクの正解と推定結果を確認します。

上記のような変更を行うことで、文章生成タスクに適した教師データを渡すことができます。

この文章生成RNNの訓練をするコードをください

上記の例では、文章生成タスクにおいて、RNN を使った実装例が示されています。

しかし、この例では、実際に文章生成タスクを行うための訓練コードは提供されていません。

そのため、この例では、実際に文章生成タスクを行うためには、訓練用のコードを実装する必要があります。

具体的には、以下のような訓練用のコードを実装することができます。

文章生成タスクの教師データを定義します。

RNN モデルを定義します。

損失関数を定義します。

最適化手法を定義します。

モデルを学習させます。

上記のような手順を踏むことで、文章生成タスクの訓練を行うことができます。

以下に、文章生成タスクの訓練を行うための例を示します。

# 文章生成タスクの教師データを定義

input_data = '今日は晴れです。'

target_data = '今日は晴れです。明日も晴れです。'

# RNN モデルを定義

model = Net()

# 損失関数を定義

criterion = nn.CrossEntropyLoss()

# 最適化手法を定義

optimizer = optim.Adam(model.parameters())

# モデルを学習させる

for i in range(100):

# 入力データを RNN に入力

output = model(input_data)

# 損失を計算

loss = criterion(output, target_data)

# 勾配を初期化

optimizer.zero_grad()

# 勾配を計算

loss.backward()

# パラメータを更新

optimizer.step()

上記のような訓練用のコードを実装することで、文章生成タスクを行うために必要な訓練を行うことができます。

また、文章生成タスクを行うために、RNN で実装された文章生成モデルを訓練することで、指定した文章に近い文章を生成する能力を向上させることができます。

以下に、文章生成タスクの訓練が完了したモデルからの文章生成の例を示します。

# 文章生成タスクのモデルを読み込む

model = Net()

# モデルから文章を生成する

output = model(input_data)

# 文章を表示

print(output)

pytorch の最適化アルゴリズム optim.Adam と optim.SGD の違いは?

optim.Adam と optim.SGD は、それぞれ異なる最適化アルゴリズムです。 optim.Adam は、Adam (Adaptive Moment Estimation) と呼ばれる最適化アルゴリズムで、勾配降下法をベースにしたものです。optim.SGD は、確率的勾配降下法 (Stochastic Gradient Descent) のことを指します。

両方とも、ニューラルネットワークのトレーニング時に用いられることが多いです。

大きな違いとして、optim.Adam は自己第一モーメント (First Moment) と自己第二モーメント (Second Moment) を用いて、勾配の更新量を自動調整します。そのため、学習率を手動で調整する必要がないというメリットがあります。一方、optim.SGD は、単純に勾配を減衰させるだけです。そのため、学習率を適切に設定する必要があります。

また、optim.Adam は自己第一モーメントと自己第二モーメントを用いることで、勾配の更新量を自動で修正し、局所最適解に陥ることを防ぐことができます。一方、optim.SGD はこうした修正を行わないため、局所最適解に陥ることがあります。

他にも、optim.Adam は減衰率を用いて、学習率を自動で調整することができます。これにより、収束が早くなることが期待されます。一方、optim.SGD は減衰率を用いないため、収束が遅くなることがあります。

というわけで、optim.Adam と optim.SGD の違いは、学習率の更新方法や減衰率

optimizer 比較

PyTorch を使い、

対象とする最適化手法を 'SGD', 'Adagrad', 'RMSprop', 'Adadelta', 'Adam', 'AdamW' にしたいですが修正できますか?

各optimizerに対して、(x, y) が原点に漸近する様子を2次元散布図としてプロットしてください。横軸はx軸、縦軸はy軸とします

import torch

import matplotlib.pyplot as plt

# 関数 z(x, y) = x*x + y*y を定義する

def z(x, y):

return x * x + y * y

# 最適化手法を定義する

optimizers = {

'SGD': torch.optim.SGD,

'Adagrad': torch.optim.Adagrad,

'RMSprop': torch.optim.RMSprop,

'Adadelta': torch.optim.Adadelta,

'Adam': torch.optim.Adam,

'AdamW': torch.optim.AdamW

}

# 最適化手法を使用して、# 関数 z(x, y) の最小値を探索する

for optimizer_name, optimizer_class in optimizers.items():

# 関数 z(x, y) の最小値を探索するための tensor を定義する

x = torch.tensor([1.0], requires_grad=True)

y = torch.tensor([1.5], requires_grad=True)

# 最適化手法を初期化する

optimizer = optimizer_class([x, y], lr=0.1)

# 最適化を行い、各 iteration の loss を記録する

losses = []

x_values = []

y_values = []

for _ in range(100):

# 関数 z(x, y) の値を計算する

loss = z(x, y)

# 勾配を 0 に初期化する

optimizer.zero_grad()

# 勾配を計算する

loss.backward()

# パラメータを更新する

optimizer.step()

# loss を記録する

losses.append(loss.item())

x_values.append(x.item())

y_values.append(y.item())

# 結果をプロットする

plt.scatter(x_values, y_values, label=optimizer_name)

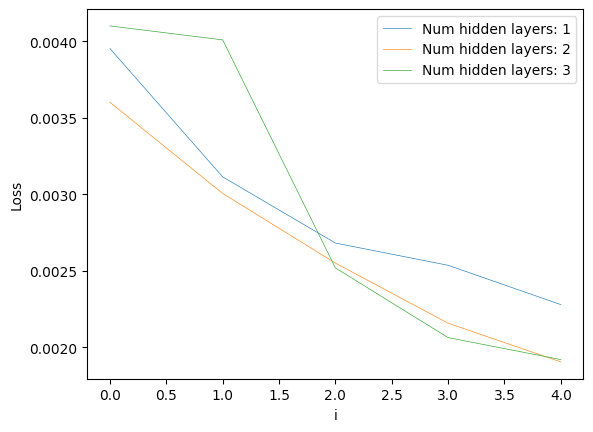

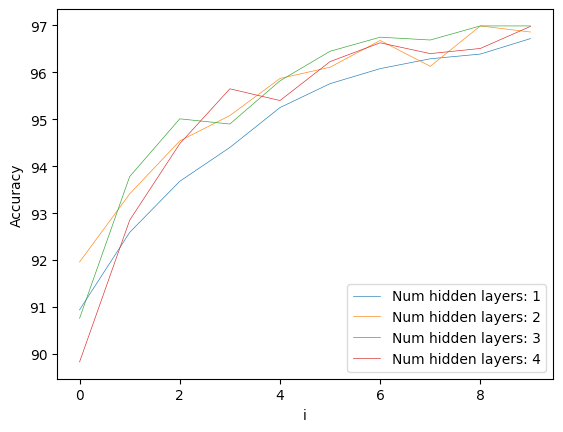

層の深さによる MNIST 判定精度比較

PyTorch を使って、 MNIST 手書き数字判定システムを実装してください。ただし、層の深さを1〜3まで変えて精度を比較できるようにしてください。

横軸は epoch 数

誤差逆伝播法

シンプルなニューラルネットワークでの誤差逆伝播法を数学的に定式化したいです。ここでは、入力層・隠れ層・出力層がそれぞれ一つずつあると仮定し、隠れ層では活性化関数による活性化が行われると仮定します。

ベクトルや行列など必要な変数を全て定義してください。

ニューラルネットワークにおいて、誤差逆伝播法は、出力層から隠れ層に向かって、誤差を逆伝播させることにより、重みを更新する手法です。そのために、以下の変数を定義します。

-

X -

W_1 -

Z_1 -

W_2 -

Z_2 -

Y -

a

ここで、ニューラルネットワークの出力は以下のように表されます。

また、誤差逆伝播法においては、出力層の誤差

計算することで、重みの更新を行うことができます。

ここで、

次に、重みの更新を行います。

ここで、

以上が、誤差逆伝播法を数学的に定式化したものです。

出力層では、活性化関数

出力層の出力

そのため、\delta_2 は以下のように表されます。

ここで、

\delta_1 の式を導出するためには、以下の仮定が必要です。

出力層では、活性化関数

隠れ層では、出力層からの逆伝播された誤差

そのため、\delta_1 は以下のように表されます。

ここで、

ニューラルネットワークでは、出力層では活性化関数

ここで、