⚙️

Azure Data Factoryの構成ファイルをJsonで出力するツール

Azure Data Factoryとはなにか

Azure Data Factory(ADF)は、クラウドベースのデータ統合サービスであり、さまざまなデータソースからデータを収集し、変換、ロードするETL(Extract, Transform, Load)プロセスを自動化できます。企業が異なるデータソース間でデータを移行・統合する際に非常に便利なツールです。

主なユースケース

- データ移行: オンプレミスからクラウドへのデータ移行。

- データ統合: 異なるシステムからのデータ統合と分析のためのデータ準備。

- データ変換: 複数のデータソースからのデータを加工し、ターゲットシステムに適した形式に変換。

メリット

- 拡張性: 大規模なデータセットにも対応可能。

- 柔軟性: 多様なデータソースとターゲットのサポート。

- 統合: Azureの他のサービスとの統合が容易。

デメリット

- 学習曲線: 機能が豊富なため、習得には時間がかかる場合がある。

- コスト: 使用量に応じた従量課金制で、複雑なパイプラインを構築するとコストが増加する可能性がある。

Azure Data Factoryの構成

Azure Data Factoryは、主に以下の構成要素で成り立っています。

- Pipeline: データ処理の一連のタスクをまとめたもの。

- DataFlow: 大規模なデータの変換や加工を行うための視覚的なデータ変換ツール。

- DataSet: データの入力元や出力先を定義するデータ構造。

- Linked Service: データソースやターゲットシステムとの接続情報を保持する設定。

- Trigger: パイプラインをスケジュールやイベントに基づいて実行するための仕組み。

これらの構成要素を適切に設定することで、データの抽出、変換、ロード(ETL)プロセスを自動化し、効率的なデータ統合を実現します。

ツールについて

この記事では、Azure Data Factoryで構築されたパイプラインやDataFlow、DataSetなどの構成要素をJsonファイルとして出力するツールを実装しました。このツールを使用することで、Pipeline、DataFlow、DataSetなどの単位でJsonファイルを生成することでバージョン管理やドキュメント化を容易になります。

使い方

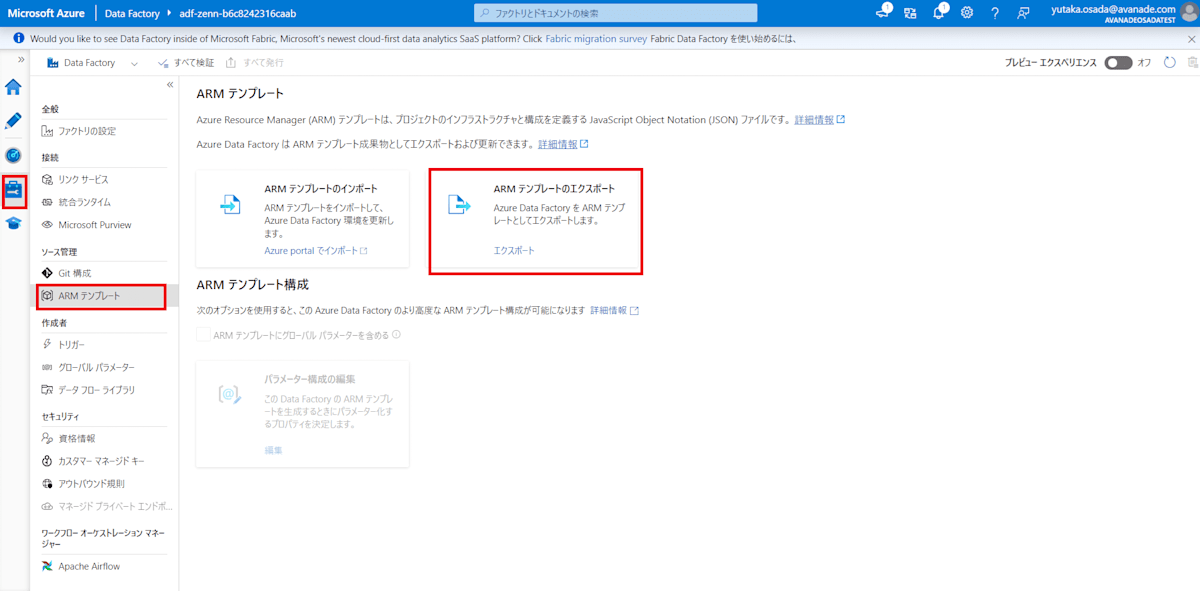

①Data Factory Studio>管理>ARMテンプレート>ARMテンプレートのエクスポート

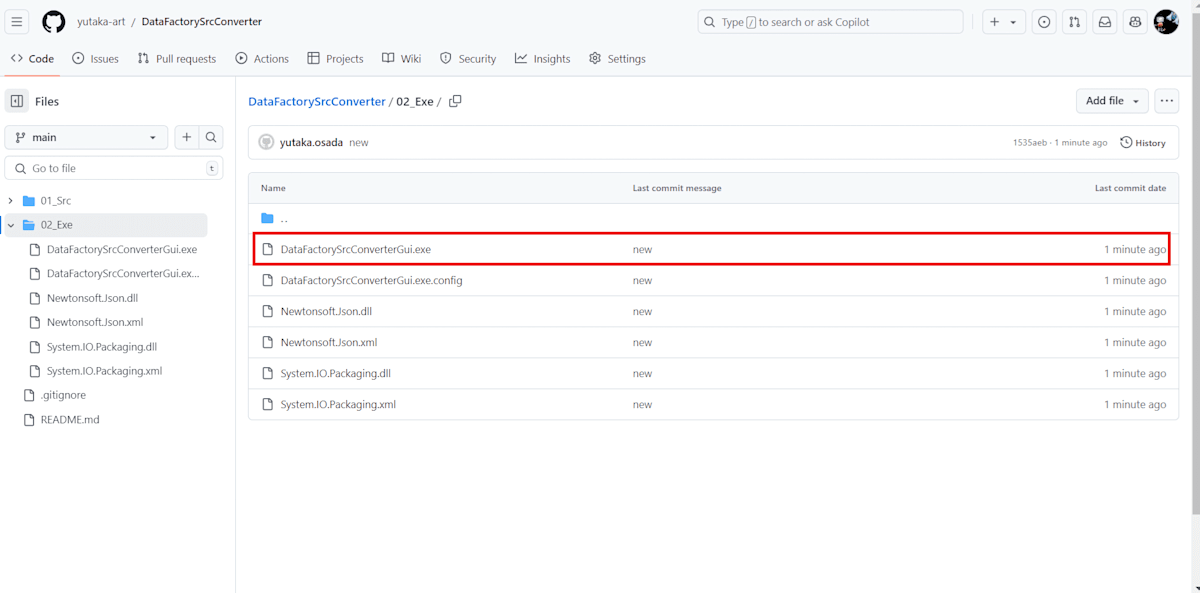

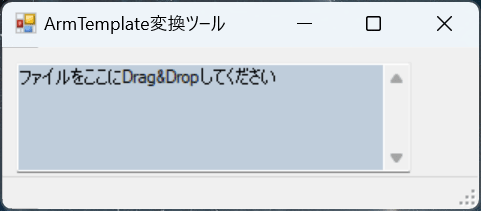

②ツールを起動

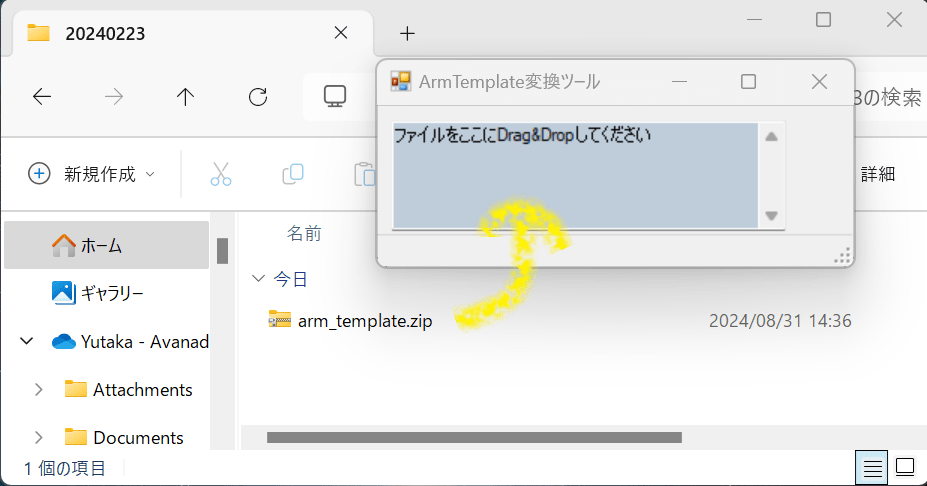

③[①]出力された圧縮ファイルをそのままツールへドラッグ&ドロップ

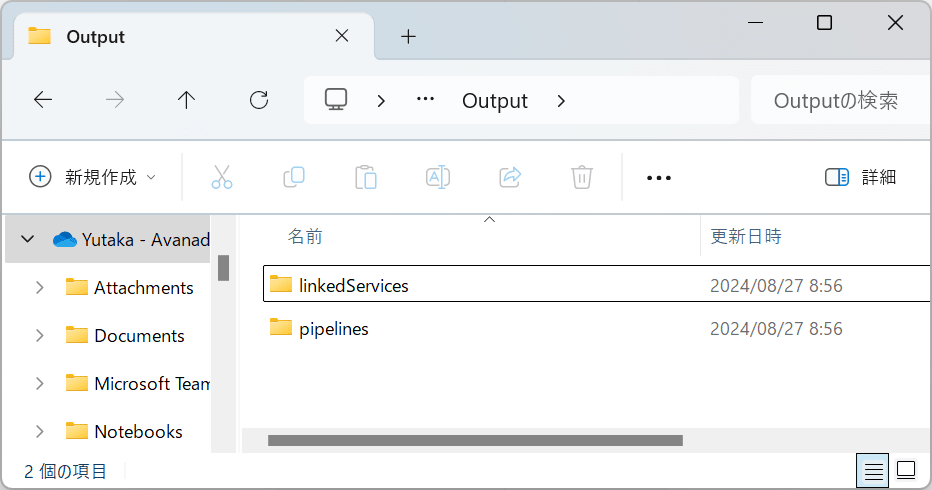

④結果出力

※例は、pipelineしかありませんが、DataFlowやDatasetも出力します。

References

Discussion