MacBook Air で gpt-oss を動かす

gpt-oss とは

gpt-oss は、2025年8月5日に OpenAI からリリースされた、オープンウェイト言語モデルです。Apache 2.0 License と USAGE_POLICY に基づき、商用利用が可能となっています。

2025年8月 現在、gpt-oss-120b と gpt-oss-20b の2つのモデルが公開されています。gpt-oss-120b は 80GB GPU(NVIDIA H100またはAMD MI300Xなど)を備えたサーバー向けです。一方、gpt-oss-20b は 16GB メモリ(RAM)内で動作可能であり、MacBook Air などの Laptop PCでも手軽に利用できるようになっています。

なぜ gpt-oss-20b は GPU がなくても快適に動かせるのかというと、様々な工夫によるものと思われますが、その一つとして MXFP4 quantization という量子化技術が関係しているようです。MXFP4 quantization は、従来の32ビット浮動小数点数の代わりに、4ビットでモデルの重みを表現することで、メモリ使用量を大幅に削減しつつ、推論速度を向上させることができるそうです。(間違っていたらすみません)

MacBook Air で gpt-oss-20b を動かしてみる

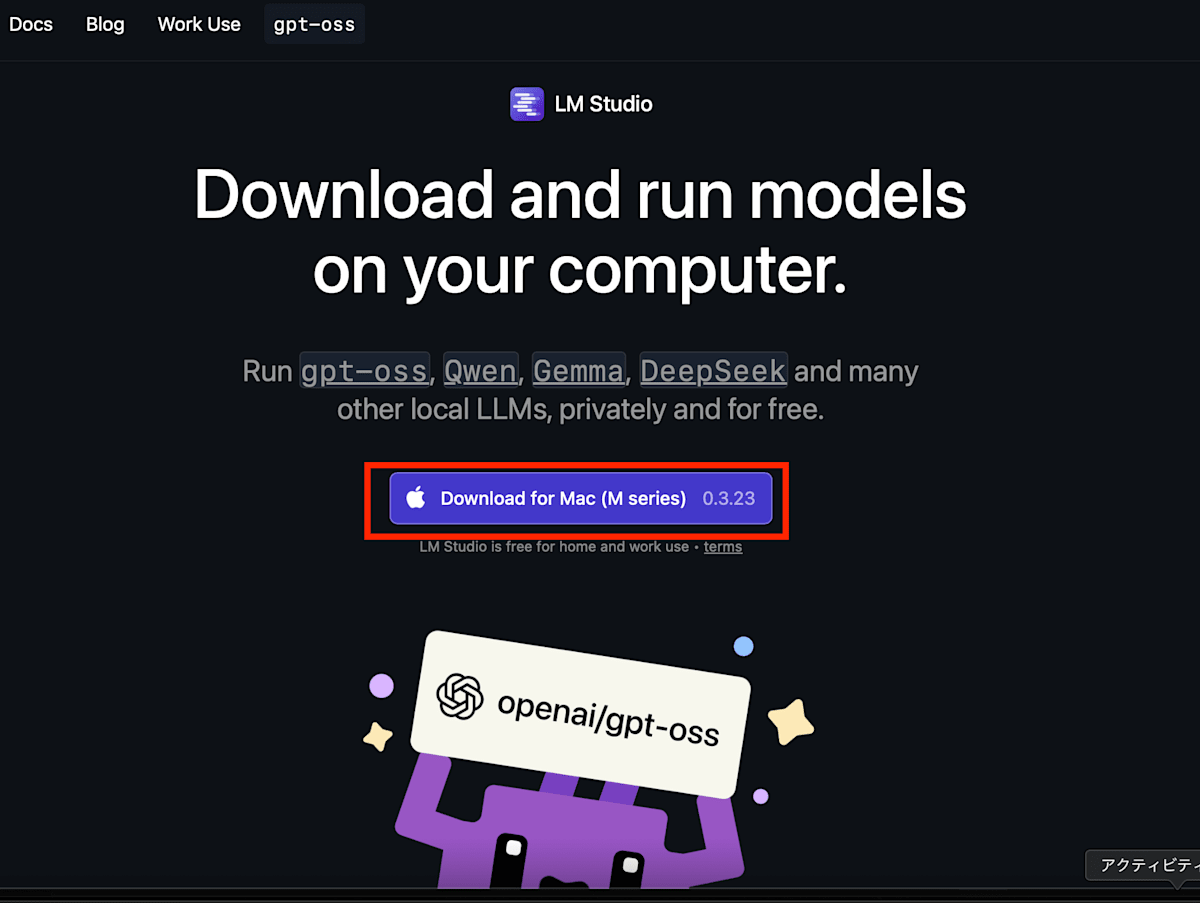

LLM を動かすためには 推論サーバー(Inference Server) が必要です。今回は、OpenAI のサイトでも紹介されている LM Studio を使ってみます。

LM Studio は、自分のコンピュータ上でLLMの開発や実験を行うことができるデスクトップアプリケーションです。

米 Element Labs によって提供されており、個人だけでなく商用でも無料で利用可能なツールとなっています。

gpt-oss の GitHub リポジトリでは、LM Studio のほかに Ollama や vLLM などを使う方法も紹介されているので、そちらの方が好みな場合は参考にしてみてください。

それでは早速 gpt-oss を動かしてみましょう。

今回の環境

- MacBook Air (Apple M4, 24GB RAM)

- macOS Sequoia 15.6

- LM Studio 0.3.23

LM Studio のセットアップと gpt-oss のダウンロード

LM Studio の公式サイトからアプリケーションをダウンロードし、インストールします。

ダウンロードが完了したらファイルを起動し、LM Studio.app を Applications にドラッグ&ドロップしてインストールします。

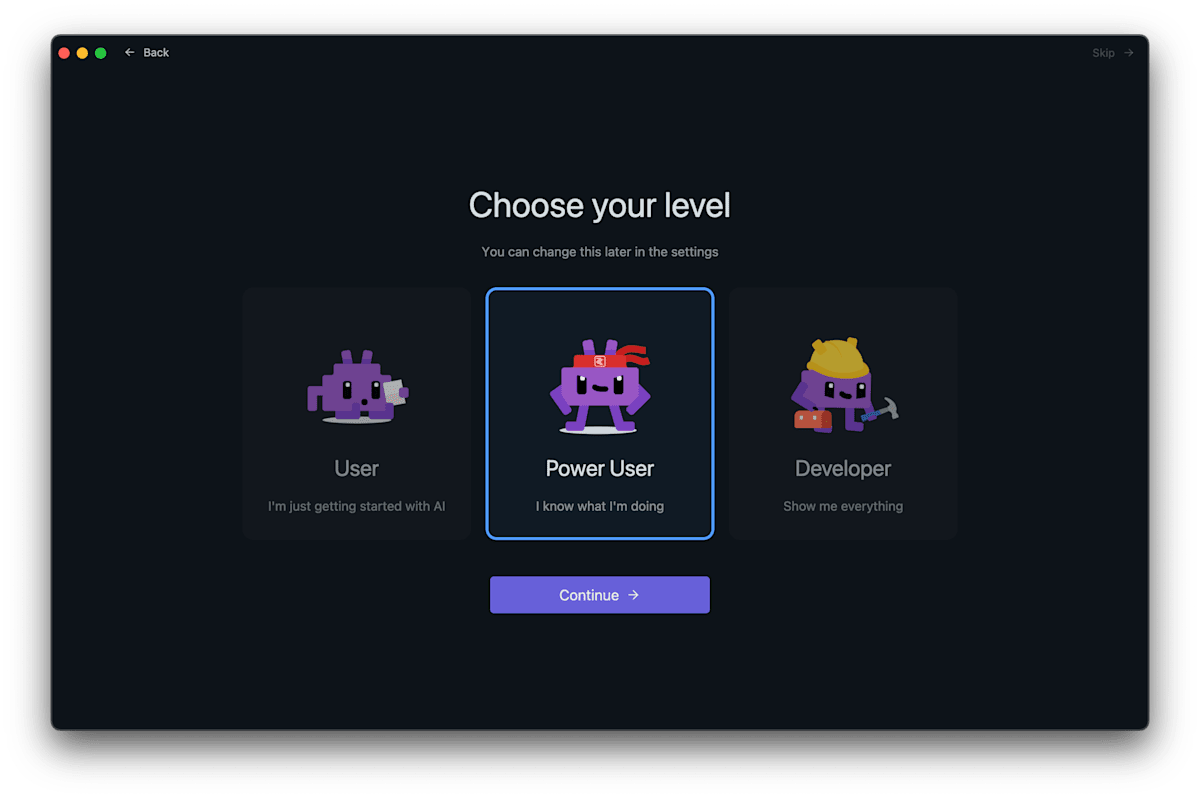

Choose your level は好きなものを選びます。

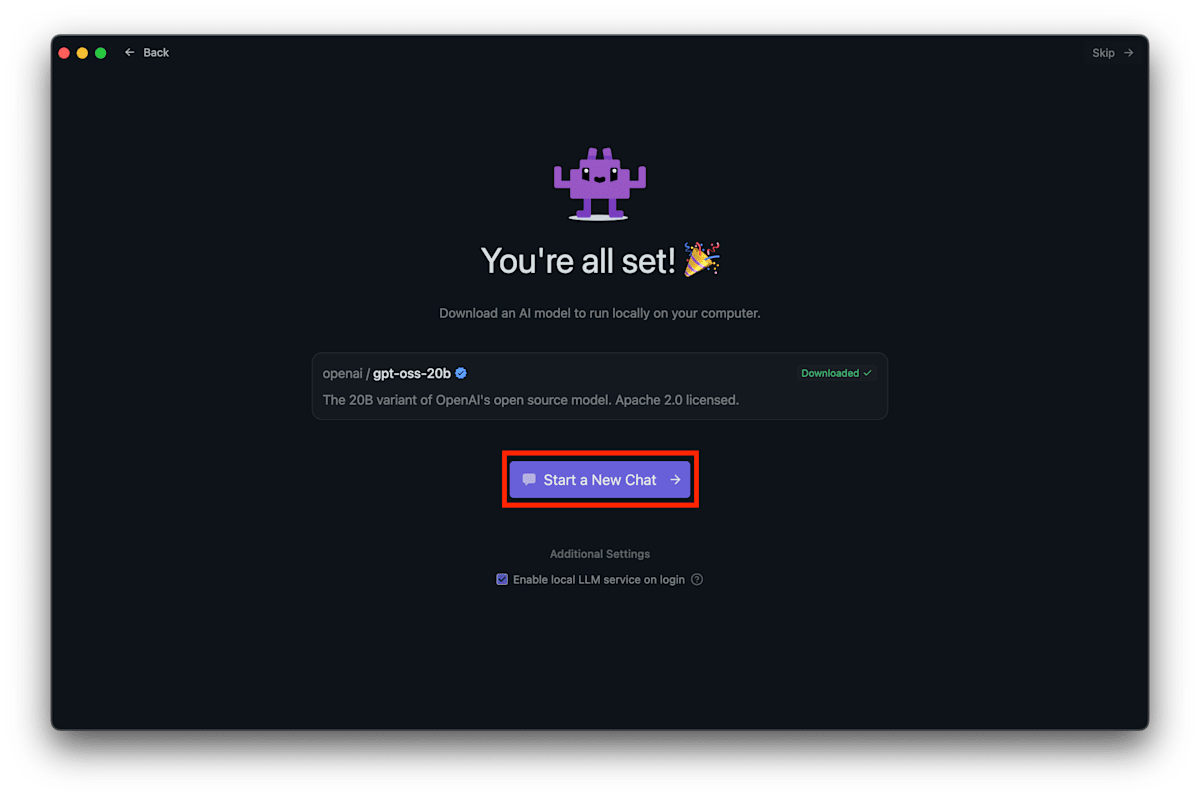

セットアップの際に gpt-oss-20b もダウンロードできるようなので、ダウンロードします。

gpt-oss-20b のダウンロードが完了すると、LM Studio でチャットを開始することができました。

私の環境の場合、爆速とまでは行かないですが、人間が読むよりは速いスピードで回答が生成されました。日本語での回答も良好で、十分実用に耐えられそうだと感じました。ただ、短く終わる時にはサクッと終わるのですが、解説し始めると中々終わらず、興味があることには饒舌なオタク君のような一面も持っているなと感じました。この辺りはパラメータの設定次第で変わるかもしれません。

また、 gpt-oss には reasoning_effort の設定があり、レイテンシとパフォーマンスをトレードオフする3種類の推論レベル(低、中、高)を選択することができます。

LM Studio のチャット画面でも、このボタンで reasoning_effort を変更できました。 High にすると、時間をかけてよく考えてくれるようになります。

なお、推論を行なっているときの MacBook のアクティビティモニタを確認すると、GPU も利用されているようでした。

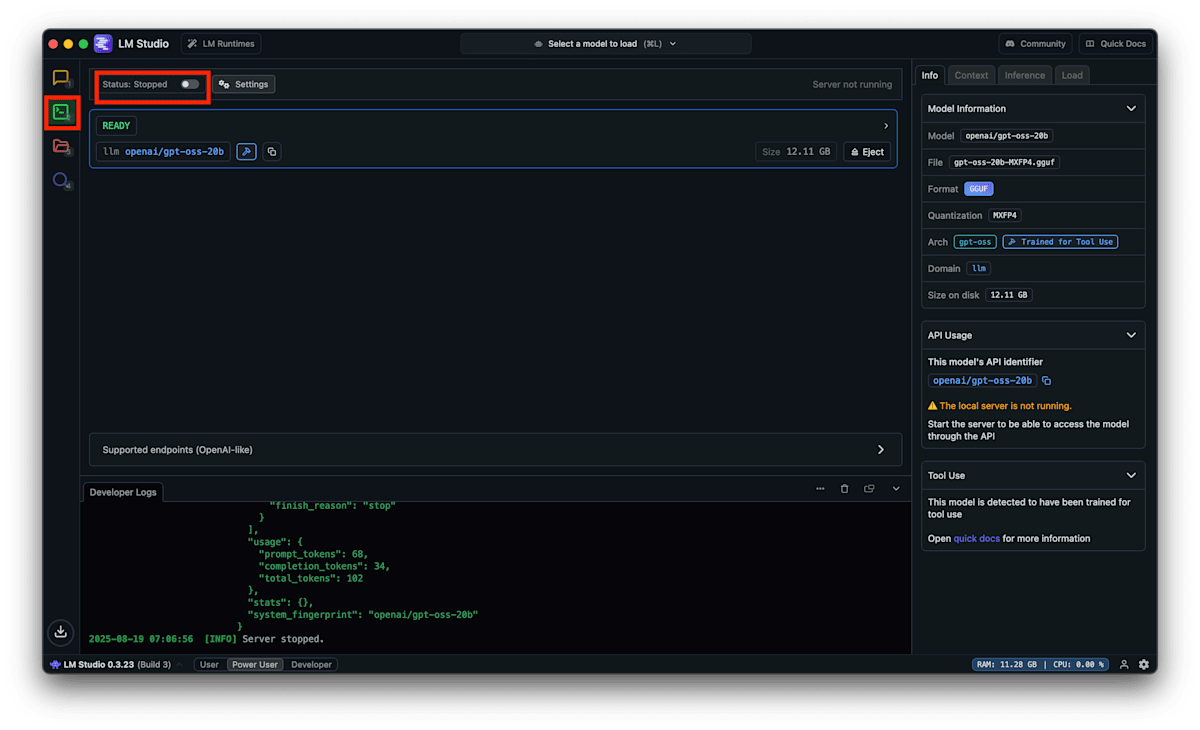

gpt-oss を API で利用する

LM Studio では、ロードしたモデルを API で利用することもできます。API を有効にするには、LM Studio の Developer 画面から Status をオンにします。

HTTP server が立ち上がったので、curl コマンドを使ってリクエストを送信してみます。そのコマンド自体を gpt-oss に作ってもらいます。

入力

OpanAI API を Curl で呼び出すコマンドを簡潔に教えてください。

サーバー: http://127.0.0.1:1234

モデル: openai/gpt-oss-20b

API認証なし

2つほどコマンドを作成してくれましたが、1つ目のコマンドで問題なさそうなので、ターミナルにそのままコピペして実行してみます。

curl http://127.0.0.1:1234/v1/chat/completions \

-X POST \

-H "Content-Type: application/json" \

-d '{

"model":"openai/gpt-oss-20b",

"messages":[{"role":"user","content":"こんにちは"}]

}'

無事に API のレスポンスが帰ってきました。

Chat Completions API の参考

まとめ

MacBook 上で gpt-oss-20b を動かすことができました。LM Studio を使うことで、簡単に利用を開始でき、API としての利用も可能でした。

gpt-oss はローカルで動かせるほどの小ささにも関わらず、十分な性能を持っており、商用利用も可能な点が魅力的です。クラウドに送信できない機密情報を取り扱う場合や、通信が難しい環境での活用など、様々なシーンでの利用が期待できます。

Discussion