Media over QuicTransport(MOQT)動向まとめ

IETFのサイトにMedia over QUICに関連するInternet-Draftやinterim Meetingの予定が纏まっている。

前回のinterim-meeting(vol.13)

2023/10/06に開催された。

スライド・議事録はあるが録画は無し。

draft-ietf-moq-requirements-02が 2023/09/29に発行。

- vol1との違いについて整理

-

Handling Scalable Video Codecsセクションの追加- SVCの使う場合、拡張レイヤは前のベースレイヤだけでなく前の拡張レイヤにも依存する。あるオブジェクトを削除すると、依存関係にある全てのオブジェクトが使えなくなる。AV1のドキュメントでも、複雑な依存関係が図示されているため厄介な部分。

- 依存関係をオブジェクトのプロパティとしてエンコードし、その依存関係をクリアできる場合にのみデコードできるようにすることもできるが、relayが複雑になるため、

linear approachが望ましいと考えている。(linear approachは、依存関係をグラフではなく線形で表すこと?)

-

Application choise for orderingセクションの追加- アプリケーションは

frame rate firstかdefinition firstかを選択できる- フレームレート優先か画質優先か

- (感想) WebRTCでは、フレームレートと画質の優先度が厳密に決められなかったが、MOQTでは制御できるらしい。風景を流すか人物の映像を流すかアニメーションを流すかで求める形が異なると思われるので、この制御は素晴らしいが、アプリケーション側でこれを指示できるようにするのはちょっと大変そうだ

- 「最低でも720p@15fps、可能であれば30fpsを確保するようにし、その上でさらに利用可能な帯域幅があれば1080pで60fpsを目指す」といった、非常に高度な制御が可能。

- アプリケーションは

-

Linear ordering using prioritiesセクションの追加- オブジェクト番号とオブジェクト優先順位の組み合わせを使って依存関係を表現する。(具体例あり)

- オブジェクト番号とオブジェクト優先順位はpublisherによって決定され、relay部分で変更はされない

- (感想) Internet Draftなのでどうなるかわからないが、MUSTになるのかな

-

Intervals and congestionセクションの追加- オブジェクトの依存関係にはルールが仕様上設定される。このルールによってリレーや他ノードでのリアルタイムな輻輳制御が可能になる。

- 欠点は、drop priority(不要な場合にパケットを落とす) を持つパケットが実際にドロップされた場合、同じグループ内のシーケンス番号が大きく、drop priorityが高いか等しいオブジェクトを全て落とさなければいけなくなること

- (感想) SVCの時は特に依存関係が複雑なので、どのパケットを落とすかのdrop priorityはかなり綿密に決められてないとバグりそう。

-

Relay behaviorセクションの追加- 輻輳発生時に、relayはオブジェクトの優先順位を用いてオブジェクトをドロップさせる。relayが輻輳の発生を検知し、オブジェクトをドロップさせる方法を持っていることが前提となっている

- (感想1) WebRTCにおけるTURNではない。TURNはRTPパケットの中身を見て制御したりしないため

- (感想2) WebRTCにおけるSFUはSFU単体でオブジェクト選択してドロップさせたりはしていない(多分)ため、あくまで輻輳制御して流すパケット量を変更するのはpublisherなので、WebRTCにおけるSFUがこれをできるのであればかなり効率が良さそう。WebRTCではpub->SFU->subという都合上、pubが制御するのはpub <- SFU間のレイテンシ分遅延しそうだから。

- また、間のrelayのところでデータをキャッシュすることができると、再送要求の遅延が短くなるだろう。WebRTCはCDN的な、「ユーザーに近いところでキャッシュする仕組み」が存在しない。

- 前のグループのオブジェクトは、現在のグループのオブジェクトよりも重要度が低ければ、これをドロップしても良い

- 輻輳発生時に、relayはオブジェクトの優先順位を用いてオブジェクトをドロップさせる。relayが輻輳の発生を検知し、オブジェクトをドロップさせる方法を持っていることが前提となっている

-

High Loss Networksセクションの追加- Web会議システムでは20%以上のパケロスがあるNWで利用されることも多い。この場合、audioは維持してvideoだけ流さないようにする仕組みがよく使われる。

- また、FECや再送などの仕組みによってパケロス耐性を得ることも多い

- 最近では3kbps程度の軽量な音声コーデック(Lyra等)が開発されている

-

interval between access pointsセクションの追加- ストリーミングのユースケースでは、「アクセスポイント間の距離が短い」ことを特徴として、再同期が重要視されている。これにより、早送りや巻き戻しなどの機能に利用できる。

- (感想)ここでいう再同期は、キーフレーム(参照フレーム)を受け取らないと映像をデコードできないので、キーフレームを要求する仕組みが必要だということ。WebRTCでは会議への入室時などにキーフレーム要求が走る。

- 参照フレームはサイズが大きく、差分フレームは参照フレームよりもサイズが小さい。差分フレームは参照フレームに依存するような関係。このため、参照フレームを受け取るタイミングでトラフィックのピークが生じる。このピークは、ビデオ会議のようなユースケースよりも、ストリーミングのようなユースケースの方が吸収するのがはるかに簡単である。

- これが理由で、ビデオ会議では、より長いグループ(chromeでは参照フレームの後の差分フレームが30秒くらい続く)が使われている。

- ストリーミングのユースケースでは、「アクセスポイント間の距離が短い」ことを特徴として、再同期が重要視されている。これにより、早送りや巻き戻しなどの機能に利用できる。

-

Media Insection and Redirectionセクションの追加- 広告の挿入などでは、メディアのソースが別のものに切り替わったことを消費者に伝えたい(広告再生中であると消費者が分かるように)。

- メディアのソースが変わったらデコーダの初期化などが必要。なのでこれを消費者に伝える必要がある

- 広告の挿入などでは、メディアのソースが別のものに切り替わったことを消費者に伝えたい(広告再生中であると消費者が分かるように)。

-

Media Encriptionセクションの修正

-

次回のinterim-meeting(vol.14)

2024/02/08,09に開催予定。

ACM Mile-High Video 2024

flano_yukiさんのポストで知った。

2024/02/11~2024/02/14で開催される、映像配信技術のカンファレンスらしい。

Day3にはMOQT関連のセッションがある。

- Video Streaming 4: Low-Latency Media and Media over QUIC

- MoQ Goes to Kindergarten (Our Little Streaming Format Grows up)

- This is The Way: Prioritization in Media-over-QUIC Transport

- MOQTで議論されている「優先順位」の話。オブジェクトの依存関係が複雑になりそうなので、この辺りの議論は最近のMOQTで議論されている大きなトピックなのかも。

- Ultra-low Latency Video Delivery Over WebRTC Data Channels

- MOQTではなく、WebRTC DataChannelを利用した超低遅延配信のセッションっぽい。WebRTC SFUを多段に繋げてやるケースはよくあるが、その中でもDataChannelを使っているのは初めて聞いた。面白そう。

- Toward WebTransport Support in dash.js

- MOQTの普及には再生プレイヤーの対応も必要なので、こういった話がすでに進んでいるのは驚いた。結構普及が早いのかも知れない。

IETF公式のMedia Over QUICの概要

Media Over QUICの概要がIETFで公開された。

ユースケース

- ⭐️ライブストリーミング(映像配信など)

- これが一番重視しているユースケースのよう。Youtubeやtwitchなどの数秒~数十秒の遅延を1秒未満に削減することで、配信者と視聴者のインタラクションを強化する。

- リアルタイムコラボレーション(ビデオ会議など)

- 「遅延が低いビデオ会議サービスは、コスト効率の高い方法でスケールアウトすることができません」と書かれていることから、こちらも視野には入れているよう。

- 一方で、WebRTC事業者目線では、まだ遠いんじゃないかなという気がする。RTP Transport など、WebRTC側でも色々と変更が想定され、根本からWebRTC=>MoQへの乗り換えは大変そう。(技術遺産をMoQに載せ替える作業が必要)

- ゲーム(クラウドゲーミング?)

歴史的に重要な観点

いくつかの技術をまとめて一つのテクノロジーセットにするというモチベーションから、複数の技術のいいとこ取りを目指している。

- WebRTC(RTP)のリアルタイムメディアに関する知見

- HLS/DASH/HTTP CDNのスケーラビリティのアイデア

低遅延かつ高品質なプロトコルとして策定が進められている。

- WebRTCは低遅延だが高品質を維持するのが困難。また、スケーラビリティにも問題があり、一般的には数百が限界

- HLSは高品質だが低遅延で配信できない。

その他素晴らしい点

- MoQではメディアをEnd-to-Endで暗号化できる。さらに、暗号化した上で、キャッシュに必要な情報にはアクセスできるように設計されており、relayするサーバでパケットを取捨選択してキャッシュしたり、輻輳制御の結果ドロップしてエンドユーザーに配信することができる。

- MoQはユースケースによって柔軟なカスタマイズが可能である。「フレームレートと画質のどちらを優先するのか」「映像と音声のどちらを優先するのか」「レイテンシと品質のどちらを優先するのか」を選択できる。WebRTCやHLSではこの制御が難しい。

- (感想)「どういった制御をするべきなのか」はユースケースによって異なるため、正しくアプリケーション側で定義するのはそれなりに難しそうだ

気になった点

MOQTがWebRTCやHLSの次の技術であることはわかっていたが、他の市場にも影響を与える可能性が記載されている。

ジェニングス氏は、MoQ はメディア配信を改善するために設計されていますが、それによってさらに多くのことが可能になり、他の市場に利益をもたらすだろうと述べています。

「MoQ は実際には、メディアの配信以上のことを可能にする非常に汎用的なメカニズムです」と彼は説明します。「MoQ を使用すると、低遅延、高ファンアウト、高スケーラビリティで機能するパブリッシャー/サブスクライバー ネットワークをインターネット上に構築でき、これは多くのアプリケーションに使用できます。」

- IoT

- プッシュ通知

- 5Gネットワーク

- テキストメッセージングプロトコル

- (感想) 確かに、WebRTCやWebSocketでも実現可能だが、ビデオ会議システムでは映像・音声はWebRTC、テキストはWebSocketというのが一般的である。ここが面倒なところではあるので、この辺りも含めて一つのプロトコルに統合するというのは革新的。Next WebSocketの側面はあまり聞かなくなっているが、今でも視野の中には入っていそう。

今後の動きで面白そうな点

- 2024/02/06にMOQTのhackathonが予定されており、相互接続試験が行われる予定

- (参加したかった・・・)

ゲーム業界におけるリアルタイム通信プロトコルについて

調べた動機

ゲーム業界でリアルタイム通信プロトコルといえば独自UDPだと思うが、MOQTおよびWebTransportってどうなのだろう?

以前、MIXIさんがWebTransportに独自RTPを載せて運用されていたことがあったので、それに関連して気になった

ゲーム業界においてWebTransportはどうなのか

- QUICならまだしも、WebTransportだとオーバースペック

- WebTransportが乗っかることによるオーバーヘッドもある可能性

- WebTransportはWebブラウザでも動くように設計されているが、ゲームにおいてはサーバーもクライアントも自前で実装できるので、無理にこの仕様に沿う必要がない

- 一方で、メリットもある

- TCP/UDPライクなユースケースに両対応できて、UDPが通らない(QUICが通らない)環境でもTCPでなんとか通信が可能

- (感想) 標準化された技術に乗っかると、オレオレUDPとか作った時にISPでブロックされたりしないとかもありそう。

- ロードバランサーがHTTP3等に対応する可能性が高いため、ロードバランサーで問題が発生する可能性が低い

- TCP/UDPライクなユースケースに両対応できて、UDPが通らない(QUICが通らない)環境でもTCPでなんとか通信が可能

感想

- P2Pで通信したいとなるとWebTransportでは足りなさそうなので、P2Pのためには他の方法を考える必要がある。これは確かに大変そうだ。

- WebTransportはサバクラが先行して策定されていて、p2p-webtransportという単語もあるにはあるが、Web業界的には当分(5年くらい?)サバクラはWebTransport、P2PはWebRTCで棲み分けというのが予想される。

- P2Pとサバクラ両対応なWebRTCでは何が足りないのだろう?

- MIXIさんでも以前WebRTC SFUを使って音声通信を提供されていたようだが、WebTransportの検証に踏み切った理由はスライドからは把握できなかった。

- なんとなく、以下の理由を想像してみた。

- 数百以上の音声通信をWebRTCでやるのは結構大変だから

- WebRTCはウェブ会議に特化した処理になっていて、ゲーム業界むけのカスタマイズをするのが難しい(libwebrtcに手を入れなければならない)

- QUICだとコネクションマイグレーション(接続がwifi -> テザリングに変わっても繋がる)ができる(WebRTCはできない)

- こちらのスライドでは、「ゲームは小さいサイズのデータを高頻度で送るため、従来の暗号化では無駄が多い」と書かれていたので、この辺りも関係しているのかも。

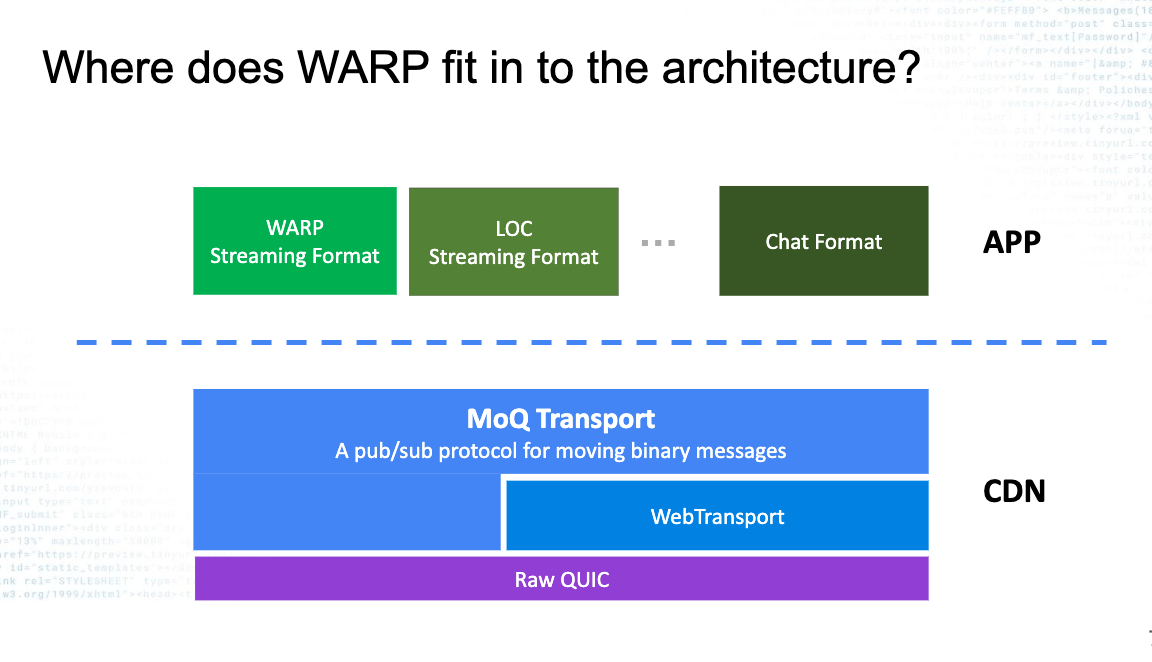

Media Over QUICTransportのプロトコルスタック

引用: https://datatracker.ietf.org/meeting/interim-2023-moq-08/session/moq

- プロトコルスタックとしてはQUIC上に構築される。

- WebTransportも含まれる。WebTransportは省略して、QUICの上に直接構築するのも許容される

- 既存のライブラリを読むと、サーバー側はWebTransportとRAW QUICの両方に対応するようになっている

- WebTransportも含まれる。WebTransportは省略して、QUICの上に直接構築するのも許容される

- MOQTはあくまで制御やペイロードの定義のみであって、ペイロードの中身のメディアフォーマットについては定義していない。

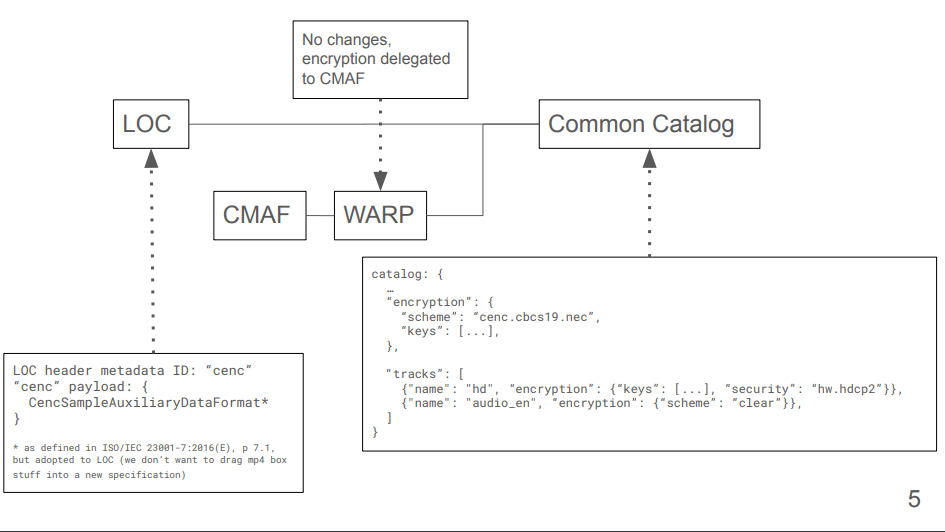

- MOQTの上にWARPやLOC(Low Overhead Media Container)を乗せることを前提にしており、ペイロードフォーマットはこちらの仕様によって決定される。

- WARPはCMAFというファイルフォーマットを前提に設計されている

- CMAFはHLSやMPEG-DASHなどで利用されている仕様

- LOCはWebブラウザのWebCodecs APIのフォーマットをそのまま流す前提に設計されている

- (感想)テキストや3Dデータを流す話もあるらしく、その点ではここの仕様が乱立する可能性がありそう。

- WARPはCMAFというファイルフォーマットを前提に設計されている

- MOQTの上にWARPやLOC(Low Overhead Media Container)を乗せることを前提にしており、ペイロードフォーマットはこちらの仕様によって決定される。

感想

MOQTの上に乗せるメディアフォーマットとしては、LOCの方がWebRTCからの乗り換えにおいては楽かもしれない。一方で、HLSやMPEG-DASHからの乗り換えではWARPの方が楽そう

参照

2024/02/08,09のIETF interim-meetingの1日目まとめ

2日(4回)に分けてMTGが行われた。実際に使われたスライドは01,02の内容のみ。これを二日にかけて議論した模様。

注意事項

こちらのコメントで利用している画像は全て以下のスライドから引用しています

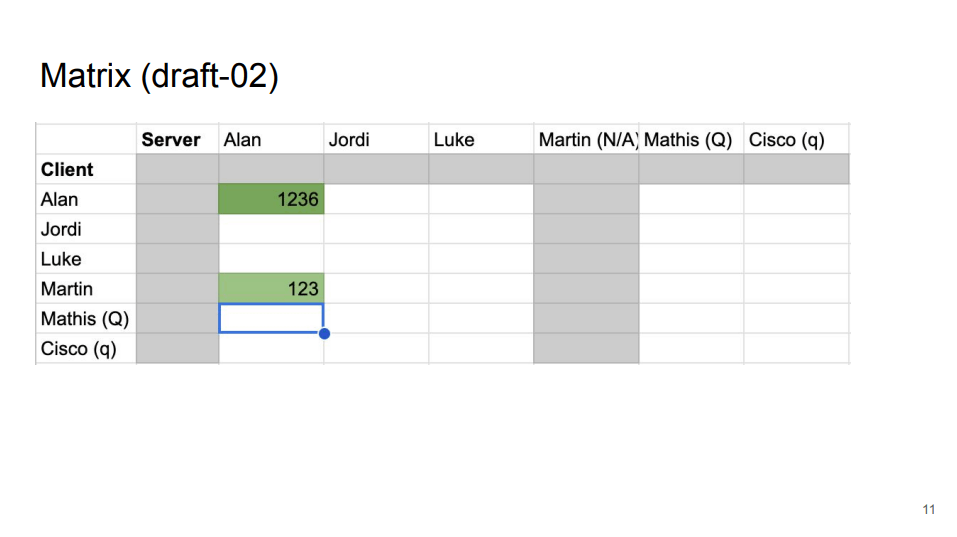

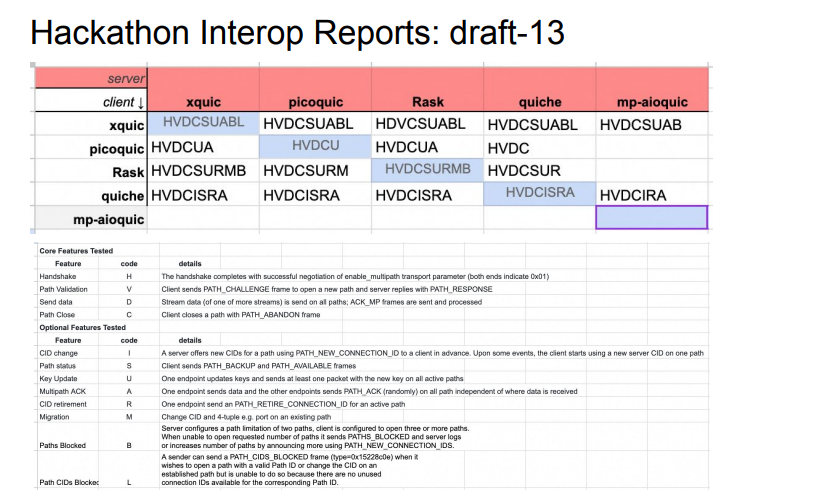

moqt-draft 02における相互接続試験の結果

- draft02への追従はまだ追いついていないようだ。(02は2024/01/24発行のため当然ではある) AlanさんとMartinさんの実装以外は成功していない。

- 01の相互接続試験結果

- 02の相互接続試験結果

- 01の相互接続試験結果

MoQTのissueについての議論

issueはこちらのGithubに挙げられ議論される。

issueの細かい話については把握しきれていないので割愛。以下サマリ

- SUBSCRIBEメッセージにERROR/FIN/RSTがあるが、他にも

TRACK_OVERとか必要なのでは?また、FINとRSTは同一なのでは?統合してメッセージ減らす余地もあるかもしれない - オブジェクトが全く送信/作成されなかったときに、SUBSCRIBE_FIN/RSTでどうやって表現する?現状表現方法がないので新たなフラグ等が必要になる。

- group N の全てをsubscribeするときにどうやって指示する?

- https://github.com/moq-wg/moq-transport/issues/312

- groupは映像や音声の塊のことで、映像ではkeyframeから最後のdeltaframeまでを指す

Rapid Recoveryについて

有線からwifiに突然切り替えた時に、高速に復旧させる処理

- Receiver側の場合の処理

- こちらは仕様の変更をせずとも実現可能。

- Receiverが切り替わり、QUICコネクションが切断され、Consumerが0人になった場合でも、relayは多少の時間維持するため、復旧可能

- Publisher側の場合の処理

- こちらは仕様の変更が必要。

- Producerが切り替わった場合、QUICコネクションが切断される前にANNOUNCEメッセージがRelayに送られ、このタイミングで同じ名前のTrackが生成されてしまう。同じ名前のTrackが生成されたタイミングで、既存のTrackと新規のTrackのSUBSCRIBEメッセージをPublisherが受け取るようにしたい

そのほかの複数の切り替えシナリオについても議論されている

- QUICのコネクションマイグレーションで再接続はできるのでは?という話

- 議事録の中で、「QUICのコネクションマイグレーション使えば?」「WebTransportはQUICを前提としていない」というやりとりがあった。

- 恐らく、WebTransportはQUICが通らない時のためにover HTTP2も想定しているので、フォールバックした時のことも考えるとQUICのコネクションマイグレーションを前提とした仕様にはできないということなのだろう。

Common Catalog Format

MOQTではOBJECTメッセージがメディアをペイロードとして含めて送受信されますが、ペイロードの仕様については定義しておらず、LOCやWarpなどの仕様によって定義されます。これらの仕様を統合するのがCommon Catalog Formatです。

Common Catalog Formatの概要についてはこちらをどうぞ。

Common Catalog FormatのissueはGithubに挙げられ、議論される。

こちらもPRやissueの議論がメインなので、抜粋して紹介。

- JSONの形式として、JSON Patch(RFC6902)とJSON Merge Patch(RFC7396) のどちらをサポートするか議論になっていたが、 JSON Patch(RFC6902) の対応で合意が取れた

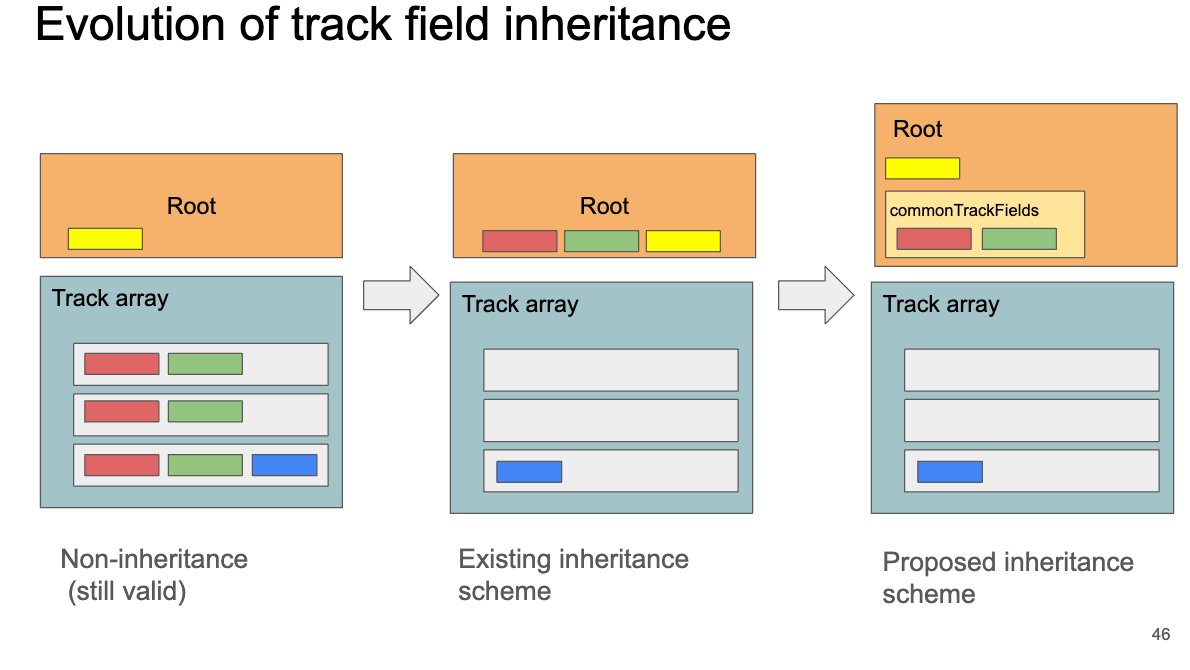

- Catalogのtrack nameが継承できるようになった。

-

commonTrackPropertiesプロパティをrootに追加し、継承するプロパティを毎回付与しなくても良いようにする仕様の提案 - DRMを必要とするフォーマットに対してDRMデータを伝送するために、現在のカスタマイズメカニズムは十分か?

- IETF118(2023/11)でCENC DRM情報を付与するためのフィールドが提案されたが、特定の技術に特化しすぎているとして却下された。

- 対案として、DRM情報を伝送するためにカスタムフィールドに好きにフィールドを追加して良いという仕様が提案されている

Live Edge, Expiry Edge & Gaps

ここについては理解が追いついていないため大雑把に要約。

- Groupの中の各Objectの有効期限が異なる場合に、どのような処理をするべきかについて議論?

- 複数Relayがあったときに、Clientが複数のrelayにリクエストを送ると、レスポンスに含まれるlatestなObjectの値がそれぞれ異なる可能性がある件について議論?

- relayからrelayに最新Group/Objectの情報が伝播するまでに時間がかかるためこの問題が発生する?

- 最新Objectがどれかクライアント側でわかったとして、それをリクエストした時に別のrelayにアクセスしてしまったら情報が共有されておらずエラーになるみたいな話かな・・・

- sliding DVR windowを導入する方法が挙げられている

- ex) Objectナンバーが15以前はexpireしていて、15-20がCurren Group, 21-25がFuture Groupの場合に、13-21のObjectのsubscribe要求が来たらどうするか?など

この辺りの解消のためにsubscription APIをSUBSCRIBEとFETCHの二つの仕様に分けることが提案されている

WARP Draftのアップデートについて

WARPについてはflano_yukiさんのこちらの記事をどうぞ

MOQTの上に乗せるフォーマットのことで、以下のようなプロトコルスタックになります。

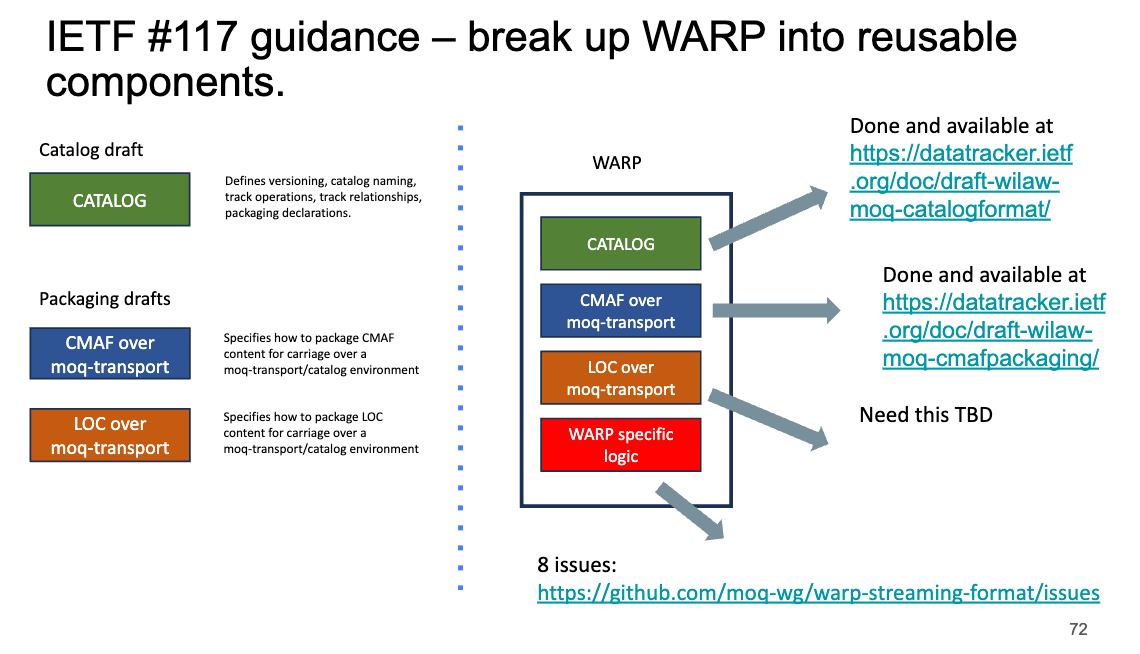

- IETF117での内容の再掲

- WARPを再利用可能なコンポーネントに分解する。

- (感想)WARPってCMAF前提かと思っていたけど、これを見るとLOCにも対応していそう。となるとLOCとの違いはなんだ?(最新のドラフトちゃんと読まないと分からなさそう)

- WARPを再利用可能なコンポーネントに分解する。

- ドラフト・実装の変更点

- CMAFをRFCの中で参照する場合にどうすれば良いのかという相談

- CMAFはMPEGによって作成された仕様(ISO標準)だが参照して良いのか(HLSは参照しているか良い?)

- (感想)CMAFの仕様書は有料?だから、こういう話が出てるのかも?

- CMAFはMPEGによって作成された仕様(ISO標準)だが参照して良いのか(HLSは参照しているか良い?)

- 重要なissue

- Seeking&DVR: リアルタイムとVODの二つの要素をWARPは兼ねているので、シークバーも使えないと行けない

- Bitrate Adaption: 可変アダプティブビットレートの実現方法

- Adverting Insertion: 広告挿入の実現方法

分散AdaptiveBitRateについて

MOQTでは、Publisher -> Relay1 -> (Relay2) -> Consumer(Client)という流れでデータが流れていくため、どの区間で品質を計測してbitrateを調整するべきなのか?という議論が出てくる。

シンプルにはfinal hopだけやるのが考えられる。

以下の画像の下の構成図のように、final hop以外でもAdaptive Bitrateを実現したい場合には、SUBSCRIBEメッセージを拡張してあげる必要がある

- (感想) 確かに、relay1とrelay2の間の帯域幅が何かしらの原因で圧迫される可能性はある。(例えばUS->EUへの転送など) なので、final hopだけのABRでは上手くいかないかもしれない。

- ここで書かれているABR、サイマルキャスト的な意味で使われていることに注意。複数画質をrelayに送信し、帯域幅によってどの画質を転送するかを決めている。

-

Publisher produces multiple copies of the content at different bitrates

and quality levels.

-

- ここで書かれているABR、サイマルキャスト的な意味で使われていることに注意。複数画質をrelayに送信し、帯域幅によってどの画質を転送するかを決めている。

Content Protetion

ネットワークレイヤーではQUICがTLS/DTLS相当のセキュリティを担保しているが、DRMやE2EE(End-to-End Encription)をどうやって実現するかについての議論。

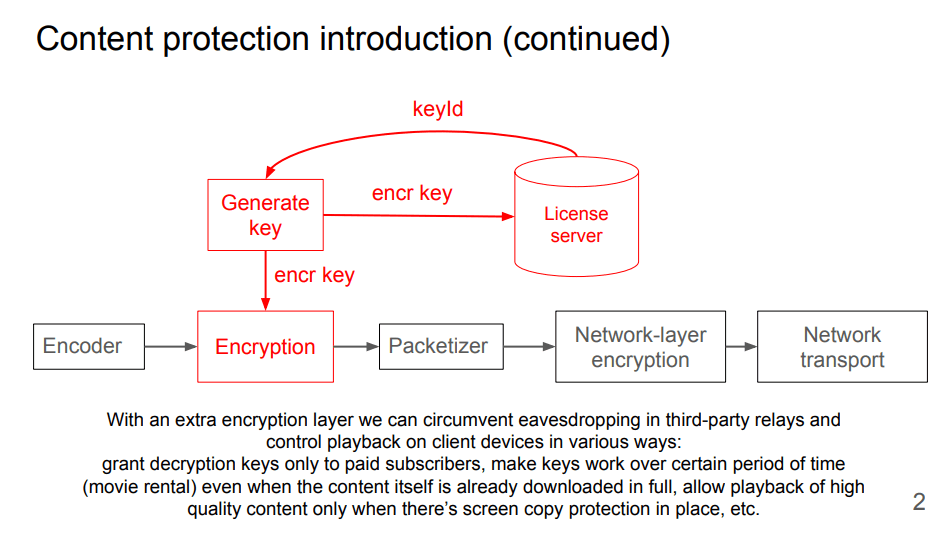

Encryptionレイヤーの追加

現時点では、EncoderとPacketizer、DecoderとPacketizerの間に新たにEncryptionレイヤーを作成してそこで暗号化することを想定。鍵はライセンスサーバを経由してやり取りを行う。

ecription プロパティの追加

Encriptionレイヤーを追加するにあたって、CatalogとTrackの両方に encription プロパティを追加することを提案。

画像にある cenc は Common Encryption のことで、MPEG-DASHのDRMで使用されている暗号技術。

ここでは複数の暗号技術を選択できると思われる。

KeyMap

どのgroupがどの復号鍵を使う必要があるかを keyMapで表現する。暗号化されていないgroupは-1で通知される。

- この仕組みによって、鍵は動的に入れ替えることが可能。

“keyMap”: [

[10, 0], // groups 10 to 19 are encrypted with keys[id=0]

[20, -1], // groups 20 to 24 are unencrypted (an inserted ad)

[25, 1], // groups 25 to 49 are encrypted with keys[id=1]

[50, 2] // groups from 50 onward are encrypted with keys[id=2]

]

Note: groups

感想

- 議論内容がかなり多い。参加者 を見ても、Google/Cisco/Meta/Tencentなど、配信事業をやっている会社の方が参加している(合計33人)。盛り上がっているのかも?

- jitsiの方が参加しているのも見えた。Web会議的な観点ではまだまだ遠いような気がするが、どうだろう・・・

- ところでMOQTとMoQT、WAPRとWarpは正式名称はどれなんだろう?

draft01から05の変更点

ちゃんと把握しているのが01なので、01から05で変わっていそうなところを整理する

3. Termination

エラーが起きてQUIC/WebTransportコネクションが削除される際のエラーコードが増えた。 Parameter Length Mismatch などは、とりあえず0x1 Generic Errorとかで実装していたが、これによってエラーの理由が明確になった。

| Code | draft-01 | draft-05 |

|---|---|---|

| 0x0 | No Error | No Error |

| 0x1 | Generic Error | Internal Error |

| 0x2 | Unauthorized | Unauthorized |

| 0x3 | Protocol Violation | Protocol Violation |

| 0x4 | - | Duplicate Track Alias |

| 0x5 | - | Parameter Length Mismatch |

| 0x10 | GOAWAY Timeout | GOAWAY Timeout |

4. Priorities

draft-01ではコンセンサスが取れておらず、TODO状態になっていたが、draft-05ではそれなりに定まっている。

- DataPlane相当のOBJECT / OBJECT_WITHOUT_LENGTHメッセージを除いたControlメッセージは、全てのOBJECT系メッセージよりも優先されるべきである [SHOULD]

- PublisherとSubscriber両方に優先順位をつけることができ、複数のSubscriberの優先度が同じ場合には、Publisherの優先度を元に優先順位が決定する。PublisherもSubscriberも優先度が同じ場合には実装によって挙動は異なる

- Subscriberの優先度は

SUBSCRIBE_UPDATEメッセージによって変更することができる - Subscriptionは複数のグループが送信可能な場合はgroup idの数値の昇順・降順の順番で送られるべきである [SHOULD]

- どちらを選ぶかは

SUBSCRIBEメッセージで指定する

- どちらを選ぶかは

- 同じgruop内のObjectはIDが低い数値のものから優先的に送信する。

5. Relays

draft-01では SUBSCRIBE_ERROR SUBSCRIBE_DONE メッセージのステータスコードが厳密に定義されていなかったこともあり、draft-05ではそこの詳細化が行われている。

SUBSCRIBE_ERRORのステータスコードが追加

| Code | Reasion |

|---|---|

| 0x0 | Internal Error |

| 0x1 | Invalid Range |

| 0x2 | Retry Track Alias |

SUBSCRIBE_DONEのステータスコードが追加

| Code | Reasion |

|---|---|

| 0x0 | Unsubscribed |

| 0x1 | Internal Error |

| 0x2 | Unauthorized |

| 0x3 | Track Ended |

| 0x4 | Subscription Ended |

| 0x5 | Going Away |

| 0x6 | Expired |

また、以前はRelayサーバー周りの挙動についてあまり書かれていなかったが、 UNANNOUNCE ANNOUNCE_CANCEL メッセージが追加されたことでこれらを扱うフローについて追記された。

- PublisherがANNOUNCEしたものに対する新しいSubscriptionを停止したい時、

UNANNOUNCEを送る - Subscriber(ここではrelayを指す?)は

ANNOUNCE_CANCELメッセージを送ることで、以前ANNOUNCE_OKと応答した ものに対する Subscriptionを新たに中継しないことを示す。

UNANNOUNCE メッセージに対する relayサーバーの返答が ANNOUNCE_CANCEL メッセージになるというわけではなく、独立したメッセージっぽい。

6. Message

MOQTメッセージの種類がかなり増えた。また、各種メッセージが持つプロパティの名前が変更されたり移動したりしている。特に、SUBSCRIBE や OBJECT 周りの変更点が多く、draft01ではメディア処理についてあまり考えられていなかったのが、version4つ分の検討によってかなり進んだ印象。

| Code | draft-01 | draft-05 |

|---|---|---|

| 0x0 | OBJECT_STREAM | |

| 0x1 | - | OBJECT_DATAGRAM |

| 0x2 | SUBSCRIBE_UPDATE | |

| 0x3 | SUBSCRIBE | SUBSCRIBE |

| 0x4 | SUBSCRIBE_OK | SUBSCRIBE_OK |

| 0x5 | SUBSCRIBE_ERROR | SUBSCRIBE_ERROR |

| 0x6 | ANNOUNCE | ANNOUNCE |

| 0x7 | ANNOUNCE_OK | ANNOUNCE_OK |

| 0x8 | ANNOUNCE_ERROR | ANNOUNCE_ERROR |

| 0x9 | UNANNOUNCE | UNANNOUNCE |

| 0xA | UNSUBSCRIBE | UNSUBSCRIBE |

| 0xB | SUBSCRIBE_DONE | |

| 0xC | ANNOUNCE_CANCEL | |

| 0xD | - | TRACK_STATUS_REQUEST |

| 0xE | - | TRACK_STATUS |

| 0x10 | GOAWAY | GOAWAY |

| 0x40 | CLIENT_SETUP | CLIENT_SETUP |

| 0x41 | SERVER_SETUP | SERVER_SETUP |

| 0x50 | - | STREAM_HEADER_TRACK |

| 0x51 | - | STREAM_HEADER_GROUP |

Githubで議論されている最近ホットそうなissue

-

Object/group TTL: https://github.com/moq-wg/moq-transport/issues/249

- https://github.com/moq-wg/moq-transport/issues/440 も関連issue

- 映像の場合、Keyframe/Deltaframeで依存性があるため、それを適切にキャッシュするにはどうするべきかという議論らしい。

- HLSのようにキャッシュをうまく使うのがMOQTには求められているため、この辺りは重要な議論になりそう(QUICやHTTP CDN周りの話も出てきていてあまり理解できていない・・・)

-

Adaptive Bit Rateの実現方法: https://github.com/moq-wg/moq-transport/issues/259

- WebRTCのように、送信側でABRをやるのがリアルタイム通信においては良いが、HLS/DASHは送信側ABRと受信側ABRを組み合わせて使っている。

- WebRTCはGCCを使っているが、このアルゴリズムは古く、ツギハギして作られているため理解するのが難しい&理解している人がかなり少ない

- 受信側ABRは色々な研究がなされており、2024ACM MMSysでも

Grand Challenge on Offline Reinforcement Learning for Bandwidth Estimation in Real Time Communicationsというコンペが行われるらしい。 - Lukeさんの意見では、第三の方法としての Server-side ABRのよう。(一部反対意見もあり)

- QUICの輻輳制御は固定されているので、QUIC WGとも協調して議論していく必要がある?

-

FECの実現方法: https://github.com/moq-wg/moq-transport/issues/320

- QUICは複数のデータグラムを結合することがあるため、FECのように、1パケットごとに個別の処理を行う形だと、MOQT上でFECが実装できない。

- QUICがデータグラムを結合しないように要求するか、QUICレイヤーでFECを導入してもらう必要があり、今後どうするか・・・

- 議論は既にしており、こちらのドラフトが解決策の一つ

- QUICはCDN企業の多くが参加して設計しているが、MOQTのWGにはakamaiの方も参加していて、CDN企業と近い場所で議論が出来ているのは素晴らしいなと思った。

moq-transforkについて

MOQTの第一人者であるLukeさんが出したmoqtのforkドラフト。

このドラフト自体はmoq-transport draft-03から派生して書かれたもので、現在仕様策定が進んでいるmoq-transportに対して、大きく変更を加えたものである。

MOQTはQUICに依存しているため、QUICがサポートしていないことは実現できない。それによって、重要なプロパティが未定義になっており、MOQTには欠陥が残っているというのが、このmoq-transforkのドラフトを書いた理由のようだ。

派生したドラフトとはいえ、完全に別個の実装を新たに作りたいわけではなく、ここで記述した内容はMOQTWGに持ち込まれ、Github issueで議論されているものもある。

なので、もしかしたらdraft 04,05でmoq-transforkの内容が一部含まれているかも。

Objectモデル

MOQTにおいてはメディアの概念とObjectモデルが対応しており、グループはVideoのGoP(I/P/Bフレームをまとめたgroup of picture)、オブジェクトはVideoフレームに相当する。

しかし、QUICとマッピングされた概念ではなく、動的にQUICストリームのプロパティが色々なトラック・グループ・オブジェクト間で移動してしまう(?)ので、すぐに管理不能になるだろうと指摘している。

おそらくは、Lukeさんが想定したよりも仕様が複雑になってしまっているのだろう。

MoqTransforkでは、ObjectモデルはQUICに直接マッピングされた概念であるため、この管理が楽になる(らしい)

Priority

MOQTにおいては、送信側が優先順位を決定する。(これはLukeさん自身が間違ったアプローチを提案したと書かれている)

より良い方法として、送信側・受信側が協調して決定する必要がある。

MoqTransforkでは、優先順位の決定をsubscriberに移譲する。

Control Streams

MOQTにおいては、ANNOUNCEなどの制御メッセージは一つのストリームを共有する仕様になっているため、HoLBの可能性がある。

MoqTransforkでは、サブスクリプションごとに一つのストリームを使い、たくさんの制御メッセージを送ってもHoLBが起きないようにする。また、これによってQUICのステートをそのまま扱うようになり、UNANNOUNCEやUNSUBSCRIBE、SUBSCRIBE_DONE, SUBSCRIBE_ERROR, SUBSCRIBE_RESETなどのメッセージは消せるようになる。

Byte Offsets

MOQTにおいては、接続やSubscriptionが中断された場合、中断されたところから再開するために、グループのObject IDを使っている。しかし、オブジェクトの一部分は再度ダウンロードされることによって、キャッシュが断片化される(?)問題がある。

MoqTransforkでは、FETCHメッセージを使い、Byte Offsetsで始まる不完全なグループを提供する(ちょっと理解が及ばなかった)。

Datagrams

MOQTにおいては、送信者のpublisher track preferenceを通して、QUICのdatagramでOBJECTメッセージを送ることをサポートしているが、これは高レイテンシでも構わないユーザーは体験が悪い

MoqTransforkでは、subscriberがQUICのStreamとDatagramのどちらで受け取りたいかを選べるようにする。DatagramはGroupがMTUより小さく、希望するレイテンシがRTTより少ない時にのみ使用されるべきである。

これによって、Streamのオーバーヘッドを削減しながら再生できる。

おそらく、Datagramはドロップするが、Streamは再送されるため、高レイテンシでも構わないならStream使って、特定の場合だけDatagramを選択しろよってことなのだろう。

Use-Cases

MOQTにおいてはユースケースが曖昧になっており、そのせいで不必要な機能が生じている。

MoqTransforkにおいては、Appendixとしてユースケースを明示し、それに推奨されるアプローチを明記している。

Common Catalog Format draft00と01の変更点

Catalog Formatについてはこちらの記事がおすすめ

そこまで大きく変更点はない。

- Common Catalog FormatはJSONで各種パラメータを設定するが、そのパラメータの位置が明示されるようになっている。

- 各種パラメータ値の型が決定されている。

- 3.2.12 Track operationsが削除されている。

- 以前はAdd/Deleteプロパティがあり、SUBSCRIBE可能かどうかを表現していた。

- おそらくだが、MOQT draft-05を読むと

TRACK_STATUSメッセージなどもあるので、Common Catalog FormatからMOQTに責任が移ったのだろう。

IETF119で話されてた内容から面白かったもの

- LOCのモチベーション

- CMAFはフレームごとに100bytes以上のオーバーヘッドが存在する。audioの場合は100%以上のオーバーヘッドとなる

- CMAFはheaderや複数フレームをパッケージング(chunks/fragments/segments)する時に複雑

- parseする必要なく、フレーム境界がわかる仕様が欲しい

IETF121の変更点についてはこっちのスライドでまとめている

IETF MoQ 中間MTG #7 (2025/2/5実施) のまとめ

参加者

- Martin Duke (Google)

- Will Law (Akamai)

- Magnus Westerlund (Ericsson)

- Suhas Nandakumar (Cisco)

- Mo Zanaty (Cisco)

- Cullen Jennings ( Cisco )

- Mike English

- Gwendal Simon (Synamedia)

- Ian Swett (Google)

- Daniel Fay (Meta)

- Giovanni Marzot (Vivoh/MarzResearch)

- Mirja Kühlewind (Ericsson)

- Mathis Engelbart (TUM)

概要

- Extensible Object Header が主。

Extensible Object Headerとは

MoQTのOBJECTメッセージに拡張可能なHeaderを追加するために、SETUPメッセージでネゴシエーションを行うもの。HTTPでも同様の機能がある。

この拡張されたHeaderは、Objectに情報を付与することで、リレーサーバーで動作を変更させることができる。例えば、End SubscriberにObjectを送るEdge Relayにおいて、広告を差し込むためにEdge Relayで動作を変更させるような場合に、拡張Headerを使ってその情報を表現する。

つまり、End Subscriberが扱うような、Object Payloadの中身に関するようなmetadataを表現するためのものではない。中間relayサーバーのための情報という側面が強い

この拡張Headerの内容は、WARPやLOCなどの、MoQ Transportの仕様とは別の枠で定義される。

LoCのドラフト でも、LoCのHeader ExtensionはMoQ Header Extensionsに入れる前提で定義されている。

ただ、LoCのドラフトでは

This metadata provides necessary information for end subscribers, relays and other intermediaries to perform their operations without accessing the media payload.

と書かれており、relayのための情報ではなく、End Subscriberのための情報も含まれると書かれている。仕様が書かれたタイミング(2024/10)と中間MTGのタイミング(2025/02)でズレているので、仕様が変更されている可能性はあるが、現時点では齟齬がありそうだ。

また、Capture TimestampなどのLoC Header Extensionsは、機密情報となる場合もあるため、End to Endで暗号化が必要なのでは無いかという点についてもLoCのドラフトでは記載されている。ここについても中間MTGで話している内容とは齟齬がありそうだ。ここも変更される可能性が高い。

議論になっている点

- Object Payloadへその情報を埋め込むのではなくObject HeaderにExtensible Headerとして追加するのは何故か

- リレーがこのHeaderを見て動作を変更したいが、Object Payloadの中身にアクセスできるとは限らないため。E2EEされている場合もある。

- なぜ 事前に仕様に定義せず、Extensible Headerとして定義するのか

- 仕様からこれを切り離すことで、仕様の肥大化を防ぐ

- 多段リレーの場合に、SETUPメッセージはHop-by-Hopで行われるが、そのうちの一つのrelayがその拡張Headerをサポートしていなかった場合の挙動はどうなるのか。

- 要議論

- 現在のdraftでは配信チェーン全体でMoQT versionを強制する機能がない

- 現在のdraftではrelayサーバーはextension headerを変更するべきではないと書かれている

- 要議論

SETUPメッセージにおいては、REQUESTED-EXTENSIONを追加する予定。これによって、clientがCLIENT_SETUPを送信する際にどのextension headerをserverがサポートしているかをネゴることができる。

MoQ relays for Support of High-Throughput Low-Latency Traffic in 5Gのまとめ

3GPPという団体(携帯通信システムの標準化団体)に所属する(?)方が提出したドラフト。MoQTのextensible headerに非常に強く関係し、extensible headerを支持するユースケースとしても例に挙げられている。

このInternet draftでは、XRでのユースケースを例に出し、なぜMoQTにおいてもextensible headerが必要かを示している。

3GPPは、アプリケーションデータをPDU setというグループで処理するが、この際に、グループ毎に輻輳した際に優先制御したい(優先度が低いものはdropして混雑を回避する)。このために、RTPでは RTP header extensionを使用して制御する。

一方で、MoQTではRTP header extensionに相当するものがないので、MoQTでも同様の概念が欲しい。

MoQTのObject Payloadの中は暗号化されている可能性もあり、relayからアクセスできない場合もあるため、PayloadではなくHeaderにこの情報は必要となる。

そして、このDraftでは、MoQ Extension Headerとして、xr-metadataというHeader名をつけ、Headerの仕様について以下のように定義している。これらはMoQTのSETUPメッセージによってClientとServer間でネゴシエーションされる。

- 3gpp-xr

- 0x00: No XR metadata

- 0x01: Release 18 XR metadata

- 0x02: Release 19 XR metadata

- 0x03: both

- 3gpp-xr-options

- 0x00: No optional metadata

- この場合は3gpp-xrは0x00でなければならない

- 0x01: PSSize and NPDS metadata included

- PSSize: PDUSetの全体のサイズを示すmetadata?

- NPDS: PDUSetの中に含まれるPDUの個数を示すmetadata?

- 0x00: No optional metadata

また、MoQT Object内部では、以下の情報が含まれる

- MoQT Datagramを利用する場合

- 3gpp-xr = 0か1の場合、全てのObjectに以下が含まれる

- E(1bit)

- D(1bit)

- PSI(4bit)

- PSSN(10bit)

- PSN(6bit)

- 3gpp-xr = 1の場合、Objectに以下が含まれる可能性がある

- BSize(bit数未定)

- TTNS(bit数未定)

- 3gpp-xr = 0か1 かつ 3gpp-xr-options = 0 の場合、Objectに以下が含まれる可能性がある

- PSSize(24bit)

- NPDS(16bit)

- 3gpp-xr = 0か1の場合、全てのObjectに以下が含まれる

- MoQT Streamを利用する場合

- 3gpp-xr = 0か1の場合、全てのObjectに以下が含まれる

- D(1bit)

- PSI(4bit)

- PSSN(10bit)

- 3gpp-xr = 1の場合、Objectに以下が含まれる可能性がある

- BSize(bit数未定)

- TTNS(bit数未定)

- 3gpp-xr = 0か1 かつ 3gpp-xr-options = 0 の場合、Objectに以下が含まれる可能性がある

- PSSize(24bit)

- NPDS(16bit)

- 3gpp-xr = 0か1の場合、全てのObjectに以下が含まれる

筆者は3GPPについては詳しく知らないが、おそらく3GPPではXR向けの要件を取り込んだversion18,19の仕様があるのだろう。このHeaderは3GPP XR仕様のどのversionをサポートするかを示す。

3GPP XR の仕様については以下のサイトに説明があった。

3GPP(3rd Generation Partnership Project) Release 15(以下,Rel-15)で策定された5GC(5G Core network)*1のアーキテクチャは,Rel-16およびRel-17での拡張に引き続き,5G-Advancedの最初のリリースと位置づけられるRel-18においても,さまざまな分野で拡張があった.特に,VR(Virtual Reality)*2,AR(Augmented Reality)3,XR(Extended Reality)4などによる拡張現実感(以下,「拡張現実感」)とメディアサービス,時刻サービスと確定性通信5,ネットワークスライシング6,RNAA(Resource owner-aware Northbound Application Program Interface Access)*7,インテント駆動管理において,以下の機能改善と新しい技術領域の追加が行われた.

Rel-18より前の5GS(5G System)*25QoSの枠組みでは,これらのフレームを伝送するすべてのPDU(Protocol Data Unit)26は,QoSフロー27ごとに設定された同一のQoSパラメータを使用して処理される.

Rel-18では,NG-RAN(Next Generation-Radio Access Network)*28の無線リソーススケジューリングを改善するために,このようなフレームを伝送する個々のPDUに対して異なるQoS処理(異なる優先順位など)を使用できる.これにより,特に輻輳状況において,NG-RANがアプリケーションのPDUの内容と重要性をより良く認識している場合に,サービスのユーザ体験が向上する.

XR向けの仕様はRelease18以降で追加されているようなので、5G NWでXRデータの優先制御を行うためにはRelease18以降の仕様を見るのが良さそうだ。

Relayの挙動としては以下の通り定義されている

- EはQUIC streamのFIN flagから設定される

- PSNは、STREAMフレームオフセット順に受信したQUIC/UDP/IPパケットに基づいて生成される。欠落パケットがある場合、リレーは、STREAMフレームオフセットとパスMTUを使用して、1つ以上の欠落パケットの後に受信したパケットのシーケンス番号を決定することができる。

Scalable Event-Based Video Streaming for Machines with MoQ についてのまとめ

ベイラー大学の助教授のFreeman AndrewさんがMoQTのメーリスで貼っていた論文。

Arxivにも似たような論文を記載しているが、多少違う部分がある。おそらく↑はMoQ WGに向けてアレンジしたものだろう。

概要

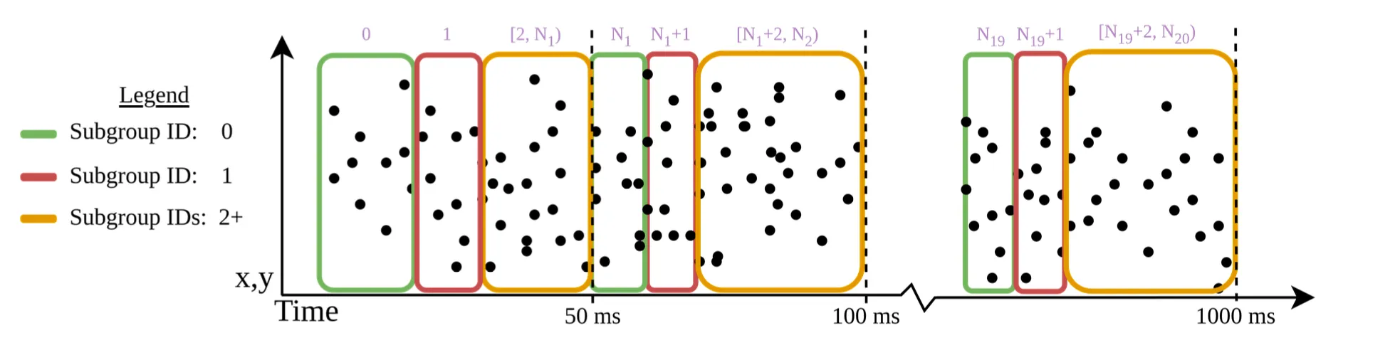

イベントカメラ(センサーで動きを検知してその差分でフレームを表現するカメラ)でもMoQTを使うことで、超大量のセンサーデータを転送したいというもの。

カメラではあるが、厳密には1ピクセルごとにセンサーが変化を検知するような形なので、従来の映像コーデックなどは適用できない。そして、このイベントカメラは1秒で100万回程度変更差分を検知する場合もあるので、サンプリングレート100MHz、100万FPSとも言える。720pだと500Mbpsにもなる。

いくつかこのイベントカメラ向けのコーデックの研究もあり、最近ではJPEGがJPEG-XEというのを出したが、まだまだ大容量すぎる状態。

このイベントカメラはComputer Visionにおいて物体認識などで使われている。多くの場合は、ローカルで処理するか、同一NWで処理がなされる。

しかし、クラウドで処理したいニーズも当然あるため、このMoQTを活用できるのではないか?というモチベーションがある。

このイベントカメラのデータ転送においては、以下の要件を満たしたい。

- リアルタイムの転送

- 後からデータを確認するための転送

https://mailarchive.ietf.org/arch/msg/moq/6cXvYsL1xDctXfYT1v5rxNpHcJg/ より引用

また、Low Latency Targetにおいては、送信したいイベントの中でも、優先順位を設定したい。

MoQTのSubgroupを用いて、50msごとにタイムウィンドウを切り、最初のN個のデータをSubgroup=0、次のN個のデータをSubgroup=1、残りのデータをSubgroup=2として、ID順に優先順位を設定すると、最初の重要なデータの優先順位を上げることが可能。

https://mailarchive.ietf.org/arch/msg/moq/6cXvYsL1xDctXfYT1v5rxNpHcJg/ より引用

WebRTCのPriority APIなどでは、帯域幅の割り当ての優先はしてくれるが、送信順の優先順位は決定してくれないので、優先されない点が厳密にはある。例えば再送処理なども逐次行われるだろうが、一番下のレイヤーを最優先して欲しい。

SFUでこの辺りまで厳密に制御するようにコードを書けば出来ると思われる(結局はRTPパケットをどういう順序にするかという話でしかないので)が、仕様としては存在していないので、実装としても現時点では存在していないかもしれない。(もしご存知の方がいれば教えてください)

MoQTはその優先制御のアルゴリズムがかなり議論されているので、WebRTCとは仕様レベルではそこが差分となるかも。

Media Interop Draft version-01 のまとめ

MoQTを利用したライブ配信やビデオチャットのユースケースにおいてmediaのフォーマットについて定義したドラフト。low overhead packagerという名前で定義されていて、これはLOC(Low Overhead Container)とは別物のようだ。

Object Format

mediaのObjectのフォーマットは以下の通り

{

Media Type (i)

Media Payload (...)

}

Media Typeは以下のコードで表現される。

| Code | Value |

|---|---|

| 0x0 | Video H264 in AVCC with LOC packager |

| 0x1 | Audio Opus bitstream |

| 0x2 | UTF-8 text |

| 0x3s | Audio AAC-LC in MPEG4 |

Media Payload

H264 with LOC packager format

{

Seq ID (i)

PTS Timestamp (i)

DTS Timestamp (i)

Timebase (i)

Duration (i)

Wallclock (i)

Metadata Size (i)

Metadata (..)

Payload (..)

}

Opus with LOC packager format

{

Seq ID (i)

PTS Timestamp (i)

Timebase (i)

Sample Freq (i)

Num Channels (i)

Duration (i)

Wall Clock (i)

Payload (..)

}

AAC-LC in MPEG4 bitstream

{

Seq ID (i)

PTS Timestamp (i)

Timebase (i)

Sample Freq (i)

Num Channels (i)

Duration (i)

Wall Clock (i)

Payload (..)

}

MoQ UseCases version-00のまとめ (MoQ Transfork)

Luky Carleyさんが提出したドラフトで、MoQ WGとは別のアプローチで出されたドラフトっぽい。

そこまでちゃんと読めていないので気になったところを箇条書きでピックアップしておく。

- SVCなどで複数画質でエンコードした場合、moqtransforkではその画質毎にTrackとしてpublishする。

- 従来のMoQTではSubgroupの利用を想定しているはず。このdraftでTrack毎にしたいモチベーションはわからなかった

- MoqTransforkの目標の一つは、複数のレイテンシのサポートを行うこと。レイテンシとリーダビリティ(品質)のトレードオフを選択できるようにすること

- 想定しているユースケース

- Realtime通話

- 低遅延ライブ配信

- 高品質ライブ配信

- Video On Demand

MoQT draft-08公開

draft-08が2025/02/12に公開された。06と比較してどのような差分があるかを確認する。 差分確認にはiddiffというツールが良い。https://author-tools.ietf.org/iddiff

draft06と08の差分比較

- Session Terminationの終了条件が増えた

- Control Message Timeout

- Control Messageへのレスポンスに時間がかかりすぎた場合

- Data Stream Timeout

- Dataを送信するのに時間がかかりすぎた場合

- Control Message Timeout

- SUBSCRIBE_NAMESPACEがSUBSCRIBE_ANNOUNCESに変更

- Priorityの挙動が厳密に定義

- Subscriber Priority > Publisher Priority > Group Orderの順番に優先順位が決定される。

- SUBSCRIBES_BLOCKEDが追加

- MAX_SUBSCRIBE_IDを超えるSUBSCRIBEを受けた時に返却するMessage

- FETCH, FETCH_OK, FETCH_ERRORが追加

- FETCHは過去、SUBSCRIBEは現在から未来のデータを取得するように使い分けがきめらえた

- さらに、過去から未来に向けてデータを取得したい場合はJoining Fetchというパラメータで判別を行う

- FETCHにはstandalone Fetch(0x1)とJoining Fetch(0x2)がある

- さらに、過去から未来に向けてデータを取得したい場合はJoining Fetchというパラメータで判別を行う

- FETCHは過去、SUBSCRIBEは現在から未来のデータを取得するように使い分けがきめらえた

- ObjectStatusからEnd of Subgroupが削除された

WARP draft-03まとめ

以前存在していたCommon Catalog Formatの仕様がWARPの中に取り込まれることになった。

02からの差分はこんな感じで、以前Common Catalog Formatで定義されていた各種フィールドが取り込まれた。

サッと見る限り、このフィールドの内容や設計思想は以前のCommon Catalog Formatの仕様と変わっていなさそう。WARPのdraftではCatalogと呼ばれているので、今後はCatalogと呼ぶことにする。

Catalogとは?

Media Over Quic Transport(MOQT)で利用するメディア情報及びそのパッケージング手法を伝達する手段。

MOQTでは、このカタログを受け取って、好きなものをSubscribeすることでメディアを受信する。

WebRTCにおけるSDPのm行に近い。

WebRTCのSDPはずっとPlainTextだが、MOQTではJSONオブジェクトで管理される。

WebRTCのSDP

v=0

o=- 4340214655134371844 2 IN IP4 127.0.0.1

s=-

t=0 0

m=audio 9 UDP/TLS/RTP/SAVPF 111 103 104 9 0 8 106 105 13 110 112 113 126

c=IN IP4 0.0.0.0

a=sendrecv

m=video 9 UDP/TLS/RTP/SAVPF 96 97 98 99 100 101 102 121 127 120 125 107 108 109 124 119 123 118 114 115 116

c=IN IP4 0.0.0.0

a=sendrecv

Catalog

{

"version": 1,

"streamingFormat": "1",

"streamingFormatVersion": "0.2",

"commonTrackFields": {

"namespace": "conference.example.com/conference123/alice",

"packaging": "loc",

"renderGroup": 1

},

"tracks": [

{

"name": "video",

"selectionParams":{"codec":"av01.0.08M.10.0.110.09","width":1920,"height":1080,"framerate":30,"bitrate":1500000}

},

{

"name": "audio",

"selectionParams":{"codec":"opus","samplerate":48000,"channelConfig":"2","bitrate":32000}

}

]

}

WebRTCのSDPでは、ICE Candidate(自身のlocal IP, global IP, TURN IP)も含めてやり取りされるが、MOQTではP2Pをサポートしていないため、Common Catalog Formatでもメディア情報のみ。

Catalogの送信方法

Catalogは「メディアの一種」として取り扱われる。

MOQTのメディアは、ANNOUNCE(配信宣言) → SUBSCRIBE(受信要求) → OBJECT(メディアデータ)という流れで送られるが、ANNOUNCE(配信宣言)ではメディア情報までは共有されず、使う名前空間の宣言のみ。

Common Catalog Formatは、メディアの一種として取り扱われるため、おそらく以下の流れが想定されている。

ANNOUNCE → SUBSCRIBE → OBJECT(Catalog) → SUBSCRIBE(MediaのTrack指定) → OBJECT(メディアデータ)

そして、Catalogは共通してCatalogというTrackNameを持ち、TrackName上の予約語となる。TrackNameSpaceはANNOUNCEで伝達され、具体的なTrackNameについては、TrackName=CatalogをSUBSCRIBEし、OBJECTメッセージとして受信することで具体的なメディアの情報を取得することができる。

Catalogの更新方法

Catalogは JSON-Patch 方式で差分更新が可能。差分更新のデータもおそらくOBJECTメッセージを使ってメディアと同じように送信される。

以下のようなベースとなるCommon Catalog Formatがあった場合に、

{

"version": 1,

"streamingFormat": "1",

"streamingFormatVersion": "0.2",

"commonTrackFields": {

"namespace": "conference.example.com/conference123/alice",

"packaging": "loc",

"renderGroup": 1

},

"tracks": [

{

"name": "video",

"selectionParams":{"codec":"av01.0.08M.10.0.110.09","width":1920,"height":1080,"framerate":30,"bitrate":1500000}

},

{

"name": "audio",

"selectionParams":{"codec":"opus","samplerate":48000,"channelConfig":"2","bitrate":32000}

}

]

以下のようなオペレーション要求がJSONで送られる。

画面共有のtrackを追加する場合

[

{

"op": "add", // 他に replace, remove, copy, move, testがある

"path": "/tracks/-",

"value": {

"name": "screen",

"selectionParams":

{

"codec":"vp8",

"width": 1920,

"height": 1080,

"framerate": 30,

"bitrate": 1500000

}

}

},

......

]

このオペレーションの結果、tracks配下にvideo,audioに加えてscreenが追加される

{

"version": 1,

"streamingFormat": "1",

"streamingFormatVersion": "0.2",

"commonTrackFields": {

"namespace": "conference.example.com/conference123/alice",

"packaging": "loc",

"renderGroup": 1

},

"tracks": [

{

"name": "video",

"selectionParams":{"codec":"av01.0.08M.10.0.110.09","width":1920,"height":1080,"framerate":30,"bitrate":1500000}

},

{

"name": "audio",

"selectionParams":{"codec":"opus","samplerate":48000,"channelConfig":"2","bitrate":32000}

},

/////////////////////////////////////////////////////////

{

"name": "screen",

"selectionParams":{"codec":"vp8","width": 1920,"height": 1080,"framerate": 30,"bitrate": 1500000}

}

/////////////////////////////////////////////////////////

]

}

WebRTCのSDPだと文字列検索で行を特定して消したり追加したりしていたけど、JSON&JSON-Patchでやれることになって快適になっている。

MoQT draft-09のまとめ

08から1ヶ月も経っていないのもあって、ほとんど変化なし。

- SUBSCRIBE_ANNOUNCESでANNOUNCEだけでなくUNANNOUNCEも受け取ることが明記された

- SUBSCRIBEのFilter Typeから Latest Groupが削除された

- FETCH(Joining FETCH) が実装されて、Latest Object + Joining FETCHと同じだからということらしい

- https://github.com/moq-wg/moq-transport/issues/679

- Object Extension CountがObject Extension Lengthに変更

- Extension数ではなく、Object Extension block全体のlength(bytes数)になった

- OBJECT_DATAGRAMからObject Payload LengthとObject Statusが削除された

QUICの輻輳制御のアルゴリズム(BBRv1?)がRTCに適切でない理由

元Twitch、現DiscordのLukeさんがメーリスにて発言していた。数ヶ月の調査によって得られた貴重なノウハウなのでメモしておく。解釈違いがあるかもなので要注意。

- BBRv1(および一般的なTCP輻輳制御)はNWをフルに活用出来ない(2Mbpsの余裕があっても1Mbpsしか出ないなど)

- 輻輳ウィンドウを利用可能帯域幅限界まで最大化させるのが非常に遅く、ロスすると急降下する

- これによって、RTCにはBBRv1は向かない。BBRv3はどうか不明

- 解決策Aは、LL-HLSとLL-DASHで採用されている方法で、フレームを束ねておく。

- 束ねたフレームがバーストすると、輻輳ウィンドウを最大化させるのに多くの時間がかかるものの、輻輳ウィンドウが乗算で増加し、bitrateが増加する。Lukeさんの調査によると、1フレーム分のレイテンシは発生したものの、推定bitrateは二倍になった

- 解決策Bは、QUICにプロービングを実装すること

- BBRはプロービングを1/8の頻度で送る?(解釈間違えてるかも)ことを明示しているが、あえてその設定を無視したプロービングを自身のQUICライブラリに実装した。これによって、輻輳ウィンドウの制御により多くの時間が費やされ(?)、輻輳ウィンドウを増加させることができる。これも推定bitrateを倍にした

リアルタイム輻輳制御では、これらの問題が発生するため、MoQTでも考慮する必要があるようだ。

QUICの輻輳制御自体はアルゴリズム選択の自由はありそうなので、「どのアルゴリズムを選択するべきなのか?」とか「ブラウザ内部のQUICのアルゴリズムとの相性が・・・」みたいな話が議論になりそうか?

2025/03時点でのWebCodecsのSVC対応状況(Google Chrome)

SVCコーデックに概要についてはこちらが詳しい。

WebCodecsはSVCに対応しており、VideoEncoderのconfigにて scalabilityMode を指定することで利用できる。

しかし、mdnには下記の通り、直接的にどのモードが対応しているかは書かれていない。

A string containing an encoding scalability mode identifier as defined in WebRTC.

W3CのWebRTCのdraftには大量のモードが記されているが、これらが実際に使えるかどうかは知らなかった。

実際に調べてみたところ、2025年3月現在でも、時間スケーラビリティ、つまりはframerateでスケールする L1Tn方式しかサポートしていないようだ。

| 種別 | 備考 | 対応状況 |

|---|---|---|

| L1T1 | 基本形 | ◯ |

| L1T2 | 2層の時間スケーラビリティ(framerate) | ◯ |

| L1T3 | 3層の時間スケーラビリティ(framerate) | ◯ |

| S2T1 | 2層の空間スケーラビリティ(resolution) | × |

| S2T2 | 2層の空間スケーラビリティ(resolution) * 2層の時間スケーラビリティ(framerate) | × |

| L2T1 | 2層の空間スケーラビリティ(resolution) | × |

| L2T2 | 2層の空間スケーラビリティ(resolution) * 2層の時間スケーラビリティ(framerate) | × |

| L2T2_KEY | keyframeのみ | × |

MoQTではSubgroupを用いて、SVCのレイヤー毎に優先度制御を行うことを想定しているが、現在の対応状況だと L1Tn方式 しか対応していないので、フレームレートでレイヤーを分けて、「NW帯域がきつい時は10FPS、余裕がある時は30FPSにする」みたいなことは可能だが、「NW帯域がきつい時は解像度低、余裕がある時は解像度高」みたいなことは不可能。フレームレートと解像度の両方使ってレイヤーを分けることもできない。

もし、実現したい場合は、解像度でtrackNameを分けて、その中でフレームレートでSubgroupで分けるみたいなことが必要になりそうだ。

- video track(SD画質)

- L1T3

- temporalLayerId=0: 10fps

- temporalLayerId=1: 20fps

- temporalLayerId=2: 30fps

- L1T3

- video track(HD)

- L1T3

- temporalLayerId=0: 10fps

- temporalLayerId=1: 20fps

- temporalLayerId=2: 30fps

- L1T3

MoQT draft-10のまとめ

09が出てから2日しか経っていないが、IETF122滑り込みで再度変更が入った。

仕様変更というよりかは、順番の整頓のみ。

draft-09時点でも似たようなことは書かれていたが、多少文章が変わっていそうなので、PublisherとSubscriber間でのメッセージのやり取りの文章は再度整理しておく。

- Publisher, SubscriberがどうやってSUBSCRIBE/FETCHメッセージを送り合うかが明記された(4章)

- SubscriberはPublisherとTrackに対するSUBSCRIBEやFETCHを通してインタクションを行いSUBSCRIBE_OK/FETCH_OKとOBJECTを受け取ることを期待する

- PublisherはSUBCRIBEの応答として正確に一つのSUBCRIBE_OK/SUBSCRIBE_ERRORを、FETCHの応答として正確に一つのFETCH_OK/FETCH_ERRORを送らなければならない

- Subscriberは応答メッセージを複数受け取ったらプロトコルエラーとしてセッションをクローズするべき

- SubscriberはUNSUBSCRIBEを送信するか、SUBSCRIBE_DONEかSUBSCRIBE_ERRORを受け取るまではSUBSCRIBEの情報を保持し続ける

- SubscriberはFETCH_CANCELの送信かFETCH_ERRORの受信かFETCH用ストリームのFINかRESET_STREAMを受信するまではFETCHの情報を保持し続ける

- FETCH用ストリームがすでにオープンしている場合はFETCH_CANCELに加えてSTOP_SENDINGも送信しても良い

- PublisherはUNSUBSCRIBEかFETCH_CANCELを受信すると、SUBSCRIBE/FETCH情報を即座に破棄できる

- その際に、SUBSCRIBE/FETCHに紐づいている全てのストリームリセットしなければならない

- FETCHデータストリームを破棄した後にFETCH情報を破棄しても良い

- PublisherはSUBSCRIBE_DONEを送信した後、即座にSUBSCRIBE情報を破棄できるが、関連する全てのストリームを閉じるまでSUBSCRIBE_DONEを送ってはならない

- データストリームを全て閉じたらFETXH情報を破棄して良い

- SUBSCRIBE_ERROR/FETCH_ERRORはPublisherもSubscriberも即座に破棄できる

IETF 122 の感想

相互接続試験

自前実装である moq-wasm を使ってIETF122の相互接続試験に参加してきた。

上記記事には書いていないような、感想や細かい情報をこちらには記載する。

MoQTの相互接続試験は各社がサーバーをクラウドにデプロイし、それぞれのクライアントが接続を行う。その結果を口頭やSlack上で共有し、spreadsheetに記入していく形だった。

相互接続試験自体はIETF開催期間の最初の土日のみを利用して行うが、MoQT関係者はセッションでの発表も控えており、常時テーブルについていたのは2,3人。 自分は出来るだけ試行したかったので、月〜金で行われる本開催期間においても相互接続試験を行なっていた。

GoogleのquicheやAlibabaのxquicは今回相互接続試験には参加していなかったので、相互接続テストが出来なかった。quicheやxquicはMulti-Path QUICの方の相互接続試験に参加していた模様。

QUICのセッションにも参加したが、Multi-Path QUICは注目されているようで、MoQTをMulti-Path QUICに対応させて、Media over Multi-Path QUIC Transportにすることも想定しているのかもしれない。

Multi-Path QUIC

IETF122に参加した収穫としては、このMulti-Path QUICが注目されていることがわかった点がある。

MoQTに取り組んでいるGoogle(quiche)とAlibaba(xquic)もこのMulti-Path QUICの実装をしており、相互接続試験に参加している。

我々が実装している moq-wasmはQUICライブラリとして quinnを採用しているが、quinnはまだMulti-Path QUICに取り組んでいないので、Media over Multi-Path QUIC Transportを行いたいのであれば、別のライブラリに乗り換えるか、quinnにコントリビュートする必要がありそうだ。

Multi-Path QUICの相互接続試験は、現在4つの実装が参加しており、その内の二つがGoogleとAlibabaによるもの。

https://datatracker.ietf.org/meeting/122/materials/slides-122-quic-multipath-quic-00 より引用

picoquicは個人で開発しているもののようで、Raskについては情報が見つけられなかった。MoQTと比較して実装の数は少ないものの、GoogleとAlibabaというビッグテックが推進しているというのは非常に大きなポイントであるように感じる。

Multi-Path QUICの利点としては、複数回線を束ねることで、片方の回線の品質が下がった場合にももう一つの回線でカバーできるという点。

仕様としては、複数回線で同じパケットを送信して冗長化を実現するというのがメインユースケースのようだが、複数回線で別のパケットを送信して複数回線の帯域幅をフルに活用するということも可能なようだ。

考えられるユースケースを書き出してみる。

- Youtuberが屋外配信する際に複数SIMを使って冗長化して送信することで屋外からでも高品質な配信を行う

- 放送局が屋外配信をする場合に複数SIMを束ねてより高品質な映像配信を行う

- 不安定な優先NWとCellular回線を束ねて冗長化して送信することで屋内でより高品質な映像配信・受信を行う

今後はstarlinkなども組み合わせるユースケースも考えられる。

一応既存の製品でも、peplinkやLiveUを利用することでMulti-Path UDPのようなことは可能なようだが、機材はそれなりに高額なようだ。一般ユーザーが簡単に使えるような形であればMulti-Path QUICを使った製品の普及はあり得るかもしれない。

また、プロユースケースならばユースケースが決まっているので、冗長化と高帯域幅のどちらが必要なのかは容易に決められそうだが、どちらを実現するのかを簡単に決められるような形であれば汎用的な製品になるので、それも一般ユーザーに好まれる可能性はある。

今のスマートフォン端末などではDualSIM可能な端末は多いが、このDualSIMも必要な時にNW回線を切り替えたり、通話とそれ以外の通信で使い分けたりしている。スマートフォン端末がSIMを複数刺している場合にこのMulti-Pathが簡単に使えるようになると機材すら不要になるので、そういった未来もありうるかもしれない。

Efficient multipath transport with QUIC in large-scale video services

IETFでの取り組みからもわかるが、AlibabaはMulti-Path QUICに取り組んでおり、ブログ記事や論文も提出されている。ここで開発されたQUICのマルチパス拡張はXLINKと呼ばれている。

Multi-Path QUICの利点

MP-QUICは、MP-TCPと比較してメリットがあるとされている。

QUICはカーネルに導入するのではなく、ユーザーランドで導入ができるため、MP-TCPよりも導入は簡単である。

OSのアップデートなどをすることなく、QUICライブラリのアップデートを行うだけで導入・更新が可能。

A/Bテストの結果

XLINKの有効性を検証するために、Taobaoモバイルで大規模なA/Bテストを行ったようだ。

このA/Bテストは、10万人以上、300万回以上の映像視聴で2週間に渡ってデータ収集がされている。

Multi-Path QUICとSingle-Path QUICで比較すると、99パーセンタイルでリクエスト完了時間は19%向上したとのこと。

TCPとQUICの比較は様々あるが、GoogleによればYoutubeの再バッファリングの時間が9%程度向上したり、スループットが7%向上したといった話もあるため、安定性・スループット両面の点から従来の仕組みからは改善が予想される。

重要な点

マルチパスを実現する際には、マルチパススケジューリング技術が非常に複雑であり重要であるとのこと。

従来のQUICのスケジューリングでは、99パーセンタイルで28%パフォーマンスが劣るらしいので、QoEの推定・スケジューリングアルゴリズムは非常に高度なものが要求される。

2021年時点でXLINKに導入されたスケジューリングアルゴリズムでも結果としてパフォーマンスが向上されたということなので、現時点でMP-QUICの有用性は確認されているが、今後もスケジューリングアルゴリズムの高度化は必要になりそうだ

参考

MoQT draft-12公開

2025年6月23日にMoQTのdraft-12が公開された。

- 不正なObject Trackについて基準が決められた

- Object IDが過去に受け取ったものより小さい

- Forwarding preferenceが過去のObjectと異なる

- Object Extension HeaderがObjectStatus=ObjectDoesNotExistのObjectに含まれている

- など

- Congestion Controlの仕組みについて

- MoQTは輻輳制御の仕組みについては指定していない

- アプリケーションによってそれぞれの動きについて考慮すべき

- Bufferbloat

- CUBICやRenoはRTTが高まると、パケロスが発生しなくてもHolBと遅延が発生する

- Apllication Limited

- 遅延に敏感なコンテンツの場合、利用可能な帯域幅よりも送信ビットレートは低くなければならない

- しかし、多くの輻輳制御アルゴリズムは帯域幅をMAXで利用している場合にのみ輻輳ウィンドウや帯域幅の推定値を増加させるため、NW帯域幅が過小評価される可能性がある

- Consistent Throughput

- 輻輳制御アルゴリズムは一般的に一貫性よりもスループットに最適化されていることが多い。

- 例えばBBRやRenoはロスを検出すると輻輳ウィンドウを半分に削減するため、送信レートが大幅に削減されてしまう。これは遅延に敏感なコンテンツでは体感品質に影響する可能性がある

- Bufferbloat

- Request IDの導入

- ANNOUNCEやSUBSCRIBEなどのControl MessageはRequest IDという概念で管理するように変更

- 以前はSUBSCRIBE IDで管理していたが、より細かくメッセージ単位で管理できるように

- クライアントリクエストは0スタートで偶数に、サーバーレスポンスは1スタートで奇数と定められた

- ANNOUNCEやSUBSCRIBEなどのControl MessageはRequest IDという概念で管理するように変更

- SUBSCRIBEメッセージの変更

- Track Aliasは削除

- Forwardプロパティの追加

- 0の場合はSubscriberにObjectを転送せず、1の場合は転送する

- Relayサーバーにおいて、SUBSCRIBEメッセージを受け取ったら、End Subscriberから受け取ったメッセージのForwardの値によらず、1としてUpstreamにSUBSCRIBEメッセージを転送する

- これによって、Relayは受け取るがEnd Subscriberに送らないという挙動が可能に。End Subscriberが動的に受け取るか受け取らないか決めたいので、帯域幅によってSubscriptionを停止したり再開したりできる

- Publishメッセージに追加

- 今までは、Relay, End SubscriberがObjectを受け取るにはSUBSCRIBEメッセージを送らなければいけなかったが、これではPublisherはObject転送開始を待たなければいけないので、Publisherからも転送開始を指示できるようになった

CloudflareのCDNがMoQに対応

遂にCDN事業者の中で、MoQに対応する会社が現れた。 この記事を書かれたMike EnglishさんはIETFのMoQTの議事録でも名前を見かけていた方である。

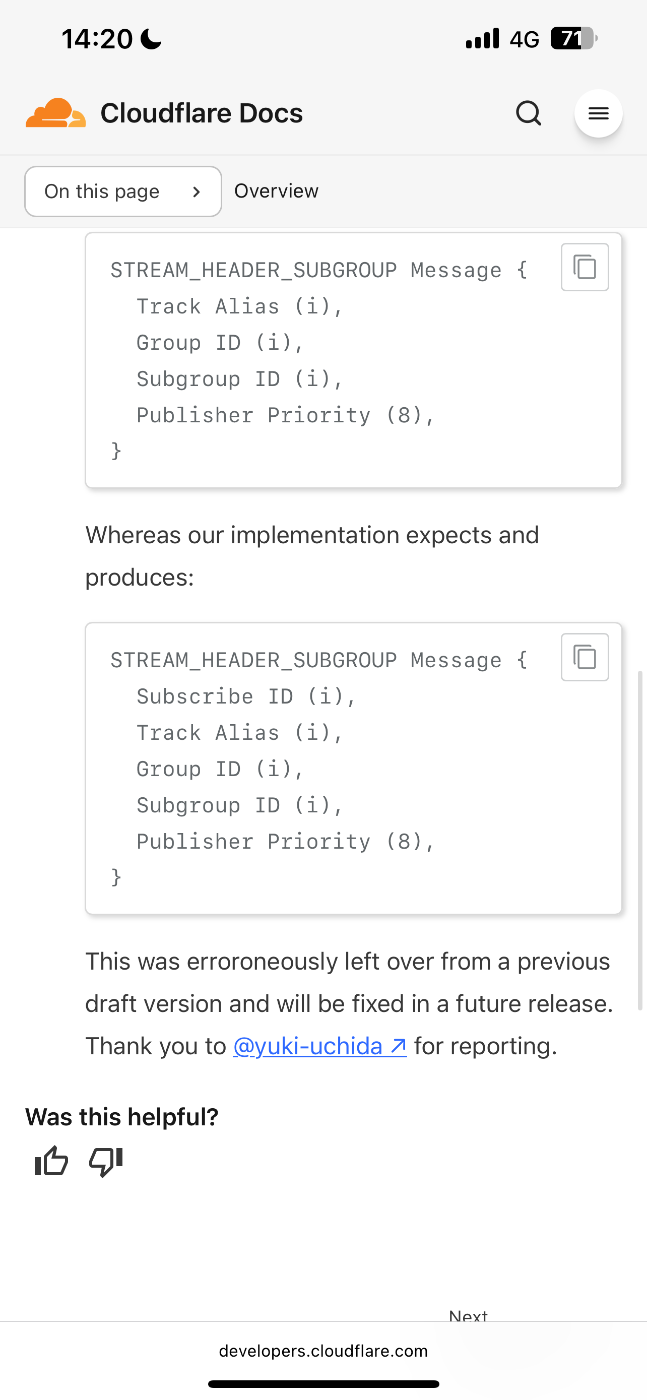

CloudflareのMoQ CDNはmoq-rsをforkして作ったらしく、IETFのdraftで言えば07準拠である。SubgroupStreamHeaderにSubscribe Idが含まれる点だけでは、moq-rs独自の仕様なので、ここは注意が必要そう。

相互接続試験してみた

moq-wasmをdraft-07準拠に下げて繋げてみた。MoQ CDNとの接続成功しました。

CloudflareのCDNを使うためには https://relay.cloudflare.mediaoverquic.com:443 にWebTransportで繋げてあげる必要があります。MoQは仕様的にはQUICにも対応しているが、Cloudflare CDNはまだQUIC対応していないので必ずWebTransportで接続すること。

QUIC Streamを使用した場合は、おおよそ50ms程度の遅延で配信が出来ました。Cloudflare CDNまでのRTTは10ms程度なので、Pub -> CDN -> Subまでは20ms程度でデータが送信できています。あとはエンコード時間とかパケタイズの時間が20ms程度あって、合計で50msって感じ。

CloudflareのCDNが勝手にスケールしてくれるので、このデモも簡単に数万人〜に配信できると考えたら感動します。

QUICのDatagramやbitrate制御、Priority設定などをやれば、遅延と品質のトレードオフを自分で調整できるようになるので、今後はRelayサーバー側はCDNに任せてトレードオフのノウハウを溜めていく必要がありそう

所感

CDN事業者がRelay実装の役割を担当してくれることでこんなに楽になるのかと感動した。moq-wasmはサーバー実装も行なっているが、多段スケールとPriorityに応じたスケジューリングなどの機能を実装するのが難しいなと感じていた。自分で実装してみたい部分ではあるけど、今はユースケース探索や、提供価値にフォーカスしたいので、技術的な困難に立ち向かって時間がかかるのは避けたい。

今後はmoq-wasmのサーバー側実装は軽めにやりつつ、クライアント側のコードを増やしていく時期になりそう。

今のところはCloudflare CDNはサービスとして使えるわけではなく、 https://relay.cloudflare.mediaoverquic.com:443 を好きに使っていいよって感じなので、バリバリ使って貢献していきたい。 今の所、「〇〇のPoC作ってるんだけど録画データ見たいからFETCH対応して欲しいな〜」とかは要望出せそうな気がする。

元Discord,元TwitchのLukeさんは、MoQTは仕様の議論の進み具合に反して、ビジネスやユースケース的な議論が足りておらず、もっとたくさんデモやサンプルを作るべきだと言っていた。これは個人的にも同感で、僕は「今まで実現していなかったけどMoQによって実現する世界はどんなものなのか」を未だに言語化できていない。なぜなら、高品質であればHLS、低遅延であればWebRTCと、複数のプロトコルを組み合わせることで大抵のことはできてしまうから。MoQじゃないとできないことはなんなのか?っていうのを考えた時に、思いつかないことはないけど、キラーユースケースかって言われると怪しい気がする。例えば映像配信業界がHLSやRTMPによっていくらのお金を産んだかを考えると、MoQでそれだけのインパクトを出すのは難しそうだ。

CloudflareのCDN自体も、「とにかくたくさんアプリケーション作ってもらってキラーユースケース見つけたい」という気持ちがあると予想している。

技術仕様の議論がそれなりに進んでいて、CDN事業者も対応してきて、技術としては整っている。個人の体感的にもMoQがスマートで素晴らしい仕様であることはそれなりに納得できているものの、だからと言って普及するかは別の話。

Cloudflare MoQ CDNの仕様と違う点について

draft07に準拠していると書かれているが、SubgroupObjectのStreamHeaderにSubscribe Idは仕様上要らないはずなのに入ってるって報告したらMoQ CDNのページに追加してくれた。一応僕が伝える前から把握してたようだけど、名前も載せてくれました。嬉しい。

Amazon Primeの独自プロトコル

Amazon PrimeはSyeという独自プロトコルを採用しているらしい。確証はないが、色々見てみるとQUICっぽい?Syeプロトコルはスウェーデンの会社が開発したプロトコルで、Amazonがそれを買収してAmazon Primeに適用した形。

Amazon公式が説明している動画もある。

公式の動画を見てみると、メディアのアップロードからダウンロードまでSyeで出来るということなので、従来のRTMP + HLS/DASHのような形式ではなく、MoQTのように一気通貫で出来るプロトコルのようだ。

このSyeプロトコルの仕様は公開されていないので、Amazon Primeと提携しているCDNは裏で情報をもらってSye対応をしているということだろう。

Lukeさんが運営しているMoQのDiscordグループでこの辺りの話がされている。Lukeさんが以前にtwitchにいた時の話も呟かれているので、興味があったらグループに参加してみて頂ければ。

このSyeプロトコルはMedia over QUIC Transportの競合となるプロトコルであるが、CDN事業者は独自プロトコルが乱立されると対応が面倒なのでIETF標準の仕様だと嬉しいだろう。あと、Lukeさんやその他によると品質が良くないらしい? これが仕様が問題なのかは分からないが、公開仕様にしていなかったり、CDN提供の企業で有名なCloudflareやAkamaiのエンジニアがMoQのWGに来ていることから、Syeが業界標準になることはあまり想定していないのだろう。

2025年11月時点ではPrime Videoのライブ配信ではSyeが使われており,WebTransportセッションが張られていたので確かにQUICを使っている様です.クライアントのコードを見たところMoQではなさそうでした.

MoQ オープンソースコンソーシアムの設立

RTC.ONというイベントに伴って、webrtc.venturesが以下の動画を公開していた。

この動画の中で、AkamaiのWill Lawが登場し、Media over QUICは2026年での仕様策定を目標としており、その中でMoQのオープンソースソフトウェアコンソーシアム openmoq を立ち上げたことが述べられていた。

openmoqの公式サイトはこちら。

現時点でこの団体に興味を持っている、参加するかもしれない企業は以下の通りらしい。

- Akamai

- CDN77

- Cisco

- Synamedia

- Youtube

個人的には、Google参加のYoutubeがMoQに興味を持っているというのは驚きだった。google自体quicheというライブラリの中でmoqtに対応していたりはするが、IETFでのMoQ WGで常に登場していたという印象ではなかったので、MoQの主要ユースケースの一つである大規模配信サービスの企業が名を連ねているというのは大きなポイントになりそうだ。

最近では、Cloudflare で MoQ CDNが使えるようになっていたりと、CDNと大規模配信サービスの企業の取り組みが増えており、MoQ界隈の動きが加速しているように感じる。

Media over QUIC はMedia以外にも使える

Will Lawは Media over QUIC の Media という単語は外すべきではないかという意見を持っているようだ。これは、MoQの仕様は Mediaの配信にのみ適用できるものではなく、それ以外の GPSデータやソフトウェア配信、データベースの更新など様々なものに使えると考えているからだ。WebRTCの領域から興味を持った自分としては、高品質な配信はHLS/DASHが、低遅延の会議はWebRTCがかなりの部分を賄えていると思っていたので、メディア以外にも適用できるプロトコルとしてMoQを策定するのは非常に良い方向だと感じた。たとえば、IoTデバイスにおけるMQTTなどはMoQTと同様のPubSubプロトコルであり、昨今ではMQTT over QUICのようなものも出てきているので、MoQTでMQTTとRTMPとWebRTCをまとめることができるようになると、IoTデバイスでも複数のプロトコルスタックを使わずに済むのでCPU利用量や通信の効率化の観点で嬉しいかもしれない。

CDN事業者などがどう考えているのか雰囲気として読み取れたので非常に理解が深まった点である。

WebRTCH4cksの記事について

WebRTCで有名なブログサイトで、CloudflareのMoQ記事に言及する記事が公開されていた。

英語の記事であるので正確なニュアンスを捉えるのが難しいので、以下は自身の理解として受け取ってほしい。

この記事は、以前に出た CloudflareのMoQ記事に関する反論や皮肉を含んだ記事になっている。

要約すると以下の通り。

- MoQ記事に書かれているWebRTCのアーキテクチャの課題は的外れである

- Media over QUICのTransport層として使われるWebTransport APIは統計データを見るとリリース5年をたった今でも全く使われていない

- Cloudflareの記事では、「Meta, Google, CiscoがMoQに携わっている」と書かれているが、これは奇妙だ。こう言った記事で他社の名前を出すことは通常ない。これらの企業でMoQに携わっているエンジニアは存在するだろうが、それは企業を代表してMoQを支持する宣言をしたわけではない。(Googleがlibwebrtcを支持し、その後10年以上メンテナンスし続けたのとは訳が違う)

- こういった記事は、組織を説得するために書かれたものであり、非常に政治的な記事だ

- WebRTCは確かに妥協を強いられたが、MoQは妥協しなくて良いというのは甘い考えである

- MoQに移行するのに成功したものはまだいない

Cloudflareの記事に対する感想

この記事は、WebRTCを誤った理由で貶したことに対する怒りの記事だと感じた。この記事を書いた人はPhilippという方で、長年WebRTCに関わっている方である。

実際、CloudflareのMoQ記事は、Media over QUICこそがメディアストリーミング業界の銀の弾丸だと思われる書き方だったことは否定できないと思うので、怒りの反論記事が出るのは納得である。

例えば、Media over QUICの技術はこれからかなりの困難が発生する。その困難に関してはこの記事では言及されていない。

- 超低遅延のための各種チューニングをやる必要がある

- webrtcは10年以上かけてそれをやってきた

- CDN事業者がMoQに対応する必要がある

- Cloudflareはテストサービスとしてリリースしているが、他のCDNはまだ

- ブラウザがWebTransportやWebCodecsに対応する必要がある

- Chrome, Edgeは対応しているが、Safariは2025/10/22時点で未対応

- Chrome, Edgeも優先制御など未実装の機能がある

- 各種ユースケースに応じた適切なチューニングをする必要がある

- webrtcはウェブ会議に特化していたのでチューニングしやすかっただろうが、ユースケースが広がるとそこのチューニングの難易度も上がるだろう

- 既にWebRTCで実現されたシステムをMoQに置き換える困難

- 超低遅延のWeb会議をわざわざWebRTCから置き換えるの?WebRTCのままで良くない?

- 1対1通信ならP2Pも出来るけどMoQだとサバクラ前提なので出来ない

- ユーザー視点での利用価値

- 従来通りWebRTC + HLS + その他プロトコルを使い分けていた状況からMoQに乗り換えるインセンティブは果たしてそんなに大きものなのか

- 市場・ユースケース開拓の困難さ

- MoQはWebRTCとHLSのギャップを埋めるプロトコルとして有用かもしれないが、そのギャップを埋めた所で新たな市場が開拓できるわけではない(可能性がある)。となると、新たな収入源にはなり得ないかもしれない

こういった点で、MoQの価値と普及を確信するのはかなり難しい。

なので、Cloudflareの記事のように、MoQを銀の弾丸かのように描写するのはあまりよろしくなかったのではないかなと、この記事を読んで改めて思った。

そして、この記事が政治的に書かれた・使われることは容易に想像できる。それが良いか悪いかはわからないが、悪い方向に進む可能性もあるだろう

webrtchacksの記事に対する感想

一方で、webrtchacksの記事もかなり感情の籠った記事であり、こちらもあまり大人な書き方ではないなと感じた。

記載内容にも突っ込めるところはいくつかあるんじゃないかと思う。

例えば、「WebRTCのgetUserMedia APIはたくさん使われてるけどMoQのWebTransport APIは全然使われていない」という主張は「リリース15年弱のWebRTCと5年のWebTransportを比較して意味あるの?」とは感じた。WebRTCもリリース5年のタイミングではそこまで普及してなくてgetUserMedia APIもほとんど使われてなかったと思うし。

WebTransport APIが使われていないっていうのも、「WebTransportを使って何をやるか」がやっとMoQで決まりかけてきた所なので、比較するレイヤが違うしタイミングも適切じゃないと思う。

また、「他社が携わってると書かれているが、これはGoogleがwebrtcを支持したのとは訳が違う」という主張については、もちろんそうだと思いつつ、最近は OpenMoQというソフトウェアコンソーシアムのような組織が設立され、YoutubeやCisco, Akamaiなどがお金と人員を割いて活動を行うことが予想される状況ではあるので、多少の希望はあるんじゃないかなと思っている。

MoQのメリットに関しても一才触れられなかったので、メリデメがきちんと整理できた記事ではなかったかな。これはCloudflareの記事もそうなので意趣返し的にわざとやっているのかもしれないが・・・

両者の記事に対する感想

WebRTCを下げてMoQを上げるように感じられる記事を読んで、怒るのは理解出来るが、その怒りを表明するためにこういった記事を書かれたのはちょっと悲しい。webrtchacksの記事も、自身の主張をするために都合の良いところを切り取ったように感じたので、両者の肩とも持ちづらいみたいな状況。

ただ、この記事によって多くの反応があって、Linkedinのコメント欄は必見である。賛成・反対の両者の意見を沢山見ることができる。

また、このコメントに対しての記事として、以下のような記事もあるので併せて読むと良い。

参考になった・面白かった意見を意訳・まとめておく。(かなり個人的な理解を混ぜて捻じ曲げているので直接読むことおすすめする。)

また、これら一つ一つのコメントの是非については置いておく。

- MoQに切り替えることで劇的なパフォーマンス改善は期待できない

- Web会議のためにMoQに大量の機能を追加するのは投資として納得できない可能性が高い

- MoQを適用するとWebRTCと比較してはるかに簡単になる

- libwebrtcに変更を加えるにはGoogleに対するロビー活動が必要なのが現状だ

- 大規模配信ユースケースで現時点で新たな技術を選ぶとしたらMoQを選ぶだろう(ICE, NATホールパンチなど、WebRTCは複雑である)

- 現時点でMoQはWebRTCと比較したときに新たな市場を開拓しない。超低遅延業界は生き残りを賭けて苦しんでいるため、MoQはWebRTCユーザーとマーケティング戦略のために採用される。

- MoQは多くの可能性を秘めているが、だからと言ってWebRTCを貶すべきではない

- 将来的に、配信ユースケースでMoQが使われている可能性は高いでしょう

- MoQとWebRTCは共存するのではなく、別のユースケースで使い分けされることになるだろう

- MoQが否定されるのは、変化を恐れる人間のサガではないか

- MoQではライブ/タイムシフト/オンデマンドといった様々なユースケースにおけるプロトコル変換を全て回避できる

- Red5 Proでは2025年末までにMoQプロトコルを追加する予定である

WebRTC DataChannel(SCTP) vs QUIC Stream/Datagram

MoQTでは、映像・音声以外のデータも送信できるように設計されている。

WebRTCも同様にDataChannel(SCTP)でメディア以外の送受信が可能だ。

実際に、ZoomのWebクライアントはWebRTC DataChannelを使って大規模にデータを流していた。

Zoomは映像や音声のメディアデータをDataChannelで送信していたと思われるので、パフォーマンスの差は分からないが、一般ユーザーに使って貰えるレベルの品質で提供できたという証拠になりそうだ。

ちなみに、2025年11月6日時点では、ChromeでZoomのWebクライアントを立ち上げてみると、映像も音声もWebRTC MediaChannelで送受信しているようだ。(無料ユーザーとして、Chromeを立ち上げてみた場合)

ちなみに、以前はVideoをWebRTC DataChannelに流していたような痕跡も残っている。今も偶に100bitほどのメッセージをやり取りしているようだ。完全にDataChannelから移行したかは分からないが参考までに。

WebRTC DataChannel(SCTP)でも問題なく映像や音声を送信し、会議アプリケーションを構築できるというのはZoomが証明しているところではあるが、パフォーマンス的にはどうだったんだろうというのが疑問だ。世間一般には、「Zoomは品質が高い」と言われることもあるが、WebRTCもかなりチューニング等がされてきていて、ZoomがWebクライアントでもMediaChannelを使うことになっている状況を見ると、現時点では大差はないのかもしれない。

ちなみに、ZoomがWebSocketを使って映像や音声の送受信をやっていたであろう2018年のbloggeek.meの情報を見ると、WebRTCの方が品質が良かった調査結果もある。(これはサンプル数=1であり、学術的には証拠にはならないが)

WebSocket vs WebRTCで言えば、TCPベースとUDPベースのプロトコルの差が発生するので、Zoomが大きく劣っていてもおかしいことはない。

2019年9月ごろからZoomはWebRTC DataChannelを採用してWebSocketから移行した。

WebRTC MediaChannelではコーデック周りのチューニングが困難だったのでWebRTC DataChannelを採用したようだ。

WebRTC DataChannel(SCTP) と QUIC Stream/Datagram の比較

ここで、WebRTC DataChannel(SCTP) vs QUIC Stream/Datagram の比較をしてみる。おそらくZoomは大量のチューニングを入れて商用レベルの品質を実現していたと思うので、そこは一旦抜いて、プロトコル的な側面からのみ比較をする。

この比較は、Internet Draftでも提出されているので、それをベースにNotebookLMに整理して貰った。

両方ともUDPベースなので、ここだけをみると同じくらいのパフォーマンスが出そうだが、細かい点は異なる。また、両方とも到達保証のあるReliableモードと到達保証のないUnReliableモードがあるがまとめて記述する。

| 比較項目 | DataChannel(SCTP) | QUIC |

|---|---|---|

| ベースプロトコル | SCTP over DTLS over UDP | QUIC over UDP |

| 初回接続 | 4-way(DTLS + SCTP) | 0-RTT/1-RTT |

| 再送単位 | チャンク(メッセージ単位) | パケット(複数フレームを含む) |

| Head-of-Line Blocking | Association内で発生? | Stream単位で独立 |

| ACK機構 | 累積TSN ACK + Selective ACK | 範囲ACK(ACK Range) |

| 輻輳制御 | TCP-friendly(NewReno系?) | BBR / CUBIC / Reno など |

多少間違いはあるかもしれないが、大きな差分は上記の通り。

気になっている部分は、WebRTC DataChannelではHoLBが同一Association内ではStreamが分かれていても発生すると書かれている点だ。

「WebRTC DataChannelではTransmission Sequence Number(TSN)がアソシエーション内で結合されているため、パケットが失われた場合はその後に続くTSNを持つすべてのパケットが詰まってしまう」ということのようだ。

WebRTC PeerConnectionを複数立てれば実質問題はないが、これはこれで面倒だし、ICEやSCTPのkeep-aliveのシグナルなどがチリツモで大きくなっていきそうな気がする。PeerConnectionが複数あることで協調的に輻輳制御されず、お互いに食い合ってしまう問題もあるかもしれない(実験していないので分からないが)

大きなデータを送信したいとなった場合、WebRTC DataChannelでは不都合が出てくるかもしれない。

テキストチャットやリアクション程度であれば問題はないと思うが、ビデオのような大きなものを一つのPeerConnectionで送信しようとすると問題が発生するかも。複数のPeerConnectionを立てればこの問題は回避できるものの、複数のPeerConnectionを貼ることでCPUを食ったり、keep-aliveのシグナルがオーバーヘッドになる可能性もある?のでちょっと気になるところではある。

あとは、輻輳制御アルゴリズムについてもQUICとは異なる部分があり、パフォーマンスに影響してくるかもしれない。

libwebrtcの中身までは自分で確認できていないのだが、SCTPはTCP-friendlyな輻輳制御アルゴリズムを使う前提で仕様策定されている。(ChatGPTはlibwebrtc/pionはTCP-friendlyで有名なNewReno系っぽい実装だと言ってた)

メディアのような大きなデータやセンサーデータをリアルタイムに送るとなると、TCP-friendlyな輻輳制御アルゴリズム(NewReno/CUBICなど)はあまり採用されない。

NewReno/CUBICはパケロスベースだが、QUICで選択できるBBRは帯域幅と遅延ベースであり、WebRTCで利用されているGCC(Google Congestion Control)はジッタとパケロスベースである。

スループットで言うとNewReno/CUBICはあまり良い数値が出ないので、QUICやWebRTCでは採用されていない。なので、SCTPとQUIC Streamを比較した際に、ここのアルゴリズムによってパフォーマンス(スループット)に差が出る可能性がある。

また、SCTPは、TSNという番号をパケットに付与している関係上、再送を行なった場合に、ACKが返って来た際にそれが元のパケットのものなのか再送パケットのものなのかが分からない。これによって、RTTの推定値が不正確になることがある。これは、再送タイマーや輻輳ウィンドウの更新に関わっているので、結果的に輻輳制御の精度を悪化させる要因になる。

他にも、再送がメッセージ単位であるが故に、適切な部分のみを再送できなかったり、ストリーム間で送信詰まりが発生したりなど細かい課題がSCTPにはあったようだが、libwebrtcで採用しているdcSCTPでは大量のチューニングが入っている(I-DATA/PR-SCTP/Unordered)ので、通信の無駄や処理詰まりは解消されていて、QUICに近い性能が出るようだ。(ChatGPTによると)

所感?

SCTPとQUIC Streamについて比較してみたが、SCTPはめちゃめちゃチューニングされているものの、かなり古いプロトコルであることもあって、大容量のデータ通信にはマッチしない可能性があるかもしれないと感じた。(実際にスループットなどの実験していないので濁させていただく)

ChatGPTやClaudeと議論してみたが、アソシエーション内でのHoLB・RTT推定値の誤差・輻輳制御がTCP-friendlyな部分はそれなりに大きな差になりそうだ。

次は実際に実験をして性能比較をしてみたい。

参考文献

Challenges in Transporting Sensing Data with Media Over QUIC(draft-03)

MoQを使ってセンシングデータを送りたいというドラフト。MoQの文脈ではIoT関連の話は少なめだが、中国企業には注目されている雰囲気があり、たまにドラフトが出たり論文が出たりしている。

ユースケース

- 自動運転ユースケース

- 自動運転車は、車載センサーだけではなく外部ソース(交通信号・周辺車両からのデータ)のリアルタイムセンシングデータに依存しているため、MoQを使ってリアルタイムに送受信可能にしたい

- 衝突警告などの重要なセンシングデータは高優先度に、交通情報更新など重要度の低いデータは低優先度で送信したい

- スマートシティユースケース

- 自動運転のユースケースと同じ感じで、交通カメラや汚染モニター、ユーティリティセンサーのセンシングデータを送受信したい

- 緊急事態やシステム障害などの重要イベント発生時に優先的に中央制御システムに送信して即時対応を可能にしたい

- IoT化された工場

- 振動・温度などのセンサーデータを監視システムに直接ストリーミングし、迅速な異常検知と対応を可能にしたい

- 重要検知データを冗長ストリームを有効化して悪条件化でも確実な配信を行いたい

MoQで解決したい・すべき課題

6Gネットワークにおけるセンシングデータ伝送のためにMoQを適用するには、解決すべき課題が多く存在する。

現状の課題は7つ

- マルチシナリオ適用性

- 多様なシナリオで遅延・スループット・信頼性などの要件に対応できるかを保証すること

- P2P通信も含めたいと考えているよう?

- 効率的なデータ伝送

- 小さくて頻繁なデータパケットのオーバーヘッド削減

- バースト的なデータパターンの伝送の最適化

- 匿名性

- センシングデータの機密情報を守るために伝送中の匿名性を確保

- データセキュリティ

- センシングデータの改竄などはリアルタイムシステムの運用にとって非常に驚異になるため、機密性・完全性・真正性を保証

- 追跡可能性(トレーサビリティ)

- センシングデータのログを記録できるように

- 情報認識

- データ配信の決定を最適化するためのNWトポロジの認識など

- QoS保証を確保して配信メカニズムをNW管理の観点からも調整すること

- センシングデータを利用するサービスやアプリケーションを特定できること

- マルチソース統合と拡張性

- 生成される膨大なデータ量を効率的に分散・集約する

MoQを採用することの良さ

- PubSubアーキテクチャは大量の多様なセンシングデータを配信するのに適している

- データのキャッシュが可能なので冗長なデータ収集と伝送を回避できる

- 途中経路でデータを覗き見できないためセキュリティが確保できる

MoQのObjectHeader構造の変更

センシングデータをMoQで流す場合、データの種別やQoS情報、NW情報、サービス情報をなどを考慮しながら伝送したいので、かなり多くのメタデータを付与したい。

従来のMoQのObjectHeaderに加えて、Extended Metadata Headerとして、4種類の情報を付与したい

- DataInfo

- Data Name

- Data Feature

- Semantics Token

- Data Representation

- Data Hash

- NetworkInfo

- Network ID(PLMN ID)

- Cell ID

- Node ID

- Tracking Area Code

- Sensing Region ID

- ServiceInfo

- Service ID

- Task ID

- Mission ID

- SFC ID

- QoSInfo

- QoS Indentifier(QI)

- Timestamp

- data quality

- data transmission QoS

- data processing QoS

MoQで通話アプリのサンプルを作ってみた

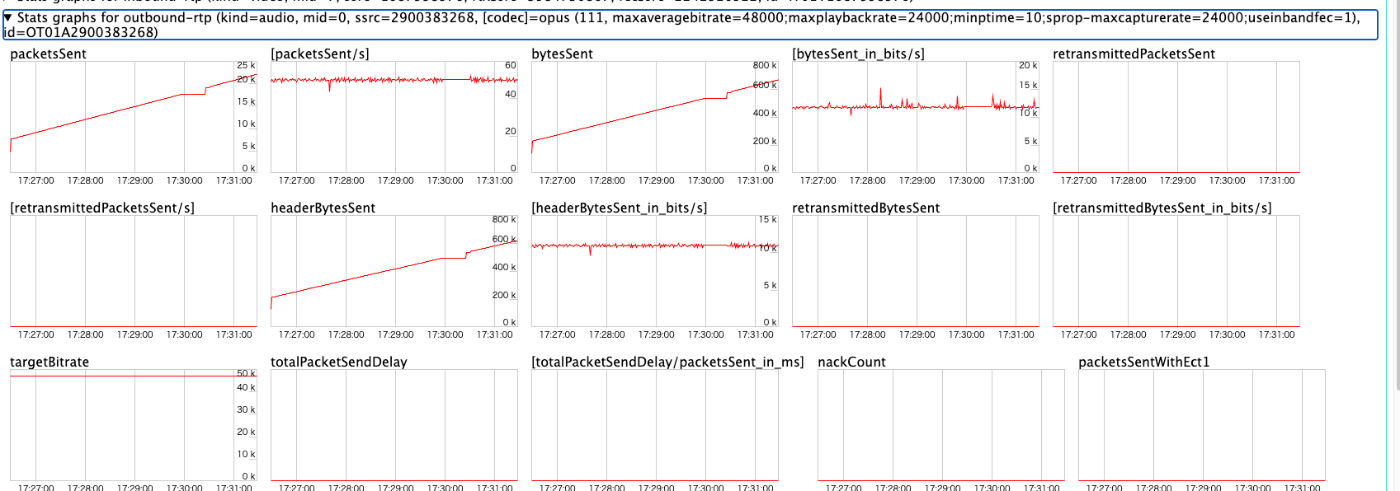

チマチマ実装しているmoq-wasm を使って、通話アプリを実装した。

1Mbpsの映像と64kbpsの音声を流しており、通信方針はWebTransport(QUIC)のStreamを利用している。

中継サーバーはヨーロッパ。

やってみての所感

ヨーロッパにRelayサーバーを置いており、距離的にはそれなりなはずだが、300ms程度の遅延(50ms程度のバッファ含む)で通話が可能だった。

QUICのStreamはQUIC Datagramとは違い、Stream内で再送処理が入っているので、UDP likeというよりかはTCP likeな通信方式。

TCP likeな通信方式なので、通話ユースケースではパケ詰まりが気になるかなと思ったが、安定したNW環境では全く問題なく通話が可能だったことにとても驚いた。

これは、QUICのStreamがTCPと比較しても再送が高速だったり、輻輳制御の仕組みがCUBICではなくBBRを使えることに起因しているんだろうと予測している。

映像と音声の同期を取ったり、NW帯域幅に応じたbitrate制御などをやらなければWebRTCにはとても及ばないが、こんなに簡単に、「使えなくもない通話アプリ」を作れることは大きな収穫だった。

(NW帯域幅が狭くなったら遅延が積み重なっていったり、音声の再生が追いつかなくなったりする問題は既に把握していて、商用レベルとは全く言えないが)

依然として、Web会議ユースケースにMedia over QUICを使うのは無駄が多い上に、WebRTCを超えられると思っていないので反対寄りの考えだが、世の中には「Web会議レベルの超低遅延は別に必要ないんだよな、TCPだと遅いけど」ってユースケースはそれなりにあるんじゃなかろうか。

例えば、低遅延な大規模配信はMoQのメインユースケースに据えられていることもありかなりマッチしている。QUIC Streamを使えばかなり簡単に低遅延にすることができるし、将来的にはCDNの後ろ盾によって、スケーリングをCDNに任せたり、安く配信ができるかもしれない。

実際にOpenMoQという団体でもYoutubeやCDN77などの企業が参加しているし、Red5 Proというストリーミング配信の会社もMoQ実装を公開した。

また、LLMと通話を繋げて会話をするようなユースケースや、カメラの映像をリアルタイムにサーバー側で解析したいユースケースなどもMoQがマッチするかもしれない。

監視カメラの映像をRTMPやUDPでクラウドにアップロードしているような場合も、MoQでアップロードからダウンロードまで簡単に実現ができるし、録画視聴もリアルタイム視聴も可能だ。

課題とか将来の話

QUIC Streamの力はかなり感じたものの、QUICはUDPの上に位置するプロトコルなので、UDPが通らなければQUIC Streamは使えない。WebRTCはTURN-TCPがあるのでそことの差は大きい。

WebTransport over HTTP2が簡単に使えるようになったら、フォールバックとして扱えるので嬉しいが、実装はあまり進んでいなさそうな気がする。。。WebTransport over HTTP3の方もまだSafariは対応していない。

残念ながらブラウザベンダが乗り気になってくれないとブラウザでMoQをやるのが困難なので、かなり苦しい。(これはWebRTCも同様で、SafariのWebRTC対応はかなり遅かった)

他にも、WebTransportの統計情報を見るgetStats APIがどのブラウザも未実装だったりする。

QUIC/WebTransport Streamだと、メッセージ単位で吐き出されるので、メッセージにtimestampを埋め込んだとしてもパケット単位のレイテンシは取れず、レイテンシ/パケットジッターベースのbitrate制御などは難しい。

GoogleはWebRTCの時と違ってWebTransportやMoQに全力な姿勢を見せていないので、外部の人間がかなりのプレゼンスを出して行かなければいけない。難しい。

このように色々と課題があり、まだまだ時間はかかってしまいそうだ。

WebTransportが登場して5年、Media over QUICが登場して3年ほど経ってしまっているが、CDN事業者やら配信事業者やらの動きは見えてきているので、もう少しウォッチしていきたい。

個人的には、今回の実装で「大体のものはQUIC Streamでよくね?」という気持ちになったのでMoQに限らずQUIC関連の動きは楽しみである。

MultiPath QUICはかなり面白い技術だと思っているのでMedia over MultiPath QUICになってくれたらなぁ。

GoogleやAlibabaというビッグテックがMultiPath QUICに取り組んでいるのでもしかしたら普及する可能性が高かったり?するかも。でもその時はMultiPath QUICに何を載せるんだって話になってやっぱりMediaでしょ!ってなって結局MoQも取り組まれるかもしれない。