【Mac】LM StudioとDifyでDeepSeek-R1-Distill-Qwen-7Bをサクッとローカル環境で触れるようにする

DeepSeek-R1-Distill-Qwen-7BはDeepSeek-R1の蒸留モデルです。

蒸留モデルとは

LM Studioのインストール

Download LM Studio for Mac (M series)からインストールを進める。

Deepseek R1のインストール

LM Studioを開いたら、左メニューのDiscoverからDeepseek R1を検索する。

表示されたら、右下に緑のDownloadボタンが出ているはずなのでそれを押す。

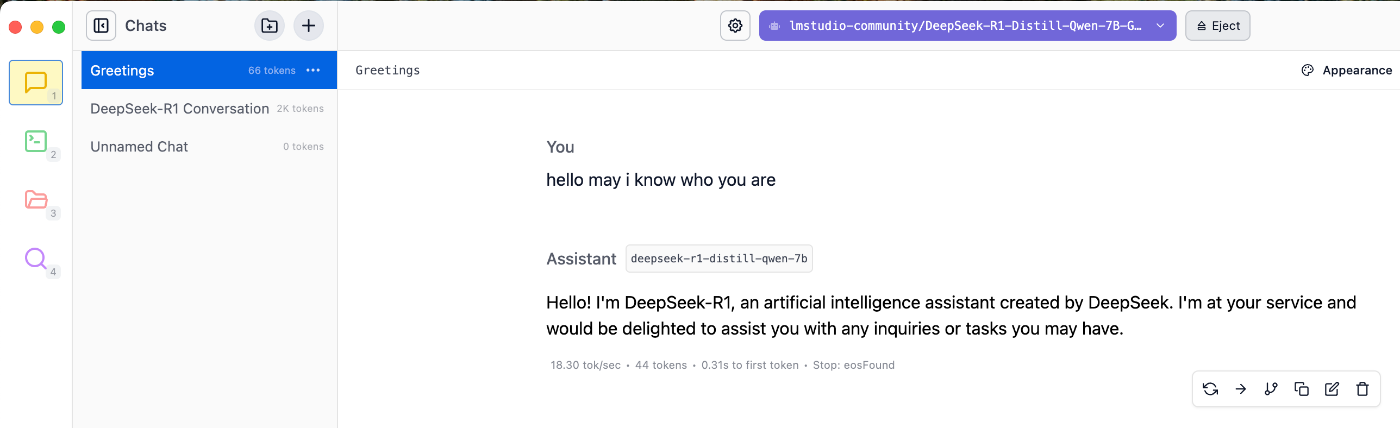

これができたら、LM Studio上でチャットができるようになります☺️

では、チャットボットなども作りたいのでDifyに環境を作っていきましょう。

Difyの環境構築

引用:

前提条件

Dify インストール前に, マシンが最小インストール要件を満たしていることを確認してください:

CPU >= 2 Core

RAM >= 4 GiB

Difyのクローンからこちらの手順に従って行なってください。

localhost/installにアクセスして、test@example.comなどでアカウントを作っておきましょう。

接続する

LM Studioの動作状況とポートを確認

デフォルトは1234

DifyからAPIを叩く

http://localhost/appsにアクセス。

アイコンのところを押すと設定が開けるので、モデルプロバイダーからOpenAI-API-compatible を探して選択してください。選択したら、モデルを追加を押します。

すると、モデルの追加画面が出てきます。

新たに入力しないといけない必須項目だけ言及します。

Model Name

適当で大丈夫です。deepseekなど

API endpoint URL

これがつまづきポイントでした。Dockerコンテナ内の Dify からホストマシン上で稼働しているLM StudioのAPIへアクセスするには、デフォルトではホストマシンのlocalhostを直接参照できないために以下のように指定しました。

http://host.docker.internal:1234/v1

保存。

これでチャットボットを作成してモデルを押せば候補に出てくるはずです。

typoしてるのは許してください。(探さなくていいですよ)

TIPS

接続がうまくいかない時の動作確認。

curl -X GET http://localhost:1234/v1/models

{

"data": [

{

"id": "deepseek-r1-distill-qwen-7b",

"object": "model",

"owned_by": "organization_owner"

},

{

"id": "text-embedding-nomic-embed-text-v1.5",

"object": "model",

"owned_by": "organization_owner"

}

],

"object": "list"

}

もし何かあればお気軽にご連絡ください🙏

間違い等ありましたらご教示お願いします。

Discussion