【論文備忘録】人間の言語は生成AIフレンドリーではないから新言語を作ってみた件について- Google DeepMind

はじめに

ヤマダと申します。情報科学と言語学を大学で学び、記号論、記号創発論、(記号と人間・テクノロジーの関係)について思考・探究している僕が、気になる論文について私見多めにまとめた記事です。

ChatGPTと速度感重視で理解することを意識しました。

今回は、Google Deepmindの研究者が書いた「We Can’t Understand AI Using our Existing Vocabulary」(私たちの既存の語彙ではAIを理解できない)についてです。

論文リンク: https://arxiv.org/abs/2502.07586

簡潔な結論

超簡単に言うと、

「人間の言語じゃ生成AIが理解しにくいから、ルールを定めて彼らに特化した新言語を作ろう。それで対話したらお互い快適に会話できそうじゃん」

という内容です。

注釈:もし理解が間違っている部分がありましたら、優しく教えてください。

面白いところは?

本論文の興味深いところは、以下の3つのポイントに集約できます。

-

人間とAIの認識ギャップとコミュニケーションの壁

従来の語彙だけでは、AIの内部概念や挙動を正しく理解・制御できないという根本問題に着目。

AIと人間の間に存在する「コミュニケーションギャップ」を解決するための画期的な方法。 -

適切な抽象度を持つネオロジズムの提案

新たな単語(neologisms/ネオロジズム)は、具体的すぎず抽象的すぎない「ちょうどよい」抽象度を持つことで、複雑な概念を簡潔に表現可能に。

これにより、AIと人間が共通の言語を作り出そうという取り組み。 -

Neologisms/ネオロジズム埋め込み学習と実験結果

モデルの重みはそのままに、新たな単語の埋め込みだけを学習するという斬新な手法を導入。

例:- 「length neologism(ensurehw)」を用いることで、従来の方法では目標とする文章の長さを生成できなかったモデルが、指定された文字数に近い応答を出力。

- 「diversity neologism(diversehw)」を導入すると、回答のバリエーションが大幅に向上し、より多様な応答が得られる。

全体構成の見直しと内容理解

- AIを理解するにはネオロジズムが必要

- 反対意見とその反論

- 他の解釈可能性研究との位置づけ

- 実証実験:ネオロジズム埋め込み学習

- ネオロジズムの正体とは?その思想は?

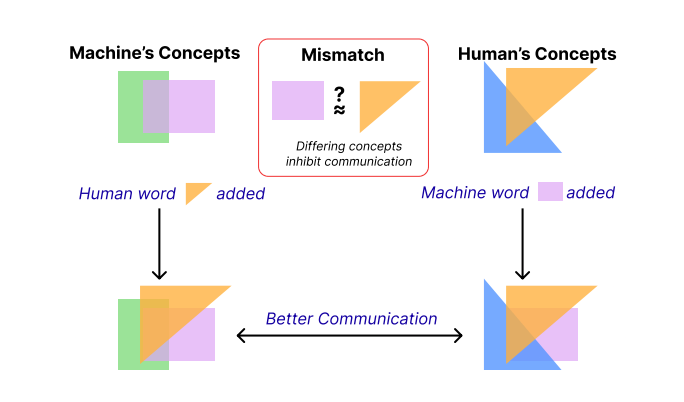

Figure 1. Humans and machines conceptualize the world differently from each other. Mismatches in communication occur, which lead to misunderstandings. To understand and control AI, we must bridge this gap by developing new words corresponding to human and machine concepts, and use these words to control machines.

AIを理解するにはネオロジズムが必要

AIと人間が効果的にコミュニケーションし、制御を行うためには、新たな単語(ネオロジズム)の導入が不可欠であると論じられています。

まず、AI理解に伴う根本的な課題として以下が示されます:

-

概念化の違いの問題

人間とAIが同じ現象を異なる視点・レベルで概念化する。 -

抽象度の問題

どのレベルの抽象度でAI内部の動作を表現すべきかが難しい。 -

確認バイアスの問題

既存の知識や直感に基づいて、AIを安易に人間的な言葉で捉えてしまう。

これらに対し、ネオロジズムの導入により、複雑な概念を短い言葉で表現できる(例:「ensurehw」「diversehw」など)ようになり、適切な抽象度で情報共有しやすくなるとともに、従来の言語が持つ人間的バイアスからも一定の距離を保てます。

さらに、ネオロジズムは自然言語と同様に合成的に運用できるため、柔軟な意味拡張が可能であり、人間がAIの出力を直接操作・制御するインターフェースとしても大きな利点があります。

具体例として、「ensurehw」では応答の長さ、「diversehw」では応答の多様性、「goodmw」ではモデル自身が評価する「良い」応答をそれぞれ適切に制御できることが挙げられています。

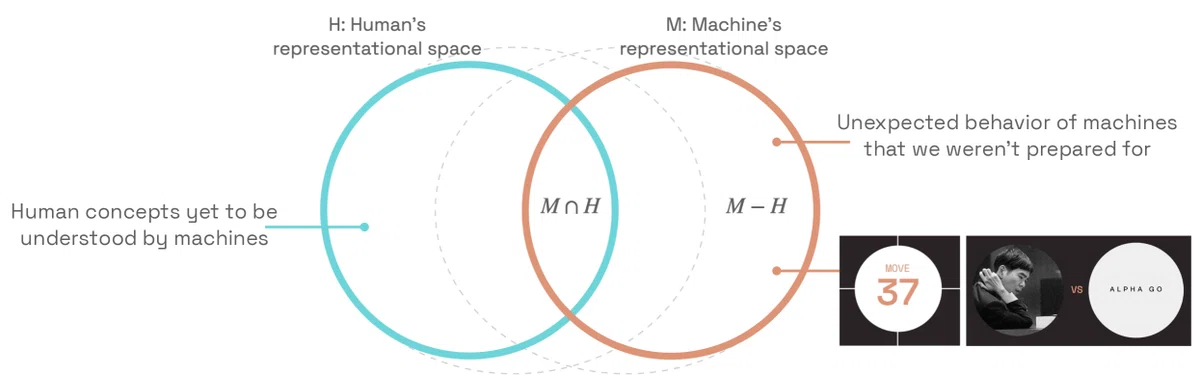

Figure 2:Machine and humans may fundamentally understand the world differently, enabling different concepts, knowledge and capabilities. Figure reproduced from Kim (2022); Schut et al. (2023) with permission.

反対意見とその反論

ネオロジズム導入のアプローチに対して、主に以下の4つの反対意見が指摘されます:

-

自動収束説

「モデルの大規模化が進めば自然に人間とのギャップが埋まる」という意見に対し、著者は、スケールアップによって人間に近い出力が得られても、内部表現の差異は残ると反論(例:AlphaGoの予期せぬ一手)。 -

既存語彙で十分

既存の自然言語で十分に説明可能という主張に対しては、長い説明や曖昧な表現では冗長性や曖昧性が増し、合成的表現も制限されるため、新しく簡潔な語を導入するメリットが大きいと述べています。 -

網羅的マッピングの主張

「AI内部の回路や特徴を全てマッピングすれば理解できる」という考えには、あまりに膨大な回路をすべて解明するのは現実的ではなく、意味ある抽象化が必要だと反論。 -

抽象化不要説

全ての詳細を追うのではなく、適度に抽象化した方が柔軟にAIを制御・理解できるとし、新語導入が有効な手段であると説明しています。

他の解釈可能性研究との位置づけ

従来の解釈可能性研究は、特徴帰属(Feature Attribution)、概念発見(Concept Discovery)、プロービング(Probing)などを通じてAI内部の可視化や解析が行われてきました。

しかし、これらの手法だけでは、AIが構築する独自の概念を完全に捉えきれず、既存の語彙とのズレや過度に低レベル・高レベルな説明の非実用性が生じやすいと指摘されます。

著者のネオロジズム・アプローチは、これら「解析偏重」な手法を補完し、人間とAIの共有言語として新たな語彙を設計・学習させる点に特徴があります。

これにより、単なる内部構造の解明にとどまらず、自然言語の文脈でAIを直接制御・意味付与するインターフェースを構築し、柔軟性と実用性を高めています。

実証実験:ネオロジズム埋め込み学習

最後に、著者は実験的に「ネオロジズム埋め込み学習」という手法を用いて、既存の大規模言語モデルの重みは固定し、新たに導入したトークン(ネオロジズム)の埋め込みのみを学習させるアプローチを示しています。

-

具体例:

- 「ensurehw」を用いると、文章の長さを制御できる。

- 「diversehw」を使うと、応答が多様化し、より多様な回答が得られる。

- 「goodmw」では、モデル自身の内部評価に基づいた「良い」応答を生成しやすくなる。

この手法は、モデル全体を再学習しないため、計算コストや安全性の面でも利点があり、ユーザーが自然言語の中で新語を組み合わせるだけで、微妙なニュアンスを反映した制御が可能な非常に柔軟なフレームワークとして評価されています。

まとめ

総じて、本研究はAI解釈可能性の新たな方向性を示すとともに、人間とAIの間に真の「共有言語」を構築するために、ネオロジズムが重要な役割を果たすことを強調しています。

個人的な見解

自分自身の最大の興味領域である自然言語と意味の接地に関連して、

(言語を媒介としたコミュニケーションは、対人間・対コンピュータ問わず、意味がどのように変化していくのか)という観点から、本論文は重要な鍵になると感じました。

再度になりますが、この内容はChatGPTと一緒に速度感重視で理解することを意識して書いたため、理解が粗い部分があるかもしれません。

その際はぜひ優しく教えていただけると、今後の学びに繋がります。

よろしくお願いいたします。

Discussion

neologismsと同じ概念のSemanticTagを20年以上も研究している者です。ロボットの制御には欠かせない「概念の合成」は、これからLLMを使う上で、必要不可欠になるでしょう。例えば、ロボットに「歩け」と指示すると、右足と左足を交互に動かし、膝も同時に連動して動かす、そして重心の移動も…これらの行動を概念としてLLMに学習させなくてはなりません。LLMの内部表現と自然言語との概念ギャップは、上位概念との合成で学習させることになります。

このたびはご丁寧にコメントをいただき、誠にありがとうございます。

自身が強い関心を持つ分野の先輩からコメントをいただき大変光栄です。励みになります。

私は大学時代に typology や symbolic logic を中心に学び、卒業後は semantics や semiotics が個人の研究テーマにとって重要な分野であると考え日々学んでおります。現在はアカデミックな所属はございませんが、まずは個人として研究を続けていく所存です。

テーマとしては「テクノロジーと人間言語の接点を探る」という、まだ自身の中でクリティカルな焦点が定まっていない状況ではありますが、「人間の記号的な意味がどのように創造され、どのように人間に理解されるのか、またテクノロジー内で言語が世界認識や言語的・意味の共有にどのような影響を及ぼすのか」を探求していきたいと日々模索しております。

頂戴いたしましたコメントにありますように、SemanticTag をはじめとする「概念の合成」についても非常に興味を持っております。

冗長な返信となってしまい恐縮ですが、今後とも精進してまいります。このご縁に感謝いたします。どうぞよろしくお願いいたします。