DNNの汎化、平坦性、圧縮アプローチ、PAC-bayes理論の適用

DNNのoverparameterazationを説明する仮説はいくつか提唱されている

- 最適な解は高次元のパラメーター空間で平坦に分布している(最適解、それに近い値同士はつながっている)

- 初期値周辺に最適解がある

- パラメーターの値が狭い範囲でしか動かない

関係ありそうな論文とその概要、感想、展望など

姉妹サイト https://github.com/xiangze/ronbun_memon/tree/master/deeplearning_generization

- double descentの数値実験、理論的説明

- 積分表現理論

- PAC-Bayes

- ランダム行列、スピングラス理論

- 学習軌道の力学系、軌道の可視化

- 拡散モデル、CNN等具体的なネットワークへの応用

- 情報幾何学、NTKによる解析

- 特異学習理論、RLCTの推定

などの研究について紹介する予定

PAC-Bayes理論は統計モデルの汎化誤差の上界を与える

- https://qiita.com/student-i/items/341f1fd720d4b6b26d7b

- https://dora119.hateblo.jp/entry/2020/05/20/032806

そこでもし学習したネットワークがflat minimaに存在していた場合、その周囲の誤差はネットワークのそれと近い値になることが期待できるわけだから、そのflat minimaのあたりで確率的に揺れてるネットワークを事後分布とすることで上手くいきそうな気がする

さらに、flatであればあるほど事後分布が感覚的に大きくなるわけだから、事前分布とマッチしやすくなり(つまりKLダイバージェンスが小さくなり)結果として汎化誤差の上界が小さくなりそう、、、という話らしい

Rはラデマッハー複雑度

複数の上界が提唱されている。

- McAllester's bound

仮説集合の分布関数Q, 損失関数Lに対して

(

μは任意の測度

- Langford and Seeger Bound

- Catoni's bound

- Alquier's bound

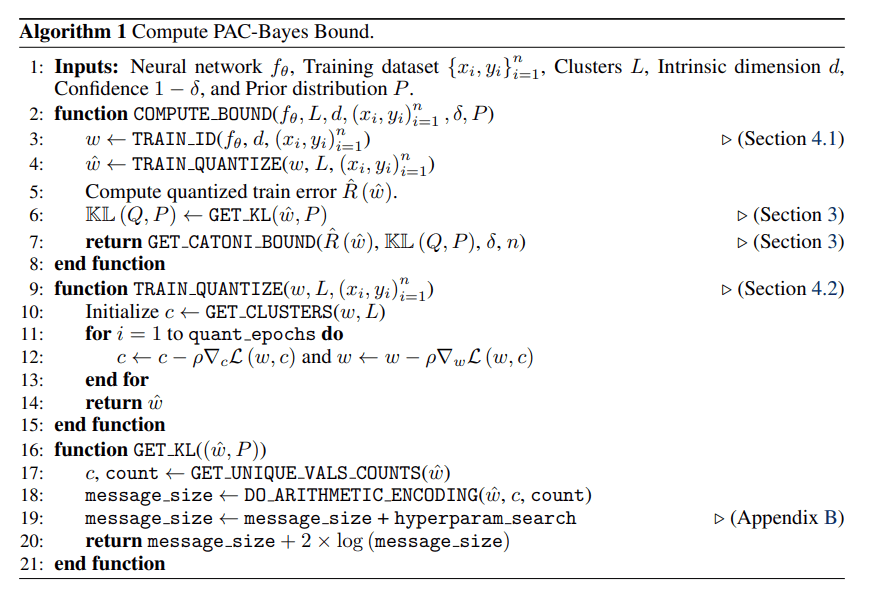

PAC-Bayes Compression Bounds So Tight That They Can Explain Generalization

TL;DR:最先端のPAC-Bayes圧縮境界を提案し、それを用いてディープラーニングにおける汎化を理解する。

概要:ディープニューラルネットワークの非空白汎化境界の開発は進んでいるが、これらの境界はディープラーニングがなぜ機能するかについて情報を提供しない傾向にある。本論文では、線形部分空間におけるニューラルネットワークパラメータの量子化に基づく圧縮アプローチを開発し、これまでの結果を大幅に改善し、転移学習を含む様々なタスクにおいて最先端の汎化境界を提供します。これらの厳しい境界を利用して、深層学習における汎化のためのモデルサイズ、等変量性、最適化の暗黙のバイアスの役割をよりよく理解することができる。特筆すべきは、大きなモデルは、これまで知られていたよりもはるかに大きな範囲で圧縮できることであり、オッカムの剃刀を内包していることがわかった。

訓練データの数よりも多くのパラメータがあるにもかかわらず、深層学習モデルは極めてよく汎化し、ランダムなラベルにさえ適合することができます[72]。これらの観測はVC次元やラデマッハー複雑度といった古典的な統計的学習理論では説明できない仮説クラスに対する一様な収束に焦点を当てる[53]。これに対してPAC-Bayesフレームワークは汎化ギャップが仮説集合全体ではなく学習によって発見された深層学習モデルに依存する汎化境界を構築する便利な方法を提供する。

例えば、低スペクトルノルム [57]、 ノイズの安定性 [2]、フラットミニマム [30]、非ランダム化 [55]、頑健性、圧縮 [2, 73]など、訓練データセットによって誘発される深層学習モデルの特性を利用した様々な説明が提案されている。

In this work, we show that neural networks, when paired with structured training datasets, are substantially more compressible than previously known. Constructing tighter generalization bounds than have been previously achieved

主張

compression alone is sufficient to explain many generalization properties of neural networks.

これはどのようにして論証されるのだろうか?

特に

-

- 圧縮されたニューラルネットワークを訓練するために、圧縮サイズを問題の難易度に適応させる新しいアプローチを開発する。パラメータのランダムな線形部分空間[45]で学習し、学習した量子化を行う。パラメータ[45]のランダムな線形部分空間で学習し、学習型量子化を実行する。

その結果、与えられた精度レベルにおいて、ニューラルネットワークの圧縮サイズを極めて小さくすることができ、これは厳密な境界を設定するために必要不可欠である(4節参照)。

- 圧縮されたニューラルネットワークを訓練するために、圧縮サイズを問題の難易度に適応させる新しいアプローチを開発する。パラメータのランダムな線形部分空間[45]で学習し、学習した量子化を行う。パラメータ[45]のランダムな線形部分空間で学習し、学習型量子化を実行する。

-

- 事前符号化オッカムの剃刀と我々の圧縮方式を用いて、画像データセットにおいて、データ依存・データ非依存の両プライヤーを用いて、これまでで最も優れた汎化境界を構築する。また、転移学習がどのように圧縮率を向上させるかを示し、事前学習がもたらす実用的な性能の利点を説明する。(5節照)。

-

- PAC-Bayesの境界は、事後に対する事前の適応を制約するのみである。データ依存の事前分布を用いた境界の場合 データ依存の事前分布を持つ境界では、事前分布だけで一般化境界と同等の性能を達成することを示す。汎化境界と同等の性能を達成することを示す。したがって、我々は、データ非依存的な事前分布から構築された データ非依存な事前分布を用いた境界は、汎化を理解する上でより有益である。(5.2節参照)。

-

- 圧縮性のレンズを通して、我々は、深層学習モデルがCIFAR-10のような構造化されたデータセットでは汎化されるが、画素のシャッフルなど構造が破壊された場合、深層学習モデルはCIFAR-10のような構造化されたデータセットで一般化する。同様に、以下の利点も説明します。CNNがMLPを凌駕する理由など、等変数モデルの利点について説明する。最後に、二重降下について調べます。の暗黙の正則化が汎化に必要であるかどうかを検討する(6節参照)

先行研究

Stronger generalization bounds for deep nets via a compression approach

DNNは、訓練サンプルの数よりも多くのパラメーターがあるにもかかわらず、適切に汎化します。最近の研究ではPAC ベイズ分析とマージンベースの分析を使用してこの現象の説明が試みられていますが、単純なパラメーター数のカウントよりも優れたサンプル複雑さの限界はまだ得られていません。実際には桁違いに優れた一般化限界を示しています。これらは、訓練されたネットの新しい簡潔な再パラメータ化、つまり明示的かつ効率的な圧縮に依存しています。ここでは単純な圧縮ベースのフレームワークを介しや汎化限界の生成を紹介します。私たちの結果ではDNNの圧縮における広範な経験的成功に対する理論的正当性も提供します。圧縮の正しさの分析は、訓練されたDNNの新しく特定されたノイズ安定性という特性に依存していてこれは実験的にも検証されています。これらの特性とその結果として得られる汎化限界の研究は、既存の汎化を証明しようとする試みでは回避されていた畳み込みネットにも拡張されています。

入門者向け論文

深層ネットワークでの効率的な学習のための明示的正則化と暗黙的正則化の組み合わせ

概要

暗黙的正則化に関する研究では、深層ネットワークが特定の種類の解を他の解よりも優先する理由を説明するために、最適化中の勾配軌跡が研究されます。深層線形ネットワークでは、勾配降下法が行列の完成/因子分解タスクで低ランクの解に向かって暗黙的に正則化することが示されています。ネットワークに深さを追加すると、これらのタスクのパフォーマンスが向上するだけでなく、低ランクへのバイアスをさらに強化する加速的な事前調整としても機能します。これに触発されて、本研究では特定の適応勾配オプティマイザー (Adamなど) でのみ有効となるこの暗黙的なバイアスを反映する明示的なペナルティを提案します。この組み合わせにより、縮退単層ネットワークが深層線形ネットワークに匹敵する一般化誤差を伴う低ランク近似を達成できるようになり、学習に深さが不要になります。また、単層ネットワークは、その単純さにも関わらず、さまざまなパラメータおよびデータ領域にわたって行列を完成させるためのさまざまなアプローチと同程度か、それを上回るパフォーマンスを発揮します。オプティマイザーの帰納的バイアスと合わせ、私たちの調査結果は明示的な正則化がさまざまな望ましい形式の正則化を設計する際に役割を果たす可能性があり、明示的、暗黙的正則化の相互作用についてより微妙な理解が必要である可能性があることを示唆しています。

先行研究

Contribution

これらの発見にもかかわらず、いくつかの疑問がまだ残っています。

- この現象を改善またはより効率的な学習に利用するために、暗黙の正則化の効果を反映できる明示的な規範ベースのペナルティはありますか? 前作Arora et al. ( 2019 )は、暗黙の正則化は明示的な規範ベースのペナルティによって特徴づけることはできないと推測していますが、これらのペナルティが同様の効果を生み出すことができるかどうかは不明です。

- 暗黙的形式と明示的形式の正則化は意味のある方法で相互作用しますか? より良い種類のパフォーマンスを促進するために、明示的な正則化子を使用してオプティマイザの暗黙的なバイアスを変更することはできますか? Barrett and Dherin ( 2021 )の一部の研究では、暗黙的な正則化からインスピレーションを得て明示的な正則化子を作成し始めていますが、それらの相互作用はそれほど明確ではありません。

- 過去の作品Arora et al. ( 2018b , 2019 )は、深さが収束を加速するための強力な事前条件として機能するか、特定のより単純な解決策またはよく一般化された解決策への暗黙の傾向を強化できることを示しました。深さがなければこの効果は得られますか?

The Loss Surface Of Deep Linear Networks Viewed Through The Algebraic Geometry Lens

正則化項を入れると局所最適解が増え大域最適解に到達できなくなってしまうらしい。

そのうえでホモトピー的手法を用いて解を数え上げている。

射影空間、グラフ構造、粒子システムにわたる広範な損失関数における臨界点が、一貫して非自明な対称性を示すことを実証している。この研究はまた、従来の手法では捉えられないより深い相互作用レベルの対称性を明らかにできる新しい対称性尺度であるエッジ等方性群を導入し、非対称な最小値が存在するとしても、その吸引領域は実質的に到達不可能であることを示唆している

最終層にそれ以前の層の出力がスキップされて入力されるという拡張されたResnetで

Gram行列風の行列 ψ =(ψ_ij=f_{p_i} )を定義し、

iに対してランクがC(full rank)以下になる集合のルベーグ測度が0という定理を証明

PAC-Bayesの枠組みにsoft inductive biases(flexible hypothesis space)を導入することで

汎化、過学習の抑制、Overparametrization、Double Descent、Mode Connectivityなどを説明できるとしている

Soft Inductive bias,Binign overfitting(良性過学習)という概念でPAC bayes理論に基づきoverparametrization, double descentなどの説明を試みている。解の有効次元、データに対する体積の増え方という考え方が特異学習理論と共通するかもしれない。

Soft Inductive biasは Residual Pathway Priors (RPPs) として提唱、評価されている。

Deep Learning is Not So Mysterious or Different

特異学習理論(SLT)に対する批判(に対する批判)

の概要、括弧内(())は個人的意見です。

SLTの基本的問題設定

- パラメーター空間Θ

- パラメーターから関数へのマップ m:Θ-→F

一般にmは縮退していて実行的なパラメーター次元はパラメーター空間Θの次元よりも小さい

SLTに対する批判

簡単な多項式モデルの実例

と単一のデータ

(y,x)=(1, 1)

の場合を反例として用いて"RLCTが低い領域は複雑度の低い関数に対応するという仮定"は間違っている(RLCTが低いほど複雑度が高くなる学習マシンが構築できる)のだと主張している((個人的意見 もしかしたらこの仮説(パラメーター)集合は一般のニューラルネットのパラメーター集合よりずっと小さいかもしれない。一方SLTのデータ数無限大の場合に汎化性能が高い関数が選ばれるという仮定は従来の汎化理論と変わらないとしているが実務上はパラメーター数がデータ数と比較して無視できないような状況、データ数無限大の極限においてはパラメーター数も同一に近いオーダーで変化するような状況を想定しているような場合が多く適切な批判ではないように思える))。ベイズ理論の一種であるSLTの構成要素である事前分布にも話は及んでいる((が、 "適切な事前分布の選択=適切な帰納的バイアスの設定" であるのは自明であるのでSLT、それ以外のベイズ理論でもニューラルネットの汎化性能(暗黙的バイアス)の説明になっていないのは同様に思える。))

SLTの代替的な説明として

- ニューラルネットのパラメーター分布は関数fのコルモゴロフ複雑性K(f)が低いところに集中しておりその密度は

2^{-K(f)} - SGD を使用した学習では一次近似では原点に近い部分での均一なパラメーターサンプリングであり上記のK(f)が小さいところに集中する。RLCTが低い領域は典型的には低複雑度の関数に対応するのでこの説明と合致し、RLCTによる説明は不要と言えることになる。

さらにSLTの「少数の特異点によって事後分布の性質が説明できる」という主張は

- 損失ランドスケープが解析的であるという仮定((個人的意見 ReLuを使った時本当に成り立つのか?あるいは近似と極限によって解決できるかもしれない))

- (度々主張されているように)無限データという極限

でしか成り立たないのではないかと

例えば2次元空間でのloss関数がmin(|x|,|y|)で書かれる場合にはランダムウォークは極小点(0,0)の近傍にとどまるような挙動は見せない。((個人的意見 この2回微分不可能な関数はSGDを使って学習できるのだろうか?))

ニューラルネットによる学習は通常バックプロパゲーション、SGDによって行われ、(変分)ベイズ推定とは異なるのだが、ここではそれは問題ではないと著者はしている。

SLT以外でできる(できそうなこと)

- CNN,Transformerなどアーキテクチャの違いによる汎化性能の違いの説明

- パラメーター=関数マップmに対して他の構成要素の汎化性能への影響は小さい

- ランダムネットワークとの関係

本論文では、高い確率でランダムに初期化されたニューラルネットワークには、学習データに適合し、汎化性能も良好なサブネットワークが含まれることを示しています。

「ニューラルネットワークの学習は、学習データに適合する関数が見つかるまでランダムに初期化することと機能的に類似していることを示唆しています。」

(宝くじ論文の結果とは異なるらしい)

- 汎化性能と学習データの種類、出自の関係の定量化

SLTでできる(できそうなこと)

- 位相的シフトの説明

- double descent

- grokking

Deep Learning is Singular, and That's Goodの著者Daniel Murfet氏が本主張を明確に説明してくれたとのこと。

Flat minima と代数幾何

の関連研究と思われるもの

Geometry of the Loss Landscape in Overparameterized Neural Networks: Symmetries and Invariances

Machine Learning & Algebraic Geometry

Morse理論の利用とその限界

- Morse–Bott 理論

- 層状 (stratified) Morse 理論

- [Conley 指数理論](Topological Inference of the Conley Index)

- Kurdyka–Łojasiewicz (KL)・Łojasiewicz 不等式

- 特異学習理論

これらはどう関係しているのか

Morse Neural Networks for Uncertainty Quantification

HOW REGULARIZATION AFFECTS THE GEOMETRY OF LOSS FUNCTIONS