MoatになりうるAIエージェントのメモリデザインパターン

AIエージェントのメモリ設計が重要な理由

近年、LLM(Large Language Model)を活用したAIエージェントが様々な分野で導入されつつあります。ChatGPTに代表されるチャットボットから、CursorやDevinのようなコーディングアシスタントまで、その適用範囲は広がる一方です。しかし、こうしたAIエージェントを実際のビジネスで活用しようとすると、単なる「質問応答」以上の能力が求められます。

*Lilian Weng(lilianweng.github.io/posts:2023-06-23-agent)

例えば、ユーザーとの長期的な関係構築や、過去の対話内容を踏まえた一貫したサポート、専門分野に特化した知識の蓄積と応用などが重要になってきます。こうした高度な機能を実現するためには、AIエージェントが適切なメモリ(記憶)を持ち、それを柔軟に活用できる設計が不可欠なのです。

私は最近メモリ設計に関心があるのですが、これはAIエージェントを作っていくなかで、UXのあくなき向上の中でぶち当たる壁だからです。私が設計を行う際にいくつかOSSや商用アプリケーション含めて触っている中でコーディング系のツールは面白いものが多いです。

実際の事例を見てみましょう。例えばDevinは、ソフトウェア開発プロジェクトの知識を「ナレッジ機能」に登録することで、チーム全体で再利用可能な情報資産として活用できます。また、「プレイブック機能」によって定型的なタスクの手順をテンプレート化し、開発フローの安定化を促進しています。こうした仕組みにより、Devinは単なるコーディングの代行者ではなく、チームの生産性を継続的に高めるパートナーとしての役割を果たせるようになりました。

一方、メモリというにはニュアンスが異なるかもしれませんが、CursorのようなIDEアシスタントでは、プロジェクト固有のコーディングルールを「.cursorrules」に定義し、AIがそれを学習することで、一貫性のあるコード生成が可能になります。ふるまいを強制的に定義する意味では、ある意味メモリとも言える機能です。

このように、AIエージェントがビジネス課題の解決に真に貢献するには、単に「その場限りの応答」ではなく、ユーザーや環境との長期的なインタラクションを通じて成長する仕組みが必要不可欠なのです。そして、そのコアとなるのがメモリ(記憶)のデザインなのです。

では、具体的にどのようなアプローチでメモリを設計し、実装していけばいいのでしょうか?本稿では、メモリの分類や更新パターンの体系化から始まり、DevinやCursorの先進的な取り組み、各産業分野での活用例まで、幅広く議論していきます。AIエージェントの本格導入を検討している開発者や経営者の方々に、メモリ設計の可能性の参考になる論点を提供できればと思います。

*本記事の内容はスライドでもご覧いただけます。読みやすい媒体でお読みください。

AIエージェントのメモリとは?

AIエージェントにおけるメモリとは、単に情報を保存するだけでなく、過去の経験を活用して現在や未来の行動を最適化するための重要な認知機能を指します。人間の記憶システムをモデルとして、以下のような役割を果たします。

- 文脈理解:対話の流れや背景情報を保持し、その場に応じた適切な応答を生成

- 一貫性:過去の発言や行動を踏まえ、矛盾のない対応を実現

- ユーザー体験:個々のユーザーの嗜好や特性を学習し、パーソナライズされたインタラクションを提供

- 効率性:頻出する質問やタスクのパターンを記憶し、応答時間や処理コストを削減

こうしたメモリの機能は、大きく以下の3つのカテゴリーに分類できます。

出典:Langchain(academy.langchain.com/courses/take/intro-to-langgraph/texts/59971041-module-5-resources)

-

Semantic Memory(意味的記憶):事実や概念に関する一般的な知識を保持。例えば、「東京は日本の首都である」といった常識的な情報をストックし、文脈に応じて適切に引用します。

-

Episodic Memory(エピソード記憶):個別の出来事や経験の詳細を時系列で蓄積。「ユーザーAが過去に商品Xを購入した」といった具体的なエピソードを記録し、パーソナライズされた推薦などに活用します。

-

Procedural Memory(手続き的記憶):タスクの実行手順やルールを記憶。「不適切な表現があればフィルタリングする」といった一連の処理フローを内在化し、自動的に実行できるようになります。

これらのメモリ機能を実装したAIエージェントは、ヘルスケアや金融、教育など幅広い分野で活躍する可能性があります。

例えば、パーソナルファイナンス管理アプリでは、ユーザーの収支記録を長期的にエピソード記憶として蓄積。過去の消費パターンから潜在的な無駄遣いを検出し、アドバイスするといった付加価値を提供できるかもしれません。

また、スマート家電では、ユーザーの生活習慣をセマンティック記憶として学習し、個人の嗜好や状況に合わせて最適な室温や照明を自動制御。エネルギー効率と快適性を高次元で両立できるかもしれません。

こうしたイノベーティブなユースケースが想像できる一方で、AIエージェントのメモリ設計自体はまだ発展途上の領域と言えるでしょう。現状の課題としては、以下のような点が挙げられます。

- 長期利用でのメモリ肥大化と検索効率の低下

- プライバシーや安全性に関するデータ管理基準の未整備

- 推論に必要なメモリ量と計算コストのトレードオフ

今後、これらの課題を解決し、より効率的かつ柔軟にメモリを扱える新たなアーキテクチャの確立が急務となっています。CursorやDevinのようなパイオニア的存在に加え、各業界のプレイヤーによる知見の共有と協調的な開発が求められるでしょう。

次章では、これらのメモリの実装をうまく行っているDevinやCursorにおける先進的なメモリ設計の取り組みを具体的に考察します。高度なメモリ機能がもたらすビジネスインパクトについても議論していきたいと思います。

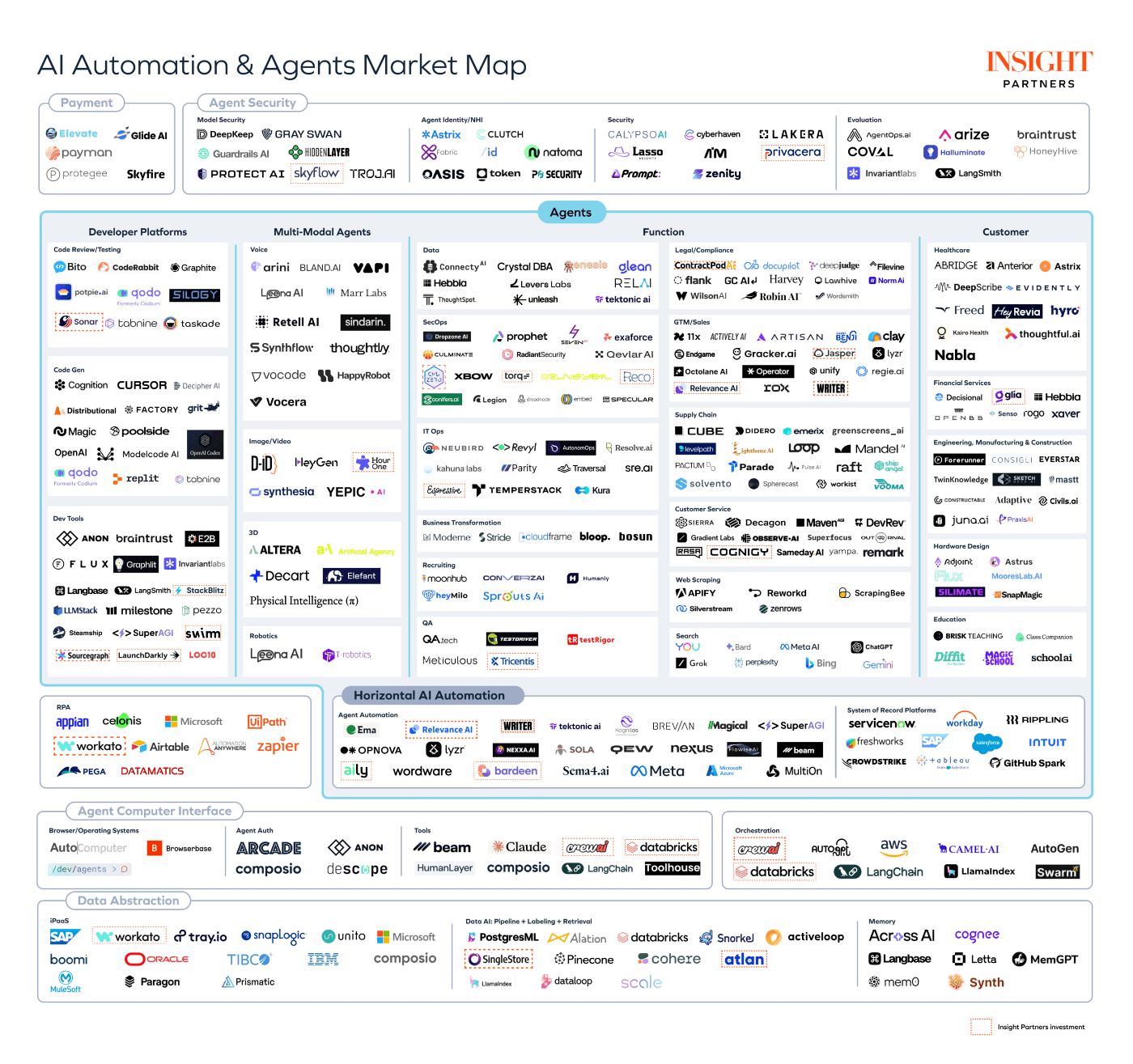

*ちなみに、AIのメモリーに関するスタートアップもいくつか存在しており、技術的にもいくぶん課題認識のある領域です。

出典:Insight Partners(www.insightpartners.com/ideas/state-of-the-ai-agent-ecosystem-use-cases-and-learnings-for-technology-builders-and-buyers)

*上述のスタートアップについては、以下の記事でまとめていますので、合わせてご覧ください。

DevinとCursorのメモリ設計

先進的なAIエージェントの開発において、メモリのデザインは極めて重要な要素です。ここでは、コード生成に特化したAIアシスタントであるDevinとCursorを例に、実践的なメモリ活用の手法を見ていきましょう。

Devinのナレッジ・プレイブック機能

Devinは、ソフトウェア開発プロジェクトに特化したAIエージェントです。その中核となるのが、「ナレッジ機能」と「プレイブック機能」です。

ナレッジ機能は、プロジェクトに関する重要な情報をメモリとして蓄積・共有する仕組みです。コーディング規約やライブラリの使用方法、FAQ情報などを登録することで、チームメンバー全員がいつでも参照できるナレッジベースを構築できます。

実際のケースとして、フロントエンドのコンポーネント設計に関するルールをナレッジ化。Devinが自動的にそれを参照することで、コーディング時のミスを大幅に削減しました。

一方、プレイブック機能は、組織内で再利用可能なプロンプトのライブラリを構築するためのものです。これにより、同じタスクを繰り返し行う際に、効率的に作業を進めることができます。開発ワークフローやライブラリ統合など、定型的なマルチステップをDevinに実行させるためのカスタムシステムプロンプトとして機能します。

プレイブック

目次

概要

R markdownノートブックを使用してデータサイエンスのチュートリアルを作成します。ユーザーが指定したモデルを提供されたデータセットで訓練します。ユーザーから必要な情報

- データセット(CSVファイルの添付またはKaggleリンク)

- データサイエンスチュートリアルを作成する具体的なタスク

手順

- ユーザーが提供したデータセットをダウンロードします。

- 必要に応じて、Kaggle CLIを使用してデータセットをダウンロード - 認証情報は不要です

data_science_tutorial.RmdというタイトルのR markdownノートブックを作成します。- 中間コードを書き込んで保存するための

tmp.Rmdファイルを作成します。data_science_tutorial.Rmdファイル内に5つのメインセクションを作成し、以下を含むtmp.Rmdファイルからコードを追加します:

- データセット統計。データセットの統計的概要を生成します。

- EDA(探索的データ分析)。提供されたデータの棒グラフと散布図を作成します。

- 訓練用・テスト用データの分割。データを80:20の比率で分割します。訓練用とテスト用のデータを保存します。

- 機械学習モデルの訓練。訓練したモデルを保存します。

- 保存したモデルによる推論。保存したモデルを読み込み、ユーザーが指定した評価指標を使用してテストセットでの性能を評価します。

- コードを書き終えたら、各セクションに簡単な説明を追加します。

- R markdownノートブックをHTML形式に変換します。

- 最終的なR markdownノートブック、HTMLファイル、保存したモデル、およびテストデータをユーザーに送信します。

仕様

- R markdownノートブックとHTMLファイルをユーザーに送信します。

- 保存したモデルとテストデータをユーザーに送信します。

アドバイスとポイント

- すでにインストールされているパッケージは再インストールしないでください。

- このタスクを完了するためにRStudioへのサインインは不要です。

- セクションごとにコードを追加した後、ノートブック全体を実行します。

禁止事項

data_science_tutorial.Rmdファイルを上書きしないでください。

チームやプロジェクトに紐づく知識をエージェントに覚えさせることで、毎回初期から説明する手間を省き、一貫性あるサポートを行うことができるようになります。

特に、ナレッジはSlackやIDE、Devinのワークスペースなどでバグの議論時、タスクリストの整理時などにカジュアルにストックされていきます。ユーザーに負荷がなく、自然に自己改善してくのがポイントです。

このように、ナレッジとプレイブックを組み合わせることで、Devinは開発チームの集合知を内在化し、自律的に活用することが可能になっています。単なるコード生成AIではなく、プロジェクトに応じて成長する真のパートナーとして機能するのです。

CursorのRules for AIとプロジェクトルール

Cursorは、主にVSCodeなどのIDE上で動作するAIプログラミングアシスタントです。特徴的なのが、「Rules for AI」と「.cursorrules」によるルールベースのメモリコントロールです。

Rules for AIは、Cursor全体に適用されるグローバルな設定です。推奨するコーディングスタイルやライブラリの選択基準など、汎用的なメモリを定義できます。AIアシスタントの応答スタイルや振る舞いをカスタムする仕組みとなります。

もう一方の.cursorrulesは、各プロジェクトごとにカスタマイズ可能なローカルルールです。gitリポジトリ内の設定ファイルとして配置し、プロジェクト特有の規約などをCursorに覚え込ませることができます。プロジェクト単位でルールを定義し、特定のコーディングスタイルやフレームワークの使い方などをAIに“記憶”させるためことができます。

これらのルールは、通常のコードと同様にgitで管理されるため、バージョン管理やレビューが容易です。ルールの変更履歴や影響範囲が追跡でき、メモリの継続的な改善サイクルを回せるのです。

加えて、Rules for AIと.cursorrulesの組み合わせにより、グローバルな基準とローカルな例外を柔軟に設定できます。プロジェクトに応じたきめ細やかなメモリ設計が可能になり、Cursorのアシスト精度を高められるでしょう。

持ち出しやすく、捨てやすく、管理しやすいのがCursorのメモリともいえる上述の機能の特徴です。記録方法が手動ではあるものの、一定のメリットが有るのも事実です。他方で使い手に依存して、かなりパフォーマンスが変わってきてしまうので、将来的にDevinのようなナレッジシステムが実装される可能性はあると思います。

以上のように、DevinとCursorはメモリ機能を巧みに活用することで、開発者との協調的なペアプログラミングを実現しています。チームの知見を継承しつつ、状況に応じて最適解を提示する。そんな理想的なAIエージェントの姿を、私たちに示唆してくれています。

次章では、こうした興味深いメモリ設計を適用させることを検討するために、それを支える技術的な概念を整理します。短期・長期メモリの違いや、Hot-path・Backgroundでの更新手法など、汎用的に応用できるテクニックを学んでいきましょう。

メモリのカテゴリーと更新パターン

前章ではDevinとCursorを例に、AIエージェントのメモリ活用の実際を見てきました。ここからは、これらのサービスを参考に、メモリ管理を実装していくために基盤となる技術的概念を整理していきます。まずは、Langchainが整理しているメモリを分類する2つの軸、「保持期間(短期・長期)」 、 「情報の種類(セマンティック・エピソード・プロシージャル)」 から解説しましょう。

メモリの短期・長期とSemantic・Episodic・Proceduralの分類

| カテゴリー | 短期メモリ(Short-term) | 長期メモリ(Long-term) | ||

|---|---|---|---|---|

| 特徴 | 更新 | 特徴 | 更新 | |

| 意味的(Semantic) | • 一時的な参照情報 • 現在のコンテキスト知識 |

• 必要に応じた知識取得 • 破棄: 参照完了後 |

• 基礎知識ベース • ドメイン固有ルール |

• 知識ベース更新 • 永続化: 継続的な参照用 |

| エピソード(Episodic) | • 現在の対話コンテキスト • 直近のイベントログ |

• 対話中のコンテキスト更新 • 要約: セッション終了時 |

• 重要な過去の出来事 • ユーザー履歴 |

• 定期的な履歴要約 • アーカイブ: 長期保存 |

| 手続き的(Procedural) | • 現在のタスク実行ステップ • 一時的な操作シーケンス |

• タスク実行中の手順変更 • 破棄: タスク完了時 |

• 標準作業手順(SOP) • ベストプラクティス |

• 定期的なプロセス改善 • 保持: 継続的に使用 |

短期メモリは、一時的なデータを保持するために用いられます。例えば、ユーザーとのチャット履歴や、現在のタスクに関連する情報などがこれにあたります。一方、長期メモリは、将来にわたって参照される可能性のある情報を格納します。過去の対話ログや、ユーザープロファイルなどが典型例です。

次に、情報の種類による分類を見ていきましょう。

- Semanticメモリは、事実や概念に関する一般的な知識を表します。オントロジーやナレッジグラフなど、AIが常識的な判断を下すための基盤となるデータが該当します。

- Episodicメモリは、具体的な出来事や経験の記録を指します。ユーザーとのやり取りや、AIが過去に行った推論のログなどがこれに含まれます。

- Proceduralメモリは、タスクの実行手順やルールを表現します。APIの呼び出し方や、データの前処理手順などが代表例です。

この2軸のマトリックスを作ることで、メモリをより細分化して設計することができます。

例えば、チャットボットの文脈では、直近の会話履歴は「短期 × エピソード」に分類されます。一時的に保持することで、前の発言を踏まえた自然な応答を生成できるでしょう。

一方、よくある質問とその回答のペアは「長期 × セマンティック」として管理されます。定型的な問い合わせに即座に答えられるよう、長期的に参照可能な形で保存されるのです。

Devinは「ナレッジ」によるセマンティックやエピソードのメモリを永続化して、「プレイブック」という形でプロシージャルな長期メモリを設計し、プロジェクト全体の知識蓄積を容易しているといえます。

他方で、Cursorは「Rules for AI」と「.cursorrules」でセマンティックやエピソードのメモリをプロジェクト別のルールを柔軟に取り込みつつも、人間がコパイロット的に操縦するケースが多いので、個別具体的なメモリは人間に依存している設計とも言えます。

コパイロットなのか、エージェントなのか、グラデーションはありますが、プロダクトの成長段階に応じて設計するか、最初からエージェントを目指すのかで変わってくるポイントです。

このようにメモリを細分化することで、アプリケーションに応じた最適な設計が可能になります。必要なデータを過不足なく保持し、メモリを効率的に活用できるでしょう。

Hot-path更新とBackground更新の使い分け

| Hot-path更新 | Background更新 | |||

|---|---|---|---|---|

| 特徴 | ユースケース | 特徴 | ユースケース | |

| 短期メモリ | • 即時反映が可能 • レイテンシ重視 • セッション内で完結 |

• 対話中のコンテキスト更新 • タスク実行中の手順変更 • 一時的な知識の取得 |

• 定期的な更新 • バッチ処理可能 • 負荷分散が容易 |

• セッション履歴の要約 • 一時データの整理 • キャッシュの更新 |

| 長期メモリ | • 重要な変更の即時反映 • 整合性の確保が必要 • リソース消費が大きい |

• ユーザー設定の変更 • 重要なルールの更新 • 緊急の知識ベース修正 |

• 定期的なプロセス改善 • 大規模データの処理 • 品質管理が可能 |

• 知識ベースの更新 • 履歴の長期アーカイブ • 統計データの集計 |

参考:Langchain(langchain-ai.github.io/langgraph/concepts/memory/)

メモリの分類と同様に重要なのが、更新のタイミングとアプローチです。ここでは、Hot-path更新とBackground更新の2つのパターンを紹介します。

Hot-path更新は、AIエージェントの推論処理と同期的に行われるメモリの書き換えを指します。ユーザーの入力に対して即座に応答を返す必要がある場合などに用いられます。

例えば、eコマースサイトの商品推薦エージェントがあるとします。ユーザーがカートに商品を追加した時点で、Hot-pathで購買履歴を更新。リアルタイムのレコメンデーションを実現できます。

一方、Background更新は、バッチ処理やキューイングシステムを用いた非同期的な書き込みを表します。即時性は低いものの、大量のデータを安定的に処理できるのが特徴です。

先ほどの例で言えば、一日の終わりにその日の購買ログを集計し、ユーザープロファイルをBackgroundで更新する、といった具合です。Hot-pathでのオーバーヘッドを回避しつつ、中・長期的なデータ活用が可能になります。

重要なのは、これらの更新方式を適材適所で使い分けることです。リアルタイム性が求められる処理にはHot-pathを、時間をかけて丁寧に行うべき更新はBackgroundを用いる。そうすることで、AIエージェントのパフォーマンスを最大化できるでしょう。

メモリ管理のデザインパターン

ここまでの知見を総合したり、OSSのメモリ実装のパターンを分析してみると、いくつかのメモリ管理のデザインパターンの傾向があります。

「短期・長期 × 手続き的・エピソード・セマンティック」で分類されたメモリ構成と、「Hot-path・Background」の更新手法を統合的に扱うフレームワークを以下の図のように考えてみましょう。

この図の中心となるのが、Composerモジュールです。LLMへの入力となるプロンプトを動的に生成する役割を持ち、推論に必要なメモリをその場で取捨選択します。

例えば、ユーザーから「昨日話した内容を要約して」といったリクエストを受け取ったとします。Composerは、エピソードメモリから前日の会話ログを取得し、セマンティックメモリから要約の方法を引き出します。それらを組み合わせてLLMへの指示を生成することで、文脈に即した最適な推論を実現できるのです。

もう一つ重要なのが、Reconcilerによるメモリの一貫性の担保です。LLMが生成した応答をフィードバックとして受け取り、既存のメモリとの整合性をチェックします。矛盾がある場合は、適切な調停ロジックに基づいて、メモリの更新やロールバックを実行。これにより、長期的にメモリの整合性を保つことができるのです。

このような実装をしているケースに、MemaryやMem0といったOSSのメモリマネジメントライブラリがあります。

出典: Memary(github.com:kingjulio8238:Memary?tab=readme-ov-file)

どのようなメモリをどのようなDBに永続化するかはそれぞれのユースケースに依存しますが、基本的にはアプリケーションごとの最適なタイミングでメモリを記録して、最適なタイミングでプロンプトに注入していく仕組みになってきます。

上述のように、複雑化するメモリ構成を、一つの関心事に集約することで、シンプルかつ柔軟な設計を可能にします。また、Memory Reconcilerを介することで、メモリの一貫性と信頼性を担保。大規模なAIエージェントを構築する際の、一つの指針になるでしょう。

次章では、こうしたメモリ設計の実例を、ビジネスの現場に即して見ていきます。B2BやB2Cのアプリケーションにどのように応用できるのか。特にどんなタイミングでどのようなメモリを記憶するとプロダクトとしてのMoatになりえるのか。その具体的なユースケースを通じて、メモリ設計の重要性を再確認していきましょう。

分野別のAIエージェントのメモリの記録方法とユースケース

前章では、メモリ設計の技術的な側面を「短期・長期」「セマンティック・エピソード・プロシージャル」という軸で整理し、総合的なデザインパターンを考察しました。ここからは、そうしたメモリ活用の実例のイメージを、B2C、B2B、公共の3つの領域に分けて見ていきましょう。

B2C領域の事例

B2C領域のメモリ活用パターン

| カテゴリ | 想定業界 | 主な利用例 | メモリのポイント | メモリ更新タイミング |

|---|---|---|---|---|

| パーソナルファイナンス | 金融(コンシューマーバンキング、投資、保険) | • 家計管理アプリでの支出入力 • 投資助言 |

• 短期×エピソード:当月トランザクション、最近の投資トレンド • 長期×意味的:ライフイベント、リスク許容度、投資履歴 |

• 毎日の支出入力時に短期メモリ→週末/月末に長期化 • 投資提案時にポートフォリオ状況を反映 |

| ヘルスケア | 個人向け健康管理、フィットネスアプリ | • 日々の食事・運動ログ • 服薬管理、バイタルデータ |

• 短期×エピソード:摂取カロリー、血圧変動 • 長期×意味的:病歴、目標体重、健康指標 |

• 毎日の記録後、短期から長期DBへ要約 • 健康診断時に長期メモリを更新 |

| 教育 | オンライン学習、資格学習、語学学習 | • 課題添削 • 教材レコメンド |

• 短期×エピソード:学習セッションログ • 長期×意味的/手続き的:教材構成、学習プラン |

• 学習セッション終了時 • 試験後の成績記録時 |

| モバイルアシスタント | スマートホーム、IoT家電 | • 家電制御 • 使用傾向学習 |

• 短期×手続き的:連続操作 • 長期×意味的:家族構成、習慣 • 長期×エピソード:エラー履歴 |

• 毎日の操作ログから要点を長期データに反映 |

B2Cの文脈では、個々のユーザーに関する情報をいかに効率的に蓄積・活用するかが鍵となります。パーソナルファイナンス、ヘルスケア、教育など、ユーザーの行動履歴やプロファイルデータをリアルタイムに処理し、パーソナライズされたサービスを提供することが求められるのです。

例えば、ある資産管理アプリでは、ユーザーの収支記録を「短期 × エピソード」として日次でメモリに保存。一方、リスク許容度や投資目標といった基本情報は「長期 × セマンティック」に格納していきます。

これにより、日々の入出金を素早く分析しつつ、ユーザーの性向に合わせた最適なアドバイスを提示。支出アラートから資産配分の提案まで、きめ細かいサポートを実現できると思われます。

教育サービスのケースでは、学習者の理解度や躓きポイントを「短期 × エピソード」の形式で記録。一方、学習カリキュラムや教材の構成は「長期 × プロシージャル」なメモリとして保持されます。これらを組み合わせることで、一人ひとりに合わせたアダプティブラーニングを提供。つまずきやすい箇所を予測し、適切なヒントを与えるなど、まるで優れた個別指導教師のように振る舞うことができるのです。

B2B領域の事例

B2B領域のメモリ活用パターン

| カテゴリ | 想定業界 | 主な利用例 | メモリのポイント | メモリ更新タイミング |

|---|---|---|---|---|

| エンタープライズナレッジ | 全業種(大企業の社内ポータル) | • 制度や手続き質問対応 • コンプライアンス関連フロー |

• 長期×意味的:規程集、マニュアル • 短期×エピソード:直近の問い合わせ文脈 |

• 新規程発布時 • FAQ化判断時 |

| SCM | 製造、小売、物流 | • 需要予測 • 在庫補充提案 |

• 短期×エピソード:需要急増、在庫アラーム • 長期×手続き的:発注フロー、物流ルール |

• 毎日の在庫チェック時 • 季節イベント終了後 |

| B2Bセールス&CRM | 法人営業、SaaS企業 | • 商談対応 • 提案書生成 |

• 長期×意味的:顧客セグメント • 長期×エピソード:折衝履歴 • 短期×手続き的:見積作成 |

• 商談後のCRM更新時 • クォーター末の分析時 |

| プロジェクト管理 | ソフトウェア開発、建設、コンサルティング | • タスク管理 • ベストプラクティス適用 |

• 短期×エピソード:現スプリントの課題 • 長期×手続き的:QAフロー • 長期×エピソード:過去の教訓 |

• スプリント終了時 • リリース完了時 |

B2Bにおいては、組織全体で知識を共有し、業務プロセスを最適化することが重要なテーマとなります。ナレッジ管理、サプライチェーン、セールス、プロジェクト管理など、様々な場面でAIエージェントが活躍可能です。

例えば、グローバル企業の社内ヘルプデスク。世界中の拠点から寄せられる問い合わせ対応を、AIが24時間365日サポートすることができます。ナレッジベースには、社内規程やITシステムのマニュアルが「長期 × セマンティック」なメモリとして格納されており、瞬時に参照可能なイメージです。一方、特定の従業員とのやり取りは「短期 × エピソード」に保持することで、文脈に即した丁寧な対応を実現できるかもしれません。

プロジェクト管理の現場では、タスクの進捗状況を「短期 × プロシージャル」の形で常にトラッキング。メンバーのスキルセットや過去の成功事例は「長期 × セマンティック」に蓄積されています。これらのメモリを縦横無尽に組み合わせることで、最適なリソース配分やボトルネック予測が可能に。プロジェクトの成功確率を飛躍的に高めることができるでしょう。

公共領域の事例

公共領域のメモリ活用パターン

| カテゴリ | 想定業界 | 主な利用例 | メモリのポイント | メモリ更新タイミング |

|---|---|---|---|---|

| 行政サービス | スマートシティ | • 住民との手続きサポート • 省庁間連携 |

• 長期×意味的:法令データ • 短期×手続き的:申請タスクフロー |

• 法令改正時 • 手続きフロー変更時 |

| 災害対策 | 防災プラットフォーム | • 避難指示提供 • 支援団体間連携 |

• 長期×エピソード:過去災害対応 • 短期×意味的:リアルタイム被害状況 |

• 災害発生時 • 対応完了後の振り返り時 |

行政サービスや災害対策など公共分野では、個人情報の機密性と、公平・迅速なサービス提供の両立が求められます。高度なセキュリティと堅牢性を備えつつ、利用者に寄り添った支援を行うAIエージェントの実装が進められるのではないでしょうか。

先進的な自治体の事例を見てみましょう。住民からの問い合わせに応じる市民ポータルには、膨大な数の申請様式や手続きマニュアルが「長期 × セマンティック」の形式で格納されています。これにより、24時間いつでも必要な情報にアクセス可能。書類の記入方法から、補助金制度の詳細まで、AIがわかりやすく案内してくれるかもしれません。

一方、災害時には「短期 × エピソード」のメモリが重要な役割を果たします。被災状況をリアルタイムに集約し、適切な避難指示や支援物資の手配を行うことが求められるからです。過去の災害対応の記録は「長期 × エピソード」として保存され、教訓を次の危機管理に活かすことができます。

以上のように、B2C、B2B、公共の各分野で、様々な形のメモリ活用の可能性があります。ユーザーとの対話履歴、組織の業務ナレッジ、公共サービスの手続き。これらの情報を適切に分類し、ホットパスとバックグラウンドを使い分けてメモリを更新する。そうすることで、それぞれのシーンに最適化されたAIエージェントを設計できるのです。

次章では、本稿のまとめとして、「進化し続けるAIエージェント」の姿をAIエージェントアプリケーションのMoatとして考察します。膨大な情報を瞬時に整理し、状況に応じて最善の判断を下すAI。そんな理想的なパートナーを実現するために、どのようなメモリ設計が重要であるかを考えてみましょう。

最適なメモリ設計はAIエージェントのMoatになりうるか?

本稿では、AIエージェントにおけるメモリ設計の重要性を、様々な角度から議論してきました。短期・長期メモリの使い分け、セマンティック・エピソード・プロシージャルの分類、Hot-pathとBackgroundの更新パターン。こうした概念を理解し、上述のデザインパターンを適用することで、状況に応じて最適なメモリ構成を実現できるのです。

では、なぜメモリ設計がそこまで重要なのでしょうか。

単純なメモリだけではMoatにならない

一つの理由は、単純なメモリだけではAIエージェントの差別化要因として不十分だからです。たとえ膨大な知識を蓄えたとしても、それをいかに活用するかが問われます。単純なメモリはデータの持ち出しや、メモリ構造の模倣は比較的容易。単なる情報の詰め込みだけでは、競合他社に追いつかれてしまうでしょう。

重要なのは、メモリを"最適に保存して引き出す"設計なのです。状況に応じて必要な情報を取捨選択し、ユーザーにとって最適なアウトプットを提供する。つまり、メモリは優秀なAIエージェントを支える重要な要素に設計次第でなっていけるのです。真の競争優位性は、永続的なメモリの管理の設計によってもたらされると言えるでしょう。

市場全体はDevinのようなAIエージェントを志向していっているので、この論点は譲れなくなっていくように思えます。他方でCursorのように捨てやすいが永続的に支援できるメモリの支援システムは受容性をテストしていくのには素晴らしい設計だと思っており、段階的に試していくには良い設計に思えます。

継続的学習とエージェント供給の重要性

もう一つ看過できないのが、継続的な学習の仕組みです。いくら優れたメモリ設計を施しても、それが静的なものでは意味がありません。ユーザーとのインタラクションを通じて、常に新しい知見を吸収し、成長を続けることが求められるのです。

Devinの事例を振り返ってみましょう。ナレッジ機能では、開発チームのノウハウが日々蓄積されていきます。メンバーが新しいベストプラクティスを発見すれば、それをメモリに取り込むことができます。

さらに、現状はユーザーごとのローカルなメモリ形成ですが、こうしたローカルメモリがグローバルに安全にフィードバックされれば、全体の知識基盤が常にアップデートされ続ける面白いエージェントになることができます。

プレイブックにしても、実際のプロジェクトで使われるたびに、その有用性が評価され、改善のサイクルが回ります。定型業務の自動化といっても、一度作ったら終わりではありません。運用を通じて継続的に磨き上げることで、真に価値あるナレッジとして昇華されていくのです。

こうした継続的学習の仕組みは、特定のAIエージェントの枠を超えて、汎用的に適用できるものでもあります。個々のエージェントが学んだ知見を、より大きな知識ベースにフィードバックすることで、全体の品質を底上げできるからです。

進化し続けるエージェントアプリケーションの育成

ここまで述べてきたように、AIエージェントにとってメモリは、単なる情報の貯蔵庫ではありません。むしろ、継続的に学習し、進化し続けるための基盤と捉えるべきでしょう。

セマンティック、エピソード、プロシージャル。それぞれのメモリが、ユーザーとのインタラクションを通じて、日々豊かになっていく。新しい知識体系が形成され、より高度な推論が可能になる。そうした成長のプロセスこそが、AIエージェントの真価なのではないかと思っています。

これはある意味、PoCフェーズで止まっている企業はAIエージェントが育たず、苦しい局面に立たされるかもしれません。また、グローバルのAIエージェントアプリケーションがWinner Takes Allになる可能性も示唆していますが、人材の採用がローカルに行われるように、AIエージェントの採用自体もローカライズが必要になるかもしれません。

もちろん、そのためには継続的に使われるユースケースと、適切なメモリ設計が欠かせません。短期と長期のバランス、更新パターンの使い分け。上述のデザインパターンを応用しつつ、それぞれのタスクに最適化された設計を施す必要があります。

しかし、本当の意味での*別化要因は、その先にあります。「育てる」という視点を持つこと。エージェントを単なるツールではなく、共に成長するパートナーとして捉えること。そこに、AIエージェントのポテンシャルを最大限に引き出すヒントがあるのではないでしょうか。AIエージェントの学習し続ける組織が次のDXのトレンドになることは間違いないでしょう。

About me

現在、市場調査やデスクリサーチの生成AIエージェントを作っています 仲間探し中 / Founder of AI Desk Research Agent @deskrex , https://deskrex.ai

ぜひお気軽にチャットしましょう!Devinもいます。

生成AIデスクリサーチサービス Deskrex | サービスページ

生成AIデスクリサーチエージェント Deskrex App | アプリケーションサイト

DeskrexAIリサーチ | メディア

株式会社Deskrex | 会社概要

Deskrex | Xページ

- 会社概要:https://www.deskrex.ai/

- Deskrex App:https://app.deskrex.ai/

- サービスページ:https://lp.deskrex.ai/

- メディア:https://media.deskrex.ai/

- X:https://x.com/deskrex

Discussion