🦙

ローカル環境でLlama 2 Chat 70B Q4を動かしてみた

はじめに

Llama2 はMetaが開発した言語モデルです。

年末年始に暇つぶしに自分のPCで動かしてみたので、その手順を紹介します。

使用ツール

動作環境

- OS: Windows 11 Pro for Workstations

- CPU: AMD Ryzen 9 7900X

- GPU: NVIDIA GeForce RTX 4090

- RAM: 64GB

手順

Janのインストール

Janは、いろんなLLMを簡単に動かせるようにするためのツールです。

まずGitHubからJanをダウンロードします。

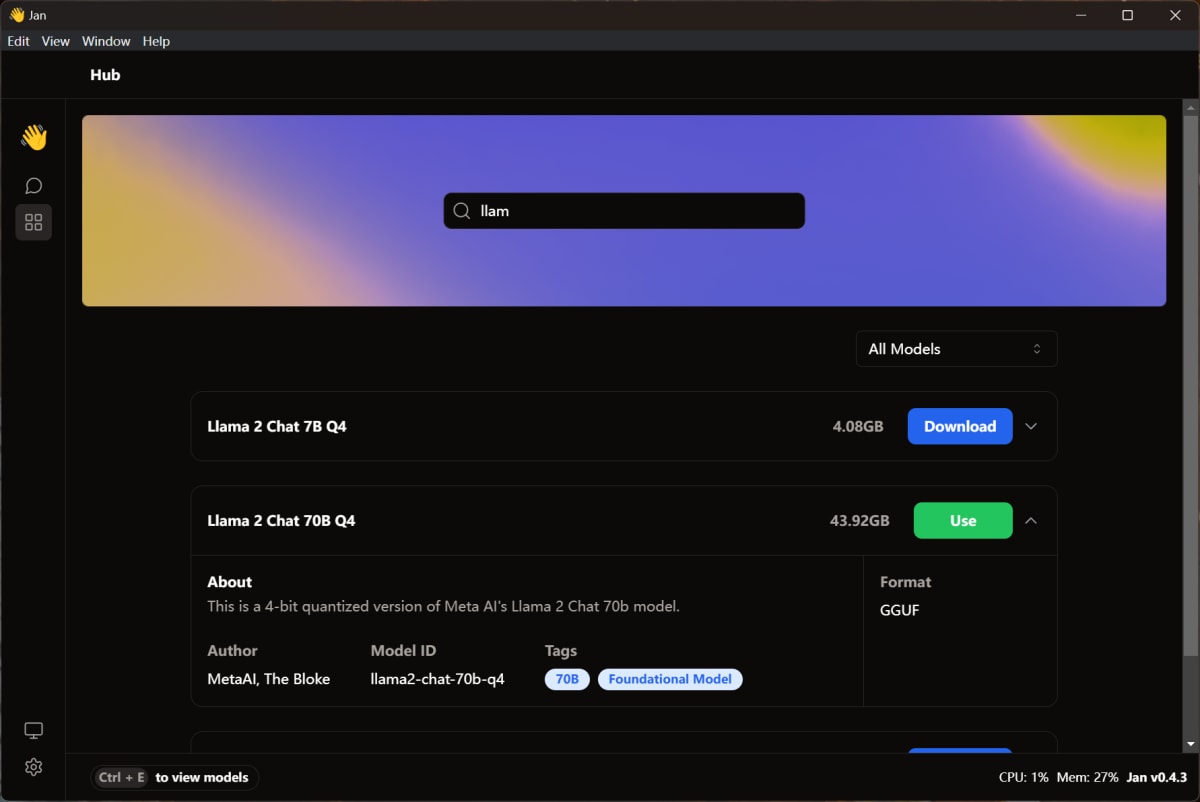

Llama 2 Chat 70B Q4のダウンロード

続いて、JanでLlama 2 Chat 70B Q4をダウンロードします。

ダウンロードが完了したら、Useボタンをクリックすればチャットが開始できます。

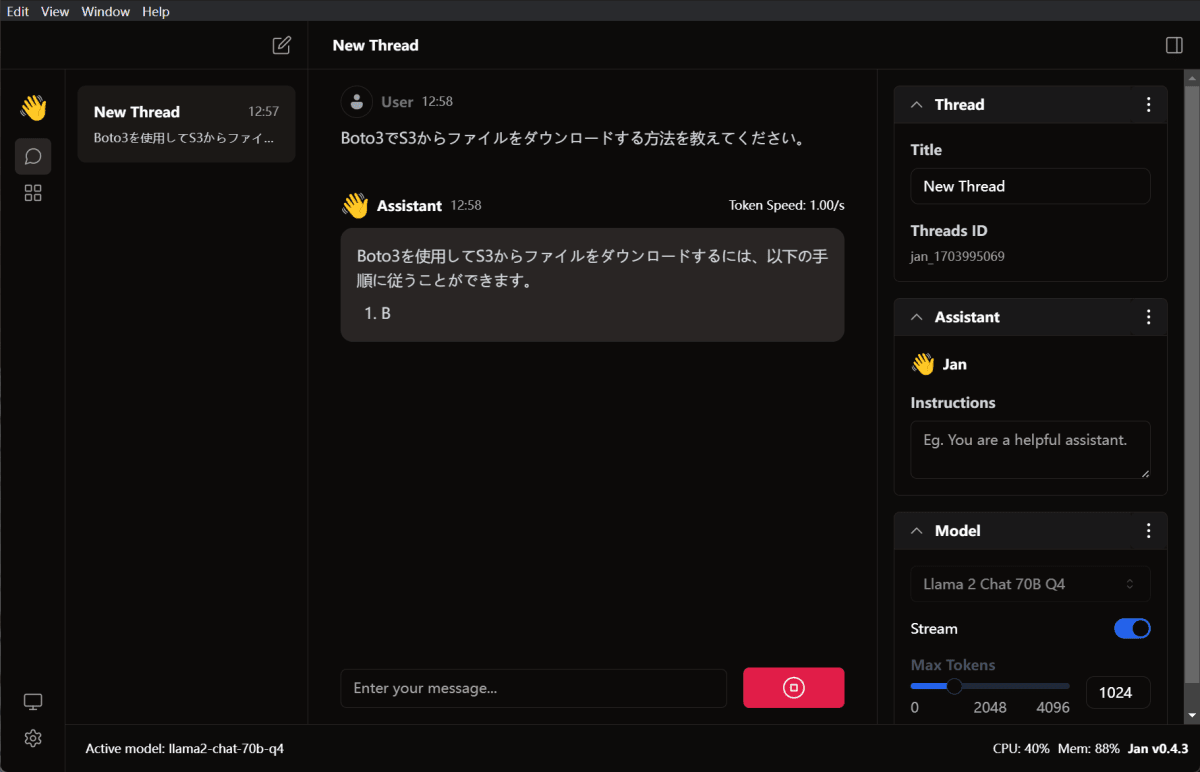

使ってみる

早速質問をしてみました。自分のPCだと大体 1 Token/s くらいの速度で返答してくれました。

メモリー使用率はカツカツですね。

まとめ

Llama 2 Chat 70B Q4をローカル環境で動かすことができました。

Janを使うと、いろんなLLMを簡単に動かすことができるので、ぜひ試してみてください。

Discussion