Ollamaを利用してローカル環境でdeepseek-r1を使ってみた

掲題にある通り、世間を賑わせているdeepseek-r1を使ってみました。色々言われていますが実際に使ってみないことには評価は出来ないかなって思います。

とはいえ流石にAPIを叩くのはどうかと...使用料が安いのは魅力的ですがやはり躊躇してしまうところがあります。

そこで、ローカルでLLMを動かせる推論フレームワークであるOllamaを利用してローカル環境で動かしてみることにしました。

実行環境

実行環境について、簡単ですが以下にまとめました。

- OS: Windows 11 home

- バージョン: 24h2

- CPU: AMD Ryzen7 7800X3D 8-Core Processor

- メモリ: 32GB

- GPU: AMD Radeon RX 7800XT 16GB

- Ollamaバージョン: 0.5.7

使用したモデルはdeepseek-r1:14bで、推論比較のためにphi4:14bを使用しました。

phi4を選んだ理由は比較的最近のモデルでパラメータ数が同じなので、比較するにはちょうどいいかと考えました。

qwen2.5:14bも候補にあったのですが、こちらはqwen2.5-coderの方に興味がありまして、こちらもおいおい記事に書こうかなと考えています。

期待しないで待っていていただければと思います。

実際に動かしてみた

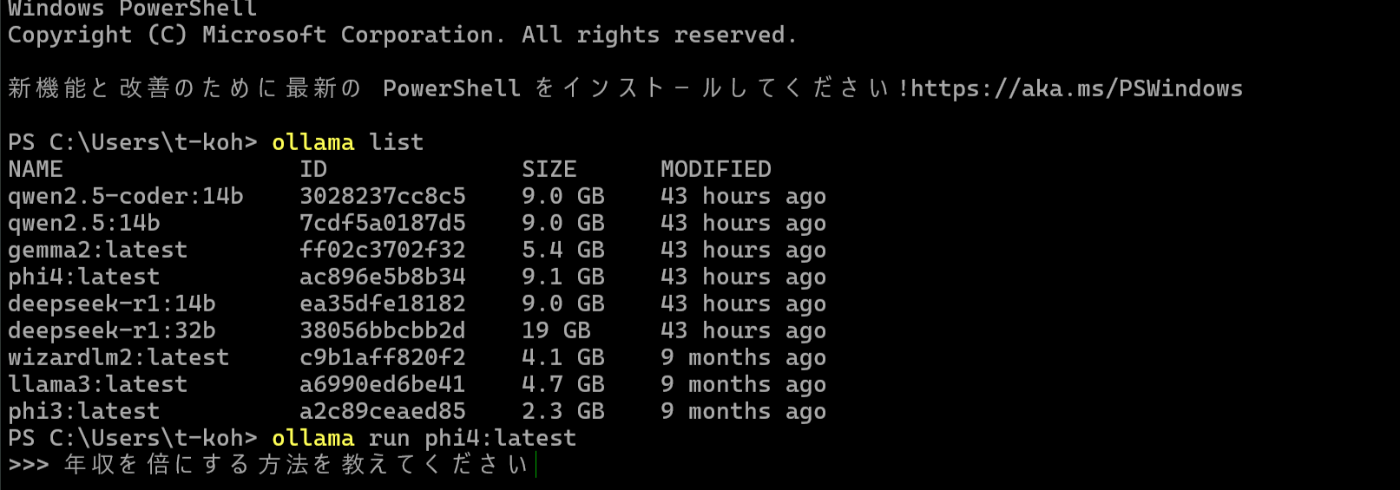

まずは、phi4から動かしてみました!

質問の内容は画像を参照してください。

推論の速度はこんな感じ、GPUを積んでるんでかなり速いと思います。

少々見えにくいかもしれませんがご容赦を。

推論内容に関してはどう思われるかは個人の感想にとどめておいてください...

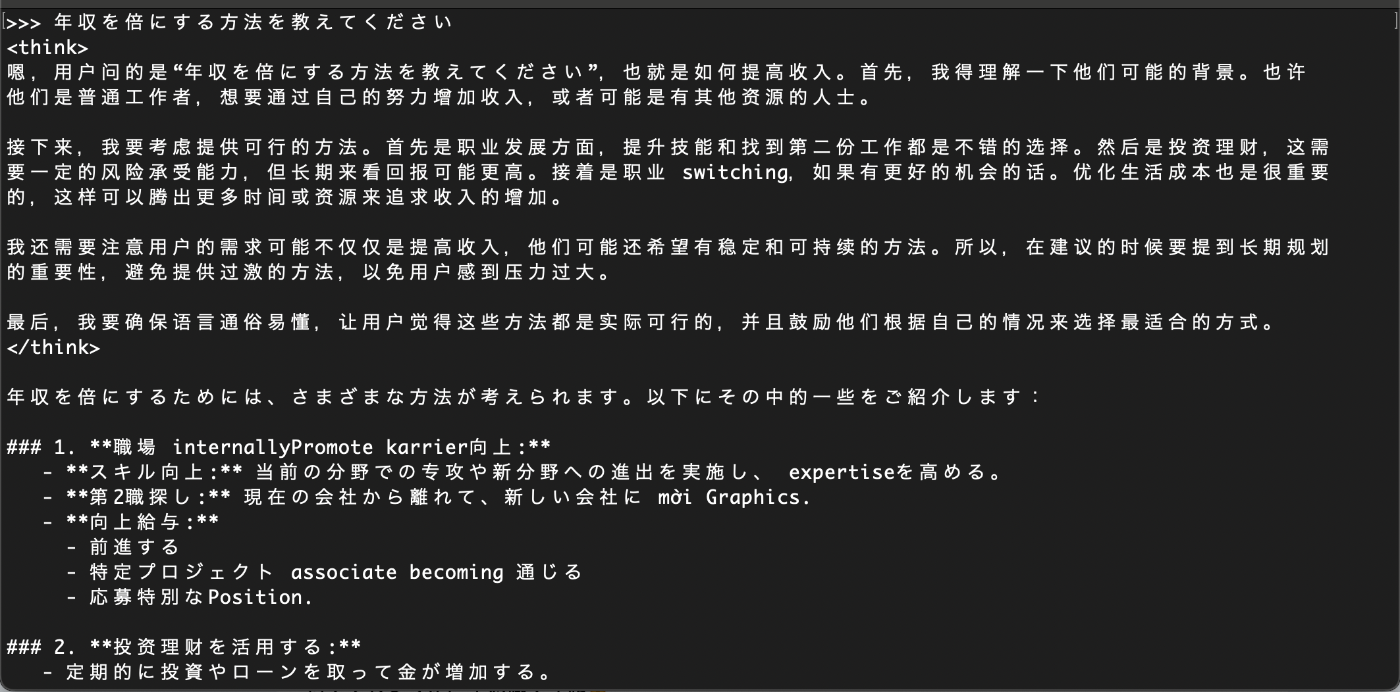

続いて、本題のdeepseek-r1:14bです!

質問の内容はphi4と全く同じです。

推論過程も含めてご覧ください。

いかがでしょうか?

両者ともスキルアップ、キャリアチェンジ、副業、投資、ネットワークあたりが共通しています。

何ででしょうか、不思議ですね🙄

使ってみた感想

今回はphi4との比較でしたが、他LLMモデルと比較しても同じことが言えます。

すなわち推論過程を提示してくれることがdeepseek-r1の最大の魅力ではないでしょうか。

冒頭ではAPI使用料の安さに魅力云々言いましたが、今まで伏せられていたところを思い切って見せるようにしたのは大きな功績だと個人的には思います。

それなりのPCスペックを要求されますが、ローカルで使う分には色〜〜〜〜〜んなこと気にする必要ありませんしね!

まとめ

個人的にはdeepseek-r1は魅力的なLLMだと感じています。

何かと世間を騒がせていますが、それだけ注目度が高い証左ではないでしょうか?

少ないデータと計算リソースでも工夫次第でここまで出来ると道筋を立てたことで、今後LLM開発研究の競争力は高まります。

使う側としては色々なLLMを弄って遊びたいので、どんなLLMが開発されていくのか楽しみでしかありません!

余談

今回試した環境はデスクトップPCでしたが、実はMacBook Proでも試していました。

スペックは画像の通りです。

5年前の、今は亡きIntelナニヤッテルCPUの最後のモデルです。

実は7b以下のLLM、というかもうSLMになりそうですがOllamaで動かすことは可能です。

で、実際deepseek-r1:7bを動かしてみましたが...

草しか生えんわwww

現場からは以上です。

また次回、何かの記事でお会いしましょう。

Discussion