Mambaで物体検出 完全に理解した

本記事は『エンジニア達の「完全に理解した」Talk #67』 で発表した内容を再構成したものです。

Mamba とは?

皆さんはMamba[1]というアーキテクチャを知っていますか?

Mambaは 2023 年に提案されたアーキテクチャで、近年活用が進んでいます。

2025 年現在、LLM のような大規模なシーケンスデータを扱うモデルでは、Transformer[2]をベースにしたモデルが主流です。

しかし、Transformer には、計算量が

Transformer の中でも重要な Attention 機構は、次のような式で表せられます。

Mamba のアイデア

「もっとスケールしやすいアーキテクチャにできないのか?」ということで生まれたのが Mamba です。

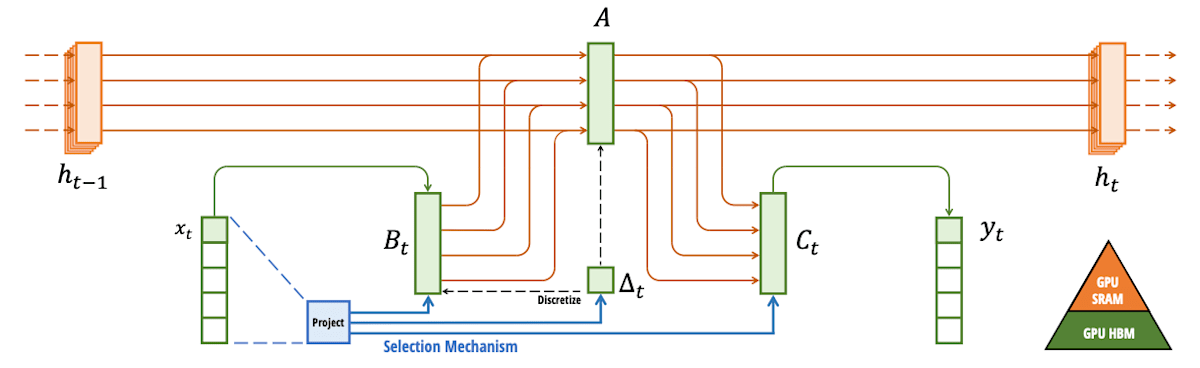

Mamba は、SSM(構造化状態空間モデル)という技術を基盤としています。

SSM は次のような式で表されます。

SSM では、状態

SSM であれば、線形

しかし、SSM にも大きな弱点がありました。それは、「必要な情報を選択する力が弱い」ことです。

Transformer の強みだった入力の重要度を計算する力が SSM にはなく、入力を全てフラットに見てしまうのです。

そこで、Mamba では選択機構を導入し、パラメータを入力に応じて動的に変化させることで、入力を状態に保存するか/しないかを判断することができるようになりました。

Mamba: Linear-Time Sequence Modeling with Selective State Spacesより

Mamba の活用事例

LLM への応用

LLM をはじめ、実際に活用もされています。

例えば、Mistral AI は 2024 年に Codestral Mamba[3] を発表しています。

画像認識分野への応用

Transformer から Vision Transformer[4] や DETR[5] が生まれたように、Mamba も画像認識分野への応用研究も進んでいます。

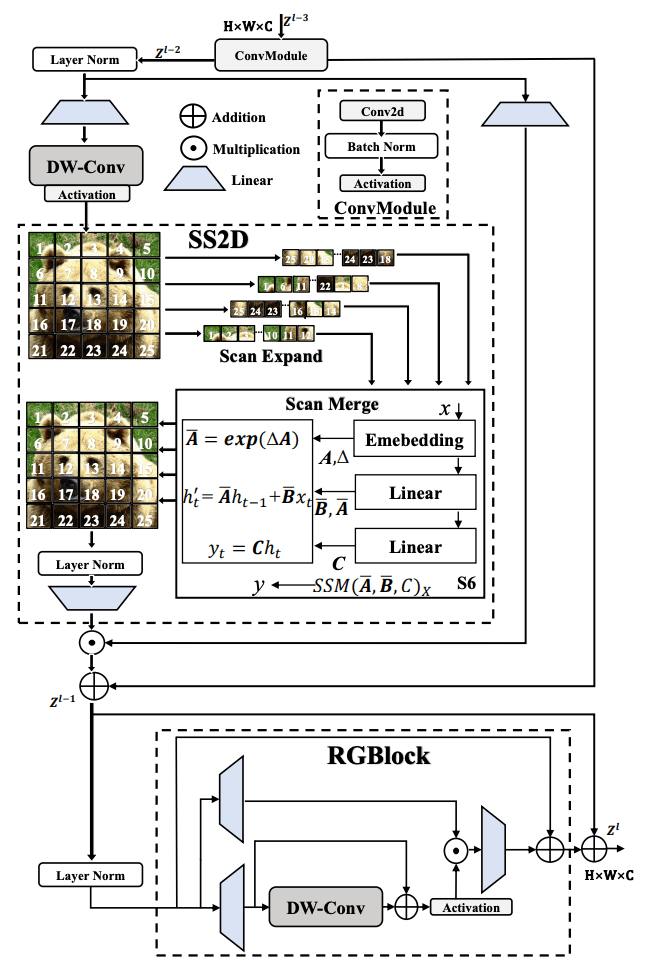

例えば、物体検出分野だと、Mamba YOLO[6] などの研究が発表されています。

Mamba YOLO: A Simple Baseline for Object Detection with State Space Modelより

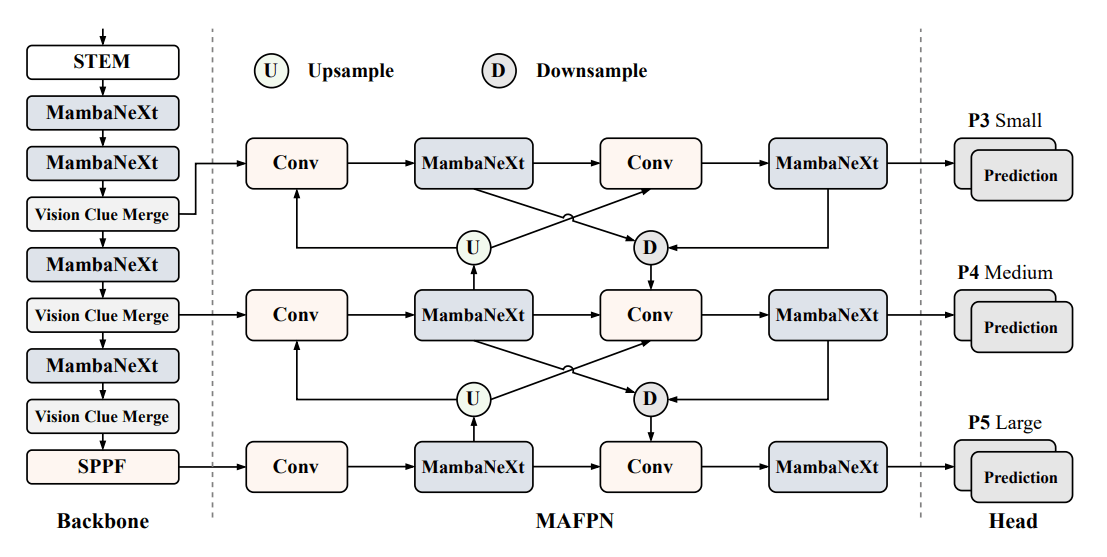

また、MambaNeXt-YOLO[7]では、従来の CNN と Mamba とのハイブリッド構成を提案しています。

局所的な特徴を掴むことが得意な CNN と、長距離の依存関係を掴むことが得意な Mamba とを組み合わせることで、リアルタイム・低リソース環境での高精度な物体検出を実現しました。

MambaNeXt-YOLO: A Hybrid State Space Model for Real-time Object

Detectionより

これまでのアーキテクチャの完全な置き換えではなく、それぞれのメリットを組み合わせて活用が進んでいくでしょう。

まとめ

Mambaが画像認識の分野でも注目だ!

Discussion