Open WebUI + Llama3 (8B)をMacで動かしてみた

こんにちは。DiamondGotCatです。

この記事では、Open WebUIというソフトウェアで、Llama3という生成AIをローカルで動かしていきます。

注意

新バージョンの記事が出ました!

この記事は古いです... (主にUI面)

この記事を参考にAIのモデルをダウンロードするというステップの前まで行ってから、

以下の新バージョンの記事を参考にしてください。

環境

生暖かい気温 (???)

Mac mini (M2 Pro, 32GBメモリ)

BUFFALOの外付けSSDから起動

結論

動く。

流石に70Bモデル(超高性能版)は動かなかったけれど、8B(通常版)で十分に感じた。

日本語はわかるものの、英語で応答してくるので注意

用語

Llamaとは

Metaが開発しているAIです。

なんと、ローカルで動かせるように、公開されています。

Open WebUIとは

Llamaなどを簡単に動かせるようにした「Ollama」を、

画面で操作できるようにするソフトです。

準備!

Ollamaのインストール

2つ方法があったのですが、arm64アーキテクチャに対応していないのか、DockerでのOllamaは動かなかったので直接使います。

ダウンロード

に行くとZIPファイルをダウンロードできます。

ダウンロードしましょう

インストール

ZIPファイルを解凍し、/Application/に 移動/コピー しましょう。

Ollamaを起動する

Ollama.app ファイルを ダブルクリック または openコマンド で起動しましょう。

Docker Desktopのインストール

ダウンロード

ここでインストーラーをダウンロードします。

インストール

ダブルクリック または openコマンド でインストーラーを起動しましょう。

Docker.app ファイルが表示されるので、アプリケーションフォルダにドラッグしましょう。

Dockerを起動する

Docker.app ファイルを ダブルクリック または openコマンド で起動しましょう。

初期設定やログイン画面が表示されるので、表示される手順に従ってください。

使う

open-webuiの起動

コマンドを打ちます。bashまたはzshで行ってください。

docker run -d -p 7860:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui ghcr.io/open-webui/open-webui:main

※初回の場合はインストールされます

ブラウザーで表示

ここにアクセスしてください。

登録 (初回のみ)

ログイン/登録画面が出ます。登録してください。

※動かしているパソコン以外に情報は送信されないようです

AIのモデルをダウンロードする (モデルごとに初回のみ)

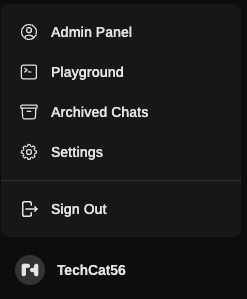

メニューを表示

自分の名前をクリックして、メニューを表示します。

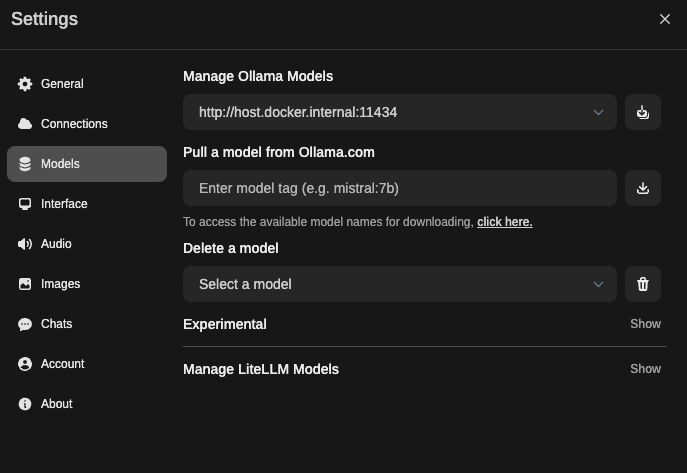

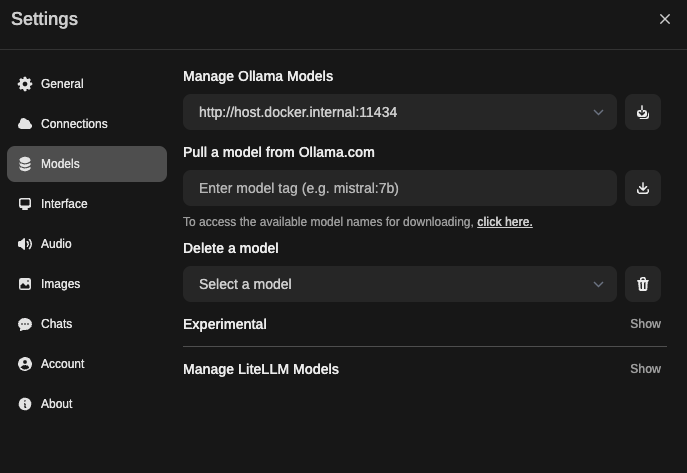

設定を開く

「Settings」をクリックして、設定を表示します。

「Models」をクリックして、モデル設定の画面を表示します。

モデルをダウンロード

「Pull a model from Ollama.com」のテキストフィールドに、モデルIDを入力し、横のダウンロードボタン?をクリックします。

今回はllama3にします。

画面上に「終わったよ」と英語で出るまで、待ちます。

終わったら、バツボタンを押します。

チャットする

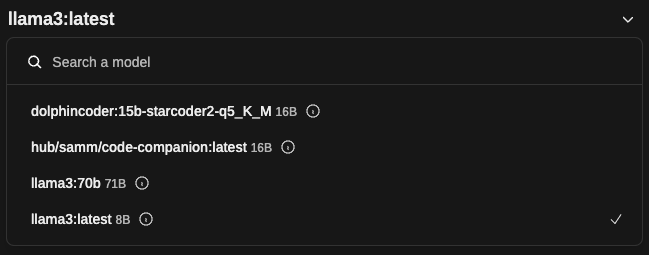

モデルの選択

ついにチャットができます!!

モデルを選択(今回はllama3:latestをクリック)してください。

話す

「よろしくお願いしまぁぁーす!」

聞く

日本語は聞けるけど話せないのか...

結論 (2)

動く。

流石に70Bモデル(超高性能版)は動かなかったけれど、8B(通常版)で十分に感じた。

日本語はわかるものの、英語で応答してくるので注意

感想

これがローカルで動くっていうのが、

いまだに信じられません...

以上!

Discussion