🙄

SAM-HQをgoogle colabで試してみた

SAM-HQとは

sam-hqとは、Metaから出たSAM(Segment Anything Model)を更にHigh qualityにしたSegment Anything modelです。

リンク

準備

Google Colabを開き、メニューから「ランタイム→ランタイムのタイプを変更」でランタイムを「GPU」に変更します。

環境構築

インストール手順です。

!git clone https://github.com/SysCV/sam-hq.git

%cd sam-hq

!pip install -e .

推論

(1)モデルのダウンロード

vit-bモデルを利用します。

%cd /content/sam-hq/

!mkdir pretrained_checkpoint

# vit-b

!gdown https://drive.google.com/u/0/uc?id=11yExZLOve38kRZPfRx_MRxfIAKmfMY47&export=download&confirm=t&uuid=ca4d343c-4bd2-47ed-bb47-1879783bc4e3&at=AKKF8vxEYbzgJ8KpsdhDmEZMFbgt:1686550376456

(2)推論

%cd /content/sam-hq/

!python demo/demo_hqsam.py

結果

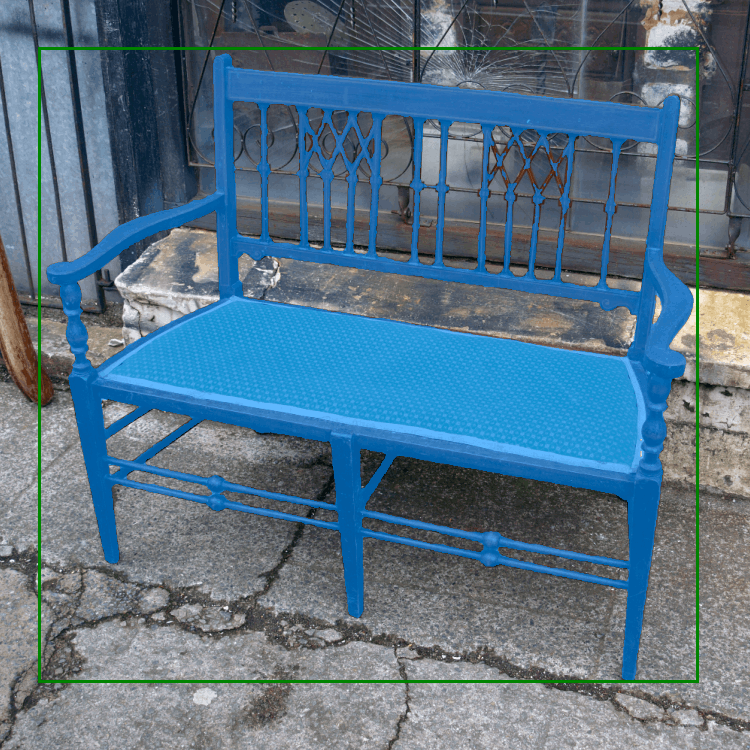

Segment Anythingを利用した人なら分かると思いますが、こんなに綺麗に柱までsegmentationできるのはマジで凄すぎる。。

最後に

今回は新しいSegment Anything Modelであるsam-hqをgoogle colabで試してみました。SAMよりもはるかにHigh Qualityなセグメンテーションができている。。もうほぼほぼ完璧に近いんじゃないかと思いますね。使い所しかない!

今後ともLLM, Diffusion model, Image Analysis, 3Dに関連する試した記事を投稿していく予定なのでよろしくお願いします。

Discussion