Closed3

コミュニティ版DifyでローカルLLMを使ってみる

ローカルLLMのAPIサーバーを起動する

下記の記事で書いているがJanでLLMサーバーを起動する

コミュニティ版DifyからこのLLMサーバーを使ってみる

Difyのモデルプロバイダーの設定をする

JanはOpenAI APIと互換がある

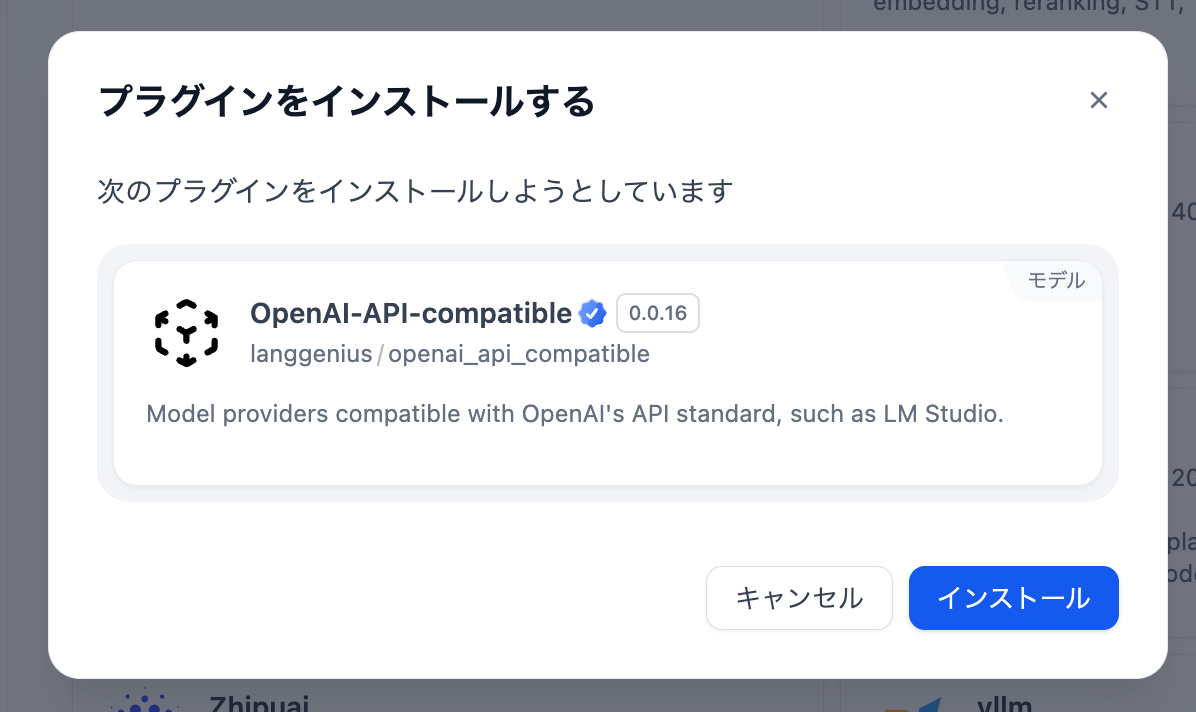

そのため、モデルプロバイダーのOpenAI-API-Compatibleをインストールして設定することで、Jan経由でローカルLLMと連携できる

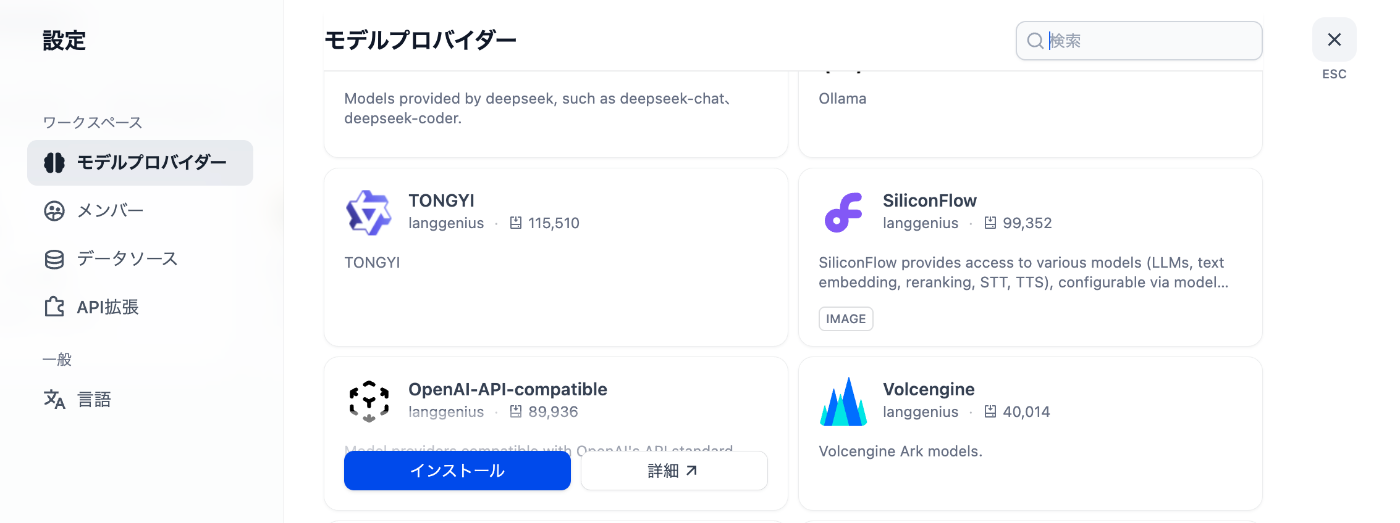

インストールする

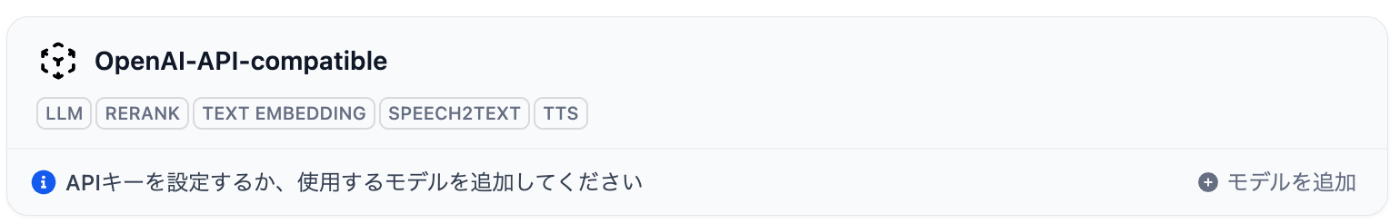

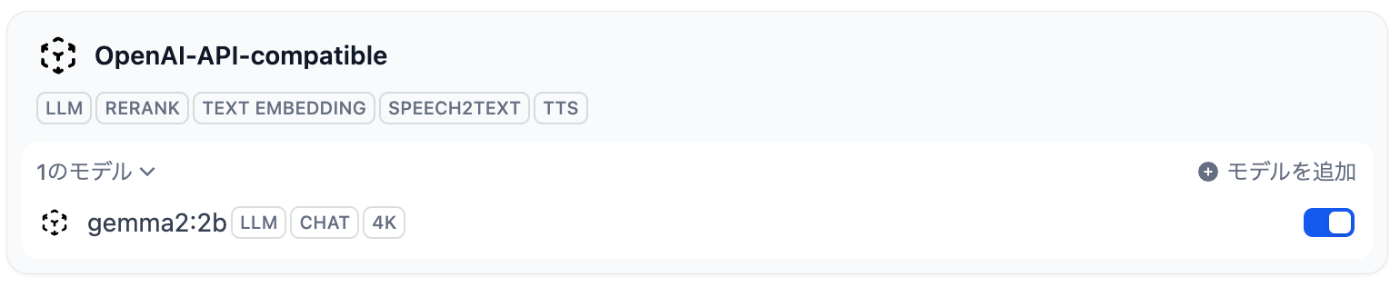

インストールが終わると下記のように追加される

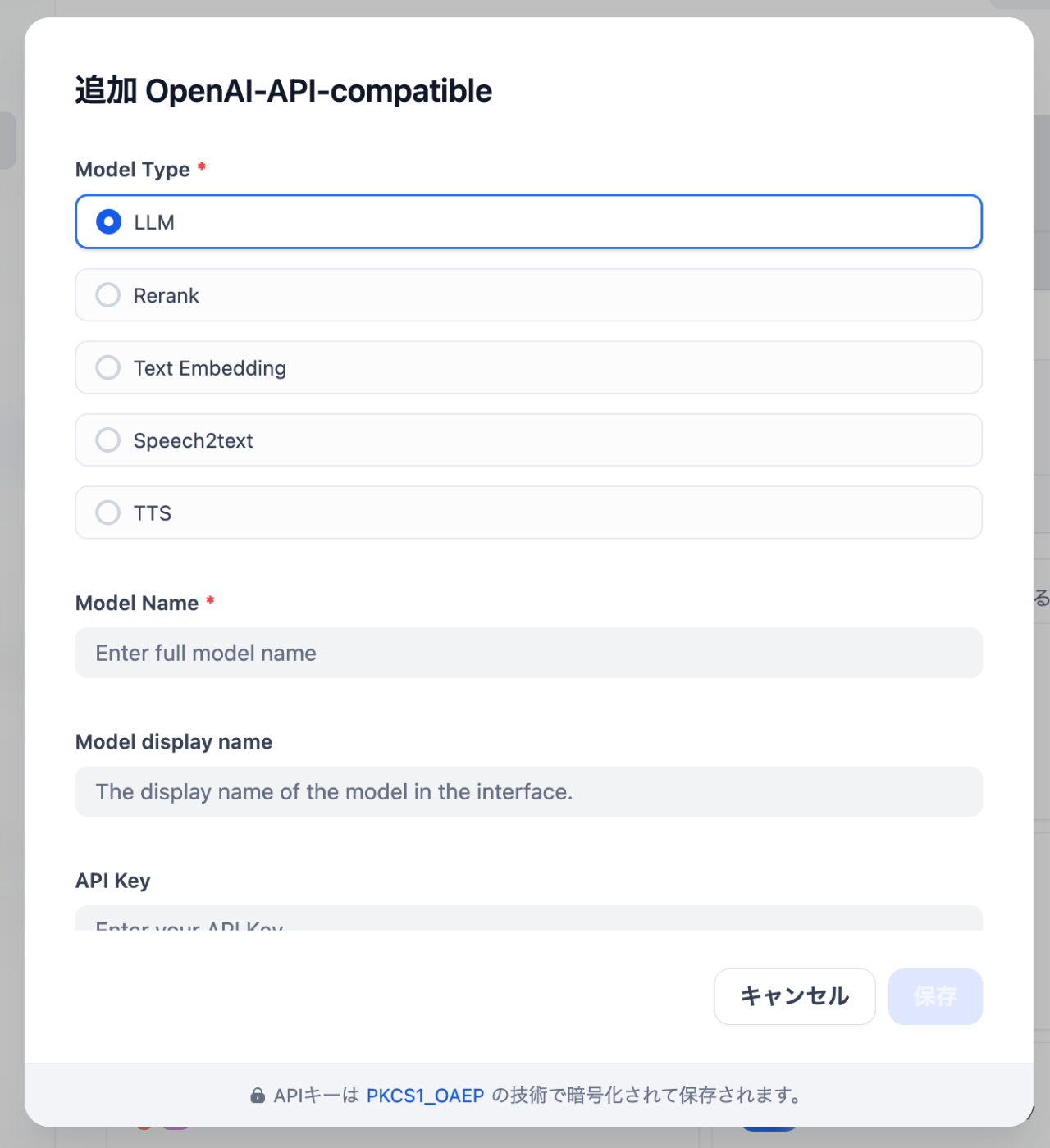

モデルの追加をクリックすると設定モーダルが表示される

私は、Janでgemma2:2bモデルをダウンロードして使えるようにしている

これを使うことを前提に設定する

下記の項目について設定する

| 項目 | 設定値 |

|---|---|

| Model Type | LLM |

| Model Name | gemma2:2b |

| Model display name | gemma2:2b |

| API endpoint URL | http://host.docker.internal:1337/v1 |

保存ボタンを押して問題がなければモーダルが閉じ、下記のようにモデルが追加されたことがわかる

補足:API endpoint URLについて

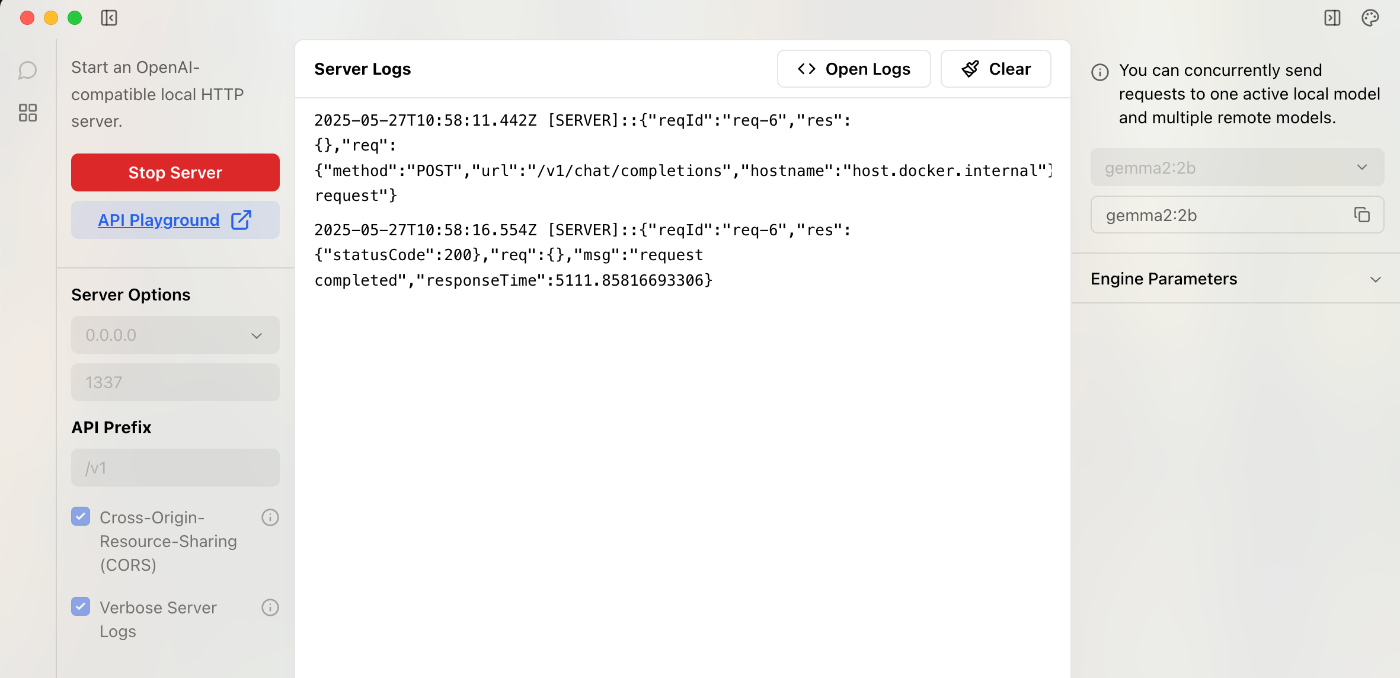

今回、Dockerで起動しているためlocalhostではなくhost.docker.internalと指定する必要がある

また、:1337/v1についてはJanで設定している内容で記述すること(デフォルトはポート1337でプレフィックスがv1になっている)

追加したモデルプロバイダーを指定する

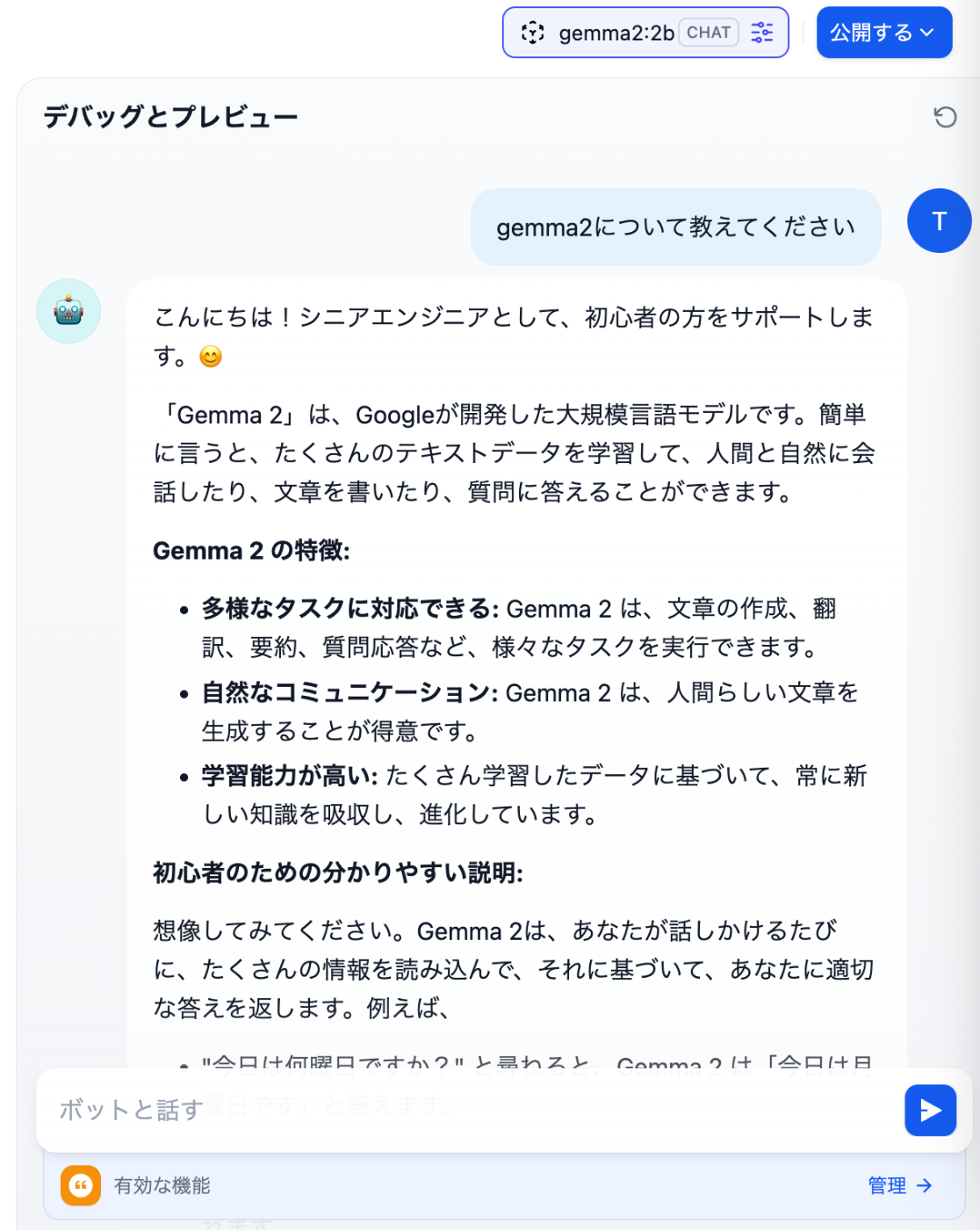

作成したアプリのオーケストレーション画面でモデルを選択しようとすると、先ほど追加したモデルが表示されるようになっている

今回はgemma2:2bを追加したが、選択肢に表示されていることがわかる

質問してみて回答が返ってくれば成功

Janのログを見てみるとログが出力されている

このスクラップは4ヶ月前にクローズされました