うさぎでもわかるComfyUI FramePackでAI動画生成 〜ControlNetを活用したカスタマイズ方法〜

うさぎでもわかるComfyUI FramePackでAI動画生成 〜ControlNetを活用したカスタマイズ方法〜

はじめに

AI画像生成の進化は目覚ましく、静止画だけでなく動画生成も手軽にできるようになりました。その中でも2025年に登場した「FramePack」は、少ないVRAMでも長時間の動画生成を可能にする画期的な技術です。

「うさぎだけど、難しいAI技術はちょっと苦手なんだぴょん...」

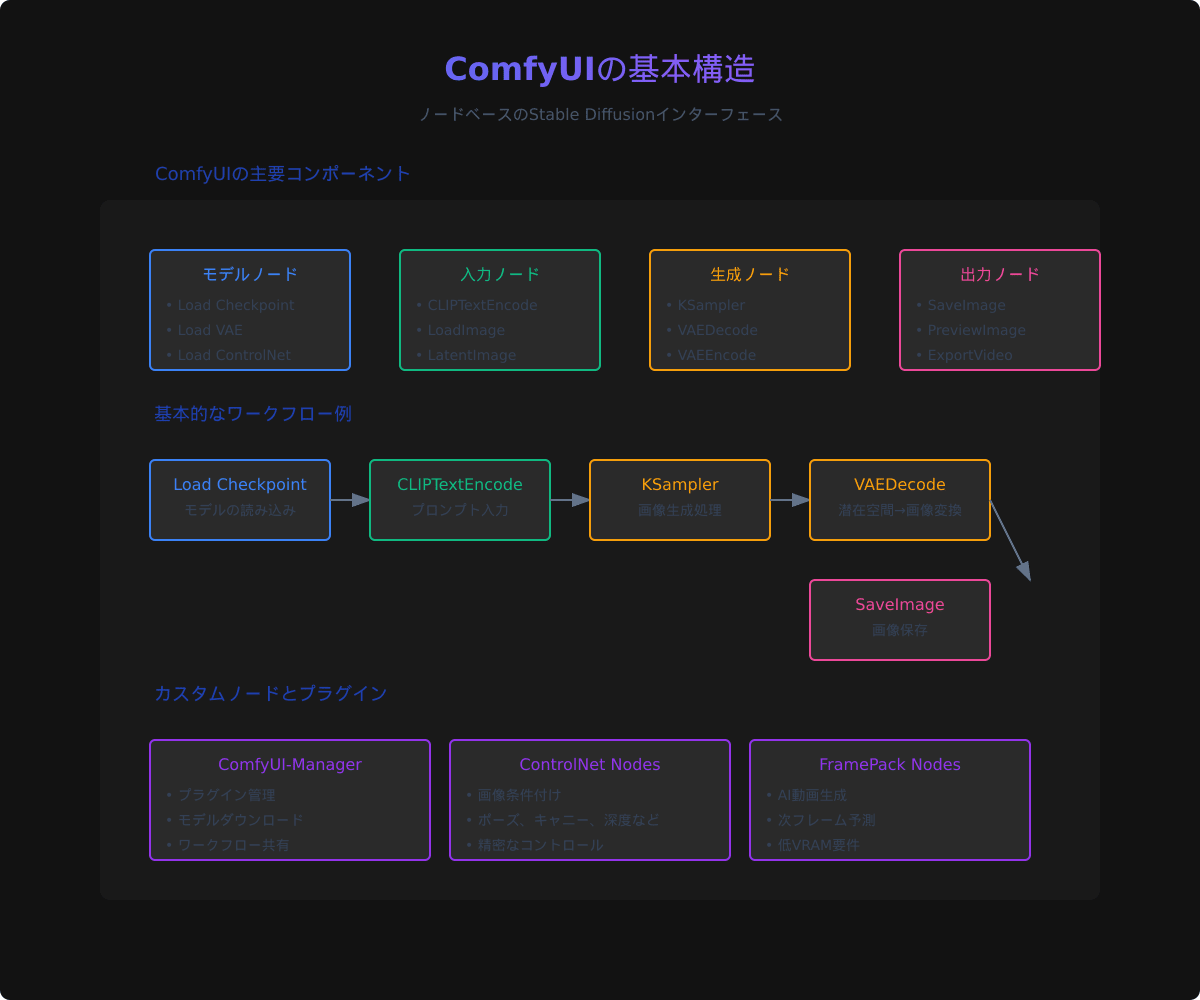

大丈夫です!この記事では、ComfyUIというノードベースのインターフェースで、FramePackを使ったAI動画生成の方法を解説します。さらに、ControlNetを使ったカスタマイズで、よりコントロールされた動画生成方法も紹介します。

この記事を読むと以下のことがわかります:

- FramePackとは何か、そしてなぜ注目されているのか

- ComfyUIでFramePackを使うための準備と基本的な使い方

- ControlNetを使ってFramePackの動画をカスタマイズする方法

- 実践的な応用例とトラブルシューティング

あなたもこの記事を読めば、ノートPCでも高品質なAI動画が作れるようになるでしょう!それではさっそく始めましょう!

FramePackとは何か

「FramePackって何なのかしら?なんだか難しそうだぴょん...」

FramePackは、スタンフォード大学のLvmin Zhang氏のチームによって開発された、次世代のAI動画生成技術です。従来のAI動画生成と比べて、どのような特徴があるのでしょうか?

従来の動画生成との違い

従来のAI動画生成モデル(AnimateDiffやSVDなど)は、一度に全フレームを処理する方式が主流でした。これは短い動画には適していますが、長時間の動画生成には大量のVRAMが必要で、一般的なGPUでは処理が困難でした。

一方、FramePackは「次フレーム予測モデル」という新しいアプローチを採用しています。これは前のフレームを参照しながら次のフレームを1枚ずつ生成していく方式です。

FramePackの主な特徴と利点

FramePackの主要な特徴と利点は以下の通りです:

- 低VRAM要件: 最小6GB程度のVRAMで動作可能(fp8モデル使用時)

- 長時間動画生成: 理論上無制限の長さの動画を生成可能

- 高い一貫性: 各フレームが前のフレームを参照するため、動きの一貫性が高い

- メモリ効率: フレーム数が増えても必要メモリは一定(コンテキスト圧縮技術による)

- 柔軟性: 異なる条件付けやプロンプト変更を途中で適用可能

「わぁ、ノートPCでも使えるなんて素晴らしいぴょん!」

そうなんです!これまでハイエンドGPUでしか実現できなかった長時間の高品質動画生成が、一般的なノートPCでも可能になりました。それでは、実際にComfyUIでFramePackを使うための準備を見ていきましょう。

ComfyUIでFramePackを使うための準備

FramePackをComfyUIで使うには、専用のプラグインとモデルをインストールする必要があります。以下の手順で準備を進めていきましょう。

必要なプラグインの導入方法

現在、ComfyUIでFramePackを使うための主要なプラグインは2つあります:

- ComfyUI_RH_FramePack: HM-RunningHubによる実装。シンプルで安定した使用感が特徴。

- ComfyUI-FramePackWrapper: Kijaiによる実装。高速処理に最適化されており、より柔軟なカスタマイズが可能。

ここでは、より安定している ComfyUI_RH_FramePack を例に導入方法を説明します。

# ComfyUIのディレクトリに移動

cd ComfyUI/custom_nodes

# プラグインのクローン

git clone https://github.com/HM-RunningHub/ComfyUI_RH_FramePack.git

# 依存パッケージのインストール

cd ComfyUI_RH_FramePack

pip install -r requirements.txt

ComfyUI-Managerがインストールされている場合は、GUIからも簡単にインストールできます:

- ComfyUIを起動し、メニューから「Manager」を選択

- 「Install Custom Nodes」タブを開く

- 検索ボックスに「FramePack」と入力

- 表示された「ComfyUI_RH_FramePack」の「Install」ボタンをクリック

「わかったぴょん!でも必要なモデルもあるのかな?」

必要なモデルのダウンロードと配置

FramePackを使うには、いくつかの特殊なモデルが必要です。主に以下の3種類のモデルファイルが必要になります:

-

FramePackI2V_HY: 次フレーム予測の核となるモデル

- 標準精度版 (bf16): 25.7GB

- 低精度版 (fp8): 16.3GB

- HunyuanVideo: ベースとなるビデオ生成モデルのコンポーネント

- SIGCLIP Vision: 画像特徴抽出のためのモデル

これらのモデルは自動的にダウンロードされる場合もありますが、手動でダウンロードする場合は以下の場所に配置します:

# FramePackI2V_HYモデル

ComfyUI/models/diffusers/lllyasviel/FramePackI2V_HY/

# または単一ファイル版の場合

ComfyUI/models/diffusion_models/FramePackI2V_HY_fp8_e4m3fn.safetensors

「モデルが大きいぴょんね。ダウンロードに時間がかかりそう...」

はい、特にbf16版は容量が大きいので、VRAM容量に余裕がない場合はfp8版を使うことをお勧めします。多少品質は落ちますが、十分実用的な結果が得られます。

準備ができたら、ComfyUIを起動して実際にFramePackを使ってみましょう!

ComfyUIでの基本的なFramePackワークフロー

ComfyUIでFramePackを使った基本的な画像から動画への変換ワークフローを見ていきましょう。

基本的な画像から動画への変換ワークフロー

FramePackの基本的なワークフローは、初期フレーム(画像)から始まり、そこから連続したフレームを生成していくものです。典型的なワークフローの構成は以下のようになります:

- 初期フレームの読み込み (LoadImage)

- プロンプトの設定 (CLIPTextEncode)

- FramePackノードによるフレーム生成

- 生成されたフレームの保存 (SaveImage/ExportVideo)

「具体的にどんなノードが必要なのかしら?」

ワークフローの各ノードの説明と役割

FramePackを使った基本的なワークフローに必要な主要なノードは以下の通りです:

- LoadImage: 初期フレームとなる画像を読み込みます

- CLIPTextEncode: 生成したい動画の内容を記述するプロンプトを設定します

- CLIPTextEncode (ネガティブ): 避けたい要素を指定するネガティブプロンプトを設定します

- RH_FramePackI2V: 核となるFramePackノードで、前のフレームから次のフレームを生成します

- VAEDecode: 生成された潜在表現を画像に変換します

- SaveImage: 生成されたフレームを保存します

これらのノードを接続して、基本的なワークフローを構築します。

パラメータの調整方法と効果

FramePackの挙動を制御する主要なパラメータとその効果を紹介します:

- steps: 生成ステップ数。多いほど品質が向上しますが、処理時間も増加します(推奨値: 20-30)

- cfg: ガイダンススケール。高いほどプロンプトに忠実になりますが、創造性は低下します(推奨値: 7-9)

- frames: 生成するフレーム数を指定します

- seed: 乱数シード。同じシードを使うと同じ結果が得られます

- motion_scale: 動きの大きさを調整します。大きいほど激しい動きになります(推奨値: 0.5-1.0)

「なるほど、いろいろと調整できるんだぴょん!」

そうです!これらのパラメータを調整することで、生成される動画の品質やスタイルをコントロールできます。次に、ControlNetを使ってさらに精密な制御を行う方法を見ていきましょう。

ControlNetによるFramePackのカスタマイズ

FramePackで生成される動画をより精密にコントロールするために、ControlNetを組み合わせる方法を紹介します。

ControlNetの基本概念とComfyUIでの使い方

ControlNetとは、画像生成プロセスに特定の条件を追加するための技術です。例えば、ポーズ、輪郭、深度マップなどの情報を元に、画像生成をコントロールすることができます。

ComfyUIでControlNetを使用するには、まず必要なノードとモデルをインストールする必要があります:

- ComfyUI-ControlNet-Aux: ControlNet前処理ツール

- ComfyUI-Advanced-ControlNet: 高度なControlNet機能の提供

これらもComfyUI-Managerから簡単にインストールできます。また、使用したいControlNetモデル(例: canny, pose, depth)をダウンロードして ComfyUI/models/controlnet/ に配置します。

FramePackワークフローにControlNetを組み込む方法

FramePackにControlNetを組み込むための基本的な手順は以下の通りです:

- 通常のFramePackワークフローを構築

- ControlNet前処理ノードを追加(例: Canny Edge Detector)

- LoadControlNetノードで適切なControlNetモデルを読み込む

- ApplyControlNetノードを使って、FramePackの生成プロセスにControlNetの条件を適用

具体的なノード接続のフローは以下のようになります:

- LoadImage → ControlNet前処理 → ControlNet適用

- CLIPTextEncode → ControlNet適用

- ControlNet適用 → FramePackノード → VAEDecode → SaveImage

「つなぐノードが増えて複雑になりそうだぴょん...」

確かに少し複雑になりますが、一度ワークフローを作成してしまえば、様々な入力画像やプロンプトで再利用できます。ComfyUIは作成したワークフローを保存・共有できるので、一度作ってしまえば簡単です。

異なるControlNetモデルの効果

FramePackと組み合わせて使用できる主なControlNetモデルとその効果を紹介します:

- Canny ControlNet: 輪郭ベースのコントロール。物体の形状や線を維持したい場合に有効

- Pose ControlNet: 人物のポーズを制御。キャラクターの動きを特定のポーズに従わせたい場合に使用

- Depth ControlNet: 深度情報に基づくコントロール。3D空間の一貫性を維持したい場合に有効

- Normal ControlNet: 法線マップに基づくコントロール。照明や表面の質感を保持するのに役立つ

それぞれのControlNetは、「strength(強度)」パラメータで影響の大きさを調整できます。値が大きいほどControlNetの影響が強くなり、小さいほどFramePackの自由度が増します。

次に、これらの組み合わせを使った実践的なカスタマイズ例を見ていきましょう。

実践的なカスタマイズ例

FramePackとControlNetを組み合わせた実践的なカスタマイズ例を紹介します。

事例1: ポーズControlNetを使った人物の動きのコントロール

人物のポーズを制御しながら、自然な動きのアニメーションを生成する方法です。

設定:

- ポーズControlNet(強度: 0.7)

- キャラクターLoRAの適用

- プロンプト例: "anime girl, blue hair, school uniform, happy, detailed, high quality, masterpiece"

- ネガティブプロンプト: "lowres, bad anatomy, bad hands, missing fingers"

手順:

- 初期フレームと目標ポーズ画像を準備

- OpenPose前処理でポーズ情報を抽出

- ポーズControlNetを適用したFramePackワークフローでアニメーション生成

効果:

人物の基本的な動きはポーズ画像に従いつつ、表情や細部は自由に生成されます。キャラクターの一貫性を保ちながら、自然な動きのアニメーションが作成できます。

事例2: キャニーControlNetを使った輪郭の維持

物体や風景の形状を維持しながら、動きや変化を追加する方法です。

設定:

- キャニーControlNet(強度: 0.5)

- スタイルLoRAの適用

- プロンプト例: "watercolor painting style, vibrant colors, brush strokes, artistic, flowing animation"

- ネガティブプロンプト: "photorealistic, digital art, flat colors"

手順:

- 初期フレームを準備

- Canny Edge Detector前処理で輪郭を抽出

- キャニーControlNetを適用したFramePackワークフローでアニメーション生成

効果:

重要な輪郭や形状を維持しながら、テクスチャやディテールに変化が生まれます。特に芸術的なスタイルや抽象的な表現に効果的です。

事例3: 複数のControlNetを組み合わせた高度なコントロール

より精密なコントロールのために、複数のControlNetを組み合わせる方法です。

設定:

- ポーズControlNet(強度: 0.6)+ キャニーControlNet(強度: 0.4)

- プロンプト例: "fantasy character, magical effects, glowing aura, dynamic pose, detailed environment"

- ネガティブプロンプト: "static, boring, plain background, low quality"

手順:

- 初期フレームを準備

- 各種前処理(OpenPose、Canny)を適用

- 複数のControlNetを組み合わせたFramePackワークフローでアニメーション生成

効果:

人物のポーズと全体の構図の両方を制御できるため、複雑なシーンでも一貫性のある動画を生成できます。ControlNetの強度バランスを調整することで、異なる要素の影響力を調整できます。

「うわぁ、すごいぴょん!いろんな組み合わせができるんだね!」

そうなんです!ControlNetを使うことで、AIの創造性を活かしながらも、あなたが望む方向へと動画の生成をガイドすることができます。次に、よくある問題やパフォーマンスの最適化方法を見ていきましょう。

トラブルシューティングとパフォーマンスの最適化

FramePackとControlNetを使用する上でよくある問題と、パフォーマンスを向上させるためのテクニックを紹介します。

よくある問題と解決策

問題1: VRAMエラーが発生する

- 解決策: 低精度のモデル(fp8版)を使用する、バッチサイズを小さくする、不要なノードを無効化する

問題2: フレーム間の一貫性が低い

- 解決策: FramePackのmotion_scaleパラメータを下げる、ControlNet強度を上げる、ステップ数を増やす

問題3: 特定の要素(顔や手など)が崩れる

- 解決策: より詳細なネガティブプロンプトを使用する、関連するLoRAを適用する、キャニーControlNetを追加して重要な輪郭を維持する

問題4: 生成が途中で停止する

- 解決策: より少ないフレーム数から始めて段階的に増やす、メモリリークの可能性がある場合はComfyUIを再起動する

VRAM使用量の最適化テクニック

- モデル精度の選択: 高品質が必要ない場合はfp8モデルを使用する

- 解像度の調整: 生成解像度を下げる(512x512など)

- バッチサイズの最適化: 一度に生成するフレーム数を減らす

- 不要な機能の無効化: 使わないプレビューや中間出力を無効にする

- メモリ効率の良いモード: VAE半精度モードを有効にする

生成速度と品質のバランス調整

- ステップ数の調整: 少ないステップ数(10-15)で速度重視、多いステップ数(20-30)で品質重視

- サンプラーの選択: 高速サンプラー(Euler a, DPM++ 2M)と高品質サンプラー(DPM++ SDE Karras)の使い分け

- ControlNet強度のバランス: 強度を下げると生成の自由度が上がり、処理も軽くなる

- プレビュー設定: 開発中はプレビュー品質を下げ、最終出力時だけ品質を上げる

「これは助かるぴょん!VRAMが足りなくて困っていたんだ」

これらの最適化テクニックを活用すれば、限られたハードウェアでもより効率的にFramePackを使用できるようになります。次に、この記事のまとめと将来の展望について見ていきましょう。

まとめと今後の展望

FramePackを使ったAI動画生成についてまとめ、今後の可能性と展望を考えてみましょう。

FramePackを使ったAI動画生成の可能性

FramePackは、AI動画生成の敷居を大きく下げました。従来は高価なGPUが必要だった長時間の動画生成が、一般的なノートPCでも可能になったことで、以下のような可能性が広がっています:

- クリエイターの表現の幅拡大: 専門的な知識や高価な機材がなくても、高品質な動画コンテンツを作成できる

- パーソナライズされたコンテンツ: 個人の好みやニーズに合わせた動画生成が手軽に

- プロトタイピング効率化: 映像制作の初期段階でのコンセプト検証や素材作成の効率化

- 教育・研究への応用: 複雑な概念や現象を視覚的に説明する動画の生成

ControlNetとの組み合わせにより、これらの可能性はさらに拡大し、より精密で目的に合った動画生成が可能になります。

今後の発展と期待される機能

FramePackやAI動画生成技術の今後の発展として、以下のような進化が期待されます:

- より高速・軽量なモデル: 処理速度の向上とVRAM要件の更なる削減

- 高解像度化: より高い解像度での動画生成(4K、8Kなど)

- 音声との統合: 音楽や効果音に合わせた動きの同期

- インタラクティブ制御: リアルタイムでの動画生成プロセス制御

- 3D対応: 3Dモデルや空間を考慮した動画生成

「わくわくするぴょん!この技術がどんどん発展していくんだね!」

そうです!AIによる創作表現はまだ始まったばかりで、FramePackのような革新的な技術によって、より多くの人が自分のビジョンを形にできるようになっています。

参考リンクと資料

さらに学習を深めるための参考リンクです:

- FramePack公式リポジトリ

- ComfyUI_RH_FramePackのリポジトリ

- ComfyUI-FramePackWrapperのリポジトリ

- ComfyUIでControlNetを使う方法

- FramePack論文「Packing Input Frame Context in Next-Frame Prediction Models for Video Generation」

「うさぎでも理解できる記事、ありがとうぴょん!もう動画生成が怖くないぴょん!」

この記事が皆さんのAI動画生成の旅の助けになれば幸いです。ぜひComfyUIとFramePack、そしてControlNetを組み合わせて、あなただけの素晴らしい動画作品を作ってみてください!質問やフィードバックがあれば、コメント欄でお待ちしています。

それでは、楽しいAI動画生成の世界をお楽しみください!

Discussion

本日時点でFramePack用のControlNetは公開されておりません。

本記事が検索で上位にヒットするので、誤った認識が広がらないようにコメントさせていただきますね。