うさぎでもわかるFramepackにControlNet導入する方法と事例

うさぎでもわかるFramepackにControlNet導入する方法と事例

皆さん、こんにちは!今回は、AIによる動画生成技術の最新トレンドである「Framepack」と、画像生成の制御を可能にする「ControlNet」の統合事例についてお話します。ぴょんぴょん!これらの技術を組み合わせることで、低スペックなPCでも高品質で制御可能な動画生成を実現できるようになりました。

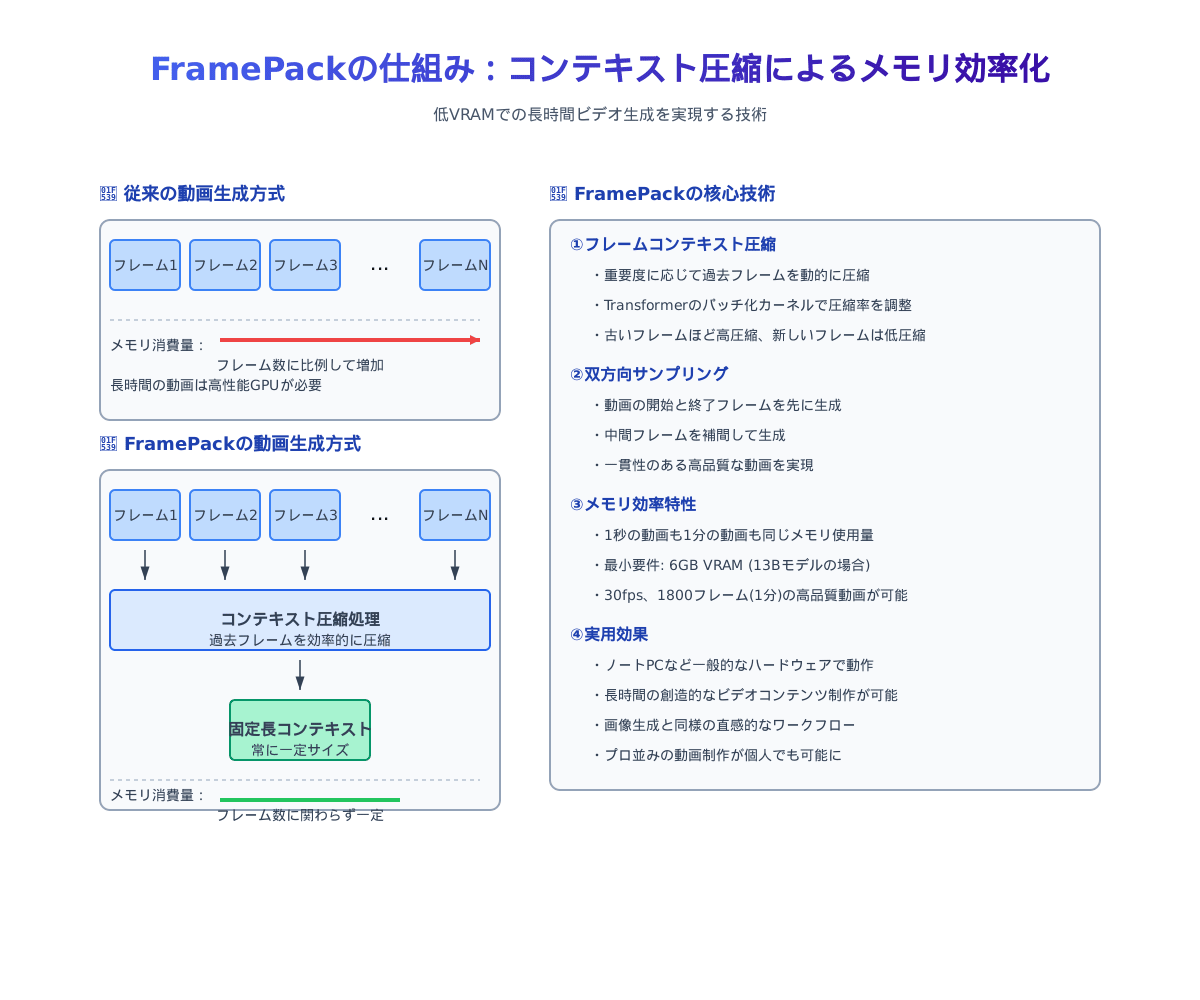

Framepackとは?

Framepackは、Lvmin Zhang氏とManeesh Agrawala氏によって開発された次世代の動画生成技術です。Zhangは以前ControlNetも開発した人物で、AI画像生成の分野で著名な研究者です。

Framepackの最大の特徴は、わずか6GBのVRAMでも、長時間(例えば1分間)のビデオを30fpsで生成できる点にあります。従来の動画生成AIモデルは、フレーム数が増えるほどメモリ消費量が増加し、一般ユーザーのコンピュータでは処理できない問題がありました。

Framepackはこの問題を独自の「コンテキスト圧縮」技術で解決しています。次のフレームを予測する際に、過去のフレーム情報を効率的に圧縮し、常に一定のメモリ使用量で処理を行うことができるのです。

長さに関わらず一定のVRAM使用量 = コンピュータにやさしい

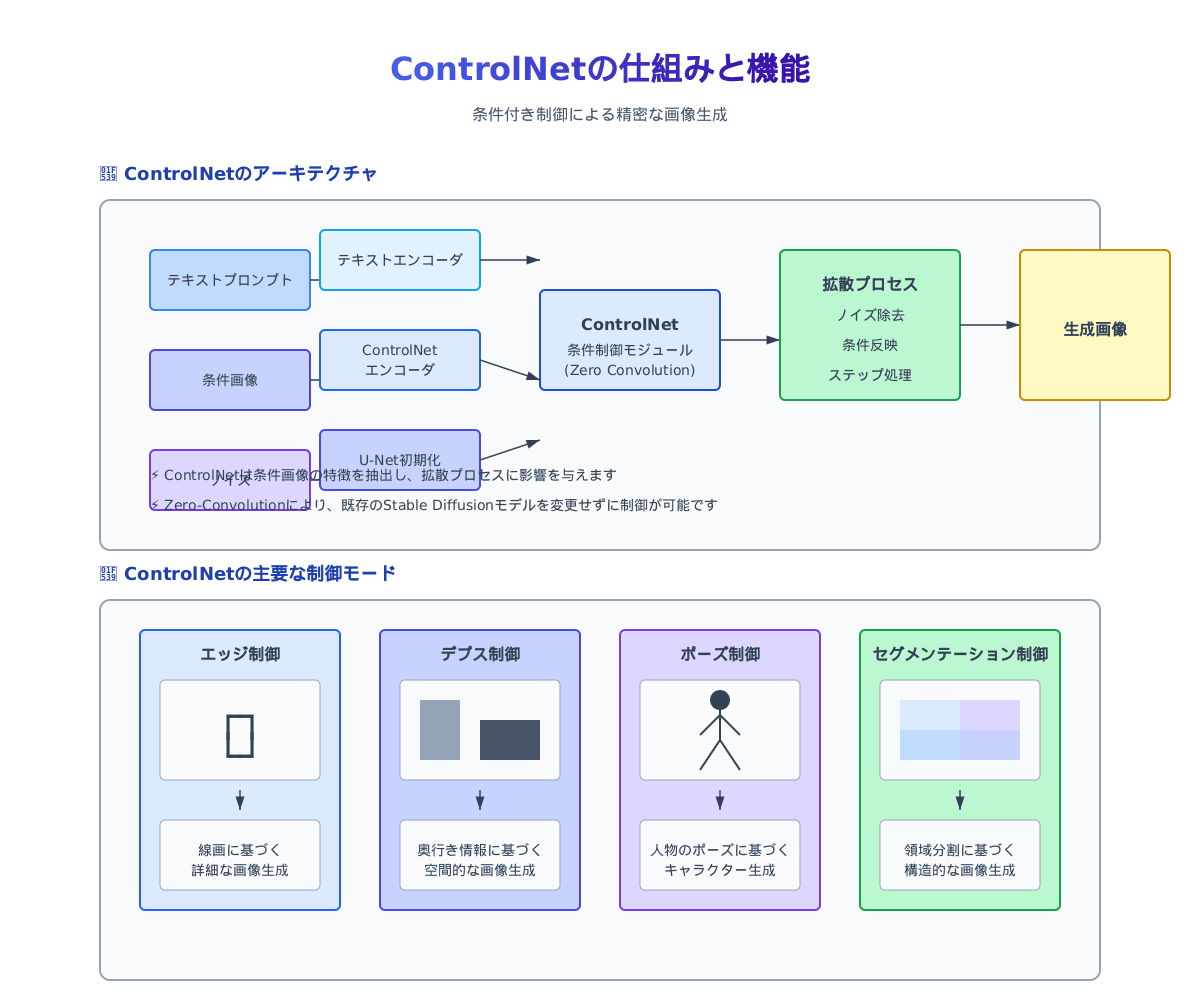

ControlNetの基本理解

ControlNetは、テキストから画像を生成するAIモデル(Stable Diffusionなど)に対して、より詳細な条件付き制御を加える技術です。これもFramepackと同じLvmin Zhang氏によって開発されました。

ControlNetの主な機能は以下の通りです:

- エッジ制御 - 線画から詳細な画像を生成

- 深度制御 - 奥行き情報に基づいた画像生成

- ポーズ制御 - 人物のポーズに基づいた生成

- セグメンテーション制御 - 領域分割に基づいた生成

つまり、ControlNetは「こういう構図で」「このポーズで」「この線画に沿って」といった具体的な条件を画像生成に与えることができるのです。うさぎさんでも自分の思い通りの絵が描けるようになるってことですね!

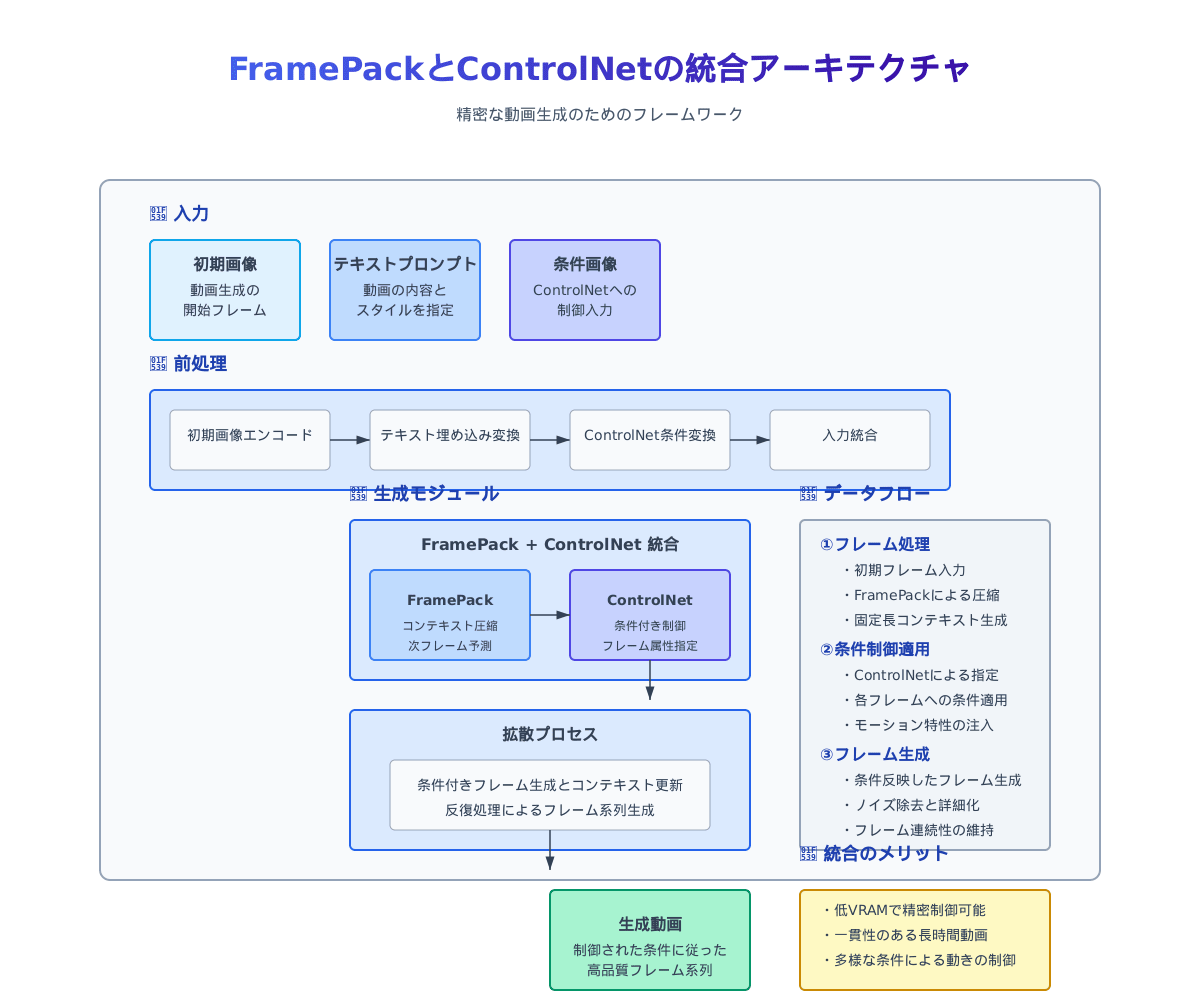

Framepackへの ControlNet導入事例

Framepackは比較的新しい技術(2025年4月公開)のため、ControlNetとの直接的な統合事例はまだ多くありませんが、いくつかの興味深い事例とアプローチが見つかりました。

1. GitHub上での開発議論

Framepackの公式GitHub(lllyasviel/FramePack)では、issue #164において「ControlNetとLoRAのサポートをロードマップに入れてほしい」という要望が出され、多くのユーザーから支持を集めています。この議論から、開発者コミュニティでFramepackとControlNetの統合が強く望まれていることがわかります。

2. CNET-Motion プロジェクトの応用

CNET-MotionはControlNetを動画フレームに適用するプロジェクトで、Stable Diffusionフレームワークに統合されています。このプロジェクトのアプローチは、Framepackと組み合わせることで、メモリ効率の良い動画生成に条件付き制御を追加する可能性を示しています。

3. ComfyUIでの実装例

ComfyUI(Stable DiffusionベースのGUIツール)では、Framepackの実装が複数のカスタムノード作者によって提供されています。これらの実装とComfyUIの既存のControlNetノードを組み合わせることで、Framepackを使った動画生成にControlNetによる制御を加えることが可能になります。

現在、以下の3つのカスタムノード実装が主流となっています:

- Kijaiのバージョン

- HM-RunningHubのバージョン

- TTPlanetPigのバージョン(最初と最後のフレームからの生成に対応)

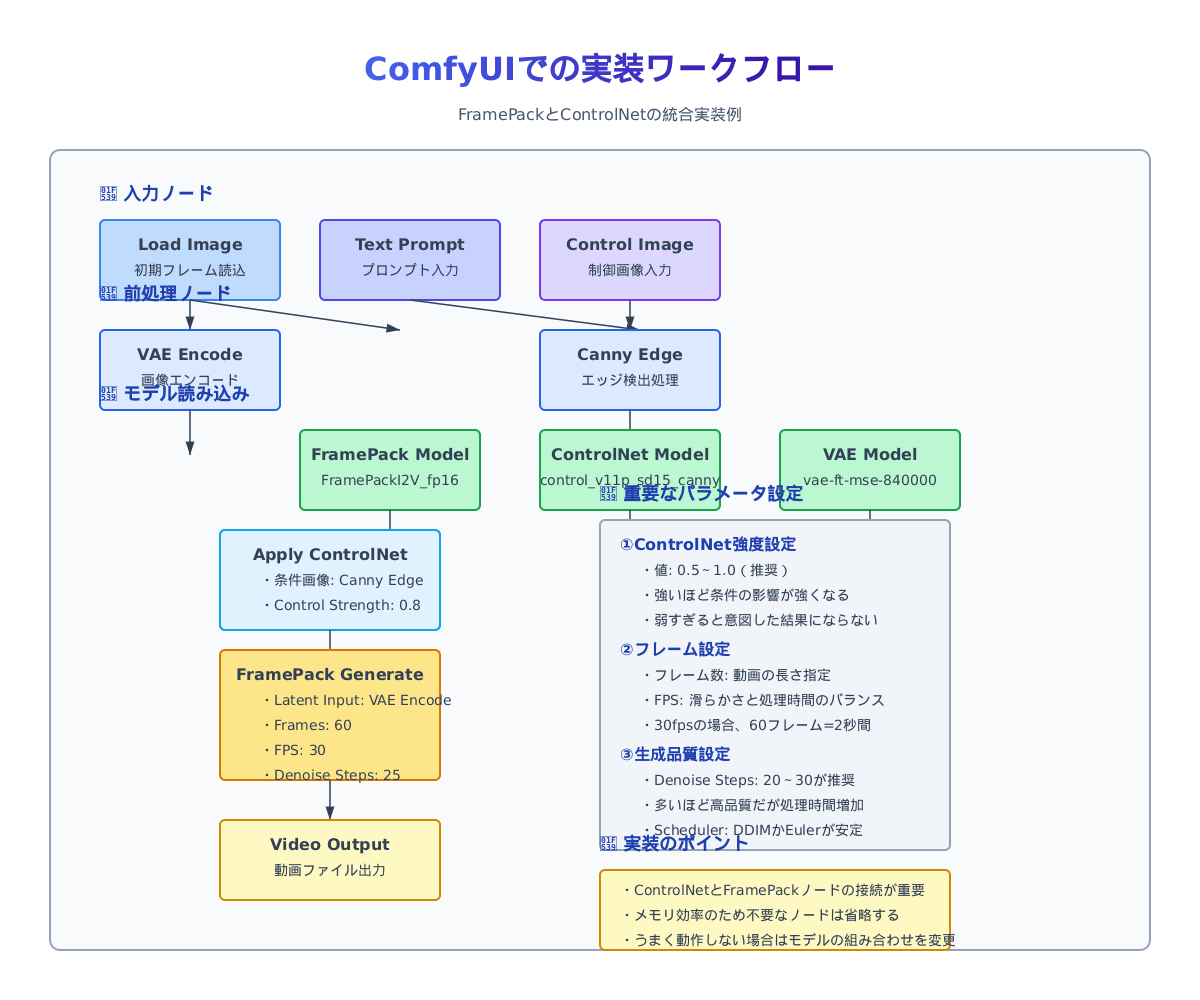

実装チュートリアル:ComfyUIでFramepackとControlNetを統合する

それでは、実際にComfyUIを使ってFramepackとControlNetを統合する方法を見ていきましょう。ぴょんぴょん!

必要なツールとモデル

- ComfyUI - Stable Diffusionベースのビジュアルスクリプティングツール

- Framepackモデル - FramePackI2V FP8またはFP16

- ControlNetモデル - control_v11p_sd15_cannyなど

- VAEモデル - 画像のエンコード・デコードに必要

セットアップ手順

- ComfyUIをインストールする

- コマンドラインから以下を実行してモデルをダウンロード:

# download_models.pyとして保存し実行

import urllib.request

import os

# モデル保存ディレクトリの作成

os.makedirs("ComfyUI/models/diffusers/lllyasviel", exist_ok=True)

os.makedirs("ComfyUI/models/diffusion_models", exist_ok=True)

os.makedirs("ComfyUI/models/vae", exist_ok=True)

# Framepackモデルのダウンロード

urllib.request.urlretrieve("https://huggingface.co/lllyasviel/FramePack/resolve/main/FramePackI2V_fp16.safetensors",

"ComfyUI/models/diffusion_models/FramePackI2V_fp16.safetensors")

# VAEモデルのダウンロード

urllib.request.urlretrieve("https://huggingface.co/stabilityai/sd-vae-ft-mse/resolve/main/vae-ft-mse-840000-ema-pruned.safetensors",

"ComfyUI/models/vae/vae-ft-mse-840000-ema-pruned.safetensors")

# ControlNetモデルのダウンロード

urllib.request.urlretrieve("https://huggingface.co/lllyasviel/ControlNet-v1-1/resolve/main/control_v11p_sd15_canny.pth",

"ComfyUI/models/controlnet/control_v11p_sd15_canny.pth")

- ComfyUIのカスタムノードマネージャーから、FramepackとAdvanced ControlNetの両方をインストール

ワークフロー構築

ComfyUIで以下のようなワークフローを構築します:

- 初期画像の読み込み(Load Image)

- 初期画像にControlNetの前処理を適用(例:Canny Edge Detection)

- Framepackモデルのロード

- ControlNetモデルのロード

- FramepackとControlNetの接続

- 動画生成の実行

パラメータ調整のポイント

- ControlNet強度(Control Strength): 値が大きいほど条件の影響が強くなります(0.5〜1.0が推奨)

- フレーム数(Number of Frames): 生成する動画の長さ

- FPS設定: フレームレート(通常は24〜30)

- デノイズステップ(Denoise Steps): 値が大きいほど品質が向上しますが、生成時間も増加(20〜30が推奨)

事例分析:動きのコントロール

Framepackに対するControlNetの最も効果的な適用例の一つが「動きのコントロール」です。ここでは、その実装方法と成功事例を見ていきましょう。

動きパターンのコントロール実装

動きをコントロールするには、以下のようなアプローチがあります:

-

参照動画からの動き抽出

- 参照動画からオプティカルフローを計算

- 抽出した動きパターンをControlNetの入力として使用

-

ポーズ系列の適用

- 人物の動きを制御するために、ポーズ推定からのキーフレームを使用

- フレームごとに異なるポーズ情報をControlNetに与える

一貫したスタイル維持の手法

動画生成において重要なのは、フレーム間の一貫性です。これを実現するための手法として:

-

条件の一貫性

- 全フレームに同じテキストプロンプトを使用

- ControlNetの強度を一定に保つ

-

FramepackのScheduling機能

- 最初のフレームに対して強いウェイトを設定

- 一貫したスタイル特性を維持

実際のプロジェクト例:Wan2.1 Fun ControlNet

Wan2.1 Fun ControlNetプロジェクトでは、参照動画から動きを抽出し、それを新しい動画生成に適用する手法が実装されています。これをFramepackと組み合わせることで、低リソースでも高品質な動き制御が可能になります。

このプロジェクトの特徴:

- インスタグラムやTikTokのダンス動画などからモーションキューを抽出

- 抽出した動きをAI生成コンテンツに模倣させる

- インペイント機能による既存ビデオフレームの詳細な修正

フレームパック+ControlNetの応用可能性

FramepackにControlNetを導入することで、どのような応用が可能になるのでしょうか?

クリエイティブ産業への影響

-

映像制作の民主化

- 高価なハードウェアなしで高品質な動画制作が可能に

- 中小規模の制作会社やフリーランスにとって大きなメリット

-

広告・マーケティングでの活用

- 商品紹介動画の迅速な生成

- ブランドスタイルの一貫性維持が容易に

-

アニメーション制作の効率化

- 中割り作業の自動化

- コンセプトから完成動画への迅速な変換

個人制作からビジネス活用まで

-

個人クリエイター

- SNS用コンテンツの生成

- ポートフォリオ作成の効率化

-

教育コンテンツ

- 複雑な概念を視覚的に説明する動画の生成

- 学習者向けのパーソナライズされた教材作成

-

ビジネス活用

- プレゼンテーション資料の動画化

- 製品デモンストレーション動画の自動生成

将来の発展方向性

-

リアルタイム処理への展開

- さらなる最適化によるリアルタイム動画生成

- ライブストリーミングにおけるリアルタイム効果

-

3Dコンテンツへの拡張

- 2D動画から3Dシーンの生成

- VR/ARコンテンツ制作への応用

-

インタラクティブコンテンツの生成

- ユーザー入力に応じた動的コンテンツ生成

- ゲームや教育アプリケーションでの活用

あらー、うさぎさんでも動画が作れるようになるなんて夢のような時代ですね!

まとめ

FramepackとControlNetの統合は、AIによる動画生成の世界に革命をもたらす可能性を秘めています。低スペックPCでも長時間の高品質動画生成が可能になり、さらにその動きや表現を詳細にコントロールできるようになるのです。

技術統合がもたらす革新性

- アクセシビリティの向上 - 高性能PCを持たないクリエイターも高品質な動画生成が可能に

- 制作の効率化 - 従来は数日かかっていた作業が数時間で完了

- 創造性の拡大 - 技術的制約が少なくなることで、より自由な表現が可能に

今後の研究と開発の展望

Framepackの開発者はすでにControlNetとLoRAの統合をロードマップに検討しており、近い将来、より直接的で使いやすい統合が実現すると期待されています。また、CNET-Motionのようなプロジェクトの発展により、動画フレームへのControlNet適用がさらに洗練されるでしょう。

コミュニティへの参加と貢献方法

これらの技術の発展には、コミュニティの貢献が不可欠です。以下の方法で参加できます:

- Framepackの公式GitHubリポジトリでの議論や問題報告

- ComfyUIのカスタムノード開発と共有

- 独自のワークフローや成功事例の共有

ぴょんぴょん!みなさんもぜひこの革新的な技術を試してみてください。低スペックPCでも驚くほど美しい動画が作れるようになりますよ!

Discussion