概要

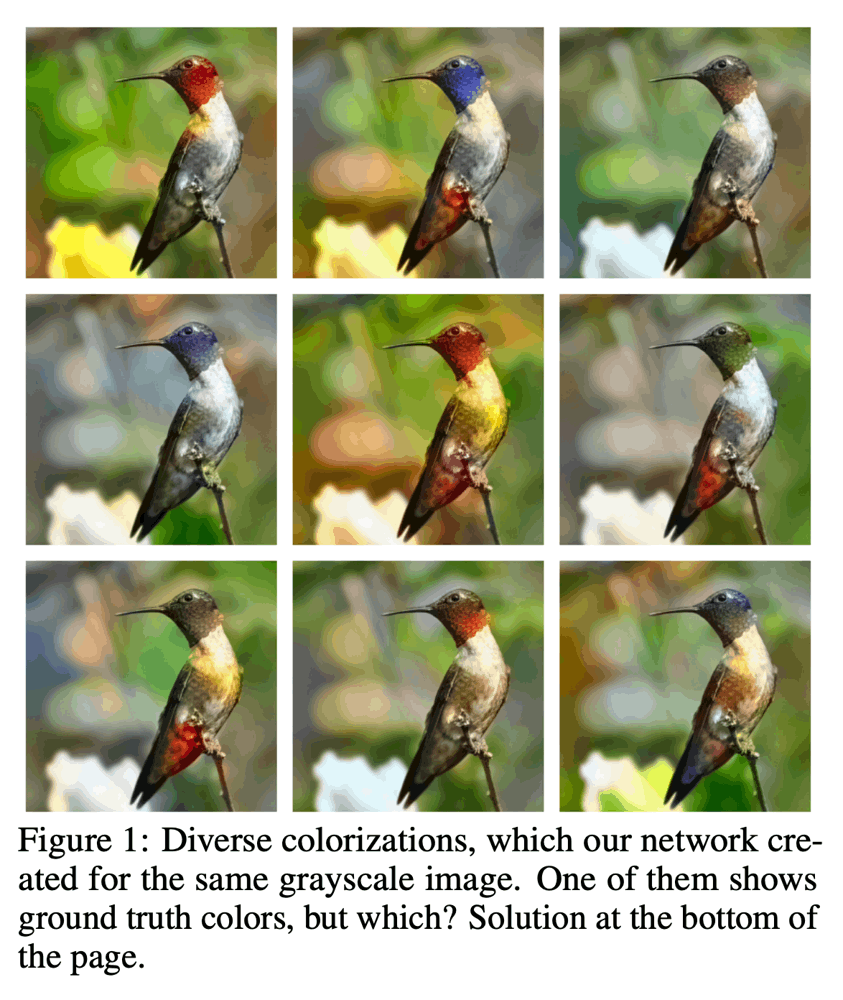

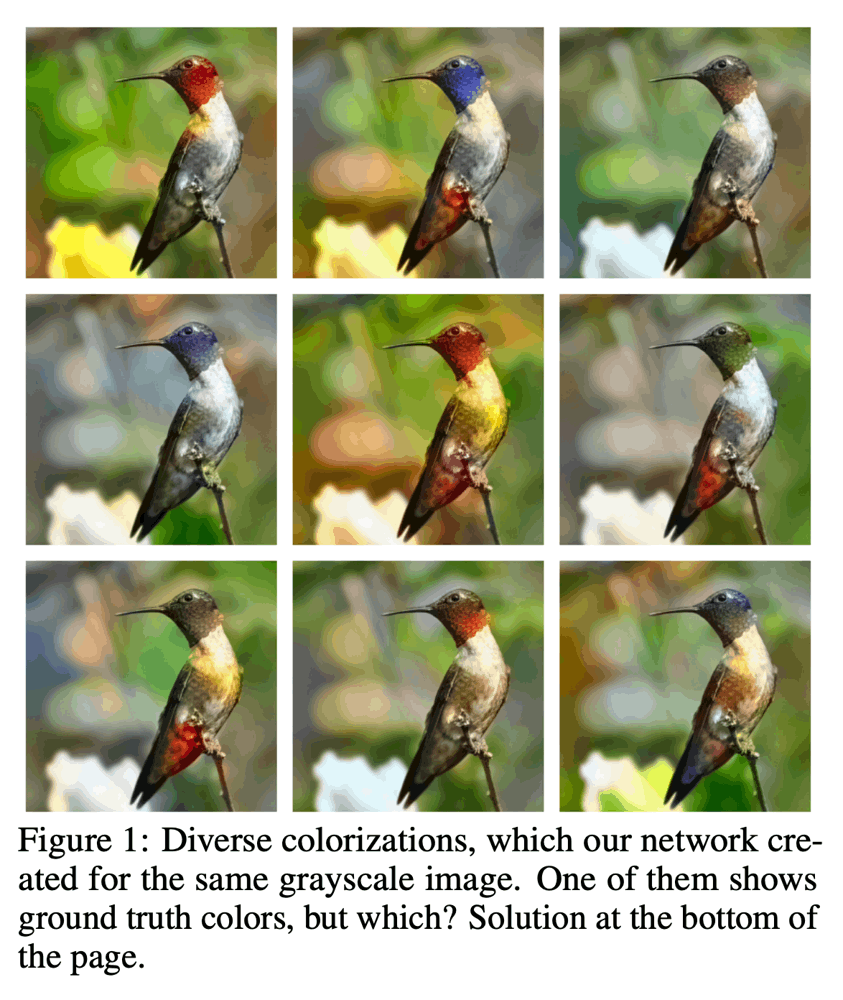

双方向の可逆な関数を表すInvertible Neural Network(INN)を条件付きにするConditional INN(cINN)を提案。以下は、本手法をColorizationに適用した例で、Conditionとしてモノクロ画像を使用し、さまざまなありそうな色合いの画像を生成している。

書誌情報

- Ardizzone, Lynton, et al. "Guided image generation with conditional invertible neural networks." arXiv preprint arXiv:1907.02392 (2019).

- https://arxiv.org/abs/1907.02392

ポイント

affine coupling blockの基礎

INNの代表格であるaffine coupling blockでは、入力をチャネル方向に分割し、分割された出力を算出する順方向の計算を以下のように行う。

v1=u1⊙exp(s1(u2))+t1(u2)v2=u2⊙exp(s2(v1))+t2(v1)

同じs1,s2,t1,t2を用いて、逆方向の計算は以下のように行える。逆関数が、複雑な計算なしに行えることがポイントである。

u2=(v2−t2(v1))⊘exp(s2(v1))u1=(v1−t1(u2))⊘exp(s1(u2)).

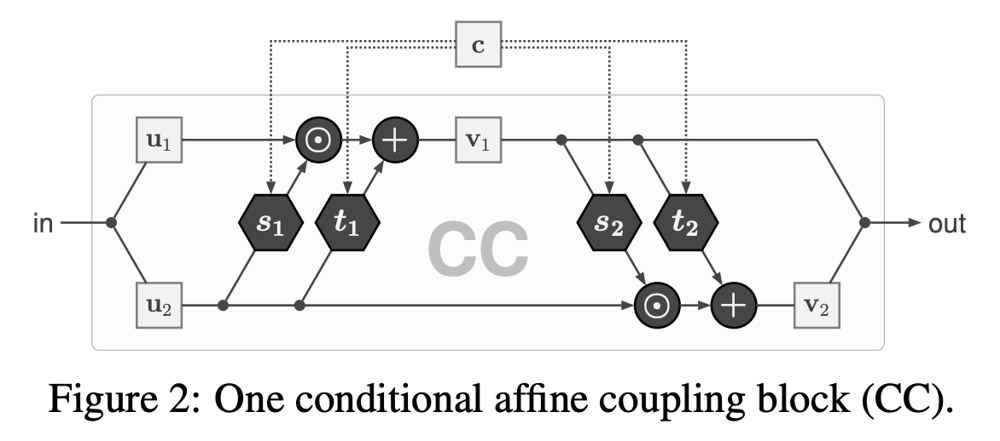

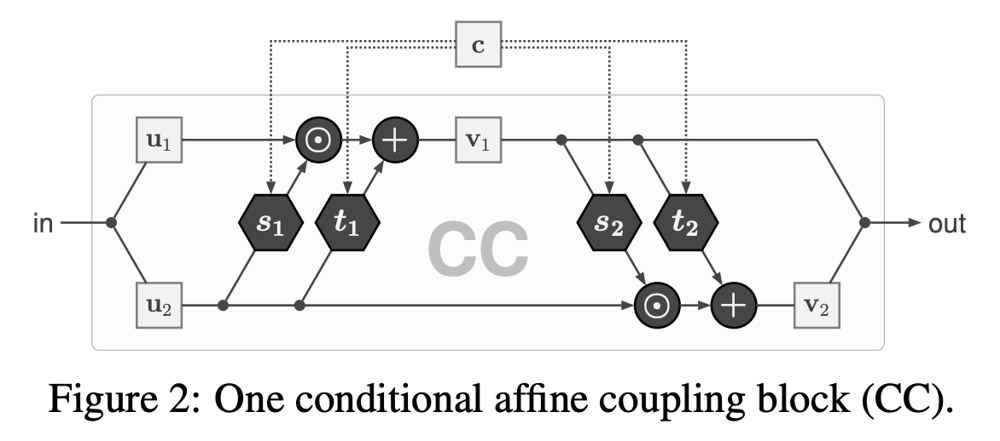

conditional affine coupling block

affine coupling blockをf(x;θ)で表すとき、特定の条件に応じて変化するConditional Affine Coupling Block(CC)を関数f(x;c,θ)で表す。CCでは、s,tを条件付きの関数にすることでこれを実現する。例えば、s1(u2)をs1(u2,c)に置き換える。CCは以下のような構造になる。

fの逆関数gは、以下のようになる。条件cは順方向でも逆方向でも同じように使用される。

f−1(⋅;c,θ)=g(⋅;c,θ)

最尤損失によるcINNの訓練

cINNは、最尤損失を用いて簡単に訓練できることを示す。

pZ(z)を潜在空間Zにおける確率密度分布とする。θをパラメータ、cを条件とする関数f(x;c,θ)を考える。この関数は全単射であり、以下のような変数変換が成り立つ。

pX(x;c,θ)=pZ(f(x;c,θ))det(∂x∂f)

∂x∂fはヤコビアンであり、そのサンプルxiにおける行列式をJi≡det(∂f/∂x∣xi)とする。

ベイズの定理により、p(θ;x,c)∝pX(x;c,θ)⋅pθ(θ)が成り立つ。そのため、事後確率p(θ;x,c)を最大化したい時の損失関数は、以下のようになる。

L=Ei[−log(pX(xi;ci,θ))]−log(pθ(θ))

ここで、pX(x;c,θ)を先の式の右辺で置き換えると、以下のように書ける。

L=Ei[−log(pZ(f(x;c,θ))−log∣Ji∣]−log(pθ(θ))

通常、pZ(z)は標準ガウス分布を考え、pθ(θ)にもガウス分布が事前分布として与えられる。1/2σθ2≡τとして、以下のように全体を書き直せる。

L=Ei[2∥f(xi;ci,θ)∥22−log∣Ji∣]+τ∥θ∥22

この式は、第1項は最大尤度損失で、第2項はL2正則化である。つまり、一般的に知られる通り、事後確率最大化は、正則化項付きの最尤法とも言える。

このような損失関数によって訓練されたネットワークのパラメータθ^MLがあれば、z∼pZ(z)と、あるcを用いて、条件付きの逆関数g:xgen =g(z;c,θ^ML)が得られる。

Conditioning Network

条件付き画像生成モデルでは、条件がone-hotベクトルのような単純な形になることもあるが、画像が条件となることもある。その場合は、分類タスクなどで学習されたネットワークhを用いて、c~=h(c)をcINNへの入力とする。

その他の工夫

-

xへのノイズ追加とデータ拡張が必要。特に、MNISTのような画像中の大部分がフラットな領域の場合はスパースな勾配になることが多いため。

-

scaleを担当するsに、以下のような非線形関数を追加する。これによって、∣s∣≪αのときsclamp ≈sになり、∣s∣≫αのときsclamp ≈±αになるため、expαが爆発するのを防ぐ。

sclamp =π2αarctan(αs)

- Xavier Initializationで初期化することで、訓練が安定することを確認した。

- チャネル間の情報を交換するためのランダムに作られた直行行列を適用する。この行列は、訓練対象ではなく、一度作成したら固定する。これにより、u1,u2の間の情報交換を効率的に行える。

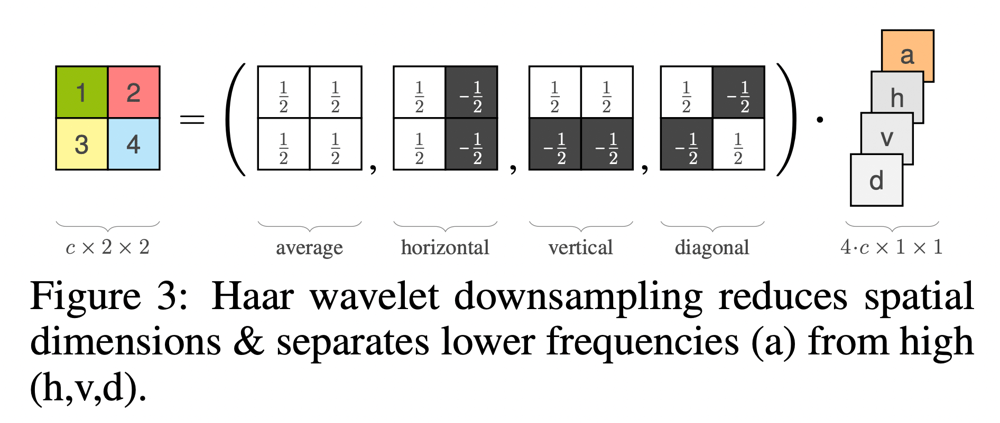

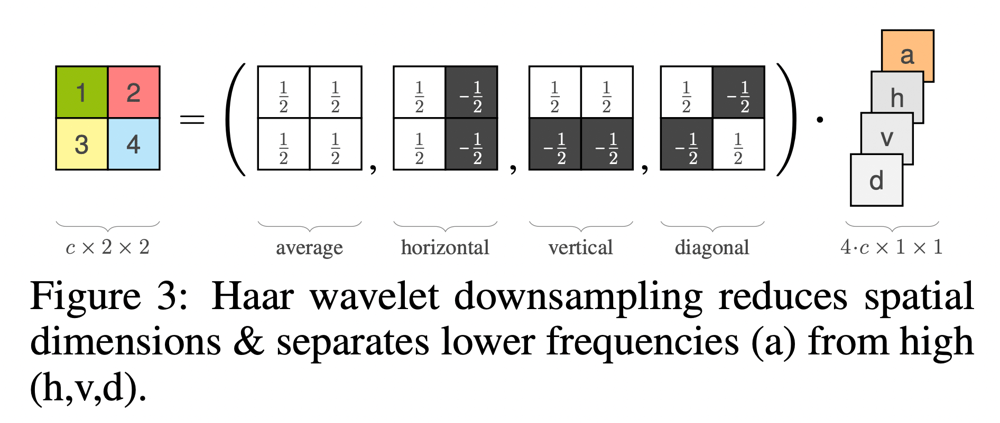

- 以下のようなHaar waveletパターンを用いて、効率的に可逆なサイズ縮小を行う。Real NVPではチェッカーボードパターンを用いてこれをおこなっていたが、Haar waveletパターンを用いることで、average poolingと3方向への勾配情報も抽出しつつ、可逆性も確保することができる。

実験

省略

Discussion