脳波EEG基盤モデルのグラフ拡張に関する研究

はじめに

こんにちは。東京大学鈴村研究室のLiminです。

本日は、私が鈴村研究室で取り組んだ、「脳波EEG基盤モデルのグラフ拡張」に関する研究について紹介させていただきます。

本研究は、 AAAI 2025 Workshop GenAI4Health にてポスター発表を行いました。また、 IEEE EMBC 2025 にて発表を行う予定です。

背景

まず、本研究の背景知識について説明します。ここでは、EEG(脳波)と、基盤モデルについて説明させていただきます。

EEGとは

EEG (Electroencephalography) とは、脳波とも呼ばれ、脳の活動を計測する手法の一つです。

頭皮の複数の決められたチャネル位置に電極を置くことで、脳波の信号を測定します。

脳波を計測することで、脳の状態や脳の活動を理解することができます。具体的には、次のようなことが可能になります。

- 脳の疾患を早期発見する

- 睡眠の質を調べる

- 考えや意図を汲み取ることでロボットやコンピュータを動かす技術 (BCI) を作ることに役立つ

このように、脳波の解析は非常に重要な分野であり、近年では機械学習を使って脳波を解析する研究が盛んになってきています。

基盤モデルとは

近年、自然言語処理や画像処理などの分野において、基盤モデルが提案されてきました。

基盤モデルとは、「多くのデータを使って事前学習し、幅広い下流タスクに高い性能で応用できるよう訓練されたモデル」のことを表します。

EEGには、先ほど挙げたような応用につながる下記のタスクをはじめとして、多岐にわたる応用タスクがあります。

- 脳の疾患を検知する

- 睡眠の質を調べる

- コンピュータ等を動かすために考えや意図を汲み取る

このように、EEGにはさまざまな下流タスクがあるため、基盤モデルを導入することによって、EEGの研究がより一層加速され、大きなメリットをもたらすと言えます。

本研究の目的と貢献

本研究では、EEGの基盤モデルの研究を行います。

具体的には、「EEGの時系列情報に加えて、チャネル間の相互関係、つまり空間的な情報も扱える基盤モデル」を提案します。

手法として、「時系列情報を学習するmask auto-encoderと、チャネル間の関係性を学習するGNNを組み合わせたアーキテクチャ」を提案します。

詳細についてはまた後ほど説明します。

関連研究

ここで、関連研究について説明します。

EEGの基盤モデル

EEGの基盤モデルはこれまでも提案されてきましたが、NLPで高性能を発揮したTransformerの技術をEEGにも応用していたものが多いです。

一例として、BENDR[1] が挙げられます。

これは、masked auto-encoderの手法を採用しています。アーキテクチャを次の図に示します。

- 複数層の畳み込み層(ここでは「BENDR Encoder」と呼びます)で、複数チャネルのEEG生データを処理し、特徴量にエンコードします。

- 畳み込まれた特徴量のうちの一部分をマスクしたのち、続くTransformerエンコーダで、マスクされた特徴量を復元します。

この学習を通して、BENDRはEEGの学習を行い、基盤モデルとなります。

ただし、BENDRをはじめとする既存のEEG基盤モデルにも限界があります。

これらのモデルでは、主に時系列情報を学習することには長けていますが、チャネル間の相互関係性に関しては学習できていません。

グラフベースのEEGモデル

チャネル間の関係性は、以下の図のようなものですが、これはとても貴重な情報です。

例えば、疾患による脳の影響が、EEGのチャネル間の関係性、すなわち空間的なパターンに現れることがあります。

そのため、チャネル間の関係性が疾患の判定に役立つ重要な手がかりとなります。

チャネル間の関係性を学習できることには大きな意義があります。

実際、この点に着目して、チャネル間の関係性を学習することを目的としたモデルが提案されています。

これらの手法では、各チャネルをノードとみなし、EEGのデータをグラフとして扱います。

一例として、EEG-GCNN[2] があります。

このモデルでは、グラフニューラルネットワーク(Graph Neural Network, GNN)を用いて、チャネル間の接続性を学習しています。

ただ、このようなグラフベースのモデルの既存手法では、幅広い下流タスクに応用することを目的には設計されていません。すなわち、基盤モデルではありません。

また、最先端のTransformerを使ってはおらず、時系列情報の学習性能に改善の余地があります。

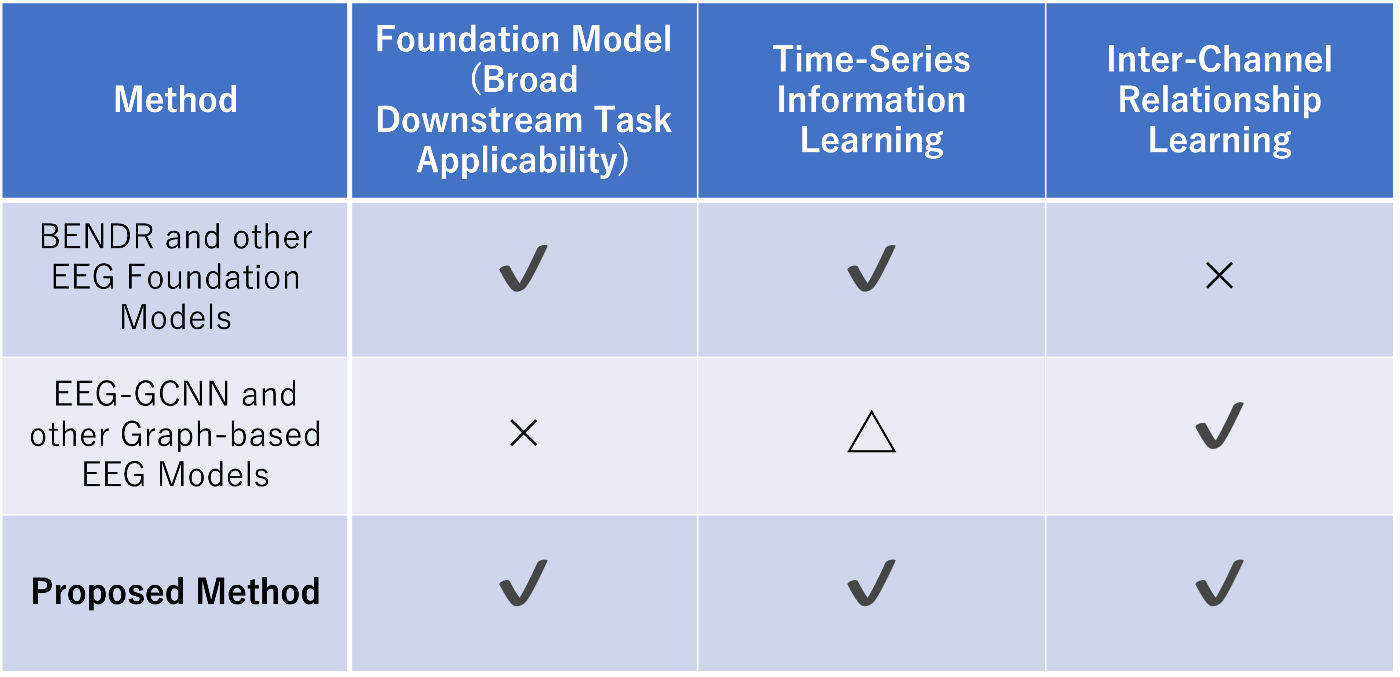

既存研究と提案手法との違い

本研究では、先ほどまでに挙げた課題の解決を目指します。これをまとめると、次の図のようになります。

提案手法

本研究では、EEGデータの分類タスクに適用可能な基盤モデルの構築に取り組みます。

特に、「EEGの時系列情報に加え、チャネル間の相互関係 (= 空間的な情報) も扱える基盤モデル」を提案します。

私たちは既存のEEG基盤モデルを、EEGのチャネル間の関係性をも学習できるように拡張しました。

ここでは、単純ではありますが効果的な手法として、BENDRをもとに、GNNを挿入する手法を提案します。

具体的には、生のEEGデータを「BENDR Encoder」に入れる前の位置にGNNを挿入します。

(これは、実装上の都合によるためですが、今後の課題としては別のGNNの挿入方法も考えています。)

よって全体としては、

- 時系列情報を学習するための、mask auto-encoder

- チャネル間の関係性を学習するための、 graph neural network (GNN)

を組み合わせることによって実現しました。

提案手法のアーキテクチャの図は以下の通りです。

ですので、学習の流れとしては、次のようになっています。

- GNNがチャネル間の関係性を学習する

- BENDR Encoderが特徴量へエンコードする

- Transformerエンコーダがマスクとその復元のタスクを通して時系列情報を学習する

評価

実験設定

本研究では、次のような実験設定で行いました。

GNNアーキテクチャ

提案手法で述べた、挿入するGNNですが、ここにはさまざまなアーキテクチャのGNNが入り得ます。そしてそれらのアーキテクチャによって性能に差が出ることが考えられます。

ここでは比較として、 GraphSAGE[3]、GCN[4]、GAT[5] の3つのアーキテクチャを採用し、実験評価を行いました。

なお、基盤モデルであることから、事前学習をしてから下流タスクへファインチューニングを行いますが、ファインチューニングでは事前学習済みのモジュールを再利用するため、事前学習とファインチューニングを通して同一のアーキテクチャが使用されることにご注意ください。

ベースライン

比較のベースラインとしては、既存研究のBENDRを使用しました。

データセット

BENDRに倣って、以下のデータセットを使用しました。

結果

実験評価の結果として、事前学習した後ファインチューニングを行った、各データセットに対する性能をまとめたものが次の表になります。

この表から、GCNが全タスクでベースラインを上回っていたことから、基盤モデルとしてGCNが最も良いということが言えます。

また、GraphSAGEとGATも、3タスク中2つにおいてはベースラインを上回っていたことから、基盤モデルとしてのポテンシャルを秘めていると言えます。

よって、GNNを挿入するという本提案は、EEGの基盤モデルとしての性能を向上させるのに有効である、といえます。

GNNアーキテクチャによる違いの詳細な分析や、より多くのデータセットで実験評価を行うことは、今後の課題です。

まとめ

本研究の主な貢献は、以下のとおりになります。

- EEG解析において、EEGの時系列情報と空間的情報の双方を学習できる基盤モデルを提案した

- 時系列情報を学習するためのmask auto-encoderと、チャネル間の空間的情報を学習するためのGNNを組み合わせた

- 3つの下流タスクと、さまざまな条件設定による実験評価を通して、提案手法の有効性を示した

今後の課題としては、次のことを考えています。

- 事前学習にて、フルのTUEGデータセットを使用して学習を行う

- より最先端な自己教師あり学習の手法に対してGNNアーキテクチャを組み合わせる手法を試す

- GNNの他の挿入方法を提案する

- GNNの有効性についてより詳細に解析する

おわりに

「グラフ拡張EEG基盤モデル」に関する研究について、ご紹介させていただきました。

より詳細が知りたい方は、論文をご参照ください。

Limin Wang, Toyotaro Suzumura, and Hiroki Kanezashi. "GEFM: Graph-Enhanced EEG Foundation Model." IEEE EMBC 2025.

お読みいただきありがとうございました。

-

Kostas, Demetres, Stephane Aroca-Ouellette, and Frank Rudzicz. "BENDR: Using transformers and a contrastive self-supervised learning task to learn from massive amounts of EEG data." Frontiers in Human Neuroscience 15 (2021): 653659. ↩︎

-

Wagh, Neeraj, and Yogatheesan Varatharajah. "Eeg-gcnn: Augmenting electroencephalogram-based neurological disease diagnosis using a domain-guided graph convolutional neural network." Machine Learning for Health. PMLR, 2020. ↩︎

-

Hamilton, Will, Zhitao Ying, and Jure Leskovec. "Inductive representation learning on large graphs." Advances in neural information processing systems 30 (2017). ↩︎

-

Kipf, Thomas N., and Max Welling. "Semi-supervised classification with graph convolutional networks." arXiv preprint arXiv:1609.02907 (2016). ↩︎

-

Veličković, Petar, et al. "Graph attention networks." arXiv preprint arXiv:1710.10903 (2017). ↩︎

Discussion