Clineを会社で試験導入するための調査

経緯

会社でAIエージェントツール(Cline)を導入したく、稟議書の叩きのようなものを作成したい

そのためにClineの調査した内容とここにまとめる

概要

公式のGitHubから

VSCode拡張機能のAI開発アシスタントツール

タスクを与えることで、ファイルの作成・編集やコマンドの実行まで自動でやってくれる

色々なモデルを選択できる

- OpenRouter

- Anthropic

- OpenAI

- Google Gemini

- AWS Bedrock

- Azure、GCP Vertex など

コスト

本体は無料

ただし利用するAIモデルの API によって従量課金が発生する

今回利用するAIモデルのAPI Claude 3.7 Sonnet を想定

- ClaudeのAPIは、入力と出力のトークン数にもとづいて料金が発生

- $3 / 100万入力トークン

- $15 / 100万出力トークン

トークンとは

トークンがよくわからなかったので調査

トークン

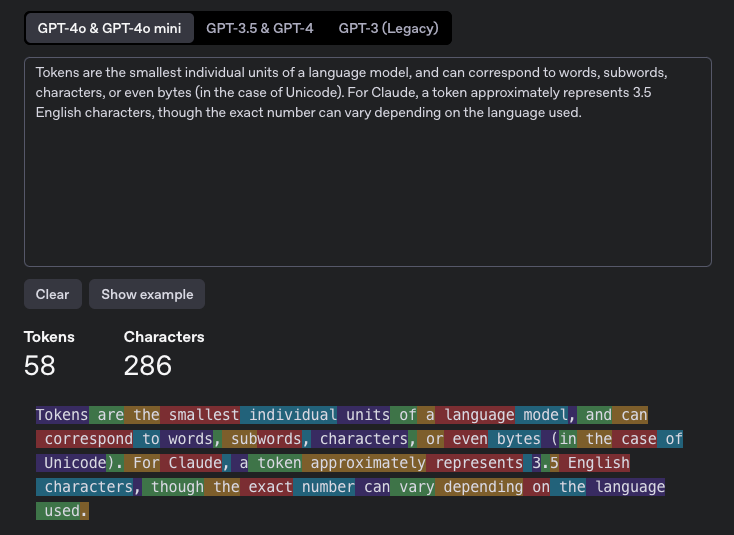

トークンは言語モデルの最小単位であり、単語、サブワード、文字、さらにはバイト(Unicodeの場合)に対応します。Claudeの場合、トークンは約3.5文字の英語を表しますが、正確な数は使用する言語によって異なります。

(Google翻訳)参考:https://docs.anthropic.com/en/docs/resources/glossary#tokens

Q:日本語の場合、トークン数はどうなるのか?

A:日本語の方が英語と比べてトークン数が多くなるよう

OpenAIが提供するTokenizerがあり、日本語と英語でトークン数を比較したところ文字数に対して英語の方がトークン数が少ないことがわかった

日本語の場合:

英語の場合:

Tokenizer:https://platform.openai.com/tokenizer

セキュリティ

データがモデルの学習に使われないか調査

基本的には顧客側が承諾しない限りデータはモデル学習には使われないよう

以下、モデルの学習に関するAnthropic社のポリシー

以下の場合を除き、当社は、お客様の入力または出力をモデルのトレーニングに使用しません。(1) お客様の会話が Trust & Safety レビューの対象としてフラグ付けされている場合 (その場合、当社は、 Anthropic の安全ミッションに従い、Trust and Safety チームが使用するトレーニング モデルなど、使用ポリシーを検出して適用する能力を向上させるために、会話を使用または分析することがあります)、(2) お客様が明示的に資料を当社に報告した場合 (たとえば、当社のフィードバック メカニズムを介して)、(3) お客様がトレーニング目的での入力および出力の使用を明示的にオプトインした場合。

(Google翻訳)