👨💻

ローカル LLM を使用して AI コーディングを試してみた

概要

Windows 11 (WSL2) 上で LM Studio を使用し、Visual Studio Code と Cline を連携させて AI コーディングを試してみました。

環境

- Windows 11 Pro (WSL2)

- Visual Studio Code 1.102.0

- Cline 3.18.14

- LM Studio 0.3.18

- mistralai/devstral-small-2507

前提

- LM Studio がインストールされていること

- Visual Studio Code がインストールされていること

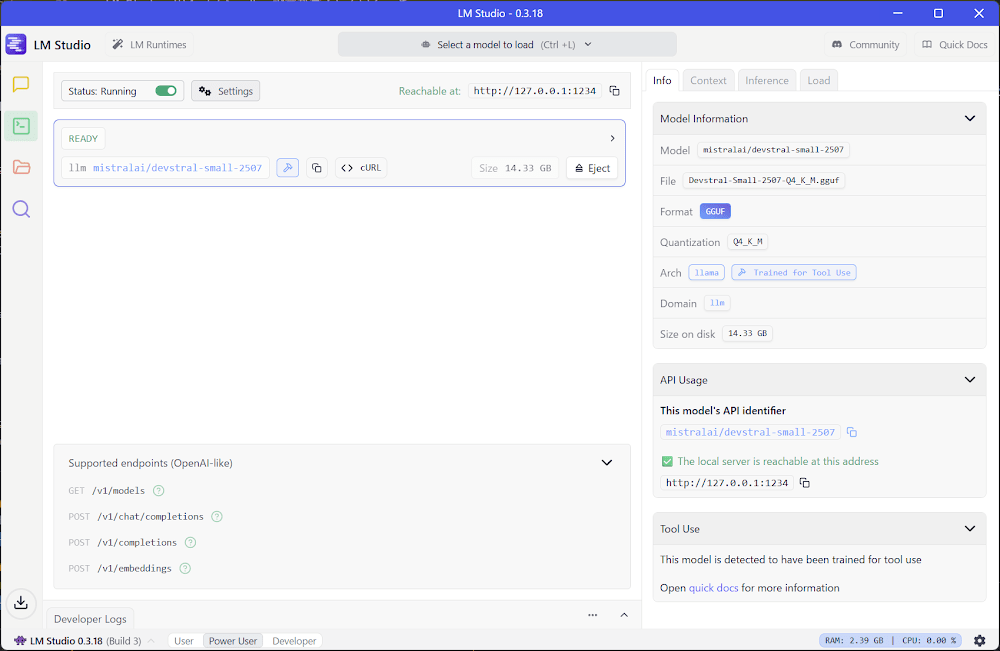

LM Studio の設定

-

Discover を開いて使用するモデルをダウンロードします。今回は mistralai/devstral-small-2507 を使用します。

-

Developer の

Select a model to loadから使用するモデルを選択します。 -

トグルボタンを ON にしてサーバーを起動し、Status が

Runningになったことを確認します。

VSCode の設定

-

Cline をインストールします。

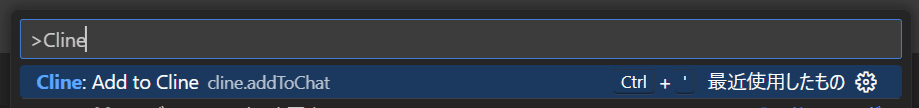

-

コマンドパレットから

Cline: Add to Clineを選択し、Cline を開きます。 -

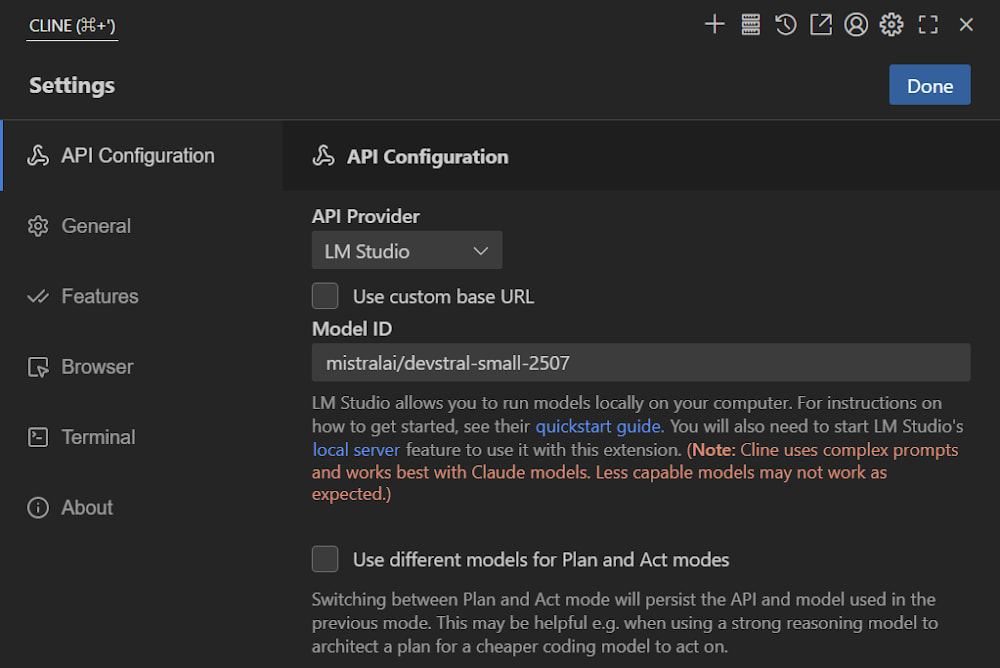

Cline の設定画面を開き、次の設定を行い

Doneをクリックして保存します。- API Configuration

- API Provider:

LM Studioを選択 - Model ID: 使用するモデルを選択

- API Provider:

- API Configuration

動作確認

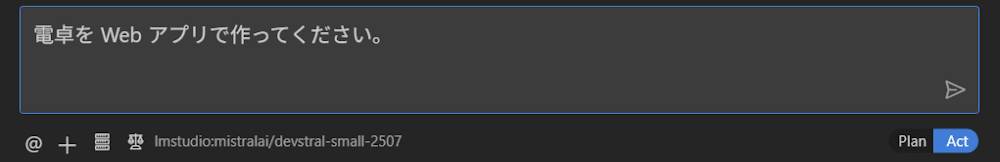

-

Cline に電卓アプリの実装を指示します。

-

次のファイルが作成されます。

- calculator

- index.html

- README.md

- script.js

- styles.css

- calculator

-

ブラウザで

index.htmlを開いて電卓アプリを動かしてみます。

試してみた感想

ローカル LLM を使用することで、料金を気にせずに好きなモデルを選択し、ローカル環境で完結する開発が可能である点が非常に魅力的でした。

特に、ローカル環境で完結することでセキュリティを高めながら効率的に作業を進められるのは大きな利点と感じました。

Discussion