AI初心者がDeepSeekの論文を読んで感動した話(解説付き)

はじめに

こんにちは! 最近AIに興味を持ち始めたばかりの超初心者です。

「DeepSeek-R1」についての解説記事を読んでみたのですが、専門用語や数学的な説明が多く、最初はなかなか理解できませんでした。

それならいっそ論文を直接読んでみよう! と思い立ち、DeepSeek-R1 の論文に挑戦することにしました。

実際に読んでみると、思っていたほど難しくなく、専門用語や数学的な要素も少なかったので、初心者の私でも意外と読みやすいことに驚きました。

最初は DeepSeek-R1 がなぜ話題になっているのか知りたくて読み始めたのですが、読み進めるうちに AI の基本的な仕組みや、これまでの技術の進化についても学ぶことができ、AI の世界の面白さと未来の可能性を強く感じるようになりました。

その楽しさやワクワク感をもっと多くの人に伝えたいと思い、この記事を書くことにしました。

この記事では、私のような超初心者でも楽しみながら理解できるように、数学の難しい式は使わず、できるだけわかりやすい言葉で説明していきます。

もし内容に誤りや不足があれば、ぜひ気軽にご指摘ください!

本記事の内容概要

前提知識が少なくても読み進められるように、以下の構成で進めていきたいと思います。

-

AIモデルの進化

AlphaGoやChatGPTを事例に挙げながら、AIモデル関連の背景知識を紹介します。 -

DeepSeek-R1論文の核心部分

DeepSeek-R1-Zeroを中心に、訓練手法やその過程での気づきなどを紹介します。 -

論文を読んだ感想

初心者として論文を読んでみて感動したことを話します。

AlphaGoの衝撃

AIが初めて人間を超えた日

2016年3月15日、Google DeepMindが開発した囲碁AI「AlphaGo」が、世界トップ棋士、李世乭(イ・セドル)に4勝1敗で勝利し、世界中に大きな衝撃を与えました。

しかし、AIがゲームで人類に勝ったのは初めてではありません。

1997年、IBM が開発したチェスAIの「Deep Blue」は当時の世界チャンピオンに破ったことで、大きな話題となったが、それほどの影響力とは言えないでしょう。

その一方、20年後のAlphaGoの勝利は、 AIが初めて人間の知性を超えたと言われています。

なぜAlphaGoの方が衝撃的だったかと言うと、それは、囲碁はチェスと比べ、「無限に近い選択肢」があるゲームで、コンピュータが人間を超えるなんて「100年も先の話だろう」と思われていました。

チェスでは、1手の平均分岐数は約35で、勝負がつくまで、平均的な局面は約

Deep Blueが人間に勝てたのは、その場で可能な手を計算し尽くす 「力まかせ探索」だけです。

つまり、Deep Blueが人間より優れたのは、スーパーコンピューターならではの計算力です。

ところが囲碁の場合、1手の選択肢が平均250通り(チェスの7倍)、ゲームの長さも2倍です。

最終的な複雑度は、

ちなみに、本当に天文学的な数字と比較すると、宇宙の原子の総数は、おおよそ

人類の想像を超える、その膨大な可能性を全部調べ上げるのは、スーパーコンピューターでも太刀打ちできません。

従来のAIを超えた秘密

AlphaGoの開発チームは、決められたルールによる大量の計算を頼らず、「ディープラーニング」という新しいアプローチを採用し、突破口を見出しました。

AlphaGoは、まず大量のプロ棋譜を使って「どんな手が優れているか」という直感を学び取り、人間のプロ棋士のような「考える力」を手に入れました。

そして、「モンテカルロ木探索(Monte Carlo tree search, MCTS)」というアルゴリズムで不要な探索を途中でやめることができ、応答生成時の推論処理効率を大幅に改善することにより、次の着手を短時間内に決めることができました。

ただ、人間のプロを模倣するだけでは、プロと同等の能力は手に入っても、人間を超えるには至らないでしょう。

そこで登場する勝ち手は、「強化学習」です。

強化学習 とは、「自分で試行錯誤を繰り返して、どんどん上達していく」学習方法です。

料理に例えるなら、人間の料理人は一流シェフのレシピをひたすら研究し、そして何万回も料理を作り直し、味見しながら改善していくことで、独自の料理を作り出せる能力を獲得したことです。

AlphaGoは、自己対戦を何百万回も繰り返すことで、次第に人間が気づかなかった戦略や手法を見出し、最終的には人間のプロ棋士を凌駕する実力を身につけました。

その証明の一つは、「奇跡の37手目」です。

李との第2局の対戦で、AlphaGoの打った37手目は、それまで囲碁の常識にはなかった手であり、観戦していた人々を驚愕させました。

解説者も「人間なら絶対に選ばない悪手」と指摘しましたが、後にこれが勝利への伏線だったと判明しました。

重要なのは、この手が人間の棋譜には存在しなかったことです。

これは、AIが独自の思考によって人間を超えた新しい手法を生み出した証明です。

AlphaGoの作成者の一人は次のように説明しました。

我々はAlphaGoに囲碁を打つようプログラムしたが、それがどんな手を思い付くのかは全く分からない。

AlphaGoの手は訓練によって生まれた創発現象なのだ。

その訓練が、強化学習です。

これこそが、強化学習による奇跡です。

2017年10月、過去の試合データを一切使わず、ルールだけを教え、自己対局のみで訓練された新囲碁AI「AlphaGo Zero」が発表されました。

人間の囲碁知恵を知り尽くした AlphaGo との対局実績は、100-0 です。

つまり、人間の知識を勉強せず、自己対局による強化学習だけで、AlphaGo Zeroの知能は全面的にAlphaGoを超えました。

非常に衝撃を受けましたが、AIが人間の知恵を必要とせず、純粋に自分を相手にするだけで自己進化ができ、やがて人間を超える存在になり得ることを初めて知りました。

ChatGPTが拓く会話AIの新時代

2016年にAlphaGoが人間の知性を超えた瞬間を目撃し、私たちはAIの可能性が飛躍的に広がったことを強く感じました。

しかし当時のAIは、囲碁のようにルールが明確な領域では圧倒的な力を発揮できる一方、より曖昧で多岐にわたる分野での応用はまだ限られていたようです。

そんな中、2022年11月に登場した大規模言語モデル「ChatGPT」は、再び世界にAIの無限の可能性を証明しました。

ChatGPT はどのように学習を行なっているのか

AI研究者でOpenAIの創設メンバーとして活躍したAndrej Karpathy氏の動画解説によると、ChatGPT のような大規模言語モデルは 「事前学習(Pre-training)」 と 「事後学習 (post-training) 」 の2つの段階を経て進化していきます。

大規模データによる事前学習(Pre-training)

ちょうどAlphaGoが最初に大量の囲碁対局データを学習して棋士の動きを身につけたように、ChatGPTも人類社会に蓄積されたあらゆるテキストデータを吸収することで、言語の「使い方」を覚えました。

ただ、モデルが学んでいるのは文法というより、単語と単語の間に存在する確率的な関連性です。

たとえば次のような例を考えてみましょう。

最近ずっと晴れていたのに、今日は___

空欄に来る単語としては「雨」「曇り」「雪」などが考えられますが、モデルは過去に学習した膨大なテキスト情報から最も高い確率の単語を推定します。

ここにランダム要素も加わるため、同じ質問をしても異なる答えが返ってくることがあるわけです。

このとき、モデルは、特定の文面をそのまま記憶しているわけではなく、言語に含まれる統計的パターンを学習し、それを「重み(Weights)」や「パラメータ」として圧縮することで蓄積しているのです。

こうして学習を終えた時点のモデルを 「ベースモデル」 と呼びますが、単に「次の単語を推測する」能力だけでは、まだ会話や数学の問題解決、プログラミングなど高度な応用には十分ではありません。

高度なタスクに対応するための事後学習(Post-training)

こうしたベースモデルに、さらに特定のタスクや目的に合わせた「微調整」を施すのが、いわゆる事後学習です。

大きく以下の2つのアプローチが代表的だと言われています。

教師ありファインチューニング(Supervised Fine-tuning,SFT)

この手法では、人間が作成した教師データを用いて、モデルに適切な応答を学習させます。

例えば、モデルに会話能力を向上させるためには、まずは人間の専門家が作成した「対話形式のデータ」や「問題と模範解答のペア」を使用し、モデルの応答がより自然で意味的に一貫性のあるものになるよう微調整します。

例として、次のようなやり取りを大量に学習させるイメージです。

ユーザー:なぜ空は青いのですか?

AI:空が青く見えるのは、レイリー散乱と呼ばれる…

ユーザー:なるほど、そうなんですね。

AI:そうなんです!ほかにも気になる自然現象とかありますか?

こうしたデータを学ぶことで、モデルは「会話形式」で人間に説明する能力を身につけます。

実際には、ユーザーが問題を入力したとき、AIが受け取るデータは次のようなものです。

user: なぜ空は青いのですか?

AI:

つまり、AIからすれば「AI: 」以降の空欄を補完することに過ぎません。

user: なぜ空は青いのですか?

AI: __________

ただ、学習データに基づいて適切な文を生成することで、あたかも人間のように自然に応答しているように見えるのです。

このように、教師ありファインチューニングSFTでは、人間がどのような出力が望ましいかを直接教えることで、AIがより精度の高い応答を生成できるようになります。

強化学習(Reinforcement Learning)

次に、より質の高い応答を得るために、強化学習という手法を採用し、モデル自身が試行錯誤を通して自己進化できるようにします。

ただし、AlphaGo ZeroのようなゲームAIと違い、大きな課題があります。

囲碁のようなゲームでは、「勝ち・負け」といった明確なルールや評価基準があるため、AIは自律的に学習できます。

しかし、現実世界には明確な正解が存在しない問題がほとんどです。

例えば:

- 「どんな詩が素晴らしいのか?」

- 「戦争のない未来をどう迎えられるのか?」

- 「人生をどのようにすれば幸せに過ごせるのか?」

このような主観的な評価が関わる問題に対して、AIは単純な強化学習だけでは学習が困難です。

そこで、OpenAIが採用したのが、人間のフィードバックによる強化学習(Reinforcement Learning from Human Feedback, RLHF) です。

RLHFでは、モデルの出力に対して人間の判断基準で評価を行い、その評価を「報酬」として学習させます。

例えば、AIが同じ質問に対して複数の回答を生成したとき、人間の専門家が次のようにランク付けを行います。

- 「この回答はわかりやすい」→ 高評価(高い報酬)

- 「この回答は誤情報が含まれる」→ 低評価(低い報酬)

そして、AIは「どうすれば高い評価を得られるか?」を学習しながら、試行錯誤を繰り返します。

また、AIが試行錯誤をより効率的に行うために、OpenAIはPPO(Proximal Policy Optimization) というアルゴリズムを導入しています。

PPO(近接方策最適化)とは、次の行動を取る「方策(policy)」の更新を極端に変更しすぎないように制御する手法です。

もしAIが報酬を最大化しようとして、一度に大きく方針を変えてしまうと、予測不可能な動作になり、学習が不安定になってしまいます。

PPOはこれを防ぐために、AIが少しずつ調整しながら最適な出力を学習できるようにするアルゴリズムです。

例えば、料理の味付けをイメージしてください。

スープが「しょっぱい」と感じたときに、一気に塩を抜くのではなく、少しずつ減らして味見をしながら調整するのがPPOの考え方です。

この方法を用いることで、AIは過剰に極端な変化をせず、安定した学習を行いながら最適な応答を見つけることができます。

PPOとRLHFを組み合わせることで、AIは人間の評価を取り入れつつ、試行錯誤しながら、より自然で質の高い応答を生成できるようになります。

こうして、ChatGPTは最終的には多くの人に受け入れられるAIへと進化してきました。

それでも残る課題と限界

こうして生まれたChatGPTは世界を驚かせるほどの会話能力を得ましたが、依然として以下のような問題も残っています。

誤情報や矛盾のある回答

AIは統計的に最も可能性の高い単語を選んでいるだけで、必ずしも論理や事実に基づいた確固たる根拠があるわけではありません。

そのため、「もっともらしいが間違っている」回答を堂々と提示してしまうことがあります。

人間のバイアスや評価基準に依存

RLHF では人間が「正解」「好ましい」と判断したものがそのまま学習の方向性を決めるため、モデルの可能性を狭めてしまうケースも考えられます。

もし AlphaGo が「人間らしい打ち方」を正解とみなしていれば、あの奇跡的な37手目のような常識外れの一手は生まれなかったでしょう。

評価自体を操作するリスク

模範解答の形式を学習しすぎると、「実質的な内容は薄いが、評価者が好む形式で書かれた文章」を量産する可能性もあります。

テスト対策で使い回しの「型」を暗記する生徒のように、AI が評価基準に適合するだけの回答を返してくるリスクが存在するのです。

推論モデルと思考の連鎖

こうした課題を解決するため、OpenAI は 2024年9月に「o1」と呼ばれる推論モデル(reasoning model)を発表しました。

公式サイトによると、このモデルが注目しているのが 「思考の連鎖(Chain of Thought)」 と呼ばれる仕組みです。

人間は複雑な問題に直感的に答えるのではなく、時間をかけて「論理的な思考法」を用いることで正確な結論にたどり着きます。

実は2022年ごろから、AI に対して「一歩ずつ考えよう(Let's think step by step)」とプロンプトを与えると、数学の難問などに対する解答の正確性が著しく向上することが報告されていました。

o1 モデルは、単に複雑な問題を細かく分解するだけでなく、さらに驚くべきことに、自身の推論過程を検証し、誤りを発見し、修正する能力も持っています。

これは、従来の「統計に基づいた単語予測」というレベルを超え、まるで本当に人間のように考えているとも言えるでしょう。

AI が論理的思考能力を持ち、さらには 自己反省や自己検証ができるようになった ことは、AI の発展史における画期的な飛躍と見なされています。

推論モデルへの探索

しかし、競争の優位性などの理由により、OpenAI は推論モデルの具体的なトレーニングプロセスを公開しておらず、モデルの生の「思考の連鎖」もユーザーに開示していません[1]。

そのため、多くの AI 研究者たちが、OpenAI の公開論文や発表内容からヒントを探ろうと試みています。

例えば、OpenAI が 2023 年に発表した論文 「Let's Verify Step by Step」 では、最終結果だけを見るよりは、プロセス報酬モデル(Process Reward Model) を用いて、モデルが生成する推論の各ステップを評価することで、モデルの数学問題解決能力を向上させることができるという研究結果が示されています。

また、もう一つの一般的なアプローチとして 応答生成段階での推論時間スケーリング(Inference-time scaling)があります。

このアプローチは、思考の連鎖から着想を得ています。

AIが単に結果を出力する場合と比べて、長い思考の連鎖 (Long Chain-of-Thought) を含む推論の方が、より正確な回答を生み出せるため、AIにより長い思考時間を与え、複数の思考ステップを経た上で最適な回答を選び出す手法が研究されています。

代表的な例としては、探索アルゴリズムを活用し、AI にできるだけ多くの候補解を生成させ、その中から長い思考の連鎖を含めたものを選択する方法が挙げられます。

このアプローチは、かつて AlphaGo がモンテカルロ木探索(MCTS)を用いて、意思決定前に多数の選択肢を評価し、最適な一手を選んでいた手法が似ています。

しかし、これらの手法は期待された成果を十分に得られず、DeepSeek も同様に試みたものの、これらの試行錯誤について論文で言及しています。

それでも、今回注目すべきなのは、DeepSeek が R1 モデルの論文で、3つの有効なアプローチ を開示したことです。

それについて、興味深いのは、OpenAIの最高研究責任者がDeepSeek-R1の論文に対して、次のように述べました。

「彼らの研究論文は、我々が o1 に至る過程で発見した重要なアイデアのいくつかを、彼らも独自に見つけたことを示している。」

では、DeepSeek は具体的にどのような手法を用いたのでしょうか?

次に、その詳細を見ていきましょう。

DeepSeek-R1: AIが自ら学び、進化する時代へ

本題に入る前に、まず前置きをしておきたいことがあります。

DeepSeekは、非常に低コストで GPT-o1 レベルの AI モデルを開発できた という印象を持たれることがありますが、実はその「低コスト」というのは、R1 ではなく、R1 の前にリリースされた DeepSeek-V3 による成果です。

DeepSeek-V3 は、6710 億パラメータを持つ大規模言語モデルであり、性能は GPT-4o に匹敵すると評価されています。

詳細については 技術レポート にまとめられています。

専門的な内容が多いため、本記事では説明を割愛します。

興味がある方は、こちらのツイート をご覧ください。

DeepSeek-V3 のコスト削減への取り組みを非常に簡潔にまとめられています。

さて、ここからが本題です。

今回の論文 DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning について詳しく見ていきましょう。

タイトルを直訳すると、「DeepSeek-R1: 強化学習による大規模言語モデル(LLM)の推論能力促進」 となります。

しかし、「Incentivizing」 には「奨励」や「動機づけ」という意味で、単に「推論能力を促進する」というよりも「報酬仕組みを通じて、モデルが自律的に推論能力を高めるよう誘導する」というニュアンスです。

この論文では、タイトルにある DeepSeek-R1 だけでなく、次の 3 つのモデルが紹介されています。

いずれも、開発チームが LLM の推論能力を獲得させるために挑戦した異なるアプローチの成果を示したものです。

| モデル名 | ベースモデル | アプローチ | 結果 |

|---|---|---|---|

| DeepSeek-R1-Zero | DeepSeek-V3-Base | 教師データを一切使わず、純粋な強化学習のみを適用。 | 高い推論能力を獲得。ただし、多言語混在など可読性の問題がある |

| DeepSeek-R1 | DeepSeek-V3-Base | DeepSeek-R1-Zero の出力を教師データとして活用。 SFT + 強化学習 を多段階に実施。 |

高性能かつ可読性・応用性の高い推論モデルが完成 |

| DeepSeek-R1-Distill | Qwen2.5, Llama-3 などの小規模モデル | DeepSeek-R1 の訓練プロセスで用いたデータと生成された推論データを活用し、SFTのみ を適用。 | 小規模モデルでも高い推論能力を獲得 |

これら 3つのモデルの訓練プロセスについて、こちらの記事 にある一枚図解がとても分かりやすいです。

※画像中ではベースモデルを「DeepSeek-V3」と記載していますが、より正確には、事前学習のみ実施された「DeepSeek-V3-Base」です。

また、その中でも、最も驚くべき成果を示したのが「DeepSeek-R1-Zero」 です。

本記事では、この3つのうち DeepSeek-R1-Zero に焦点を当てて詳しく紹介します。

DeepSeek-R1-Zero: AIに自由に思考させることで生まれた奇跡

「AIに論理的思考を教えるにはどうすればよいのか?」

この課題に対して、多くの研究者は、「人間が作成する大量の教師データやサンプルが必要だ」と悩んでいました。

しかし、DeepSeek開発チームは、まるで信じられないような答えを出しました:

教える必要はない。AIは自ら学ぶ

そして、その訓練プロセスも非常にシンプルです。

人間の専門家があらかじめ作成したサンプルデータは一切使用せず、純粋な強化学習だけを採用し、モデルの自我進化能力を探究することに主眼を置きました。

もちろん、開発チームはその理由も率直に語っています。

サンプルデータを収集するには膨大な時間とコストがかかるからです。

今回の訓練に向けて、彼らが用意したのは以下の3つでした。

- シンプルな訓練テンプレート

- シンプルな報酬モデル

- 改良版の強化学習アルゴリズム

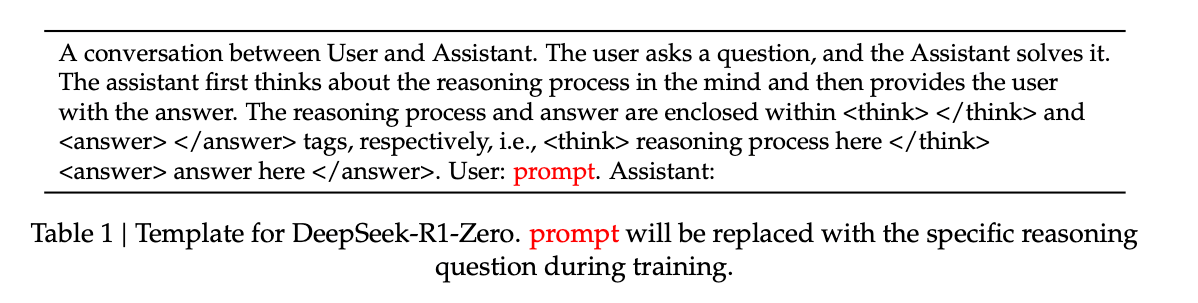

シンプルな訓練テンプレート

まずは訓練テンプレートについて。

ベースモデルが要求に合わせて出力を生成できるようにする一方で、人為的な誘導(バイアス)を与えたくないため、あえて最小限の指示とフォーマット指定だけを盛り込んでいます。

簡単に翻訳すると、下記となります。

ユーザーとアシスタントの間の会話です。

ユーザーが質問をし、アシスタントがそれを解決します。

アシスタントはまず頭の中で推論プロセスを考え、その後、ユーザーに答えを提供します。

推論プロセスと回答は、それぞれ <think> </think> および <answer> </answer> タグで囲まれます。

つまり、 <think> ここに推論プロセス </think> <answer> ここに答え </answer> の形式になります。

User: ${ここに具体的な質問内容}

Assistant:

このテンプレートでは、思考プロセスを <think>…</think> で囲み、最終回答を <answer>…</answer> に記述するなどの簡単なルールを設定するのみです。

シンプルな報酬モデル

モデルの出力が適切かどうかを判断し、フィードバック(報酬)を与えるために報酬モデルを使用します。

そして、この報酬モデルも驚くほどシンプルでした。

報酬(スコア)の基準は大きく2つに分かれます。

-

正確性報酬(Accuracy Rewards)

- 解答が正しいかどうかを評価する。

- 例えば、数学問題なら答えが正解か。LeetCodeコーディング問題なら、実際にコードを実行してテスト結果を検証する。

-

フォーマット報酬(Format Rewards)

- 回答のフォーマットがテンプレート通りかどうかを評価する。

- 具体的には、思考プロセスを <think>…</think> タグで囲むことを必須条件とするなど。

彼らは、一般的によく採用される「ニューラルネットワーク(neural network, NN)を使った報酬モデル」は使わず、シンプルかつ明確的なルールベースのみを採用しました。

理由ついて、現実世界では「唯一の正解がない」ケースがほとんどなので、モデル出力を評価すること自体が難しいのが一つです。

OpenAIがChatGPTを訓練するときに行った方法としては、

- まず大量の人間による主観的・客観的なフィードバックデータを集める

- そのデータで「評価を行うAI(報酬モデル)」を学習させる

- その報酬モデルを使って、強化学習中のモデルの出力を評価する

という流れを採用しています。

このやり方には大きく2つの問題があるとされています。

まず、報酬モデルを訓練するには多大なコストがかかり、全体の学習プロセスが複雑になります。

また、前述したように、「賢いモデル」が、報酬モデルの抜け道を探してスコアを不正に稼ぐ (Reward Hacking) リスクが増します。

さらに、ニューラルネットワークベースの報酬モデルは、ブラックボックス的要素が強いため、報酬ハッキングを防ぐために、モデルそのものを改良することも難しいのです。

そこでDeepSeekチームは、正解判定とフォーマット判定という2つの明確なルールだけを用いて報酬を与える方針に決定しました。

強化学習アルゴリズム

最後に、モデルが試行錯誤を重ねながら、正しい方向へ学習を進めるためのアルゴリズムが必要です。

一般的にはPPOがよく使われますが、PPOでは即時報酬を与える「報酬モデル」と、累積報酬を推定するための「価値モデル」をそれぞれ訓練する必要があり、計算コストが莫大になります。

そこでDeepSeekチームは、PPOを改良し、価値モデルを外してしまうという大胆な方法を選びました。

そして、この新アルゴリズムを グループ相対ポリシー最適化(Group Relative Policy Optimization, GRPO) と名付けています。

GRPOの数式レベルの解説については,こちらの解説記事で詳しく解説されています。

ここでは簡単な数学問題「2 * 3 + 2 = ?」を例に、GRPOがどのように動くか概略を示します。

-

まず、モデルに複数の回答を生成させる

- 回答1:"6"

- 回答2:"8"

- 回答3:"<think>2 * 3 = 6, 6 + 2 = 8</think><answer>8</answer>"

-

それぞれの回答を採点する

- 回答1:"6"

- スコア: 0点(誤答)

- 回答2:"8"

- スコア: 1点(正解だが、フォーマットが守られていない)

- 回答3:<think>2 * 3 = 6,6 + 2 = 8</think><answer>8</answer>

- スコア: 2点(正解、かつフォーマットが正しい)

- 回答1:"6"

-

このグループ全体の平均スコアを計算する

平均スコア = (0 + 1 + 2) / 3 = 1 -

各回答のスコアを平均値と比較し、相対スコアを算出する

- 回答1:0 - 1 = -1

- 回答2:1 - 1 = 0

- 回答3:2 - 1 = 1

-

相対スコアに基づいて、次回以降の回答生成方針(ポリシー)を更新する

相対スコアの高いパターンはより多く生成されやすくなる

上記のように、モデルがどのように推論すべきか人間が教えることはせず、非常にシンプルなトレーニング仕組みを使い、モデルに自力で学習させるだけです。

そして、奇跡が生まれました。

DeepSeek-R1-Zeroの自己進化と「自分で考え直す」能力

強化学習を進めるにつれ、DeepSeek-R1-Zero は数学や科学分野など幅広い問題において、OpenAI-o1 モデルに匹敵する性能を示すようになりました。

特に驚かれたのは、モデル自身が思考時間を自然に長くする という現象です。

テンプレートや報酬設計では「時間をかけて考えろ」と明示したわけではないのに、深く考えたほうがスコアが上がるということをモデル自身が学び、「より長い思考プロセスを出力すれば、正確な答えに近づく」という自己戦略を自然に獲得したようなのです。

さらに、モデルが自分自身の間違いに気づいて「考え直す」動作も身につけたことが観測されています。

下図のように、モデルの思考ログには人間のような「つぶやき」が現れるようになったとのことです。

これは、人間が問題を解く際に「いや、ちょっと違うかも…あ、そうか!」と頭の中で独り言を呟く様子に非常に近い動きです。

DeepSeek-R1-Zeroが残す課題

教師データに頼らず、純粋な強化学習のみで学習した結果、モデルが自律的に推論を深め、自分で考え直す能力まで獲得した点は非常に興味深いです。

一方で、多言語が混在しやすかったり、可読性に課題が残るなどの弱点も指摘されています。

この弱点を補ったのが、DeepSeek-R1-Zero の推論結果を教師データ化して SFT を繰り返した DeepSeek-R1 です。

DeepSeek-R1 の訓練パイプラインとDeepSeek-R1-Distillに関しての蒸留もとても興味深いですが、後日に余裕があれば、また追加で書きたいと思います。

今回は、紙面上の関係で、DeepSeek-R1とDeepSeek-R1-Distillに関しての説明は一旦割愛します。

以上はDeepSeek R1論文の主要内容(主にDeepSeek-R1-Zero)をまとめたものです。

論文を読んで感動した話

最後に、AI超初心者の私が今回の DeepSeek R1 論文を読んで感じたことを共有したいと思います。

初心者としてDeepSeekの論文を楽しむために頑張ったこと

実は、論文を直接読む前に、英語・中国語・日本語を含む様々な解説記事を読んでみましたが、多くの解説記事は私にとって難解で、論文への興味を高めるどころか挫折感を覚えることが多かったのです。

ところが、DeepSeek R1 Reveals Path to Surpassing Human Intelligence という記事に出会ったことが大きな転換点でした。

この記事は、AlphaGo から ChatGPT、DeepSeek に至る AI の歴史的背景をわかりやすい言葉で整理していて、スムーズに読むことができました。

何より、おかげで「強化学習の魔法」を強く感じさせられました。

それを読んで一気に DeepSeek や AI そのものへの興味が高まり、「AI の基礎をもう少し学んでみよう」と思えるようになりました。

それからは、ニューラルネットワークとは何か、Transformer とは何か、SFT(Supervised Fine-Tuning)とは何かといった基礎知識を少しずつ調べるようにしました。

そして十分に興味が湧き、基本的な用語がわかった段階で、改めて DeepSeek の論文を開いてみたところ、前よりもはるかに理解しやすくなったと実感しました。

最初はさっぱりわからなかった解説記事の内容も、「あ、こういう意味だったのか」と腑に落ちる瞬間が増えました。

もちろん、DeepSeek R1 論文自体がわりと読みやすく書かれているという点も大きいと思います。

確かにAI 論文は専門用語や複雑な数式が多く、取っ付きにくい印象を持たれがちですが、DeepSeek R1 の場合、数学的な部分を抜きにして、訓練プロセスの流れを追うだけで全体像を把握できると思います。

一方で、なぜ多くの解説記事を読んでもピンとこなかったか、後になって振り返ると大きく2つの理由があったと思います。

1つめは、それらの解説記事が主に AI の実務者向けに書かれていて、前提知識がかなり省略されていたこと。

2つめは、私自身が AI の歴史や背景、どんな課題が存在するのかを知らなかったため、DeepSeek の成果に対して「どこが素晴らしいなのか」がイメージしづらかったことです。

今回の場合、最初からすべてを理解しようとせず、「自分のレベルに合った資料を探し続ける」ことが大事だと感じました。

なぜなら、自分に足りないのがどの知識なのかをはっきり認識できない状態だと、難しい専門書や解説を読んでも何がわからないのかわからない、というループに陥りがちだからです。

「まずは興味をかき立ててくれる分かりやすい資料に出会う → 分からない用語を補足学習する → また元の資料を読む」というサイクルを繰り返すうちに、知識同士がつながって理解が深まっていくという経験を実感しました。

まるで大きなジグソーパズルを組み立てるような感覚もありました。

ピースが増えれば増えるほど「まだ他にも集めるべきピースがある」と気づき、全体像は見えやすくなるけれど、完成形もどんどん大きくなってきました。

そのような学びの循環もとても面白かったです。

技術の突破は世代を超えた努力の上に築かれる

もう一つ感じたのは、AI の進化は、一人の天才のひらめきではなく、長年にわたる研究者たちの試行錯誤の積み重ねによるものです。

AI 分野を見てもわかるように、多くの画期的な理論やモデルは、提案された当時は計算リソースや周辺技術が追いつかず、何十年もの間「温められていた」ケースが少なくありません。

たとえば、ニューラルネットワークの基礎理論は1950年代に提案されていましたが、当時の計算リソースでは実用化には至りませんでした。

数十年の時を経て、GPU の性能向上や分散学習技術の発展が進んだことで、ニューラルネットワークの可能性が現実味を帯びてきました。

DeepSeek もまた、一朝一夕で生まれたものではありません。

その背景には、大規模言語モデル分野全体の技術進歩と、彼ら自身による数年にわたる研究と改良の積み重ねがあります。

実際、ここ1年ほどの間に彼らが公開した論文は十数本にのぼります[2]。

たとえば、DeepSeek-R1-Zero の強化学習アルゴリズムは、2024年2月に発表された DeepSeekMath: Pushing the Limits of Mathematical Reasoning in Open Language Modelsで詳しく紹介されており、そこから改良を続けてきたという経緯があります。

また、最も話題を呼んだコスト削減の取り組みに関しても、DeepSeekMoE や Multi-head Latent Attention(MLA) は、既存のアプローチを改良した手法であり、DeepSeek V2 (2024年5月) の段階で、既に試していました。

さらに V3 では、 FP8 GEMM や Multi-Token Prediction という技術を取り入れることで、学習および応答生成時の推論処理(inference)の計算効率をいっそう高めています。

強力な V3-Base モデルの完成を土台に、さらに強化学習を重ねることで、DeepSeek-R1-Zero の「奇跡」が生まれたのです。

ちなみに、DeepSeek-R1-Zero の中核をなす強化学習という概念自体も、実は1950年代から存在していました。

しかし、それが大きく注目を集めるようになったのは、2016年に AlphaGo が人間のトップ棋士を破ったときでした。

このように、大きな成果の裏には、多くの試行錯誤や先行研究、そして改良の積み重ねがあります。

そこには一世代にとどまらない、歴代の研究者たちの積み上げがあることを改めて感じさせられました。

とても感動を覚えています。

自由な探索と継続的な学習

今は、DeepSeek-R1 のおかげで、過去にブラックボックスとなっていたAIの思考プロセスは日常的に見えるようになりました。

そして驚くべきことに、AIの思考プロセスこそが、結果以上に興味深い場合さえあるのです。

信じがたいことに、これらの思考プロセスや自問自答は学習の中でモデル自らが悟ったものであり、人間が教えたわけではありません。

8年ほど前には、人間の指導を必要とせず、自分自身との対局だけで人間のプロを打ち負かす囲碁AIが誕生しました。

そして今や、同じアプローチによって、AIは人間のように推論能力を身につけることさえ可能だとわかってきています。

DeepSeekチームが論文で述べているように、これはまさに強化学習の「力と美しさ(the power and beauty)」を示したものです。

「シンプルさは究極の洗練である。」

AlphaGo Zero以来、私たちは再び強化学習の奇跡を目の当たりにしているといえるでしょう。

そして、ちょうど数日前、強化学習の2人の創始者が2025年度のチューリング賞を共同受賞しました[3]。

そのうちの一人(Richard Sutton氏)は2019年に The Bitter Lesson という有名な記事を発表したことがあります。

AI研究分野に長年携わってきた彼は、次のような「苦い教訓」を見出しました。

AIの性能を高めたいという目的のもとで、研究者はいつも人間の知識や経験をAIに組み込もうとしがちだ。

しかし、その結果として計算コストが大きく増えるだけでなく、しばしば逆効果となり、時間を浪費するに終わる。

つまり、私たちが学ぶべき「苦い教訓」とは、以下の2点が持つ強大な力を改めて認識することだというのです。

- 汎用性のある方法

- 計算リソースの増加にともなって性能が拡張し続ける方法

そして、この2つの条件を満たす手段こそが「探索(search)と学習(learning)」だ、とRichard Sutton氏は語りました。

探索と学習。

人生も同じではないでしょうか?

自由な探索と継続的な学習が、新たな可能性を切り開く。

それはAIに限らない真実かもしれません。

今回DeepSeek R1の論文を読んで、最も感動したことでした。

-

2025年1月、DeepSeek-R1 の登場によって、初めて推論モデルの思考過程が完全に公開され、ユーザーはその全過程を確認できるようになりました。Open AI側はその直後に o3-mini モデルでより多くの思考プロセスを公開する決定をしました。 ↩︎

スペースを簡単に貸し借りできるサービス「スペースマーケット」のエンジニアによる公式ブログです。 弊社採用技術スタックはこちら -> whatweuse.dev/company/spacemarket

Discussion