🚄

LoRAよりも超高速の学習フレームワークが提案されているらしい

Drag-and-Drop LLMs: Zero-Shot Prompt-to-Weights

- プロンプトエンジニアリングじゃなくて、内部のパラメータを学習できる

- 「知識をドラッグアンドドロップ感覚でLLMに学習させることができる」

元論文: https://arxiv.org/abs/2506.16406

参考にした解説動画:

Drag-and-Drop LLM (DND) の利点

- 高速化: パラメータ生成は1秒未満で行われ、従来のファインチューニングに比べて1万倍以上高速

- 高性能: LoRAを用いたファインチューニングと同等以上の性能を達成している

- 汎用性: 学習データセット以外のプロンプトに対しても、ある程度の汎用性がある

- 簡便性: プロンプトのみを入力とするため、正解データは不要

- 拡張性: 様々なモデルサイズで効果が確認されており、LoRAよりも高い性能を示す場合もある

- 一貫性: DND適用後、性能が低下することは基本的にない

- 革新性: 重み自体を新たなデータモダリティとして見なす

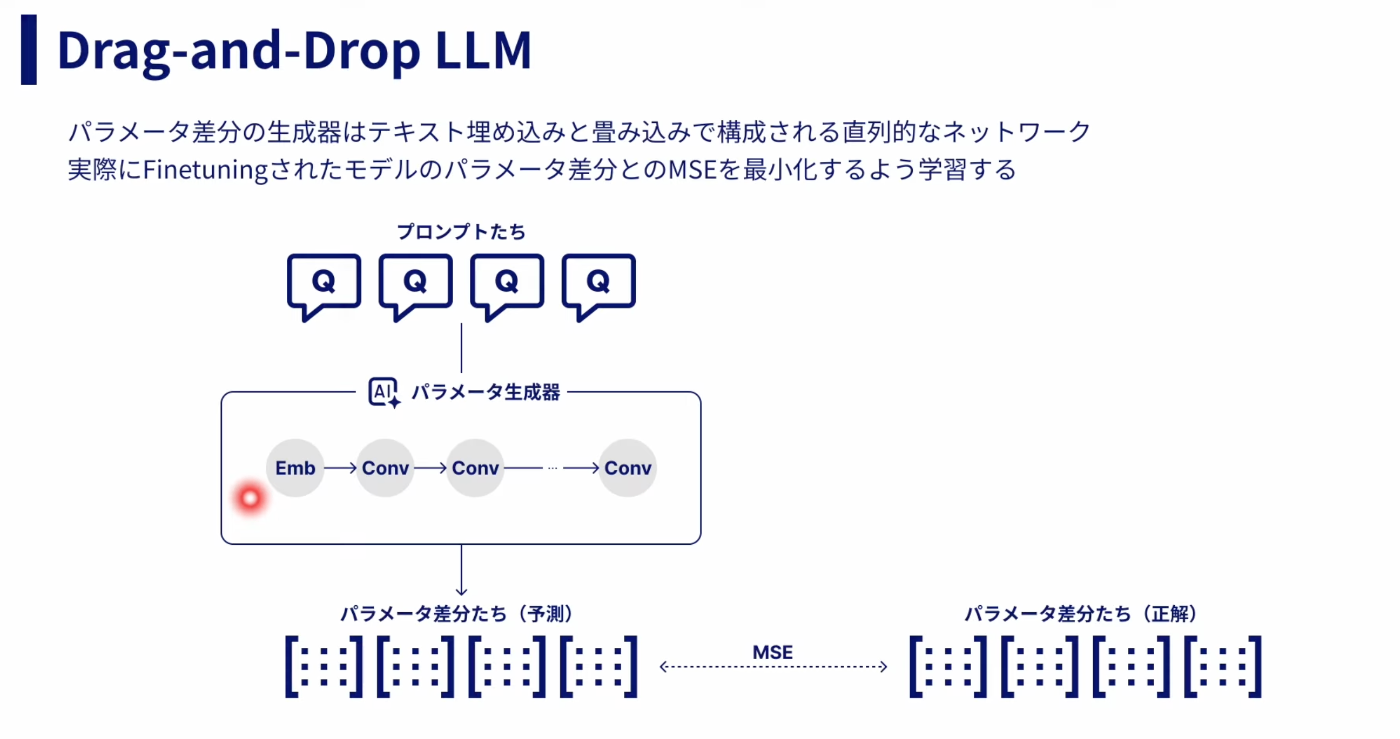

手法

Drag-and-Drop LLMs (DnD) は、プロンプトを条件としてLLMのパラメータ(LoRAの重み)を直接生成する新しい手法

画像出典: 【最先端】新たな知識を一瞬で学習するAI【DnD】

個人的感想

重み自体を新たなデータモダリティとして見なす、という方向性は新しくて良いなと感じた

Discussion