✨

OpenHands cli をローカルの ollama + gemma3 で動かしてみた(動いてなかった)

追記: これダメでした。モデル設定が反映されてませんでした。取り急ぎ。

OpenHands cli がリリースされました。Google の gemma3 も Ollama で実行できるようになったので、動かしたメモ。

まずは ollama + gemma3 をセットアップ

brew install ollama

ollama pull gemma3

ただ、gemma3 は openhands-cli 標準では使えないので、標準で使える codegeex4 を用意しておく。

ollama pull codegeex4

これだけ。続いて openhands cli を実行。

uvx --python 3.12 --from openhands-ai openhands

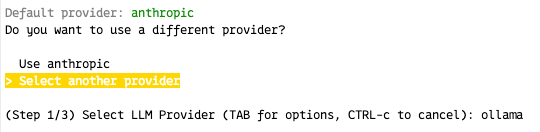

anthropic を使うか?と聞かれるので Select other provider を選択し、リストから ollama を選択

デフォルトのモデルを使うか?と聞かれる。ここで Select another model を選択しても、gemma3 が一覧に出てこないので意味なし。なので、デフォルトモデルを選択する。

API Key は ollama では使わないので dummy とでもしておく。

ちなみに、どうせ後でカスタムセッティングするのでここは何選んでもいいかも。

プロンプトに戻ったら /settings とタイプして、Advanced を選択し、モデルの設定を行う。

最終的にこうなってれば OK

これでローカルの ollama を使って gemma3 でエージェントを動かせる。

ちなみに、2020 年ものの M1 Mac でもギリギリ動きました。

参考

Discussion