ファインチューニングとRAGの違いについて

はじめに

生成AIの進化が加速する中、その性能を向上させる手法として「ファインチューニング」と「RAG(Retrieval-Augmented Generation)」が注目を集めています。これらの技術は、AIモデルをより賢く、効率的に、そして特定のタスクに適したものにする上で重要な役割を果たしています。

しかし、一見似ているように見えるこれらの手法は、実際にはまったく異なるアプローチを取っています。この記事では、ファインチューニングとRAGの違いを詳しく解説し、それぞれの特徴、メリット・デメリット、そして具体的なユースケースを紹介します。

AIエンジニアや開発者はもちろん、AIサービスの導入を検討している企業の方々にとって、この記事は両技術の理解を深め、適切な選択をする上で役立つ情報となれば幸いです。

ファインチューニングとRAGの概要

このセクションでは、ファインチューニングとRAGの基本的な違いを理解し、それぞれのアプローチの特徴を学びます。

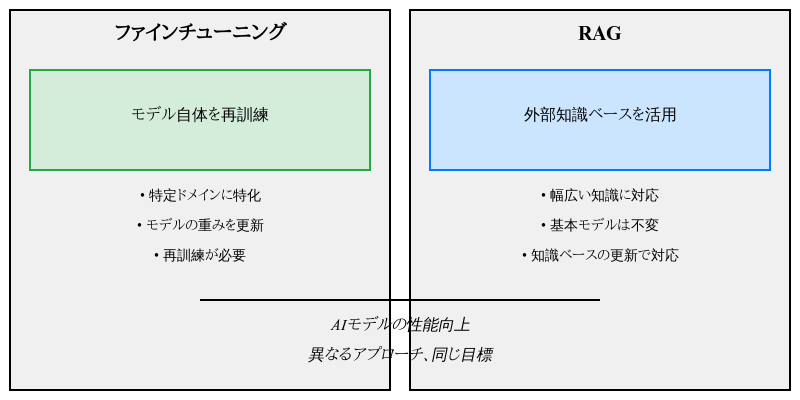

ファインチューニングとRAG (Retrieval-Augmented Generation) は、両方とも大規模言語モデル (LLM) の性能を向上させるための手法ですが、アプローチが異なります。

ファインチューニング

- データの扱い方:モデル自体を追加のデータセットで再訓練

- モデルの変更:モデルの重みを更新

- 新しい知識の追加:新しい知識を追加するには再度訓練が必要

- メモリ使用量:モデルサイズが大きくなる可能性

- 適用範囲:特定のドメインや課題に特化したモデルを作成するのに適している

RAG

- データの扱い方:外部知識ベースからリアルタイムに関連情報を取得し、推論時に活用

- モデルの変更:基本モデルはそのままで、外部知識を参照する機能が追加

- 新しい知識の追加:知識ベースを更新するだけで新しい情報を反映

- メモリ使用量:基本モデルのサイズは変わらないが、外部知識ベースのストレージが必要

- 適用範囲:幅広い知識が必要な一般的なタスクに適している

それぞれの特徴(メリット・デメリット)

このセクションでは、ファインチューニングとRAGのメリットとデメリットを比較し、それぞれの手法がどのような状況で有効かを理解します。

ファインチューニング

メリット

- 特定ドメインでの性能向上:特定の分野や課題に特化した高精度なモデルを作成可能

- 一貫性:学習したパターンを安定して再現可能

- 推論速度:追加の外部参照が不要なため、比較的高速

- オフライン使用:一度訓練すれば、インターネット接続なしで使用可能

デメリット

- データ依存性:高品質で大量の訓練データが必要

- 計算コスト:再訓練に多大な計算リソースが必要

- 柔軟性の欠如:新しい情報を追加するたびに再訓練が必要

- 過学習リスク:特定のデータセットに過度に適応する可能性

RAG

メリット

- 最新情報の反映:知識ベースを更新するだけで新しい情報を即座に利用可能

- 柔軟性:様々な種類の外部知識を容易に統合可能

- 透明性:参照元を明示できるため、回答の根拠が明確

- メモリ効率:基本モデルのサイズを増やさずに知識を拡張可能

デメリット

- レイテンシー:外部知識の検索と統合に時間がかかる場合がある

- 知識ベースの品質依存:検索結果の質が回答の質に直結

- インフラ要件:効率的な検索システムと大規模なストレージが必要

- 統合の複雑さ:検索結果を適切にモデルの出力に統合する処理が複雑になる可能性

実装の基本

このセクションでは、ファインチューニングとRAGの基本的な実装手順を学び、それぞれの技術を実際のプロジェクトに適用する際の準備を整えます。

ファインチューニング

- 事前学習済みモデルの選択(例:GPT-3、BERT)

- タスク固有のデータセットの準備

- ハイパーパラメータの設定(学習率、エポック数など)

- 転移学習の実行(PyTorch、TensorFlowなどのフレームワークを使用)

- モデルの評価と調整

主要なツール:Hugging Face Transformers、OpenAI GPT-3 Fine-tuning API

RAG

- ベースとなる言語モデルの選択

- 知識ベースの構築(文書のインデックス化)

- 検索システムの実装(例:Elasticsearch、Faiss)

- 検索結果と言語モデル出力の統合ロジックの開発

- システム全体の最適化とチューニング

主要なツール:Haystack、LangChain、Pinecone

両手法とも、実装の詳細はタスクや使用するモデル、フレームワークによって大きく異なります。適切なアプローチの選択には、プロジェクトの要件、利用可能なリソース、そして期待される結果を慎重に検討することが重要です。

ユースケース

このセクションでは、ファインチューニングとRAGの具体的な応用例を紹介し、それぞれの技術がどのような場面で効果を発揮するかを理解します。

ファインチューニング

専門分野の文書生成

- 法律文書の作成(例:LegalAI by LawGeex)

- 医療レポートの生成(例:Nuance DAX)

- 特定業界向けの技術文書作成

特定スタイルの文章生成

- ブランド固有のマーケティングコピー作成(例:Persado)

- 特定の作家や詩人のスタイルを模倣した創作

多言語対応

- 特定言語ペアに特化した機械翻訳(例:DeepL)

- 方言や専門用語を考慮したローカライゼーション

感情分析

- 特定業界や製品に関するSNSデータの感情分析(例:Brandwatch)

- カスタマーレビューの詳細な感情分類

質問応答システム

- 企業固有の製品やサービスに関するFAQボット(例:IBM Watson Assistant)

- 学術分野に特化した研究支援AIアシスタント

RAG

最新情報を反映した質問応答

- ニュース記事や最新の研究論文に基づく回答生成(例:Anthropic's Claude)

- 頻繁に更新される製品情報や価格に関する問い合わせ対応

大規模な知識ベースを活用したサポート

- 技術サポートチャットボット(製品マニュアルや過去の事例を参照)(例:Zendesk Answer Bot)

- 複雑な法律や規制に関する助言システム(例:ROSS Intelligence)

個人化されたレコメンデーション

- ユーザーの過去の行動履歴を参照したコンテンツ推奨(例:Netflix推薦システム)

- 企業の過去の取引データを活用した商品提案

学習支援システム

- 幅広い教育リソースを活用した個別化された学習支援(例:Century Tech)

- 最新の研究成果を反映した科学教育支援

事実確認と情報検証

- ジャーナリズムにおける事実確認ツール(例:Full Fact)

- 学術論文の引用チェックと関連研究の提案

複合的な問題解決

- 複数の情報源を組み合わせた戦略立案支援(例:Palantir Foundry)

- 多角的な視点を提供する意思決定支援システム

これらのユースケースは、それぞれの手法の強みを活かしています。ファインチューニングは特定の領域や課題に深く特化したい場合に適しており、RAGは幅広い知識を柔軟に組み合わせて活用する必要がある場合に効果的です。

実際の応用では、これらの手法を組み合わせたハイブリッドアプローチも考えられます。例えば、ベースとなるモデルをファインチューニングで特定ドメインに適応させつつ、RAGで最新情報や詳細なデータを補完するといった使い方も可能です。

選択基準

このセクションでは、プロジェクトに最適な手法を選択するための基準を学び、実際の意思決定プロセスをシミュレートします。

プロジェクトに最適な手法を選ぶ際は、以下の点を考慮してください:

-

タスクの特殊性

- 高度に専門的なタスク → ファインチューニング

- 一般的な知識を要するタスク → RAG

-

データの更新頻度

- 静的なデータセット → ファインチューニング

- 頻繁に更新される情報 → RAG

-

リソースの制約

- 計算リソースが豊富 → ファインチューニング

- ストレージリソースが豊富 → RAG

-

レイテンシー要件

- 低レイテンシーが必須 → ファインチューニング

- レイテンシーより正確性重視 → RAG

-

透明性の必要性

- 結果の根拠を示す必要がある → RAG

- ブラックボックスでも問題ない → ファインチューニング

-

スケーラビリティ

- 固定的な知識範囲 → ファインチューニング

- 拡張可能な知識ベースが必要 → RAG

-

予算

- 初期投資可能(計算リソース) → ファインチューニング

- 運用コストを分散したい → RAG

これらの基準を総合的に評価し、プロジェクトの目的と制約に最も適した手法を選択してください。場合によっては、両方の手法を組み合わせたハイブリッドアプローチも検討する価値があります。

最新のトレンドと将来展望

このセクションでは、ファインチューニングとRAGの最新の発展と将来の可能性について探ります。

最新のトレンド

- マルチモーダルRAG:テキストだけでなく、画像や音声などの複数のモダリティを統合したRAGシステムの開発が進んでいます。

- 効率的なファインチューニング:パラメータ効率的なファインチューニング手法(LoRA、Prefix-tuningなど)の研究が活発化しています。

- ハイブリッドアプローチ:ファインチューニングとRAGを組み合わせたモデルが登場し、両者の長所を活かす試みが増えています。

- 自己改善型RAG:検索結果の品質を自動的に評価し、知識ベースを動的に更新するRAGシステムの研究が進んでいます。

将来展望

- より効率的な学習手法:少量のデータでも高精度な特化型モデルを作成できる手法の発展が期待されます。

- 動的知識統合:リアルタイムで外部知識を取り込み、モデルの能力を継続的に拡張する技術の進化が予想されます。

- 説明可能なAI:RAGの透明性を活かした、より説明可能なAIシステムの開発が進むでしょう。

- ドメイン特化型RAG:特定の産業や分野に特化した高度なRAGシステムの登場が期待されます。

これらのトレンドと展望は、AIの応用範囲をさらに拡大し、より intelligent、efficient、そして transparent なシステムの実現につながるでしょう。

まとめ

ファインチューニングとRAG(Retrieval-Augmented Generation)は、大規模言語モデル(LLM)の性能を向上させるための重要な技術ですが、それぞれ異なるアプローチを取ります。

ファインチューニングは、特定のドメインや課題に対してモデルを最適化する手法で、高度に専門化されたタスクに適しています。一方、RAGは外部知識ベースを活用し、モデルの柔軟性と最新情報への対応力を高める手法です。

両技術の主な違いは以下の点にあります:

- 知識の更新方法:ファインチューニングは再訓練が必要、RAGは知識ベースの更新で対応

- リソース要件:ファインチューニングは計算リソース、RAGはストレージリソースが重要

- 適用範囲:ファインチューニングは特定ドメイン、RAGは幅広い知識が必要なタスクに適する

選択基準としては、タスクの特殊性、データの更新頻度、リソース制約、レイテンシー要件、透明性の必要性、スケーラビリティ、予算などを考慮する必要があります。

最新のトレンドとしては、マルチモーダルRAG、効率的なファインチューニング手法、ハイブリッドアプローチなどが注目されており、将来的にはより効率的な学習手法や動的知識統合、説明可能なAIシステムの発展が期待されます。

これらの技術は、AIの応用範囲をさらに拡大し、より intelligent、efficient、そして transparent なシステムの実現に貢献するでしょう。プロジェクトの要件と目標を慎重に評価し、適切な手法を選択することが、AIシステムの成功の鍵となります。

今後のAI開発において、ファインチューニングとRAGは相補的な役割を果たし、場合によってはハイブリッドアプローチを採用することで、より強力で柔軟なAIソリューションの創出が可能になるでしょう。

Discussion