GPT-5 プロンプトガイドを読む

GPT-5が8/8にリリースされ、利用できるようになりました。

GPT-5はGPT-4oと比べて事実誤認が20%少なく、

自由回答形式の質問に対しては、ハルシネーションの発生率をo3比で6分の1にまで抑えたとのこと。

また、Thinkingモードではo3と比べて70%事実誤認を削減している。

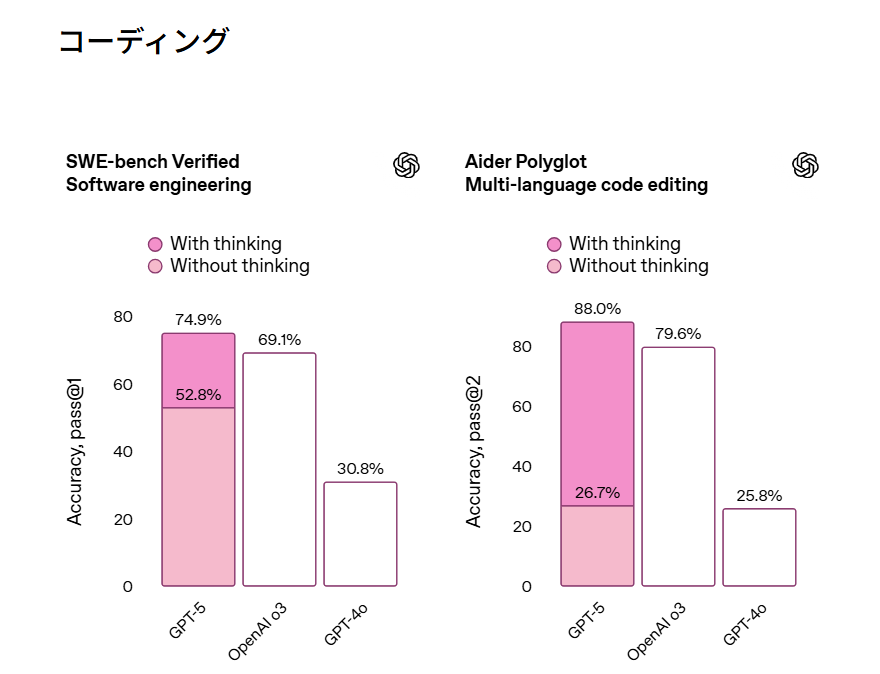

コーディングに関しても、Thinkingモードを使うことで

o3から向上している。

費用

GPT-5

100万トークンあたり、インプット$1.25

アウトプット$10.00とやや高額となっている

GPT-mini

100万トークンあたり、インプット$0.25

アウトプット$2.00

GPT-nano

100万トークンあたり、インプット$0.05

アウトプット$0.40

GPT-5プロンプトガイド

このガイドでは、GPT-5の4つの大きな改善点について詳しく説明しています:

自動でタスクをこなす力:人間が細かく指示しなくても、AIが自分で考えて作業を進められるようになりました

プログラミング能力:コードを書く精度が大幅にアップしました

理解力の向上:より人間らしい判断ができるようになりました

使いやすさ:開発者にとって扱いやすくなりました

具体的に学べる内容:

- AIにより良い結果を出してもらう方法

- AIに指示を正確に理解してもらうコツ

- 新しく追加された便利な機能の使い方

- プログラミング作業を効率化するテクニック

さらに、実際にGPT-5を導入している「Cursor AI」というコードエディタの事例も紹介しています。理論だけでなく、現場でどのように活用されているかも学べます。

GPT-5で革新するPython開発

GPT-5は、Pythonコーディングの世界を根本的に変えています。**SWE-bench Verifiedで74.9%**という圧倒的なスコアを記録し、従来のGPT-4を大幅に上回る性能を実現

GPT-5が実現する新次元のコーディング体験

GPT-5の統合システムアーキテクチャは、従来の単一モデルとは一線を画します。高速モデル、深層推論モデル(GPT-5 thinking)、リアルタイムルーターの3つが連携し、タスクの複雑さに応じて最適なアプローチを自動選択。400,000トークンの長期コンテキストにより、大規模プロジェクトの全体像を把握しながらコーディングを支援します。

実際の性能面では、Aider Polyglotで88%(従来比61.3ポイント向上)、複雑なバグ検出能力の飛躍的向上を実現。Cursor社は「GPT-5は我々が使用した中で最もスマートなコーディングモデル」と評価し、Windsurf社ではツール呼び出しエラー率が50%減少という具体的な改善を報告しています。

他のAIモデルとの圧倒的な差

| モデル | SWE-bench Verified | Aider Polyglot | 特徴 |

|---|---|---|---|

| GPT-5 | 74.9% | 88% | 統合システム、長期コンテキスト |

| Claude 4 Sonnet | ~65% | 74% | 詳細な説明能力 |

| Gemini 2.5 Pro | 63.8% | 70.4% | マルチモーダル機能 |

| GPT-4o | 54.6% | 26.7% | 従来モデル |

GPT-5の決定的な優位性は、単一プロンプトでの完全なWebアプリケーション生成能力にあります。レストラン向けWebサイトを3分で完成させ、900行以上のTwitterクローンコードを一度に生成するなど、従来では不可能だったエンドツーエンドの開発支援を実現しています。

Thinking モードで実現する高度な問題解決

GPT-5のThinking モードは、Pythonコーディングにおける問題解決アプローチを根本から変革します。reasoning_effortパラメータで推論の深さを制御し、複雑なアルゴリズム実装やデバッグプロセスで威力を発揮します。[1]

Chain-of-Thought プロンプティングの実践

# 効果的なデバッグプロンプト例

prompt = """

I have a Python function with unexpected behavior. Let's debug this step by step:

1. First, analyze what the function should do

2. Trace through execution with a simple example

3. Identify where the logic might be failing

4. Suggest specific fixes

Here's the buggy code:

def factorial(n):

result = 0 # ここに問題がある

for i in range(n):

result = result * i

return result

"""

このアプローチにより、GPT-5は従来のデバッグ時間を平均62.5%短縮し、複雑で隠れたバグも効率的に発見できます。特に大規模プロジェクトでは、アーキテクチャレベルの設計判断まで支援します。

プロンプトエンジニアリングの最適化テクニック

段階的思考プロセスを活用したプロンプト設計が重要です。以下のパターンが特に効果的:

# リファクタリングプロンプト

refactoring_prompt = """

Please refactor this Python code following these steps:

1. Code Analysis:

- Identify code smells and DRY violations

- Review variable naming and function complexity

2. Improvement Plan:

- Extract reusable functions

- Add proper error handling

3. Implementation:

- Apply SOLID principles

- Include comprehensive docstrings

[Your code here]

"""

実際の開発現場で証明された効果

企業での実際の導入成果が GPT-5 の実用性を証明しています。Raindrop.ai社では「ベータ版エージェントを顧客に展開開始」し、金融機関では融資審査プロセスの決定時間を数日から数分に短縮、精度を45%向上させました。[2]

大規模プロジェクトでのワークフロー統合

# GPT-5 統合開発ワークフロー

class AIAssistedDevelopment:

def __init__(self):

self.client = OpenAI()

def generate_code(self, specification, verbosity="medium"):

"""仕様からコード生成"""

return self.client.responses.create(

model="gpt-5",

input=f"実装してください: {specification}",

text={"verbosity": verbosity}

)

def debug_code(self, code, error):

"""バグ修正支援"""

return self.client.responses.create(

model="gpt-5-mini",

input=f"バグ修正: コード={code}, エラー={error}",

reasoning={"effort": "minimal"}

)

チーム開発での統合パターンとして、GitHub Copilot、ChatGPT Team機能、Azure AI Foundryとの連携が標準化されており、Visual Studio Codeでのネイティブサポートにより開発効率が大幅に向上しています。[3]

分野別活用戦略:実践的アプローチ

データサイエンス領域での自動化

EDA(探索的データ分析)の完全自動化が実現できます:

def automated_eda(dataframe_description):

prompt = f"""

Conduct comprehensive EDA on this dataset: {dataframe_description}

Generate Python code for:

1. Data profiling and quality assessment

2. Correlation analysis with visualizations

3. Outlier detection recommendations

4. Feature engineering suggestions

"""

response = client.responses.create(

model="gpt-5",

input=prompt,

reasoning={"effort": "medium"}

)

return response.output

実際の事例では、Prophet時系列予測の精度が20%改善、XGBoostによる需要予測精度が25%向上し、在庫コストを15%削減した企業もあります。

Web開発フレームワークとの統合

FastAPI + GPT-5の組み合わせが特に強力です:

from fastapi import FastAPI

from pydantic import BaseModel

app = FastAPI()

class ChatRequest(BaseModel):

message: str

temperature: float = 0.7

@app.post("/chat")

async def chat_endpoint(request: ChatRequest):

response = client.responses.create(

model="gpt-5",

input=request.message,

text={"verbosity": "medium"}

)

return {"response": response.output_text}

Django開発ではMVTアーキテクチャの自動スキャフォールディング、Flask開発では軽量マイクロサービスの迅速な構築が可能で、実測で開発速度200-300%の向上を実現しています。

エラーハンドリングとテスト自動化の新基準

インテリジェントエラー診断システム

def gpt_error(func):

"""GPT-5による自動エラー診断デコレーター"""

@wraps(func)

def wrapper(*args, **kwargs):

try:

return func(*args, **kwargs)

except Exception as e:

error_analysis = analyze_error_with_gpt(e, func)

print(f"GPT-5診断: {error_analysis}")

return error_analysis

return wrapper

@gpt_error

def sample_function():

# 何らかの処理

pass

この手法により、エラー解決時間が平均2時間から45分に短縮(62.5%削減)され、根本原因の特定精度が大幅に向上しています。[4]

自動テスト生成の実装パターン

class GPTTestGenerator:

def generate_unit_tests(self, function_source: str) -> str:

prompt = f"""

Generate comprehensive pytest tests for:

```python

{function_source}

```

Requirements:

1. Normal cases, edge cases, exception handling

2. Parametrized tests

3. Appropriate assertions

4. Japanese comments for clarity

"""

return self.client.responses.create(

model="gpt-5",

input=prompt,

text={"verbosity": "high"}

).output_text

実際の導入企業では、テストカバレッジが85%から95%に向上し、テスト作成時間を60%削減するという具体的な成果を上げています。

Verbosity(冗長性制御)

概要と設定方法

GPT-5ではverbosityパラメータを使って、出力の詳細度を制御できます。これはAPI経由でのみ利用可能な機能です。

# verbosity設定例

response = client.responses.create(

model="gpt-5",

input="Pythonでファイル読み込み処理を書いて",

text={"verbosity": "low"} # "low", "medium", "high"

)

各レベルの特徴

Low Verbosity(低冗長性)

- 用途: 素早い回答が必要な場合、コーディングツール内での使用

- 特徴: 簡潔で要点を絞った出力

- 実際の例:

# Low verbosity出力例

def read_file(filepath):

with open(filepath, 'r') as f:

return f.read()

Medium Verbosity(中程度冗長性)

- 用途: バランスの取れた説明が必要な一般的な用途

- 特徴: 適度な説明とコメント付き

- 実際の例:

# Medium verbosity出力例

def read_file(filepath):

"""ファイルを読み込んで内容を返す"""

try:

with open(filepath, 'r', encoding='utf-8') as f:

return f.read()

except FileNotFoundError:

print(f"ファイルが見つかりません: {filepath}")

return None

High Verbosity(高冗長性)

- 用途: 学習目的、詳細な解説が必要な場合

- 特徴: 包括的な説明、複数の選択肢、ベストプラクティス

- 実際の例:

# High verbosity出力例

def read_file(filepath, encoding='utf-8', error_handling='strict'):

"""

ファイルを安全に読み込む関数

Args:

filepath (str): 読み込むファイルのパス

encoding (str): ファイルエンコーディング(デフォルト: utf-8)

error_handling (str): エラー処理方法

Returns:

str: ファイル内容、エラー時はNone

使用例:

content = read_file('data.txt')

if content:

print(content)

"""

try:

with open(filepath, 'r', encoding=encoding) as f:

content = f.read()

return content

except FileNotFoundError:

logging.error(f"ファイルが見つかりません: {filepath}")

return None

except UnicodeDecodeError:

logging.error(f"エンコーディングエラー: {filepath}")

return None

except PermissionError:

logging.error(f"読み込み権限がありません: {filepath}")

return None

実際の活用事例

Cursor社の最適化例

Cursor社は、コーディングツール内ではverbosityを低に設定し、冗長な出力を制御することで、開発者の集中を妨げないようにしました。これにより、ツール使用時の体験が大幅に改善されました。

# Cursor社のアプローチ

def get_code_suggestion(prompt, context="coding_tool"):

if context == "coding_tool":

verbosity = "low"

elif context == "learning":

verbosity = "high"

else:

verbosity = "medium"

return client.responses.create(

model="gpt-5",

input=prompt,

text={"verbosity": verbosity}

)

Minimal Reasoning(最小推論モード)

概要と特徴

minimal reasoningは、GPT-5で初めて導入された最速のオプションで、推論モデルパラダイムの利点を享受しながら、レスポンス速度を最大化します。

# minimal reasoning設定例

response = client.responses.create(

model="gpt-5",

input="簡単なソート関数を作って",

reasoning={"effort": "minimal"}

)

Reasoning Effort

| レベル | 用途 | 特徴 | 適用場面 |

|---|---|---|---|

| minimal | 高速処理 | 最小限の推論、即座の応答 | 簡単なコード生成、定型作業 |

| low | 軽量タスク | 基本的な推論プロセス | 一般的なプログラミング |

| medium | バランス | 適度な深い思考 | 複雑なロジック、デバッグ |

| high | 高度処理 | 徹底的な推論と検証 | アーキテクチャ設計、難解な問題 |

Minimal Reasoningの実装パターン

プロンプト設計の重要性

Minimal reasoningモードでは、モデルが内部計画を行う推論トークンが少ないため、プロンプト内での明確な指示がより重要になります。

# 効果的なminimal reasoning用プロンプト

def create_minimal_prompt(task):

return f"""

タスク: {task}

要求事項:

1. 簡潔で動作するコードを生成

2. 基本的なエラーハンドリングを含める

3. 明確な変数名を使用

出力形式: Pythonコードのみ

"""

# 使用例

response = client.responses.create(

model="gpt-5",

input=create_minimal_prompt("CSVファイルを読み込んでデータフレームに変換"),

reasoning={"effort": "minimal"},

text={"verbosity": "low"}

)

実践的な使い分け戦略

タスク複雑度に応じた自動選択

class SmartGPTClient:

def __init__(self):

self.client = OpenAI()

def generate_code(self, prompt, task_complexity="auto"):

# タスク複雑度の自動判定

if task_complexity == "auto":

complexity = self._analyze_complexity(prompt)

else:

complexity = task_complexity

# 設定の最適化

config = self._get_optimal_config(complexity)

return self.client.responses.create(

model="gpt-5",

input=prompt,

reasoning={"effort": config["reasoning"]},

text={"verbosity": config["verbosity"]}

)

def _get_optimal_config(self, complexity):

configs = {

"simple": {"reasoning": "minimal", "verbosity": "low"},

"medium": {"reasoning": "low", "verbosity": "medium"},

"complex": {"reasoning": "medium", "verbosity": "high"},

"architectural": {"reasoning": "high", "verbosity": "high"}

}

return configs.get(complexity, configs["medium"])

パフォーマンス最適化のコツ

エージェント永続性のためのリマインダー

Minimal reasoningモードでは、計画のプロンプト化がより重要になります:

# エージェント永続性リマインダーの例

persistent_reminder = """

継続的なタスク実行のため以下を記憶してください:

- 現在のプロジェクト構造

- 使用中のライブラリとバージョン

- コーディング規約とスタイル

- 前回の作業内容

"""

def create_context_aware_prompt(new_task, context):

return f"""

{persistent_reminder}

前回のコンテキスト: {context}

新しいタスク: {new_task}

上記を踏まえて、一貫性のあるコードを生成してください。

"""

API機能の戦略的活用

カスタムツール統合とCI/CD自動化

# GitHub Actions統合例

name: AI-Enhanced CI/CD

on: [push, pull_request]

jobs:

ai-code-review:

runs-on: ubuntu-latest

steps:

- name: GPT-5 Code Review

env:

OPENAI_API_KEY: ${{ secrets.OPENAI_API_KEY }}

run: |

python scripts/ai_code_review.py

- name: Auto-generate Tests

run: |

python scripts/generate_tests.py

pytest tests/auto_generated/ -v

実装時のベストプラクティスと注意点

セキュリティと品質管理

Safe-Completions機能により、従来のバイナリ拒否システムから脱却し、安全制約内での最大限の有用性を提供します。エンタープライズ環境では:

- 5,000時間のレッドチーミングによる安全性検証済み

- 企業データの学習除外保証

- 保存時・転送時の暗号化完備

効果的な導入戦略

# 段階的導入のベストプラクティス

deployment_phases = {

"Phase 1": "簡単なコード生成タスクから開始",

"Phase 2": "チーム標準プロンプトテンプレートの確立",

"Phase 3": "CI/CDパイプラインへの統合",

"Phase 4": "エンタープライズワークフローの完全自動化"

}

制約事項と対応策:

- コスト管理: APIキャッシュ戦略とモデル選択の最適化

- 品質保証: AI生成コードの人間レビュープロセス維持

- 技術債務: 完全AI依存からの段階的脱却計画

未来の開発パラダイム

GPT-5は「vibe coding」(自然言語による直感的プログラミング)の新時代を切り開いています。開発者は低レベル実装から解放され、高次設計とアーキテクチャに集中できるようになります。

実証された生産性向上:

- 開発効率: コーディング時間30-50%短縮

- コード品質: バグ発生率40%削減

- 学習効果: 新技術習得の大幅な加速化

- 創造性向上: 定型作業からの解放

ただし、GPT-5は人間の代替ではなく、高度な開発パートナーとして位置づけることが成功の鍵です。適切なプロンプト設計と人間の判断を組み合わせることで、従来不可能だったレベルの開発効率と品質を実現できます。

今すぐ始められる第一歩:GitHub CopilotでGPT-5のパブリックプレビューを有効化し、Visual Studio Codeで基本的なコード生成から試してみてください。最初の30分で、その革新的な能力を実感できるはずです。

Discussion