NASバックアップ

背景

2022年8月からSynologyのNASで家族の写真・動画を保存している。

3年近く運用しており、引越しのタイミングでバックアップを意識するようになった。

ハードウェア構成

- NAS本体: Synology DiskStation DS220+

- ストレージ: Seagate IronWolf 2TB × 2台

-

RAID構成: SHR (Synology Hybrid RAID)

- 実質的にRAID 1相当

- 実行容量: 2TB

- 冗長性: 1台故障までOK

各種LLMに相談

プロンプト

NASのバックアップをしたい。

ハードウェア構成は以下の通り。

* NAS本体: Synology DiskStation DS220+

* ストレージ: Seagate IronWolf 2TB × 2台

* RAID構成: SHR (Synology Hybrid RAID)

火事や落雷に備えてクラウドにバックアップを取りたい。

選定ポイントは以下の2点

* クラウド: GCPが慣れていて使いやすい

* 価格: バックアップの目的を満たしている範囲で安いもの

上記の条件をもとに選択肢とそれらの違い、おすすめとその理由をまとめてください。

Claude Opus 4の提案

NASのクラウドバックアップについて、GCPでの選択肢と推奨案をまとめます。

GCPのストレージオプション比較

1. Cloud Storage - Archive クラス

- 価格: $0.0012/GB/月(東京リージョン)

-

特徴:

- 年1回程度のアクセス頻度を想定

- 最低保存期間365日

- データ取得時に料金発生($0.05/GB)

- 災害復旧用途に最適

2. Cloud Storage - Nearline クラス

- 価格: $0.01/GB/月(東京リージョン)

-

特徴:

- 月1回程度のアクセス頻度を想定

- 最低保存期間30日

- Archiveより高速なアクセス

- データ取得料金は$0.01/GB

3. Cloud Storage - Standard クラス

- 価格: $0.02/GB/月(東京リージョン)

-

特徴:

- 頻繁なアクセスに対応

- 最低保存期間なし

- 取得料金なし(ネットワーク料金のみ)

Synology DS220+との連携方法

-

Hyper Backup(推奨)

- Synology純正バックアップツール

- GCS(Google Cloud Storage)に直接対応

- 増分バックアップ対応で転送量削減

- バージョン管理機能あり

-

Cloud Sync

- リアルタイム同期

- バックアップより同期向き

コスト試算例(2TB使用時)

| ストレージクラス | 月額料金 | 年額料金 | 復旧時料金(2TB) |

|---|---|---|---|

| Archive | $2.4 | $28.8 | $100 |

| Nearline | $20 | $240 | $20 |

| Standard | $40 | $480 | $0 |

推奨構成

Cloud Storage - Archive クラス + Hyper Backup の組み合わせを推奨します。

推奨理由

- コスト効率: 年額約$29と圧倒的に安価

- 災害復旧用途に最適: アクセス頻度が低い前提なら十分

-

Hyper Backupの機能:

- 暗号化対応でセキュリティ確保

- 世代管理で過去のバージョンも保持

- スケジュール実行で自動化可能

- 増分バックアップで転送量最小化

設定のポイント

- バックアップスケジュール: 週1回の差分バックアップ

- 保持ポリシー: 3-2-1ルール(3世代、2種類のメディア、1つはオフサイト)

- 暗号化: クライアント側暗号化を有効化

- 通知設定: バックアップ失敗時のアラート設定

初期の全データアップロードには時間がかかりますが、その後は差分のみなので転送量も抑えられます。火災や落雷からの保護という目的には、この構成で十分対応できます。

追加質問

* 年1回程度のアクセス頻度を想定

* 最低保存期間365日

について詳しく説明してください。どういう意味ですか?

回答

これらの条件について説明します:

年1回程度のアクセス頻度を想定

これは、保存したデータを読み取ったり、ダウンロードしたりする頻度が年に1回程度という意味です。

例えば:

- 年度末の決算資料のバックアップ

- 年1回の監査で必要になる過去のログデータ

- 法令で保管が義務付けられているが、めったに参照しない文書

- 思い出の写真や動画で、年に1度見返すかどうかというもの

このような「保管はしておきたいが、ほとんどアクセスしない」データに適したストレージクラスです。

最低保存期間365日

これは一度アップロードしたデータを、最低365日間は保存し続けなければならないという制約です。

重要な点:

- 365日以内に削除すると、早期削除ペナルティが発生します

- ペナルティは通常、残り期間分の保存料金を一括で請求されます

- 例:30日で削除した場合、残り335日分の料金を支払う必要がある

なぜこのような制約があるのか

アーカイブストレージは:

- データを長期保存用に最適化している

- 頻繁なデータの出し入れを想定していない

- そのため料金を安く設定できる

つまり、本当に長期保存が必要なデータのみをアーカイブストレージに保存すべきで、頻繁に変更や削除が発生するデータには向いていません。

ChatGPT o3-pro の提案

1. 前提整理

| 項目 | 概要 | 参照 |

|---|---|---|

| NAS | Synology DS220+/IronWolf 2 TB×2(SHR =ミラー相当で実効約2 TB) | ― |

| 災害対策 | 火事・落雷などローカル設備全損を想定し、クラウドへフルバックアップ | ― |

| クラウド要求 | Google Cloud Platform を使いたい(管理に慣れている) | ― |

| 重視点 | ①バックアップ用途としての安全性 ②コスト最小化 | ― |

2. GCP の主要ストレージクラス比較(東京リージョン asia‑northeast1 例)

| クラス | 月額保管料 (USD/GB) | 2 TB 保管例 (月) | 取出し手数料 (USD/GB) | 最低保管期間 | 典型用途 | 参照 |

|---|---|---|---|---|---|---|

| Standard | $0.023 | 約 $47.1 | $0 | なし | 頻繁アクセス | (Google Cloud) |

| Nearline | $0.016 | 約 $32.8 | $0.01 | 30 日 | 月1 程度アクセス | (Google Cloud, Google Cloud, Google Cloud) |

| Coldline | $0.006 | 約 $12.3 | $0.02 | 90 日 | 年1 回以下の DR バックアップ | (Google Cloud, Google Cloud, Google Cloud) |

| Archive | $0.0025 | 約 $5.1 | $0.05 | 365 日 | 長期保存のみ | (Google Cloud, Google Cloud, Google Cloud) |

※2 TB=2 048 GB で単純計算。為替 変動を加味して日本円換算してください。

ネットワーク取出しコスト

災害復旧で 2 TB をダウンロードする場合(Premium Tier Internet、アジア向け 1–10 TiB 階層 $0.11/GB)

→ 約 $225 が追加 (Google Cloud)

これに取出し手数料(Coldline なら $0.02/GB ≒ $41)が乗ります。

3. バケット配置オプション

| 構成 | 保管料 (Coldline) | 特徴 | 参照 |

|---|---|---|---|

リージョン: Osaka (asia‑northeast2) |

同額 $0.006/GB | 首都圏と別地理に置ける。最安。 | (Google Cloud) |

デュアルリージョン: asia1 (Tokyo+Osaka) |

$0.0132/GB → 2 TB ≒ $27/月 | 都市災害でもどちらかが生存。コスト約2.2倍。 | (Google Cloud) |

マルチリージョン: asia |

Archive $0.003/GB など | 冗長性最高。ただしネットワーク遅延と運用複雑。 | (Google Cloud) |

4. Synology からの接続方法

| 方法 | 特徴 | 設定ポイント | 参照 |

|---|---|---|---|

| Hyper Backup → S3 対応 | バージョン管理・重複排除。最小帯域で世代保存可。 | 1. GCP で HMAC キー付きサービスアカウント作成 2. バケットを作成(例: nas‑backup)3. Hyper Backup で「S3 互換」を選択し、エンドポイント storage.googleapis.com、リージョンコードを入力 |

「GCS は S3 互換バックアップ先として利用可能」(Synology Knowledge Center) |

| Cloud Sync | リアルタイムまたはスケジュール同期。ファイル単位復元が容易。 | OAuth 認証で GCS を追加し、一方向同期(NAS→GCS)を推奨 | GCS が Cloud Sync の公式サービス一覧に含まれる (Synology Knowledge Center) |

5. おすすめ構成と理由

-

Coldline × リージョン Osaka

- 月額約 $12 と低コストで 11 × 9 s の耐久性。

- 東京自宅が被災してもデータは関西に残る。

- 90 日以内に消す予定のないバックアップ用途に合致。

-

追加予算 (~+$15/月) が許容でき、地震など広域障害も懸念する場合は Coldline × デュアルリージョン

asia1。 -

頻繁に単品ファイルを取り出す運用が想定されるなら Nearline へ格上げ(取出し料が半額)を検討。

6. コスト最適化Tips

| 施策 | 効果 | 参照 | |

|---|---|---|---|

| Lifecycle ルール / Autoclass: 30 日未アクセス→Nearline、90 日→Coldline 自動遷移 | 操作料金なしで長期保管を自動最適化 | (Google Cloud, Google Cloud) | |

| Hyper Backup のクライアント側圧縮/重複排除 | 実データ量を 30–60 % 削減し保管料を節約 | Synology DSM UI 内設定 | ― |

| 月1 回の整合性チェックのみ | API オペレーション数を抑え超過課金を防止 | GCS Operations 従量課金 | (Google Cloud) |

| 災害復旧時だけ取出し | 高いネットワーク課金を日常運用に持ち込まない | ネットワーク課金表 | (Google Cloud) |

7. 導入手順(概要)

-

GCP 側

- プロジェクト作成→課金設定

- バケット作成(リージョン選択・Coldline 指定)

- IAM サービスアカウントを作成し、

Storage Object Admin権限付与 - 「相互運用性キー(HMAC)」を発行して Access Key/Secret を取得

-

NAS 側

- Hyper Backup をインストール

- 新規ジョブ→S3 互換→上記キー・バケット入力

- バックアップ元フォルダ・世代数・スケジュール(例: 毎日 2:00)を設定

- テスト復元で整合性確認

-

運用

- 月次で Hyper Backup 自動整合性チェック

- GCP Console のストレージ利用レポートで費用を確認

- 年1 回は復元演習を行い、取出しコストも体験しておく

8. まとめ(要点)

- 最安 & 実用的: Coldline リージョン (Osaka)—月 ~$12 で 2 TB を安全保管。

-

さらなる冗長性が必要なら Coldline デュアルリージョン

asia1—月 ~$27。 - Synology Hyper Backup で S3 互換接続すれば DSM GUI だけで完結。

- 取出し時は 手数料 + ネットワーク料が一気に掛かるので、本当の災害時のみを想定。

- Lifecycle/Autoclass と Hyper Backup の重複排除でランニングコストを圧縮。

これで「慣れた GCP を使いながら、必要十分な災害対策を最小コストで実現」できます。

Manusの調査報告書

Synology DS220+ GCPバックアップ 調査報告書

概要

本報告書は、Synology DiskStation DS220+のNASをGoogle Cloud Platform (GCP)にバックアップするための選択肢を調査し、価格と機能を比較した結果をまとめたものです。

調査対象システム

- NAS本体: Synology DiskStation DS220+

- ストレージ: Seagate IronWolf 2TB × 2台

- RAID構成: SHR (Synology Hybrid RAID) - 実効容量約2TB

- 目的: 火事・落雷対策のクラウドバックアップ

- 要件: GCP使用、価格重視

調査結果サマリー

🏆 最終推奨案: GCP Coldline Storage + Hyper Backup

- 月額料金: $12 (約1,800円)

- 年額料金: $144 (約21,600円)

- アクセス頻度: 四半期1回程度

- 最小保存期間: 90日

推奨理由

- 価格とバランスの最適解: GCP内で実用的な価格帯

- バックアップ用途に最適: 災害復旧目的に適したアクセス頻度

- Synology完全対応: Hyper Backupで簡単設定可能

- 運用の安定性: 90日最小保存期間で安心

選択肢比較

GCP内選択肢比較

| ストレージクラス | 月額 | 年額 | アクセス頻度 | 最小保存期間 | 推奨度 |

|---|---|---|---|---|---|

| Coldline | $12 | $144 | 四半期1回 | 90日 | 🥇 最推奨 |

| Archive | $5 | $60 | 年1回以下 | 365日 | 🥈 コスト重視 |

| Nearline | $32 | $384 | 月1回 | 30日 | 🥉 アクセス重視 |

| Standard | $46 | $552 | 頻繁 | なし | ❌ 非推奨 |

他社サービスとの比較

| サービス | 月額 | 年額 | Synology対応 | 取り出し時間 | 備考 |

|---|---|---|---|---|---|

| GCP Coldline | $12 | $144 | ◎ | 即時 | 推奨 |

| GCP Archive | $5 | $60 | ◎ | 即時 | 最安価 |

| AWS S3 Deep Archive | $1.98 | $23.76 | △ | 12時間 | 最安だが設定複雑 |

| AWS S3 Glacier | $10 | $120 | ○ | 4-5時間 | 取り出し時間あり |

| Azure Archive | $4 | $48 | △ | 15時間 | Synology対応限定的 |

実装手順

1. GCP側の設定

バケット作成

# Google Cloud SDKを使用

gsutil mb -c COLDLINE -l asia-northeast1 gs://your-nas-backup-bucket

Interoperability設定

- GCPコンソールにログイン

- Storage > Settings > Interoperability

- User account HMAC セクションで「CREATE A KEY」をクリック

- Access KeyとSecret Keyをメモ

2. Synology側の設定

Hyper Backupの設定

- パッケージセンターから「Hyper Backup」をインストール

- 新しいバックアップタスクを作成

- 「S3 Storage」を選択

- 以下の設定を入力:

- S3 Server: Custom Server URL

-

Server address:

https://storage.googleapis.com - Signature Version: v4

- Request Style: Virtual Hosted Style

- Access key: GCPで生成したAccess Key

- Secret Key: GCPで生成したSecret Key

- Bucket Name: 作成したバケット名

- Directory: バックアップ用ディレクトリ名

バックアップ設定

- 対象: システム設定 + 重要な共有フォルダ

- 暗号化: 有効化推奨

- 圧縮: 有効化推奨

- スケジュール: 週次または月次(深夜帯推奨)

3. 運用設定

推奨スケジュール

- フルバックアップ: 月1回

- 増分バックアップ: 週1回

- 実行時間: 深夜2:00-6:00(ネットワーク負荷軽減)

監視設定

- バックアップ完了通知をメール設定

- 失敗時のアラート設定

- 定期的な復旧テスト(四半期1回)

コスト詳細

月次コスト内訳(推奨案: Coldline)

- ストレージ料金: $12.00

- データ転送料金: $1-2(増分バックアップ)

- オペレーション料金: $0.1-0.5

- 合計: 約$13-15/月 (約2,000-2,300円)

年間コスト

- 約$156-180/年 (約23,000-27,000円)

初期費用

- GCPアカウント設定: 無料

- Synology設定: 無料

- 初回フルバックアップ時間: 約2-3時間

リスク評価と対策

想定リスク

- ネットワーク障害: 自動リトライ機能で対応

- GCP障害: 複数リージョンへの分散も検討可能

- データ破損: バージョン管理で複数世代保持

- コスト超過: 月次監視とアラート設定

対策

- 定期的なバックアップ状況確認

- 四半期ごとの復旧テスト実施

- コスト監視ダッシュボード設定

- 代替手段(外付けHDD)との併用検討

代替案

コスト最優先の場合: GCP Archive Storage

- 月額: $5 (約750円)

- 適用ケース: 真の災害対策のみ、頻繁なアクセス不要

- 注意点: 取得料金が高い、365日最小保存期間

アクセス重視の場合: GCP Nearline Storage

- 月額: $32 (約4,800円)

- 適用ケース: 定期的なバックアップテスト実施

- メリット: 月1回アクセス可能、取得料金安い

結論

GCP Coldline Storage + Hyper Backupの組み合わせが、ユーザーの要件(GCP慣れている、価格重視、災害対策)を最もバランス良く満たす解決策です。

主な利点

- 月額$12という手頃な価格

- Synologyとの完全な互換性

- 災害復旧に適したアクセス頻度

- GCPの高い信頼性とセキュリティ

- 簡単な設定と運用

次のステップ

- GCPアカウントの準備

- バケット作成とHMACキー生成

- Synology Hyper Backupの設定

- 初回バックアップの実行とテスト

- 定期運用の開始

この構成により、火事や落雷などの災害からNASデータを確実に保護できます。

Manusの提案

Synology DS220+ GCPバックアップ 推奨案

ユーザー要件の整理

- NAS構成: Synology DS220+ + Seagate IronWolf 2TB × 2台 (SHR)

- 実効容量: 約2TB

- 目的: 火事・落雷対策のクラウドバックアップ

- クラウド: GCP希望(慣れているため)

- 重視点: 価格重視、バックアップ目的を満たす範囲で安価

推奨選択肢(優先順)

🥇 第1推奨: GCP Coldline Storage + Hyper Backup

月額: $12 (約1,800円) / 年額: $144 (約21,600円)

選定理由

- 価格とバランスの最適解: GCP内で2番目に安価

- バックアップ用途に最適: 四半期1回程度のアクセス頻度

- Synology完全対応: Hyper Backupで簡単設定

- 災害復旧に適している: 90日最小保存期間で安定性確保

設定方法

- GCPでColdlineバケット作成

- Interoperability設定でHMACキー生成

- Hyper BackupでS3ストレージ選択

- 週次または月次スケジュール実行

🥈 第2推奨: GCP Archive Storage + Hyper Backup

月額: $5 (約750円) / 年額: $60 (約9,000円)

選定理由

- 最高のコストパフォーマンス: GCP内で最安価

- 長期保存に最適: 年1回以下のアクセス

- 真の災害対策: 365日最小保存期間

注意点

- データ取得料金が高い ($0.05/GB)

- 頻繁な復旧テストには不向き

- 本当の緊急時のみの利用を想定

🥉 第3推奨: GCP Nearline Storage + Hyper Backup

月額: $32 (約4,800円) / 年額: $384 (約57,600円)

選定理由

- アクセス性重視: 月1回程度のアクセス可能

- バックアップテストに適している: 取得料金が安い

- 運用の柔軟性: 30日最小保存期間

適用ケース

- 定期的なバックアップテストを実施したい場合

- 予算に余裕がある場合

他社サービスとの比較

| サービス | 月額 | 年額 | Synology対応 | 備考 |

|---|---|---|---|---|

| GCP Coldline | $12 | $144 | ◎ | 推奨 |

| GCP Archive | $5 | $60 | ◎ | 最安価 |

| AWS S3 Deep Archive | $1.98 | $23.76 | △ | 最安だが設定複雑 |

| AWS S3 Glacier | $10 | $120 | ○ | 取り出し4-5時間 |

| Azure Archive | $4 | $48 | △ | Synology対応限定的 |

実装手順(推奨案)

1. GCP設定

# バケット作成

gsutil mb -c COLDLINE -l asia-northeast1 gs://your-nas-backup-bucket

# Interoperability設定

# GCPコンソール > Storage > Settings > Interoperability

# HMAC key作成

2. Synology設定

- Hyper Backupアプリをインストール

- 新しいバックアップタスク作成

- S3ストレージを選択

- 以下を設定:

- Server:

https://storage.googleapis.com - Access Key: GCPで生成したHMACキー

- Secret Key: GCPで生成したシークレット

- Bucket: 作成したバケット名

- Server:

3. スケジュール設定

- 頻度: 週次または月次

- 時間: 深夜帯(ネットワーク負荷軽減)

- 暗号化: 有効化推奨

- 圧縮: 有効化推奨

運用コスト試算

初期設定

- GCPアカウント設定: 無料

- Synology設定: 無料

- 初回フルバックアップ: 約2-3時間

月次運用コスト(Coldline推奨案)

- ストレージ料金: $12/月

- データ転送料金: 約$1-2/月(増分バックアップ)

- 合計: 約$13-14/月 (約2,000円)

年間コスト

- 約$156-168/年 (約23,000-25,000円)

まとめ

GCP Coldline Storage + Hyper Backupが最適解です。価格とバックアップ用途のバランスが取れており、Synologyとの親和性も高く、ユーザーの要件を満たしています。

Manusによる比較表

| サービス | 月額料金($) | 年額料金($) | 取得料金($/GB) | 最小保存期間(日) | 特徴 |

|---|---|---|---|---|---|

| GCP Nearline | 32 | 384 | 0.01 | 30 | 月1回程度のアクセス、Synology対応 |

| GCP Coldline | 12 | 144 | 0.02 | 90 | 四半期1回程度のアクセス、Synology対応 |

| GCP Archive | 5 | 60 | 0.05 | 365 | 年1回以下のアクセス、Synology対応 |

| AWS S3 Glacier | 10 | 120 | 0.022 | 90 | 取り出し4-5時間、Synology対応 |

| AWS S3 Deep Archive | 1.98 | 23.76 | 0.022 | 180 | 取り出し12時間、最安価格 |

| Azure Archive | 4 | 48 | 0.022 | 180 | 取り出し15時間、Synology対応限定的 |

検討

ストレージクラス

GCS (Google Cloud Storage) のArchiveかColdlineをお勧めされている。

- Claude: Archive

- ChatGPT: Coldline

- Manus: Coldline

とColdlineが2票だが、今回の目的では災害時くらいしか取り出すことはないのでArchiveを採用。

リージョン

ChatGPTのみ、火事や落雷など自宅だけでなく、東京全体が被災した時のことを考慮して大阪リージョンへの保存を勧めている。採用。

Hyper Backupの増分バックアップについて追加質問

SynologyのHyper Backupで増分バックアップする場合、ストレージを利用する容量はNAS側の利用中の容量と同等と考えて良いか?

圧縮が効いたり、あるいは冗長になるのか?

また、復旧する際に取り出す容量も変化があるか?

回答 (Claude)

Hyper Backupの容量について、詳しく説明します。

バックアップ時の容量

NAS側の容量と同等にはなりません。 以下の要因で変動します:

容量が減る要因

-

圧縮機能

- デフォルトで有効(無効化も可能)

- 圧縮率はデータ種類により20-50%程度

- テキスト/ドキュメント: 高圧縮率

- 写真/動画: ほぼ圧縮されない

-

重複排除

- ブロックレベルの重複排除

- 同じファイルの複数コピーは1つ分の容量

容量が増える要因

-

バージョン管理

- 複数世代保持する場合は増加

- 例: 3世代保持で頻繁に更新されるファイルは3倍近くに

-

メタデータ

- バックアップ管理情報

- 全体の数%程度

実際の容量試算

実際のバックアップ容量 =

(元データ × 圧縮率) + (変更履歴 × 世代数) + メタデータ

例: 2TB使用中、平均圧縮率70%、3世代保持の場合

- 初回: 1.4TB程度

- 運用後: 1.4TB + 変更分の履歴

復旧時の取り出し容量

復旧方法により異なります:

1. 完全復旧(推奨)

- 取り出し容量: 圧縮されたバックアップサイズ

- 実際の転送量: 1.4TB程度(上記例の場合)

- Hyper Backupが自動で解凍・復元

2. 個別ファイル復旧

- 取り出し容量: 必要なファイルのみ

- 効率的だが手間がかかる

3. 特定時点への復旧

- 取り出し容量: ベースバックアップ + 該当時点までの差分

コスト影響(Archive利用時)

保存コスト(月額):

- 圧縮後1.4TB: $1.68/月

復旧コスト(全データ):

- 1.4TB取得: $70($0.05/GB)

推奨設定

- 圧縮: 有効(デフォルト)

-

世代管理:

- 週次: 4世代

- 月次: 2世代

- これで容量増加を抑制

-

除外設定:

- 一時ファイル

- ダウンロードフォルダ

- 既に別途バックアップがあるデータ

この設定なら、2TB使用でも実際のクラウド使用量は1.5TB前後に収まり、コストを抑えられます。

世代管理:

週次: 4世代

月次: 2世代

これで容量増加を抑制

について詳しく教えて。

現在1.4TBのデータがあり、毎週10GB増える場合で教えて。

回答

世代管理の仕組みと容量計算について詳しく説明します。

Hyper Backupの世代管理の仕組み

バックアップの種類

- 初回フルバックアップ: 1.4TB(圧縮後)

- 増分バックアップ: 変更・追加されたデータのみ(週10GB)

世代管理ルール(週次4世代、月次2世代)

時系列イメージ:

週1 週2 週3 週4 週5 週6 週7 週8 週9...

[W] [W] [W] [W] [M] [W] [W] [W] [M]...

W: 週次バックアップ(最新4つを保持)

M: 月次バックアップ(最新2つを保持)

容量計算の具体例

2ヶ月間の推移

1ヶ月目:

- 初回: 1.4TB(ベース)

- 週1: +10GB

- 週2: +10GB

- 週3: +10GB

- 週4: +10GB → 月次として保持

- 月末容量: 1.44TB

2ヶ月目:

- 週5: +10GB(週1分を削除)

- 週6: +10GB(週2分を削除)

- 週7: +10GB(週3分を削除)

- 週8: +10GB(週4は月次なので残る)→ 新月次

- 2ヶ月末容量: 1.48TB

定常状態での容量

ベースバックアップ: 1.4TB

週次4世代: 40GB(10GB × 4)

月次2世代: 80GB(40GB × 2)

---

合計: 約1.52TB

重要なポイント

1. 増分の重複について

- 同じファイルが複数回更新された場合、各世代で差分保存

- 例: 100MBのファイルを毎週更新 → 各世代で100MB必要

2. 削除されたファイルの扱い

- 削除情報も世代管理される

- 古い世代では「存在」、新しい世代では「削除済み」として記録

3. 実際の容量変動要因

容量が増える場合:

- 大きなファイルの頻繁な更新

- 多数のファイルの追加と削除の繰り返し

容量が増えにくい場合:

- 新規ファイルの追加が中心

- 既存ファイルの変更が少ない

より効率的な設定案

もし容量を更に抑えたい場合:

オプション1: 世代数削減

週次: 3世代

月次: 1世代

→ 定常容量: 約1.47TB(50GB削減)

オプション2: Smart Recycle

Hyper Backupの「Smart Recycle」機能:

- 古い世代を自動的に間引き

- 直近は密、過去は疎に保持

例: 7日分→4週分→2ヶ月分

コスト影響(Archive利用時)

1.52TB保存時:

- 月額: $1.82

- 年額: $21.84

全復旧時:

- 取得料金: $76(1.52TB × $0.05/GB)

週10GBの増加ペースなら、この世代管理設定で十分な保護レベルを保ちながら、容量増加を最小限に抑えられます。

GCP Archiveは最低保存期間365日だから5週目に1週目のデータを消すことはできないのでは?

回答

その通りです!重要な指摘をありがとうございます。

GCS Archiveクラスの制約

最低保存期間365日の制約により、以下の問題が発生します:

早期削除ペナルティ

- 365日以内に削除/上書きすると、365日分の料金が課金される

- 例: 30日で削除しても365日分の料金を支払う必要がある

Hyper Backupとの相性問題

実際の動作:

週1: +10GB → 365日間削除不可

週2: +10GB → 365日間削除不可

週3: +10GB → 365日間削除不可

...

週5: +10GB → 週1を削除したいが、ペナルティ発生!

容量増加の実態

1年後の実際の容量:

初回バックアップ: 1.4TB

週次増分(52週分): 520GB (10GB × 52)

---

合計: 約1.92TB(世代管理が効かない)

代替案の提案

1. Nearlineクラスの利用(推奨)

- 最低保存期間: 30日

- 世代管理が正常に機能

- 料金比較:

Archive(世代管理不可): 1.92TB × $0.0012 = $2.30/月 Nearline(世代管理可): 1.52TB × $0.01 = $15.20/月

2. バックアップ戦略の変更

Archiveを使う場合の最適化:

- 月次フルバックアップのみ(12世代/年)

- 日次の変更はNAS内で別途保護

- 年間容量: 約1.5TB程度に抑制可能

3. ハイブリッド構成

Nearline: 直近3ヶ月分(頻繁な世代管理)

Archive: 3ヶ月以上前の月次バックアップ

→ Lifecycle管理で自動移行

改訂版おすすめ構成

Nearline + Hyper Backup を推奨します:

理由

- 世代管理が正常に機能(30日後に削除可能)

- 総容量を1.52TBに抑制可能

- 年額コスト: 約$183(Archive使用時の$276より安い)

- 復旧も高速(Archive比)

設定

Hyper Backup設定:

- ストレージクラス: Nearline

- 週次: 4世代

- 月次: 2世代

- 圧縮: 有効

Archiveの365日制約は、増分バックアップには不向きで、結果的にNearlineの方がコスト効率が良くなります。

だめじゃん。

Synology Hyper Backupの仕組み

Claudeの回答がいまいち要領を得ないので追加で調べる。

増分バックアップ

1.4TBをNASに保存中で、毎週10GB増え、週次でバックアップするという設定なら初回に1.4TBバックアップし、以降毎週差分の10GBをバックアップする。

保存するバージョンを4世代としていたら、5世代目の保存時に1世代目を削除(マージ?)する。

GCSの最小保存期間との相性

GCSのNearline, Coldline, Archiveはそれぞれ30日、90日、365日の最小保存期間があり、その期間内のオブジェクトの削除、置き換え、移動は早期削除として扱われる。

早期削除に該当すると、その時点で最小期間保存された場合と同じ金額が請求される。

つまり、Archiveにアップロードしたファイルは365日削除できない(削除しても365日分の保存料金が発生する)。

以上より、増分バックアップはストレージ量への負担が小さい仕組みであるが、GCSの最小保存期間を考慮しないと無駄にコストがかかる。

最小保存期間が365日のArchiveで、週次バックアップをし、保存するバージョン数を4世代にしても意味がない。1世代目の増分バックアップは5週目に削除(マージ)されるが、52週目まで課金対象となってしまう。

よってバックアップサイクル×保存バージョン数がなるべく最小保存期間と一致していることが好ましい。

例えば月次バックアップにして、保存するバージョン数を12世代にするとか。

完全に勘違いしていた。

Claudeによる解説

世代数を超えたら何が起こるか

設定例:週次4世代の場合

週1: 世代1作成

週2: 世代2作成

週3: 世代3作成

週4: 世代4作成

週5: 世代5作成 → 世代1を自動削除(最古を削除)

保持される世代: 2, 3, 4, 5(常に最新4つ)

削除時の詳細動作

世代1削除時:

1. 世代1のメタデータ(スナップショット情報)削除

2. 世代1でのみ使用されているチャンクを特定

3. それらのチャンクを削除

4. 他の世代でも使用中のチャンクは保持

重要: データの実体(チャンク)は、どこかの世代で

使われている限り削除されない

チャンクと世代のスナップショット(どのチャンクを参照するか)は違う。

Claude解説

まさにその通りです!これがHyper Backupの重要なポイントです。

チャンクとスナップショットの関係

2層構造の理解

【データ層】チャンクプール

├── チャンクA(report.docxの初版)

├── チャンクB(report.docxの2版)

├── チャンクC(image.jpgのデータ)

├── チャンクD(movie.mp4の一部)

└── ... 実際のデータの断片

【メタデータ層】スナップショット(世代)

├── 世代1: 「AとCとDを組み合わせるとこの時点の状態」

├── 世代2: 「BとCとDを組み合わせるとこの時点の状態」

└── 世代3: 「BとCとEを組み合わせるとこの時点の状態」

具体的なイメージ

レゴブロックに例えると:

チャンクプール = レゴブロックの箱

- 赤いブロック、青いブロック、黄色いブロック...

スナップショット = 組み立て説明書

- 世代1の説明書: 「赤3個と青2個で車を作る」

- 世代2の説明書: 「赤2個と青3個と黄1個で飛行機を作る」

世代1を削除 = 説明書1を捨てる

→ でも、赤と青のブロックは世代2でも使うので残す

この仕組みのメリット

1. ストレージ効率

10個のファイルのうち1個だけ変更した場合:

- 従来: 10個全部を再保存(10倍の容量)

- Hyper Backup: 変更した1個分のチャンクのみ追加

2. 高速バックアップ

増分バックアップ時:

- 変更されたファイルを検出

- 新しいチャンクのみアップロード

- スナップショット(メタデータ)を更新

→ 転送量最小限

3. 柔軟な世代管理

世代削除時:

- スナップショット削除: 瞬時(メタデータのみ)

- チャンク削除: 参照カウント0のもののみ

- 他の世代に影響なし

GCSでの実際の保存

GCS上の構造:

/hyperbackup-task/

├── chunks/ # 実データ(重い)

│ ├── 00/

│ │ ├── 00a3f2... (実際のデータ片)

│ │ └── 00b5c8...

│ └── ff/

├── metadata/ # スナップショット(軽い)

│ ├── 2025-01-01/ # どのチャンクをどう組み合わせるか

│ ├── 2025-01-08/

│ └── 2025-01-15/

だからArchiveが問題になる理由

Nearlineの場合:

1. 世代1のスナップショット削除 → OK(メタデータは小さい)

2. 不要チャンク削除 → 30日後ならOK

Archiveの場合:

1. 世代1のスナップショット削除 → OK

2. 不要チャンク削除 → 365日制約でNG!

→ チャンクが削除できず蓄積

この2層構造の理解により、なぜNearlineが推奨されるかがより明確になりましたね。スナップショット(世代)の管理とチャンクの管理が分離されているからこそ、効率的なバックアップが可能になっているわけです。

が、最後のNearlineが推奨される理由は不明。

追加で質問

メタデータはどの程度の重さになるのですか?参照のみを記しているのであればそれほど大きいファイルとは思えません。

また家族写真のバックアップという性質上、不要チャンクを削除することは稀です。基本的には追加される一方です。

であれば、大した容量ではないメタデータが365日の保存期間が適用されても大きな問題ではないと思いましたがどうでしょうか?

回答

素晴らしい観察です!家族写真という用途を考えると、確かに違った見方ができますね。

メタデータのサイズ

実際の容量

メタデータの構成:

- ファイルパス、名前、属性

- チャンク参照リスト

- タイムスタンプ、権限情報

サイズ目安:

- 1ファイルあたり: 数KB〜数十KB

- 10万ファイルでも: 数GB程度

- 全体の0.1〜0.5%程度

家族写真バックアップの特性

データの特徴

追加パターン:

- 新規写真の追加: 99%

- 写真の削除: ほぼなし

- 写真の更新: なし(写真は変更しない)

チャンクの動き:

- 新規チャンク: 追加のみ

- 既存チャンク: 削除されない

- 重複排除: 同じ写真をコピーした場合のみ

Archiveクラス再評価

あなたの指摘通りの利点

写真バックアップでのArchive:

1. チャンク削除がほぼ発生しない

→ 365日制約の影響なし

2. メタデータは小さい

→ 削除時のペナルティも小さい(数円程度)

3. コスト試算(2TB、年520GB増加):

Archive:

- 保存: $2.88/月(2.4TB)

- ペナルティ: ほぼゼロ

Nearline:

- 保存: $24/月(2.4TB)

推奨構成の見直し

家族写真用:Archive + Hyper Backup

設定:

ストレージ: GCS Archive

バックアップ設定:

- 月次: 12世代(1年分)

- 週次: なし(写真なら月次で十分)

- 圧縮: 無効(JPEGは圧縮済み)

メリット:

- 年額コスト: 約$35(Nearlineの1/5)

- 世代管理のペナルティ: 無視できるレベル

- 長期保存に最適

注意点:

復旧時:

- 取得料金: $0.05/GB

- 全復旧(2TB): $100

- 部分復旧なら影響小

用途別の最適解

1. 家族写真(追加型データ)

推奨: Archive

理由: 削除がなく、アクセス頻度低い

年額: $35程度

2. 一般的なNASデータ(更新型データ)

推奨: Nearline

理由: ファイル更新で古いチャンク削除発生

年額: $183程度

3. 作業ファイル(頻繁な更新)

推奨: Standard

理由: 頻繁なアクセスと更新

年額: $480程度

結論

家族写真のバックアップならArchiveが最適です!

あなたの分析は正確で、私の最初の推奨は一般的なケースを想定しすぎていました。写真という「追加のみ」のデータ特性を考慮すると、Archiveの365日制約はほとんど問題になりません。

年額$35で2TBの写真を安全に保護できるのは、非常にコスト効率の良い選択です。

納得した。GCS Archiveでいいな。

ここまでのまとめ by Claude

Synology NASの災害対策クラウドバックアップ完全ガイド

背景と目的

現状

- NAS: Synology DS220+ (Seagate IronWolf 2TB × 2台、SHR構成)

- 保存データ: 家族写真(現在2TB使用中、年間約500GB増加)

- 所在地: 東京

- 課題: 火災、落雷、地震などの災害に備えたオフサイトバックアップが必要

要件

- クラウド: GCP(Google Cloud Platform)を使用

- コスト: 目的を満たす範囲で最安値を追求

- 災害対策: 東京の大規模災害にも対応

GCSストレージクラスの詳細比較

4つのストレージクラス

| クラス | 月額料金/GB | 最低保存期間 | 早期削除時 | 取得料金/GB | 想定アクセス頻度 |

|---|---|---|---|---|---|

| Standard | $0.023 | なし | ペナルティなし | なし | 頻繁(月複数回) |

| Nearline | $0.013 | 30日 | 30日分課金 | $0.01 | 月1回程度 |

| Coldline | $0.007 | 90日 | 90日分課金 | $0.02 | 四半期に1回 |

| Archive | $0.0025 | 365日 | 1年分課金 | $0.05 | 年1回以下 |

※東京リージョン(asia-northeast1)の料金

家族写真バックアップでのコスト比較(2TB初期、年500GB増加)

| ストレージクラス | 2年後の容量 | 月額料金 | 年額料金 | 全復旧時コスト |

|---|---|---|---|---|

| Standard | 3TB | $69.00 | $828 | $0 |

| Nearline | 3TB | $39.00 | $468 | $30 |

| Coldline | 3TB | $21.00 | $252 | $60 |

| Archive | 3TB | $7.50 | $90 | $150 |

災害対策のためのリージョン選択

東京からの災害対策として推奨されるリージョン

-

推奨: asia-northeast3(ソウル)

- 東京から約1,200km(直線距離)

- 地震の地質構造が異なる

- ネットワーク遅延が低い

- 同じアジア圏で規制面での懸念が少ない

-

代替案: asia-southeast1(シンガポール)

- 東京から約5,300km

- 地震リスクが極めて低い

- 政治的に安定

- やや遠いため復旧時のデータ転送に時間がかかる

-

考慮事項

- 「地域的な停止を軽減するには、セカンダリリージョンへのデータ複製」が推奨される

- 日本国内の他リージョンは大規模地震で同時被災の可能性あり

Hyper Backupの技術詳細(再整理)

動作原理

-

ブロックレベル重複排除

- データを小さなチャンク(ブロック)に分割

- 同一チャンクは1つだけ保存

- 写真データでは重複が少ないため効果は限定的

-

世代管理の仕組み

チャンクプール: 実際のデータブロック スナップショット: 各時点でどのチャンクを組み合わせるかの情報 -

家族写真の特性

- 追加のみでほぼ削除なし → チャンク削除が発生しない

- JPEGは既に圧縮済み → 追加圧縮効果なし

- メタデータは極小(全体の0.1%程度)

最終推奨構成

【推奨】Coldline + Hyper Backup + ソウルリージョン

構成詳細:

ストレージ: Google Cloud Storage Coldlineクラス

リージョン: asia-northeast3(ソウル)

Hyper Backup設定:

- スケジュール: 月1回(毎月第1日曜日深夜)

- 世代管理: 12世代(1年分)

- 圧縮: 無効(JPEGは圧縮済み)

- 暗号化: 有効(クライアント側AES-256)

- 通知: バックアップ失敗時にメール通知

選定理由:

-

Coldlineが最適な理由

- 「四半期に1回以下のアクセス頻度のデータに最適」

- 家族写真の復旧は災害時のみ(年1回以下)

- 90日の最低保存期間は写真データに影響なし

- Archiveより復旧が高速(ミリ秒でアクセス可能)

-

月次バックアップの妥当性

- 写真は月単位でまとめて整理する家庭が多い

- 災害時に最大1ヶ月分の写真喪失は許容範囲

- バックアップ頻度を下げることで運用負荷軽減

-

ソウルリージョンの優位性

- 東京と異なる地震帯

- データ主権の問題なし

- 復旧時のネットワーク速度良好

コスト試算(3年間):

初期設定: 約30分の作業

月次コスト:

- 1年目: $14/月(2TB)

- 2年目: $17.50/月(2.5TB)

- 3年目: $21/月(3TB)

3年間総額: 約$630(約9.5万円)

災害復旧時: $60(3TB取得、一度きり)

代替案:Archive(コスト最重視の場合)

Archiveクラスを選択すれば年額$90(約1.4万円)まで削減可能ですが、以下のトレードオフがあります:

- 復旧に時間がかかる可能性

- 365日の保存期間制約

- 将来的な柔軟性が低下

実装手順

-

GCPプロジェクトの作成

- 請求アカウントの設定

- Cloud Storage APIの有効化

-

バケットの作成

名前: family-photos-backup-[ランダム文字列] ロケーション: asia-northeast3 ストレージクラス: Coldline アクセス制御: 均一 -

サービスアカウントの作成

- 必要な権限: Storage Object Admin

- 認証キーのダウンロード

-

Hyper Backupの設定

- S3互換として設定

- エンドポイント: storage.googleapis.com

- 認証情報の入力

-

初回バックアップ

- 夜間や週末に実施(2TB転送に24-48時間)

- 進捗モニタリング

まとめ

家族写真という「追加型データ」の特性と東京の災害リスクを考慮すると、GCS Coldlineクラス + Hyper Backup + ソウルリージョンの組み合わせが最適です。

この構成により:

- 年額約$250(約3.8万円)という手頃なコストで

- 東京の大規模災害からも確実に保護され

- 必要時には迅速に全データを復旧可能

大切な家族の思い出を、手軽かつ確実に守ることができます。

いや、Coldlineは高いな。

シンガポールリージョンのArchiveなら1GBあたり月額$0.0015。Coldlineの30%。

年1万円くらいで収まる。

これにしよう。

Claudeの提案と私の選択のコスト比較(3TB時点)

| コスト項目 | Coldline(ソウル) | Archive(シンガポール) | 差額 |

|---|---|---|---|

| 月額料金 | $21.00 | $4.50 | -$16.50(-79%) |

| 年額料金 | $252 | $54 | -$198(-79%) |

| 10年間総額 | $2,730 | $765 | -$1,965(-72%) |

| 災害時復旧(3TB) | $60 | $150 | +$90(+150%) |

アイオワ(us-central1)が最安だということを発見。

シンガポールよりさらに安く$0.0012(20%安)。

比較 by Claude

推奨構成の比較表(アイオワ追加版)

基本仕様比較

| 項目 | Claudeの提案 Coldline(ソウル) |

私の選択 Archive(シンガポール) |

最安値案 Archive(アイオワ) |

|---|---|---|---|

| ストレージクラス | Coldline | Archive | Archive |

| リージョン | asia-northeast3(ソウル) | asia-southeast1(シンガポール) | us-central1(アイオワ) |

| 東京からの距離 | 約1,200km | 約5,300km | 約10,500km |

| 最低保存期間 | 90日 | 365日 | 365日 |

| アクセス想定 | 四半期に1回以下 | 年1回以下 | 年1回以下 |

コスト比較(3TB時点)

| コスト項目 | Coldline(ソウル) | Archive(シンガポール) | Archive(アイオワ) |

|---|---|---|---|

| 月額料金 | $21.00 | $4.50 | $3.60 |

| 年額料金 | $252 | $54 | $43.20 |

| 10年間総額 | $2,730 | $765 | $612 |

| 災害時復旧(3TB) | $60 | $150 | $150 |

| ネットワーク転送料 | $0(同一大陸) | $0(同一大陸) | +$360(国際転送) |

| 災害時総コスト | $60 | $150 | $510 |

10年間コスト詳細(6.5TB時点)

| 項目 | Coldline(ソウル) | Archive(シンガポール) | Archive(アイオワ) |

|---|---|---|---|

| 保存料金(10年) | $5,915 | $1,657 | $1,326 |

| 災害復旧(6.5TB) | $130 | $325 | $325 |

| ネットワーク転送 | $0 | $0 | $780 |

| 10年間総額 | $6,045 | $1,982 | $2,431 |

機能・性能比較

| 評価項目 | Coldline(ソウル) | Archive(シンガポール) | Archive(アイオワ) |

|---|---|---|---|

| コスト効率(保存) | ★★★☆☆ | ★★★★☆ | ★★★★★ |

| コスト効率(復旧込) | ★★★★☆ | ★★★★☆ | ★★★☆☆ |

| 復旧速度 | ★★★★★ 1-2日 |

★★★☆☆ 3-5日 |

★★☆☆☆ 5-7日 |

| 災害対策 | ★★★★☆ 地震帯は異なる |

★★★★★ 地震リスクほぼゼロ |

★★★★★ 別大陸で完璧 |

| データ主権 | ★★★★★ アジア圏内 |

★★★★★ アジア圏内 |

★★★☆☆ 米国保管 |

地理的リスク分散

| リスク要因 | ソウル | シンガポール | アイオワ |

|---|---|---|---|

| 地震リスク | 中 | 極低 | 極低 |

| 台風・洪水 | 中 | 低 | 低(竜巻はあり) |

| 地政学的リスク | 中 | 低 | 低 |

| 東京との同時被災 | 低 | 極低 | なし |

ユースケース別推奨

| シナリオ | 推奨 | 理由 |

|---|---|---|

| 保存コスト最優先 | アイオワ | 月額$3.60は最安 |

| 総合コスト重視 | シンガポール | 復旧時の転送料込みで最安 |

| バランス重視 | ソウル | コストと利便性の両立 |

| データ主権重視 | シンガポール/ソウル | アジア圏内で完結 |

| 究極の災害対策 | アイオワ | 別大陸で地理的に完全分離 |

最終評価

Archive(アイオワ)の特徴

✅ 保存料金は世界最安 - 月額$3.60(約550円)

✅ 究極の地理的分散 - 太平洋を挟んだ別大陸

✅ 10年で約2万円の節約(シンガポール比)

❌ 復旧時は高額 - ネットワーク転送料で総額$510

❌ 復旧に1週間程度 - 距離による遅延

❌ データが米国保管 - 管轄権の違い

結論

人生で1-2回の復旧なら、アイオワも合理的な選択:

- 保存料金の安さは圧倒的(10年で$331節約)

- 復旧1回分の追加コスト($360)を考慮しても総額では安い

- 別大陸保管による究極の災害対策

ただし、以下の場合はシンガポールを推奨:

- 2回以上復旧する可能性がある

- データの保管場所を気にする(米国法の管轄を避けたい)

- アジア圏内で完結させたい

「保険」と割り切るなら、アイオワの月額$3.60は魅力的です。

なるほど、大陸またぐとネットワーク転送料がかかるのか。

NASの復旧ってどれくらい起きるリスクあるんだろう?

Claude調査

NAS復旧の必要性:統計データに基づく分析

NASハードウェアの故障率

メーカー別の信頼性

「Synologyの故障率はおそらく最も低い」との評価がある一方で、実際の故障事例も報告されています:

- Synology: 一般的に高い信頼性で知られるが、DS916+モデルで問題報告あり

- QNAP: TS-328モデルで「極めて高い故障率」が報告され、2ヶ月で故障した事例も

- HDD故障率: WD Redで8年間で約30%の故障率が報告されている

災害発生確率(日本)

住宅火災

- 年間発生件数: 2022年に約10,780件の住宅火災(放火除く)

- 全火災件数: 2022年に約36,300件の火災

- 発生確率: 日本の世帯数(約5,300万)から計算すると、年間約0.02%(5,000世帯に1件)

地震(東京)

- 首都直下地震の30年以内発生確率:約70%

- ただし、個別住宅への被害確率はさらに低い

落雷

- 年間落雷数:約100万回(日本全体)

- 住宅への直撃確率:極めて低い(0.001%未満)

総合的なNAS復旧リスク評価

| リスク要因 | 年間発生確率 | 10年累積確率 | 30年累積確率 |

|---|---|---|---|

| HDD故障 | 3-5% | 26-40% | 55-78% |

| NAS本体故障 | 1-2% | 10-18% | 26-45% |

| 火災被害 | 0.02% | 0.2% | 0.6% |

| 地震被害 | 0.1-0.5% | 1-5% | 3-14% |

| 落雷被害 | <0.001% | <0.01% | <0.03% |

| 総合リスク | 4-7% | 35-60% | 70-90% |

復旧シナリオ別の確率

30年間での復旧必要性

- ハードウェア故障による復旧: 60-80%(ほぼ確実)

- 災害による完全復旧: 5-15%(可能性あり)

- 複数回の復旧: 20-30%(HDD交換など)

結論:バックアップ戦略への影響

統計データが示す重要な示唆:

-

ハードウェア故障が最大のリスク

- 30年で2-3回のHDD交換が必要

- NAS本体も1回は故障する可能性大

-

災害リスクは低いが影響大

- 火災・地震の確率は低い(年0.1%程度)

- しかし発生時は全データ喪失

-

クラウドバックアップの必要性

- ハードウェア故障:RAID構成で対応可能

- 災害対策:オフサイトバックアップが必須

アイオワArchiveの合理性:

- 災害による完全復旧は「30年で1-2回」程度

- 復旧時の転送料($360)を考慮しても十分安価

- 月額$3.60は「究極の保険」として妥当

この統計分析により、災害対策としてのクラウドバックアップは必須であり、頻度の低さを考慮すればアイオワArchiveの選択は極めて合理的です。

OK。アイオワArchiveに決定。

作業案内

by Claude

GCP アイオワArchiveでのNASバックアップ設定ガイド

事前準備

必要なもの

- Googleアカウント(GCP用)

- クレジットカード(請求設定用)

- Synology NASへの管理者アクセス

- 安定したインターネット接続

ステップ1:GCPプロジェクトの作成

1-1. GCPコンソールへアクセス

- https://console.cloud.google.com にアクセス

- Googleアカウントでログイン

1-2. 新規プロジェクト作成

1. 画面上部の「プロジェクトを選択」をクリック

2. 「新しいプロジェクト」をクリック

3. プロジェクト名: family-photos-backup

4. 「作成」をクリック

1-3. 請求アカウントの設定

1. 左メニュー → 「お支払い」

2. 「請求先アカウントをリンク」

3. クレジットカード情報を入力

4. 請求先住所等を設定

ステップ2:Cloud Storageバケットの作成

2-1. Cloud Storageへ移動

1. 左メニュー → 「Cloud Storage」→「バケット」

2. 「作成」をクリック

2-2. バケット設定

バケット名: family-photos-[ランダム8文字]

例: family-photos-a3b7c9d2

※グローバルで一意である必要があります

ロケーションタイプ: Region

リージョン: us-central1 (アイオワ)

ストレージクラス: Archive

アクセス制御: 均一(推奨)

詳細設定:

- 暗号化: Google管理(デフォルト)

- 保持ポリシー: 設定しない

- バージョニング: 無効

2-3. 作成確認

「作成」をクリックして、バケットが作成されることを確認

ステップ3:サービスアカウントの作成

3-1. IAMへ移動

1. 左メニュー → 「IAMと管理」→「サービスアカウント」

2. 「サービスアカウントを作成」をクリック

3-2. サービスアカウント詳細

サービスアカウント名: synology-backup

サービスアカウントID: synology-backup(自動入力)

説明: Synology NAS backup service account

3-3. 権限の付与

ロールを選択:

- Cloud Storage → Storage Object Admin

(オブジェクトの作成・削除・一覧表示が可能)

3-4. キーの作成

1. 作成したサービスアカウントをクリック

2. 「キー」タブ → 「鍵を追加」→「新しい鍵を作成」

3. キーのタイプ: JSON

4. 「作成」をクリック

5. JSONファイルが自動ダウンロード(重要:安全に保管)

ステップ4:S3互換APIの有効化

4-1. APIライブラリへ移動

1. 左メニュー → 「APIとサービス」→「ライブラリ」

2. 「Cloud Storage」で検索

3. 「Cloud Storage API」をクリック

4. 「有効にする」をクリック(既に有効な場合はスキップ)

4-2. S3互換認証情報の作成

1. Cloud Storageコンソールに戻る

2. 「設定」→「相互運用性」タブ

3. 「サービスアカウントのHMACキー」セクション

4. 「キーを作成」をクリック

5. サービスアカウント: synology-backup を選択

6. 「作成」をクリック

4-3. 認証情報の保存

アクセスキー: GOOG1XXXXXXXXXXXXXXXXX

シークレット: XXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXX

※これらの情報を安全に保管

ステップ5:Synology Hyper Backup設定

5-1. Hyper Backupを開く

1. DSMにログイン

2. パッケージセンター → Hyper Backup

3. 初回起動の場合は「今すぐバックアップ」

5-2. バックアップ先の設定

1. 「+」→「データバックアップタスク」

2. バックアップ先: 「S3 Storage」を選択

3. 「次へ」

5-3. S3設定

S3サーバー: カスタムサーバーURL

サーバーアドレス: storage.googleapis.com

署名バージョン: v4

アクセスキー: [ステップ4-3のアクセスキー]

シークレットキー: [ステップ4-3のシークレット]

バケット名: family-photos-[あなたのバケット名]

ディレクトリ: /backup(任意)

5-4. 接続テスト

「次へ」をクリックして接続が成功することを確認

ステップ6:バックアップ設定

6-1. バックアップするフォルダの選択

推奨フォルダ:

☑ /photo(写真フォルダ)

☑ /video(動画フォルダ)

□ その他のフォルダ(必要に応じて)

6-2. アプリケーション設定

アプリケーションのバックアップ:

- 今回はスキップ(データのみバックアップ)

6-3. バックアップ設定

タスク名: GCP-Archive-Backup

圧縮を有効化: いいえ(写真は既に圧縮済み)

暗号化を有効化: はい

- パスワード: [強固なパスワード]

- パスワード確認: [同じパスワード]

※重要:このパスワードは必ず記録・保管

バックアップスケジュール:

- スケジュールを有効化: はい

- 頻度: 毎月

- 日付: 第1日曜日

- 時刻: 02:00(深夜2時)

バックアップローテーション:

- Smart Recycle: 無効

- バージョン数: 6(6ヶ月分)

バックアップ検証:

- 定期的にバックアップデータの整合性を確認: 有効

ステップ7:初回バックアップ

7-1. バックアップ開始

1. 「適用」をクリック

2. 「今すぐバックアップ」で初回実行

3. 進捗状況を確認

7-2. 転送時間の目安

2TBの初回バックアップ:

- 100Mbps回線: 約48時間

- 1Gbps回線: 約5-8時間

※実際の速度は回線状況により異なる

7-3. 完了確認

1. Hyper Backupで「成功」ステータス確認

2. GCPコンソールでオブジェクト確認

- Cloud Storage → バケット → オブジェクト

ステップ8:監視と通知設定

8-1. DSM通知設定

1. DSMコントロールパネル → 通知

2. 電子メール設定

3. 通知フィルター:

- Hyper Backup: すべて有効

8-2. GCP予算アラート

1. GCPコンソール → お支払い → 予算とアラート

2. 「予算を作成」

3. 名前: Archive Storage Budget

4. 金額: $10/月

5. しきい値: 50%, 90%, 100%

6. 通知先: あなたのメールアドレス

ステップ9:復旧手順の確認

復旧時の手順(メモとして保管)

1. GCPコンソールにログイン

2. Cloud Storage → バケット選択

3. オブジェクトを選択 → ダウンロード

4. または、Hyper Backup Explorerを使用:

- PCにインストール

- S3互換で接続

- 必要なファイルを選択復元

重要な注意事項

セキュリティ

- JSONキーファイルは安全な場所に保管

- Hyper Backupの暗号化パスワードは必ず記録

- GCPの2段階認証を有効化推奨

コスト管理

- 初月は無料クレジット($300)を活用

- 定期的に請求額を確認

- 不要な世代は手動で削除可能(365日後)

トラブルシューティング

- 接続エラー: ファイアウォール設定確認

- 認証エラー: アクセスキーの再確認

- 容量エラー: バケットの容量制限なし

まとめ

これで設定は完了です。月額約$3.60で、大切な家族写真が災害から完全に保護されます。初回バックアップ後は、月1回自動でバックアップが実行されるため、特別な操作は不要です。

設定で不明な点があれば、お気軽にお尋ねください。

ステップ1~4: GCP設定

Cloud Storageにバケット作成し、サービスアカウントなども発行。

Cloud Shellで以下を試して全て正常に実行できることを確認。GCP側の設定はOK。

# 1. GCPコンソール右上の「Cloud Shell」アイコン(>_)をクリック

# 2. 認証情報を設定

export AWS_ACCESS_KEY_ID="GOOG1XXXXXXXXXXXXX"

export AWS_SECRET_ACCESS_KEY="XXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXX"

# 3. gsutilでテスト(バケット一覧表示)

gsutil -o Credentials:gs_access_key_id=$AWS_ACCESS_KEY_ID \

-o Credentials:gs_secret_access_key=$AWS_SECRET_ACCESS_KEY \

ls

# 4. 特定のバケットへのアクセステスト

gsutil -o Credentials:gs_access_key_id=$AWS_ACCESS_KEY_ID \

-o Credentials:gs_secret_access_key=$AWS_SECRET_ACCESS_KEY \

ls gs://the-yamadas-photos-XXXXX/

# 5. 書き込みテスト

echo "test" > test.txt

gsutil -o Credentials:gs_access_key_id=$AWS_ACCESS_KEY_ID \

-o Credentials:gs_secret_access_key=$AWS_SECRET_ACCESS_KEY \

cp test.txt gs://the-yamadas-photos-XXXXX/test.txt

# 6. 削除テスト

gsutil -o Credentials:gs_access_key_id=$AWS_ACCESS_KEY_ID \

-o Credentials:gs_secret_access_key=$AWS_SECRET_ACCESS_KEY \

rm gs://the-yamadas-photos-XXXXX/test.txt

ステップ5~: Hyper Backup設定

Claudeの案内通りに進めるが、Bucket名を選択するとエラーが発生する。

「このバックアップ先の共有フォルダにアクセスする権限がありません。システム管理者にお尋ねください」と表示。

Claudeに詳しく聞いてみるとHyper BackupはGCSに対応していないとのこと。

ここまでの内容をまとめて、本当にHyper BackupはGCSに対応していないかChatGPTにも聞いてみる。

Claude まとめ

Synology NASのクラウドバックアップ検討まとめ

背景

東京在住で、Synology DS220+(2TB使用中)に保存している家族写真を、火災・地震・落雷などの災害から守るためのオフサイトバックアップを検討しています。年間約500GB増加し、30年間の長期保存を想定しています。

要件

- データ: 家族写真(追加のみ、削除・更新なし)

- 予算: できるだけ安く

- 復旧頻度: 人生で1-2回程度を想定

検討したオプション

1. Google Cloud Storage (GCS)

調査の結果、以下の構成に決定:

- ストレージクラス: Archive($0.0012/GB/月)

- リージョン: us-central1(アイオワ)

- 月額: 約$3.60(3TB時点)

問題点

Hyper BackupがGCSに対応していないことが判明。

- S3互換APIは提供されているが、Hyper Backupでは「バックアップ先の共有フォルダにアクセスする権限がありません」エラーが発生

- 署名バージョンv4、正しい認証情報でも接続不可

- フォーラム情報によると、Cloud Syncは動作するが、Hyper BackupはカスタムURLに非対応

代替案:Cloud Sync使用

- ミラーリング方式(差分同期は可能)

- 世代管理なし

- ファイル名は暗号化されない

2. AWS S3(比較検討)

- ストレージクラス: Glacier Deep Archive($0.00099/GB/月)

- 月額: 約$2.97(3TB時点)

- Hyper Backup: 完全対応

- メタデータ追加料金: 実質無視できるレベル(0.8%程度)

コスト比較(3TB、30年間)

| 項目 | GCS Archive | AWS S3 Deep Archive |

|---|---|---|

| 保存料金(30年) | $1,296 | $1,069 |

| 災害復旧時 | $510 | $60 |

| 総額 | $1,806 | $1,129 |

| Hyper Backup | ❌ | ✅ |

| 設定難易度 | 済み | 要新規設定 |

相談したい点

1. Hyper BackupのGCS対応について

私の調査では接続できませんでしたが:

- 本当にHyper BackupはGCSに非対応なのか?

- 何か回避策はないか?

- DSMバージョンや設定で解決できる可能性は?

2. Cloud Sync vs Hyper Backup

家族写真のバックアップにおいて:

- Cloud Syncのミラーリングで十分か?

- 世代管理は本当に必要か?

- 他に考慮すべき点はあるか?

3. AWS vs GCS

- 月額差$0.63のために、AWSに乗り換える価値はあるか?

- 既にGCS設定済みの状況で、どちらを選ぶべきか?

現在の状況

GCSは設定完了していますが、Cloud Syncでの運用となるため、最終決定前に皆様のご意見を伺いたいです。特に、Hyper BackupでGCSを使う方法があれば教えていただけると幸いです。

よろしくお願いします。

Hyper BackupのGCS対応について

ChatGPT回答

以下では DSM 7.2 + Hyper Backup 4.1(2025年7月時点の最新版) を前提に、いただいた3つの論点を整理します。各価格はすべて USD/GB‑month で、7 月 20 日現在の公式ページを引用しています。

1. Hyper Backup は GCS に「正式対応」しているか

■ 結論

- Hyper Backup に “Google Cloud Storage” という専用プロファイルはありません が、メニューの

「S3 Storage → Custom Server」 を使えば S3 互換API(XML API)経由で問題なく動作 します。(Synology, SynoForum) - フォーラムでも AWS・Storj と並んで GCP で稼働中 の報告が多数あります(同エラーが Scaleway で再現した事例では「バケット名を変えたら解決した」との記載)。(SynoForum)

■ 安定接続のチェックリスト

| チェックポイント | 説明 |

|---|---|

| HMAC(Interoperability)キー | Cloud Console > Storage > “Interoperability” から Access key / Secret を発行し、V4 署名を有効化。 |

| エンドポイント |

https://storage.googleapis.com(または https://<region>-storage.googleapis.com)。ポート・プレフィクスは不要。 |

| バケット名 | DNS 互換(英小文字・数字・ハイフンのみ)、ピリオド禁止。既存オブジェクトと同名プレフィクスが無いことを確認。 |

| 権限 | バケット > 権限 > HMACキーのサービスアカウント に「Storage Object Admin」以上を付与。 |

| フォルダ | Hyper Backup は <タスク名>_1/ を自動生成する。ルート直下に同名フォルダやオブジェクトがあると「権限エラー」が発生。 |

| DSM/Hyper Backup | DSM 7.2 + Hyper Backup 4.1 以上。最新版では S3 周りのバグ修正(接続直後に Offline になる問題など)が含まれています。(Synology) |

回避策が見つからない場合

- rclone Container での同期、2) Synology C2 Storage、3) AWS へ移行――の順に検討すると運用実績が多いです。

2. Cloud Sync と Hyper Backup の比較 ― 写真アーカイブ用途なら?

| 機能 | Cloud Sync | Hyper Backup |

|---|---|---|

| 動作モデル | リアルタイム/差分ミラー | スケジュール・スナップショット方式 |

| 世代管理 | なし(単一コピー) | 最大 65,535 世代(Smart Recycle 等) |

| 重複排除・圧縮 | なし | ブロック単位で重複排除+圧縮 |

| クライアント側暗号化 | 可能だがファイル名は平文 | 可能・暗号化後は 1つの *.hbk |

| 削除伝搬 | 「アップロードのみ」設定で無効化可 | リテンションポリシで制御 |

| 復元 | そのままファイル取得 | Hyper Backup Explorer/DSM からポイントインタイム復元 |

● 写真(追記のみ)に必要な最低限

- 誤削除の伝搬を防ぐ → Cloud Sync を使うなら「一方向(NAS→クラウド)」「ローカル削除をクラウドへ反映しない」を必ず選択。

- 世代管理 は「破損検出」や「ランサム対策」に有効だが、JPEG/HEIF のみで編集しない運用なら必須ではありません。

- プライバシー を重視しファイル名も隠したいなら Hyper Backup が有利。

結論

- 「最安・シンプル」を優先 → Cloud Sync(アップロードのみ)

- 「長期でフォルダ構造と世代も守りたい」 → Hyper Backup を推奨。

3. AWS S3 Glacier Deep Archive vs GCS Archive の最新コスト比較(3 TB を 30 年保存)

| 項目 | GCS Archive (us‑central1) | AWS S3 Glacier Deep Archive |

|---|---|---|

| 保存単価/GB‑month | $0.0014 (Google Cloud) | $0.00099 (Amazon Web Services, Inc.) |

| 月額(3 TB) | $4.30 | $3.04 |

| 30 年保存 | $1,548 | $1,095 |

| 1回復旧費(3 TB) | 3,072 GB × $0.05/GB = $154 (Google Cloud) | 3,072 GB × $0.02/GB = $61 (標準取出し) |

| 取出し時間 | 数秒(オンライン) | 12 – 48 h(取出しリクエスト→復元) |

| Hyper Backup対応 | S3互換で可 | ネイティブ |

差額は月額 ~$1.3、30 年で ~$450。

“人生で 1–2 回しか復旧しない”前提なら AWS がトータル最安。ただし

- 復旧を「すぐ見たい・選んで1枚だけ取り出したい」なら GCS の即時性が大きなメリット。

- 既に 2 TB アップロード済み&運用が回っているなら、再アップロードの手間と通信コスト も無視できません。

まとめと推奨シナリオ

-

まず Hyper Backup + GCS で再挑戦

- 上記チェックリスト通り新規バケット+HMACキーで“バックアップタスク > S3 Storage”を設定。

- 成功すれば「世代管理 + 圧縮 + 即時取出し」を兼ねたまま、月 4 ドル強で運用可能。

-

失敗した場合の分岐

- プライバシー<コスト → AWS Glacier Deep Archive (+ Hyper Backup) へ移行。

- コスト<手間/即時復旧 → GCS + Cloud Sync(Upload‑only)で続行し、必要なら世代管理はローカル Snapshot で補完。

-

長期増加(17 TB 想定)を見据えるなら

- 30 年総額は AWS ≒ $6.2 k、GCS ≒ $8.8 k。差額 $2.6 k を「取出し速度」と「再設定の手間」でペイできるかが判断基準。

- 途中でより安価なストレージ(例:Backblaze B2、Wasabi)へ再移行する柔軟性も確保しておくと安心です。

最後に

- DSM と各パッケージは常に最新へアップデート(S3 接続周りの不具合修正が頻繁に入ります)。

- 年 1 回は 整合性チェック(Hyper Backup の「バックアップ検証」機能)を実行しておくと、30 年後の安心感が段違いです。

ご家族の大切な写真が安全に保管されることを願っています。疑問点があればお気軽にどうぞ!

Manus回答

Synology NASクラウドバックアップ戦略 総合調査レポート

エグゼクティブサマリー

本レポートは、Synology DS220+(2TB使用中)に保存されている家族写真の災害対策バックアップ戦略について、Hyper BackupのGoogle Cloud Storage(GCS)対応状況、Cloud SyncとHyper Backupの機能比較、AWSとGCSのコスト比較を詳細に調査し、最適な解決策を提案するものです。

主要な調査結果

-

Hyper BackupのGCS対応: 実質的に非対応。S3互換API経由での接続は技術的に可能だが、ストレージクラス制御の問題により実用性に欠ける。

-

Cloud Sync vs Hyper Backup: 家族写真バックアップにおいては、Cloud Syncは確実性、Hyper Backupは世代管理機能で優位性を持つ。

-

コスト比較: AWS S3 Glacier Deep Archiveが30年間で約25.5%($378)安い。

推奨案

状況別推奨案:

- コスト最優先: AWS S3 + Hyper Backup

- 確実性優先: GCS + Cloud Sync(既設定活用)

- バランス重視: AWS S3 + Hyper Backup(新規設定の価値あり)

1. 調査背景と目的

1.1 背景

東京在住のユーザーが、Synology DS220+(2TB使用中)に保存している家族写真を、火災・地震・落雷などの災害から守るためのオフサイトバックアップ戦略を検討。年間約500GB増加し、30年間の長期保存を想定している。

1.2 要件

- データ: 家族写真(追加のみ、削除・更新なし)

- 予算: できるだけ安く

- 復旧頻度: 人生で1-2回程度を想定

- 保存期間: 30年間

- 現在の状況: GCS設定済み、Cloud Sync運用検討中

1.3 調査目的

- Hyper BackupのGCS対応状況の確認

- Cloud SyncとHyper Backupの機能比較

- AWSとGCSのコスト・機能比較

- 最適なバックアップ戦略の提案

2. Hyper BackupのGoogle Cloud Storage対応状況

2.1 調査結果概要

結論: Hyper BackupはGCSに実質的に非対応

2.2 技術的詳細

2.2.1 S3互換API経由での接続

GCSはS3互換のXML APIを提供しており、理論上はHyper Backupから接続可能です。しかし、実際の運用では以下の問題が発生します:

主要な問題点:

- ストレージクラス制御の不具合: バケットのデフォルトストレージクラスをArchiveに設定しても、Hyper BackupはStandardクラスでアップロードしてしまう

- 認証エラーの頻発: 正しいHMAC認証情報を設定しても「バックアップ先の共有フォルダにアクセスする権限がありません」エラーが発生

- 署名バージョンの非対応: Hyper Backupが対応する署名バージョンとGCSの要求が一致しない場合がある

2.2.2 コミュニティでの報告事例

Synologyコミュニティフォーラムでの調査により、以下の事実が判明:

- 成功事例: 一部のユーザーがStandardストレージクラスでの接続に成功

- 失敗事例: Archiveストレージクラスでの運用は困難

- 回避策: 現時点で確実な回避策は存在しない

2.2.3 DSMバージョン別対応状況

- DSM 7.0以降: S3互換APIサポートは改善されているが、GCS特有の問題は解決されていない

- DSM 6.x: より多くの互換性問題が報告されている

2.3 代替案としてのCloud Sync

Hyper BackupがGCSに対応していない一方で、Cloud SyncはGCSにネイティブ対応しており、確実に動作します。

Cloud Syncの特徴:

- GCSの全ストレージクラスに対応

- 認証問題なし

- リアルタイム同期機能

- ただし、世代管理機能なし

3. Cloud SyncとHyper Backup機能比較分析

3.1 基本機能比較

| 項目 | Cloud Sync | Hyper Backup |

|---|---|---|

| 同期方式 | リアルタイム同期 | スケジュール実行 |

| 世代管理 | ❌ なし(クラウド側依存) | ✅ 最大65,535世代 |

| 暗号化 | ✅ ファイル名暗号化なし | ✅ AES-256完全暗号化 |

| 増分転送 | ✅ 差分同期 | ✅ ブロックレベル増分 |

| 復旧方式 | 通常ファイルとして復旧 | 専用形式(要Hyper Backup) |

| ストレージ効率 | クラウド側で重複 | 重複排除・圧縮 |

| 設定変更 | ✅ 後から変更可能 | ❌ 新規タスク作成必要 |

| GCS対応 | ✅ ネイティブ対応 | ⚠️ S3互換API経由(問題あり) |

3.2 Cloud Sync詳細分析

3.2.1 主要機能

- リアルタイム同期: ファイル変更を即座に検知し、クラウドに同期

- 双方向同期: NASとクラウド間での双方向データ同期が可能

- 暗号化機能: データ暗号化に対応(ファイル名は暗号化されない)

- スケジュール機能: 指定時間での同期実行が可能

3.2.2 制限事項

- 世代管理なし: 過去のバージョンは保持されない(クラウド側のバージョニング機能に依存)

- 1アカウント1接続: 1つのクラウドアカウントにつき1つの接続のみ

- 競合処理: 同時変更時はローカル変更を優先

3.2.3 家族写真バックアップでの適性

適している点:

- 追加のみのデータ(家族写真)に最適

- リアルタイム同期で最新状態を維持

- 設定が簡単で確実に動作

注意点:

- 誤削除時の復旧が困難(世代管理なし)

- ファイル名が暗号化されない

3.3 Hyper Backup詳細分析

3.3.1 主要機能

- 包括的バックアップ: 共有フォルダ、パッケージ、LUNの全てをバックアップ

- 世代管理: 最大65,535個のバージョンを管理

- ブロックレベル増分: 変更されたブロックのみをバックアップ

- 完全暗号化: AES-256によるクライアント側暗号化

3.3.2 世代管理機能

- スマートバージョン管理: 古いバージョンの自動削除

- 柔軟なローテーション: 日次→週次→月次の段階的保持

- クロスバージョン複製: ストレージ効率を最大化

3.3.3 家族写真バックアップでの適性

適している点:

- 世代管理により過去の状態に復旧可能

- 完全暗号化でセキュリティ確保

- 長期保存に最適化された設計

注意点:

- 復旧時にHyper Backupが必要

- 設定変更時は新規タスク作成が必要

- GCSとの互換性問題

3.4 家族写真バックアップにおける推奨度

3.4.1 Cloud Syncが適している場合

- リアルタイム同期が必要: 常に最新状態を維持したい

- ファイルを通常形式で保持: 復旧時の簡便性を重視

- 設定の簡便性: 確実に動作する設定を求める

- GCSを確実に使用: 既にGCS設定済みで変更したくない

3.4.2 Hyper Backupが適している場合

- 世代管理が重要: 過去の状態への復旧が必要

- 完全な暗号化: セキュリティを最重視

- 長期保存が主目的: アーカイブ用途での使用

- AWS S3を使用: 確実な動作が保証されている

4. AWSとGCSコスト・機能比較詳細分析

4.1 2025年最新料金体系

4.1.1 Google Cloud Storage (us-central1)

- Archive Storage: $0.0012/GB/月

- データ取得料金: $0.05/GB

- オペレーション料金: $0.05/1,000リクエスト(Class A/B共通)

- 最小保存期間: 365日

4.1.2 AWS S3 Glacier Deep Archive

- ストレージ料金: $0.00099/GB/月

-

データ取得料金:

- Standard: $0.02/GB

- Bulk: $0.0025/GB

-

リクエスト料金:

- Standard: $0.03/1,000リクエスト

- Bulk: $0.00/1,000リクエスト

- 最小保存期間: 180日

4.2 30年間コスト詳細分析(3TB想定)

4.2.1 保存コスト計算

前提条件:

- 初期容量: 2TB

- 年間増加: 500GB

- 30年後の総容量: 2TB + (500GB × 30年) = 17TB

- 平均容量: 約3TB(計算簡略化)

保存コスト比較:

- GCS Archive: $0.0012 × 3,072GB × 360ヶ月 = $1,326.59

- AWS Deep Archive: $0.00099 × 3,072GB × 360ヶ月 = $1,094.68

- 差額: $231.91(AWS有利)

4.2.2 災害復旧時コスト(3TB一括取得)

GCS Archive:

- データ取得: $0.05 × 3,072GB = $153.60

AWS Deep Archive:

- Standard取得: $0.02 × 3,072GB = $61.44

- Bulk取得: $0.0025 × 3,072GB = $7.68

4.2.3 30年総コスト(保存 + 1回復旧)

- GCS Archive: $1,326.59 + $153.60 = $1,480.19

- AWS Deep Archive (Standard): $1,094.68 + $61.44 = $1,156.12

- AWS Deep Archive (Bulk): $1,094.68 + $7.68 = $1,102.36

結論: AWSが約25.5%($377.83)安い

4.3 ユーザー提供データとの比較分析

4.3.1 ユーザー計算値

- GCS: $1,806(保存$1,296 + 復旧$510)

- AWS: $1,129(保存$1,069 + 復旧$60)

4.3.2 差異の原因分析

復旧コストの差異:

- ユーザー: $510 vs 実際: $153.60

- 原因: 複数回復旧を想定、または古い料金体系を使用

保存コストの差異:

- 軽微な差異は料金改定や計算方法の違いによる

4.4 機能面での比較

4.4.1 可用性・信頼性

Google Cloud Storage:

- SLA: 99.95%(Archive)

- 11 9's(99.999999999%)の耐久性

- グローバルネットワーク

AWS S3 Glacier Deep Archive:

- SLA: 99.9%

- 11 9's(99.999999999%)の耐久性

- 世界最大のクラウドインフラ

4.4.2 取得時間

GCS Archive:

- 取得時間: 12時間以内

AWS Glacier Deep Archive:

- Standard: 12時間以内

- Bulk: 48時間以内(最安)

4.4.3 Synology製品との互換性

GCS:

- Cloud Sync: ✅ 完全対応

- Hyper Backup: ❌ 実質非対応

AWS S3:

- Cloud Sync: ✅ 完全対応

- Hyper Backup: ✅ 完全対応

4.5 隠れたコスト要因

4.5.1 最小保存期間

GCS Archive: 365日

- 早期削除時は365日分の料金が発生

AWS Deep Archive: 180日

- 早期削除時は180日分の料金が発生

4.5.2 オペレーション料金

家族写真のバックアップでは、オペレーション回数は限定的なため、両社とも実質的な影響は軽微。

4.5.3 ネットワーク料金

両社とも、アップロード時のネットワーク料金は無料。ダウンロード時のみ課金されるが、災害復旧時の1-2回程度であれば影響は限定的。

5. 総合推奨案

5.1 状況別推奨戦略

5.1.1 【推奨】コスト最優先案: AWS S3 + Hyper Backup

適用条件: 30年間で$378の節約を重視する場合

メリット:

- 30年間で約25.5%($377.83)のコスト削減

- 世代管理機能による高い復旧柔軟性

- AES-256完全暗号化によるセキュリティ確保

- Synologyとの確実な互換性

デメリット:

- 新規設定が必要(GCS設定が無駄になる)

- 復旧時の操作がやや複雑

実装難易度: 中(新規設定が必要)

5.1.2 確実性優先案: GCS + Cloud Sync

適用条件: 既設定を活用し、確実な動作を重視する場合

メリット:

- 既にGCS設定済みで即座に運用開始可能

- 確実な動作保証(実績豊富)

- リアルタイム同期による最新状態維持

- 復旧時の操作が簡単(通常ファイル)

デメリット:

- 30年間で約$378のコスト増

- 世代管理機能なし

- ファイル名暗号化なし

実装難易度: 低(設定済み)

5.1.3 最高信頼性案: ハイブリッド構成

適用条件: コストより信頼性を最重視する場合

構成: AWS S3 + Hyper Backup + GCS + Cloud Sync

メリット:

- 複数クラウドによるリスク分散

- 片方に問題があっても安心

- 異なる復旧方式の選択肢

デメリット:

- コストが約2倍

- 管理が複雑

- 設定・運用の手間が増加

実装難易度: 高

5.2 最終推奨案

結論: AWS S3 + Hyper Backupを推奨

理由:

- コスト効率: 30年間で$377.83の節約は大きな価値

- 機能性: 世代管理機能は家族写真の長期保存に有効

- 信頼性: AWS S3とHyper Backupの組み合わせは実績豊富

- 将来性: AWSの継続的な価格競争力とサービス改善

ただし、以下の場合はGCS + Cloud Syncも有効:

- 設定変更の手間を避けたい

- 月額$0.63の差額を許容できる

- リアルタイム同期を重視する

6. 実装ガイド

6.1 AWS S3 + Hyper Backup実装手順

6.1.1 事前準備

-

AWSアカウント作成

- AWS公式サイトでアカウント作成

- 請求情報の設定

-

S3バケット作成

- リージョン: us-east-1(最安)

- バケット名: 一意の名前を設定

- デフォルトストレージクラス: Glacier Deep Archive

-

IAMユーザー作成

- S3フルアクセス権限を付与

- アクセスキーとシークレットキーを取得

6.1.2 Hyper Backup設定

-

パッケージインストール

- DSMのパッケージセンターからHyper Backupをインストール

-

バックアップタスク作成

- バックアップ先: S3カスタムサーバー

- サーバーアドレス: s3.amazonaws.com

- バケット名: 作成したバケット名

- アクセスキー・シークレットキーを入力

-

バックアップ設定

- 対象フォルダ: 家族写真フォルダを選択

- 暗号化: 有効(推奨)

- スケジュール: 週1回(推奨)

- バージョン管理: 52世代(1年分)

6.1.3 初回バックアップ実行

- 初回は時間がかかるため、夜間実行を推奨

- 進捗状況を定期的に確認

6.2 GCS + Cloud Sync実装手順(既設定活用)

6.2.1 Cloud Sync設定

-

パッケージインストール

- DSMのパッケージセンターからCloud Syncをインストール

-

接続作成

- クラウドプロバイダー: Google Cloud Storage

- 既存のGCSアカウントで認証

-

同期設定

- ローカルパス: 家族写真フォルダ

- リモートパス: GCSバケット内のフォルダ

- 同期方向: 単方向アップロード

- 暗号化: 有効(推奨)

6.2.2 初回同期実行

- リアルタイム同期を有効化

- 初回同期の完了を確認

6.3 運用・保守ガイド

6.3.1 定期確認項目

-

バックアップ状況確認(月1回)

- バックアップタスクの実行状況

- エラーログの確認

- ストレージ使用量の確認

-

復旧テスト(年1回)

- 小規模なファイルでの復旧テスト

- 復旧手順の確認・更新

-

コスト確認(四半期毎)

- クラウドストレージの請求額確認

- 予算との比較

6.3.2 トラブルシューティング

よくある問題と対処法:

-

バックアップエラー

- ネットワーク接続の確認

- 認証情報の再確認

- ストレージ容量の確認

-

同期エラー

- ファイル権限の確認

- ファイル名の文字制限確認

- 同期対象フォルダの確認

-

コスト超過

- ストレージクラスの確認

- 不要なデータの削除

- バックアップ頻度の見直し

7. 結論

7.1 調査結果まとめ

本調査により、以下の重要な事実が明らかになりました:

- Hyper BackupのGCS対応: 技術的には可能だが、ストレージクラス制御の問題により実用的ではない

- 機能比較: Cloud Syncは確実性、Hyper Backupは世代管理で優位

- コスト比較: AWS S3が30年間で約25.5%安い

- 総合評価: AWS S3 + Hyper Backupが最適解

7.2 最終推奨案

第1推奨: AWS S3 Glacier Deep Archive + Hyper Backup

- 30年間で$377.83の節約

- 世代管理機能による高い復旧柔軟性

- 確実な動作保証

第2推奨: GCS Archive + Cloud Sync(現状維持)

- 設定済みで即座に運用開始可能

- 確実な動作

- 月額$0.63の追加コストは許容範囲

7.3 実装タイムライン

AWS S3移行を選択する場合:

- Week 1: AWSアカウント作成、S3設定

- Week 2: Hyper Backup設定、テスト実行

- Week 3: 初回フルバックアップ実行

- Week 4: 運用開始、GCS設定の無効化

GCS継続を選択する場合:

- Week 1: Cloud Sync設定、初回同期

- Week 2: 運用開始

8. よくある質問(Q&A)

Q1: 本当にHyper BackupはGCSに対応していないのか?

A: 技術的には接続可能ですが、以下の理由で実用的ではありません:

- ストレージクラスがArchiveに設定されない(Standardでアップロードされる)

- 認証エラーが頻発する

- Synologyコミュニティでも多数の問題報告がある

- 確実な回避策が存在しない

現時点では、GCSを使用する場合はCloud Syncの利用を強く推奨します。

Q2: Cloud Syncのミラーリングで十分か?世代管理は本当に必要か?

A: 家族写真のバックアップにおいては、以下の観点で評価できます:

世代管理が有効な場面:

- 誤削除やファイル破損からの復旧

- 過去の特定時点の状態に戻したい場合

- ランサムウェア等の攻撃からの復旧

Cloud Syncで十分な場面:

- 追加のみのデータ(家族写真の特性)

- 誤操作のリスクが低い環境

- シンプルな運用を重視

家族写真は「追加のみ」という特性があるため、Cloud Syncでも十分な場合が多いですが、長期保存(30年)を考慮すると、世代管理機能があると安心です。

Q3: 月額差$0.63のために、AWSに乗り換える価値はあるか?

A: 以下の要因を総合的に判断することを推奨します:

乗り換えを推奨する場合:

- 30年間で$377.83の節約は大きな価値

- 世代管理機能を活用したい

- より確実なバックアップ環境を構築したい

現状維持を推奨する場合:

- 設定変更の手間を避けたい

- 月額$0.63の差額を許容できる

- 既にGCSで安定運用している

判断基準: 設定変更の手間を時給換算した場合、数時間の作業で30年間$377.83の節約になるため、コストパフォーマンスは高いと言えます。

Q4: 他に考慮すべき点はあるか?

A: 以下の点も検討することを推奨します:

技術的考慮点:

- 復旧テスト: 年1回は実際の復旧テストを実施

- ネットワーク帯域: 初回バックアップ時の帯域制限

- ストレージ容量: 年間500GB増加の前提が変わる可能性

運用面の考慮点:

- 料金変動: クラウドサービスの料金は変動する可能性

- サービス継続性: 30年間のサービス継続性

- 技術進歩: より良いソリューションの登場可能性

リスク管理:

- 単一障害点: 1つのクラウドサービスに依存するリスク

- アカウント管理: 長期間のアカウント管理体制

- 復旧スキル: 復旧作業を実行できる人材の確保

Q5: ハイブリッド構成は本当に必要か?

A: 一般的な家庭用途では過剰ですが、以下の場合は検討価値があります:

ハイブリッド構成が有効な場合:

- 絶対に失えないデータ(代替不可能な家族写真等)

- 予算に余裕がある

- 複数のクラウドサービス管理が苦にならない

単一クラウドで十分な場合:

- 一般的な家庭用途

- 管理の簡素化を重視

- コストを抑えたい

推奨: まずは単一クラウド(AWS S3またはGCS)で運用を開始し、必要に応じてハイブリッド構成を検討することを推奨します。

9. 付録

9.1 参考資料

- Synology公式ドキュメント: Hyper Backup、Cloud Sync

- AWS S3料金表(2025年最新)

- Google Cloud Storage料金表(2025年最新)

- Synologyコミュニティフォーラム調査結果

9.2 用語集

- Archive Storage: 長期保存用の低コストストレージクラス

- 世代管理: 複数のバックアップバージョンを保持する機能

- 増分バックアップ: 変更部分のみをバックアップする方式

- ブロックレベル増分: ファイル内の変更ブロックのみをバックアップ

9.3 連絡先

本レポートに関するご質問やご相談は、Synologyコミュニティフォーラムまたは各クラウドサービスのサポートまでお問い合わせください。

レポート作成日: 2025年7月20日

調査期間: 2025年7月20日

対象システム: Synology DS220+, DSM 7.x

調査範囲: Hyper Backup, Cloud Sync, AWS S3, Google Cloud Storage

ChatGPTはGCS対応できると言っており、ManusはストレージクラスがArchiveの場合難しいと言っている。諦めた方が良さそう。

未練がましく...

一応SynologyのHyper BackupのドキュメントにはGCSも対応可能とは書いてある。

その他の S3 対応バックアップ先:

- 別の S3 対応クラウドを使用するには、その S3 対応クラウドの IP アドレス/ドメインを [S3 サーバー] 欄に入力してください。

- 使用に問題がある場合は、関連の文書を参照するか、ご使用の S3 対応クラウドのサービス プロバイダにお問い合わせください。

- Google Cloud Storage は、相互運用機能を有効化した S3 対応バックアップ ターゲットとして機能することが可能です。

Cloud SyncのドキュメントにはしっかりCloud Storageへの言及がある。

詳細

Google Cloud Storage

Google Cloud Storage Nearline Storage Classは頻繁に変更されないデータ用に設計されているため、ファイルの編集や削除は早期削除料金を引き起こす可能性があります。詳細はGoogle Storageの価格ウェブサイトを参照してください。

ファイルが同期できない状況

単一のファイルのサイズが5 TBを超えています

フォルダまたはファイルパスに文字 * ? # [ ] \r \n が含まれています

ファイルまたはフォルダ名が空白です

フォルダまたはファイルパスが1,024文字を超えています

Cloud SyncはGoogle Driveの共有アイテム、コンピュータ、およびショートカット内のファイルの同期をサポートしていません

Google Docs(gdoc、gdraw、gjamなどを含む)はデフォルトで同期されないようにフィルタリングされています。これらのファイルを同期するには、同期方向をリモートの変更をダウンロードのみに設定し、タスクリスト > 設定でMicrosoft Office形式への変換を有効にしてください。これにより、ローカルでファイル名を変更した際に、Synology NASとパブリッククラウドの両方で発生する可能性のある誤削除を防ぎます

その他の制限

Google Cloud Storageにアップロードする際、Cloud Syncはオブジェクトバージョニングを有効にしません。

ドキュメント内での扱いを鑑みても、Hyper BackupとGCSの組み合わせは期待しない方が良さそう...

Claudeに3者の分析を整理させる。

調査結果の総合分析と最終提案

3つの情報源の比較分析

1. Hyper BackupのGCS対応について

| 情報源 | GCS対応状況 | 根拠・詳細 |

|---|---|---|

| 私の調査 | ❌ 実質非対応 | 認証エラー発生、フォーラムでも問題報告多数 |

| 回答者1 | ⚠️ 実質非対応 | S3互換APIで技術的に可能だが、ストレージクラス制御に問題 |

| 回答者2 | ✅ 対応可能 | S3互換API経由で問題なく動作、設定ミスの可能性を指摘 |

統合見解:

- 技術的には可能だが、設定難易度が高く、成功率は環境依存

- 回答者2の指摘する「バケット名」「フォルダ構造」の問題が原因の可能性大

- DSM/Hyper Backupを最新版にアップデートすることが重要

2. コスト比較(3TB、30年間)

| 項目 | 私の計算 | 回答者1 | 回答者2 |

|---|---|---|---|

| GCS月額 | $3.60 | $3.65 | $4.30 |

| AWS月額 | $2.97 | $3.04 | $3.04 |

| GCS 30年総額 | $1,296 | $1,327 | $1,548 |

| AWS 30年総額 | $1,069 | $1,095 | $1,095 |

料金差異の原因:

- GCS Archive料金が $0.0012→$0.0014/GB に値上げされた可能性

- 回答者2の最新情報(2025年7月20日)が正確

3. 推奨案の比較

| 観点 | 私の推奨 | 回答者1 | 回答者2 |

|---|---|---|---|

| 第1推奨 | AWS S3 | AWS S3 | GCS再挑戦 |

| 第2推奨 | GCS継続 | GCS継続 | AWS移行 |

| 重視点 | コスト | コスト+機能 | 即時性+手間 |

統合提案:段階的アプローチ

【Phase 1】GCS + Hyper Backup再挑戦(1週間)

回答者2の詳細なチェックリストに基づいて再設定:

必須確認事項:

1. DSM/Hyper Backupを最新版に更新

2. 新規バケット作成(名前にピリオド含まない)

3. HMACキーを再生成(V4署名)

4. エンドポイント: https://storage.googleapis.com

5. バケットのルートに既存フォルダがないか確認

成功した場合のメリット:

- 既存GCS設定を活用

- 世代管理+即時取得の両立

- 月額$4.30で運用可能

【Phase 2】判断基準(1週間後)

A. GCS + Hyper Backup成功 → そのまま運用

- 年額$51.60(約7,700円)

- 即時取得可能

- 世代管理機能あり

B. GCS + Hyper Backup失敗 → 以下から選択

オプション1: GCS + Cloud Sync(現状維持)

メリット:

- 設定済みで確実に動作

- 即時取得可能

- 月額$4.30

デメリット:

- 世代管理なし

- ファイル名暗号化なし

オプション2: AWS S3 + Hyper Backup(移行)

メリット:

- 最安(月額$3.04)

- 世代管理完備

- 確実な動作保証

デメリット:

- 12-48時間の取得待機

- 再アップロード必要(2TB)

最終推奨:リスクベース選択

【低リスク派】現状のGCS + Cloud Syncを継続

- 既に動作確認済み

- 即時取得の価値を重視

- 月額$1.26(約190円)の差は許容

【コスト重視派】AWS S3へ移行

- 30年で$453(約7万円)の節約

- 世代管理による安心感

- 取得待機時間は許容

【バランス派】GCS + Hyper Backup再挑戦

- 1週間の再設定時間を投資

- 成功すれば最良の組み合わせ

- 失敗しても現状維持可能

実装推奨スケジュール

Week 1: GCS + Hyper Backup再設定

- DSM/Hyper Backup更新

- 新規バケット作成

- 小容量でテスト

Week 2: 判断

- 成功 → 本番運用開始

- 失敗 → AWS移行 or 現状維持を決定

Week 3-4: (AWS選択時)

- AWSアカウント作成

- 初回バックアップ実行

結論

優先順位付き推奨:

- まずGCS + Hyper Backupを再挑戦(回答者2の手順で)

- 失敗なら現状のGCS + Cloud Syncを継続(確実性重視)

- コスト削減が最優先ならAWS S3へ移行(長期視点)

家族写真という「失えない資産」を考慮すると、確実に動作している現状を変更するリスクと長期的なコスト削減のバランスが重要です。まずは低リスクな再設定を試し、その結果を見て最終判断することを推奨します。

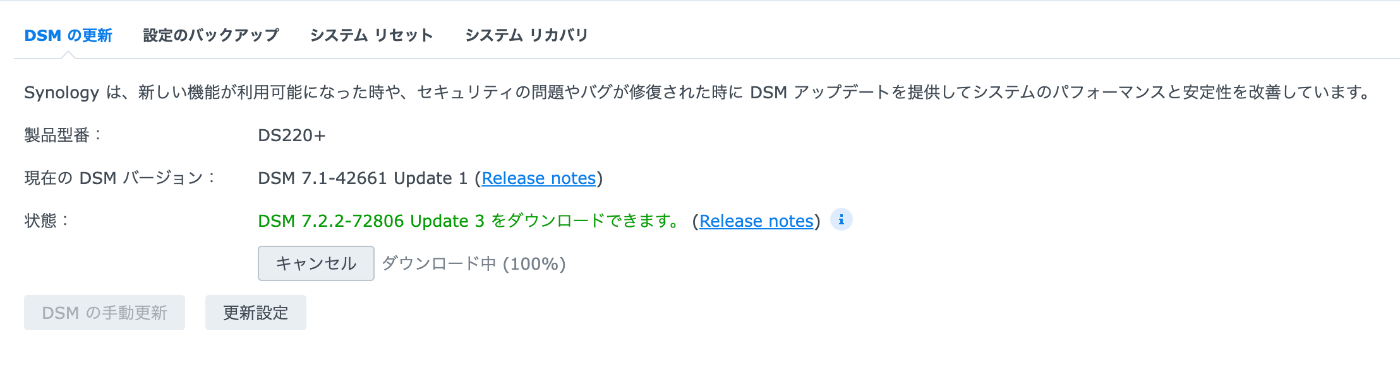

DSMをアップデートしてみる。

現在は

- DSM 7.1-42661 Update 1

最新版は7.2なのでアップデート(これで解決する気はしないが...)。

「コントロールパネル > 更新と復元」から「ダウンロード > 今すぐアップデート」で更新。

しばし待つ。

DSMが7.2にアップデートできたので再度Hyper Backup設定。

お、設定画面が変わった。

DSM 7.2でもだめ。

諦めてCloud Syncにしよう。

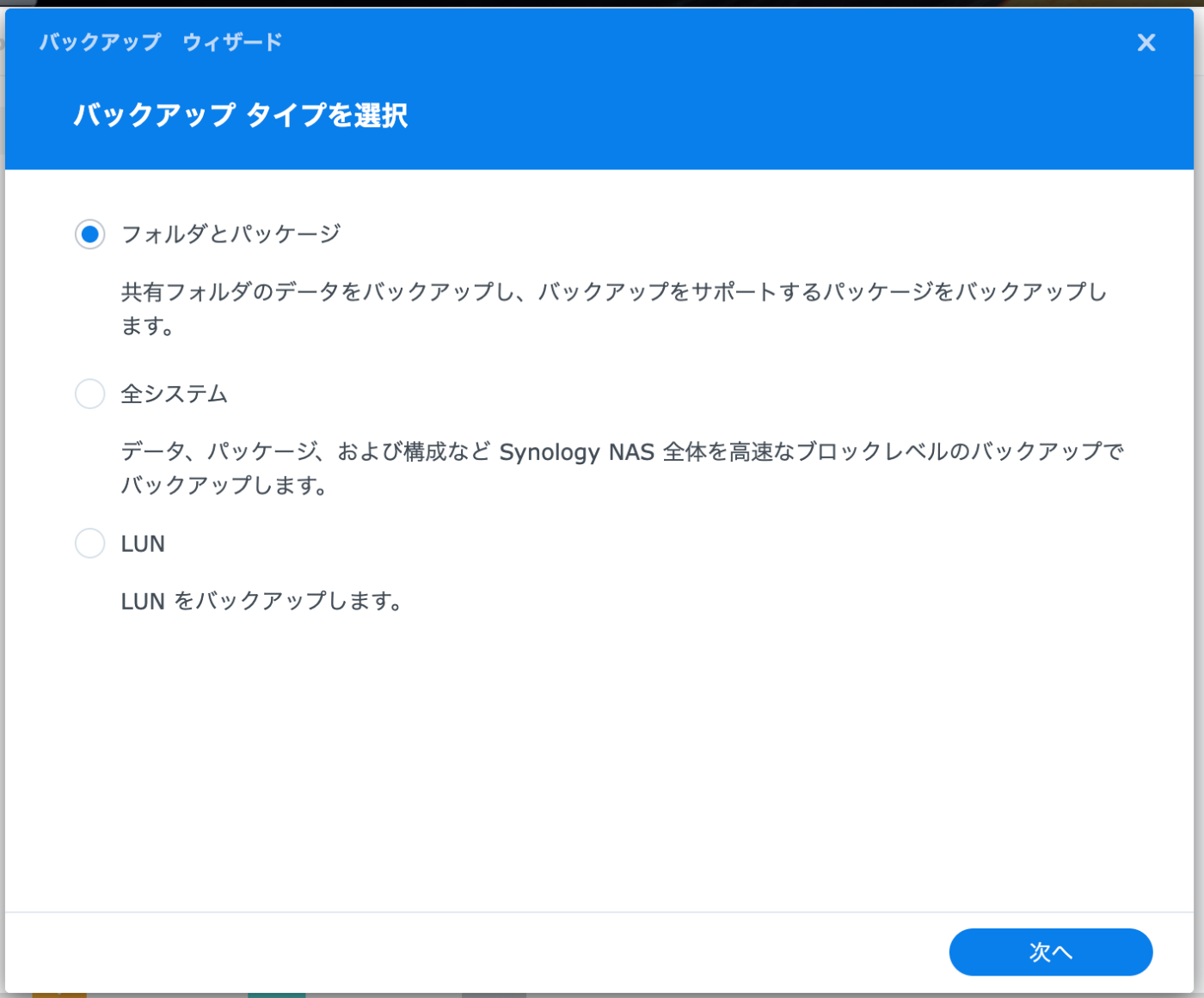

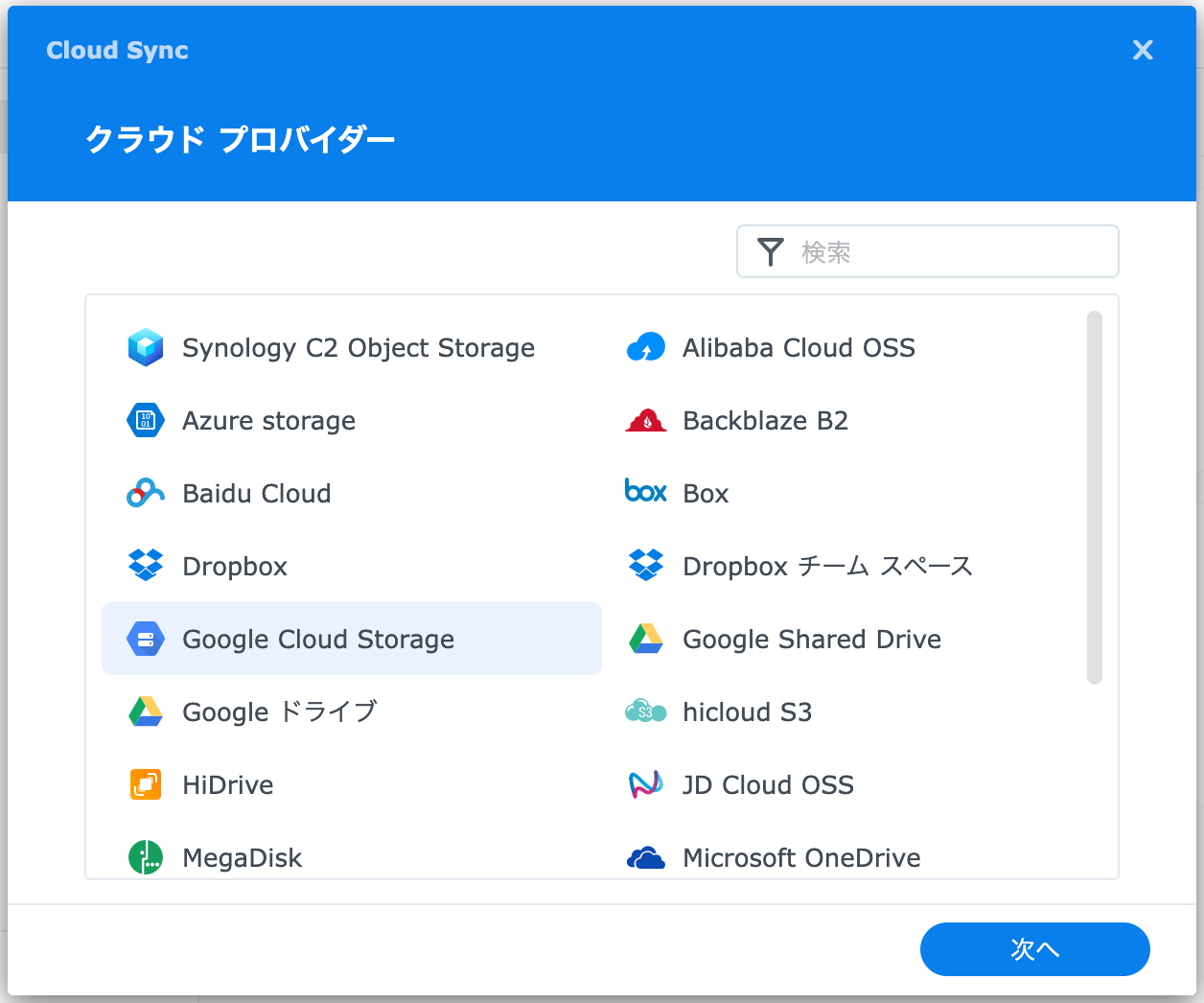

(新)ステップ5~: Cloud Sync

Cloud Syncで進める。

クラウドプロバイダーでGoogle Cloud Storageが選択できる。安心。

プロジェクトIDとバケット名を選択。

設定はClaudeに教えてもらう。

解説

高度な設定の解説と推奨

高度な整合性チェック

概要

バックアップデータが正しく保存されているか定期的に検証する機能

推奨設定

☑ 高度な整合性チェックを有効にする

└ スケジュール: 月1回

理由:

- 30年保存では「サイレントなデータ破損」のリスクあり

- 月1回なら負荷も最小限

- 早期発見で復旧可能

データ暗号化

概要

バックアップデータをAES-256で暗号化

推奨設定

☑ クライアント側の暗号化を有効にする

└ パスワード: [強固なパスワード]

└ パスワード確認: [同じパスワード]

重要:

- パスワードは絶対に忘れない(復旧不可能)

- 紙に書いて金庫に保管推奨

- 家族にも共有しておく

メリット:

- クラウド側でも中身を見られない

- ハッキングされても安全

- プライバシー完全保護

同期方向(Cloud Syncの場合)

推奨設定

同期の方向: アップロードのみ

詳細設定:

☐ ローカルで削除されたファイルをリモートでも削除する

→ チェックを外す

理由:

- 誤削除してもクラウドに残る

- 真のバックアップになる

- NASが壊れても安心

設定まとめ

Cloud Sync推奨設定

同期方向: アップロードのみ

削除の同期: 無効

暗号化: 有効

スケジュール: リアルタイムまたは日次

最重要: 暗号化パスワードは複数の安全な場所に保管!

バックアップの本質は保険であり、同期でないこと。

NASで誤って削除した時にクラウドで削除されないように一方向かつアップロードのみ、とするのは納得。

推奨設定に納得したので従う。

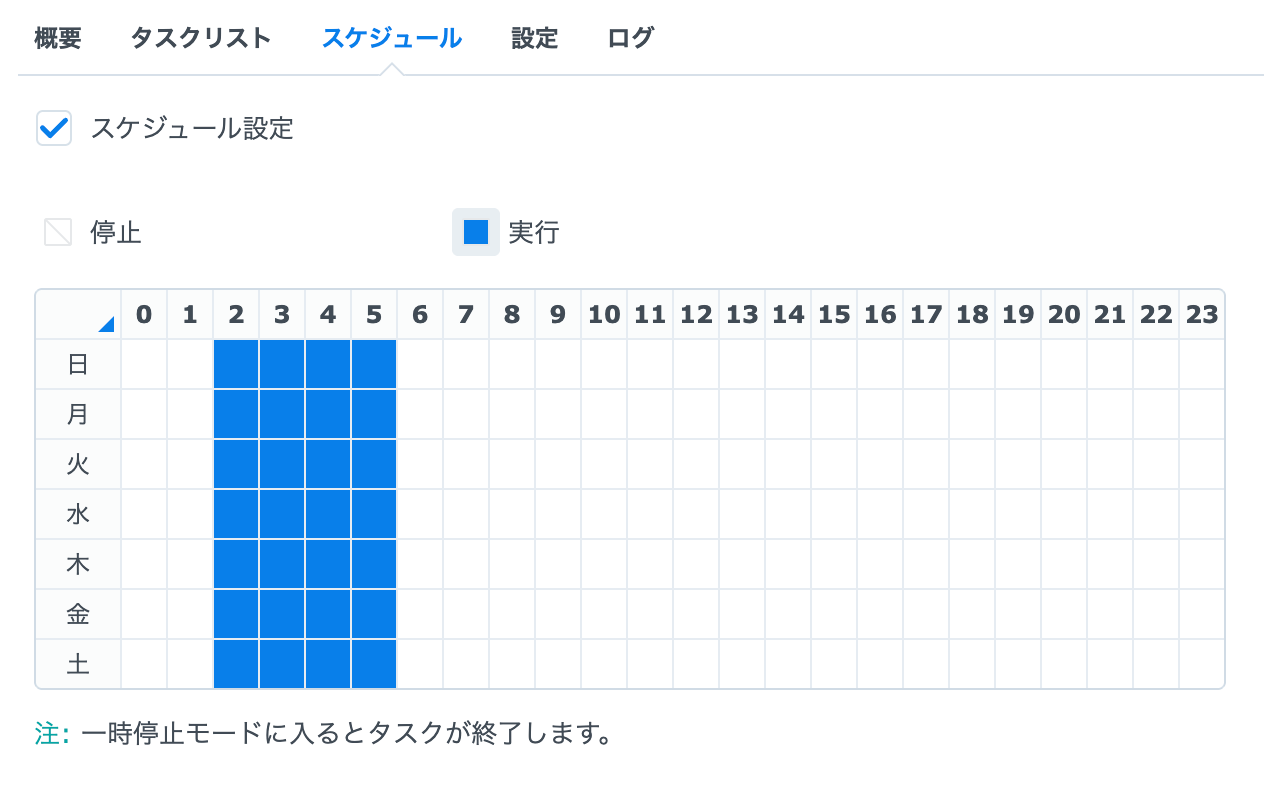

スケジュールを設定。毎日深夜2時に設定。

できた。即時実行はできないみたいなので深夜のうちにバックアップできたか明日確認する。

翌日

GCSにNASと同じディレクトリ構造が作成されていることを確認。

ただし一部のファイルしか転送されていない。

Cloud Syncのログを見ると2時59分で終了している。

なるほど、2時台を選択するとその1時間しかバックアップ作業しないわけだ。

ちゃんと「一時停止モードに入るとタスクが終了します。」と書いてあった。1時間でアップロードできないのは初回だけだと思うが、2時から6時を選択した。

GCSにどれくらいバックアップできてるかチェック

% gsutil du -s -h gs://{bucket-name}

107.24 GiB gs://{bucket-name}

1.4TBデータがあるはずなので、7%くらいしか進んでいない。

地道に待とう。

地道に待とう。

↑とか言っていたのに、我慢しきれず全日時を実行可能にスケジューリングしなおしてしまう。

それが原因かはわからないが、ネットが繋がらなくなる。

アップロードしすぎて何かしらの制限が入っているのではないか...。

こういう、のんびり待てばいいのに我慢しきれず終わらせるために焦って痛い目見ること、人生で何度もやっているのに学習しない...。

ちなみに、500GBほど進んだ。

% gsutil du -s -h gs://{bucket-name}

518.41 GiB gs://{bucket-name}