動画から模倣学習するやつら【4分まとめ】

初めに

このようなものを総称してIfO(Imitation from Observation)といわれることが多い。

通常の模倣学習はアクションラベルが付いたデモンストレーションを必要とするが、ここでは本当にビデオだけで学習する手法をまとめてみた。

早く読みたい人は太字だけ追えばわかると思います。

BCO(2018)

環境とインタラクションをとり、逆ダイナミクスモデルを学習し、動画データにアクションラベルを付与し、オフライン学習

しかし、オフライン学習同様分布シフトに悩まされる

※逆ダイナミクスモデルとは前後二つの状態の間で実行された行動を推定するモデル = IDM

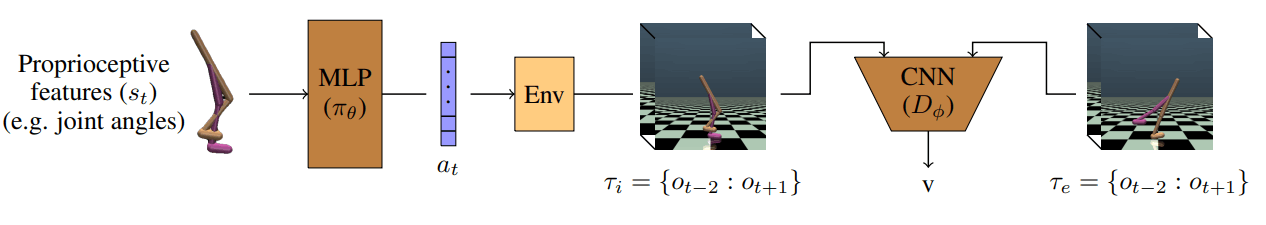

GAIfO(2019)

GAILのようにGAN的構造を取り入れ分布シフトに強くなる。なお、行われた状態遷移と、教師データの遷移を判別するdiscriminatorを学習し、一度環境を挟むため微分不可であることから、discriminatorの判別結果を報酬として渡し、普通の強化学習を行う。

VGAIfO(2019)

環境から関節角度などを取得でき、動画からIfOする場合に、GAIfOでは関節角度などを生かした学習ができなかった。しかし関節角度のみからポリシーを決定することで、ビデオからの模倣学習の効率が上がった。

VGAIfO-SO(2022)

VGAIfOのdiscriminatorはそのまま観測情報(画像)が入力されていたが、それでは効率が悪い。そこで、観測情報を適切に圧縮して、policy(generator)とdiscriminatorに通すことでビデオでの学習効率を上げた。

具体的にはビデオから関節角を予測し、それを利用して次元を下げている

サンプリング効率のいいIfO

IfOではdiscriminator lossを伝播するために強化学習を利用しているわけだが、そこの強化学習を従来から存在する高性能な強化学習に置き換えることで、サンプリング効率を上げているのが現状

VPT(2022)

上に述べられているBCOと基本は変わらない。違うところは、IDMを教師データと同じポリシーから抽出、つまり少数の人間のaction label付きビデオデータで学習することで、分布シフトの影響が消えたのと、大量のデータ+Trabsformerを利用。それと、minecraftでダイヤモンドを集めることに関連する動画でfine tuningしたり、強化学習でfine tuningすることでminecraftでダイヤモンドを獲得することに成功した。

エージェント版のGPT

詳細はこちら

Discussion