Causal Reinforcement Learning

Causal RLについてのICML2020で発表されたチュートリアルを起点に、かいつまんで理解する

Causal RLについてのICML2020で発表されたチュートリアルを起点に、かいつまんで理解する

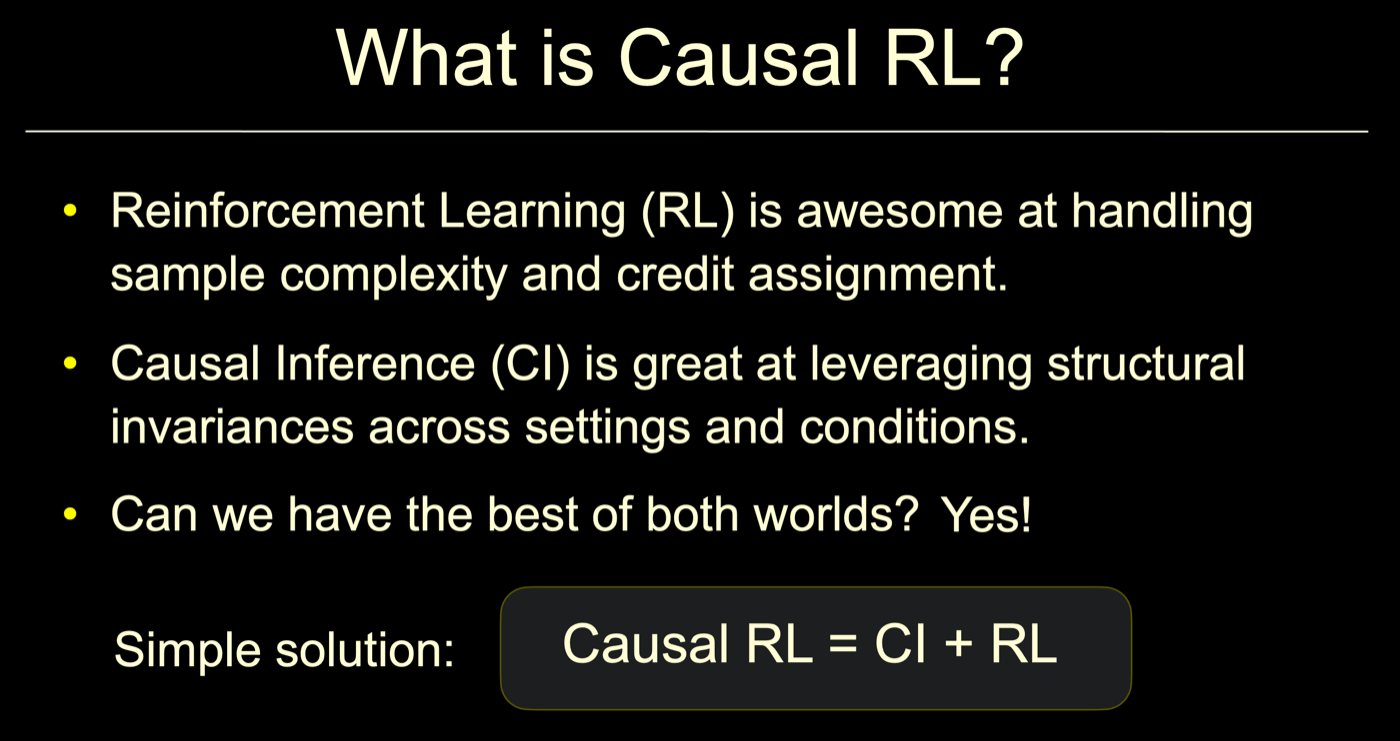

CI(Causal Inference, 因果推論)とRLのいいとこ取りをしよう、と言う主張ってありだったんだ。

用語

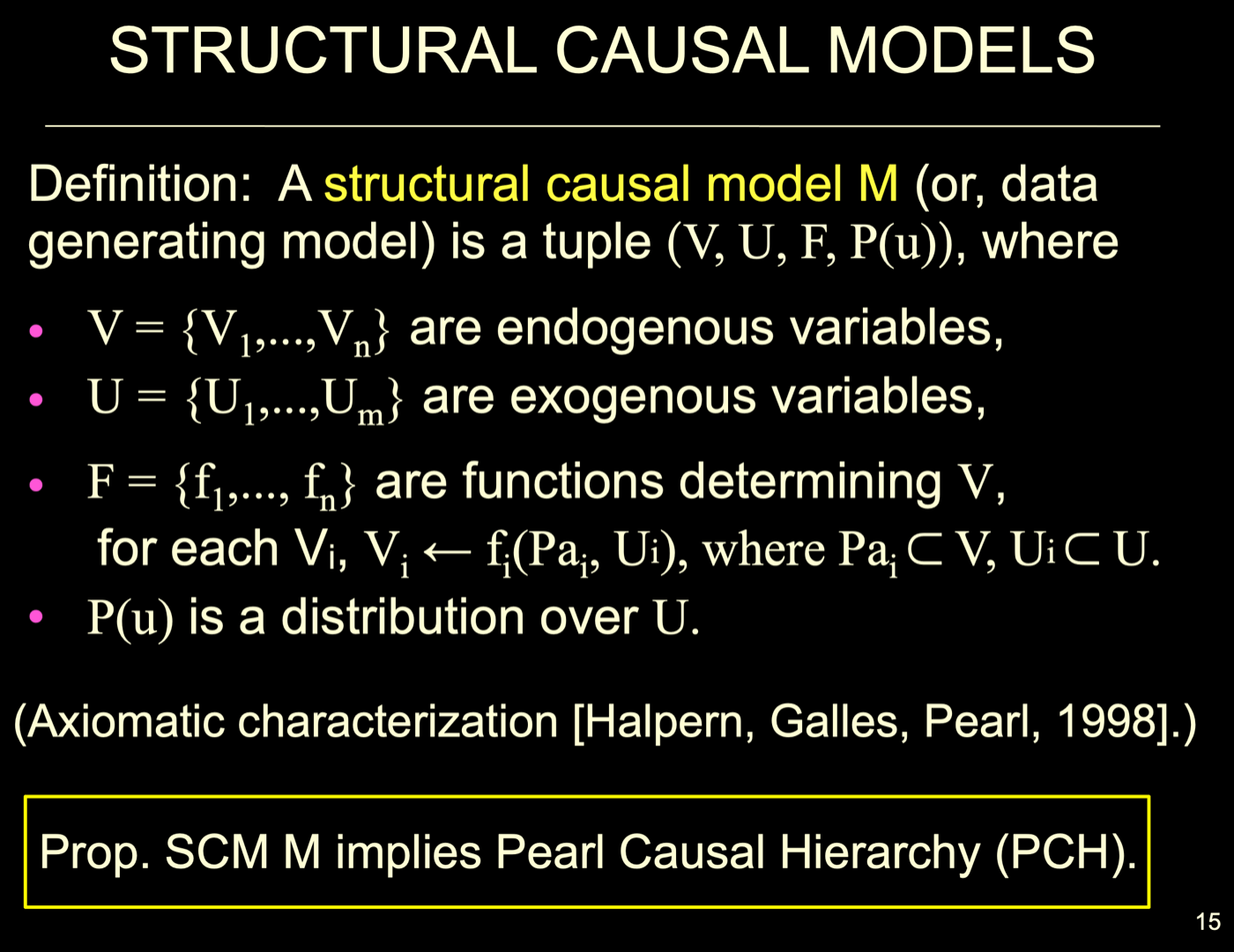

- SCM(Structural Causal Models)

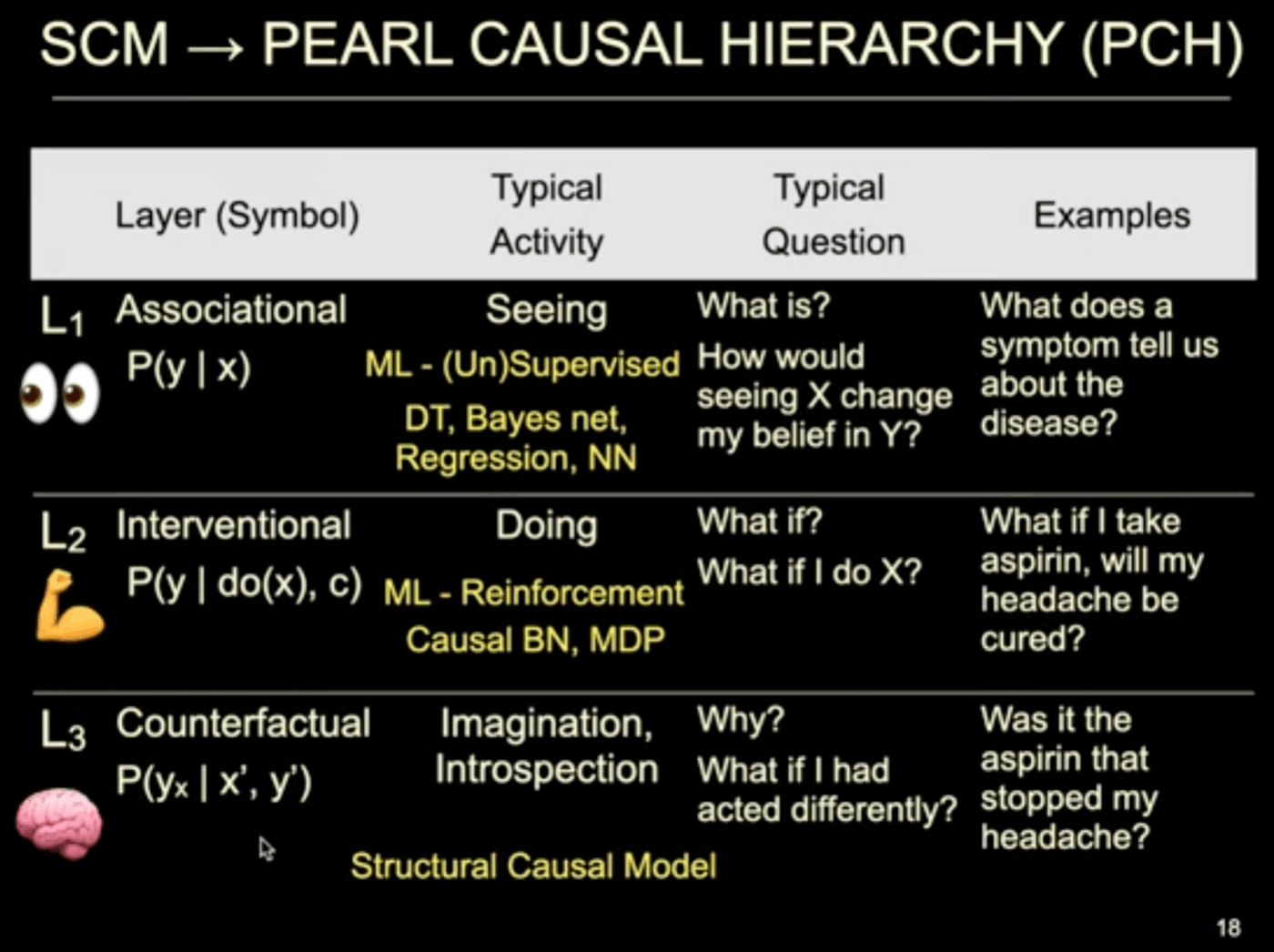

- PCH(Pearl Causal HIerarchy) Pearlは人名

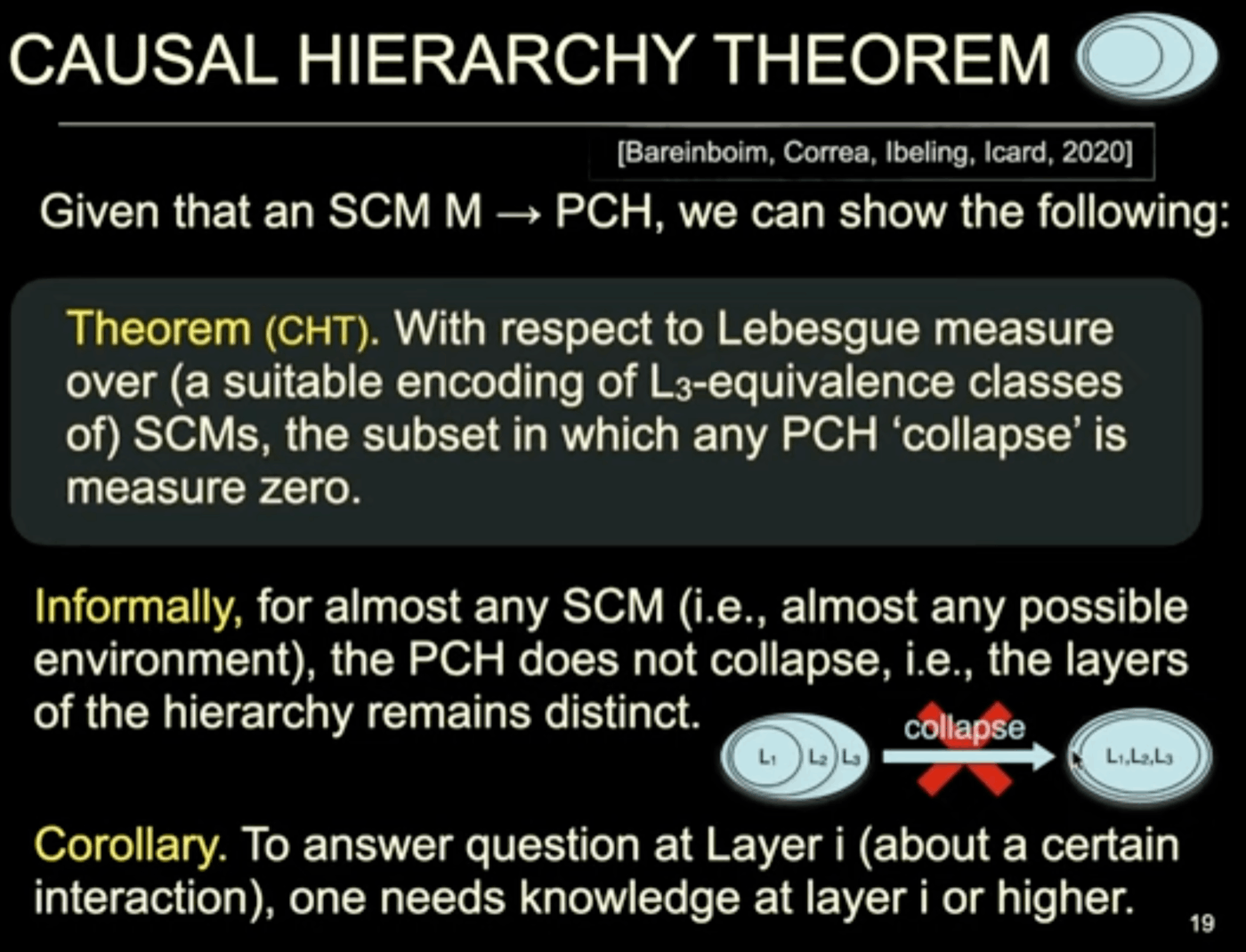

- CTH(Causal Hierarchy Theorem)

[BLZ 2020] Bareinboim, E., Lee, S., Zhang, J. An Introduction to Causal Reinforcement Learning. Columbia CausalAI Laboratory, Technical Report (R-65). 2020. forthcoming.

公開予定と言ってるが、2022になっても公開されてない。🤔

RLの再解釈

Envが「M = SCM」

Agentが「G = Causal Graph」

をもち、互いに連携する

CIの概要

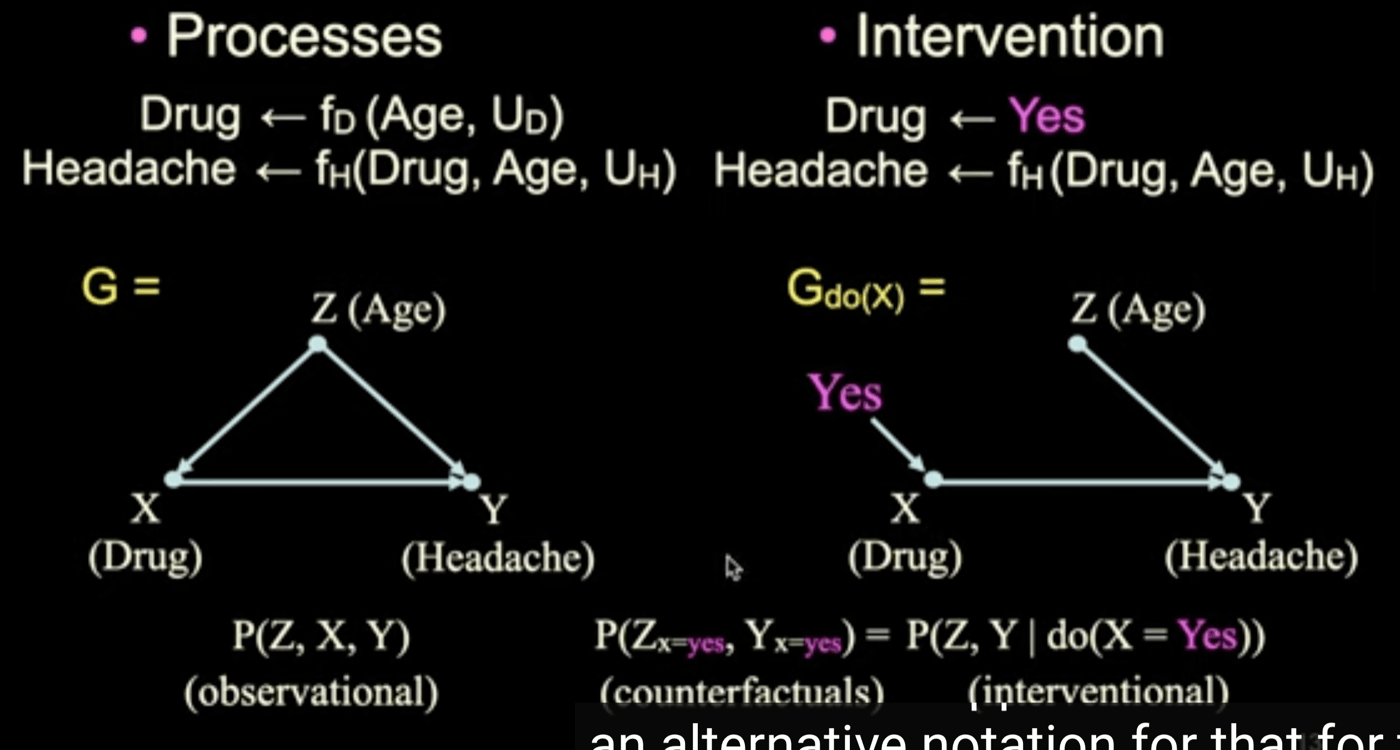

介入は、因果グラフの式を書き換えて構造を変えてしまう

prop: 命題、定義

implies: 含意する

SCMならばPCHだ←と言うことをここから示す

SCM→PCH

L1:観察(Seeing)

L2:実行(Doing)

L3:反実仮想(Imagination, Introspection)

measure zero = 零集合

CHT: Bareinboim,Correa,Ibeling,Icard,2020

Lebesgue measure:ルベーグ測度 ユークリッド距離、面積などの延長

corollary: 系。「ある主張(典型的には定理)の系(けい、英: corollary)とは、その(既知の)主張から「直ちに」証明される主張をいう。(weblio)」

almost anyと言っている理由:面積についての話をしているので、一つの点(面積がない)については無視してもいい

確率はルベーグ測度なので、この面積は確率分布のことなのではないか

(確立分ぷは事象から確率への写像)

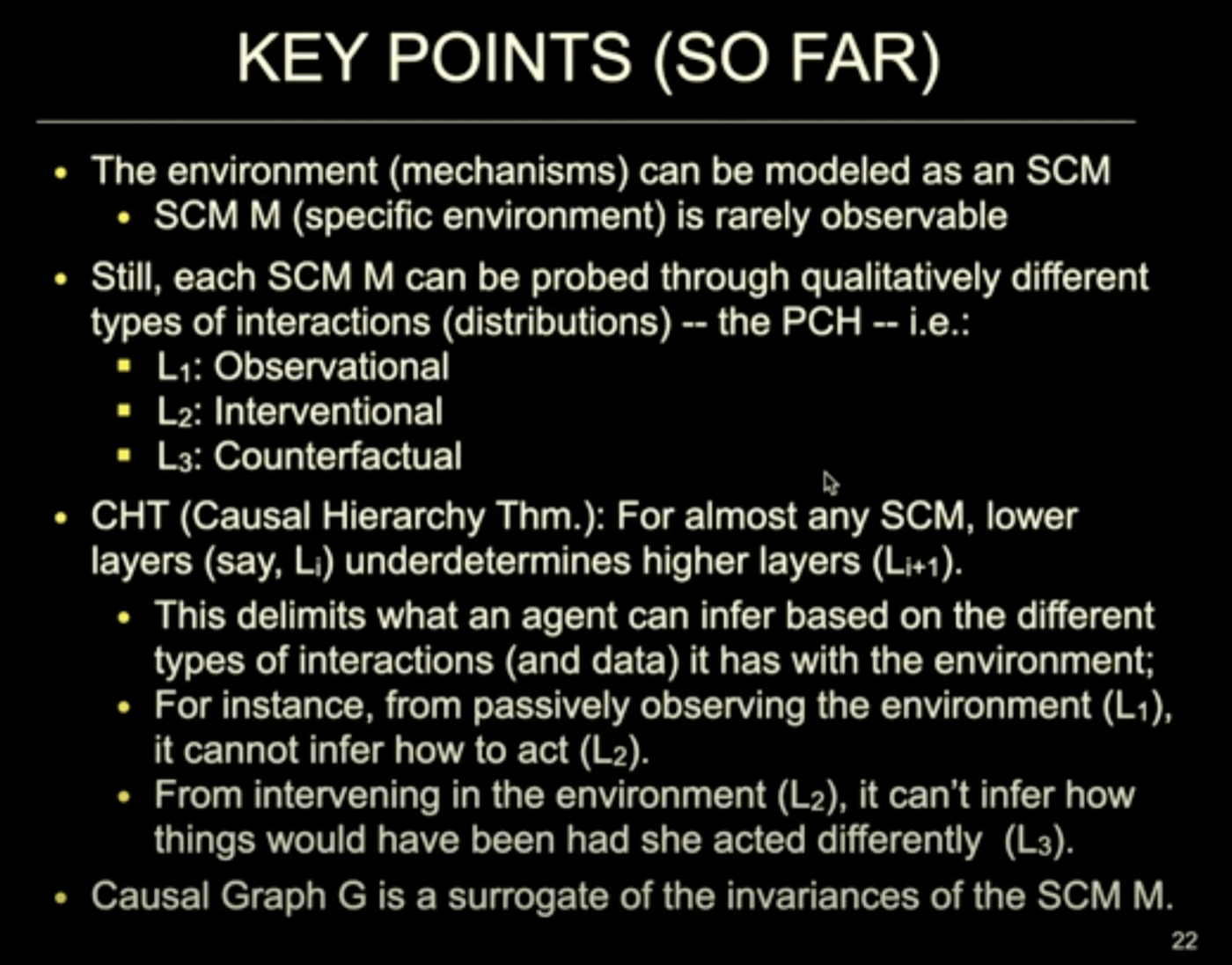

probe: 徹底的に調べる

underdetermine: 説明できない

surrogate: 代理

中まとめ

- SCM:環境はSCMとしてモデル化できるが、それは観察できない

- PCH:L1、L2、L3で、インタラクションを加えることでSCMを調べることができる

- CHT:L1、L2、L3で低次のレイヤーから高次を説明できないと言う理論

X, Y, do(X)ってなんだ?

なんとなくRLの

- Online

- Off-policy

- Do-calculus

do-calculus: do演算子? https://takehiko-i-hayashi.hatenablog.com/entry/20111222/1324487579

confounders: 交絡因子

unobserved counfounders