🎸

人間の脳まねたらすごかった!27Mでo3にも勝つ!

話すこと

昨日HRM6ページまでよんだ、今日はOCR論文読んだから続きよめなかった

途中だけど、自分の理解で書く

1 どんなもの

速い思考の層と遅い思考の層を組み合わせたらすごかったモデル

27百万パラメータでもっと大きい(はずの)推論モデルに勝つ

適応計算もできる(他のチームのアブレーション調査では、こいつが一番聞いている?とか)

このアイデアにたどりついたのはすごい!

だけど、聞いたら単純。コロンブスの卵みたいな話かと。

LLMのAGI化に大貢献! LLM競争激化必死 シンガポールから!

図(左)能をまねた構造図

図(右)ベンチマークで大きい(はずの)推論モデルに勝っている

図(左)幅より深さが大事

図(右)HRMが強い

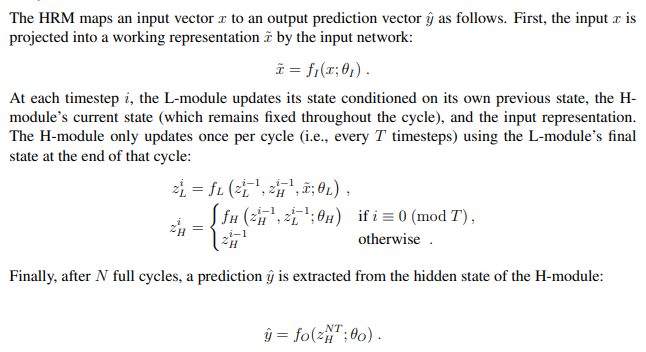

HRMの計算の式

図(上)学習のダイアグラム

図(下)学習疑似コード

2 議論はあるか?

こいつがやっている学習(loopをきちんとおいかけていなそう)みて2000年頃に誤差逆伝播の話を聞いて、なんとなくの理解で、aiのフレームワークも知らなくVC++だけで、本もなく、AIを自作したとき、微分さえ使わず、文字認識できた(はず)のを思い出した。

数学で証明できるほうが、うれしいけど、直感で、今のモデル突き放す実装は、全然できる可能性あるなとこれ見ても思った

あとがき

記事よかったら、いいね♡ 押してね!

Discussion