LLM-as-a-judge (暫定)

はじめに

- LLM-as-a-judgeサーベイを勉強会+個人でも読んでいたが、有用なので記事にする

- 最近AIが凄すぎるので、自分で記事かくのあほらし?になりつつあるので、大幅にAIの作業+自分の追加的で書いていこうかな?と思っている。その試行始める。なので、最初から大幅に変わるかも

初版、ほぼほぼAI作成

ちょっと思ったこと(ここは少なくとも全部自分が書いたはず)

- 最近、cursourとかのコード生成AIツールがすごいが、(よくわかってなくいいうので、違ってたらすいません)エラーが起こったら、修正とかするのは、環境の反応に応じているだけなので、この言葉の動きには当てはまらない。

- AIがテストケースを作って、それに対して、カバー率が低くないかと評価するとこの言葉に当てはまる動きと思える。

- 名前と違って LLM AS a examinatorとかもあった、評価のエージェントパイプラインとかも

これらや、いろんなバイアス(自分の評価高い、位置バイアス、長さバイアス)とかの低減も金を書けて

いろんなモデル使う、たくさんトークンまわす等すればある程度緩和できたり、精度上げられそう

なので、いつ、どの位、どこに金を使うかが人間の重要な仕事になりそう

AI論文をサクッと解説:LLM-as-a-judge ― LLMは「評価者」になれるのか?

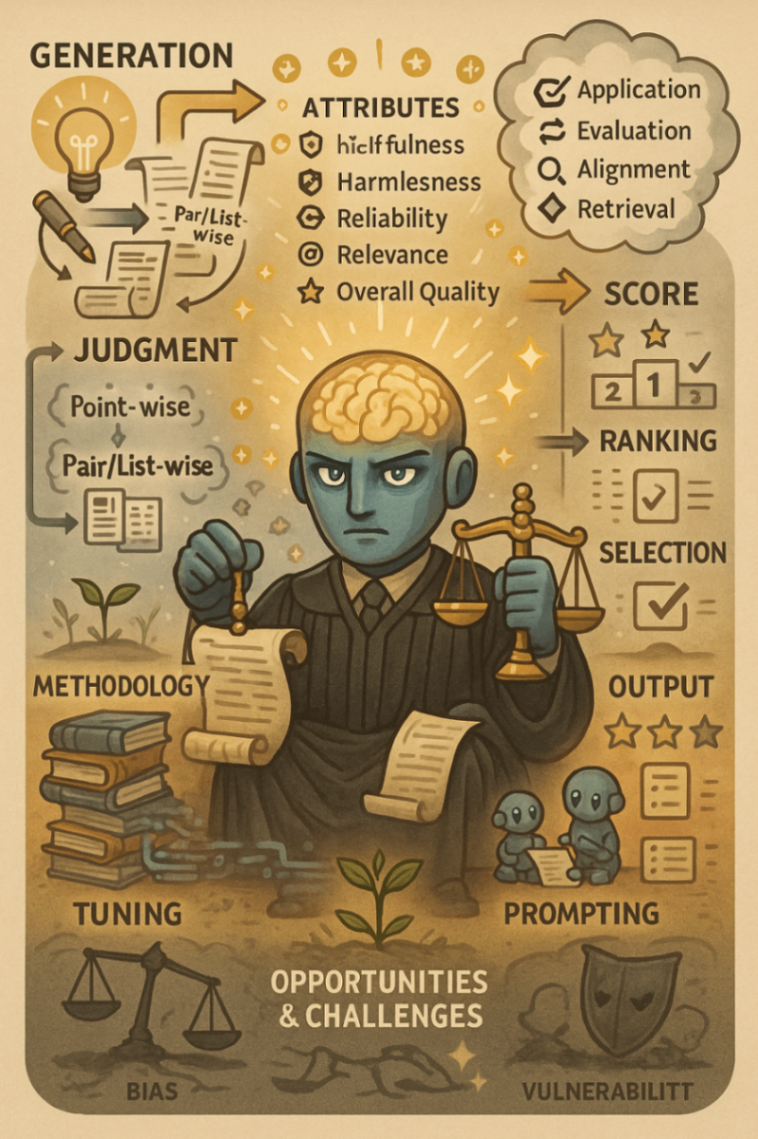

最近のLLM(大規模言語モデル)って、文章作るだけじゃなくて、評価もデキるって話、知ってる? 「LLM-as-a-judge」っていう、LLMを「評価者」として使う考え方があるんだ。今回は、それに関する論文「From Generation to Judgment: Opportunities and Challenges of LLM-as-a-judge」をザックリ紹介するよ。

これって何?

「LLM-as-a-judge」は、LLMを使って、いろんなタスクで点数つけたり、ランキング作ったり、モノを選んだりするってこと。この論文は、LLMによる「判断」や「評価」をガッツリ調べたもので、この新しい分野の最新情報をまとめたものだね。従来のやり方じゃ難しかった細かい部分の判断とか、イマイチな結果しか出なかった問題を解決するかもって期待されてるんだ。

何がスゴイの?

LLM-as-a-judgeのスゴイところは、今までの評価方法じゃダメだった部分をカバーできる点。ただ評価するだけじゃなくて、LLMが作られてから使われるまでの一連の流れ(アライメント、検索、推論とか)全体で役立つ可能性があるんだ。自己進化したり、意思決定したり、LLMをもっと賢くする力も秘めてる。つまり、自然言語処理の評価の世界で、新しい常識を作るかもしれないってこと。

押さえるべきポイントは?

この論文のポイントは、LLM-as-a-judgeを理解するための「3つの視点」。

- 何を判断する? (Attribute): 役立つか、害がないか、信頼できるか、関係あるか、実現できるか、全体的に質が高いか、とか。

- どうやって判断する? (Methodology): 人がラベル付けしたデータ、AIが作ったフィードバック、細かく調整するテクニック(ファインチューニング)、好みを学習させる方法、順番を入れ替えてみる、ルールを追加する、複数のAIで協力する、例を見せる、何回かやり取りする、比較をスピードアップする、とかのやり方。

- どこで判断する? (Application): 評価そのもの、LLMの調整(アライメント)、情報検索、推論とか、いろんな場面で使える。

あと、LLM-as-a-judgeを評価するための基準(ベンチマーク)もまとめてて、今の課題とか、これからどうなるかについても触れてる。

どうやって確かめたの?

この論文は、自分たちで新しい実験をしたんじゃなくて、すでにある研究とかデータを集めて分析した「サーベイ論文」ってやつ。だから、「確かめた」っていうのは、LLM-as-a-judgeに関する論文とか、公開されてる評価基準(ベンチマーク)を調べてまとめたってことだね。

課題とか、議論されてる?

うん、もちろん。LLM-as-a-judgeには、まだ課題もあって、色々議論されてるよ。

- 偏見とか弱点 (Bias & Vulnerability): LLMが判断するときに、どうしても偏った見方しちゃったり(例えば、出てくる順番とか、どっちのAIが作ったかとか、文章の長さとかに影響されるとか)、悪いヤツに騙されやすい弱点があるって話。

- 状況に応じた複雑な判断 (Dynamic & Complex Judgment): いつも同じやり方じゃなくて、もっと状況に合わせて柔軟に、複雑な判断ができるようにしないとね、って話。LLMが試験官みたいに、相手に合わせて質問とか判断を変えていくようなイメージ。

- 自分で自分を判断すること (Self-Judging): LLMが自分で作ったものを評価するときって、どうしても自分に甘くなりがちじゃん? そういう問題をどうするか、もっとうまく自己評価できるようになるにはどうしたらいいか、って話。

- 人とLLMで一緒に判断すること (Human-LLM Co-judgment): LLMの判断の偏りとか弱点をカバーするために、人間もチェックしたり、人とLLMが協力して判断したりする方がいいんじゃないの、って話。

こういう課題は、LLM-as-a-judgeを本当に信頼して使えるようにするために、すごく大事なポイントだね。

まとめると…

この論文は、「LLM-as-a-judge」っていう、LLMを評価者として使う考え方について、いろんな角度から掘り下げてる。LLMがどうやって判断するのか、入力と出力のパターンで分類したり、何を・どうやって・どこで判断するのかっていう枠組みで整理したりしてる。さらに、評価のための基準(ベンチマーク)を紹介して、今の課題とかこれからの可能性も示してるから、この分野に興味がある人には、かなり役立つ情報源になるはずだよ。

あとがき

記事よかったら、いいね♡ 押してね!

Discussion