Closed15

Google Cloud Modern App Summit '25 参加レポート

着いた

もうちょっと早めに来れば良かった

無料Wi-Fi用意してくれるの助かる

15:00〜15:40

Track1 【基調講演】生成 AI とモダナイゼーションが加速させる、アプリ開発とデータベースの進化

オープニング

TL;DR

- Google Cloud のオススメサービス紹介

Geminiで開発(運用)の生産性の向上

- Gemini Code Assist

- Gemini Code Assist for individuals

サービス開発における付加価値

Cloud Run

- サーバーレス ランタイム

Cloud Run with GPUs

- オンデマンド、高いスケーラビリティ、高速起動、秒単位の課金

HRBrain

課題

- 開発が進むに連れて次第にローカル環境の CPU/メモリ負荷が辛くなってきた

解決方法

- Cloud Workstations を使うことにした

- Cloud Workstations = クラウドワークステーション

- カスタムコンテナイメージを使っている

- 再現性のある開発環境をすぐに構築でき、

Gemini Code Assistについて

- プロジェクト全体を考慮した実装をAIがしてくれる

- GitHub や GitLab と連携して使うことができる。24時間に一度リポジトリの読み込みが走り、専用のインデックスが作成される。

株式会社はてな toittaの話

サービス概要

- ユーザーインタビュー業務のサポート

- サービスにAIを組み込みつつ、開発環境でも活用した

Cloud Runを活用した開発について

- 特定機能の業務フローを分解し分析、そのプロトタイピングにCloud Runを使った

- toittaでは音声認識での書き起こしや話者分離が必要なのでGPUリソースが必要。下記を活用した。

- Vertex AI Workbench

- Vertext AI Pipelines

- Cloud Batch

- GKE Autopilot

- GPU support for Cloud Run (preview)

- セキュリティ性も担保する必要があり、Security Command Center プレミアム ティアを活用した

結構スライドがポンポン進むからメモが追いつかない

でも、 Google Cloud を一切触ったことがない人間なのでサービスを活用事例込みで幅広く知れるのは良いね

15:50 - 16:20

Track1 開発を加速する!Gemini Code Assist 最新アップデート

世の中の課題

- 開発の生産性に直結するソリューションを探すことの難しさ、時間を要するもどかしさがある

- DORA 2023 の調査によると、開発の生産性は組織全体のパフォーマンスに直結して影響している

- リードタイムの変更

- デプロイ頻度

- 失敗率の変更

- サービス復旧までの時間

- 翌年 DORA 2024 の調査によると、AIによる生産性の向上を実感しているというアンケート結果が出た。ただ、わずかな向上しか感じていない人が多い様子。

Gemini Code Assist の紹介

AIコード生成

- AIとのチャットウィンドウでの結果をコードエディタへの反映ができる

- コード補完ができる

- サジェスト内容についてライセンス帰属の確認ができ、ライセンス条項を遵守するコーティングを支援してくれる

- コード説明ができる

- ユニットテスト計画の提案するようテストプランを要求できる

- テストプランからテストを生成できる

その他の最新機能

Code Customization

- プライベートなコードを活用し、organization内のルールや文化を考慮した提案を強化する機能

- 別リポジトリのコードから、共通処理であれば流用したり、考慮したサジェストができる

- SaaS だけでなく オンプレミス 環境のリポジトリも連携可能 (GitHubやGitLab、Bitbucketなど)

Code Review Agent

- プルリクエストを契機にGeminiが自動でレビューや提案をしてくれる機能

- PR を作成したら即時でAIによる投稿が走る

- Summary of Changes などを文章にまとめて出してくれる

- コードの共通性を向上する指摘やより良い改善などをレビューで投稿してくれる

Code Assist Everywhere

Gemini 2.0 (with Code optimize)

- Gemini in BigQuery

- Gemini in Dataases (Database studio内)

Gemini Code Assist for Individual

- 個人開発者向けEditionとして、個人開発者や学生向けに無料公開 (パブリックプレビュー)

- Code Assist for GitHub Apps も無料提供

- Google Workspace に登録されていない Google アカウント (メールアドレス) が必要

Tech Acceralationの紹介

- Developer Productivity Workshop

- Day1からDay3を通して渋谷のGoogleオフィスでワークショップできる

- 参考) SanSanさんのTech Blog[1]

個人開発者はGeminiを使ってみようかなと思った (小並感)

16:30 - 17:00

Track1 NVIDIA NIM コンテナを活用した Google Cloud 上での AI モデル ホスティング

モデルのホスティングについて

- セルフホスティングのニーズは、コスト、セキュリティ、レイテンシの面から需要が高い

- APIベースでの利用ではコストの予測が難しく、課金額がユーザーに依存するため制御が困難

- インターネットへのアクセスが必要で、社外に持ち出せない情報を用いたAI利用ができない

- すぐレスポンスしたいユースケースがあるとレイテンシを少しでも減らしたい状況に置かれる

- NVIDIA社とのパートナーシップも相まってGoogle Cloudを提供できる

Google Cloud の選択肢

- Compute Engine

- Kubenetes Engine

- Cloud Run (今回着目するサービス)

- VertexAI

Cloud Run with GPUs の紹介

- LLMアプリにおいてはコールドスタートが重要なため.サーバーレスランタイムのCloud Runとの相性がいい

- プロンプトを受け取ってできるだけ早くレスポンを返す必要があるため

- 複雑なネットワーク構成を設計せずとも比較的早くアプリケーション開発に移れる (AIモデルのセルフホスティングの範疇では)

NVIDIA NIM で AI モデルをホストする (NVIDIA NIMの紹介)

- NVIDIA NIMであればデプロイに必要なのはワンラインコマンドのみで、5分ほどでデプロイできる

- Docker Container で提供しており、CUDAなどのLLM推論モデルがプリインストールされている

- NIM は FastAPI で実装されており、OpenAIの仕様に準拠している

- REST API のエンドポイントを経由してLLMレイヤにアクセスするイメージ

- LLMの高速化や最適化はすでに構築済みな Docker Image を提供しているとのこと

- 日本語対応モデルも新しく提供!

- Llama3.1 Swallow 8B/70B

- Llama 3 Swallow 70B

- RakutenAI 7B (preview)

- 多言語モデルは DeepSeek-R1、Llama、Mistral、Nemotron、Gemma、Phiなども対応している

- すでに最適化済みしたモデルに対して独自の重み付けを付与することも可能

デモ

概要

- 今回は日本語特化のGemma (Gemma2 JPN) を利用

- Cloud Run を使う

セルフホスティング良さそう

Docker Image で提供されていて REST API にリクエスト投げるだけなら割と気軽に使えそうだし

会場にはドリンクやら軽食やらが置いてあってすごい

聞きたいセッションがなければ聴講せずにゆったりするのもあり

早速ドリンクを頂いたけど、会場には蓋付きじゃないと持ち込めないので会場の外でガブ飲み

午前中にインフラのイベントがあったことを今更知るなど

17:10 - 17:40

Track2 「みんなの銀行」のモダンな開発基盤を支えるアーキテクチャと ArgoCD による自動化戦略

みんなの銀行について

- 銀行機能に必要な機能のほとんどをGoogle Cloud 城野に GKE で構築

- 外部サービス (BaaSサービスなど) はオープンAPIを活用したり公開したりしている

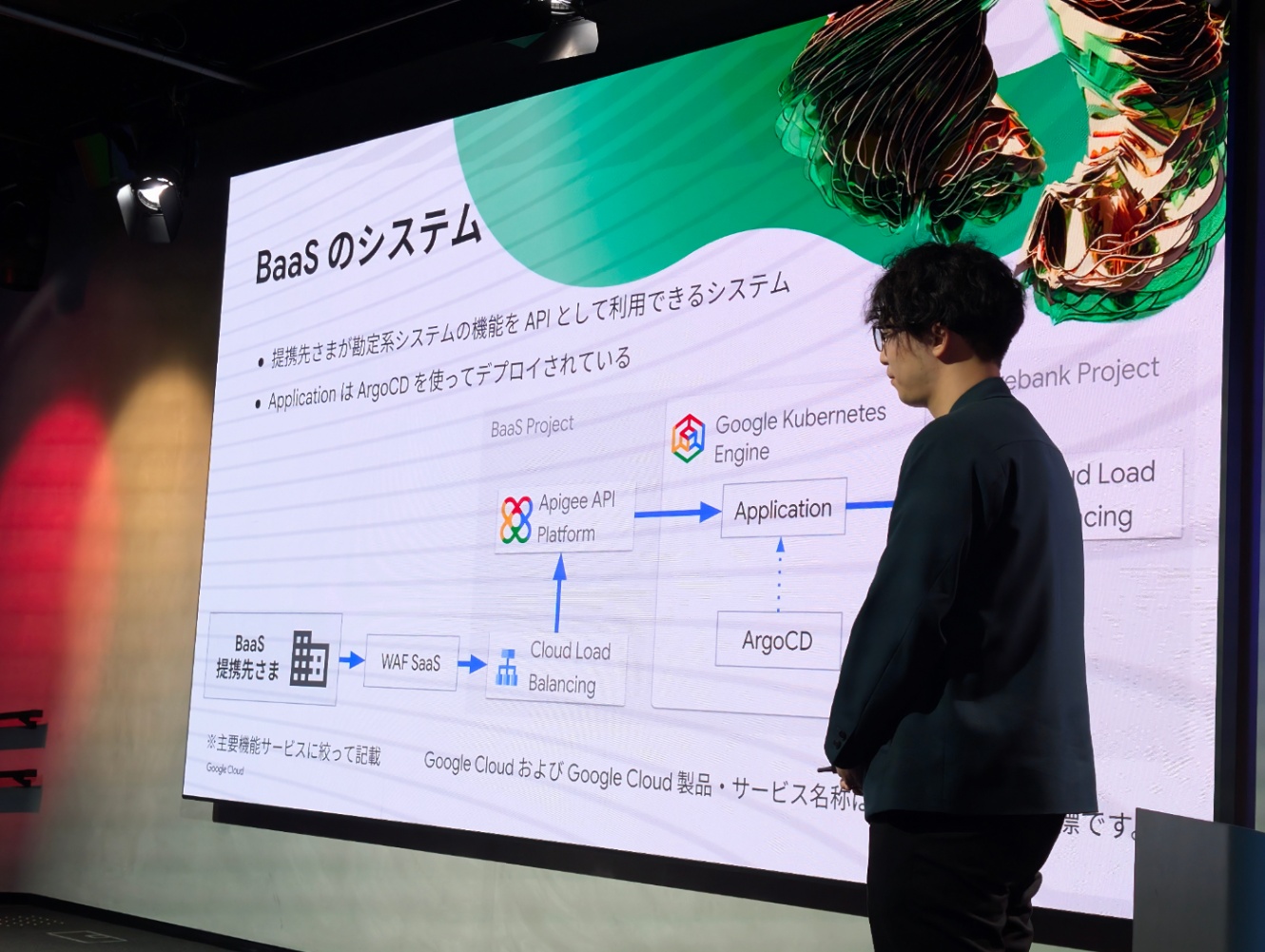

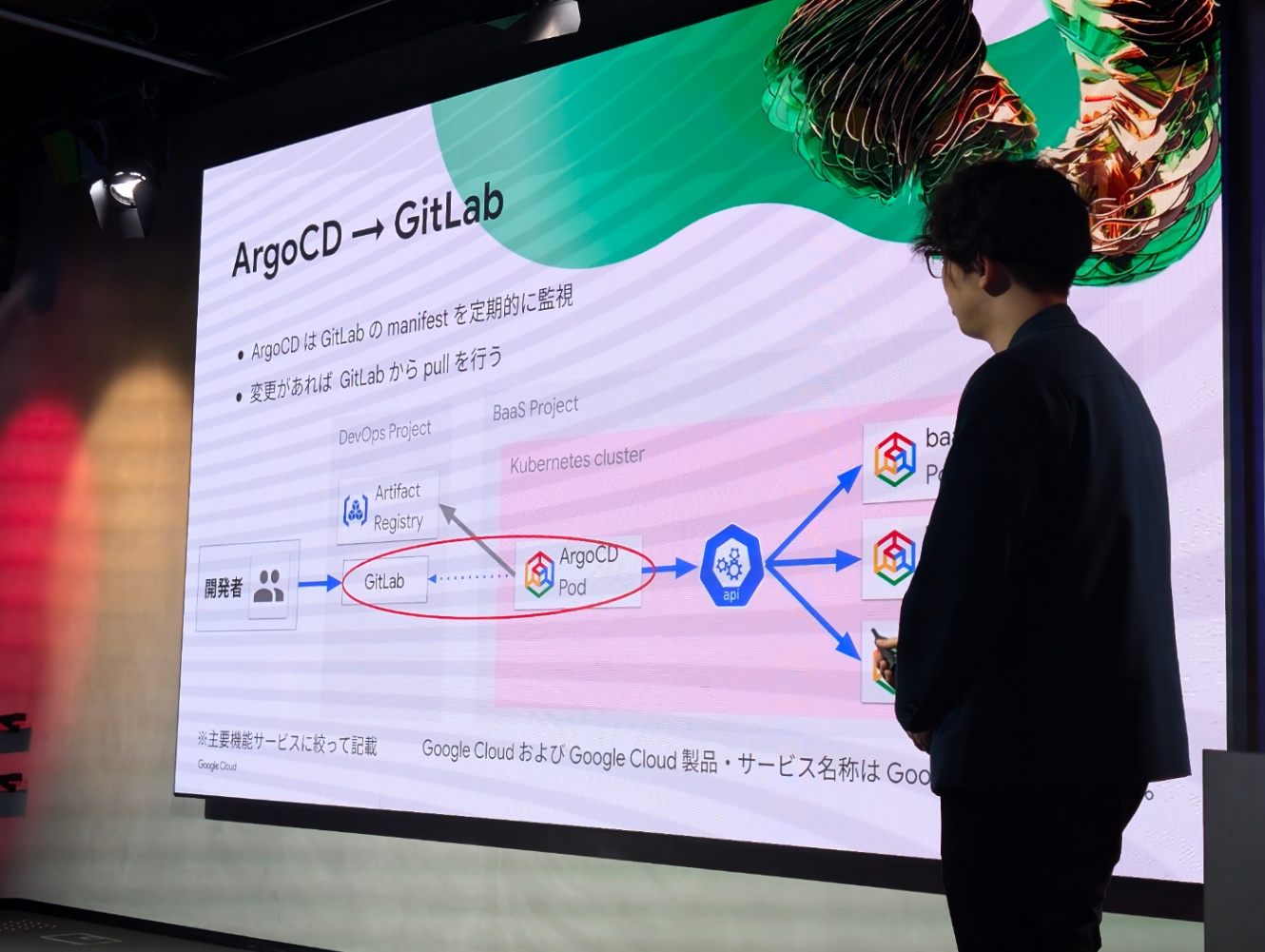

- BaaS のシステムは提携先に向けて公開していて、ArgoCDを使っている

- クイックに開発、クイックに世に出すことがやりたかった

みんなの銀行に導入したこと

- Zero Touch Prod を目指し、人為的なオペレーションリスクを減らしたかった

- なので、ArgoCD を利用したリリースフローを実装した

ArgoCD での改善点

- Deploy 作業の負荷軽減やミス排除

- LaC の原則に従い、信頼性を向上させた

Sysdig でのセキュリティ対策

- GKE に SysdigAgent をデプロイし、脅威検知と脆弱性検知を行っている

- 最新の攻撃手法をすぐに検知できる脅威検知性、脆弱性のトリアージが可能になり対応すべき脆弱性に優先度をつけられる、Helm Chartが提供されているのでArgoCDによるデプロイが可能などのメリットあり

- 国内サポートのレスポンスの速さ・知識量が豊富で、脆弱性などの可視化でき分かりやすかったとのこと。ただ、Custom Policies の権限分離ができない点がネックと感じているが、ログ連携しているSIEMによるアラートでカバー。

そもそも Sysdig について

- Wiresharkを作った人が作った会社。今は技術責任者。

- Linux コマンドの sysdig から始まり、クラウドネイティブの時代にあわせてセキュリティ製品を出してきた

- CNAPP (Cloud Native Application Protection Platform)

AIが登場してからのセキュリティ事情

- 昨今は AI 活用もあり攻撃するのに10分もあれば行われてしまうとのこと

- LLMjacking という手法も出てきてしまい、つい最近もDeepSeekが標的になってしまった

- それに対し、新たな基準としてSysdigが「555ベンチマーク」[1]を発表

- 5秒以内の脅威を検知

- 5分以内のトリアージ

- 5分以内の対応開始

17:50 - 18:20

Track2 Google Cloud 活用の AI DevSecOps プラットフォーム紹介

一般共通的なソフトウェア開発の話

- 仕様はメンバーに本質的に伝わっていないことが多く、それにより作るものを間違えてしまいがち。ソフトウェア開発って難しい。

GitLab について

- 企業向けにソフトウェア管理全般をカバー・統合している製品

- GitLab は DevSecOps に注力して機能を追加している

- GitLabは SSOT 、各工程のタスクの紐づけ、計画管理、進捗管理、生産性管理などを一元管理できる

- PM、Team Leader、Developerのそれぞれが欲しい情報が集約できる

GitLab のAI活用

- Epicに始まり、issue、PR、deployまで実施でき、その間に必要な情報も一元管理できるおかげで、GitLab のAIはチームの状況を学習し理解している状態になり、チームメンバーの1人(または2人、3人かもしれない)として参画してくれるような存在になっている

- GitLab 17.9にてローカルLLMを動作させることが可能に

デモ

- GKEとGitLabを連携した開発デモ

- 流れ

- GKE環境を作成し、GitLabのリポジトリと連携を設定しておく

- issueを作成

- 空のマージリクエストを作成

- 開発予定を記入

- コードを変更しコミット

- CDが動作し、GKEにデプロイされ、PR単位で変更後のアプリケーションが動作する (レビュワーに実際に動いているアプリを見せることができる)

これらによって GitLab でできること

- ソフトウェア開発の3大失敗に早く気付けるようになる

- 作るものを間違っていることに早く気付ける

- 仕様が伝わっていないことを早く気付ける

- アーキテクチャが崩れ始めていることに早く気付ける

AI時代に入ってからのGitLabについて全然キャッチアップしてなかったけど、一元管理を活かした特徴がすごい良さそうだった

プロジェクト管理はこれにまとめて進めるのはアリかもしれない

PCのバッテリー、割とギリギリだったけど乗り切った

キンキンに冷えたペリエを片手に退場

お疲れ様でした

このスクラップは2025/03/06にクローズされました