gpt-3.5-turbo を gpt-4o-mini に換装したらAPIのコストが20分の1になった話 (+プロンプトエンジニアリング)

こんにちは、オープンの橋岡です。

タイトル通りですが、4月ごろの話で、サービスでChatGPTのAPIを使ってドキュメント分析をする機能があり、トークンあたりの利用料が20分の1なので理論上は20分の1になる想定で換装したら、ちゃんとコストが下がりました。

厳密に20分の1ではないのですが、かなりインパクトはありました。

前提

OpenAI ChatGPT API モデル比較

Inputのコストが20分の1です。そして利用実態としは割合的にほぼInput利用です。

プロンプトエンジニアリング

使用モデルの換装にあたっては、出力のクオリティが換装前より下がらないように、投げるプロンプトを調整する必要がありました。

ニュアンスだけですが、このような感じでいじりました。

換装前(gpt-3.5-turboに投げるリクエスト)

ドキュメントとarticleを参照し、{target}が条件と合致するかどうかを0か2で評価してください。

【注意事項】[特定の内容]がある場合は0。

フィクションである場合は2と判定。

関連しているが当事者でなく関係者である場合は2。

換装後(gpt-4o-miniに投げるリクエスト)

ドキュメントとarticleを参照し、{target}が条件と合致するかどうかを0か2で評価してください。

【注意事項】[特定の内容]がある場合は0。

登場人物がの[特定の内容]当事者である場合は必ず0。

フィクションである場合は2と判定。

関連しているが当事者でなく関係者である場合は2。

0,2以外の評価には絶対にしないこと

実はあまり変わっていません。

この内容が汎用的に使い回せるわけではないと思われますが、現状ではうまくいっています。

(そう判断しています。)

結果

APIのInput単位あたりのコストが20分の1なので、

かなり下がってくれました。

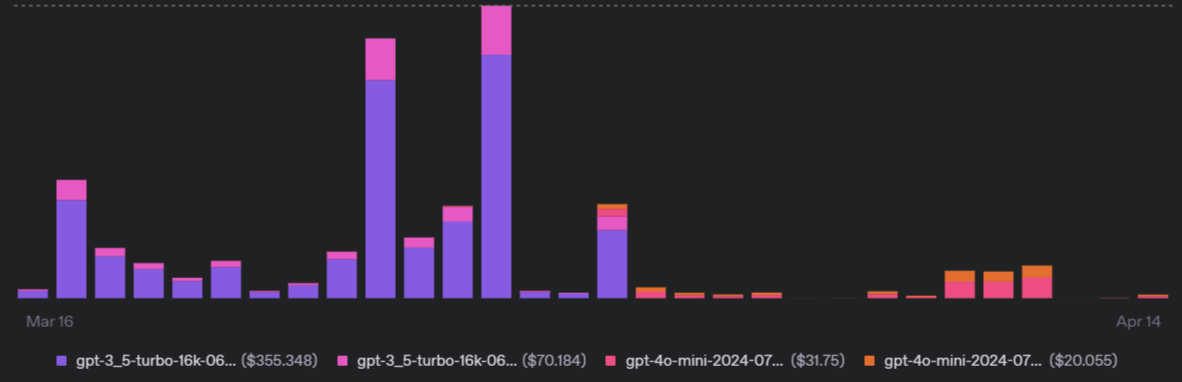

日毎のコストだとこんな感じです。

後半の、色が変わりかつガクッと減っているのが換装後です。

APIへのリクエスト回数は減っておらず、むしろ増えているのですが

コストは目に見えて下がっています。

まとめと感想

OpenAIのAPIでモデルを gpt-3.5-turbo から gpt-4o-mini に変えて、

コストを圧縮することができました。

それなりのプロンプトエンジニアリングとテストは必要ですし

どこまでどんなテストすればよいかの判断も難しいですが、

このあたりは腕の見せどころかと思います。

今後LLMのコスパはどんどん改善(旨い、安い、早い)されていくでしょうから

ちゃんと活用できるようにしたいです。

Discussion